Facilità d'uso

Amazon EMR semplifica la creazione e il funzionamento degli ambienti e delle applicazioni per Big Data. Tra le caratteristiche correlate di EMR vi sono provisioning, scaling gestito e riconfigurazione semplificati dei cluster e EMR Studio per lo sviluppo collaborativo.

Provisioning rapido di cluster: bastano pochi minuti per avviare un cluster EMR. Non è più necessario preoccuparsi di allocare un’infrastruttura né configurare, impostare o ottimizzare i cluster. EMR svolge queste attività e consente ai tuoi team di concentrarsi sullo sviluppo di applicazioni di Big Data differenziate.

Ridimensiona facilmente le risorse per soddisfare le esigenze di business: puoi dimensionare facilmente le policy di scaling gestito EMR e consentire al tuo cluster EMR di gestire automaticamente le risorse di calcolo per soddisfare le tue esigenze di utilizzo e di prestazioni. Ciò permette di migliorare l’utilizzo dei cluster e di risparmiare sui costi.

EMR Studio è un ambiente di sviluppo integrato (IDE) che semplifica lo sviluppo, la visualizzazione e il debug di applicazioni di data engineering e scienza dei dati scritte in scritte in R, Python, Scala e PySpark per i data scientist e gli ingegneri dei dati. EMR Studio fornisce notebook Jupyter completamente gestiti e strumenti come Spark UI e YARN Timeline Service per semplificare il debug.

Elevata disponibilità con un clic: puoi configurare facilmente l’alta disponibilità per applicazioni multi-master come YARN, HDFS, Apache Spark, Apache HBase e Apache Hive con un singolo clic. Abilitando il supporto multi-master, EMR configurerà le applicazioni per garantire elevata disponibilità e, in caso di errori, avvierà automaticamente il processo di failover su un master affinché l’attività del cluster non venga interrotta e posizionerà i nodi master in rack distinti riducendo il rischio di errori simultanei. Gli host vengono monitorati per rilevare gli errori e quando si riscontrano problemi, vengono allocati nuovi host e aggiunti automaticamente al cluster.

Scaling gestito EMR: ridimensiona automaticamente il cluster in modo da ottenere migliori prestazioni al costo più basso possibile. Con lo scaling gestito EMR puoi specificare i limiti di elaborazione minimo e massimo per i cluster e Amazon EMR li ridimensionerà automaticamente in modo da ottenere prestazioni e utilizzo delle risorse migliori. Inoltre, lo scaling campiona continuamente i parametri chiave associati ai carichi di lavoro in esecuzione sui cluster.

Facile riconfigurazione dei cluster in esecuzione: è ora possibile modificare la configurazione delle applicazioni in esecuzione sui cluster EMR, tra cui Apache Hadoop, Apache Spark, Apache Hive e Hue, senza riavviare il cluster. La riconfigurazione di EMR consente di modificare al volo le applicazioni senza dovere arrestare o ricreare il cluster. Amazon EMR applicherà le nuove configurazioni e riavvierà agevolmente l’applicazione riconfigurata. Le configurazioni sono applicabili tramite la Console, l’SDK o l’interfaccia a riga di comando.

Elasticità

Amazon EMR consente di allocare tutta la capacità necessaria in modo semplice e veloce, aggiungendo e rimuovendo capacità in modo automatico o manuale. Questo risulta particolarmente utile quando non è possibile prevedere i requisiti di elaborazione oppure quando variano nel tempo. Ad esempio, se il picco di elaborazione si verifica di notte, potrebbero occorrere solo 100 istanze durante il giorno e 500 istanze nelle ore notturne. Oppure potrebbe essere necessario disporre di grandi quantità di risorse per un breve intervallo di tempo. Con Amazon EMR è possibile allestire centinaia o migliaia di istanze, ricalibrandone le risorse in base ai requisiti di elaborazione, e terminarle appena l'attività per cui erano necessarie si conclude, in modo da non pagare per capacità non utilizzata.

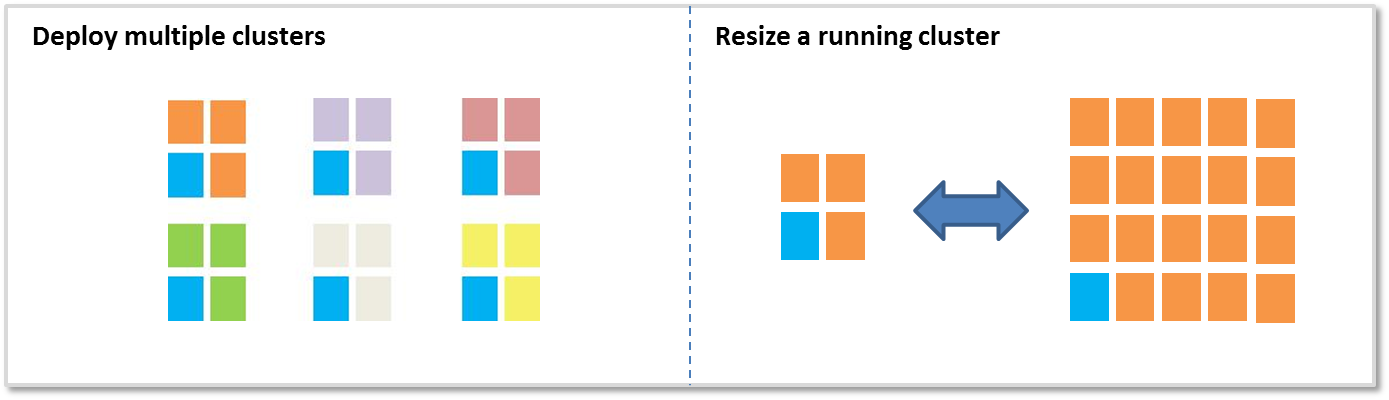

Sono due le opzioni che consentono di aggiungere o rimuovere capacità:

Distribuzione di più cluster: quando occorre un volume maggiore di risorse, è possibile avviare un nuovo cluster, terminandolo quando non è più necessario. Non è previsto alcun limite al numero di cluster che è possibile avviare. È possibile utilizzare diversi cluster quando sono presenti più utenti o più applicazioni. Ad esempio, è possibile memorizzare i dati di input in Amazon S3 e avviare un cluster per ogni applicazione che deve elaborare tali dati. Un cluster può essere ottimizzato per la CPU, un secondo cluster può essere ottimizzato per lo storage, ecc.

Ridimensionamento di un cluster in esecuzione: con Amazon EMR è semplice utilizzare lo scaling gestito EMR, scalare automaticamente o ridimensionare manualmente un cluster in esecuzione. Potrebbe essere necessario aumentare le risorse per aggiungere temporaneamente potenza di elaborazione al cluster, oppure ridurle per risparmiare sulla capacità inattiva. Ad esempio, alcuni clienti aggiungono centinaia di istanze ai loro cluster quando è prevista l'elaborazione di batch, rimuovendo poi le istanze non necessarie al termine dell'attività. Al momento dell'aggiunta di istanze al cluster, EMR utilizza la capacità allocata appena risulta disponibile. In fase di ridimensionamento, EMR sceglie in maniera proattiva i nodi inattivi per ridurre l'impatto sulle attività in esecuzione.

Costi ridotti

Amazon EMR è progettato per ridurre i costi derivanti dall'elaborazione di grandi quantità di dati. Questo grazie a tariffe al secondo ridotte, elasticità, integrazione con le istanze Spot e riservate di Amazon EC2 e integrazione con Amazon S3.

Tariffe al secondo ridotte: le tariffe di Amazon EMR sono calcolate al secondo con un addebito minimo di un minuto e partono da 0,015 USD per ora di utilizzo di un'istanza di piccole dimensioni (131,40 USD all'anno). Per ulteriori informazioni, consulta la pagina dei prezzi.

Integrazione con Amazon EC2 Spot: il prezzo delle istanze Spot di Amazon EC2 varia in base alla domanda e all'offerta delle istanze, ma non sarà mai addebitata una cifra superiore a quella specificata. Con Amazon EMR è semplice utilizzare le istanze Spot per risparmiare tempo e denaro. I cluster di Amazon EMR includono "nodi principali" e "nodi di task" (solo i primi in esecuzione in HDFS); i nodi di task sono la scelta ottimale per le istanze Spot, perché se le istanze vengono interrotte a causa dell'aumento del prezzo Spot, non perderai i dati salvati in HDFS. Scopri di più su nodi principali e nodi di task. Con la combinazione di parchi istanze, strategie di allocazione per istanze Spot, scaling gestito EMR e altre opzioni di diversificazione, puoi ottimizzare EMR in termini di resilienza e costi. Per ulteriori informazioni, leggi qui il nostro blog.

Integrazione con Amazon S3: il file system EMR o EMRFS (EMR File System) consente ai cluster EMR di utilizzare Amazon S3 come object store per Hadoop in modo efficiente e sicuro. Sarà quindi possibile memorizzare i dati in Amazon S3 e utilizzare diversi cluster di Amazon EMR per elaborare lo stesso set di dati. Ogni cluster può essere ottimizzato per un determinato carico di lavoro per ottenere la massima efficienza, mentre in genere vengono assegnati a un singolo cluster svariati carichi di lavoro con requisiti diversi. Ad esempio, puoi prevedere un cluster ottimizzato per le operazioni I/O e un altro ottimizzato per la CPU, ognuno dei quali elabora lo stesso set di dati contenuto in Amazon S3. Inoltre, memorizzando i dati in entrata e in uscita in Amazon S3, puoi arrestare i cluster quando non sono più necessari.

EMRFS consente prestazioni elevate in lettura e in scrittura su Amazon S3, supporta la crittografia lato server e lato client tramite AWS Key Management Service (KMS) e chiavi gestite dall'utente, e offre una vista opzionale che consente di controllare la consistenza della verifica dopo scrittura e a livello di elenco per gli oggetti monitorati nei relativi metadati. Infine, i cluster di Amazon EMR possono usare sia EMRFS sia HDFS, così non sarà necessario scegliere tra storage su cluster o in Amazon S3.

Integrazione con il catalogo dati di AWS Glue: è possibile utilizzare il catalogo dati AWS Glue come repository di metadati gestito per memorizzare i metadati di tabelle esterne per Apache Spark e Apache Hive. Inoltre, offre rilevamento automatico di schemi e storico delle versioni degli schemi. In questo modo è più semplice conservare i metadati delle tabelle esterne in Amazon S3 al di fuori del cluster.

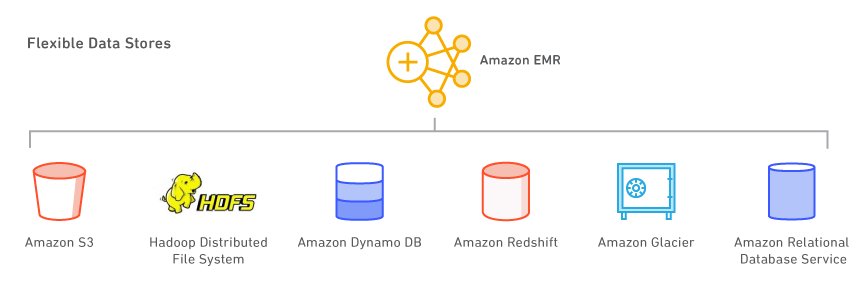

Datastore flessibili

Con Amazon EMR, è possibile impiegare più di un datastore, ad esempio Amazon S3, HDFS (Hadoop Distributed File System) e Amazon DynamoDB.

Amazon S3: Amazon S3 è un servizio di storage altamente durevole, scalabile, sicuro, veloce ed economico. Con il file system EMR o EMRFS (EMR File System), Amazon EMR è in grado di utilizzare Amazon S3 come object store per Hadoop in modo efficiente e sicuro. Amazon EMR migliora molte funzionalità di Hadoop, consentendo ad esempio di elaborare in modo ottimale grandi quantità di dati memorizzati in Amazon S3. Inoltre, EMRFS facilita il controllo della consistenza della verifica dopo scrittura e a livello di elenco per gli oggetti in Amazon S3. EMRFS supporta la crittografia lato server o lato client per l'elaborazione di oggetti crittografati di Amazon S3, ed è possibile utilizzare AWS Key Management Service (KMS) oppure un fornitore di chiavi personalizzate.

Quando viene avviato un cluster, Amazon EMR inoltra i dati da Amazon S3 a tutte le istanze al suo interno e avvia immediatamente l'elaborazione. Uno dei vantaggi di memorizzare i dati in Amazon S3 ed elaborarli con Amazon EMR è che puoi usare diversi cluster per elaborare gli stessi dati. Ad esempio, puoi disporre di un cluster di sviluppo in Hive, ottimizzato per la memoria, e un cluster di produzione in Pig, ottimizzato per la CPU, che usano entrambi lo stesso set di dati di input.

HDFS (Hadoop Distributed File System): HDFS è il file system di Hadoop. L'attuale topologia di Amazon EMR prevede il raggruppamento delle istanze in 3 gruppi logici: Master Group, che esegue il servizio YARN Resource Manager e HDFS Name Node; Core Group, che esegue HDFS DataNode Daemon e il servizio YARN Node Manager; Task Group, che esegue il servizio YARN Node Manager. Amazon EMR installa HDFS sullo storage associato alle istanze nel Core Group.

Ogni istanza EC2 viene fornita con una quantità fissa di storage, nota come "instance store", associata a un'istanza. È inoltre possibile personalizzare lo storage su un'istanza aggiungendo volumi di Amazon EBS. Amazon EMR consente di aggiungere volumi di tipo General Purpose (SSD), Provisioned (SSD) e Magnetic. Al momento dell'arresto di un cluster EMR, i dati sui volumi EBS collegati non vengono conservati. EMR cancellerà automaticamente i dati.

È anche possibile configurare la crittografia completa per HDFS utilizzando una configurazione di sicurezza di Amazon EMR, oppure creare zone di crittografia HDFS con Key Management Server di Hadoop. Quando specifichi AWS KMS come provider principale, puoi utilizzare un'opzione di configurazione della sicurezza per crittografare il dispositivo root EBS e i volumi di archiviazione. Per maggiori informazioni, consulta Crittografia su disco locale.

Amazon DynamoDB: Amazon DynamoDB è un servizio di database NoSQL rapido e completamente gestito. Amazon EMR si integra con Amazon DynamoDB, consentendo di elaborare i dati memorizzati in Amazon DynamoDB in modo rapido ed efficiente e di trasferire dati tra Amazon DynamoDB, Amazon S3 e HDFS in Amazon EMR.

Altri datastore AWS: puoi utilizzare anche Amazon Relational Database Service (un servizio Web che semplifica configurazione, funzionamento e scalabilità di database relazionali nel cloud), Amazon Glacier (un servizio di storage dai costi estremamente contenuti che fornisce storage durevole per l'archiviazione e il backup dei dati) e Amazon Redshift (un servizio di data warehousing rapido e gestito, con dimensioni nell'ordine dei petabyte). AWS Data Pipeline è un servizio Web che consente di elaborare e trasferire dati tra più servizi di elaborazione e storage AWS (tra cui Amazon EMR) e origini dati locali, a specifici intervalli di tempo e con la massima affidabilità.

Compatibilità con le più comuni app open source

Con le release in versioni multiple in Amazon EMR, è possibile selezionare e usare i progetti open source più recenti in un cluster EMR, incluse le applicazioni negli ecosistemi Apache Spark e Hadoop. Il software viene installato e configurato da Amazon EMR, perciò sarà possibile tralasciare le attività di allestimento dell'infrastruttura e l'amministrazione e concentrare la propria attenzione sul valore dei dati.

Strumenti per i Big Data

Amazon EMR supporta strumenti potenti e affidabili per Hadoop come Apache Spark, Apache Hive, Presto e Apache HBase. I data scientist utilizzano EMR per eseguire strumenti di deep learning e machine learning come TensorFlow e Apache MXNet e, servendosi delle bootstrap actions, aggiungere le tue librerie e i tuoi strumenti specifici per casi d'uso. I data analyst utilizzano EMR Studio, Hue e i notebook EMR per lo sviluppo interattivo, per creare i processi Apache Spark e inoltrare query SQL ad Apache Hive e Presto. Gli ingegneri dei dati utilizzano EMR per lo sviluppo della pipeline dei dati e l’elaborazione dei dati e Apache Hudi per semplificare la gestione incrementale dei dati e i casi d’uso di privacy dei dati che richiedono operazioni di inserimento, aggiornamento ed eliminazione a livello di record.

Elaborazione di dati e machine learning

Apache Spark è un motore dell'ecosistema Hadoop che velocizza l'elaborazione di set di dati di grandi dimensioni. Impiega set di dati resilienti o RDD (Resilient Distributed Dataset) in memoria con tolleranza ai guasti e grafi aciclici diretti o DAG (Directed Acyclic Graphs) per definire le trasformazioni dei dati. Spark include inoltre Spark SQL, Spark Streaming, MLlib e GraphX. Ottieni ulteriori informazioni su Spark e Spark su EMR.

Apache Flink è un motore di flussi di dati in streaming che semplifica l'elaborazione di flussi in tempo reale su origini dati a velocità di trasmissione effettiva elevata. Supporta semantica di eventi temporali per eventi di esaurimento, semantica di elaborazione singola, controlli di congestione e API ottimizzate per la scrittura con applicazioni in streaming e in batch. Ottieni ulteriori informazioni su Flink e Flink su EMR.

TensorFlow è una libreria matematica di simboli open source per applicazioni di intelligenza automatica deep learning. TensorFlow riunisce in bundle più modelli di machine learning e deep learning e modelli di algoritmi per addestrare ed eseguire reti neurali profonde per vari e diversificati casi d'uso. Ulteriori informazioni su TensorFlow in EMR.

Gestione dei dati Amazon S3 a livello di record

Apache Hudi è un framework di gestione dei dati open source utilizzato per semplificare l’elaborazione incrementale dei dati e lo sviluppo della pipeline dei dati. Apache Hudi ti consente di gestire i dati a livello di record in Amazon S3 per semplificare l’acquisizione di Change Data Capture (CDC) e di dati di streaming e fornisce un framework per gestire i casi d’uso di privacy dei dati che richiedono aggiornamenti ed eliminazioni a livello di record. Scopri di più su Apache Hudi su Amazon EMR.

SQL

Apache Hive è un pacchetto open source di data warehouse e analisi eseguibile con Hadoop. Hive funziona con Hive QL, un linguaggio basato su SQL che consente di creare strutture, riepiloghi e query di dati. Hive QL ha più funzioni di SQL, supporta le funzioni di mappatura/riduzione e permette l'uso di tipi di dati estensibili complessi definiti dall'utente quali JSON e Thrift. Grazie a questa funzionalità, è possibile elaborare origini dati complesse e non strutturate quali documenti di testo e file di log. Hive consente l'utilizzo di estensioni utente tramite funzioni definite dall'utente scritte in Java. Amazon EMR migliora molte funzionalità di Hive, come l'integrazione diretta con Amazon DynamoDB e Amazon S3. Ad esempio, con Amazon EMR è possibile caricare automaticamente partizioni di tabelle da Amazon S3, scrivere nelle tabelle in Amazon S3 senza impiegare file temporanei e accedere alle risorse in Amazon S3, quali script per operazioni personalizzate di mappatura o riduzione e librerie aggiuntive. Scopri cos'è Hive e ulteriori informazioni su Hive su EMR.

Presto è un motore di query SQL open source ottimizzato per l'analisi di dati ad hoc a bassa latenza. Supporta lo standard SQL ANSI, incluse query complesse, aggregazioni, join e funzioni finestra. Presto è in grado di elaborare dati da una moltitudine di origini dati, tra cui il file system distribuito Hadoop (HDFS) e Amazon S3. Ottieni ulteriori informazioni su Presto e Presto su EMR.

Apache Phoenix consente l'uso di funzionalità SQL a bassa latenza con proprietà ACID sui dati memorizzati in Apache HBase. Creare indici secondari per ottenere migliori prestazioni è semplice, così come creare visualizzazioni diverse sulla stessa tabella HBase. Scopri di più su Phoenix in EMR.

Database NoSQL

Apache HBase è un database open source non relazionale distribuito, creato sul modello di BigTable di Google. È stato sviluppato nell'ambito del progetto Hadoop di Apache Software Foundation e viene eseguito con il file system distribuito Hadoop (HDFS) per fornire funzionalità di tipo BigTable per Hadoop. HBase fornisce un modo efficiente e con tolleranza ai guasti di memorizzare grandi quantità di dati a bassa densità utilizzando storage e compressione basati su colonne. Inoltre, HBase offre consultazione rapida dei dati, perché li memorizza nella memoria cache. HBase è ottimizzato per operazioni di scrittura sequenziali ed è particolarmente efficiente per aggiornamenti, eliminazioni ed inserimenti in batch. HBase è ottimizzato per Hadoop, condividendone il file system e fungendo da input e output diretto per i relativi processi. Inoltre, HBase si integra con Apache Hive, consentendo query di tipo SQL su tabelle HBase, unioni con tabelle basate su Hive e supporto per JDBC (Java Database Connectivity). Con EMR, è possibile utilizzare Amazon S3 come datastore per HBase, così da ridurre i costi e la complessità operativa. Se HDFS viene utilizzato come datastore, è possibile effettuare il backup di HBase in S3 ed eseguirne il ripristino da un backup precedente. Scopri cos'è HBase e ulteriori informazioni su HBase su EMR.

Analisi interattiva

EMR Studio è un ambiente di sviluppo integrato (IDE) che semplifica lo sviluppo, la visualizzazione e il debug di applicazioni di data engineering e scienza dei dati scritte in scritte in R, Python, Scala e PySpark per i data scientist e gli ingegneri dei dati. EMR Studio fornisce notebook Jupyter completamente gestiti e strumenti come Spark UI e YARN Timeline Service per semplificare il debug.

Hue è un'interfaccia utente open source per Hadoop che semplifica l'esecuzione e lo sviluppo di query in Hive, la gestione dei file in HDFS, l'esecuzione e lo sviluppo di script in Pig e la gestione delle tabelle. Hue in EMR si integra inoltre con Amazon S3, così da potervi inoltrare le query in modo diretto e trasferire file tra HDFS e Amazon S3 con la massima semplicità. Ulteriori informazioni su Hue ed EMR.

Jupyter Notebook è un'applicazione web open source che consente di creare e condividere documenti che contengono codice in tempo reale, equazioni, visualizzazioni e testo narrativo. JupyterHub ti consente di eseguire l'hosting di più istanze di un unico server notebook Jupyter di un solo utente. Quando crei un cluster EMR con JupyterHub, EMR crea un container Docker sul nodo master del cluster. JupyterHub, tutti i componenti necessari per Jupyter e Sparkmagic vengono eseguiti all'interno del container.

Apache Zeppelin è un'interfaccia grafica open source che crea notebook interattivi e collaborativi per la visualizzazione di dati mediante Spark. Per manipolare i dati e visualizzare rapidamente i risultati, è possibile usare Scala, Python, SQL (tramite Spark SQL) o HiveQL. I notebook di Zeppelin possono essere condivisi tra diversi utenti, mentre le visualizzazioni possono essere pubblicate in pannelli di controllo esterni. Ulteriori informazioni su Zeppelin in EMR.

Pianificazione e flusso di lavoro

Apache Oozie è un sistema di pianificazione dei flussi di lavoro per Hadoop con cui è possibile creare grafi aciclici diretti o DAG (Directed Acyclic Graphs) di azioni. Inoltre consente di attivare i flussi di lavoro di Hadoop in base ad azioni o tempi predefiniti. Scopri di più su Oozie in EMR. AWS Step Functions ti consente di aggiungere alle tue applicazioni l'automazione del flusso di lavoro serverless. Le fasi del flusso di lavoro possono essere eseguite ovunque, ad esempio nelle funzioni AWS Lambda, su Amazon Elastic Compute Cloud (EC2) oppure in locale. Ulteriori informazioni su Step Functions in EMR.

Altri progetti e strumenti

EMR supporta inoltre una vasta gamma di strumenti e applicazioni molto comuni quali R, Apache Pig (elaborazione dati ed ETL), Apache Tez (esecuzione DAG complessa), Apache MXNet (deep learning), Ganglia (monitoraggio), Apache Sqoop (connettore di database relazionali), HCatalog (gestione di tabelle e storage) e molti altri. Il team di Amazon EMR gestisce un repository open source di operazioni di bootstrap che può essere usato per installare software aggiuntivi, configurare il cluster o semplicemente come esempio per scrivere le proprie operazioni di bootstrap.

Controllo degli accessi ai dati

Per impostazione predefinita, i procedimenti delle applicazioni di Amazon EMR utilizzano il profilo dell'istanza EC2 nell'ambito di altri servizi AWS. Per i cluster multi-tenant, Amazon EMR offre tre opzioni di gestione degli accessi degli utenti ai dati di Amazon S3.

L'integrazione con AWS Lake Formation permette di definire e gestire le policy di autorizzazione granulari in AWS Lake Formation per accedere ai database, alle tabelle e alle colonne nel catalogo dati di AWS Glue. Puoi applicare le policy di autorizzazione ai lavori inviati tramite Amazon EMR Notebooks e Apache Zeppelin per i carichi di lavoro interattivi di EMR Spark e puoi inviare gli eventi di audit ad AWS CloudTrail. Abilitando questa integrazione, abiliti anche il single sign-on federato in EMR Notebooks o Apache Zeppelin dai sistemi di identità aziendale compatibili con lo standard Security Assertion Markup Language (SAML) 2.0.

L'integrazione nativa con Apache Ranger permette di impostare un server nuovo o esistente di Apache Ranger per definire e gestire le policy di autorizzazione granulare per gli accessi degli utenti ai database, alle tabelle e alle colonne dei dati di Amazon S3 tramite Hive Metastore. Apache Ranger è uno strumento open-source che abilita, monitora e gestisce la sicurezza dei dati in modo completo sulla piattaforma Hadoop.

Questa integrazione nativa permette di definire tre tipi di policy di autorizzazione nel server di gestione delle policy di Apache Ranger. Puoi abilitare autorizzazioni a livello di tabella, colonna o riga per Hive, autorizzazioni a livello di tabella e colonna per Spark e autorizzazioni a livello di prefisso e oggetto per Amazon S3. Amazon EMR installa e configura automaticamente i plug-in di Apache Ranger corrispondenti nel cluster. Questi plug-in Ranger si sincronizzano con il server di gestione delle policy per le policy di autorizzazione, applicano il controllo degli accessi ai dati e inviano eventi di audit ad Amazon CloudWatch Logs.

Il mappatore di ruoli utente per Amazon EMR consente di sfruttare le autorizzazioni AWS IAM per gestire gli accessi alle risorse AWS. Puoi creare delle mappature tra utenti (o gruppi) o ruoli IAM personalizzati. Un utente o un gruppo può accedere solo ai dati permessi dal ruolo IAM personalizzato. Questa caratteristica è al momento disponibile tramite AWS Labs.

Esperienza ibrida coerente

AWS Outposts è un servizio completamente gestito che estende l'infrastruttura, i servizi, le API e gli strumenti AWS virtualmente a qualsiasi data center, spazio di co-location o struttura in locale per un'esperienza ibrida realmente omogenea. Amazon EMR su AWS Outposts permette di distribuire e gestire i cluster EMR nel data center utilizzando la stessa Console di gestione AWS, lo stesso Software Development Kit (SDK) e la stessa interfaccia a riga di comando (CLI) di EMR.

Funzionalità aggiuntive

Seleziona l’istanza corretta per il tuo cluster: è possibile scegliere i tipi di istanza EC2 da usare in un cluster (standard, memoria extra, CPU extra, I/O extra, ecc.) in base ai requisiti dell’applicazione. Avrai accesso root a qualsiasi istanza e potrai personalizzare completamente il cluster secondo le tue esigenze specifiche. Scopri di più sui tipi di istanze Amazon EC2 supportati. Amazon EMR ora consente di ridurre i costi fino al 30% e migliora le prestazioni del 15% per i carichi di lavoro Spark su istanze basate su Graviton2. Scopri di più nel nostro blog.

Debug delle applicazioni: quando si sceglie di eseguire il debug di un cluster, Amazon EMR archivia i file di log in Amazon S3 e li indicizza. Puoi quindi utilizzare un’interfaccia grafica nella console per esplorare i log e visualizzare la cronologia dei processi un'interfaccia grafica intuitiva. Scopri di più sul debug di processi di Amazon EMR.

Monitoraggio del cluster: è possibile usare Amazon CloudWatch per monitorare i parametri personalizzati di Amazon EMR, ad esempio il numero medio di attività di mappatura e riduzione. Sarà anche possibile assegnare allarmi ai parametri. Scopri di più sul monitoraggio di cluster Amazon EMR.

Risposta ad eventi: è possibile usare i tipi di evento correlati ad Amazon EMR in Amazon CloudWatch Events per rispondere a modifiche di stato di cluster Amazon EMR. Utilizzando regole semplici e rapide da impostare, sarà possibile creare corrispondenze tra eventi e instradarli in argomenti Amazon SNS, funzioni AWS Lambda, code Amazon SQS e non solo. Scopri di più sugli eventi nei cluster Amazon EMR.

Pianificazione di flussi di lavoro ricorrenti: con AWS Data Pipeline, è possibile pianificare i flussi di lavoro ricorrenti che si avvalgono di Amazon EMR. AWS Data Pipeline è un servizio Web che consente di elaborare e trasferire dati tra più servizi di elaborazione e storage AWS e origini dati locali, a specifici intervalli di tempo e con la massima affidabilità. Scopri di più su Amazon EMR e AWS Data Pipeline.

Deep learning: puoi usare i framework di deep learning più noti, ad esempio Apache MXNet, per definire, formare e distribuire reti neurali profonde. Tali framework possono essere utilizzati su cluster Amazon EMR con istanze GPU. Scopri di più su MXNet per Amazon EMR.

Controllo degli accessi di rete al cluster: è possibile avviare un cluster in un Amazon Virtual Private Cloud (VPC), una sezione logicamente isolata del cloud AWS. L'utente ha il controllo completo sul proprio ambiente virtuale di rete, incluse la selezione del proprio intervallo di indirizzi IP, la creazione di subnet e la configurazione di tabelle di routing e di gateway di rete. Scopri di più su Amazon EMR e Amazon VPC.

Gestione di utenti, autorizzazioni e crittografia: è possibile utilizzare gli strumenti di AWS Identity and Access Management (IAM), tra cui ruoli e utenti IAM, per tenere sotto controllo accessi e autorizzazioni. Per esempio, è possibile autorizzare un determinato utente ad accedere in lettura ma non in scrittura ai cluster. Inoltre, è possibile usare le configurazioni di sicurezza di Amazon EMR per impostare le opzioni di crittografia su dati inattivi o in transito, con supporto per la crittografia di Amazon S3 e l'autenticazione di Kerberos. Scopri di più su controllo degli accessi al cluster e opzioni di crittografia di Amazon EMR.

Installazione di software aggiuntivo: puoi utilizzare le operazioni di bootstrap o una Amazon Machine Image (AMI) personalizzata che esegue Amazon Linux per installare software aggiuntivo sul cluster. Le operazioni di bootstrap sono script eseguiti sui nodi del cluster in cui Amazon EMR avvia il cluster stesso. Vengono eseguiti prima dell'avvio di Hadoop e prima che il nodo avvii l'elaborazione dei dati. Inoltre, è possibile precaricare e utilizzare software su AMI Amazon Linux personalizzate. Scopri di più sulle operazioni di bootstrap di Amazon EMR e sulle AMI Amazon Linux personalizzate.

Copia efficiente dei dati: puoi trasferire elevati volumi di dati tra Amazon S3 e HDFS oppure tra i bucket di Amazon S3 utilizzando S3DistCp, un'estensione dello strumento open source Distcp di Amazon EMR, che utilizza MapReduce. Scopri di più su S3DistCp.

JAR personalizzati: puoi scrivere un programma in Java, compilarlo secondo la versione di Hadoop in uso e caricarlo in Amazon S3. Puoi quindi inviare processi di Hadoop al cluster mediante l'interfaccia JobClient di Hadoop. Scopri di più sull'elaborazione di JAR personalizzati con Amazon EMR.

Ulteriori informazioni sui prezzi di Amazon EMR