- Machine Learning›

- Amazon SageMaker AI›

- Amazon SageMaker AI MLOps

Amazon SageMaker para MLOps

Forneça modelos de ML em produção de alta performance rapidamente e em grande escala

Por que usar o Amazon SageMaker MLOps

Como funciona

Benefícios do SageMaker MLOps

Acelere o desenvolvimento de modelos

Provisione ambientes padronizados de ciência de dados

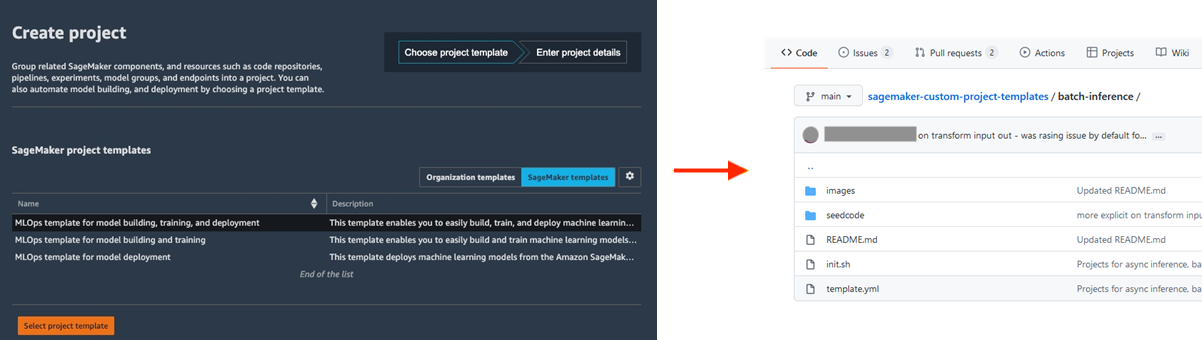

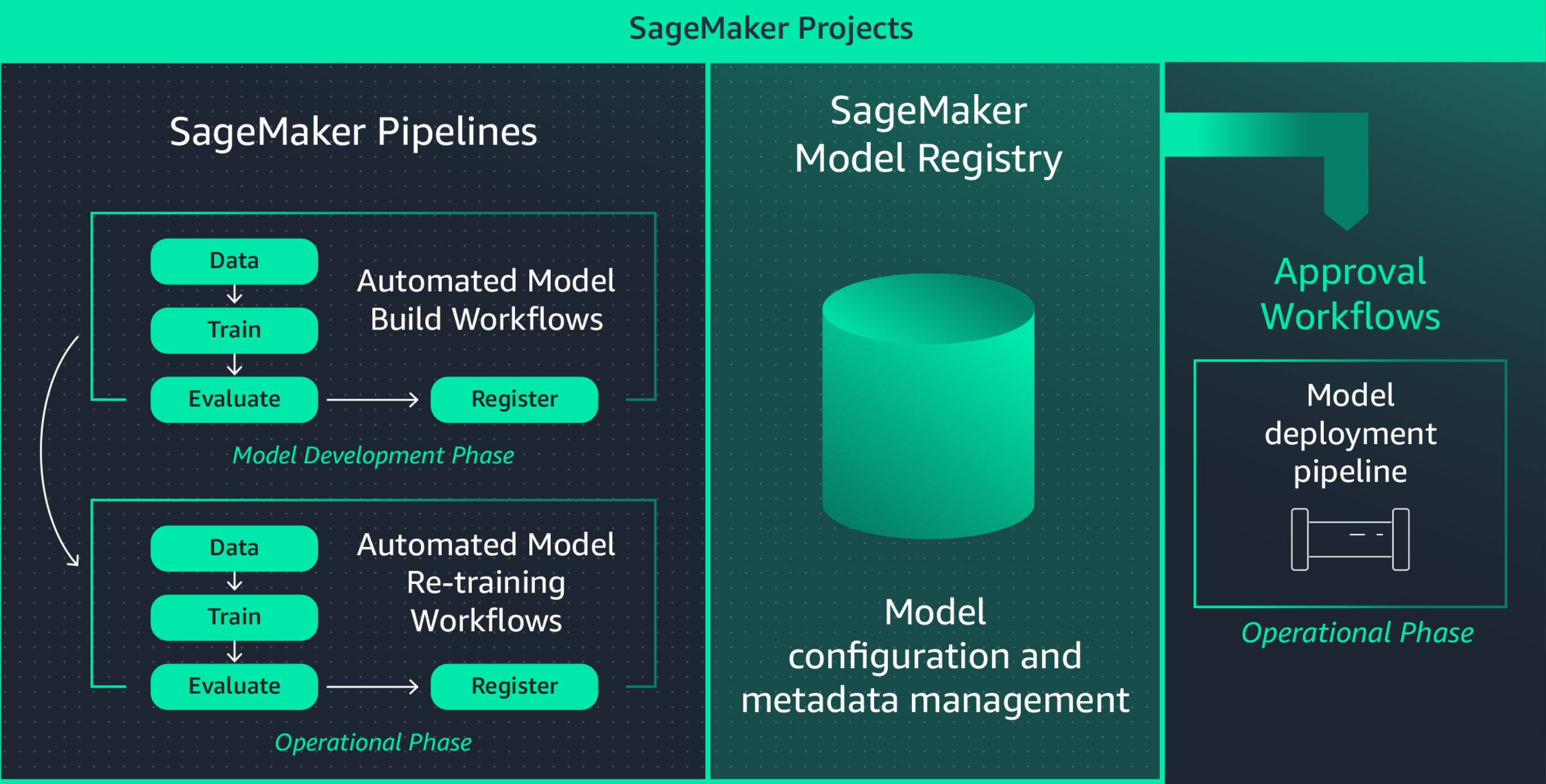

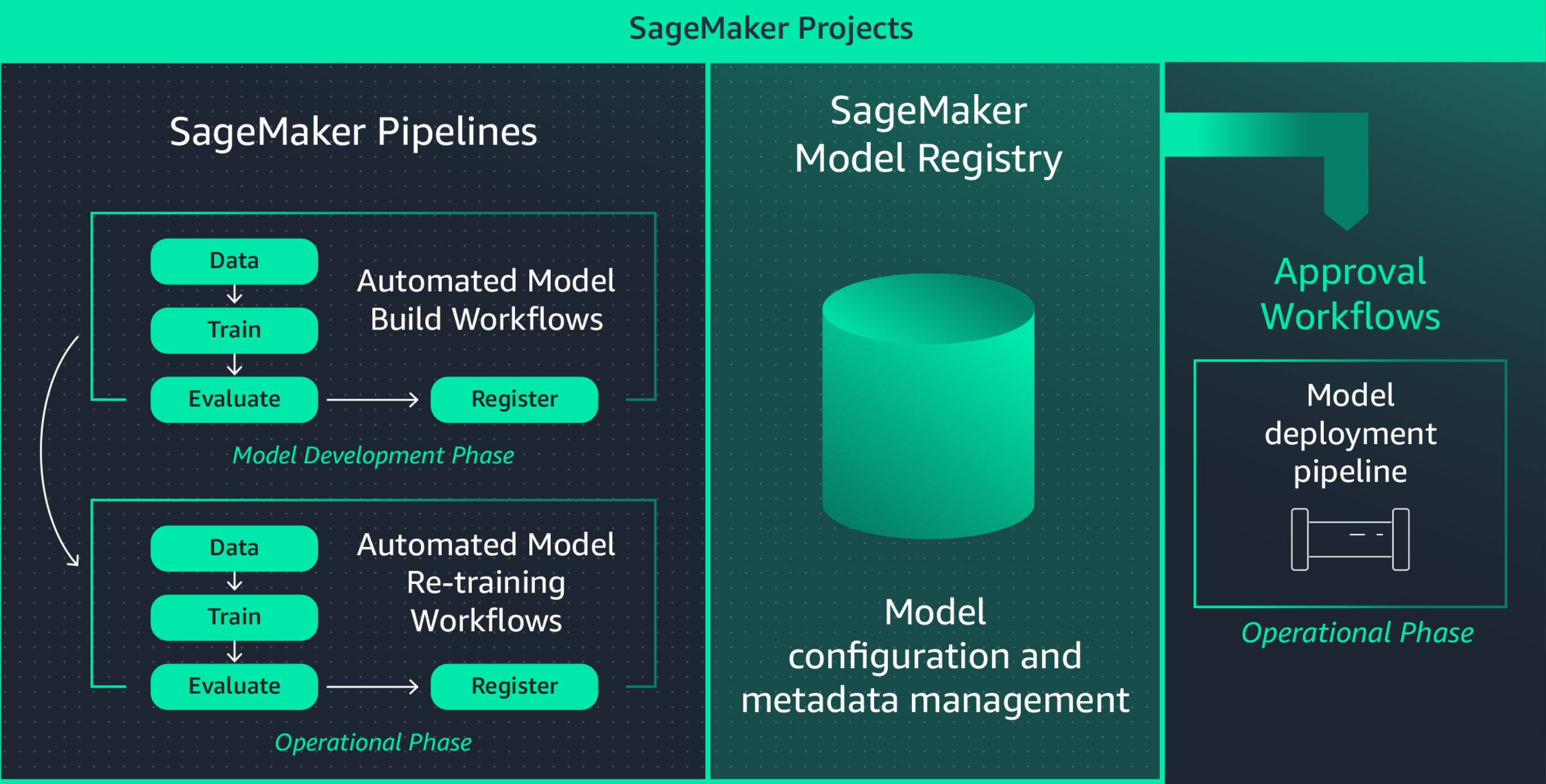

A padronização dos ambientes de desenvolvimento de ML aumenta a produtividade dos cientistas de dados e, em última análise, o ritmo da inovação, facilitando o lançamento de novos projetos, o rodízio de cientistas de dados entre projetos e a implementação de práticas recomendadas de ML. O Amazon SageMaker Projects oferece modelos para provisionar rapidamente ambientes padronizados para cientistas de dados com ferramentas e bibliotecas bem testadas e atualizadas, repositórios de controle de origem, código estereotipado e pipelines de CI/CD.

Colabore usando MLflow durante a experimentação de ML

A construção de modelos de ML é um processo iterativo que envolve o treinamento de centenas de modelos para encontrar o melhor algoritmo, arquitetura e parâmetros para otimizar a precisão do modelo. O MLflow permite que você acompanhe as entradas e saídas nessas iterações de treinamento, melhorando a repetibilidade das avaliações e promovendo a colaboração entre cientistas de dados. Com recursos de MLflow totalmente gerenciados, você pode criar servidores de rastreamento MLflow para cada equipe, facilitando a colaboração eficiente durante a experimentação de ML.

O Amazon SageMaker com MLflow gerencia o ciclo de vida de machine learning de ponta a ponta, simplificando o treinamento eficiente de modelos, rastreando experimentos e reprodutibilidade em diferentes estruturas e ambientes. Ele oferece uma interface única na qual você pode visualizar seus trabalhos de treinamento em andamento, compartilhar experimentos com os colegas e implantar modelos diretamente de um experimento.

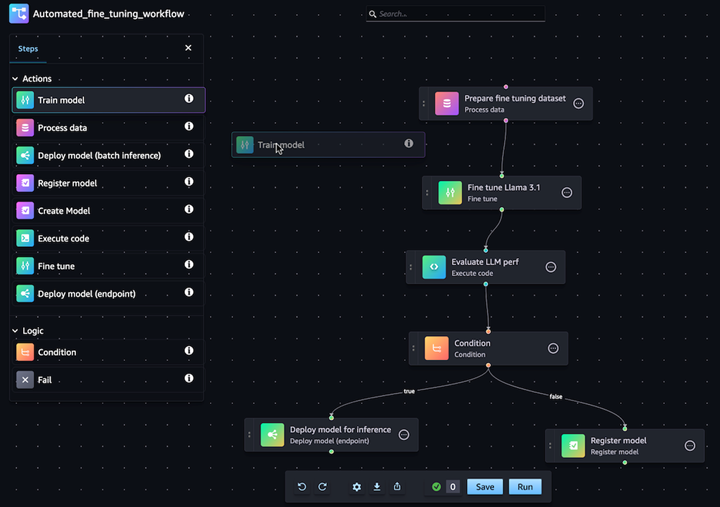

Automatize os fluxos de trabalho de personalização do modelo de IA generativa

Com o Amazon SageMaker Pipelines, você pode automatizar o fluxo de trabalho de ML de ponta a ponta para processamento de dados, treinamento de modelos, ajustes, avaliação e implantação. Crie seu próprio modelo ou personalize um modelo de base do SageMaker Jumpstart com alguns cliques no editor visual do Pipelines. Configure o SageMaker Pipelines para ser executado automaticamente em intervalos regulares ou quando determinados eventos são acionados (por exemplo, novos dados de treinamento no S3)

Implante e gerencie modelos facilmente em produção

Reproduza rapidamente seus modelos para solução de problemas

Muitas vezes, você precisa reproduzir modelos em produção para solucionar problemas com o comportamento de modelos e determinar a causa raiz. Para ajudar com isso, o Amazon SageMaker registra cada etapa do seu fluxo de trabalho, criando uma trilha de auditoria de artefatos de modelos, como dados de treinamento, definições de configuração, parâmetros de modelos e gradientes de aprendizado. Usando o rastreamento de linhagem, você pode recriar modelos para depurar possíveis problemas.

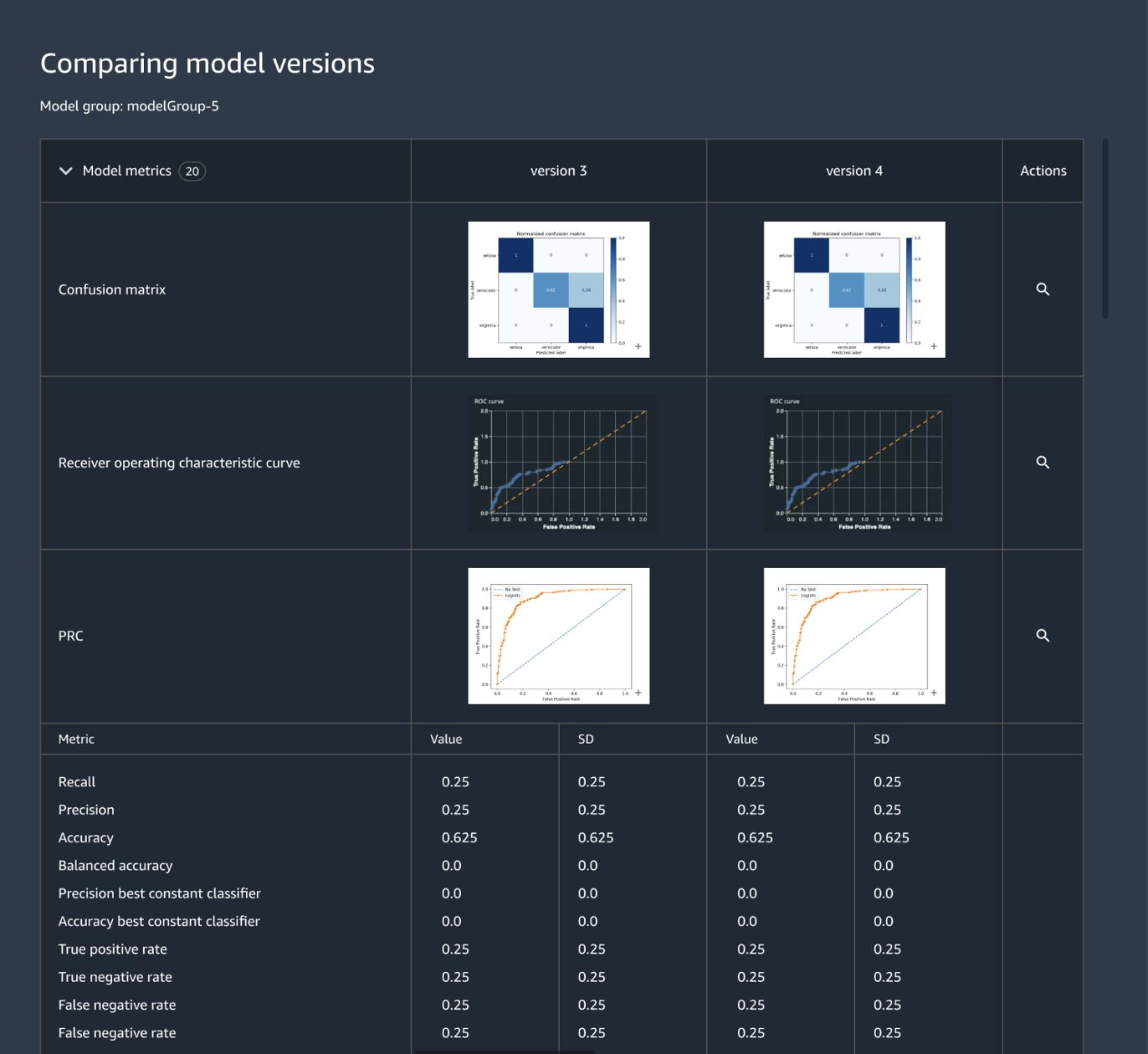

Rastreie e gerencie versões de modelos centralmente

A criação de uma aplicação de ML envolve o desenvolvimento de modelos, pipelines de dados, pipelines de treinamento e testes de validação. Usando o Amazon SageMaker Model Registry, você pode rastrear versões de modelos, seus metadados, como agrupamento de casos de uso, e referências a métricas de performance de modelos em um repositório central, onde é fácil escolher o modelo certo para implantação com base nas suas necessidades de negócios. Além disso, o SageMaker Model Registry registra fluxos de trabalho de aprovação automaticamente para auditoria e conformidade.

Defina a infraestrutura de ML por meio de código

A orquestração da infraestrutura por meio de arquivos de configuração declarativos, comumente chamada de “infraestrutura como código”, é uma abordagem popular para provisionar a infraestrutura de ML e implementar a arquitetura da solução exatamente conforme especificado por pipelines de CI/CD ou por ferramentas de implantação. Usando o Amazon SageMaker Projects, você pode escrever infraestrutura como código usando arquivos de modelos pré-criados.

Automatize fluxos de trabalho de integração e implantação (CI/CD)

Fluxos de trabalho de desenvolvimento de ML devem se integrar a fluxos de trabalho de integração e implantação para oferecer rapidamente novos modelos para aplicações de produção. O Amazon SageMaker Projects traz práticas de CI/CD para ML, como manter a paridade entre ambientes de desenvolvimento e produção, controle de origem e versão, testes A/B e automação de ponta a ponta. Como resultado, você coloca um modelo em produção assim que ele é aprovado e, dessa maneira, aumenta a agilidade.

Além disso, o Amazon SageMaker oferece defesas integradas para ajudar você a manter a disponibilidade dos endpoints e minimizar os riscos de implantação. O SageMaker se encarrega de configurar e orquestrar práticas recomendadas de implantação, como implantações azuis/verdes, para maximizar a disponibilidade e as integra a mecanismos de atualização de endpoints, como mecanismos de reversão automática, para ajudar você a identificar problemas automaticamente com antecedência e tomar medidas corretivas antes que eles afetem significativamente a produção.

Recicle o treinamento de modelos continuamente para manter a qualidade das previsões

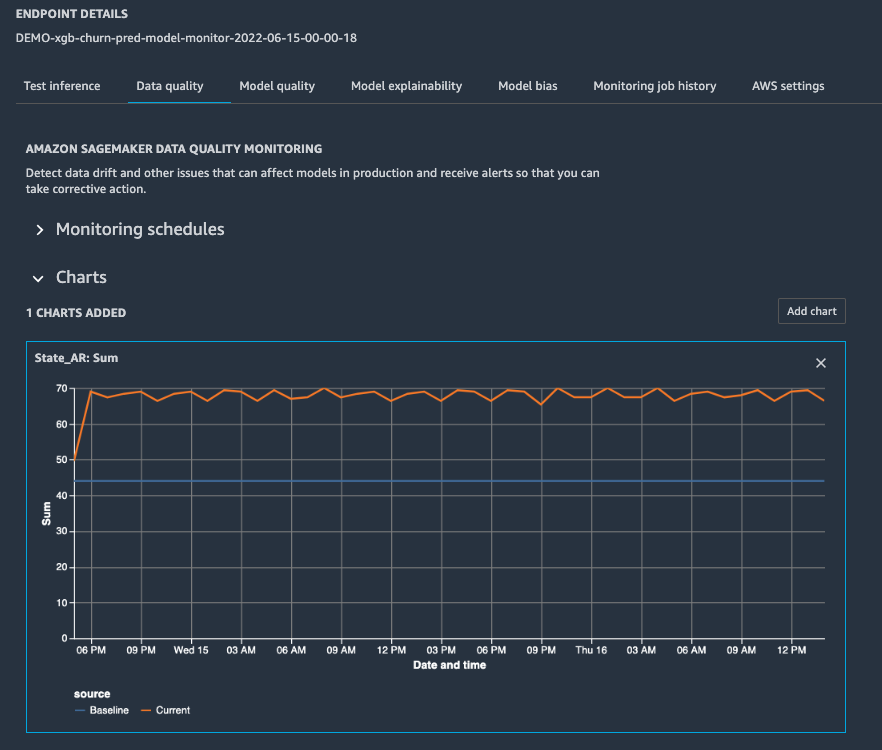

Depois que um modelo estiver em produção, você precisará monitorar sua performance, configurando alertas para que um cientista de dados de plantão possa solucionar o problema e acionar a reciclagem do treinamento. O Amazon SageMaker Model Monitor ajuda você a manter a qualidade, detectando desvios conceituais e de modelos em tempo real, bem como enviando alertas para que você possa tomar medidas imediatamente. O SageMaker Model Monitor monitora constantemente as características de performance dos modelos, como a precisão, que mede o número de previsões corretas em comparação com o número total de previsões, para que você possa lidar com quaisquer anomalias. O SageMaker Model Monitor é integrado ao SageMaker Clarify para melhorar a visibilidade de possíveis vieses.

Otimize a implantação de modelos para performance e custo

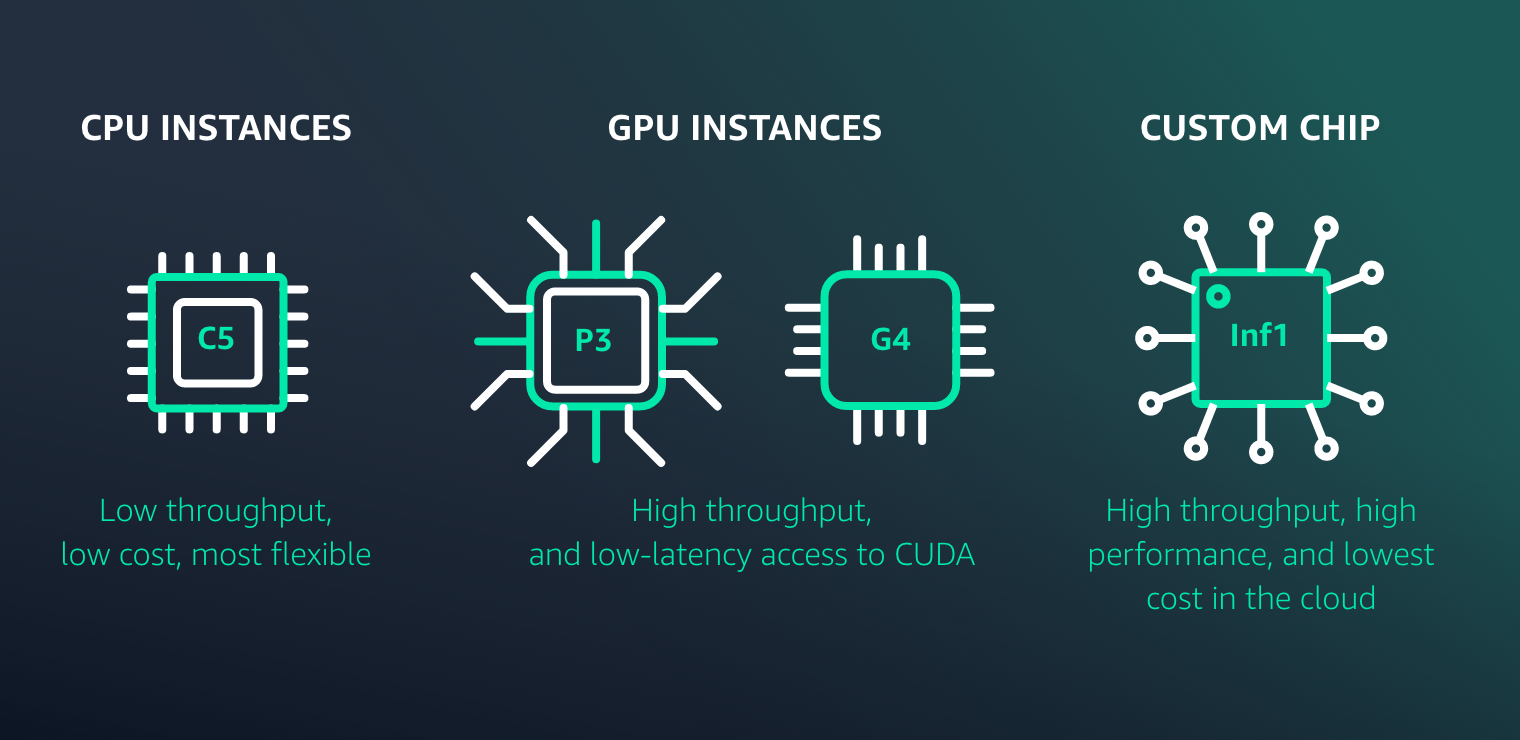

O Amazon SageMaker facilita a implantação de modelos de ML para inferência com alta performance e baixo custo para qualquer caso de uso. Ele fornece uma ampla seleção de opções de implantação de modelos e infraestrutura de ML para atender a todas as suas necessidades de inferência de ML.

Recursos para o SageMaker MLOps

Novidades

Execute experimentos do Amazon SageMaker Autopilot pelo Amazon SageMaker Pipelines para automatizar facilmente fluxos de trabalho de MLOps

30/11/2022

Amazon SageMaker Pipelines já oferece suporte a testes de fluxos de trabalho de machine learning em ambientes locais

17/08/2022

Amazon SageMaker Pipelines agora oferece suporte ao compartilhamento de entidades de pipeline entre contas

09/08/2022

O MLOps Workload Orchestrator adiciona suporte para o Amazon SageMaker Model Explainability e Model Bias Monitoring

02/02/2022

O Amazon SageMaker Pipelines agora oferece suporte ao controle de simultaneidade

21/01/2022