Phiên bản Amazon EC2 Inf1

Các doanh nghiệp thuộc nhiều ngành nghề đang tìm kiếm một phương thức chuyển đổi dựa trên trí tuệ nhân tạo (AI) để tăng tốc độ đổi mới, cải thiện trải nghiệm khách hàng và xử lý các cải tiến. Những mô hình máy học (ML) hỗ trợ ứng dụng AI đang ngày càng trở nên phức tạp hơn, từ đó làm tăng chi phí cơ sở hạ tầng điện toán. Chi phí suy luận có thể chiếm tới 90% trong tổng chi phí cơ sở hạ tầng cho hoạt động phát triển và chạy ứng dụng máy học (ML). Khách hàng đang rất cần những giải pháp cơ sở hạ tầng tiết kiệm chi phí để đưa các ứng dụng ML của họ vào sử dụng.

Các phiên bản Amazon EC2 Inf1 mang đến khả năng suy luận ML hiệu suất cao và chi phí thấp. Những phiên bản này cung cấp thông lượng cao gấp 2,3 lần với chi phí thấp hơn đến 70% trên mỗi suy luận so với các phiên bản Amazon EC2 tương đương. Các phiên bản Inf1 được xây dựng từ đầu để hỗ trợ các ứng dụng suy luận ML. Các phiên bản Inf1 này được trang bị tới 16 chip AWS Inferentia, loại chip suy luận ML hiệu năng cao do AWS thiết kế và xây dựng. Ngoài ra, các phiên bản Inf1 còn có bộ xử lý Intel Xeon Scalable thế hệ 2 cùng khả năng kết nối mạng lên tới 100 Gbps để mang đến khả năng suy luận thông lượng cao.

Khách hàng có thể dùng các phiên bản Inf1 để chạy các ứng dụng suy luận ML quy mô lớn, chẳng hạn như công cụ tìm kiếm, công cụ đề xuất, thị giác máy tính, nhận dạng giọng nói, xử lý ngôn ngữ tự nhiên (NLP), cá nhân hóa và phát hiện lừa đảo.

Các nhà phát triển có thể triển khai mô hình ML của họ trên các phiên bản Inf1 bằng cách dùng SDK AWS Neuron, bộ công cụ này được tích hợp với những khung ML phổ biến như TensorFlow, PyTorch và Apache MXNet. Họ có thể tiếp tục dùng các quy trình ML hiện tại và di chuyển liền mạch các ứng dụng sang các phiên bản Inf1 với ít thay đổi về mã và không phải phụ thuộc vào giải pháp cụ thể nào của nhà cung cấp.

Bắt đầu dễ dàng với các phiên bản Inf1 với Amazon SageMaker, AMI học sâu của AWS (DLAMI) được cấu hình sẵn với SDK Neuron hoặc Dịch vụ bộ chứa linh hoạt của Amazon (Amazon ECS) hoặc Dịch vụ Kubernetes linh hoạt Amazon (Amazon EKS) cho các ứng dụng ML có trong bộ chứa.

Lợi ích

Giảm tới 70% chi phí cho mỗi lần suy luận

Bằng cách dùng Inf1, nhà phát triển có thể giảm đáng kể chi phí triển khai ML để đưa vào sử dụng. Nhờ chi phí phiên bản thấp và thông lượng cao, các phiên bản Inf1 có chi phí trên mỗi suy luận thấp hơn tới 70% so với các phiên bản Amazon EC2 tương đương.

Tính dễ dùng và tính linh động về mã

SDK Neuron được tích hợp với các khung ML phổ biến như TensorFlow, PyTorch và MXNet. Nhà phát triển có thể tiếp tục dùng các quy trình ML hiện tại và tích hợp liền mạch ứng dụng lên các phiên bản Inf1 với chỉ một vài thay đổi rất nhỏ về mã. Nhờ đó, họ có thể thoải mái sử dụng khung ML ưa thích và nền tảng điện toán phù hợp yêu cầu cũng như các công nghệ mới nhất mà không phải phụ thuộc vào giải pháp cụ thể nào của nhà cung cấp.

Thông lượng cao gấp 2,3 lần

Các phiên bản Inf1 cung cấp thông lượng cao gấp 2,3 lần so với các phiên bản Amazon EC2 tương đương. Các chip AWS Inferentia mà phiên bản Inf1 sử dụng được thiết kế để tối ưu hóa hiệu suất suy luận cho kích thước lô nhỏ, cho phép các ứng dụng thời gian thực tối đa hóa thông lượng và đáp ứng các yêu cầu về độ trễ.

Độ trễ cực thấp

Chip của AWS Inferentia được trang bị bộ nhớ lớn gắn trên chip, cho phép lưu trực tiếp các mô hình ML vào bộ nhớ đệm trên chính các chip này. Bạn có thể triển khai mô hình của mình bằng các chức năng như Quy trình NeuronCore để không phải sử dụng đến các tài nguyên bộ nhớ bên ngoài. Với các phiên bản Inf1, bạn có thể triển khai ứng dụng suy luận theo thời gian thực với độ trễ cận thời gian thực mà không làm ảnh hưởng tới băng thông.

Hỗ trợ cho nhiều mô hình ML và kiểu dữ liệu khác nhau

Các phiên bản Inf1 hỗ trợ nhiều kiến trúc mô hình ML thông dụng như SSD, VGG và ResNext để nhận biết/phân loại hình ảnh, cũng như Transformer và BERT để xử lý ngôn ngữ tự nhiên (NLP). Ngoài ra, việc hỗ trợ kho mô hình HuggingFace trong Neuron mang đến cho khách hàng khả năng biên dịch và chạy suy luận dễ dàng bằng các mô hình đào tạo sẵn hoặc mô hình được tinh chỉnh mà chỉ cần thay đổi một dòng mã. Nhiều loại dữ liệu, trong đó có BF16 và FP16, với độ chính xác hỗn hợp cũng được hỗ trợ để đáp ứng nhiều mô hình và nhu cầu hiệu suất khác nhau.

Tính năng

Được AWS Inferentia cung cấp

AWS Inferentia là chip ML được AWS xây dựng cho mục đích nhất định nhằm cung cấp khả năng suy luận hiệu năng cao với chi phí thấp. Mỗi chip AWS Inferentia sẽ có bốn NeuronCore thế hệ đầu tiên và có hiệu suất lên đến 128 nghìn tỷ hoạt động mỗi giây (TOPS). Loại chip này cũng hỗ trợ các loại dữ liệu FP16, BF16 và INT8. Chip AWS Inferentia còn nổi bật ở bộ nhớ dung lượng lớn trên chip, có thể dùng để lưu các mô hình lớn vào bộ đệm. Điều này đặc biệt hữu ích đối với các mô hình đòi hỏi truy cập thường xuyên vào bộ nhớ.

Triển khai với khung ML phổ biến bằng AWS Neuron

SDK AWS Neuron bao gồm trình biên dịch, trình điều khiển thời gian hoạt động và các công cụ phân tích hiệu suất. Bộ công cụ này cho phép bạn triển khai các phiên bản Amazon Inf1 để thực thi những mô hình mạng nơ-ron phức tạp được tạo và đào tạo trong các khung phổ biến như TensorFlow, PyTorch và MXNet. Với Quy trình NeuronCore, bạn có thể phân tách mô hình lớn để thực thi trên nhiều chip Inferentia nhờ sự liên kết vật lý tốc độ cao giữa các chip, qua đó mang đến thông lượng suy luận cao và chi phí suy luận thấp hơn.

Kết nối mạng và lưu trữ hiệu năng cao

Các phiên bản Inf1 cung cấp thông lượng mạng lên tới 100 Gbps cho các ứng dụng yêu cầu khả năng kết nối mạng tốc độ cao. Bộ điều hợp mạng linh hoạt (ENA) thế hệ tiếp theo và công nghệ NVM Express (NVMe) cung cấp những giao diện thông lượng cao, độ trễ thấp cho việc kết nối mạng và Kho lưu trữ khối linh hoạt của Amazon (Amazon EBS) cho các phiên bản Inf1.

Được phát triển trên hệ thống AWS Nitro

Hệ thống AWS Nitro là một tập hợp đa dạng các khối dựng, giúp giảm tải nhiều chức năng ảo hóa truyền thống sang phần cứng và phần mềm chuyên dụng để mang lại hiệu suất cao, tính sẵn sàng cao và độ bảo mật cao, đồng thời giảm tổng chi phí ảo hóa.

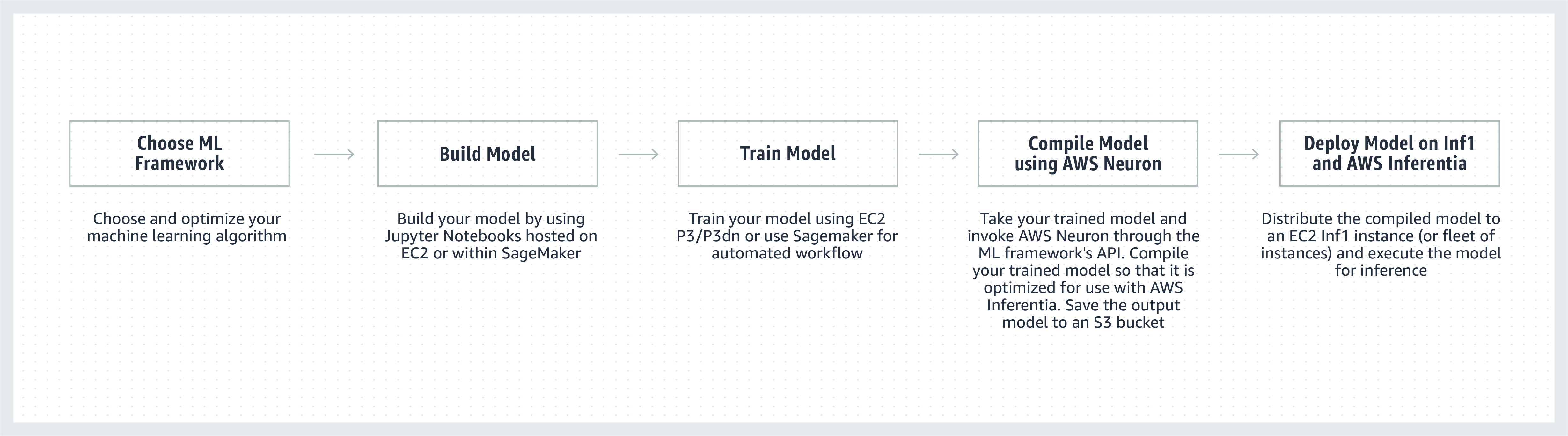

Cách hoạt động

Chứng thực từ khách hàng

Được thành lập năm 2008, Airbnb với trụ sở tại San Francisco là một thị trường cộng đồng với hơn 4 triệu chủ trọ. Các chủ trọ này đã tiếp đón hơn 900 triệu lượt khách ở hầu khắp mọi quốc gia trên thế giới.

"Nền tảng hỗ trợ cộng đồng của Airbnb mang đến các trải nghiệm dịch vụ thông minh, có quy mô linh hoạt và vượt trội cho cộng đồng với hàng triệu khách hàng và chủ trọ trên khắp thế giới. Chúng tôi không ngừng tìm kiếm cách thức để cải thiện hiệu suất của mô hình NLP mà các ứng dụng chatbot hỗ trợ của chúng tôi sử dụng. Với phiên bản Amazon EC2 Inf1 được cung cấp bởi AWS Inferentia, chúng tôi nhận thấy hiệu suất của thông lượng ngay từ đầu đã tăng gấp 2 lần so với các phiên bản dựa trên GPU dành cho mô hình BERT dựa trên PyTorch của mình. Chúng tôi mong muốn tận dụng phiên bản Inf1 cho các mô hình và trường hợp sử dụng khác trong tương lai.”

Bo Zeng, Giám đốc kỹ thuật của Airbnb

“Chúng tôi đã tích hợp công nghệ ML vào nhiều khía cạnh của Snapchat. Trong lĩnh vực này, việc khám phá sự đổi mới là ưu tiên hàng đầu. Khi nghe về Inferentia, chúng tôi đã cộng tác với AWS để áp dụng các phiên bản Inf1/Inferentia nhằm hỗ trợ việc triển khai ML xoay quanh hiệu năng và chi phí. Chúng tôi bắt đầu từ mô hình đề xuất và trong tương lai, chúng tôi sẽ tìm cách triển khai những mô hình khác bằng các phiên bản Inf1.”

Nima Khajehnouri, Phó chủ tịch phụ trách kỹ thuật của Snap Inc.

“Nền tảng quản lý trải nghiệm người dùng thống nhất (Unified-CXM) định hướng AI của Sprinklr cho phép các công ty thu thập và chuyển đổi phản hồi của khách hàng theo thời gian thực trên nhiều kênh thành những thông tin chuyên sâu hữu ích – từ đó chủ động giải quyết vấn đề, tăng cường phát triển sản phẩm, cải thiện quá trình tiếp thị nội dung, nâng cao dịch vụ khách hàng, v.v. Bằng cách sử dụng Amazon EC2 Inf1, chúng tôi đã có thể cải thiện đáng kể hiệu suất của một trong những mô hình NLP cũng như một trong những mô hình thị giác máy tính của chúng tôi. Chúng tôi mong muốn tiếp tục sử dụng Amazon EC2 Inf1 để phục vụ những khách hàng toàn cầu của mình tốt hơn.”

Vasant Srinivasan, Phó chủ tịch cấp cao về kỹ thuật sản phẩm của Sprinklr

"Sản phẩm NLP Finch for Text tiên tiến của chúng tôi cung cấp cho người dùng khả năng trích xuất, phân định nghĩa cũng như làm phong phú thêm nhiều loại thực thể nằm trong khối lượng văn bản khổng lồ. Finch for Text cần khá nhiều tài nguyên điện toán để cung cấp cho máy khách của chúng tôi những tính năng bổ sung có độ trễ thấp trên nguồn cấp dữ liệu toàn cầu. Chúng tôi hiện đang sử dụng các phiên bản AWS Inf1 trong những mô hình PyTorch NLP, dịch thuật và xác định thực thể. Chúng tôi có thể giảm trên 80% chi phí suy luận (so với GPU) với những mục tối ưu hóa ở mức tối thiểu, đồng thời vẫn duy trì được tốc độ cũng như hiệu suất suy luận của mình. Sự cải tiến này cho phép các khách hàng của chúng tôi làm phong phú thêm văn bản bằng tiếng Pháp, Tây Ban Nha, Đức và Hà Lan theo thời gian thực trên nguồn cấp dữ liệu truyền liên tục và trên quy mô toàn cầu – điều này có ý nghĩa quan trọng đối với các dịch vụ tài chính, công cụ tổng hợp dữ liệu và khách hàng ở khu vực công của chúng tôi.”

Scott Lightner, Giám đốc công nghệ của Finch Computing

“Chúng tôi cảnh báo về nhiều loại sự kiện trên toàn thế giới bằng nhiều ngôn ngữ, ở các định dạng khác nhau (hình ảnh, video, âm thanh, cảm biến văn bản, kết hợp tất cả các loại này) từ hàng trăm nghìn nguồn. Tối ưu hóa tốc độ và chi phí với quy mô đó là điều vô cùng quan trọng đối với doanh nghiệp của chúng tôi. Với AWS Inferentia, chúng tôi đã giảm độ trễ của mô hình và đạt được thông lượng tốt hơn tới 9 lần trên mỗi đồng tiền. Điều này đã cho phép chúng tôi tăng độ chính xác của mô hình và phát triển khả năng của nền tảng bằng cách triển khai các mô hình DL tinh vi hơn và xử lý khối lượng dữ liệu gấp 5 lần, đồng thời vẫn kiểm soát được chi phí.”

Alex Jaimes, Giám đốc khoa học và Phó chủ tịch cấp cao về AI của Dataminr

"Autodesk đang sử dụng Inferentia để cải tiến công nghệ nhận thức cho trợ lý ảo hoạt động dựa trên AI của mình, với tên gọi Autodesk Virtual Agent (AVA). AVA có thể trả lời 100.000 câu hỏi của khách hàng mỗi tháng bằng cách áp dụng hệ thống hiểu ngôn ngữ tự nhiên (NLU) và các kỹ thuật học sâu (DL) để rút ra ngữ cảnh, ý định và ý nghĩa đằng sau các câu hỏi. Với việc thí điểm Inferentia, chúng tôi đạt được mức thông lượng qua G4dn cao hơn 4,9 lần cho các mô hình NLU của mình và sẽ tìm cách chạy thêm khối lượng công việc trên các phiên bản Inf1 dựa trên Inferentia.”

Binghui Ouyang, Nhà khoa học dữ liệu cấp cao của Autodesk

Các dịch vụ Amazon sử dụng phiên bản Amazon EC2 Inf1

Amazon Advertising giúp các doanh nghiệp thuộc mọi quy mô kết nối với khách hàng ở tất cả các giai đoạn trên hành trình mua sắm của họ. Hàng triệu quảng cáo, bao gồm văn bản và hình ảnh, được điều chỉnh, phân loại và phân phối để mang đến trải nghiệm khách hàng tối ưu mỗi ngày.

“Để xử lý quảng cáo dạng văn bản, chúng tôi triển khai trên toàn cầu mô hình BERT dựa vào PyTorch trên phiên bản Inf1 sử dụng AWS Inferentia. Nhờ việc di chuyển từ GPU sang Inferentia, chúng tôi đã có thể giảm 69% chi phí với hiệu suất tương đương. Chúng tôi chỉ dành ra không đến ba tuần để biên soạn và kiểm thử mô hình cho AWS Inferentia. Khi sử dụng Amazon SageMaker để triển khai các mô hình của mình cho phiên bản Inf1, việc triển khai được đảm bảo là có thể thay đổi quy mô và dễ quản lý. Khi tôi lần đầu tiên phân tích các mô hình đã biên soạn, hiệu suất với AWS Inferentia ấn tượng đến mức tôi phải chạy lại các điểm quy chuẩn để đảm bảo tính chính xác của chúng! Trong tương lai, chúng tôi dự định chuyển các mô hình xử lý quảng cáo hình ảnh của mình sang Inferentia. Chúng tôi đã tiến hành đo lường theo quy chuẩn và nhận thấy độ trễ thấp hơn 30% và tiết kiệm 71% chi phí so với các phiên bản dựa trên GPU tương đương cho những mô hình này.”

Yashal Kanungo, Nhà khoa học ứng dụng của Amazon Advertising

Đọc blog tin tức »

“Thông qua AWS, công nghệ trí tuệ dựa trên AI và ML của Amazon Alexa hiện nay đã có mặt trên hơn 100 triệu thiết bị. Chúng tôi cam kết với khách hàng rằng Alexa sẽ ngày càng trở nên thông minh hơn, giao tiếp tốt hơn, chủ động hơn và thậm chí là dễ thương hơn. Để thực hiện lời hứa đó, chúng tôi sẽ phải liên tục cải thiện thời gian phản hồi và giảm bớt chi phí cơ sở hạ tầng ML, vì vậy, chúng tôi rất vui mừng khi có thể sử dụng Amazon EC2 Inf1 để giảm bớt độ trễ suy luận và chi phí của mỗi lần suy luận cho chức năng chuyển văn bản thành lời nói của Alexa. Với Amazon EC2 Inf1, chúng tôi sẽ có thể cung cấp dịch vụ tốt hơn nữa cho hàng chục triệu khách hàng đang sử dụng Alexa mỗi tháng.”

Tom Taylor, Phó chủ tịch cấp cao, Amazon Alexa

"Chúng tôi không ngừng đổi mới để cải thiện hơn nữa trải nghiệm của khách hàng cũng như giảm chi phí cơ sở hạ tầng. Chúng tôi di chuyển khối lượng công việc về giải đáp thắc mắc trên nền tảng web (WBQA) từ phiên bản P3 dựa trên GPU sang phiên bản Inf1 dựa trên AWS Inferentia, việc này không chỉ giúp chúng tôi giảm 60% chi phí suy luận mà còn cải thiện hơn 40% độ trễ đầu cuối, từ đó giúp nâng cao trải nghiệm giải đáp thắc mắc của khách hàng với Alexa. Nhờ sử dụng Amazon SageMaker cho mô hình dựa trên TensorFlow của chúng tôi, quy trình chuyển sang các phiên bản Inf1 trở nên đơn giản và dễ quản lý. Chúng tôi hiện đang sử dụng các phiên bản Inf1 trên toàn cầu để chạy những khối lượng công việc WBQA này, đồng thời tối ưu hóa hiệu suất của chúng cho AWS Inferentia để giảm hơn nữa chi phí và độ trễ.”

Eric Lind, Kỹ sư phát triển phần mềm của Alexa AI

“Amazon Prime Video sử dụng các mô hình ML thị giác máy tính để phân tích chất lượng video của các sự kiện trực tiếp nhằm đảm bảo trải nghiệm người xem tối ưu cho các thành viên của Prime Video. Chúng tôi đã triển khai các mô hình ML phân loại hình ảnh trên những phiên bản EC2 Inf1 và có thể nhận thấy hiệu suất được cải thiện gấp 4 lần, đồng thời tiết kiệm lên đến 40% chi phí. Hiện giờ, chúng tôi đang tìm cách để tận dụng những khoản chi phí tiết kiệm được này để đổi mới và xây dựng các mô hình tiên tiến có thể phát hiện nhiều sai sót phức tạp hơn, chẳng hạn như lỗ hổng đồng bộ hóa giữa tệp âm thanh và video để mang lại trải nghiệm xem được nâng cao hơn cho các thành viên của Prime Video.”

Victor Antonino, Kiến trúc sư giải pháp của Amazon Prime Video

“Amazon Rekognition là ứng dụng phân tích hình ảnh/video đơn giản và tiện dụng, giúp khách hàng xác định vật thể, con người, văn bản và hoạt động. Amazon Rekognition cần cơ sở hạ tầng DL hiệu năng cao, có thể phân tích hàng tỷ hình ảnh và video mỗi ngày cho khách hàng. Với các phiên bản Inf1 dựa trên AWS Inferentia, việc chạy các mô hình Amazon Rekognition như phân loại vật thể sẽ có độ trễ thấp hơn 8 lần và thông lượng cao hơn 2 lần so với khi chạy những mô hình này trên GPU. Dựa vào những kết quả này, chúng tôi đang chuyển Amazon Rekognition sang Inf1 để khách hàng có thể nhận được kết quả nhanh và chính xác hơn.”

Rajneesh Singh, Giám đốc, Kỹ sư phần mềm của Amazon Rekognition and Video

Giá cả

*Mức giá trình bày ở trên dành cho Khu vực AWS Miền Đông Hoa Kỳ (Bắc Virginia). Các mức giá cho phiên bản đặt trước 1 năm và 3 năm là dành cho các tùy chọn thanh toán "Trả trước một phần" hoặc "Không trả trước" đối với phiên bản không có tùy chọn Trả trước một phần.

Phiên bản Amazon EC2 Inf1 được cung cấp dưới dạng Theo nhu cầu, Đặt trước hoặc Phiên bản dùng ngay ở Khu vực AWS Miền Đông Hoa Kỳ (Bắc Virginia) và Miền Tây Hoa Kỳ (Oregon).

Bắt đầu

Sử dụng Amazon SageMaker

SageMaker giúp bạn biên soạn và triển khai mô hình ML đã đào tạo của mình dễ dàng hơn để đưa vào sử dụng trên các phiên bản Amazon Inf1. Nhờ đó, bạn có thể bắt đầu tạo ra những dự đoán theo thời gian thực với độ trễ thấp. AWS Neuron là công cụ biên soạn cho AWS Inferentia, được tích hợp với Amazon SageMaker Neo, giúp bạn biên soạn các mô hình ML đã đào tạo của mình để chạy tối ưu trên phiên bản Inf1. Với SageMaker, bạn có thể dễ dàng chạy mô hình của mình trên các cụm tự động thay đổi quy mô của phiên bản Inf1, trải rộng khắp nhiều Vùng sẵn sàng, mang lại cả hiệu năng cao lẫn khả năng suy luận theo thời gian thực có độ sẵn sàng cao. Tìm hiểu cách triển khai trên phiên bản Inf1 bằng dịch vụ SageMaker với các ví dụ trên GitHub.

Sử dụng DLAMI

DLAMI cung cấp cho các học viên và nhà nghiên cứu ML cơ sở hạ tầng và công cụ để tăng tốc DL trên đám mây, ở mọi quy mô. SDK AWS Neuron được cài đặt sẵn trong DLAMI để biên soạn và chạy các mô hình ML của bạn một cách tối ưu trên các phiên bản Inf1. Để được hướng dẫn về quá trình bắt đầu, bạn hãy tham khảo hướng dẫn lựa chọn AMI và các tài nguyên DL khác. Xem tài liệu hướng dẫn Bắt đầu sử dụng DLAMI của AWS để tìm hiểu cách dùng DLAMI với Neuron.

Sử dụng bộ chứa học sâu

Giờ đây, các nhà phát triển có thể triển khai phiên bản Inf1 trong Amazon EKS, một dịch vụ Kubernetes được quản lý toàn phần cũng như trong Amazon ECS, dịch vụ điều phối bộ chứa được quản lý toàn phần của Amazon. Tìm hiểu thêm cách bắt đầu sử dụng Inf1 trên Amazon EKS hoặc với Amazon ECS. Bạn có thể tìm thêm thông tin chi tiết về cách chạy bộ chứa trong phiên bản Inf1 trên trang hướng dẫn về công cụ bộ chứa Neuron. Neuron cũng được cài đặt sẵn trong Bộ chứa học sâu của AWS.

Blog và bài viết

Cách Amazon Search giảm 85% chi phí suy luận ML bằng AWS Inferentia

bởi Joao Moura, Jason Carlson, Jaspreet Singh, Shaohui Xi, Shruti Koparkar, Haowei Sun, Weiqi Zhang và Zhuoqi Zhangs, 22/09/2022

Cơ sở hạ tầng máy học hiệu suất cao, chi phí thấp đang thúc đẩy sự đổi mới trong đám mây

Tác giả: MIT Technology Review Insights, 01/11/2021

Tác giả: Davide Galliteli và Hasan Poonawala, 19/10/2021

Máy học trên đám mây sẽ giúp các doanh nghiệp đổi mới

Tác giả: MIT Technology Review Insights, 15/10/2021

AWS Inferentia cung cấp 3.000 mô hình deep learning trên Amazon EKS với giá chưa đến 50 USD/giờ

Tác giả: Alex Iankoulski, Joshua Correa, Mahadevan Balasubramaniam và Sundar Ranganatha, 30/09/2021

Tác giả: Fabio Nonato de Paula và Mahadevan Balasubramaniam, ngày 04/05/2021

Tác giả: Binghui Ouyang, ngày 07/04/2021

Phần lớn Alexa hiện đang chạy trên các phiên bản Amazon EC2 Inf1 nhanh hơn, tiết kiệm chi phí hơn

Tác giả: Sébastien Stormacq, ngày 12/11/2020

Tác giả: Julien Simon, ngày 22/04/2020

Amazon ECS hiện hỗ trợ phiên bản EC2 Inf1

Tác giả Julien Simon, 14/08/2020

Tác giả: Fabio Nonato De Paula và Haichen Li, 22/07/2020

Amazon EKS hiện hỗ trợ phiên bản EC2 Inf1

Tác giả: Julien Simon, ngày 15/06/2020

Tác giả: Jeff Barr, ngày 03/12/2019

Tác giả: Gadi Hutt, ngày 28/09/2020