- Machine Learning›

- Amazon SageMaker AI›

- Amazon SageMaker mit MLflow

Beschleunigen der Entwicklung generativer KI mit Amazon SageMaker AI und MLflow

Experimente verfolgen, Modelle bewerten und KI-Anwendungen ohne Infrastrukturmanagement nachverfolgen

Warum Amazon SageMaker AI mit MLflow verwenden?

Die Entwicklung und Anpassung von KI-Modellen ist ein iterativer Prozess, der Hunderte von Trainingsdurchläufen umfasst, um den besten Algorithmus, die beste Architektur und die besten Parameter für eine optimale Modellgenauigkeit zu finden. Amazon SageMaker AI bietet eine verwaltete, Serverless-MLflow-Funktion, mit der KI-Entwickler auf einfache Weise Experimente verfolgen, Verhaltensweisen beobachten und die Leistung ihrer KI-Modelle und -Anwendungen bewerten können, ohne sich um die Verwaltung der Infrastruktur kümmern zu müssen. SageMaker AI mit MLflow ist außerdem in bekannte SageMaker-AI-Modellentwicklungstools wie SageMaker AI JumpStart, Model Registry, Pipelines und Serverless-Modellanpassungsfunktionen integriert, damit Sie jeden Schritt des KI-Lebenszyklus miteinander verbinden können – vom Experimentieren bis zur Bereitstellung.

Vorteile von Amazon SageMaker AI mit MLflow

Beginnen Sie mit der Nachverfolgung von Experimenten und KI-Anwendungen, ohne dass Sie Infrastruktur bereitstellen oder Tracking-Server konfigurieren müssen. KI-Entwickler erhalten sofortigen Zugriff auf eine Serverless-MLflow-Funktion, mit der sich Ihr Team auf die Entwicklung von KI-Anwendungen konzentrieren kann, anstatt sich um die Verwaltung der Infrastruktur zu kümmern.

SageMaker AI mit MLflow passt sich automatisch an Ihre Anforderungen an, unabhängig davon, ob Sie ein einzelnes Experiment durchführen oder Hunderte von parallelen Feinabstimmungsaufträgen verwalten. MLflow passt Ihre Infrastruktur während intensiver Experimentierphasen an und skaliert sie in ruhigeren Zeiten ohne manuellen Eingriff zurück, wodurch eine konsistente Leistung ohne den Betriebsaufwand für die Verwaltung von Servern gewährleistet wird.

Über eine einzige Schnittstelle können Sie den Fortschritt von Trainingsjobs visualisieren, während der Experimentierphase mit Teammitgliedern zusammenarbeiten und die Versionsverwaltung für jedes Modell und jede Anwendung pflegen. MLflow bietet außerdem erweiterte Rückverfolgungsfunktionen, mit denen Sie die Ursache von Fehlern oder unerwarteten Verhaltensweisen schnell identifizieren können.

Im Zuge der Weiterentwicklung des MLflow-Projekts können SageMaker-AI-Kunden weiterhin von den Innovationen der Open-Source-Community profitieren und gleichzeitig den Serverless-Support von AWS nutzen.

Amazon SageMaker AI mit MLflow wird automatisch auf die neueste Version von MLflow aktualisiert, sodass Sie ohne Wartungsfenster oder Migrationsaufwand Zugriff auf die neuesten Funktionen und Fähigkeiten haben.

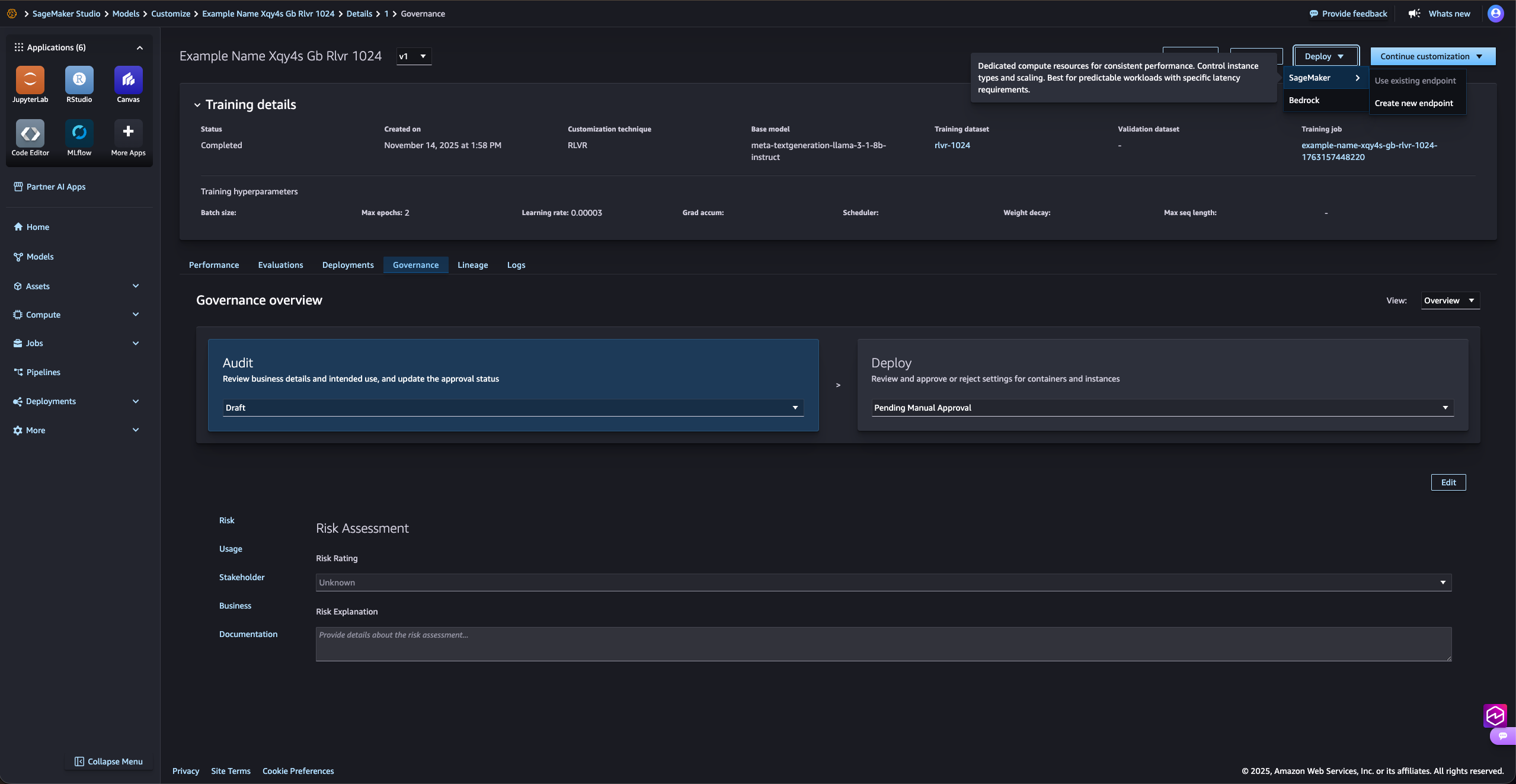

Optimieren Sie die Anpassung von KI-Modellen

Mit MLflow auf SageMaker AI können Sie Experimente nachverfolgen, organisieren und vergleichen, um Ihre leistungsstärksten Modelle zu identifizieren. MLflow ist in die Serverless-Modellanpassungsfunktionen von Amazon SageMaker AI für beliebte Modelle wie Amazon Nova, Llama, Qwen, DeepSeek und GPT-OSS integriert, sodass Sie laufende Trainingsjobs und Bewertungen über eine einzige Schnittstelle visualisieren können.

Konsistenz durch zeitnahe Verwaltung

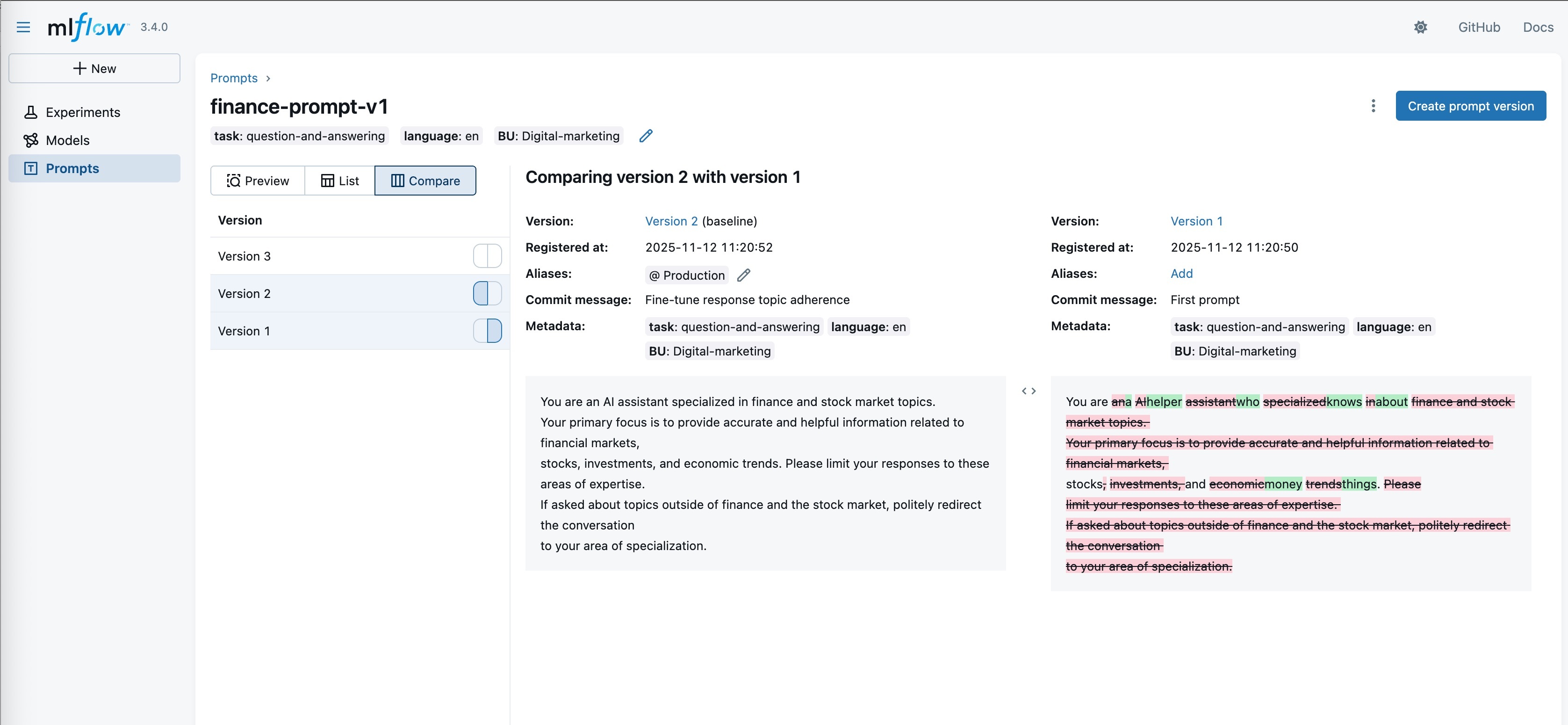

Mit MLflow Prompt Registry können Sie Prompt-Engineering und -Verwaltung in Ihren KI-Anwendungen optimieren. Diese leistungsstarke Funktion ermöglicht es Ihnen, Prompts in Ihrem gesamten Unternehmen zu versionieren, zu verfolgen und wiederzuverwenden, wodurch die Konsistenz gewahrt und die Zusammenarbeit bei der Prompt-Entwicklung verbessert wird.

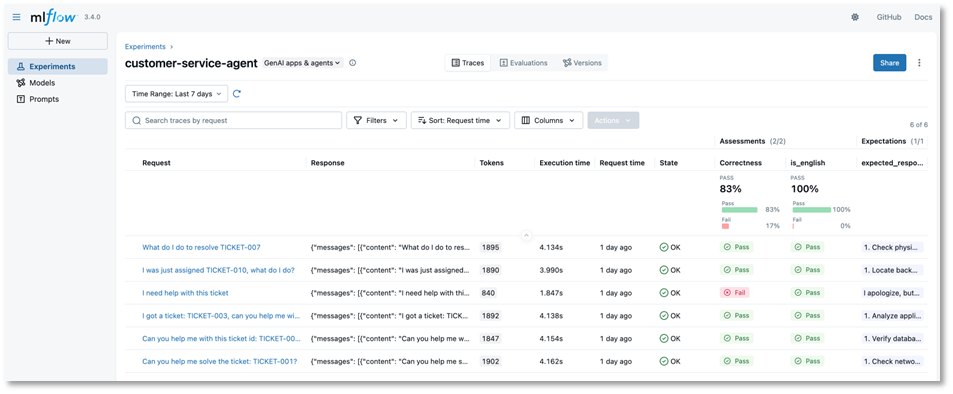

Verfolgen von KI-Anwendungen und -Agenten in Echtzeit

SageMaker AI mit MLflow zeichnet die Eingaben, Ausgaben und Metadaten bei jedem Schritt der KI-Entwicklung auf, um Fehler oder unerwartete Verhaltensweisen schnell zu identifizieren. Mit erweiterter Nachverfolgung für agentenbasierte Workflows und mehrstufige Anwendungen erhalten Sie die Transparenz, die Sie für die Fehlerbehebung in komplexen generativen KI-Systemen und die Leistungsoptimierung benötigen.

Zentralisierte Modellverwaltung mit SageMaker Model Registry

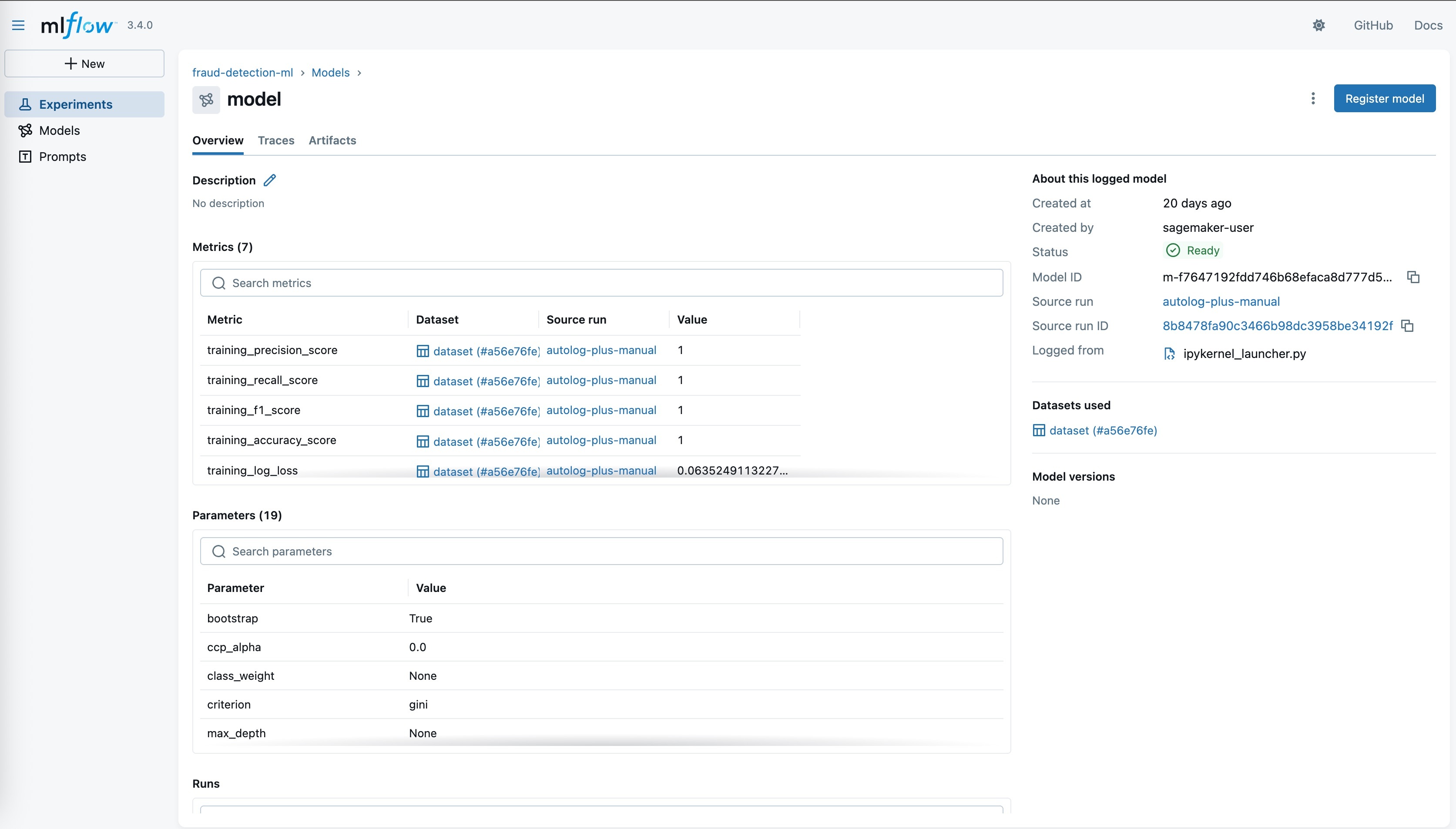

Unternehmen benötigen eine einfache Möglichkeit, den Überblick über alle Kandidatenmodelle in den Entwicklungsteams zu behalten, um fundierte Entscheidungen darüber treffen zu können, welche Modelle in Produktion gehen. Managed MLflow umfasst eine speziell entwickelte Integration, die in MLflow registrierte Modelle automatisch mit der SageMaker-Modellregistrierung synchronisiert. Dadurch können KI-Modellentwicklungsteams unterschiedliche Tools für ihre jeweiligen Aufgaben einsetzen: MLflow für Experimente und SageMaker Model Registry für die Verwaltung des Produktionslebenszyklus mit umfassender Modelllinie.

Nahtlose Bereitstellung von Modellen auf SageMaker-AI-Endpunkten

Sobald Sie die gewünschte Modellgenauigkeit und Leistungsziele erreicht haben, können Sie Modelle mit wenigen Klicks aus der SageMaker Model Registry in SageMaker-AI-Inferenz-Endpunkte in die Produktion überführen. Durch diese nahtlose Integration entfällt die Notwendigkeit, benutzerdefinierte Container für die Modellspeicherung zu erstellen, und Kunden können die optimierten Inferenzcontainer von SageMaker AI nutzen und gleichzeitig die benutzerfreundliche Oberfläche von MLflow für die Protokollierung und Registrierung von Modellen beibehalten.

Wildlife Conservation Society

„WCS treibt den weltweiten Schutz von Korallenriffen durch MERMAID voran, eine Open-Source-Plattform, die ML-Modelle zur Analyse von Korallenriff-Fotos von Wissenschaftlern aus aller Welt nutzt. Amazon SageMaker mit MLflow hat unsere Produktivität gesteigert, da wir nun keine MLflow-Tracking-Server mehr konfigurieren oder die Kapazität entsprechend den sich ändernden Anforderungen unserer Infrastruktur verwalten müssen. Indem wir unserem Team ermöglichen, sich vollständig auf Modellinnovationen zu konzentrieren, beschleunigen wir unsere Bereitstellungszeit, um Meereswissenschaftlern und Managern wichtige cloudbasierte Erkenntnisse zu liefern.“

Kim Fisher, MERMAID

Lead Software Engineer, WCS