Warum Amazon SageMaker?

Amazon SageMaker ist ein vollständig verwalteter Service, der eine breite Palette von Tools vereint, um leistungsstarkes, kostengünstiges Machine Learning (ML) für jeden Anwendungsfall zu ermöglichen. Mit SageMaker können Sie ML-Modelle mithilfe von Tools wie Notebooks, Debuggern, Profilern, Pipelines, MLOps und mehr im großen Maßstab erstellen, trainieren und bereitstellen – alles in einer integrierten Entwicklungsumgebung (IDE). SageMaker unterstützt Governance-Anforderungen mit vereinfachter Zugriffskontrolle und Transparenz über Ihre ML-Projekte. Darüber hinaus können Sie Ihre eigenen FMs erstellen, große Modelle, die an riesigen Datensätzen trainiert wurden, mit speziell entwickelten Tools zur Feinabstimmung, zum Experimentieren, Umschulen und Bereitstellen von FMs. SageMaker bietet Zugriff auf Hunderte von vortrainierten Modellen, einschließlich öffentlich verfügbarer FMs, die Sie mit nur wenigen Klicks bereitstellen können.

Warum Amazon SageMaker?

Amazon SageMaker ist ein vollständig verwalteter Service, der eine breite Palette von Tools vereint, um leistungsstarkes, kostengünstiges Machine Learning (ML) für jeden Anwendungsfall zu ermöglichen. Mit SageMaker können Sie ML-Modelle mithilfe von Tools wie Notebooks, Debuggern, Profilern, Pipelines, MLOps und mehr im großen Maßstab erstellen, trainieren und bereitstellen – alles in einer integrierten Entwicklungsumgebung (IDE). SageMaker unterstützt Governance-Anforderungen mit vereinfachter Zugriffskontrolle und Transparenz über Ihre ML-Projekte. Darüber hinaus können Sie Ihre eigenen FMs erstellen, große Modelle, die an riesigen Datensätzen trainiert wurden, mit speziell entwickelten Tools zur Feinabstimmung, zum Experimentieren, Umschulen und Bereitstellen von FMs. SageMaker bietet Zugriff auf Hunderte von vortrainierten Modellen, einschließlich öffentlich verfügbarer FMs, die Sie mit nur wenigen Klicks bereitstellen können.

Vorteile von SageMaker

Mehr Menschen ermöglichen, mit ML zu innovieren

-

Geschäftsanalysten

-

Datenwissenschaftler

-

ML-Techniker

-

Geschäftsanalysten

-

Geschäftsanalysten

Erstellen Sie ML-Vorhersagen über eine visuelle Schnittstelle mit SageMaker Canvas. -

Datenwissenschaftler

-

Data Scientists

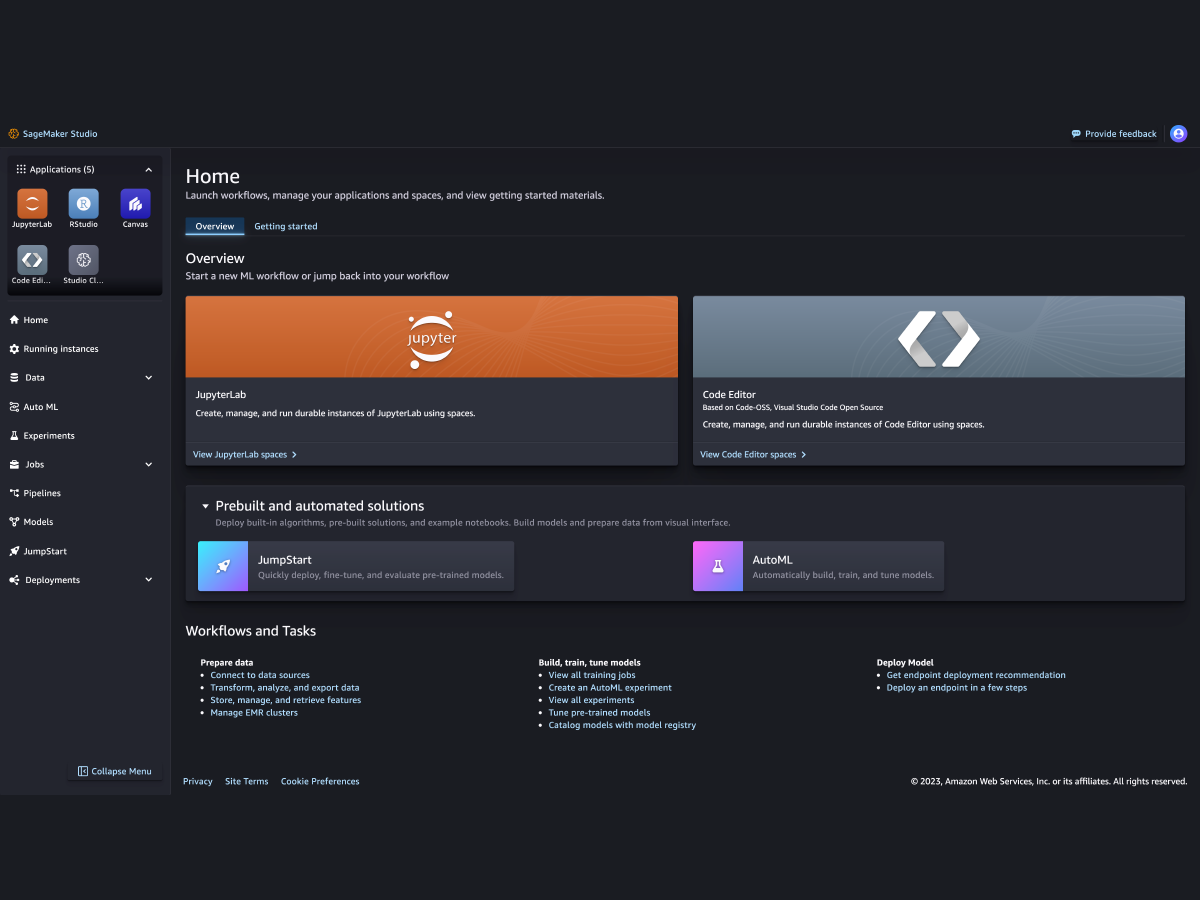

Bereiten Sie Daten vor und entwickeln, trainieren und implementieren Sie Modelle mit SageMaker Studio. -

ML-Techniker

-

ML-Engineers

Mit SageMaker MLOps können Sie Modelle in großem Umfang bereitstellen und verwalten.

Unterstützung für die führenden ML-Frameworks, Toolkits und Programmiersprachen