- AI Generatif›

- Amazon Bedrock›

- Evaluasi

Evaluasi Amazon Bedrock

Evaluasi model fondasi, termasuk model kustom dan impor, untuk menemukan model yang sesuai dengan kebutuhan Anda. Anda juga dapat mengevaluasi pengambilan atau alur kerja RAG menyeluruh di Basis Pengetahuan Amazon Bedrock.

Gambaran Umum

Amazon Bedrock menyediakan alat evaluasi bagi Anda untuk mempercepat adopsi aplikasi AI generatif. Evaluasi, bandingkan, dan pilih model fondasi untuk kasus penggunaan Anda dengan Evaluasi Model. Siapkan aplikasi RAG Anda untuk produksi yang dibangun pada Basis Pengetahuan Amazon Bedrock atau sistem RAG kustom Anda dengan mengevaluasi fungsi ambil atau fungsi ambil dan hasilkan.

Tipe evaluasi

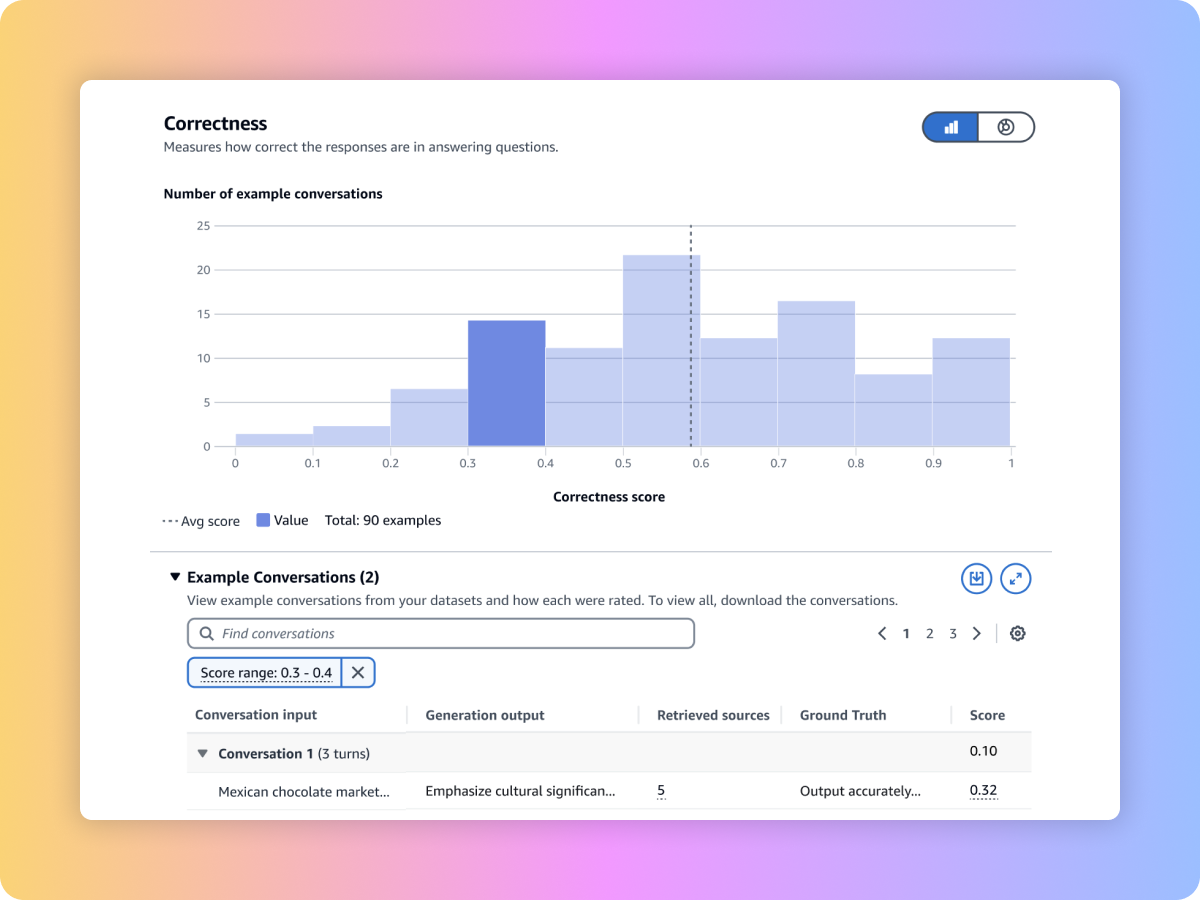

Gunakan LLM sebagai juri untuk mengevaluasi output model menggunakan set data prompt kustom Anda dengan metrik-metrik seperti kebenaran, kelengkapan, dan tingkat bahaya.

Evaluasi output model menggunakan algoritma dan metrik bahasa alami tradisional, seperti Skor BERT, F1, dan teknik pencocokan tepat lainnya, menggunakan set data prompt bawaan atau milik Anda sendiri.

Evaluasi output model dengan tenaga kerja Anda sendiri atau minta AWS mengelola evaluasi Anda tentang respons terhadap set data prompt kustom Anda dengan metrik bawaan atau kustom.

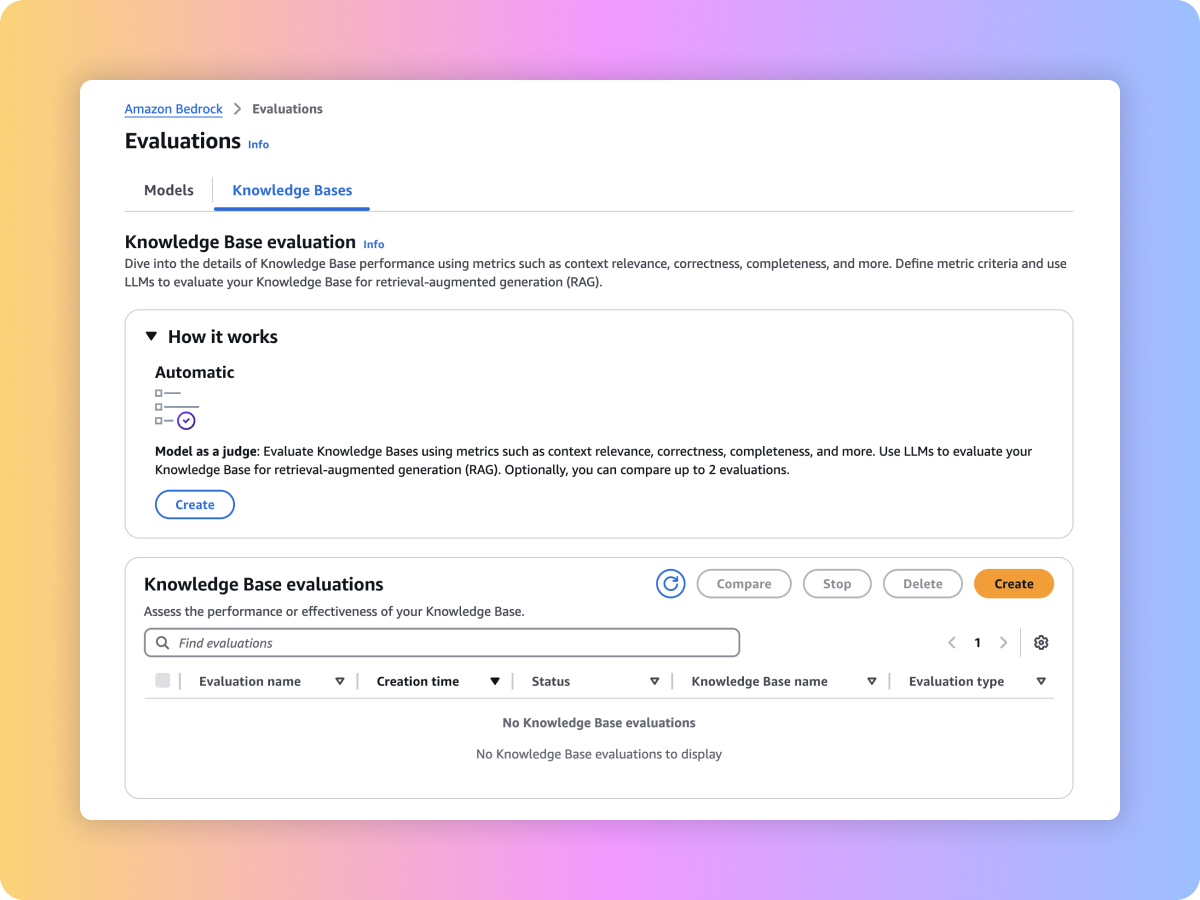

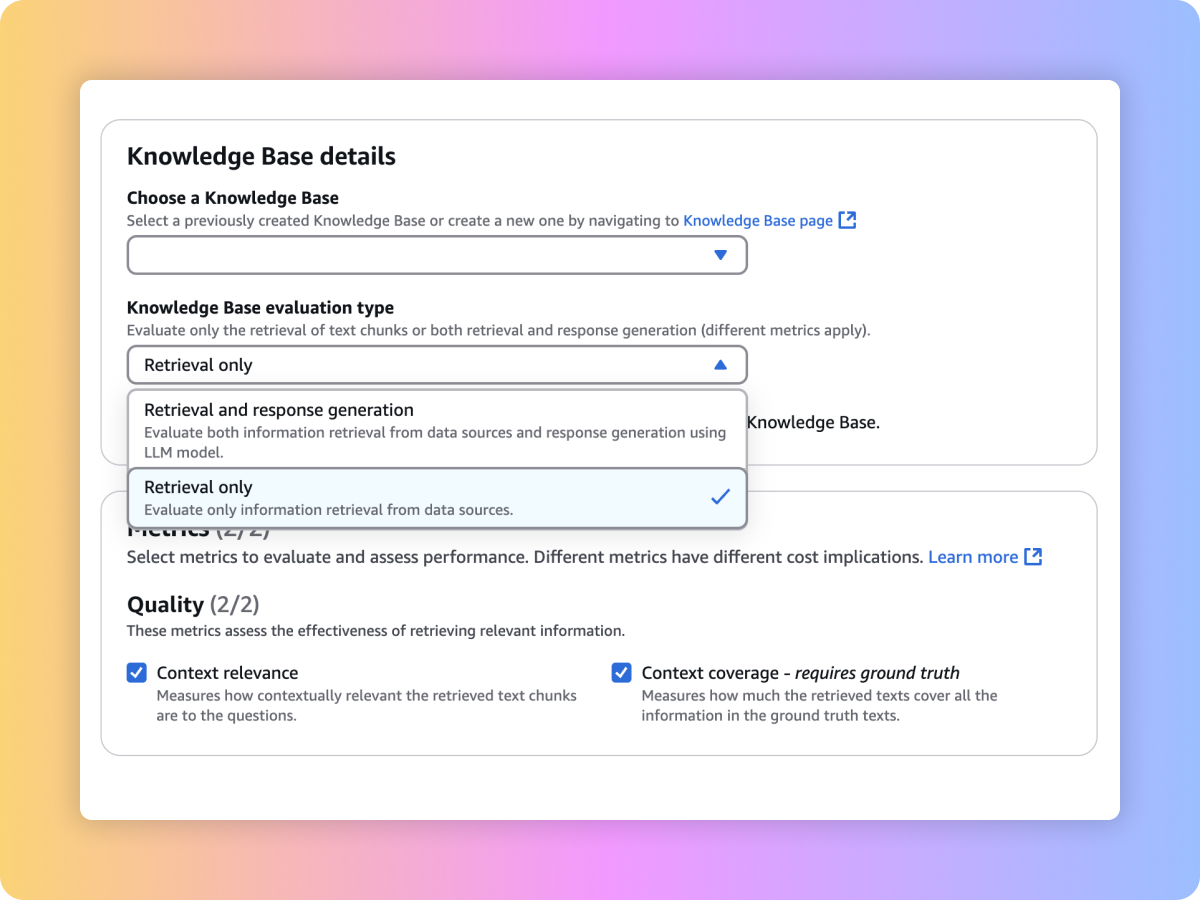

Evaluasi kualitas pengambilan sistem RAG kustom atau Basis Pengetahuan Amazon Bedrock Anda dengan prompt dan metrik seperti relevansi konteks serta cakupan konteks.

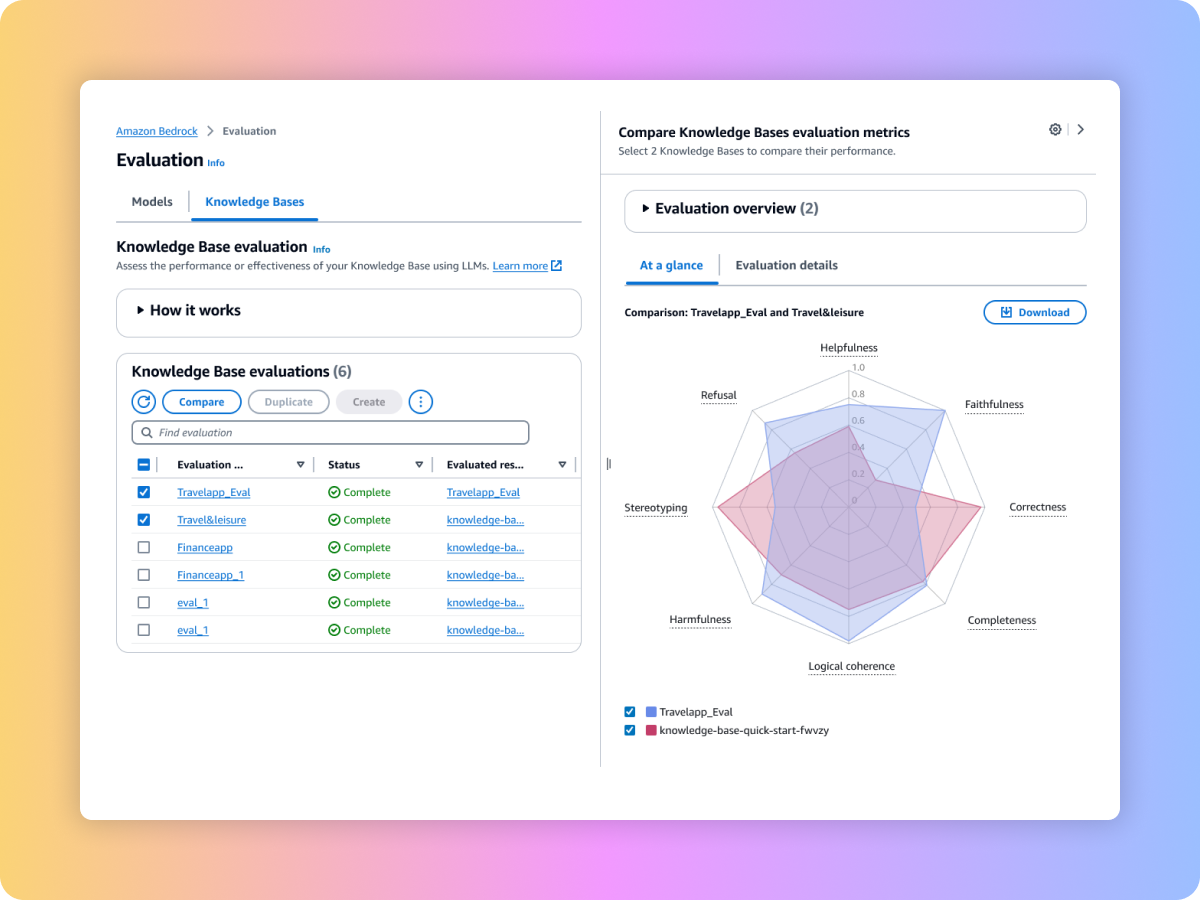

Evaluasi konten yang dihasilkan dari alur kerja RAG end-to-end, baik dari pipeline RAG kustom maupun Basis Pengetahuan Amazon Bedrock Anda. Gunakan prompt dan metrik Anda sendiri seperti kejujuran (deteksi halusinasi), kebenaran, dan kelengkapan.

Evaluasi alur kerja RAG end-to-end Anda

Pastikan pengambilan yang lengkap dan relevan dari sistem RAG Anda

Evaluasi FM untuk memilih yang terbaik untuk kasus penggunaan Anda

Bandingkan hasil pada beberapa tugas evaluasi untuk membuat keputusan lebih cepat