概览

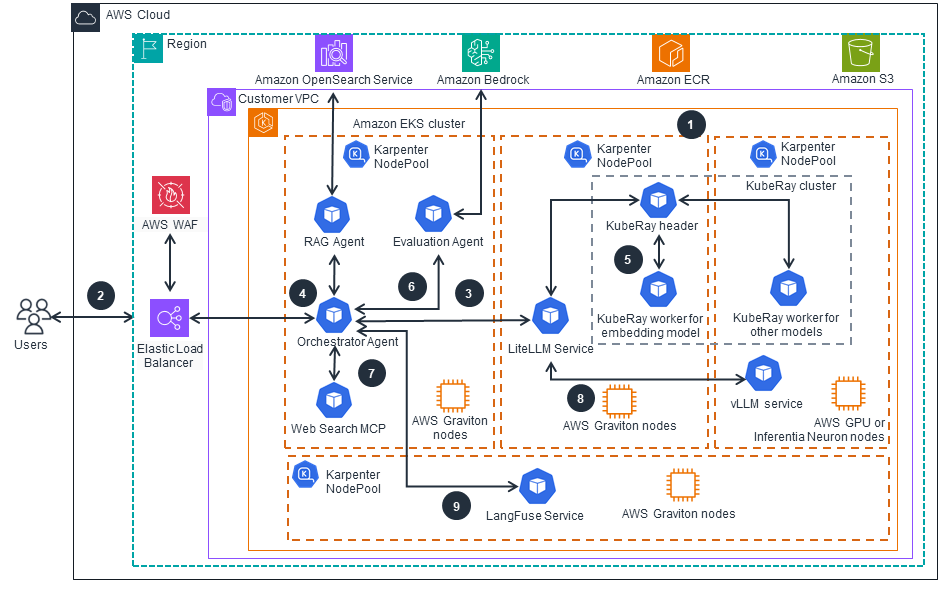

本指南展示了如何构建稳健强大的企业级人工智能架构,从而最大限度地提高机器学习投资的价值。本指南通过智能资源分配帮助组织优化其机器学习工作负载分配,同时提供统一的模型推理 API 网关,以简化访问和管理。本指南展示了如何实施代理式人工智能功能,以实现模型与外部 API 之间的无缝交互,从而显著扩展自动化的可能性。此外,本指南还展示了如何通过将专用工具与检索增强生成 (RAG) 相结合来增强 LLM 性能,从而产生更具上下文感知能力和更强大的人工智能系统,而这些系统能够更好地了解及响应复杂的业务场景。

优势

使用 AWS Graviton 处理器和智能自动扩展,部署具成本效益的人工智能工作负载。Karpenter 可根据实际工作负载需求自动预置适当大小的计算资源,减少不必要的基础设施开支,同时保持性能。

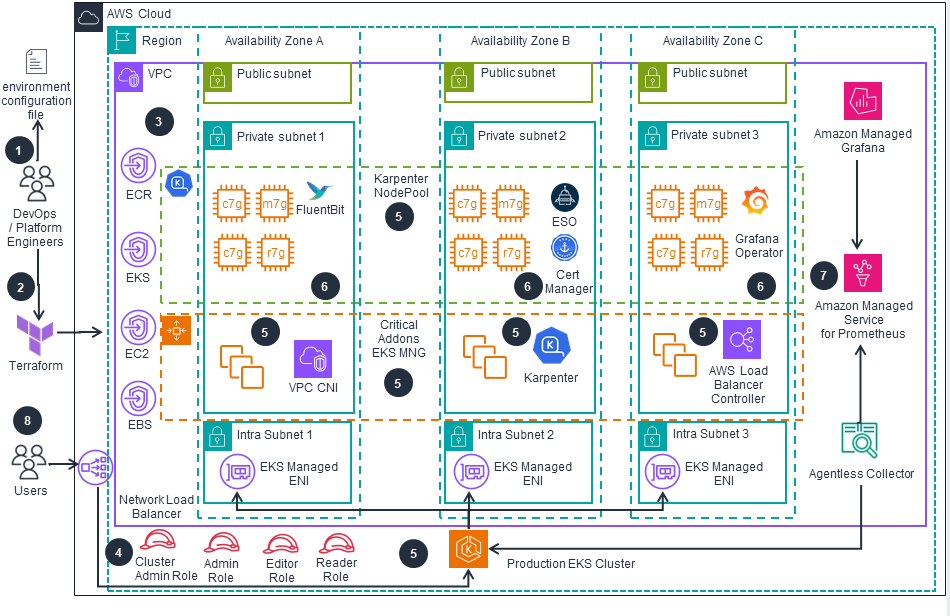

实施可跨多个可用区动态扩展的生产就绪型基础设施。该架构可根据需要自动预置 GPU、Graviton 和基于 Inferentia 的计算资源,以高效处理各种不同的推理工作负载,从而确保在需求激增期间也能保持一致的性能。

通过预先配置的可观测性和安全控制,降低运营复杂性。本指南提供了可随时部署的基础设施以及可用于监控、记录和安全的托管式服务,从而使您的团队能够专注于模型开发,而不是基础设施管理。

免责声明

示例代码;软件库;命令行工具;概念验证;模板;或其他相关技术(包括由我方人员提供的任何前述项)作为 AWS 内容按照《AWS 客户协议》或您与 AWS 之间的相关书面协议(以适用者为准)向您提供。您不应将这些 AWS 内容用在您的生产账户中,或用于生产或其他关键数据。您负责根据特定质量控制规程和标准测试、保护和优化 AWS 内容,例如示例代码,以使其适合生产级应用。部署 AWS 内容可能会因创建或使用 AWS 可收费资源(例如,运行 Amazon EC2 实例或使用 Amazon S3 存储)而产生 AWS 费用。

找到今天要查找的内容了吗?

请提供您的意见,以便我们改进网页内容的质量