“又一次半夜被Kubernetes告警惊醒,我发现自己正在查阅第五个不同的文档,试图找出为什么集群中的一个关键服务突然不可用。”作为一名身处云原生转型前线的架构师,这样的经历对我而言曾是家常便饭。尽管Amazon EKS让Kubernetes部署变得更简单,但运维的复杂性和知识门槛仍然是许多团队面临的巨大挑战。然而,亚马逊云科技最新推出的AI驱动运维工具彻底改变了这一现状。在这篇文章中,我将分享如何利用这些革命性技术让Kubernetes管理变得像日常对话一样自然,以及这些工具如何帮助一个陷入运维困境的大型企业重获云原生之路的信心。

1. 云原生智能运维的新纪元

客户痛点:某消费电子行业制造商的EKS运维困境

近一年来,持续与一家大型消费电子制造商合作,他们在亚马逊云科技的北美及欧洲区域内共计部署了14个EKS集群来支持其研发、生产和供应链系统。尽管云原生技术为他们带来了巨大的灵活性和创新能力,但他们的运维团队正面临严峻挑战:

- 专业知识短缺:团队中只有两名工程师精通Kubernetes,导致关键操作存在人员依赖

- incident响应迟缓:生产环境问题平均解决时间超过3小时,影响业务连续性Best Practices

- 运维人员倦怠:频繁的告警和复杂的故障排查导致团队疲惫Best Practices

- 环境不一致:开发、测试和生产环境配置漂移,导致”在我机器上能运行”的问题

- 文档滞后:快速迭代导致操作手册和知识库无法及时更新

- 学习曲线陡峭:新加入的运维工程师需要3-6个月才能独立处理集群事务

其公司的运维总监向我坦言:”我们的工程师花费过多时间在重复性任务上,而非创新。每次Kubernetes或亚马逊云科技发布新功能,我们都需要大量学习时间。我们需要一种方法来降低管理EKS集群的复杂性,并使我们的整个团队能够高效操作,而不只是依赖少数专家。”

Kubernetes复杂性痛点与传统管理方法的局限

随着企业云原生架构的广泛采用,Kubernetes已经成为容器编排的事实标准。然而,Kubernetes的强大功能伴随着显著的技术复杂性,这为DevOps和平台工程团队带来了诸多挑战:

- 陡峭的学习曲线:掌握Kubernetes需要深入理解其资源模型、网络模型和安全机制,这对新手来说尤其困难

- API复杂性:Kubernetes拥有超过50种资源类型,各有不同的API版本和字段定义

- 故障排查困难:当应用程序出现问题时,可能涉及多个组件和资源层级,导致根因分析耗时且复杂

- 操作风险高:配置错误可能导致生产环境中断,尤其在多集群、多租户环境中

- 配置管理挑战:随着集群和应用数量增加,手动管理配置变得越来越困难

- 工具碎片化:需要使用多种命令行工具(kubectl, eksctl, aws cli等)和配置文件

传统的Kubernetes管理方法主要依靠命令行工具、声明式YAML配置和自动化脚本。这些方法虽然有效,但存在一系列局限:

- 高度依赖专业知识:需要专家级别的Kubernetes和云服务知识

- 缺乏上下文感知:工具不了解整个环境的状态,无法提供智能建议

- 自动化脚本维护成本高:随着集群配置的变化,脚本需要不断更新

- 跨团队协作障碍:不同经验水平的团队成员难以高效协作

AI驱动的DevOps转型:从工具到助手的演进

人工智能,特别是大型语言模型(LLM)的出现,正在彻底改变DevOps和云基础设施管理的方式。这一转变可以描述为”从工具到助手”的演进:

AI助手时代的特点:

- 自然语言交互

- 上下文感知和适应性

- 关注”要做什么”而非”如何做”

- 智能错误解释与指导

- 能够理解模糊的需求并给出建议

亚马逊云科技的智能EKS管理解决方案代表了这一演进的前沿,它将Kubernetes专业知识与AI助手能力相结合,创建了一个更智能、更直观的云原生管理范式,正是消费电子行业客户所迫切需要的解决方案。

在本文中将深入探讨如何利用AI驱动工具来构建智能化EKS运维体系,以及这如何为我们的客户解决了长期困扰的集群管理难题,并提供了创建EKS集群、部署容器化应用、实时故障排查、性能监控与优化、EKS集群升级规划等5个实战案例来帮助您理解AI工具与EKS交互的方式,以及作为您实际应用中的参考。Amazon EKS MCP Server代表了这一演进的前沿,它将Kubernetes专业知识与AI助手能力相结合,创建了一个更智能、更直观的云原生管理范式。

2. 技术架构深度解析

Model Context Protocol (MCP)技术解析:连接LLM与基础设施的桥梁

Model Context Protocol (MCP)是一个开放协议,设计用于连接大语言模型(LLM)与外部工具和服务。它解决了LLM在实际应用中的一个核心限制:虽然这些模型拥有丰富的通用知识,但它们无法直接与实时系统交互或访问最新数据。

MCP的核心原理:

- 工具调用标准化:定义了LLM如何发现、调用和使用外部工具的统一接口

- 上下文共享机制:允许LLM和工具之间高效交换信息和状态

- 双向通信流:支持从LLM到工具的调用,以及从工具到LLM的响应

- 工具定义标准:提供描述工具功能、参数和约束的结构化方式

在EKS MCP Server中,MCP成为连接LLM(如Amazon Q)与Kubernetes基础设施的桥梁,使AI助手能够:

- 理解和执行复杂的Kubernetes管理任务

- 访问集群状态和资源信息

- 生成和应用配置

- 诊断问题并提供解决方案

这种集成彻底改变了工程师与Kubernetes的交互方式,从手动命令和YAML编写转变为自然语言对话和意图表达。

EKS MCP Server是基于MCP协议构建的专用服务,连接Amazon Q Developer CLI与Amazon EKS环境,提供Kubernetes管理功能。其核心能力如下,

- 使AI代码助手的用户能够创建新的EKS集群,包括完成所有前提条件,如专用VPC、网络配置和EKS自动模式节点池,通过将请求转换为适当的CloudFormation操作实现。

- 提供部署容器化应用程序的能力,可以通过应用现有的Kubernetes YAML文件,或根据用户提供的参数生成新的部署和服务清单。

- 支持EKS集群内各种Kubernetes资源(如Pod、Service和Deployment)的完整生命周期管理,支持创建、读取、更新、补丁和删除操作。

- 提供列出Kubernetes资源的功能,可按命名空间、标签和字段进行筛选,简化了用户和大语言模型(LLM)收集Kubernetes应用程序和EKS基础设施状态信息的过程。

- 促进运维任务,如从特定Pod和容器中检索日志,或获取与特定资源相关的Kubernetes事件,为直接用户和AI驱动的工作流提供故障排除和监控支持。

- 使用户能够排查EKS集群的问题。

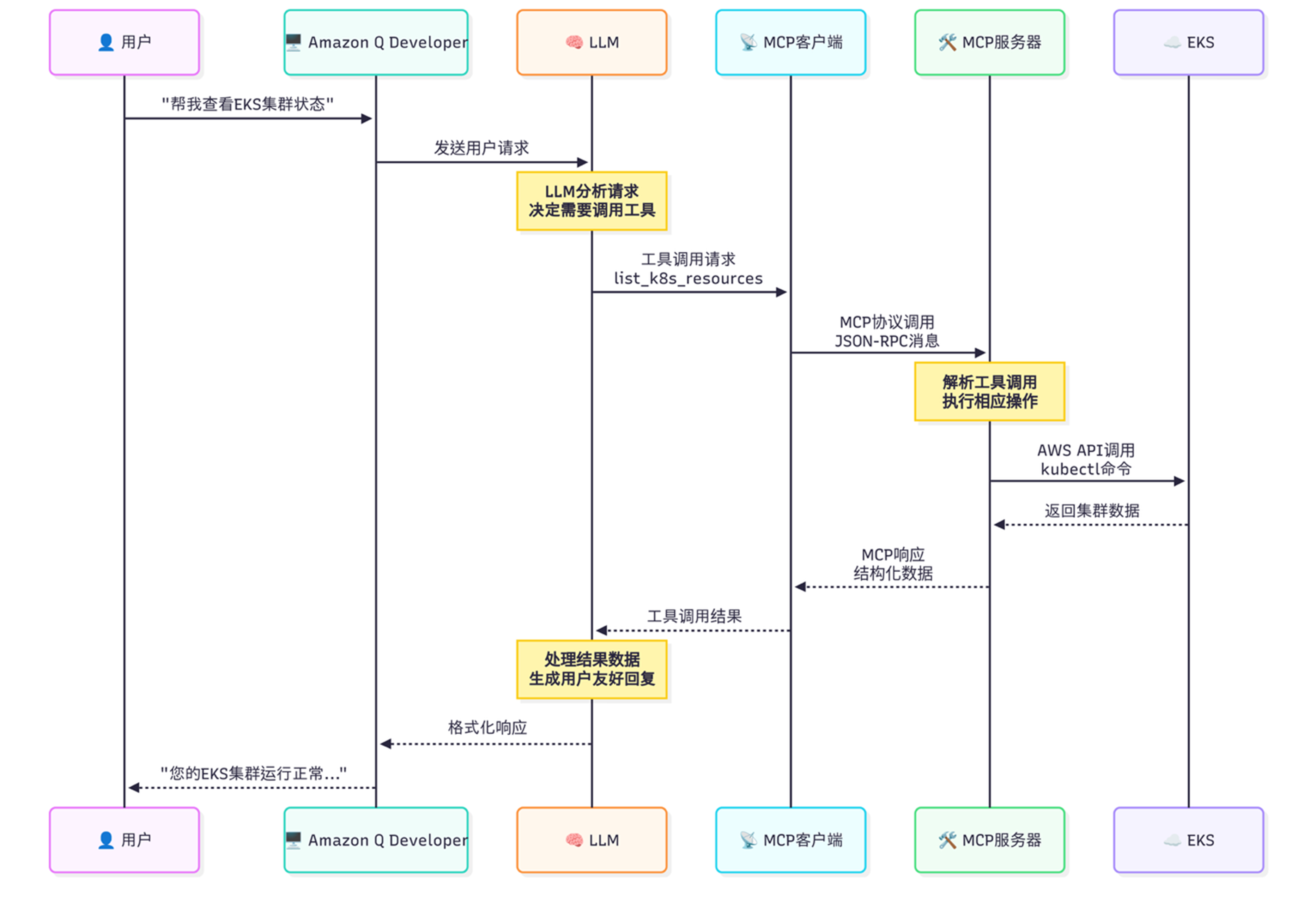

EKS MCP Server的模块化设计确保了高度的可扩展性和可维护性,使系统能够适应不断变化的需求和环境。同时,其标准化的接口使Amazon Q能够通过自然语言理解用户意图,并将其转化为适当的Kubernetes操作,极大地简化了集群管理流程。让我们以以”查看EKS集群状态”为例,展示Amazon Q Developer CLI、LLM、MCP协议与EKS服务之间的完整交互流程和数据传递过程。

EKS MCP Server作为为AI代码助手,提供了完整的EKS和Kubernetes资源管理能力。简单来说,它让Amazon Q理解并可以直接

操作你的Kubernetes集群,从创建集群到部署应用,从监控到故障排除,全部通过自然语言对话完成。Amazon EKS MCP Server的核心愿景是实现AI驱动的云原生管理范式,通过将LLM的智能与Kubernetes的强大功能相结合,大幅提升运维效率和可靠性。

- 技术门槛降低:

- 将Kubernetes专业知识编码到工具中,降低入门壁垒

- 通过自然语言简化复杂概念和流程

- 效率显著提升:

- 将小时级任务压缩至分钟或秒级

- 自动化重复性工作流程

- 减少上下文切换和工具切换开销

- 一致性与可靠性保障:

- 应用内置的最佳实践和安全措施

- 减少手动操作错误

- 提供可重复、可审计的操作记录

- 智能故障排除:

- 提供上下文感知的问题诊断

- 自动关联日志、指标和事件

- 建议针对性解决方案和预防措施

- 全生命周期支持:

- 从集群创建到应用部署再到监控维护

- 覆盖开发、测试、生产全环节

- 支持基础设施即代码(IaC)和配置管理

- 适应性与可扩展性:

- 支持多样化的EKS和Kubernetes环境

- 可通过自定义工具扩展功能

- 适应不断发展的云原生生态系统

通过这些价值主张,EKS MCP Server正在重新定义云原生管理的可能性,从传统的”工具驱动”向”意图驱动”模式转变,使组织能够更快速、更安全地实现云基础设施的价值。

3. 部署架构与环境配置

安装准备工作

在安装EKS MCP Server之前,需要确保您的环境满足以下前提条件:

3.1 系统要求

- Python 3.10或更高版本

- 有效的亚马逊云科技账户和凭证

- 对目标EKS集群的访问权限

3.2 环境配置

- 配置AWS CLI并验证凭证

- 确认IAM权限满足最低要求(EKS只读权限或更高)

IAM 只读权限策略,

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": [

"eks:DescribeCluster",

"cloudformation:DescribeStacks",

"cloudwatch:GetMetricData",

"logs:StartQuery",

"logs:GetQueryResults",

"iam:GetRole",

"iam:GetRolePolicy",

"iam:ListRolePolicies",

"iam:ListAttachedRolePolicies",

"iam:GetPolicy",

"iam:GetPolicyVersion",

"eks-mcpserver:QueryKnowledgeBase"

],

"Resource": "*"

}

]

}

EKS Full Access权限策略(注意: 此处展示的是具有完全访问权限的策略,仅用于学习演示目的。在生产环境中,应当遵循最小权限原则,根据管理员职责范围和实际需求配置精细化的权限策略。通配符权限(eks:*)会授予对所有EKS资源的完全控制权,这在安全性方面存在潜在风险。建议在实际部署中限制特定操作和资源范围,以提高系统安全性。)

{

"Version": "2012-10-17",

"Statement": [

{

"Effect": "Allow",

"Action": "eks:*",

"Resource": "*"

}

]

}

3.3 Python环境准备

安装步骤详解,以下是安装EKS MCP Server的详细步骤:

git clone https://github.com/awslabs/mcp.git

cd mcp/src/eks-mcp-server

3.4 配置Amazon Q开发者设置

创建或编辑`~/.amazon-q/config.json`文件,此配置文件设置Amazon Q与EKS MCP服务器的交互方式。它指定了服务器运行命令、工作目录、环境变量以及自动批准的操作列表。通过这些设置,Amazon Q可以帮助开发者管理和监控EKS资源,而无需频繁进行权限确认。您可以根据实际需求调整路径、AWS配置文件和区域设置。”autoApprove”部分定义了哪些操作可以自动执行,增强使用体验的同时减少重复授权操作。:

{

"mcpServers": {

"awslabs.eks-mcp-server": { // 服务器标识名称,用于在Amazon Q中识别此EKS MCP服务器

"command": "uv", // 启动命令:使用uv作为Python包管理和运行工具

"args": [

"run", // uv子命令:运行Python应用

"--directory", // 指定工作目录参数

"/Users/eks/mcp/src/eks-mcp-server", // EKS MCP服务器的安装路径

"python", // 使用Python解释器

"-m", // 以模块方式运行

"awslabs.eks_mcp_server.server", // 要运行的Python模块路径

"--allow-write", // 允许写操作权限(创建/修改K8s资源)

"--allow-sensitive-data-access" // 允许访问敏感数据(如Secrets、日志等)

],

"env": { // 环境变量配置,用于设置AWS和日志相关参数

"aws_PROFILE": "default",

// AWS配置文件名称,对应~/.aws/credentials中的profile

// 可以改为其他profile名称,如"production"、"development"等

"aws_REGION": "us-east-1",

// 默认AWS区域,EKS集群必须在此区域

// 常用区域:us-west-2, eu-west-1, ap-southeast-1等

"FASTMCP_LOG_LEVEL": "INFO"

// 日志级别设置,控制输出的详细程度

// 可选值:DEBUG(最详细)、INFO(一般)、WARNING、ERROR(最少)

},

"autoApprove": [

// 自动批准的工具列表,这些操作无需用户手动确认

// 注意:自动批准会降低安全性,请根据需要调整

"manage_eks_stacks", // EKS CloudFormation堆栈管理:创建、更新、删除EKS集群

"manage_k8s_resource", // Kubernetes资源管理:创建、更新、删除K8s对象(Pod、Service等)

"list_k8s_resources", // 列出Kubernetes资源:查看集群中的各种资源状态

"get_pod_logs", // 获取Pod日志:查看容器应用的运行日志,用于故障排查

"get_k8s_events", // 获取Kubernetes事件:查看集群中发生的事件和警告

"get_cloudwatch_logs", // 获取CloudWatch日志:查看EKS控制平面和节点日志

"get_cloudwatch_metrics", // 获取CloudWatch指标:监控集群性能和资源使用情况

"get_policies_for_role", // 获取IAM角色策略:查看EKS相关的权限配置

"search_eks_troubleshoot_guide", // 搜索EKS故障排除指南:获取问题解决建议

"list_api_versions" // 列出Kubernetes API版本:查看集群支持的API版本

]

}

}

}

3.5 使用已安装的MCP Server

若已安装和配置EKS MCP Server,可通过Amazon Q Developer CLI直接使用:

q chat

在terminal输出如下

在Amazon Q交互界面中,您可以通过自然语言执行EKS管理任务,例如:

- “列出我的EKS集群”

- “在us-east-1创建一个新的EKS集群”

- “显示default命名空间中的所有Pod”

尝试基本命令

在交互界面中输入任意语种的自然语言即可与Amazon Q Cli进行交互,比如以下示例我们均采用中文语言与Amazon Q Cli进行交互:

列出我所有的EKS集群

检查工具调用,您应该看到类似以下的输出:

我将为您列出EKS集群。

[工具调用: list_clusters]

region: us-east-1

在us-east-1区域找到以下EKS集群:

1. my-cluster-1 (1.30)

2. my-cluster-2 (1.31)

如果工具调用成功并返回结果,则表示安装和配置成功。

4. 实战案例:对话式EKS管理的威力

在这一章节,我们将通过几个实战案例,展示EKS MCP Server与Amazon Q Developer CLI的集成如何彻底改变Kubernetes管理体验。这些案例基于真实工作场景,展示了通过自然语言对话完成复杂EKS任务的强大能力。

4.1 案例一:零基础创建EKS集群

场景描述:一位开发人员需要创建一个新的EKS集群,但不熟悉CloudFormation模板或EKS配置细节。

对话实例

用户:

我需要在us-east-1区域创建一个名为"peculiar-funk-badger"的新EKS集群,带有3个节点,能帮我实现吗?

Amazon Q:

我可以帮你在us-east-1区域创建一个名为"peculiar-funk-badger"的EKS集群,包含3个节点。我会使用CloudFormation来完成这项工作。

首先,让我查看你当前的EKS集群情况,确认该名称未被使用。

[工具调用: manage_eks_stacks]

operation: describe

cluster_name: peculiar-funk-badger

我会为你创建EKS集群。这个操作将创建以下资源:

- 一个VPC及其相关联的网络组件(子网、路由表、NAT网关等)

- 必要的IAM角色和策略

- EKS集群控制平面

- 包含3个节点的EKS节点组

这个操作需要一些时间完成(通常15-20分钟)。你确定要创建这个集群吗?

[工具调用: manage_eks_stacks]

operation: deploy

cluster_name: peculiar-funk-badger

node_count: 3

region: us-east-1

已开始创建名为"peculiar-funk-badger"的EKS集群。

CloudFormation堆栈"eks-peculiar-funk-badger"正在创建中。

你可以通过AWS控制台或命令行工具监控创建进度。

完成时间预计为15-20分钟。

堆栈状态: CREATE_IN_PROGRESS

技术解析

在这个交互中,EKS MCP Server通过manage_eks_stacks工具完成了几个关键步骤:

- 资源验证:检查集群名称是否已存在

- 模板生成:自动生成适合的CloudFormation模板

- 资源预估:向用户说明将创建哪些资源

- 部署执行:调用 CloudFormation API创建所需资源

整个过程用户不需要了解任何CloudFormation语法或EKS资源配置细节,只需用自然语言表达意图即可。

4.2 案例二:部署容器化应用

场景描述:团队需要将一个简单的微服务部署到现有EKS集群,包括创建部署和服务。

对话实例

用户:

我想在peculiar-funk-badger集群的demo-ns命名空间中部署nginx,并通过LoadBalancer暴露服务,能做到吗?

Amazon Q:

我可以帮你在"peculiar-funk-badger"集群的"demo-ns"命名空间中部署nginx,并通过LoadBalancer暴露服务。

首先,让我检查这个集群和命名空间是否存在。

[工具调用: list_k8s_resources]

cluster_name: peculiar-funk-badger

kind: Namespace

api_version: v1

我没有找到"demo-ns"命名空间。我会先创建这个命名空间,然后部署nginx。

[工具调用: manage_k8s_resource]

operation: create

cluster_name: peculiar-funk-badger

kind: Namespace

api_version: v1

name: demo-ns

body: {"apiVersion":"v1","kind":"Namespace","metadata":{"name":"demo-ns"}}

命名空间"demo-ns"已创建成功。

现在,我将生成nginx部署和服务的YAML清单,并应用到集群。

[工具调用: generate_app_manifest]

app_name: nginx

image_uri: nginx:latest

output_dir: /tmp

port: 80

replicas: 2

cpu: "500m"

memory: "512Mi"

namespace: demo-ns

load_balancer_scheme: internet-facing

已生成应用清单:

- Deployment: nginx

- Service: nginx (LoadBalancer类型)

现在将这些清单应用到集群:

[工具调用: apply_yaml]

cluster_name: peculiar-funk-badger

yaml_path: /tmp/nginx-manifests.yaml

namespace: demo-ns

force: true

部署已成功完成!

你的nginx应用已在"peculiar-funk-badger"的"demo-ns"命名空间中部署,并通过LoadBalancer暴露。服务将需要几分钟来配置并获取外部IP地址。

你可以通过以下命令查看服务状态和IP地址:

[工具调用: list_k8s_resources]

cluster_name: peculiar-funk-badger

kind: Service

api_version: v1

namespace: demo-ns

name: nginx

服务详情:

- 名称: nginx

- 类型: LoadBalancer

- 外部IP: a13b4c5d6e7f.us-east-1.elb.amazonaws.com (可能需要几分钟才会分配)

- 端口: 80

技术解析

这个交互展示了多个工具的协同工作:

- 环境验证:使用

list_k8s_resources检查命名空间是否存在

- 资源创建:使用

manage_k8s_resource创建命名空间

- 清单生成:使用

generate_app_manifest生成适当的Kubernetes YAML

- 资源应用:使用

apply_yaml将资源应用到集群

- 状态验证:再次使用

list_k8s_resources检查部署状态

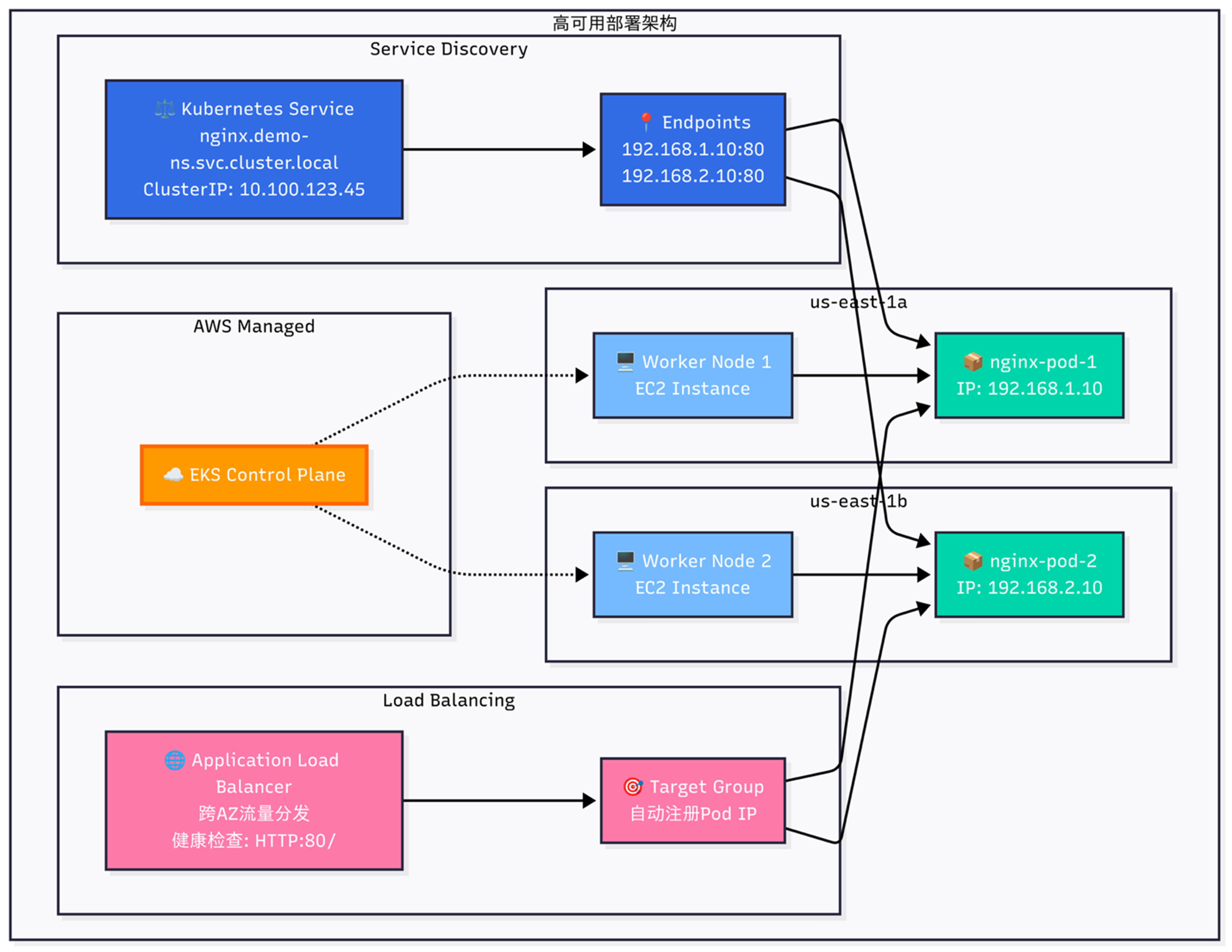

整个过程展示了EKS MCP Server如何将复杂的Kubernetes部署流程简化为一次简单的对话交互,部署完成后的的应用架构图如下,

4.3 案例三:实时故障排查

场景描述:一个生产应用出现故障,开发人员需要快速排查原因。

对话实例

用户:

我的payment-service应用在production命名空间下似乎不工作了,能帮我找出问题吗?

Amazon Q:

我会帮你排查production命名空间中payment-service应用的问题。让我们逐步检查各种可能的故障点。

首先,让我查看deployment的状态:

[工具调用: list_k8s_resources]

cluster_name: peculiar-funk-badger

kind: Deployment

api_version: apps/v1

namespace: production

name: payment-service

我看到payment-service的deployment存在问题:

- 期望副本数: 3

- 可用副本数: 1

- 就绪副本数: 1

- 最新状态副本数: 3

这表明有2个pod无法正常启动。让我查看相关pod的状态:

[工具调用: list_k8s_resources]

cluster_name: peculiar-funk-badger

kind: Pod

api_version: v1

namespace: production

label_selector: app=payment-service

我找到了3个pod:

1. payment-service-7d8f9c6b5-abc12 (状态: Running)

2. payment-service-7d8f9c6b5-def34 (状态: CrashLoopBackOff)

3. payment-service-7d8f9c6b5-ghi56 (状态: CrashLoopBackOff)

有两个pod处于CrashLoopBackOff状态,这表明它们无法成功启动。让我检查其中一个失败pod的日志:

[工具调用: get_pod_logs]

cluster_name: peculiar-funk-badger

pod_name: payment-service-7d8f9c6b5-def34

namespace: production

tail_lines: 50

日志显示以下错误:

Error: could not connect to database at db-service:5432

failed to initialize database connection

retrying in 5 seconds...

Error: could not connect to database at db-service:5432

failed to initialize database connection

retrying in 5 seconds...

现在让我检查相关的Kubernetes事件,可能提供更多线索:

[工具调用: get_k8s_events]

cluster_name: peculiar-funk-badger

kind: Pod

name: payment-service-7d8f9c6b5-def34

namespace: production

我发现了问题所在!根据日志和事件分析:

1. payment-service无法连接到数据库服务(db-service)

2. 让我检查db-service是否存在并正常运行

[工具调用: list_k8s_resources]

cluster_name: peculiar-funk-badger

kind: Service

api_version: v1

namespace: production

name: db-service

我发现db-service存在,但没有对应的pod在运行。让我检查数据库deployment:

[工具调用: list_k8s_resources]

cluster_name: peculiar-funk-badger

kind: Deployment

api_version: apps/v1

namespace: production

name: db-service

数据库deployment存在问题:

- 期望副本数: 1

- 可用副本数: 0

- 就绪副本数: 0

根据我的分析,问题是:

1. 数据库服务(db-service)的pod没有正常运行

2. 导致payment-service无法连接数据库而崩溃

3. 建议首先修复数据库部署问题

你要我进一步检查数据库pod的状态和日志吗?

技术解析

这个案例展示了EKS MCP Server在故障排查中的强大能力:

- 系统分析:自动检查部署状态、Pod状态等关键指标

- 日志收集:使用

get_pod_logs获取关键错误信息

- 事件关联:通过

get_k8s_events收集相关事件

- 根因分析:基于收集的信息推断问题根源

- 关联服务检查:扩展到相关服务(数据库)的状态检查

整个过程模拟了有经验的Kubernetes工程师的思维方式,提供了系统性的故障排查流程。

4.4 案例四:性能监控与优化

场景描述:运维团队需要了解应用的资源使用情况,优化资源分配。

对话实例

用户:

我想了解inventory-ver1服务在过去30分钟的CPU和内存使用情况,以便我们优化资源配置

Amazon Q:

我会帮你获取过去30分钟inventory-ver1服务的CPU和内存使用情况。

首先,让我了解一下在查询容器指标时应该使用哪些指标和维度:

[工具调用: get_eks_metrics_guidance]

resource_type: pod

感谢您的耐心等待。现在我来查询api-gateway的CPU使用情况:

[工具调用: get_cloudwatch_metrics]

cluster_name: peculiar-funk-badger

metric_name: pod_cpu_utilization

namespace: ContainerInsights

dimensions: {"ClusterName":"peculiar-funk-badger","PodName":"inventory-ver1"}

minutes: 30

period: 60

stat: Average

接下来查询内存使用情况:

[工具调用: get_cloudwatch_metrics]

cluster_name: peculiar-funk-badger

metric_name: pod_memory_utilization

namespace: ContainerInsights

dimensions: {"ClusterName":"peculiar-funk-badger","PodName":"inventory-ver1"}

minutes: 30

period: 60

stat: Average

基于收集到的指标,我为你整理了inventory-ver1服务的资源使用情况:

**CPU使用情况**:

- 平均使用率: 37.5%

- 峰值使用率: 65.2% (在22:45出现)

- 最低使用率: 12.3% (在22:30出现)

**内存使用情况**:

- 平均使用率: 42.8%

- 峰值使用率: 45.6% (持续稳定)

- 最低使用率: 40.2% (启动阶段)

**资源优化建议**:

1. **CPU资源**: 目前的设置似乎合理,有足够的头部空间应对峰值,但不会过度浪费。如果当前设置为1000m (1 vCPU),可以考虑调整到750m,仍能应对当前负载。

2. **内存资源**: 内存使用相对稳定,峰值仅为45.6%。如果当前设置为1Gi,可以安全降低到768Mi,为集群释放资源。

3. **扩展策略**: 基于CPU使用模式,建议设置HPA (Horizontal Pod Autoscaler):

- CPU目标使用率: 60%

- 最小副本数: 2

- 最大副本数: 5

你希望我帮你实施这些建议中的哪一个?或者你需要更多的数据分析?

技术解析

这个案例展示了EKS MCP Server在性能监控与优化方面的应用:

- 指标指南获取:使用get_eks_metrics_guidance了解可用指标

- CPU指标收集:使用get_cloudwatch_metrics获取CPU使用数据

- 内存指标收集:同样获取内存使用数据

- 数据分析:对收集的时序数据进行分析

- 最佳实践建议:基于数据分析提供具体的资源优化建议

整个流程展示了如何将复杂的指标收集与分析转化为明确的操作建议。

4.5 案例五:EKS集群升级方案设计与规划

场景描述:

客户需要将业务关键型EKS集群从1.31版本升级到1.32版本,要求升级过程中不能影响线上业务。客户需要一个详细的升级规划方案,按照控制平面、插件组件(add-on)和数据平面的顺序进行升级。

对话实例

用户:

请帮我规划设计目前eks集群peculiar-funk-badger从1.31到1.32的升级方案,

在升级的过程中不能影响线上业务,目前只规划和设计,不需要执行升级。

Amazon Q:

我来帮您规划设计EKS集群peculiar-funk-badger从1.31到1.32的无中断升级方案。

首先让我获取当前集群的详细信息来制定合适的升级策略。

[工具调用: manage_eks_stacks]

operation: describe

cluster_name: peculiar-funk-badger

让我通过AWS CLI直接查看集群信息:

[工具调用: use_aws]

service: eks

operation: describe-cluster

parameters: {"name": "peculiar-funk-badger"}

region: us-east-1

label: Get EKS cluster details

现在让我查看节点组信息:

[工具调用: use_aws]

service: eks

operation: list-nodegroups

parameters: {"cluster-name": "peculiar-funk-badger"}

region: us-east-1

label: List EKS nodegroups

让我获取每个节点组的详细信息:

[工具调用: use_aws]

service: eks

operation: describe-nodegroup

parameters: {"nodegroup-name": "mng", "cluster-name": "peculiar-funk-badger"}

region: us-east-1

label: Describe first nodegroup

[工具调用: use_aws]

service: eks

operation: describe-nodegroup

parameters: {"cluster-name": "peculiar-funk-badger", "nodegroup-name": "x86-c6a-large-nodegroup"}

region: us-east-1

label: Describe second nodegroup

现在让我查看集群中运行的工作负载:

[工具调用: list_k8s_resources]

cluster_name: peculiar-funk-badger

kind: Deployment

api_version: apps/v1

现在让我查看集群中的插件信息:

[工具调用: use_aws]

service: eks

operation: list-addons

parameters: {"cluster-name": "peculiar-funk-badger"}

region: us-east-1

label: List EKS addons

让我查看一些关键插件的版本信息:

[工具调用: use_aws]

service: eks

operation: describe-addon

parameters: {"addon-name": "coredns", "cluster-name": "peculiar-funk-badger"}

region: us-east-1

label: Describe coredns addon

基于收集到的信息,我为您制定以下EKS集群peculiar-funk-badger从1.31到1.32的无中断升级方案:

EKS集群升级方案:peculiar-funk-badger (1.31 → 1.32)

当前集群状态分析

集群基本信息:

集群名称:peculiar-funk-badger

当前版本:1.31

创建时间:2025-05-07

状态:ACTIVE

认证模式:API

节点组配置:

mng:2个节点(最小2,最大2),使用自定义AMI

x86-c6a-large-nodegroup:1个节点(最小1,最大3),使用AL2_x86_64 AMI

关键工作负载:

业务应用:inventory-ver1, parking, review, nginx-simple(default命名空间)

Istio服务网格:istiod, istio-ingressgateway, grafana, kiali, jaeger, prometheus

系统组件:coredns, aws-load-balancer-controller, metrics-server等

升级策略与时间规划

阶段1:升级前准备(预计1-2小时)

1.1 兼容性检查

# 检查Kubernetes 1.32的API变更和弃用

# 验证当前工作负载与1.32的兼容性

# 特别关注Istio 1.25.2与K8s 1.32的兼容性

1.2 备份关键配置

备份所有应用的YAML配置

导出重要的ConfigMap和Secret

记录当前插件版本和配置

1.3 扩容准备

将x86-c6a-large-nodegroup扩容至3个节点(为滚动升级提供缓冲)

确保有足够的计算资源处理工作负载迁移

阶段2:控制平面升级(预计30-45分钟)

2.1 升级EKS控制平面

aws eks update-cluster-version \

--region us-east-1 \

--name peculiar-funk-badger \

--kubernetes-version 1.32

影响评估:

控制平面升级期间API服务器会短暂不可用(通常<5分钟)

现有Pod不受影响,继续正常运行

新的Pod调度会暂停

阶段3:插件升级(预计45-60分钟)

3.1 核心插件升级顺序

vpc-cni → 1.32兼容版本

coredns → 1.32兼容版本

kube-proxy → 1.32兼容版本

aws-ebs-csi-driver → 最新兼容版本

metrics-server → 最新兼容版本

3.2 升级命令示例

aws eks update-addon \

--cluster-name peculiar-funk-badger \

--addon-name vpc-cni \

--addon-version <1.32-compatible-version> \

--resolve-conflicts OVERWRITE

阶段4:节点组升级(预计60-90分钟)

4.1 升级策略

采用滚动升级方式,确保业务连续性

先升级x86-c6a-large-nodegroup,再升级mng

利用maxUnavailable=1的配置逐个替换节点

4.2 节点组升级命令

# 升级x86-c6a-large-nodegroup

aws eks update-nodegroup-version \

--cluster-name peculiar-funk-badger \

--nodegroup-name x86-c6a-large-nodegroup \

--kubernetes-version 1.32

# 升级mng

aws eks update-nodegroup-version \

--cluster-name peculiar-funk-badger \

--nodegroup-name mng \

--kubernetes-version 1.32

业务连续性保障措施

1. Pod分布策略

确保关键应用(inventory-ver1, parking, review)的Pod分布在不同节点

利用Pod反亲和性规则避免单点故障

2. 健康检查增强

在升级期间增加应用健康检查频率

监控Istio网关和服务网格连通性

3. 流量管理

利用Istio的流量管理功能实现优雅的服务迁移

配置适当的超时和重试策略

4. 回滚准备

保留原始节点组配置

准备快速回滚脚本和流程

风险评估与缓解

1.主要风险

Istio兼容性:Istio 1.25.2可能需要更新以完全支持K8s 1.32

自定义AMI:mng使用自定义AMI,需要确保1.32兼容性

应用依赖:某些应用可能依赖特定的Kubernetes API版本

2.缓解措施

分阶段升级:先升级测试环境验证兼容性

蓝绿部署:考虑为关键应用实施蓝绿部署策略

监控告警:设置详细的监控告警机制

3.总体时间估算

总升级时间:3-4小时

业务影响:最小化,预期<5分钟的API服务器不可用

建议执行时间:业务低峰期(如凌晨2-6点)

4.升级后优化建议

节点组优化:升级完成后可以考虑统一节点组配置

资源调整:根据1.32的新特性调整资源配置

安全加固:应用1.32版本的安全最佳实践

这个升级方案确保了业务连续性,通过分阶段、滚动升级的方式最小化对线上服务的影响。建议在执行前先在测试环境进行完整的升级演练。

技术解析

这个案例展示了AI助手如何构建全面的EKS集群升级规划:

- 系统性信息收集:通过多种工具全面收集集群状态,包括:

- 集群核心配置(版本、平台版本等)

- 节点组配置与容量

- 运行中的工作负载状态

- 现有插件版本与配置

- 多维度分析与规划:基于收集到的数据进行深入分析,设计了符合最佳实践的升级路径:

- 按照控制平面→插件→数据平面的严格升级顺序

- 为每个阶段提供具体的命令和步骤

- 对每个阶段可能的影响进行评估

- 业务连续性设计:针对客户”不影响业务”的核心要求,设计了多层次的保护措施:

- 节点扩容缓冲策略

- 滚动更新与Pod分布策略

- 基于Istio的流量管理

- 全面的备份与回滚准备

- 风险管理与监控:通过识别潜在风险点并提供缓解措施,结合详细的监控计划,确保升级过程可控可观测:

- 识别关键组件兼容性风险

- 设计分步验证流程

- 提供具体的监控命令

这个案例展示了AI如何像经验丰富的云原生架构师一样,能够从简单的用户需求出发,通过系统性的信息收集和专业分析,生成一个全面、实用且符合AWS最佳实践的EKS升级方案。整个方案严格遵循控制平面→插件组件→数据平面的升级顺序,并特别关注业务连续性保障,体现了AI在复杂云基础设施管理中的实际应用价值。

4.6 实战案例总结

通过这些实战案例,我们可以看到EKS MCP Server与Amazon Q Developer CLI集成带来的显著优势:

- 知识门槛降低:无需深入了解Kubernetes或EKS的复杂细节

- 操作效率提升:通过自然语言完成复杂任务,无需记忆命令和参数

- 智能化故障排查:系统性分析问题,提供专业级别的故障诊断

- 决策支持增强:基于数据分析提供具体的优化建议

这种对话式Kubernetes管理方式特别适合以下场景:

- 对Kubernetes不熟悉的开发团队

- 需要快速解决问题的生产环境

- 资源优化和性能调优

- 复杂多集群环境管理

最重要的是,这种方式不仅提高了效率,也降低了操作错误的风险,为团队提供了一种更安全、更智能的云原生管理范式。

5. EKS MCP Server的价值与未来展望

在云原生时代,Kubernetes已成为容器编排的事实标准,而Amazon EKS作为托管Kubernetes服务,为众多企业提供了强大的容器部署平台。然而,Kubernetes的复杂性一直是阻碍其广泛采用的因素之一。EKS MCP Server的出现,标志着一种全新的交互范式诞生,它彻底改变了我们与EKS集群交互的方式。

EKS MCP Server通过将复杂的Kubernetes操作转化为自然语言对话,实现了从”命令式”到”意图式”的管理模式转变。这种转变意味着用户不再需要记忆大量命令、参数和YAML语法,而是可以直接表达他们的意图,由系统智能地解析并执行相应操作。

通过自然语言理解、智能工具集成和上下文感知等技术,EKS MCP Server正在重塑EKS集群管理的体验,使之更加直观、高效且富有洞察力。随着技术的不断成熟,我们有理由相信,这种”对话式Kubernetes管理”模式将成为未来云原生运维的主流范式。

在企业全面拥抱云原生架构的今天,EKS MCP Server提供了一条降低复杂性、提升效率、加速创新的道路。无论您是刚开始Kubernetes之旅,还是寻求优化现有EKS环境,EKS MCP Server都能为您提供显著价值,助力您在云原生时代保持竞争优势。

*前述特定亚马逊云科技生成式人工智能相关的服务目前在亚马逊云科技海外区域可用。亚马逊云科技中国区域相关云服务由西云数据和光环新网运营,具体信息以中国区域官网为准。

本篇作者

AWS 架构师中心:云端创新的引领者

探索 AWS 架构师中心,获取经实战验证的最佳实践与架构指南,助您高效构建安全、可靠的云上应用

|

|