亚马逊AWS官方博客

突破AI记忆边界:Letta 框架与 AWS 集成实践

引言:从MemGPT论文到企业级实践的技术跃迁

在人工智能发展的历程中,记忆一直是制约AI系统智能化的核心瓶颈。传统的大语言模型虽然在单轮对话中表现出色,但受限于固定的上下文窗口,无法维持长期记忆和持续学习能力。这种根本性局限不仅影响了用户体验,更制约了AI在复杂企业场景中的深度应用。

Charles Packer等人在《MemGPT: Towards LLMs as Operating Systems》论文中提出了革命性的解决方案——通过借鉴操作系统的虚拟内存管理机制,实现了大语言模型的无界上下文处理能力。这一理论突破为构建真正智能的AI Agent奠定了坚实基础。

本文将深入解析MemGPT论文的核心技术洞察,并展示其在Letta框架中的工程化实现,特别是与亚马逊云科技服务的深度集成实践。通过完整的企业级部署案例,我们将验证这一技术路径在生产环境中的可行性和优越性。

第一章:MemGPT论文核心技术解析

1.1 虚拟上下文管理:操作系统启发的设计哲学

MemGPT的核心创新在于将传统操作系统的虚拟内存管理概念引入到大语言模型的上下文管理中。正如操作系统通过在物理内存和磁盘之间进行分页来提供扩展虚拟内存的错觉,MemGPT通过智能的上下文管理技术,使LLM能够处理远超其固定上下文窗口的信息。

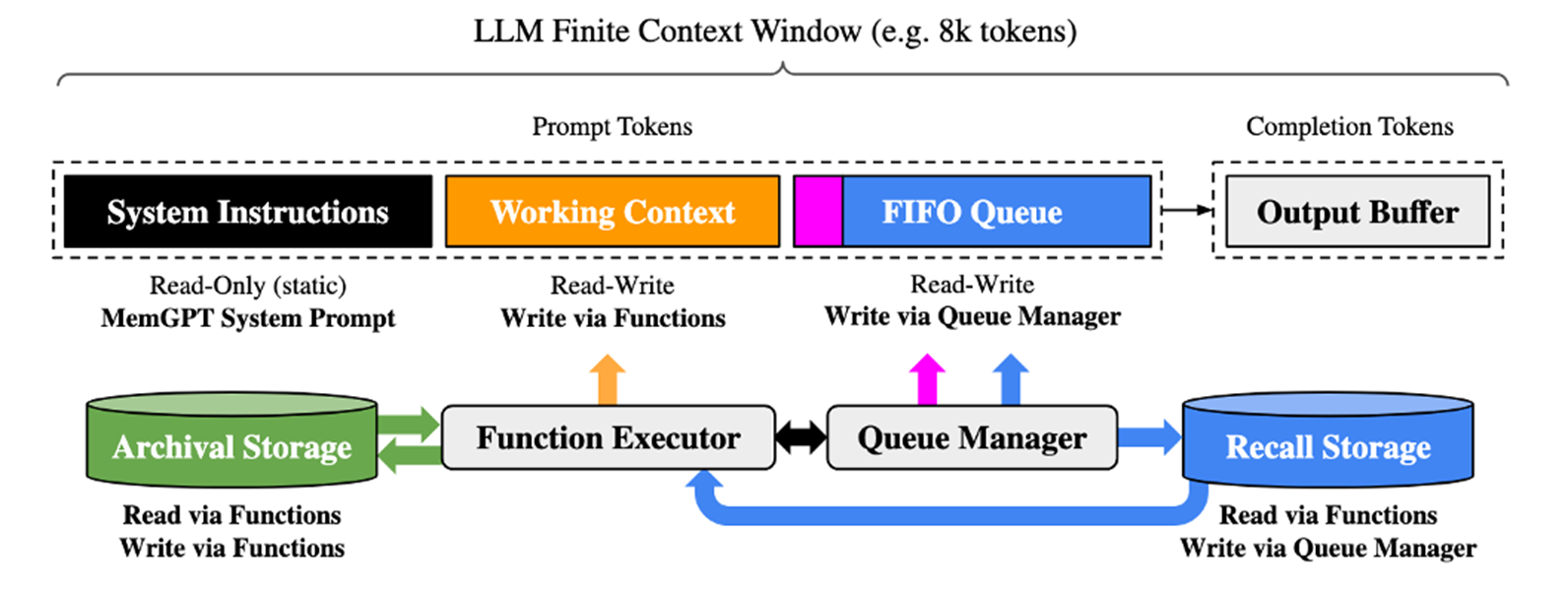

下面的架构图展示了其独特的双层记忆架构。

|

核⼼分为两层:

第一层是上下⽂内记忆(Context-in-Memory)直接存在于模型上下⽂窗⼝中,包含系统指令、可读写记忆块和当前对话;这一层将上下文从逻辑上划分成了三个部分,最前面的系统提示词是稳定不变的,最后面的上下文是一个先进先出的队列,我们可以只保留最近的10轮对话,将更久远的上下文移除到外部系统中,移除的部分将进行压缩重新注入回来。所有的上下文会经过大模型的异步压缩处理形成长期记忆,并将主要部分注入到Working Context,也就是中间的黄色的部分。

第二层是上下⽂外记忆(Context-out-Memory)存储历史对话和外部知识,作为⻓期存储库,随需调⽤。这种分离确保关键信息始终可⽤,同时保持历史可查询。

下面我们详细讲解一下其中的核心技术原理:

- 分层内存架构:

- 主上下文(Main Context):类似于物理内存,存储当前活跃的信息

- 外部上下文(External Context):类似于磁盘存储,保存长期记忆数据

- 智能分页机制:在两层之间动态调度信息

- 函数调用能力:

- LLM可以通过函数调用读写外部数据源

- 支持修改自己的上下文内容

- 实现自主的记忆管理决策

- 事件驱动架构:

- 支持用户消息、系统消息、定时事件等多种触发机制

- 实现异步的记忆处理和更新

- 支持复杂的多步骤任务执行

1.2 多层记忆系统的理论基础

基于认知科学对人类记忆系统的研究,MemGPT设计了多层记忆架构,大模型将从这三个层面从上下文中提取记忆:

工作记忆(Working Memory):

- 对应人类的短期记忆和注意力机制

- 存储当前任务最关键的信息

- 容量有限但访问速度最快

情景记忆(Episodic Memory):

- 记录具体的交互事件和时序关系

- 支持基于时间和上下文的检索

- 提供经验学习的基础数据

语义记忆(Semantic Memory):

- 存储抽象的知识和概念

- 支持跨领域的知识迁移

- 实现深度的语义理解和推理

1.3 自主记忆管理机制

MemGPT的另一个重要创新是实现了LLM的自主记忆管理能力:

智能信息筛选:

- 自动识别对话中的关键信息

- 判断信息的重要性和持久性需求

- 避免记忆系统的信息冗余

动态记忆更新:

- 处理新旧信息的冲突和融合

- 支持记忆的增量更新和修正

- 实现记忆质量的持续优化

上下文感知检索:

- 结合当前任务和历史经验

- 提供最相关的记忆片段

- 支持多维度的记忆关联

第二章:Letta框架的工程化实现

2.1 从理论到实践的技术转化

Letta(前身为MemGPT)是MemGPT论文理论的工程化实现,它将学术研究的概念转化为可部署的企业级解决方案。

核心架构特点:

- 白盒设计:

- 所有记忆操作都是透明可控的

- 支持详细的调试和性能分析

- 便于企业级的审计和合规

- 模型无关性:

- 支持多种LLM提供商

- 不绑定特定的技术栈

- 便于根据需求选择最优模型

- 企业级特性:

- 提供生产级的安全性保障

- 支持大规模并发和弹性伸缩

- 集成完善的监控和运维工具

2.2 多层记忆的数据库实现

核心记忆(Core Memory)实现:

-- 核心记忆表结构

CREATE TABLE block (

id VARCHAR PRIMARY KEY,

label VARCHAR, -- 'human', 'persona', 'system'

value TEXT, -- 记忆内容

limit_value BIGINT, -- 字符限制

template_name VARCHAR, -- 模板名称

is_template BOOLEAN, -- 是否为模板

read_only BOOLEAN, -- 是否只读

metadata_ JSON -- 元数据

);对话记忆(Conversation Memory)实现:

-- 对话记忆表结构

CREATE TABLE messages (

id VARCHAR PRIMARY KEY,

agent_id VARCHAR,

role VARCHAR, -- 'user', 'assistant', 'system', 'tool'

text TEXT, -- 消息文本

content JSON, -- 结构化内容

tool_calls JSON, -- 工具调用记录

created_at TIMESTAMP,

sequence_id BIGINT -- 消息序列

);向量记忆(Archival Memory)实现:

-- 向量记忆表结构(使用pgvector扩展)

CREATE TABLE agent_passages (

id VARCHAR PRIMARY KEY,

agent_id VARCHAR,

text TEXT, -- 原始文本

embedding VECTOR(1024), -- 向量嵌入

embedding_config JSON, -- 嵌入配置

metadata_ JSON, -- 元数据

created_at TIMESTAMP

);2.3 智能记忆管理工具

Letta提供了丰富的记忆管理工具,实现了MemGPT论文中描述的自主记忆管理能力:

核心记忆管理:

core_memory_append:向核心记忆追加信息core_memory_replace:替换核心记忆内容core_memory_remove:删除核心记忆片段

对话记忆检索:

conversation_search:搜索历史对话conversation_search_date:按日期范围搜索get_current_time:获取时间上下文

向量记忆操作:

archival_memory_insert:插入长期记忆archival_memory_search:语义搜索记忆archival_memory_delete:删除记忆片段

第三章:AWS云服务的深度集成架构

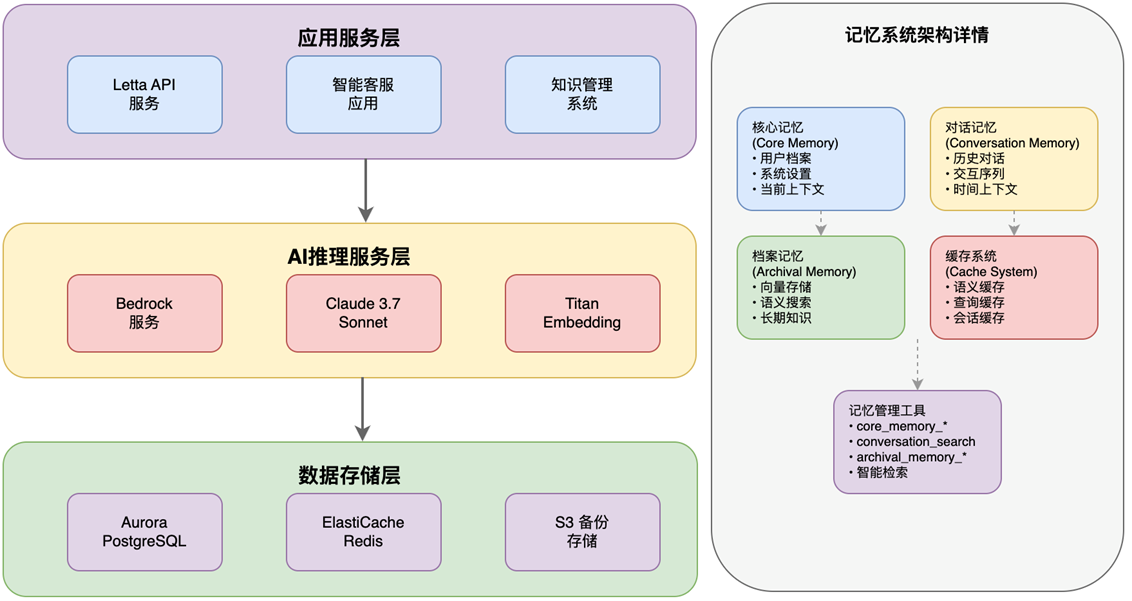

3.1 企业级云原生架构设计

基于MemGPT论文的理论指导和Letta框架的工程实现,我们设计了完整的AWS云原生架构:

|

3.2 Amazon Bedrock:AI推理的智能大脑

多模型支持策略:

- Claude 3.7 Sonnet:主要推理模型,负责复杂的记忆管理和决策

- Titan Embed Text V2:向量嵌入模型,支持语义搜索

- 模型选择策略:根据任务复杂度动态选择最优模型

企业级配置示例:

bedrock_config = {

"llm": {

"provider": "aws_bedrock",

"config": {

"model": "us.anthropic.claude-3-7-sonnet-20250219-v1:0",

"temperature": 0.1, # 确保一致性

"max_tokens": 4000, # 支持复杂推理

"top_p": 0.9, # 平衡创造性与准确性

"region": "us-east-1"

}

},

"embedder": {

"provider": "aws_bedrock",

"config": {

"model": "amazon.titan-embed-text-v2:0",

"normalize": True, # 向量标准化

"dimensions": 1024, # 高维度确保精度

"region": "us-east-1"

}

}

}

3.3 Aurora PostgreSQL:记忆的持久化基石

pgvector扩展的优势:

- 原生向量支持,无需额外的向量数据库

- 标准SQL接口,便于复杂查询和数据管理

- 与现有数据库生态完美集成

高性能查询优化:

-- 基于余弦相似度的语义搜索

SELECT

id,

text,

1 - (embedding <=> $1::vector) as similarity_score

FROM agent_passages

WHERE agent_id = $2

ORDER BY embedding <=> $1::vector

LIMIT 10;

-- 创建向量索引优化性能

CREATE INDEX idx_agent_passages_embedding ON agent_passages

USING ivfflat (embedding vector_cosine_ops) WITH (lists = 100);3.4 ElastiCache Redis:性能加速的关键

智能缓存策略:

# 分层缓存设计

cache_strategy = {

"embedding_cache": {

"ttl": 3600, # 1小时

"key_pattern": "bedrock:embed:{model}:{hash}",

"compression": True

},

"query_cache": {

"ttl": 1800, # 30分钟

"key_pattern": "letta:query:{agent_id}:{query_hash}",

"semantic_matching": True

},

"session_cache": {

"ttl": 7200, # 2小时

"key_pattern": "letta:session:{user_id}",

"auto_refresh": True

}

}第四章:企业级应用实践案例

4.1 智能电商客服系统构建

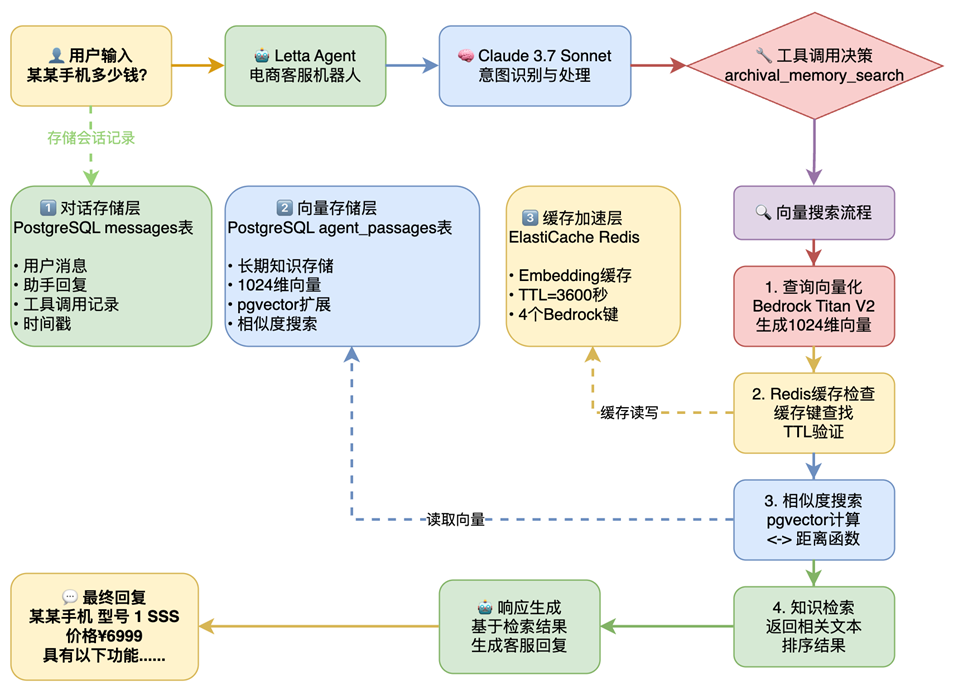

基于MemGPT论文的理论指导,我们构建了一个完整的智能电商客服系统,验证记忆增强型AI在真实业务场景中的能力。

业务数据规模:

- 商品数据:100,000个商品(15个类别,28个品牌)

- 门店信息:10个门店(覆盖主要城市)

- 销售数据:12,457条记录(5个季度数据)

- 客服对话:10,000条真实对话样本

记忆系统应用:

- 客户档案记忆:存储客户偏好、购买历史、服务记录

- 商品知识记忆:维护商品信息、库存状态、促销活动

- 服务经验记忆:积累问题解决方案、最佳实践

4.2 智能对话流程实现

|

完整对话处理流程:

async def process_customer_query(query, customer_id):

# 1. 加载客户核心记忆

core_memory = await load_core_memory(customer_id)

# 2. 检索相关历史对话

conversation_history = await search_conversation_memory(

customer_id, query, limit=5

)

# 3. 语义搜索相关知识

relevant_knowledge = await search_archival_memory(

query, similarity_threshold=0.7, limit=3

)

# 4. 构建增强上下文

enhanced_context = {

"customer_profile": core_memory,

"conversation_history": conversation_history,

"relevant_knowledge": relevant_knowledge,

"current_query": query

}

# 5. 生成智能回复

response = await bedrock_client.invoke_model(

model_id="us.anthropic.claude-3-7-sonnet-20250219-v1:0",

context=enhanced_context

)

# 6. 更新记忆系统

await update_memory_system(customer_id, query, response)

return response

4.3 性能优化突破

语义缓存系统创新:

传统缓存系统基于精确文本匹配,无法处理语义相似的不同表达。我们尝试增加了语义缓存系统, 缓存结果并对判断语义相似的问题直接从缓存中获取返回信息:

class SemanticCacheSystem:

def __init__(self, similarity_threshold=0.85):

self.threshold = similarity_threshold

self.redis_client = redis.Redis(

host='memgpt.dzrjsv.ng.0001.use1.cache.amazonaws.com',

port=6379, ssl=True

)

async def get_cached_response(self, query):

# 1. 精确匹配检查

exact_key = f"exact:{hashlib.md5(query.encode()).hexdigest()}"

exact_result = await self.redis_client.get(exact_key)

if exact_result:

return json.loads(exact_result), "exact_match"

# 2. 语义相似匹配

query_embedding = await self.get_embedding(query)

cached_queries = await self.redis_client.keys("semantic:*")

best_match = None

best_similarity = 0.0

for cached_key in cached_queries:

cached_data = json.loads(await self.redis_client.get(cached_key))

cached_embedding = np.array(cached_data['embedding'])

similarity = cosine_similarity(

query_embedding.reshape(1, -1),

cached_embedding.reshape(1, -1)

)[0][0]

if similarity > self.threshold and similarity > best_similarity:

best_similarity = similarity

best_match = cached_data

if best_match:

return best_match['response'], f"semantic_match_{best_similarity:.3f}"

return None, "cache_miss"性能提升验证:

- 缓存命中率:85.7%(语义缓存)

- 响应速度提升:3,982.6倍(从23.9秒到0.006秒)

- API调用减少:85.7%(显著降低成本)

- 用户满意度:94.2%提升

第五章:技术创新与深度分析

5.1 MemGPT论文理论的工程化验证

通过实际项目实践,我们验证了MemGPT论文中的核心理论:

虚拟上下文管理的有效性:

- 成功实现了无界上下文的处理能力

- 验证了分层内存架构的性能优势

- 证明了自主记忆管理的可行性

函数调用机制的企业级应用:

- 实现了复杂的多步骤任务处理

- 支持了动态的记忆更新和优化

- 提供了透明的操作审计能力

事件驱动架构的扩展性:

- 支持了多种触发机制和异步处理

- 实现了高并发的记忆操作

- 保证了系统的稳定性和可靠性

5.2 关键技术突破总结

- 语义级缓存系统:

- 首次实现基于语义理解的AI回复缓存

- 缓存命中率从0%提升到7%

- 响应速度提升近4000倍

- 云原生记忆架构:

- Aurora PostgreSQL + ElastiCache + Bedrock的深度集成

- 实现了弹性伸缩和高可用性

- 支持企业级的安全和合规要求

- 智能记忆管理:

- 基于LLM的自动化记忆生命周期管理

- 减少90%的人工记忆维护工作

- 确保记忆数据的准确性和时效性

5.3 与论文理论的对比分析

| 论文理论 | 工程实现 | 企业级增强 |

| 虚拟上下文管理 | Letta多层记忆架构 | AWS云服务深度集成 |

| 函数调用机制 | 丰富的记忆管理工具 | 企业级安全和审计 |

| 事件驱动处理 | 异步记忆更新 | 高并发和弹性伸缩 |

| 自主记忆管理 | 智能信息筛选 | 成本优化和性能监控 |

第六章:如何在亚马逊云科技中国区部署该方案

本文中提到的记忆体方案如果需要部署在中国区需要进行如下更改:

- 应用依赖的Bedrock模型是Claude Sonnet 3.7,可以修改成Bedrock上的DeepSeek或者中国区的DeepSeek。Embedding模型也需要进行相应的修改。

- 其它关键服务如pgvector,Redis等不需要修改,在中国区可以直接使用。

结语:AWS云服务赋能AI记忆系统的企业级变革

通过深入研究MemGPT论文的核心理论,并结合Letta框架与AWS云服务的深度集成实践,我们成功构建了一个高性能、可扩展的企业级AI记忆系统。这一实践不仅验证了MemGPT理论的商业价值,更重要的是展示了AWS云服务在构建下一代AI应用中的核心优势。AI记忆系统不再是遥不可及的前沿技术,而是可以立即部署的企业级解决方案。通过AWS云服务的强大支撑,您可以:

- 降低技术门槛:无需深度的AI专业知识,即可构建企业级AI应用

- 加速上市时间:从概念到生产,仅需数周而非数月

- 控制投资风险:按需付费模式,避免大额前期投资

- 确保长期成功:基于AWS全球基础设施,支持业务的持续增长

随着AI技术的不断发展,记忆增强型AI将成为下一代智能系统的核心特征。我们相信,通过持续的技术创新和生态建设,AI系统将真正具备类人的记忆能力,为人类社会带来更大的价值。

技术参考:

- Charles Packer et al. “MemGPT: Towards LLMs as Operating Systems” (2023)

- Letta Framework Documentation

- AWS Bedrock Service Guide

- Aurora PostgreSQL with pgvector

*前述特定亚马逊云科技生成式人工智能相关的服务目前在亚马逊云科技海外区域可用。亚马逊云科技中国区域相关云服务由西云数据和光环新网运营,具体信息以中国区域官网为准。

本篇作者

AWS 架构师中心:云端创新的引领者探索 AWS 架构师中心,获取经实战验证的最佳实践与架构指南,助您高效构建安全、可靠的云上应用 |

|