- IA generativa›

- Amazon Bedrock›

- Evaluaciones

Evaluaciones de Amazon Bedrock

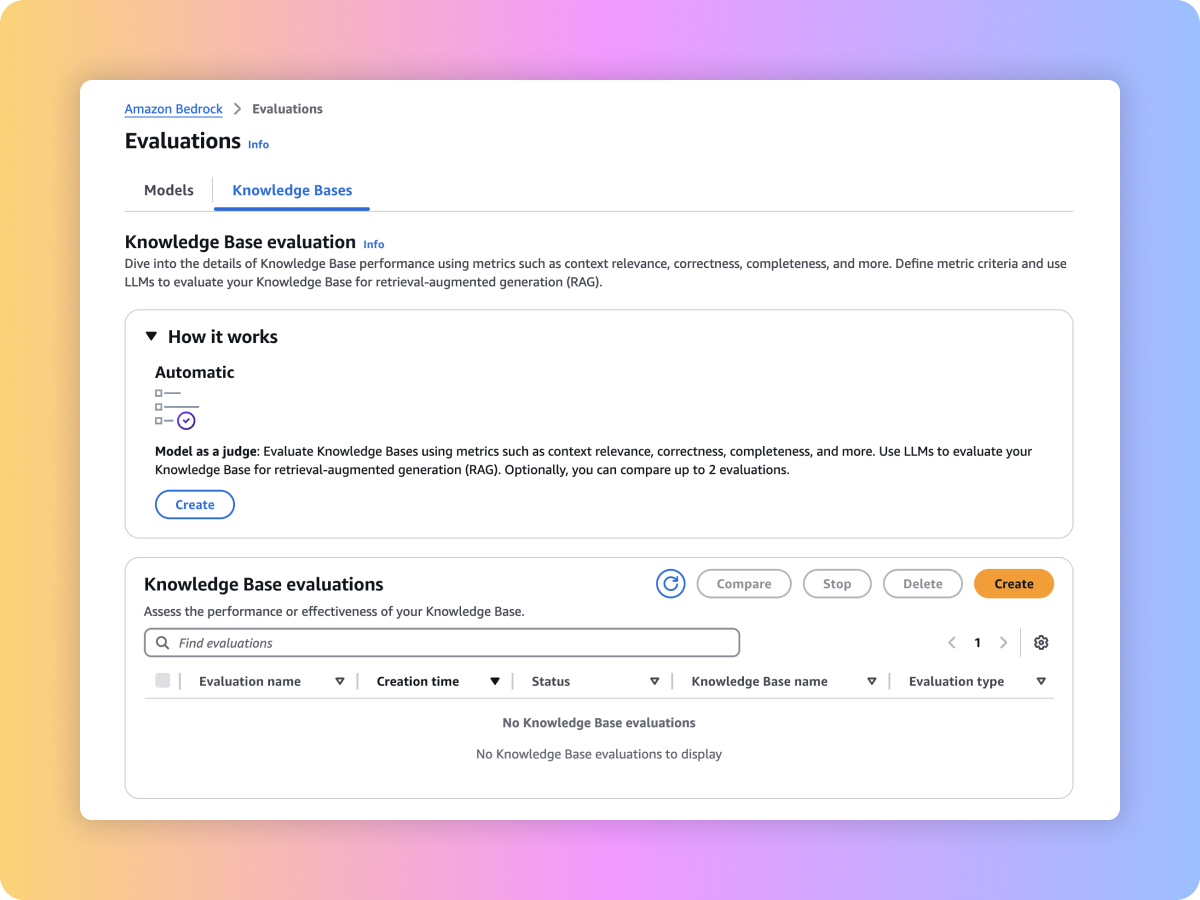

Evalúe modelos fundacionales (FM), incluidos los modelos personalizados e importados, para encontrar modelos que se ajusten a sus necesidades. También puede evaluar su flujo de trabajo de generación aumentada por recuperación (RAG) integral o de recuperación en las Bases de conocimiento de Amazon Bedrock.

Información general

Amazon Bedrock proporciona herramientas de evaluación para acelerar la adopción de aplicaciones de IA generativa. Evalúe, compare y seleccione el FM para su caso de uso con la evaluación del modelo. Prepare sus aplicaciones de RAG para la producción, ya sea que estén creadas en las Bases de conocimiento de Amazon Bedrock o en sus propios sistemas de RAG personalizados, mediante la evaluación de las funciones de recuperación o recuperación y generación.

Tipos de evaluación

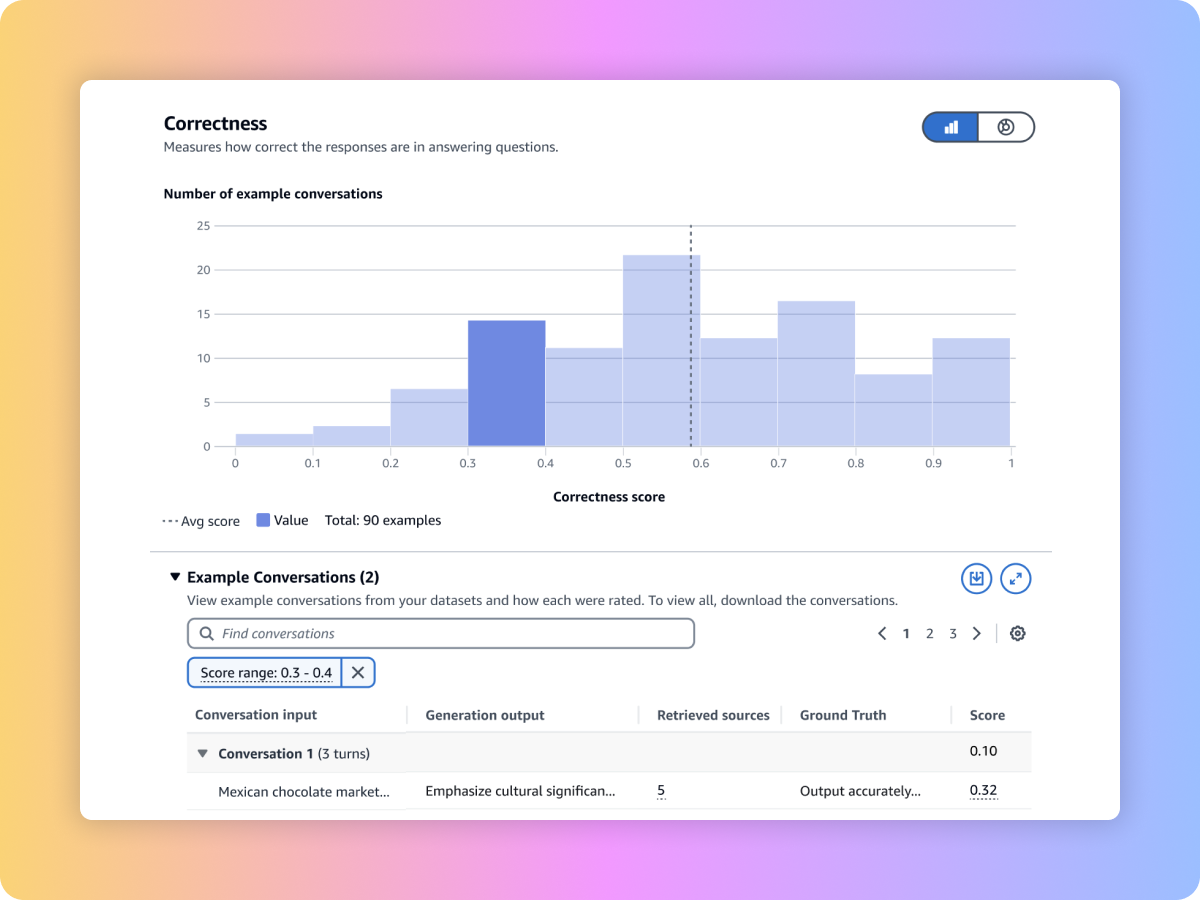

Utilice un modelo de lenguaje de gran tamaño (LLM) como juez para evaluar los resultados del modelo mediante sus conjuntos de datos de peticiones personalizadas con métricas como la exactitud, la integridad y la nocividad.

Evalúe los resultados del modelo a través de algoritmos y métricas tradicionales del lenguaje natural, como BERT Score, F1 y otras técnicas de coincidencia exacta, mediante conjuntos de datos de peticiones integrados o mediante sus propios conjuntos.

Evalúe los resultados del modelo con su propio personal o haga que AWS administre las evaluaciones de las respuestas a sus conjuntos de datos de peticiones personalizadas con métricas integradas o personalizadas.

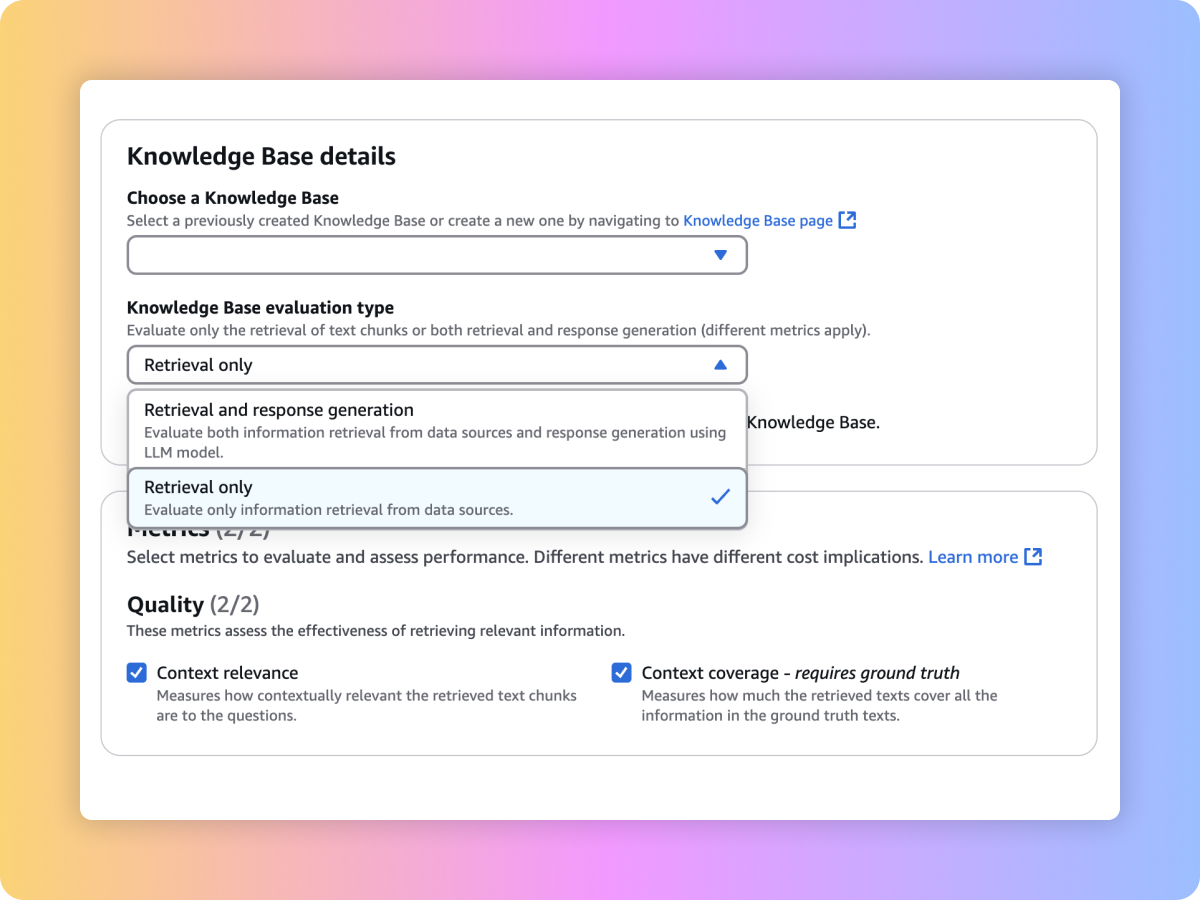

Evalúe la calidad de recuperación del sistema de RAG personalizado o de las Bases de conocimiento de Amazon Bedrock con peticiones y métricas propias, como la adecuación y la cobertura del contexto.

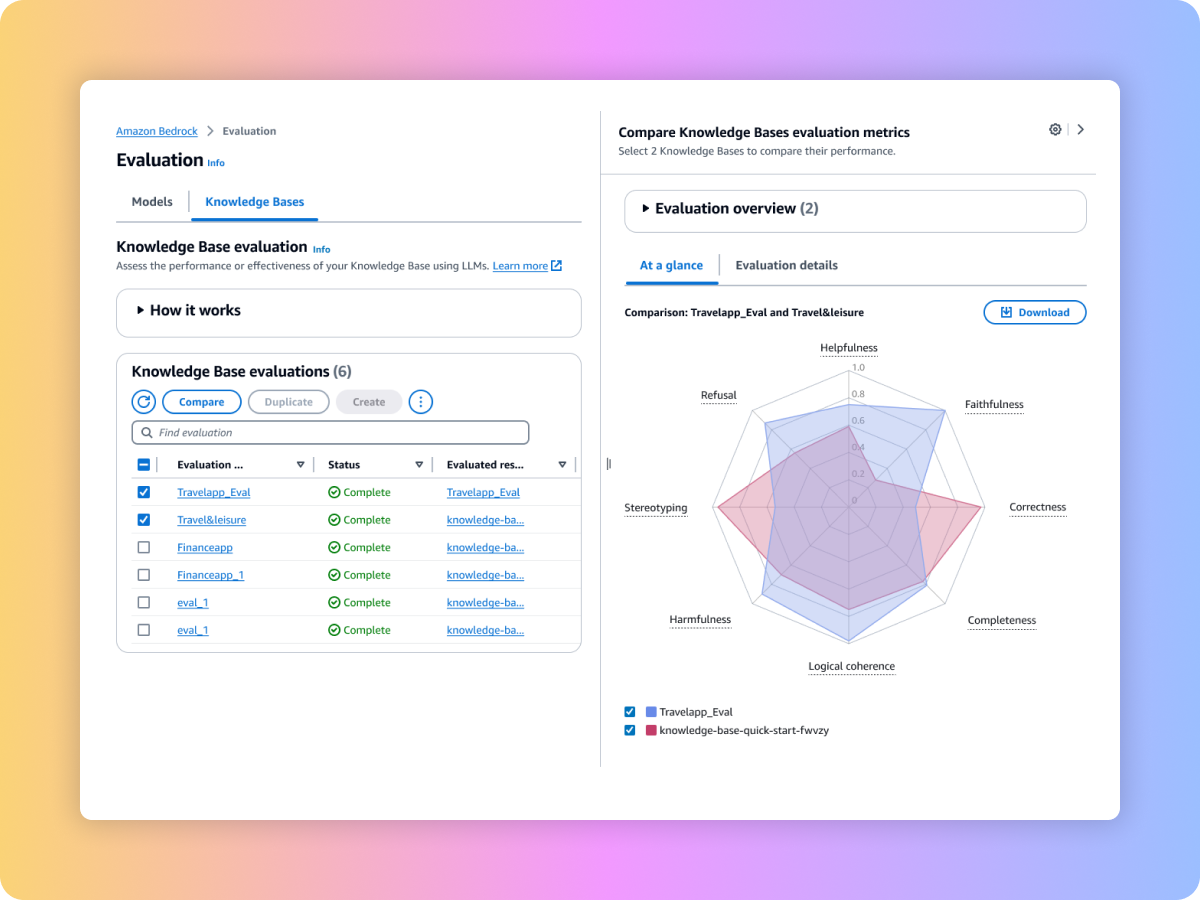

Evalúe el contenido generado en el flujo de trabajo integral de RAG, ya sea desde una canalización personalizada de RAG o desde las Bases de conocimiento de Amazon Bedrock. Use peticiones y métricas propias, como la fidelidad (detección de alucinaciones), la exactitud y la integridad.

Cómo evaluar íntegramente el flujo de trabajo de RAG

Cómo asegurar la recuperación completa y pertinente de su sistema de RAG

Cómo evaluar los modelos fundacionales para seleccionar el que mejor se adapte a su caso de uso

Cómo comparar los resultados de varios trabajos de evaluación para tomar decisiones con mayor rapidez