- AWS Builder Center›

- builders.flash

AI 技術で高校生の未来を支援する『AI-m(エイム)』~ 面接練習の革新

2025-01-06 | Author : 三木 天平 (株式会社マイナビ), 山田 直央 (株式会社マイナビ)

はじめに

こんにちは。

株式会社マイナビのデジタルテクノロジー戦略本部に所属しております三木と申します。

普段は AI 関連技術を活用し、会社 (顧客・利用者) の課題解決に取り組んでいます。

今回は、高校生の面接対策と教員の指導負担軽減を目指す、動画面接練習サービス『AI-m(エイム)』での AI 活用についてご説明します。

builders.flash メールメンバー登録

builders.flash メールメンバー登録で、毎月の最新アップデート情報とともに、AWS を無料でお試しいただけるクレジットコードを受け取ることができます。

AI-m(エイム)について

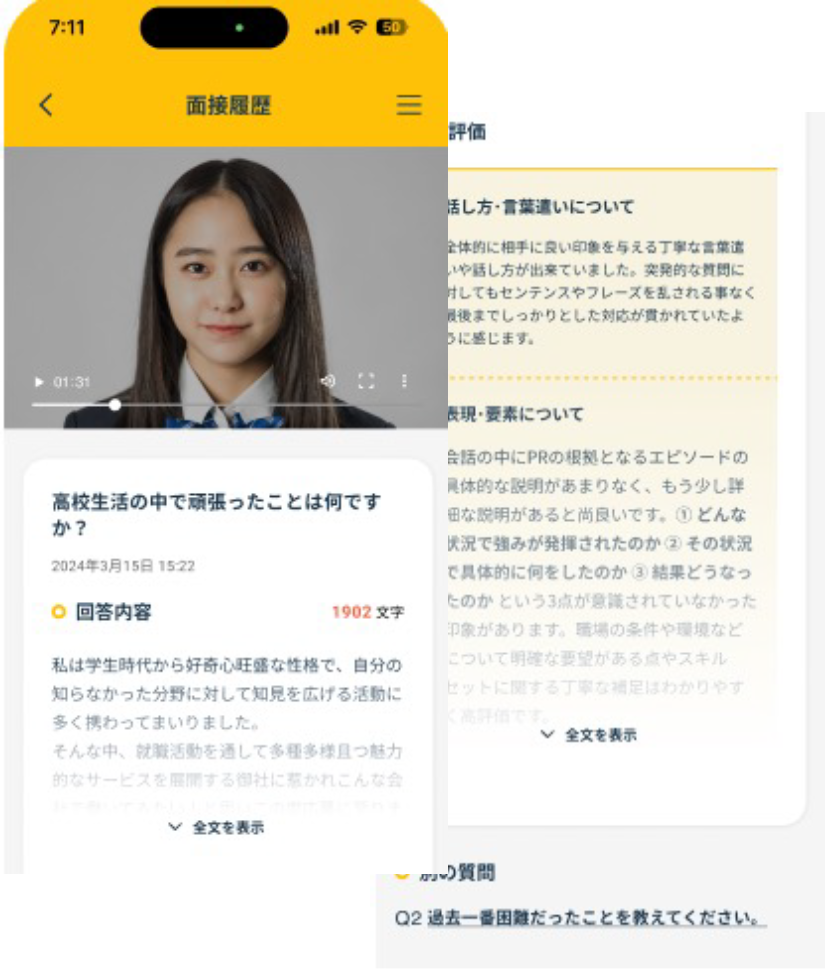

サービスの特徴

『AI-m (エイム)』を使って生徒は事前に面接練習を行い、自分の弱点を把握します。また、その結果を教員が確認することで丁寧な指導をサポートします。面接の録画と文字起こし機能により、効率的な面接対策を実現するサービスです。

AI 技術による面接フィードバック

さて、ここからは面接練習を通して AI が詳細なフィードバックをどのように提供しているのか、2 つのステップに分けて紹介いたします。

アーキテクチャ図

STEP 1 : 音声データの文字起こし

このステップでは、面接音声データの文字起こしを行います。 ワークフローとしては大きく 3 つのステップに分かれています。

1. アプリケーションからのリクエスト受付

-

Amazon API Gateway を使用してリクエストを受け付けます。

-

API Gateway Lambda authorizers を通じて認可を行い、許可されたデータは Amazon Simple Storage Service (Amazon S3) に直接格納されます(図中①・②)。

2. リクエスト通知とキューイング

-

Amazon S3 への格納完了を通知し(図中③)、Amazon Simple Queue Service (SQS) にリクエストをキューイングします。

キューイングを実施する理由としては後続処理である「文字起こし」にあります。

そこでは Amazon ECS クラスターで処理サーバーを構成しているのですが動的スケーリングにするとプロビジョニングに時間がかかってしまい、ユーザー体験の質に影響があるためサーバー台数は固定値で運用しております。サーバー台数が固定であるが故に全サーバーが高負荷になるとリクエストが失敗してしまいます。そのためここでは Amazon SQS を用いてキューイングを行なっております。

3. 文字起こし

-

キューイングされたデータは AWS Lambda を介して、Amazon Elastic Container Service(ECS)上で稼働する文字起こしサーバーに渡されます (図中④~⑤)。

-

Amazon ECS は、文字起こし処理をスケーラブルに実行します。

【STEP 1 で工夫した点】

-

Amazon S3 への直接格納

AWS Lambda の 6 MB ペイロード制限を回避するため、Amazon API Gateway から Amazon S3 への直接格納を実現しました。これにより、大きな音声データもスムーズに処理可能です。 -

高負荷時への対応

当初、高負荷時は Amazon ECS のスケーリングによって対応することを予定しておりました。しかし動的スケーリングを行うことでプロビジョニング時間が発生してしまい、要件としてのレスポンス速度が担保できなくなってしまいます。

そこでサーバー台数は固定にし、その分サーバーへの負荷を Elastic Load Balancing (ELB) と前段の Amazon SQS を活用することで、システムへの高負荷を緩和。負荷分散と非同期処理を組み合わせることで、ピーク時のリクエストにも柔軟に対応しています。

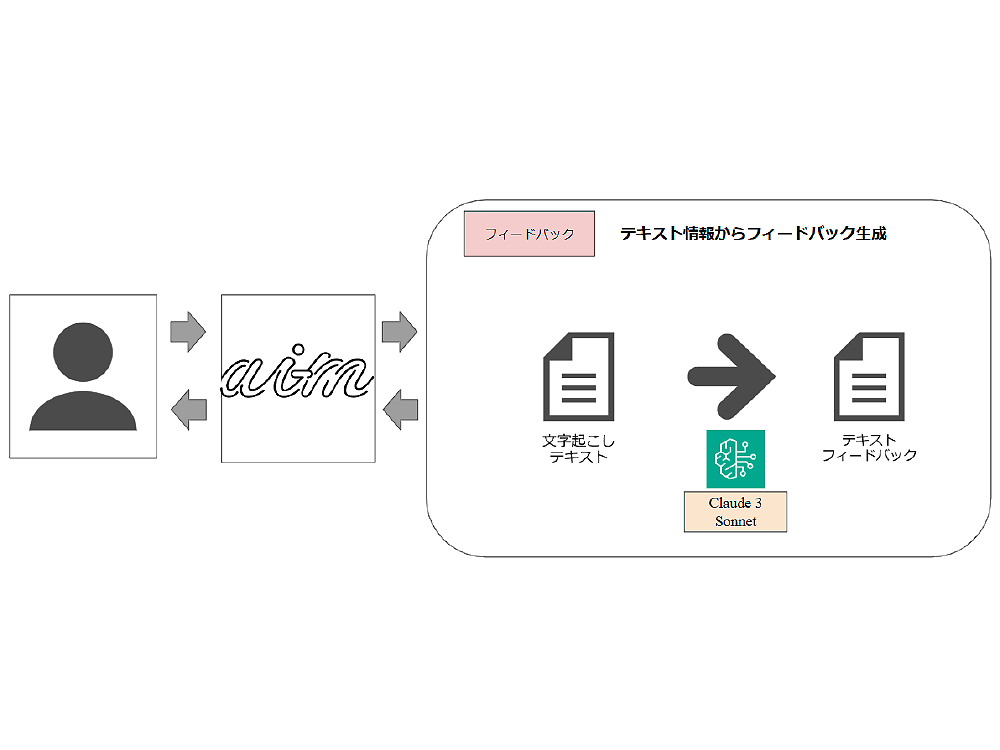

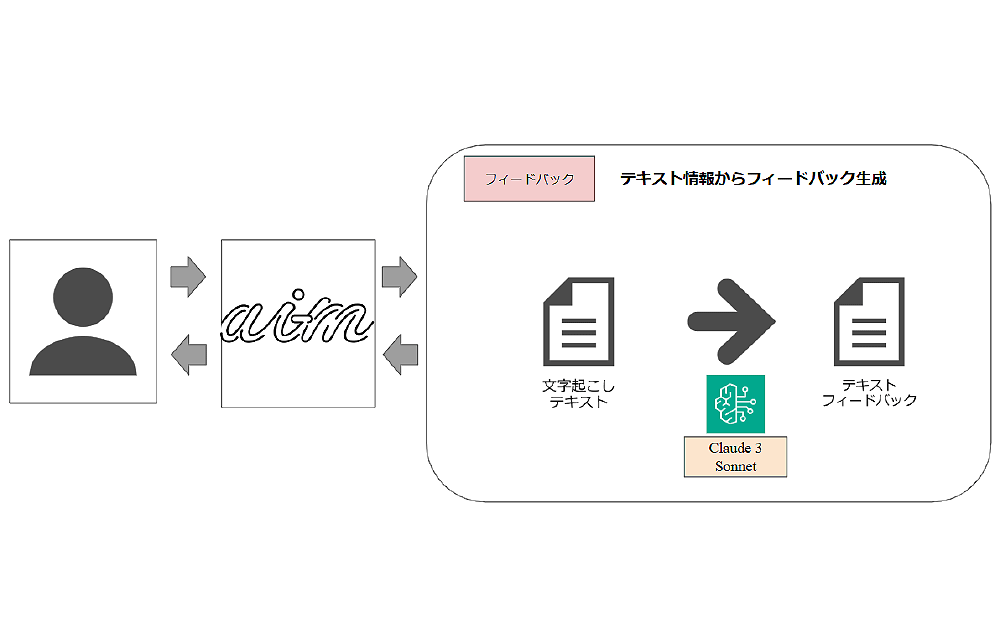

STEP 2 : フィードバックテキストの生成

このステップでは、文字起こしされたテキストを基にフィードバックテキストを生成します。生成されたフィードバックは、面接者の振り返りや改善に役立てられます。

1. リクエスト受付とキューイング

-

アプリケーションからリクエストされたテキストは、Amazon API Gateway を経由し、Amazon SQS にキューイングされます (図中⑥)。

こちらでもキューイングを実施しているのは STEP 1 と同様に安定したシステム管理や急な高負荷などに対して対応するためです。

2. フィードバック生成

-

キューイングされたデータは AWS Lambda で処理され、Amazon Bedrock を利用してフィードバックテキストを生成します (図中⑦)。

-

Amazon Bedrock では Anthropic 社の Claude 3 Sonnet を使用し、高品質なフィードバック生成を実現しています。

技術検証の段階では Anthropic 社に限らず Amazon Bedrock に用意してあるさまざまなモデルを対象としており、検証が進むにつれてモデルを絞っていった結果、Anthropic 社の Claude モデルになりました。

その中でも精度面、コスト面、速度面などを考慮した上で Claude 3 Sonnet に決定いたしました。

【STEP 2 で工夫した点】

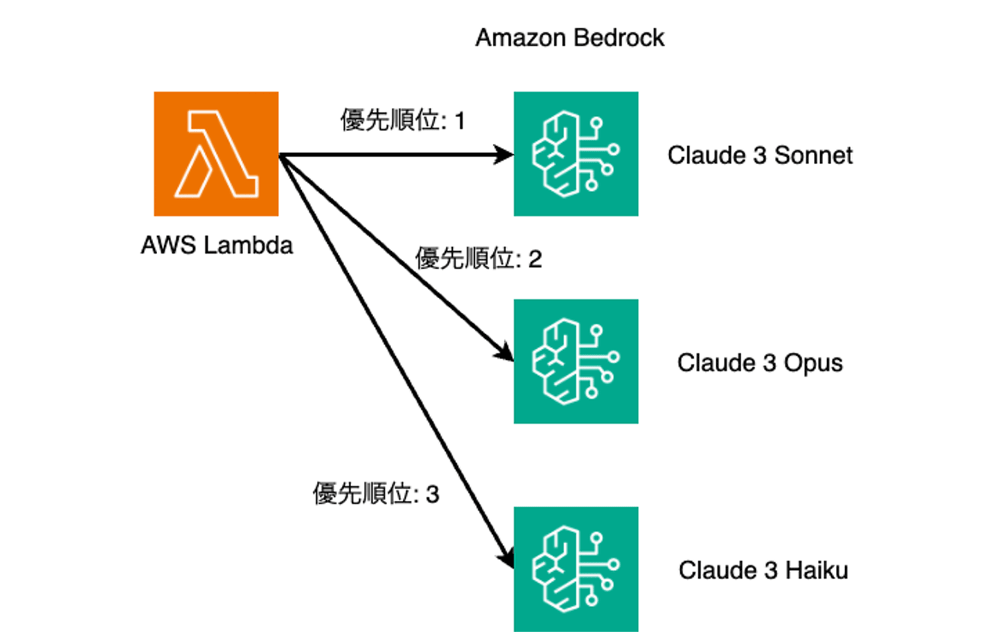

1. 生成 AI 利用時のフォールバック処理

Amazon Bedrock 利用中にエラーが発生した場合、フォールバックとして他の生成 AI にリクエストを送信する仕組みを Lambda で構築。サービスの可用性を向上させました。

モデルの使用優先順位を内部で決め、優先順にモデルへのリクエスト処理を行なっていきます。もし Amazon Bedrock 利用中にエラーが発生した場合は優先順位次点のものにリクエストを行うようにすることでなるべくシステムへの影響を軽減できるようにしております。(イメージ図)

2. リクエストキューイングによる安定性向上

Amazon SQS を使用することで、同時に複数のリクエストが発生しても安定したシステム動作を実現しました。

まとめ

本記事では、AWS サービスを活用した AI プロダクトの事例をご紹介しました。

今回ご紹介した『AI-m(エイム)』サービスは現在無料トライアル版※ であり、ニーズを把握するための重要なステップとして運用しています。トライアル版を通じて、課題解決にどれほど貢献できたか、またコストがどれほどかかったかを評価し、今後のプロダクト改善と価値向上に役立てていきたいと考えています。

この点につきましては、今後の機会に改めてご紹介できればと思います。

※2025 年 1 月 8 日 (水) をもって無料利用受付期間は終了いたします。

筆者プロフィール

三木 天平 (Tempei Miki)

株式会社マイナビ

デジタルテクノロジー戦略本部所属

データ分析や AI プロダクト開発に携わる。

趣味は温泉巡りと映画鑑賞。好きな食べ物は味噌煮込みうどん。

山田 直央

株式会社マイナビ

デジタルテクノロジー戦略本部所属

AI プロダクト開発や PoC 検証業務などを担当

Did you find what you were looking for today?

Let us know so we can improve the quality of the content on our pages