- Machine Learning›

- Amazon SageMaker AI›

- MLOps de Amazon SageMaker AI

Amazon SageMaker para MLOps

Proporcione rápidamente modelos de ML de producción de alto rendimiento a escala

Por qué elegir Amazon SageMaker MLOps

Funcionamiento

Beneficios de MLOps de SageMaker

Aceleración del desarrollo de modelos

Aprovisionamiento de entornos de ciencia de datos estandarizados

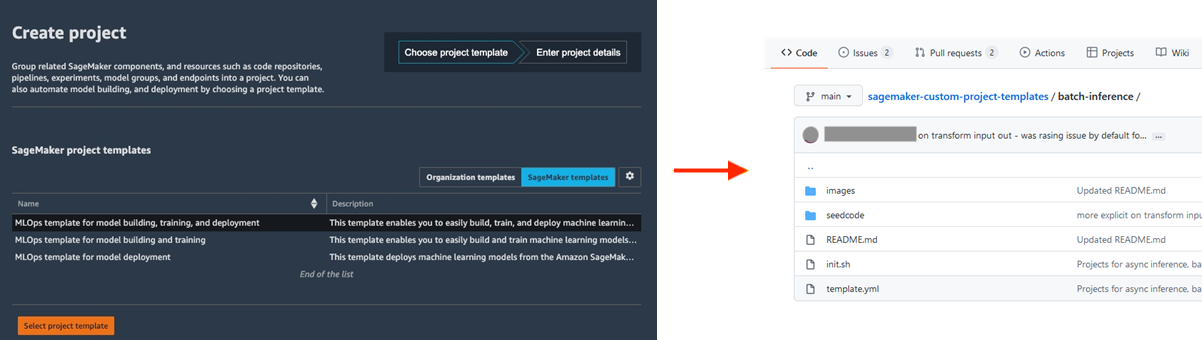

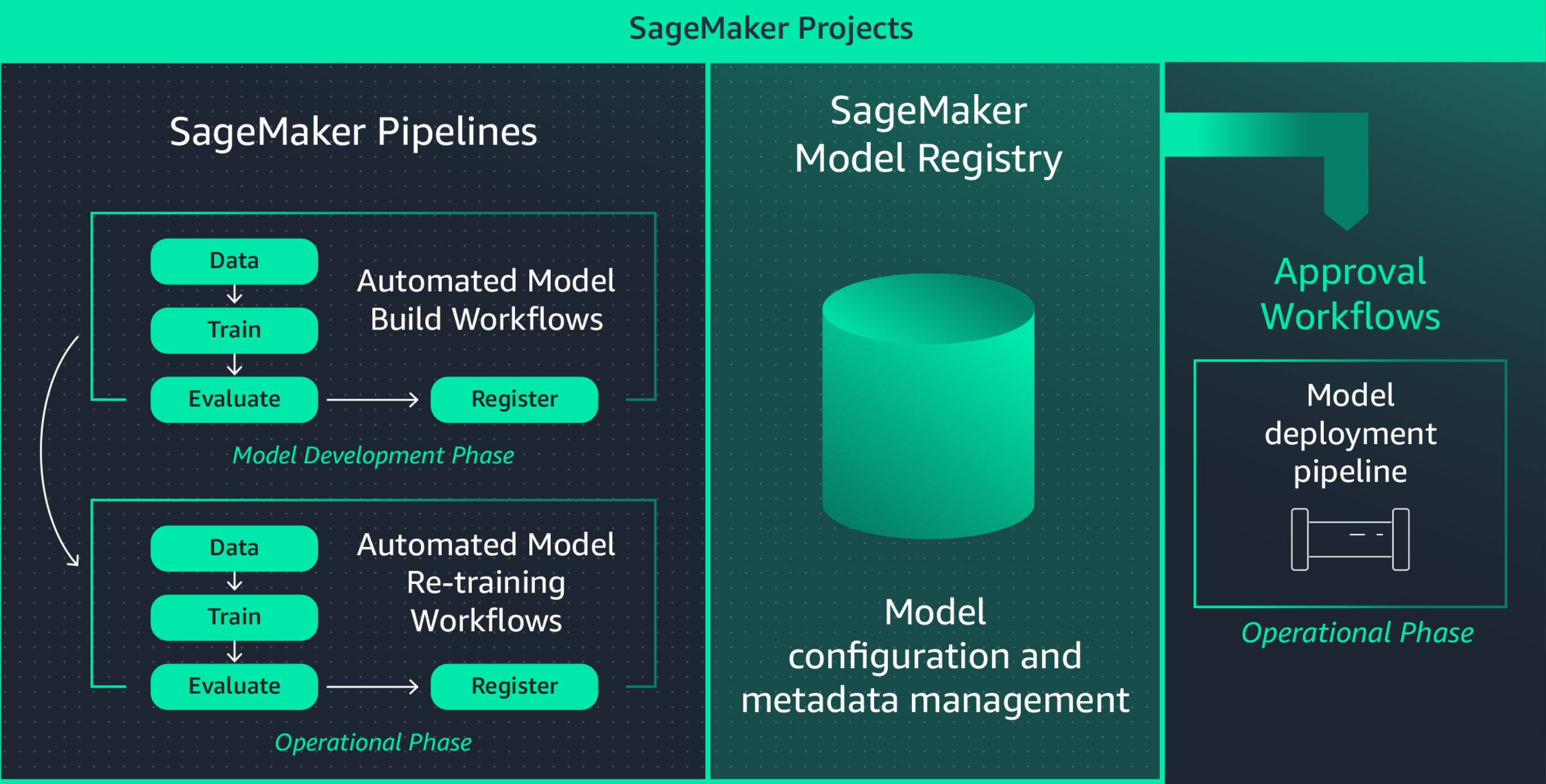

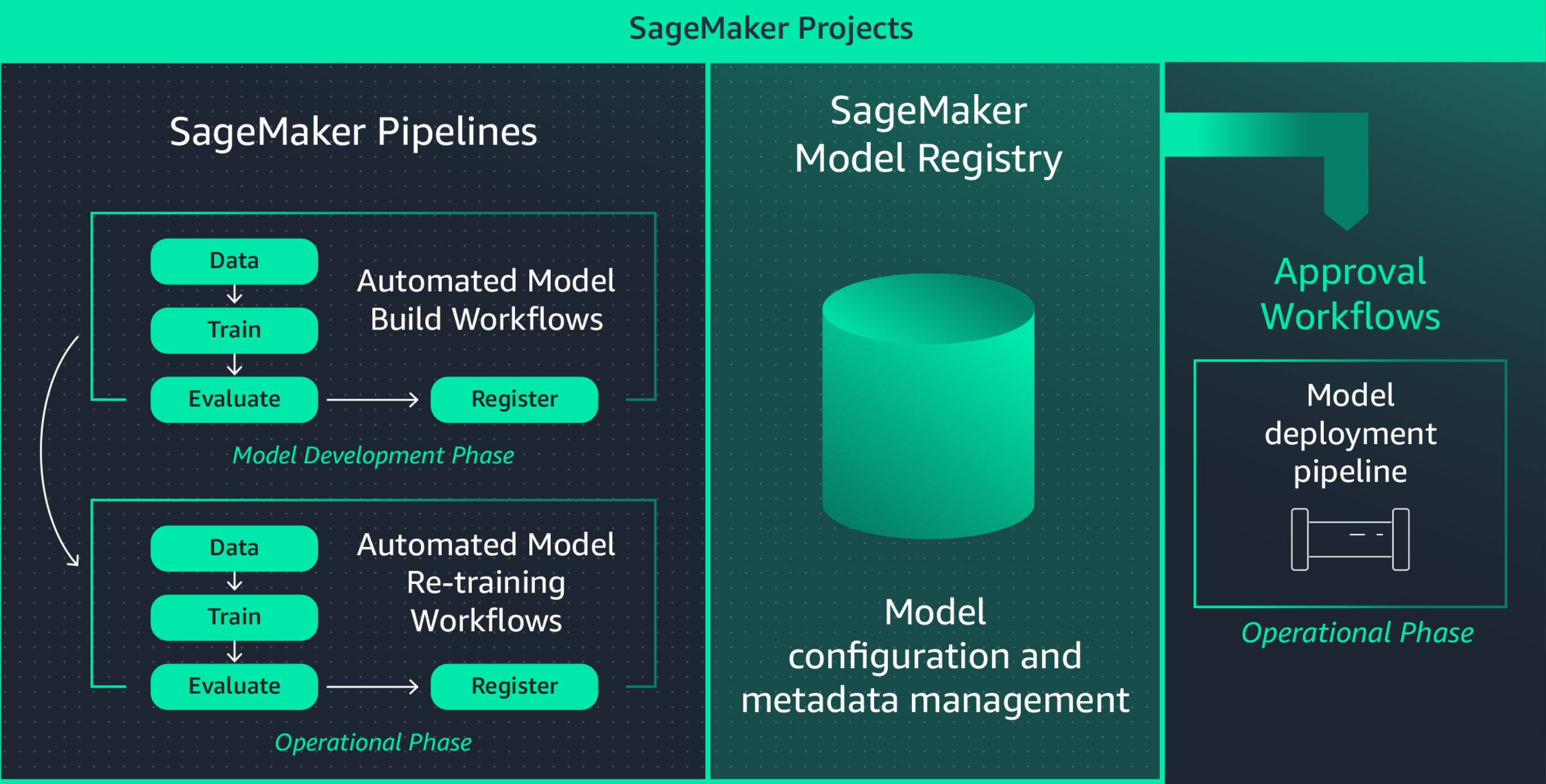

La estandarización de los entornos de desarrollo de ML aumenta la productividad de los científicos de datos y, finalmente, el ritmo de la innovación mediante la facilidad para lanzar nuevos proyectos, rotar a los científicos de datos en los proyectos e implementar las mejores prácticas de ML. Amazon SageMaker Projects ofrece plantillas para el rápido aprovisionamiento de entornos de científicos de datos estandarizados con herramientas y bibliotecas, repositorios de control de origen, código reutilizable y canalizaciones de CI/CD actualizados y bien probados.

Colaboración con MLflow durante la experimentación con ML

La creación de modelos de ML es un proceso iterativo que implica el entrenamiento de cientos de modelos para encontrar el mejor algoritmo, arquitectura y parámetros para una precisión óptima del modelo. MLflow le permite realizar un seguimiento de las entradas y salidas de estas iteraciones de entrenamiento, lo que mejora la repetibilidad de los ensayos y fomenta la colaboración entre los científicos de datos. Con las capacidades de MLflow completamente administradas, puede crear servidores de seguimiento de MLflow para cada equipo, lo que facilita una colaboración eficiente durante la experimentación con ML.

Amazon SageMaker con MLflow administra el ciclo de vida integral del machine learning, lo que agiliza el entrenamiento eficiente de modelos, el seguimiento de los experimentos y la reproducibilidad en diferentes marcos y entornos. Ofrece una única interfaz donde puede visualizar los trabajos de entrenamiento en curso, compartir experimentos con colegas y registrar modelos directamente a partir de un experimento.

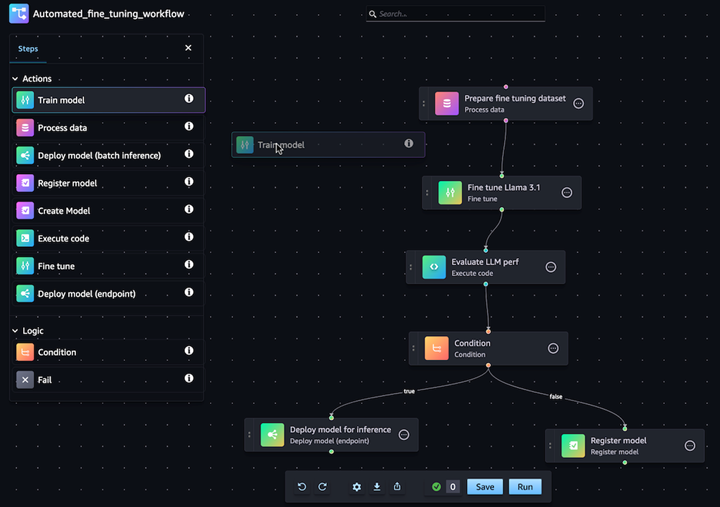

Automatización de los flujos de trabajo de personalización de modelos de IA generativa

Con las canalizaciones de Amazon SageMaker puede automatizar el flujo de trabajo de ML de extremo a extremo del procesamiento de datos, el entrenamiento del modelo, el refinamiento, la evaluación y el despliegue. Cree su propio modelo o personalice un modelo fundacional desde SageMaker JumpStart con unos pocos clics en el editor visual de las canalizaciones. Puede configurar las canalizaciones de SageMaker para que se ejecuten automáticamente a intervalos regulares o cuando sucedan ciertos eventos (por ejemplo, nuevos datos de entrenamiento en S3)

Despliegue y administración sencillas de modelos en producción

Reproducción rápida de los modelos para la resolución de problemas

A menudo debe reproducir los modelos en producción para solucionar problemas de funcionamiento de los modelos y determinar la causa principal. Para ayudar con esto, Amazon SageMaker registra cada paso del flujo de trabajo a través del seguimiento de auditoría de los artefactos del modelo, tales como los datos de entrenamiento, las configuraciones de la plataforma, los parámetros del modelo y las gradientes de aprendizaje. Con el seguimiento del linaje, puede recrear modelos para depurar problemas potenciales.

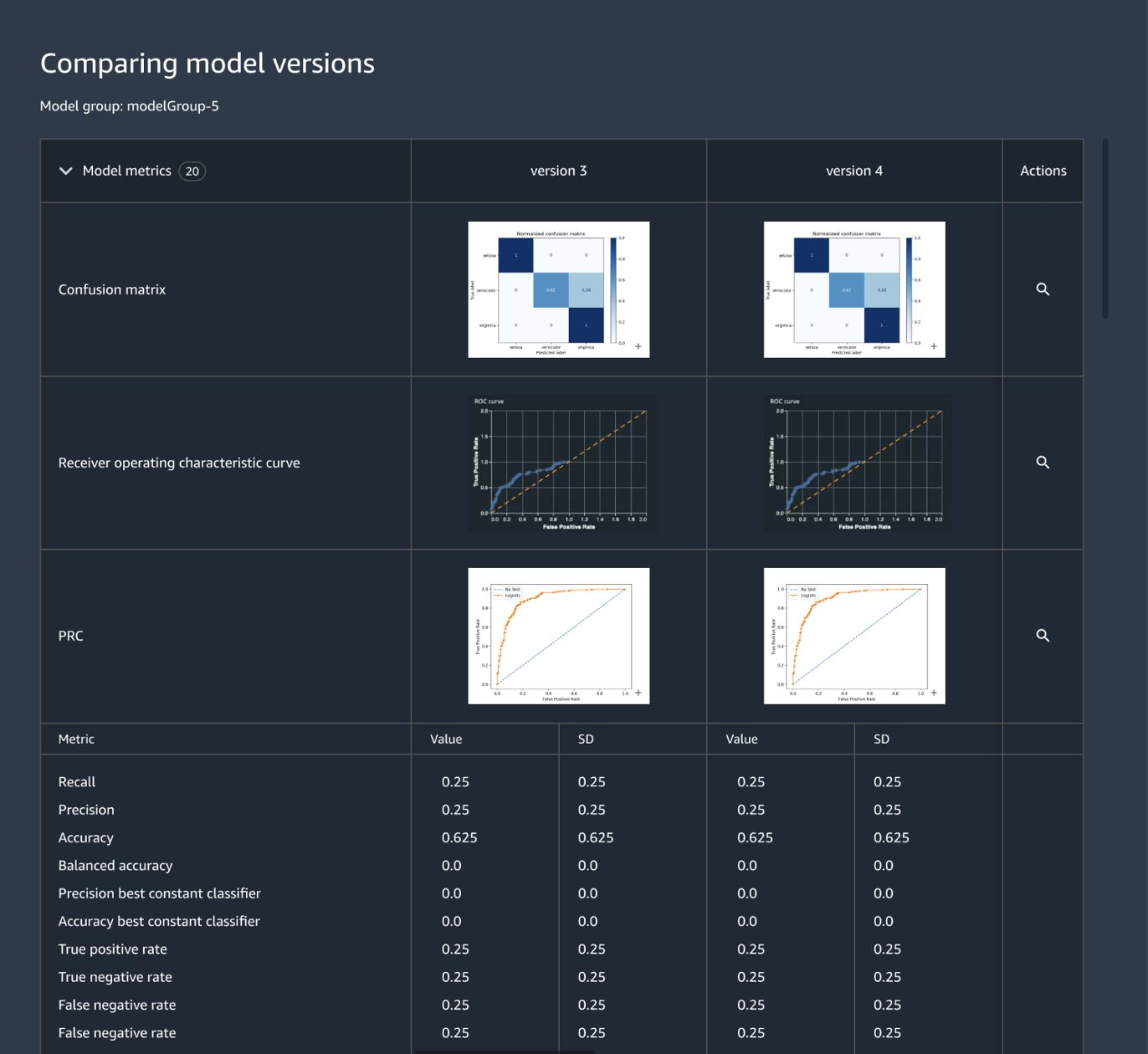

Seguimiento y administración centralizados de las versiones de los modelos

La creación de una aplicación de ML requiere el desarrollo de modelos, la canalización de datos, la canalización de entrenamiento y las pruebas de validación. Amazon SageMaker Model Registry le permite realizar un seguimiento de las versiones del modelo, de sus metadatos, como la agrupación de casos de uso, y de las referencias de las métricas de rendimiento del modelo en un repositorio central donde es fácil elegir el modelo adecuado para el despliegue en función de los requisitos de su empresa. Además, SageMaker Model Registry puede registrar automáticamente flujos de trabajo de aprobación para fines de auditoría y cumplimiento.

Definición de infraestructuras de ML mediante código

La organización de infraestructura mediante archivos de configuración declarativa, conocida comúnmente como «infraestructura como código», es un enfoque popular para aprovisionar una infraestructura de ML e implementar una arquitectura de soluciones como lo especifican exactamente las canalizaciones de CI/CD o las herramientas de despliegue. Con Amazon SageMaker Projects puede escribir infraestructura como código con archivos de plantillas prediseñadas.

Automatización de flujos de trabajo de integración y despliegue (CI/CD)

Los flujos de trabajo de desarrollo de ML deben integrarse con los flujos de trabajo de integración y despliegue para proporcionar rápidamente nuevos modelos para las aplicaciones de producción. Amazon SageMaker Projects lleva las prácticas de CI/CD al ML, como por ejemplo el mantenimiento de la paridad entre los entornos de desarrollo y producción, el control de versiones y orígenes, las pruebas A/B y la automatización integral. Por consiguiente, un modelo pasa a producción en cuanto se aprueba, lo que aumenta la agilidad.

Además, Amazon SageMaker ofrece mecanismos de seguridad incorporados para ayudar a mantener la disponibilidad del punto de conexión y minimizar el riesgo de despliegue. SageMaker se ocupa de configurar y organizar las prácticas recomendadas de despliegue, como los despliegues azul-verde para maximizar la disponibilidad, y las integra con los mecanismos de actualización de los puntos de enlace, tales como los mecanismos de reversión automática, para ayudarle a anticiparse en la identificación de los problemas de forma automática y tomar las correspondientes medidas correctivas antes de que impacten significativamente en la producción.

Reentrenamiento continuo de los modelos para mantener la calidad de la predicción

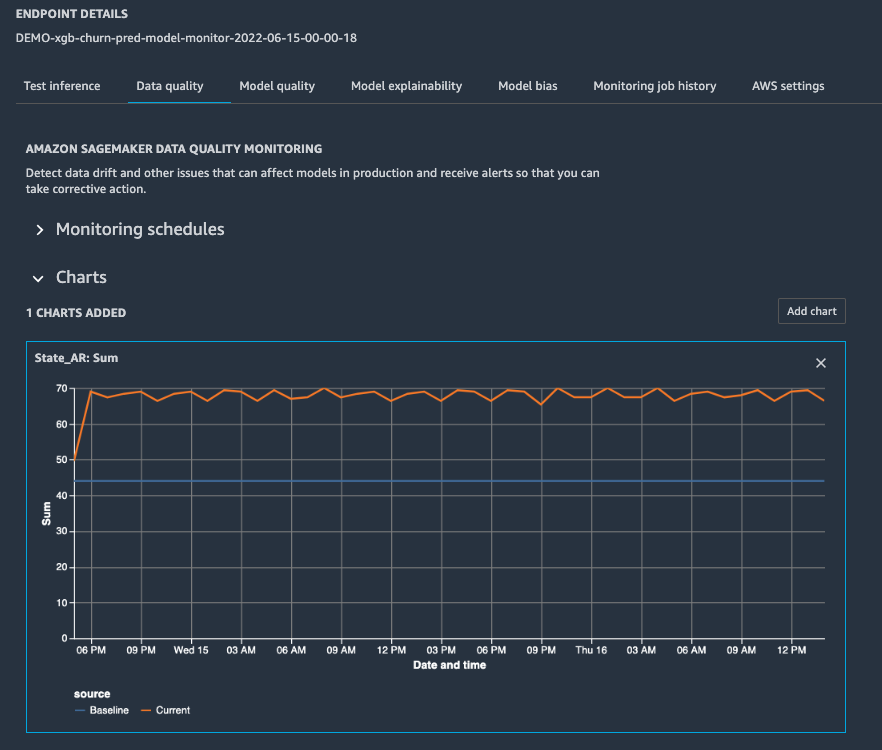

Una vez que el modelo se encuentra en producción, debe supervisar el rendimiento mediante la configuración de alertas para que el científico de datos de turno pueda solucionar el problema y activar el reentrenamiento. Monitor de modelos de Amazon SageMaker le ayuda a mantener la calidad mediante la detección de la desviación de modelo y de concepto en tiempo real y el envío de alertas para que tome medidas cuanto antes. Monitor de modelos de SageMaker supervisa de manera constante las características de rendimiento del modelo, tales como la precisión que mide el número de predicciones correctas en comparación con el número total de predicciones, de modo que pueda tomar medidas para solucionar anomalías. El Monitor de modelos de Amazon SageMaker está integrado con SageMaker Clarify para mejorar la visibilidad de sesgos potenciales.

Optimización del despliegue de modelos en términos de rendimiento y coste

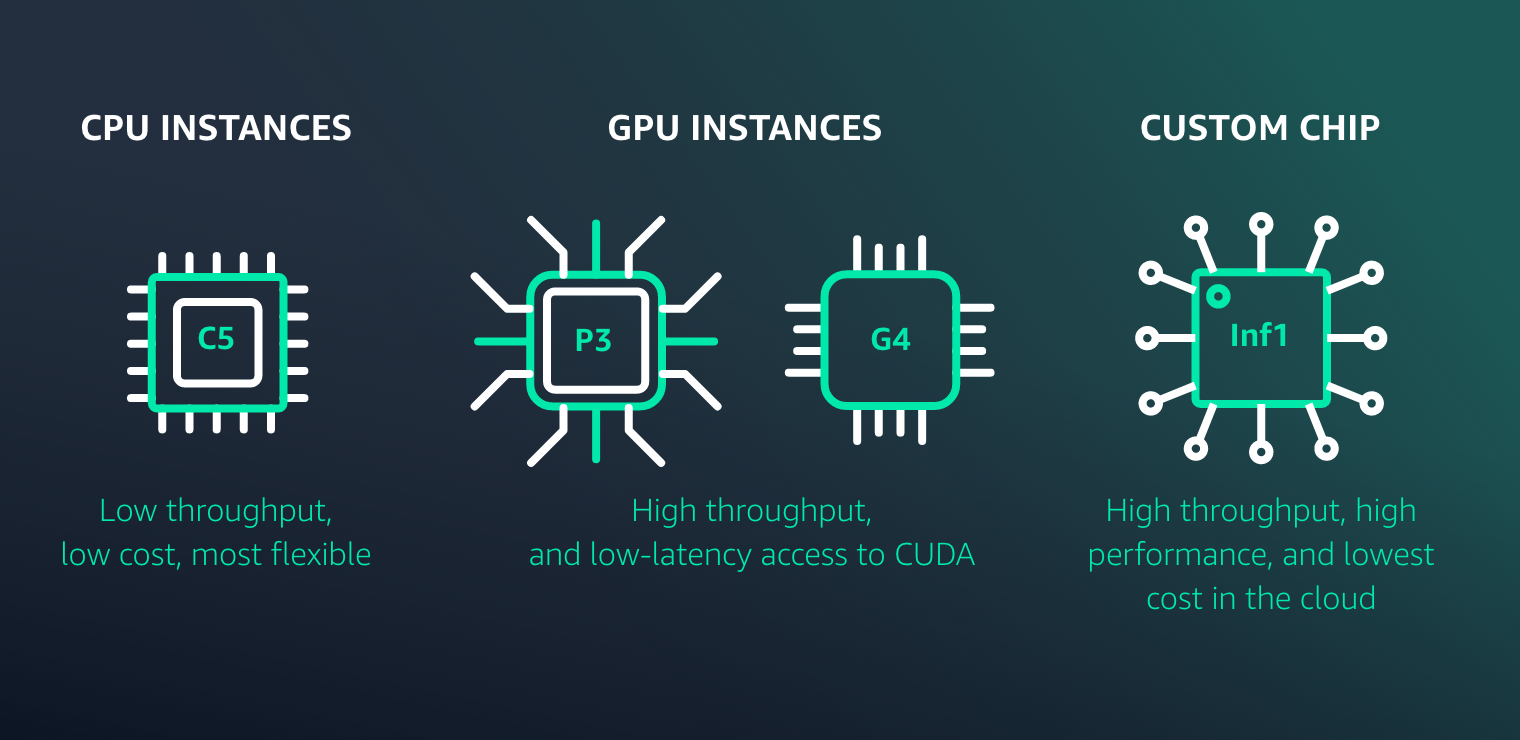

Amazon SageMaker facilita el despliegue de modelos de ML para inferencia con alto rendimiento y bajo coste para cualquier caso de uso. Proporciona una amplia selección de infraestructura de ML y opciones de despliegue de modelos para satisfacer todas las necesidades de inferencia de ML.

Recursos para MLOps de SageMaker

Novedades

Ejecute experimentos del Piloto automático de Amazon SageMaker desde las Canalizaciones de Amazon SageMaker para automatizar con facilidad los flujos de trabajo de MLOps

30/11/2022

Las Canalizaciones de Amazon SageMaker ahora admiten la prueba de flujos de trabajo de machine learning en su entorno local

17/08/2022

Las Canalizaciones de Amazon SageMaker ahora admiten el uso compartido de entidades de canalización entre cuentas

09/08/2022

El orquestador de cargas de trabajo de MLOps añade compatibilidad con la explicabilidad de modelos y la supervisión de sesgos de modelos de Amazon SageMaker

02/02/2022

Las Canalizaciones de Amazon SageMaker ahora son compatibles con el control de simultaneidad

21/01/2022