- Machine Learning›

- Amazon SageMaker AI›

- MLOps Amazon SageMaker AI

Amazon SageMaker for MLOps

Mengirimkan model ML produksi beperfoma tinggi dengan cepat dan dalam skala besar

Mengapa MLOps Amazon SageMaker

Cara kerja

Keunggulan MLOps SageMaker

Percepat pengembangan model

Sediakan lingkungan ilmu data berstandar

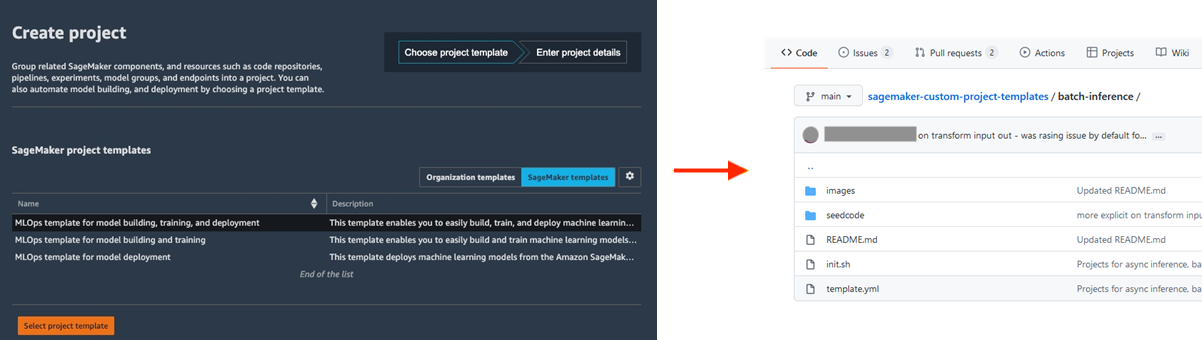

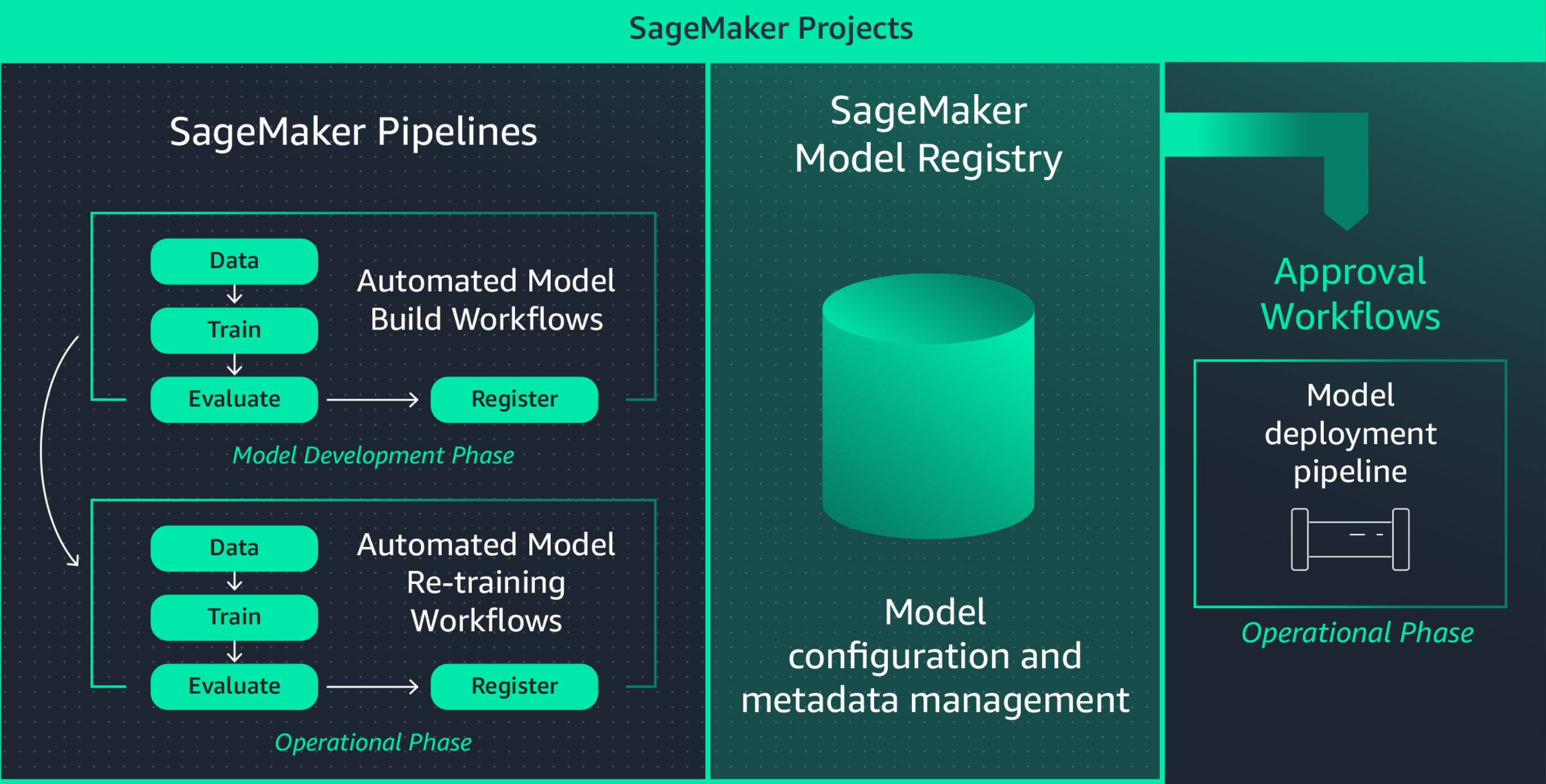

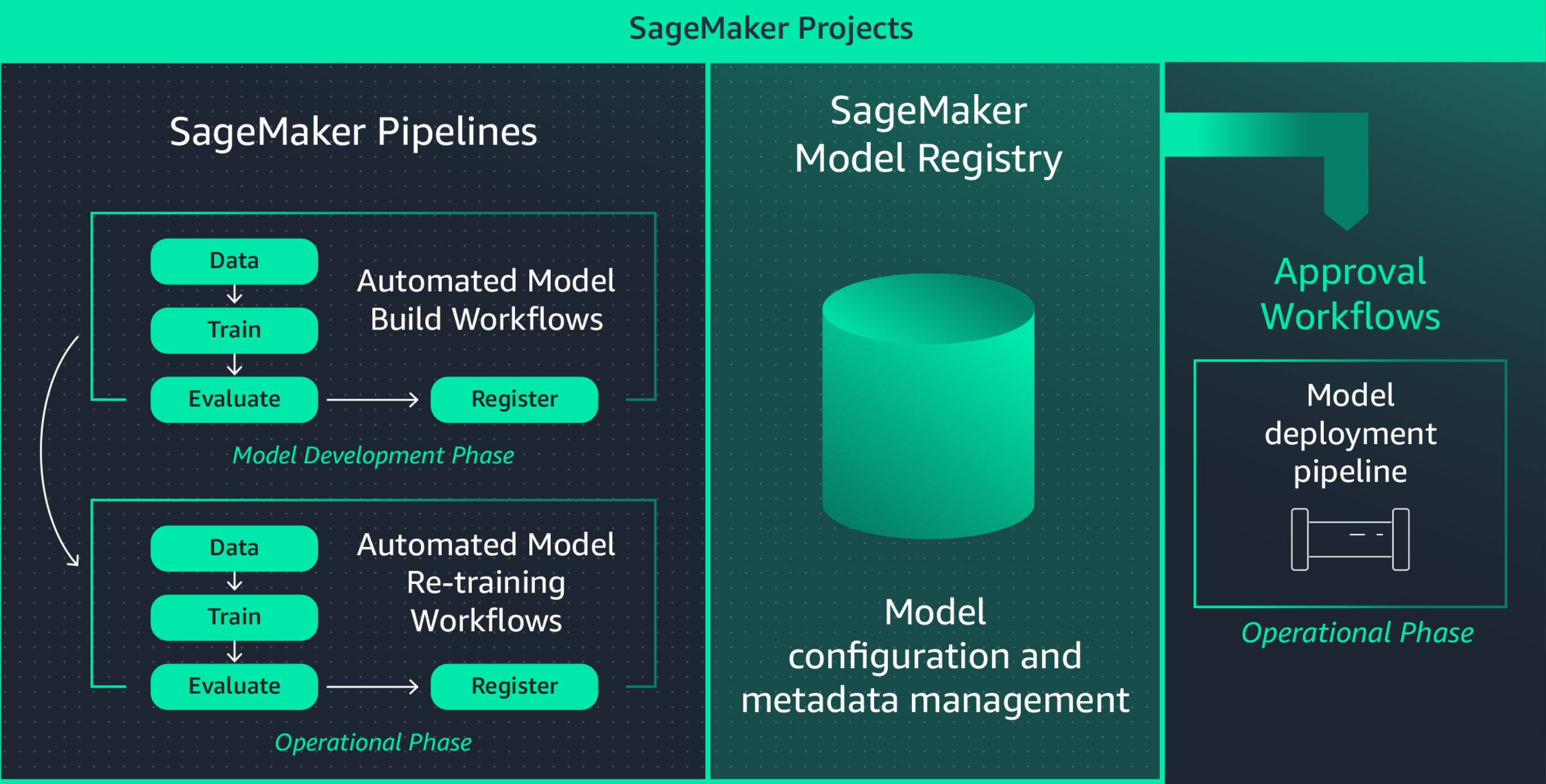

Dengan menstandarkan lingkungan pengembangan ML, produktivitas ilmuwan data dan kecepatan inovasi dapat ditingkatkan sehingga dapat dengan mudah meluncurkan proyek baru, merotasikan ilmuwan data di seluruh proyek, dan mengimplementasikan praktik terbaik ML. Proyek Amazon SageMaker menawarkan templat yang langsung menyediakan lingkungan ilmuwan data berstandar dengan alat dan pustaka yang teruji dan terbaru, repositori kontrol sumber, kode boilerplate, serta pipeline CI/CD.

Berkolaborasi menggunakan MLflow selama eksperimen ML

Pembuatan model ML merupakan proses berulang, yang melibatkan pelatihan ratusan model untuk menemukan algoritma, arsitektur, dan parameter terbaik untuk akurasi model yang optimal. MLflow memungkinkan Anda melacak input dan output di seluruh iterasi pelatihan ini sehingga meningkatkan kemampuan pengulangan uji coba dan mendorong kolaborasi di antara ilmuwan data. Dengan kemampuan MLflow yang terkelola penuh, Anda dapat membuat Server Pelacakan MLflow untuk setiap tim sehingga memfasilitasi kolaborasi yang efisien selama eksperimen ML.

Amazon SageMaker dengan MLflow mengelola siklus hidup machine learning secara menyeluruh, menyederhanakan pelatihan model yang efisien, melacak eksperimen, dan reproduktifitas di berbagai kerangka kerja dan lingkungan. Layanan ini menawarkan antarmuka tunggal yang dapat menampilkan tugas pelatihan Anda yang sedang berlangsung, membagikan eksperimen dengan rekan kerja, dan mendaftarkan model secara langsung dari suatu eksperimen.

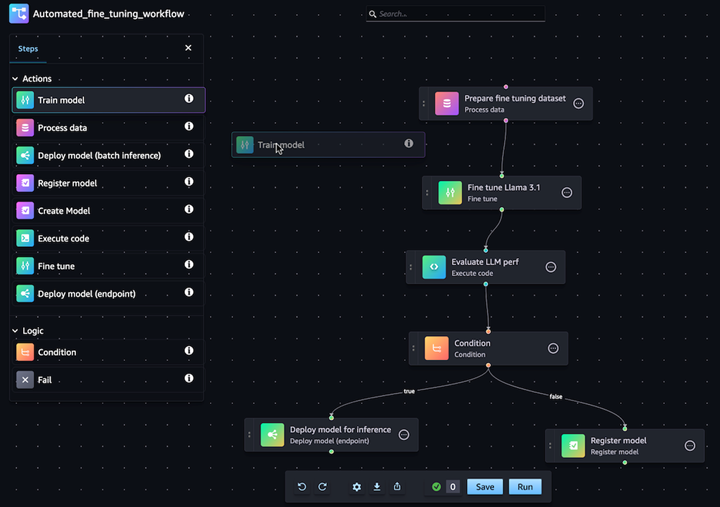

Otomatiskan alur kerja kustomisasi model GenAI

Dengan Amazon SageMaker Pipelines, Anda dapat mengotomatiskan alur kerja ML menyeluruh dari pemrosesan data, pelatihan model, penyempurnaan, evaluasi, dan deployment. Bangun model Anda sendiri atau sesuaikan model fondasi dari SageMaker Jumpstart dengan beberapa klik di editor visual Pipelines. Anda dapat mengonfigurasi SageMaker Pipelines untuk berjalan secara otomatis pada interval berkala atau saat peristiwa tertentu dipicu (misalnya, data pelatihan baru di S3)

Lakukan deployment dan kelola model yang sedang diproduksi dengan mudah

Perbanyak model dengan cepat untuk penyelesaian masalah

Biasanya, Anda perlu memperbanyak model yang sedang diproduksi untuk menyelesaikan masalah perilaku model dan menentukan akar masalahnya. Untuk membantu hal ini, Amazon SageMaker mencatat setiap langkah dari alur kerja Anda, membuat jejak audit dari artefak model, seperti data pelatihan, pengaturan konfigurasi, parameter model, dan gradien pembelajaran. Anda dapat membuat ulang model untuk men-debug potensi masalah menggunakan pelacakan silsilah.

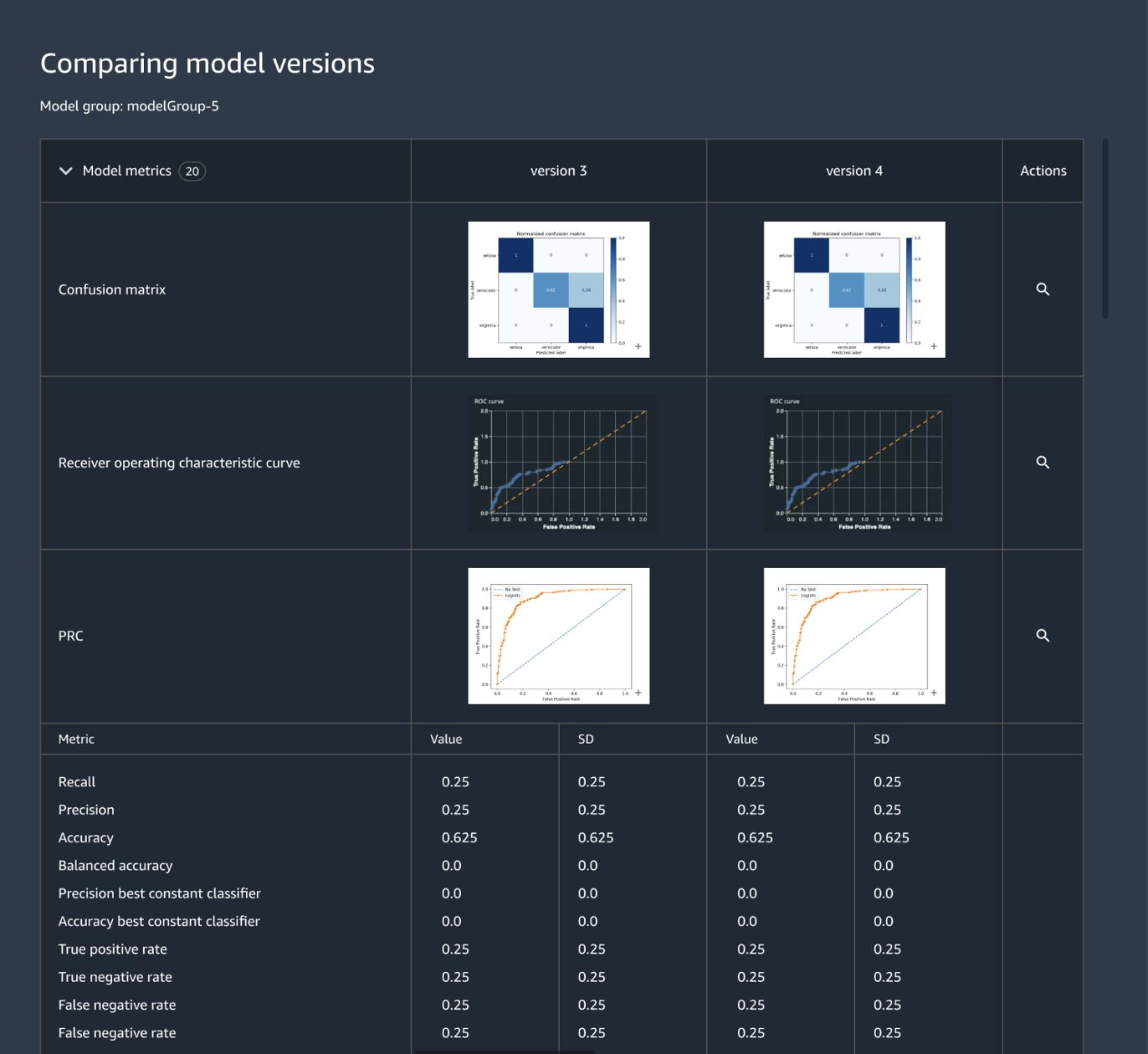

Lacak dan kelola versi model secara terpusat

Pembuatan aplikasi ML melibatkan pengembangan model, pipeline data, pipeline pelatihan, dan uji validasi. Anda dapat menggunakan Registri Model Amazon SageMaker untuk melacak versi model dan metadata model, seperti pengelompokan kasus penggunaan, serta dasar metrik performa model di repositori pusat yang dapat dengan mudah memilih model yang tepat untuk deployment sesuai kebutuhan bisnis. Selain itu, Registri Model SageMaker secara otomatis mencatat alur kerja persetujuan untuk kepentingan audit dan kepatuhan.

Tentukan infrastruktur ML melalui kode

Mengorkestrasi infrastruktur melalui file konfigurasi deklaratif, yang biasa disebut “infrastruktur sebagai kode”, adalah suatu pendekatan populer dalam penyediaan infrastruktur ML dan implementasi arsitektur solusi yang sama persis dengan yang ditentukan oleh pipeline CI/CD atau alat deployment. Anda dapat menggunakan Proyek Amazon SageMaker untuk menulis infrastruktur sebagai kode menggunakan file templat yang sudah dibuat sebelumnya.

Otomatiskan alur kerja integrasi dan deployment (CI/CD)

Alur kerja pengembangan ML harus berintegrasi dengan alur kerja integrasi dan deployment sehingga model baru untuk aplikasi produksi dapat dikirimkan dengan cepat. Proyek Amazon SageMaker menghadirkan praktik CI/CD ke ML, seperti menjaga keseimbangan antara lingkungan pengembangan dan produksi, kontrol sumber dan versi, pengujian A/B, dan otomatisasi menyeluruh. Akibatnya, Anda dapat menempatkan model di produksi segera setelah disetujui dan juga meningkatkan ketangkasan.

Selain itu, Amazon SageMaker menawarkan perlindungan bawaan untuk membantu menjaga ketersediaan titik akhir dan meminimalkan risiko deployment. SageMaker menangani penyiapan dan perancangan praktik terbaik deployment, seperti deployment Blue/Green untuk memaksimalkan ketersediaan dan mengintegrasikannya dengan mekanisme pembaruan titik akhir, misalnya mekanisme rollback otomatis, untuk membantu Anda secara otomatis mengidentifikasi masalah lebih awal dan mengambil tindakan perbaikan sebelum masalah tersebut memengaruhi produksi secara signifikan.

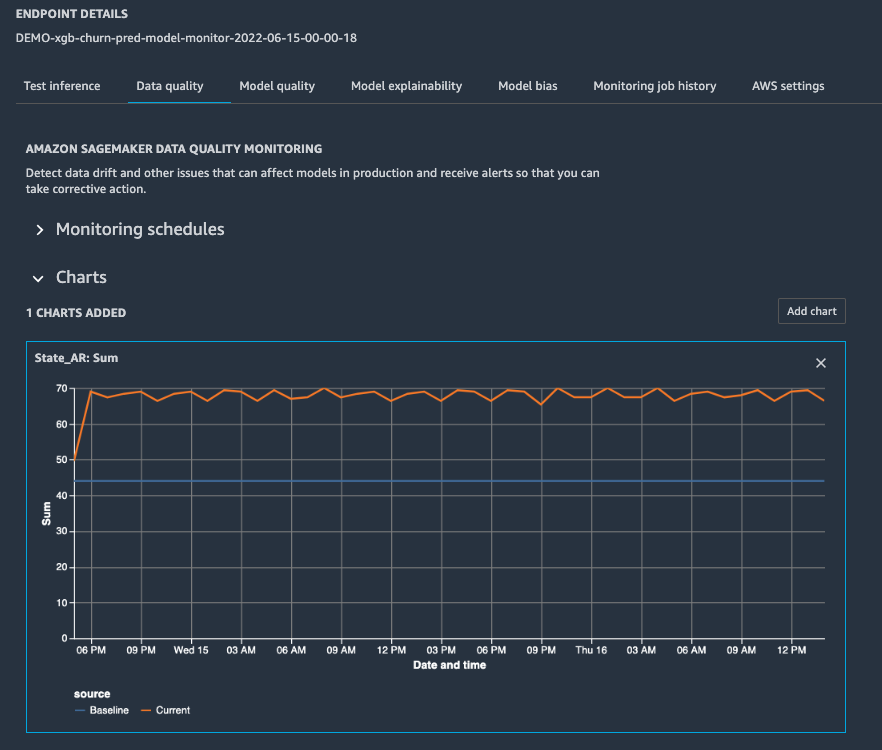

Terus latih ulang model untuk mempertahankan kualitas prediksi

Setelah model diproduksi, Anda perlu memantau performanya dengan mengonfigurasi peringatan sehingga ilmuwan data yang siap dipanggil dapat menyelesaikan masalah dan merancang pelatihan ulang. Amazon SageMaker Model Monitor membantu Anda mempertahankan kualitas model dengan mendeteksi penyimpangan model dan konsep secara langsung, serta mengirim peringatan kepada Anda agar dapat segera mengambil tindakan. SageMaker Model Monitor terus memantau karakteristik performa model, seperti akurasi dalam menghitung jumlah prediksi yang benar dibandingkan dengan jumlah total prediksi sehingga Anda dapat mengatasi anomali. SageMaker Model Monitor terintegrasi dengan SageMaker Clarify untuk meningkatkan visibilitas terhadap potensi bias.

Optimalkan deployment model untuk performa dan biaya yang lebih baik

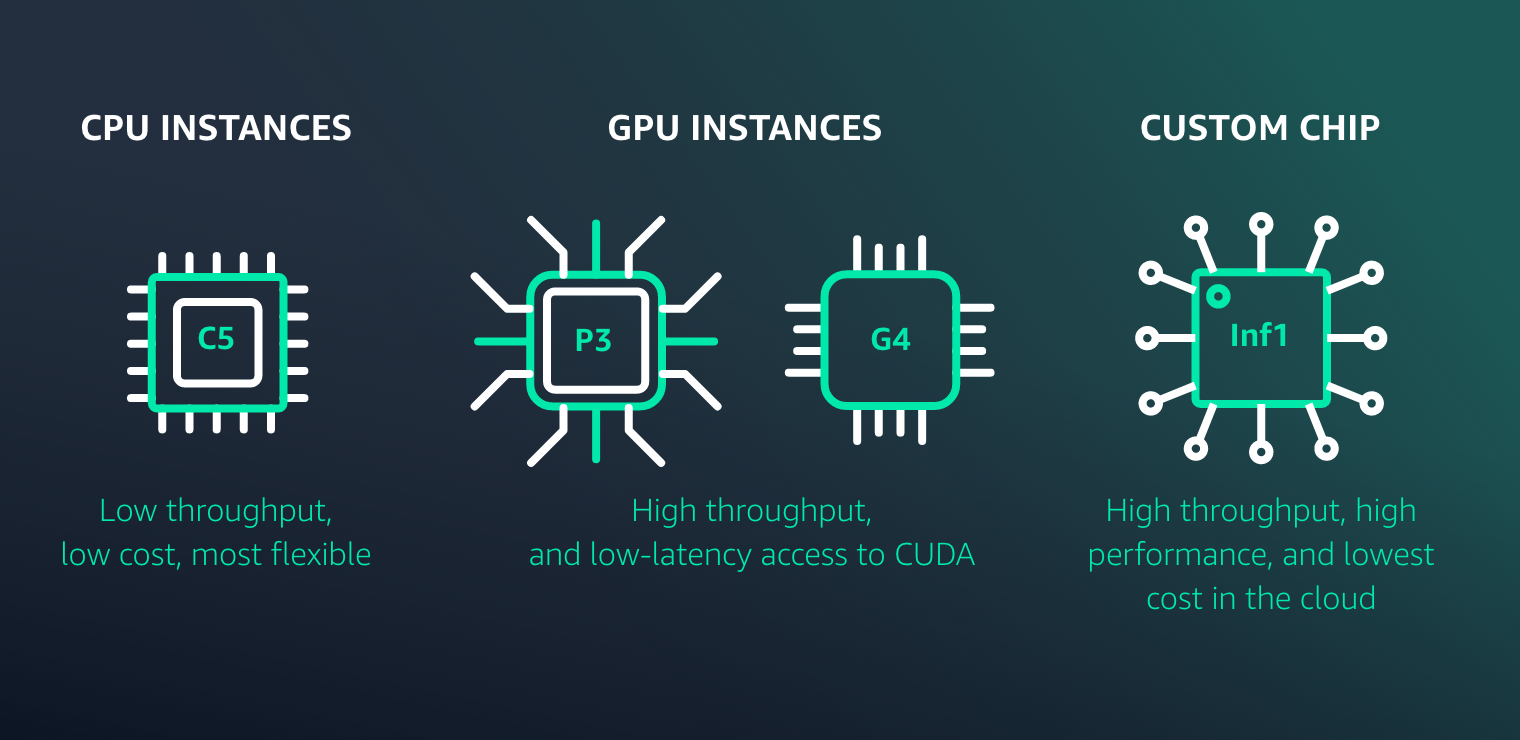

Amazon SageMaker mempermudah deployment model ML untuk menghasilkan inferensi beperforma tinggi dan berbiaya rendah bagi setiap kasus penggunaan. Amazon SageMaker menyediakan banyak pilihan infrastruktur ML dan opsi deployment model untuk memenuhi kebutuhan inferensi ML Anda.

Sumber daya untuk MLOps SageMaker

Apa yang baru

Luncurkan eksperimen Amazon SageMaker Autopilot dari Amazon SageMaker Pipelines untuk mengotomatisasi alur kerja MLOps dengan mudah

30/11/2022

Amazon SageMaker Pipelines kini mendukung pengujian alur kerja machine learning di lingkungan lokal Anda

17/08/2022

Amazon SageMaker Pipelines kini mendukung berbagi entitas pipeline antar akun

09/08/2022

MLops Workload Orchestrator menambahkan dukungan untuk Pemantauan Keterjelasan Model dan Bias Model Amazon SageMaker

02/02/2022