限られた学習データでの画像生成 AI モデル開発とコスト最適化

2026-02-03 | Author : Le Van Quy Hoang (ACワークス株式会社), Nguyen Vu Bao Hung (ACワークス)、Le Hoang Phuc (ACワークス株式会社)、Lee Rui

はじめに

近年、画像生成AIは急速に進化・普及していますが、多くの既存モデルは学習データの権利が不明確であり、日本国内で商用利用できる画像素材として安全に利用できる画像を生成することが難しいという課題がありました。プロンプトにおける言語の壁だけでなく、画像のスタイルやテイスト面でも、日本の商用利用ニーズに合致しないケースが多く見られます。

私たちは画像生成 AI の進化は多くのクリエイターの創作物の上に成り立っていると考えています。だからこそ、その貢献に正しく報い、安心して作品を提供できる環境をつくることは不可欠だと感じていました。

これらの課題を解決するためには、既存モデルのカスタマイズだけでは根本的な解決は困難であると判断しました。そこで当社は、自社で著作権を保有し、AI への活用を許可したクリエイターの画像のみを用いて学習した独自の画像生成 AI モデルをスクラッチから構築し、報酬をクリエイターへ還元するプロジェクトを始動することにしました。

本記事では、AWS Bedrock、AWS Inferentiaを含めた AWS サービスを活用し、以下の観点で ACワークス社の事例をご紹介します。

- 比較的に少量な学習データで高精度画像生成モデルをスクラッチ構築した際の工夫点

- サービスリリース後コストパフォーマンス最適化の工夫点

X ポスト » | Facebook シェア » | はてブ »

builders.flash メールメンバー登録

builders.flash メールメンバー登録で、毎月の最新アップデート情報とともに、AWS を無料でお試しいただけるクレジットコードを受け取ることができます。

全体概要

開発の初期段階で、私たちの画像生成モデルは一つの大きな課題にぶつかりました。それは、GPU を多用する AI モデルを本番環境に安定してデプロイする方法です。運用フェーズを見据えたとき、この機能の安定性や堅牢性についてさまざまな懸念が浮かび上がりました。そこで徹底的な調査と実証テストを重ねた結果、AWS にはこれらの課題を解決できる豊富なサービス群が揃っていることが分かりました。これにより、AI モデルのデプロイは現実的かつスケーラブル、そして十分に運用可能なものとなりました。

本記事の後半では、その中でも本プロジェクトの成功に大きく貢献したサービス ── Amazon Bedrock、Amazon EKS、Amazon SageMaker、そしてInferentia インスタンス (Amazon EC2) ── についてご紹介します。

私たちの取り組み

限られたデータセット

著作権に配慮した画像生成モデルを開発するうえで、私たちが直面した大きな課題のひとつが、既存の公開モデルに比べてはるかに小さいデータセットしか使えないことでした。既存モデルの多くは Webク ロールによって収集された膨大なデータで学習されていますが、私たちはあえて「量より質」という方針を採用し、限られた著作権対応データを最大限に活かすことを目指しました。

自動 Web クロールで作られた公開データセットには、以下のような品質面での課題が多く見られます。

-

画像品質のばらつき : 解像度の混在、画像の欠陥 (アーティファクト)、無関係な画像の混入

-

キャプションとの不整合 : 内容が漠然としている、あるいは画像と一致しない説明

画像生成モデルは「画像」と「キャプション」のペアから学習することを踏まえ、私たちは次の 3 つの重要な最適化ポイントに注力しました。

-

厳選した画像の採用 (Curated Image Selection)

明確で厳密なフィルタリング基準を設け、目指す出力品質やスタイルに最も合致する画像だけをトレーニングデータとして使用しました。 -

キャプション品質の向上 (Enhanced Caption Quality)

モデルが可能な限り正確に「見えているもの」を理解できるよう、キャプションの精度や情報量を高めるために多くの工数を投じました。 -

データ拡張 (Augmentation)

選び抜いた画像の中からさらに小規模なセットを抽出し、データ拡張を行うことで、枚数・多様性を増やすとともに、学習データのバランスを調整しました。

これらの手法は手間も工数もかかりますが、すべての学習サンプルがモデルの学習に有効な役割を果たすように設計されています。その結果、従来の大量データ前提の手法に比べ、より少ないデータポイントでも高品質な成果を得ることができるようになります。

モデルのトレーニング

学習プロセスでは、トレーニングを高速化しつつもコストを削減するために、複数の最適化手法を取り入れました。

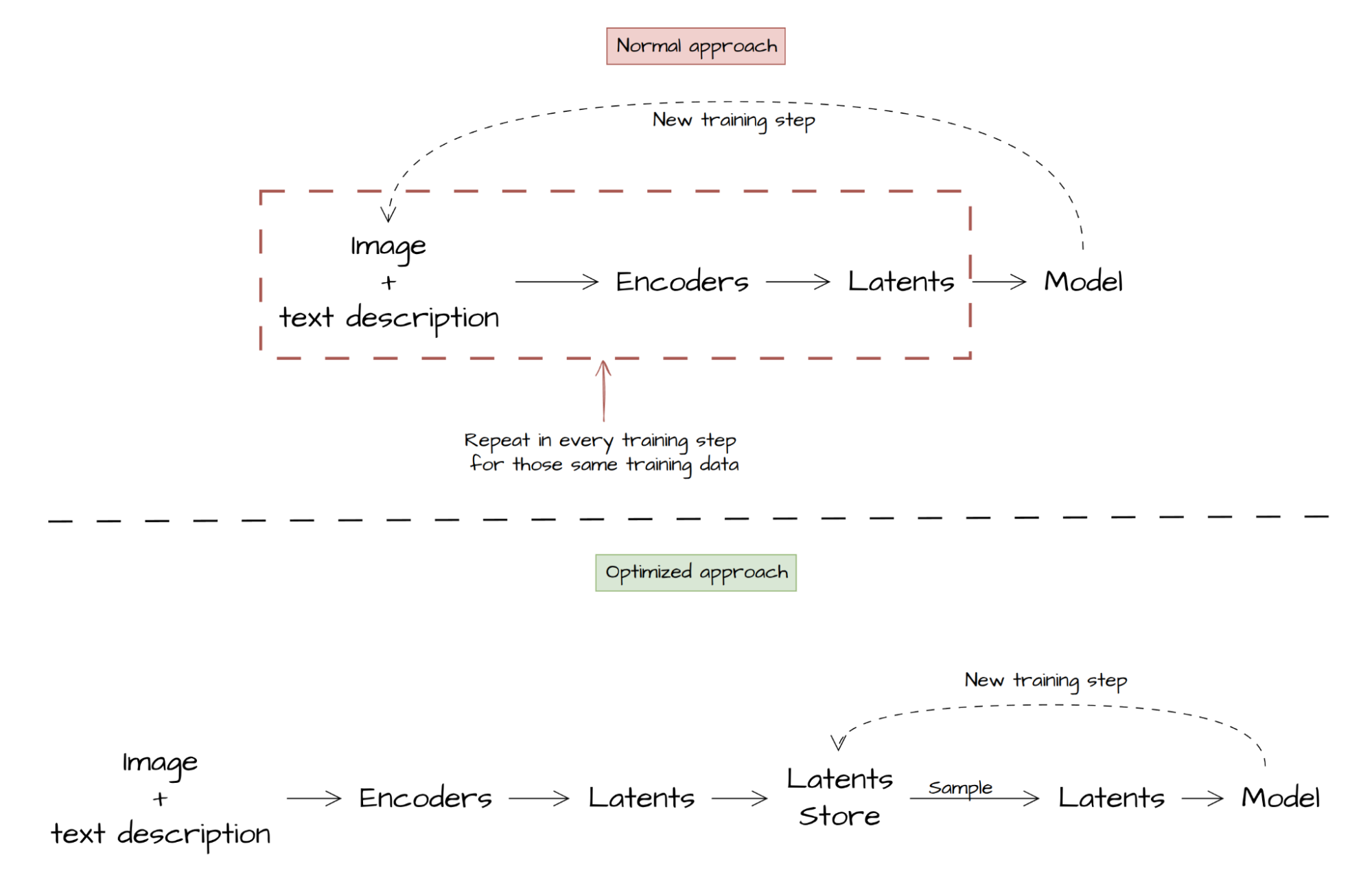

1. 潜在表現の事前計算 (Precompute latents):

拡散モデル(diffusion-based model)では、テキストや画像を直接処理するのではなく、まずエンコーダ を通して「潜在表現(latents)」に変換してから学習を行います。

このとき、エンコーダには次のような特徴と課題があります。

- 決定論的で一貫した出力 : 同じ入力に対しては常に同じ出力が得られる

- 高いハードウェア負荷 : VRAMや処理時間を多く消費し、本来であればモデル本体の学習に割けるリソースを圧迫してしまう

この特性を踏まえ、私たちは学習開始前に一度だけ潜在表現を事前計算 (Precompute) し、学習中に同じエンコード処理を繰り返さないようにしました(図 1 参照)。この最適化により、学習時間とコストの両方を削減することができました。

図 1:通常のアプローチと最適化アプローチにおける学習データの流れ

マルチフェーズ学習 (Multi-phase training)

AI モデルをゼロから学習させるのは、人に絵を教えるのに似ています。いきなり細かい描き込みから始めるのではなく、まずは基本的な形を描けるようになることが重要です。 同じように、Stable Diffusion モデルでも、シンプルな概念から複雑なパターンへと段階的に学習を進める方が効率的で、結果的に学習コストも抑えられます。

このアプローチでは、各フェーズごとに明確な目標を設定してモデルを導きます。

- フェーズ 1 (低解像度、例 : 256×256) – 基礎の習得

学習データから基礎的な構造や概念を学び、フェーズ 2 への準備を整えます。この段階では低解像度のため、必要なハードウェアリソースも少なくて済みます。 - フェーズ 2 (目標解像度、例:512×512) – 応用と高度化

フェーズ 1 で築いた基礎の上に、より複雑なディテールやパターンを学習させ、最終的な出力品質を向上させます。

本番リリース & 最適化

以下の図 は、私たちが構築した画像生成モデルの運用アーキテクチャを示しています。ここでは、それぞれの AWS サービスがどのように成功に貢献したのかをご紹介します。

1. Amazon Bedrock

Amazon Bedrock は、Anthropic、Cohere、Stability AI の基盤モデルへの集中管理されたアクセスを提供しました。特に Converse API の標準化されたインターフェースは重要で、コードの大規模な書き換えをせずに異なるモデルをテスト・切り替えできたため、開発サイクルを大幅に短縮できました。

2. Amazon EKS

初期段階では、画像生成モデルの提供に EKS を使用していました (のちに SageMaker へ移行)。EKS は Kubernetes の運用管理負荷を取り除き、不規則なリクエスト量に対してもオートスケーリングを提供。さらに、EC2 スポットインスタンスとの統合により、重要度の低いワークロードで最大 70% の計算コスト削減を実現し、GPU 集約型のサービスを経済的に運用可能にしました。

3. Amazon SageMaker

私たちの実装では、SageMaker の非同期推論機能を利用して、長時間かかる画像生成タスクに対応しました。この機能にはキューなどの便利な機能が組み込まれているため、効率的な処理が可能です。これにより、アプリケーションはインフラ管理から切り離され、私たちはユーザー体験の向上に集中でき、SageMaker 側で信頼性とスケーラビリティのある推論環境が確保されました。

4. Amazon EC2

幅広い EC2 インスタンスタイプの選択肢により、データ合成、テスト、評価など、モデル開発ライフサイクルの各段階で計算リソースを最適化することができました。

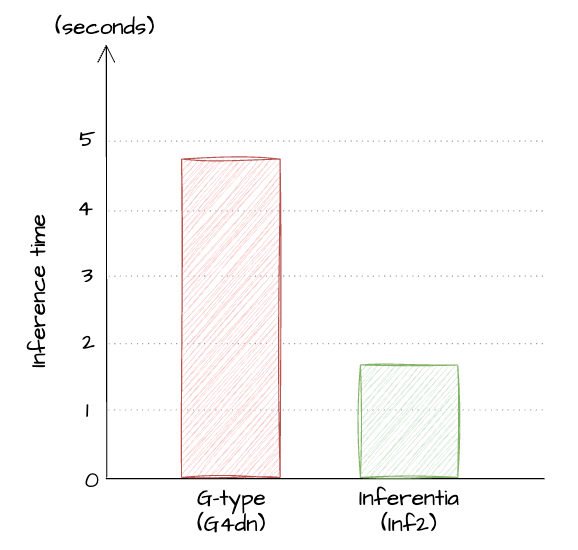

特に、AWS の最新世代 Inferentia チップを搭載した Inf2 インスタンスの導入が大きく貢献しました。これらの専用インスタンスは、従来の GPU インスタンスに比べて大幅な性能向上を実現し、図3の実験結果では推論時間を最大 60% 短縮。

同時に画像1枚あたりのコストも 40% 削減できたため、運用コストを抑えながら高いスループットを実現できました。

図 3 : 我々のパイプラインにおける G4dn インスタンスと Inf2 インスタンスの推論時間比較 (画像 1 枚生成時)

まとめ

本プロジェクトでは、著作権に配慮した独自データセットの構築から始まり、限られたデータを最大限に活かすためのキャプション精度向上やデータ拡張、マルチフェーズ学習など、多くの最適化手法を組み合わせてきました。また、AWS の各種サービス ── Bedrock、EKS、SageMaker、Inferentia 搭載 EC2 ── を活用することで、開発・運用の両面でコストパフォーマンスを大幅に向上させることができました。

結果として、商用利用可能な画像生成 AI を、従来よりも低コストかつスケーラブルな形で提供できる環境を実現しました。

この取り組みは、単なる技術検証ではなく、クリエイターの権利保護と還元を軸にした持続可能な AI 活用モデルの実例となります。今後も私たちは、より効率的で透明性の高い運用を追求し、日本の商用利用ニーズに真に応える画像生成プラットフォームの発展を目指していきます。

筆者プロフィール

Le Van Quy Hoang

ACワークス株式会社 開発部 CTO

同社のプロダクト領域における技術全般を統括し、新たな技術動向に強い関心を持つ。特に近年の生成 AI 分野の進展を踏まえ、プロダクトへの実用的な活用を推進している。

Nguyen Vu Bao Hung

ACワークス株式会社

開発部 DevOps チームリーダー

AWS クラウド基盤の設計・運用を主導し、主要製品を拡張性・セキュリティ・コスト効率の観点で支援。堅牢なアーキテクチャ採用を推進し、安定成長と信頼できる本番運用を実現。開発と連携し DevOps、インフラ自動化、運用成熟度を改善。近年は AI ワークロード最適化にも注力し、実務的で持続可能な設計を探り事業価値につなげる。

Le Hoang Phuc

ACワークス株式会社

開発部

AI エンジニア仕組みへの好奇心を原動力に、AI の可能性を探求するAI エンジニア。AI モデル開発から始め、実用化にはクラウド基盤の設計が重要だと気づき、その面白さに惹かれた。現在は複数の AI 領域でプロトタイプと解決策を作り、社内業務と顧客向け本番運用の双方を支える。

Lee Rui

アマゾン ウェブ サービス ジャパン合同会社

ソリューションアーキテクト

AWS のソリューションアーキテクトとして Web 業界お客様を中心に IT 戦略策定から実装まで支援しています。

ロードバイク大好きで、長距離輪行を楽しんでいます。