一、前言

Amazon Timestream专门设计用来处理随时间变化的数据,如IoT设备数据、可观测性数据等,是一种快速、可扩展的无服务器时间序列数据库服务,适用于物联网和监控运维应用程序。Amazon Q developer是一个由生成式AI驱动的助手,旨在为开发者和IT专业人员增强软件开发生命周期,包括:开发、测试、运维、应用现代化、AWS云上资源优化、上下文感知和自然语言交互。

本文分享在大规模IoT设备场景下,如何利用Amazon Q Developer的AI能力解决Amazon Timestream的性能瓶颈和成本挑战,快速实现将TCU消耗降至合理范围的优化实践。该企业是一家全球领先的制造业品牌企业,随着业务快速扩张和IoT设备规模的增长,面临着海量时序数据处理的挑战。如何在保障系统性能的同时,有效控制云服务成本,成为技术团队的重要课题。文章详细介绍了如何利用Amazon Q Developer进行业务代码优化、时序数据建模优化、查询语句优化等核心实践,通过系统性的优化措施,显著降低了TCU消耗,实现了可观的成本节约效果,为企业级IoT数据平台降本增效提供了可落地的解决方案。

二、项目背景与挑战

技术背景

Amazon Timestream是AWS推出的专门用于处理时序数据的无服务器数据库服务,具备以下核心特性:

- 高性能:专为时序数据优化,支持每秒数百万次写入和查询

- 自动扩缩容:根据工作负载自动调整计算和存储资源

- 无服务器:无需管理基础设施,按实际使用量付费

Amazon Q Developer是AWS推出的AI驱动开发助手,在本项目中发挥了关键作用:

- 智能代码生成:自动生成测试工具和优化代码

- 性能分析:基于最佳实践提供优化建议

- 问题诊断:快速识别性能瓶颈和成本问题

- 架构设计:协助设计最优的数据模型和查询策略

项目价值

本项目的成功实践证明了AI驱动的数据库优化在以下方面的价值:

- 技术价值:建立了完整的时序数据库优化方法论

- 商业价值:实现了显著的成本节约和性能提升

- 创新价值:展示了AI工具在复杂系统优化中的实际应用

业务现状分析

在业务快速发展过程中,面临着时序数据库性能与成本的平衡挑战:

- 性能层面: 随着IoT设备规模持续增长,系统业务出现了Amazon Timestream Query异常(Status Code: 429),Query TCU消耗达到配额上限,触发限流机制,影响了用户体验和业务稳定性。

- 成本层面: Amazon Timestream费用增长完全超出预期,临时调整TCU配额上限虽解决了性能瓶颈,但如何在保障性能的同时实现成本效益最大化成为关键课题。

- 优化层面: 缺乏系统性的性能调优方法论,无法充分利用官方性能基准(8TCUs支持159QPS,p99延迟<200ms)参考值实现最优的性价比配置。

经过深入分析,客户IoT平台呈现出典型的大规模时序数据处理系统特征:

- IoT设备:数万台设备在线运行

- 数据采集:每分钟采集频率,单设备几十个关键指标

- 数据规模:日均数千万条时序记录

- 查询模式:定期执行复杂聚合分析查询

技术架构分析

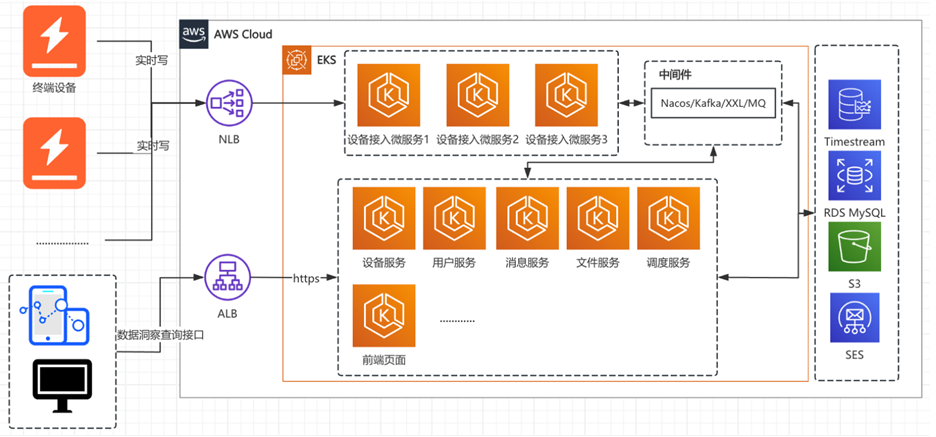

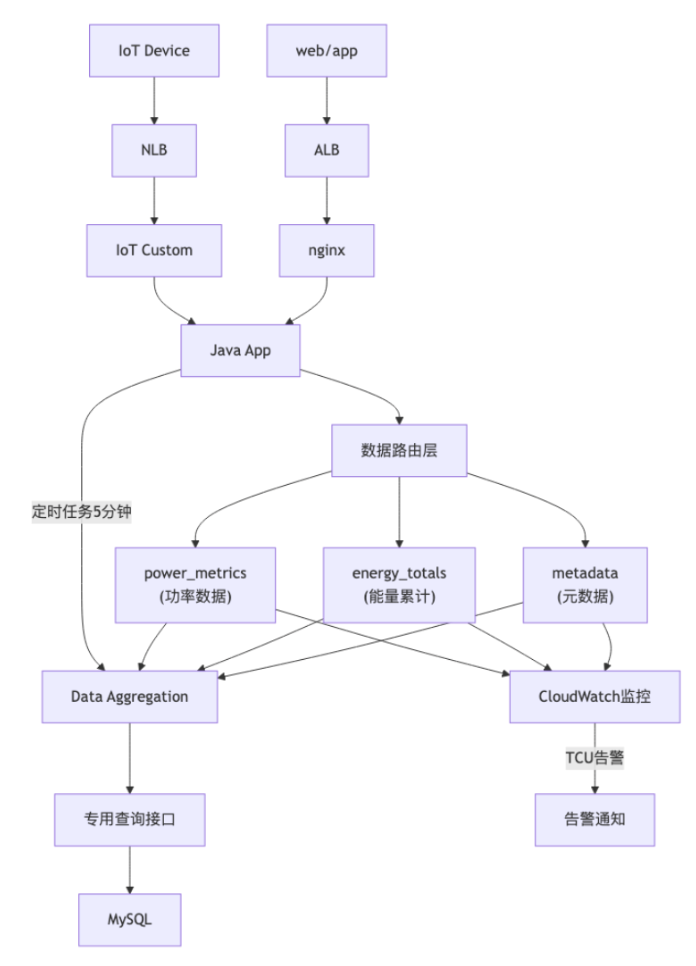

如下图所示,系统IoT平台采用了典型的时序数据处理架构。

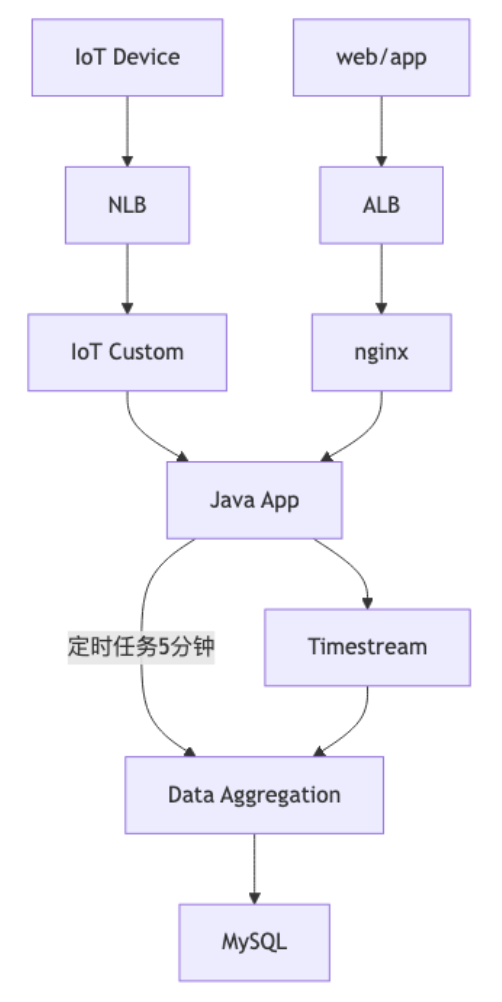

我们重点关注核心数据处理流程:服务端程序通过定时任务机制,每5分钟执行一次数据汇聚操作。系统采用线程池并发处理方式,从Amazon Timestream中查询和聚合时序数据,经过计算处理后写入MySQL数据库进行持久化存储。详细流程如下图所示:

性能与成本挑战

通过对上面的业务现状分析,发现目前存在如下挑战:

| 分类 |

指标 |

现状 |

备注 |

| 成本 |

TCU消耗 |

显著超出预期配额 |

成本大幅增长 |

| 性能 |

查询延迟 |

较高 |

不符合预期 |

| 稳定性 |

查询成功率 |

出现限流 |

Status Code: 429 |

针对根据业务现状分析得出来的挑战,我们联合客开发团队一起进行架构review,对根因进行如下分析:

| 分类 |

当前状态 |

最佳实践 |

| 架构设计 |

单表存储所有数据类型 |

按业务场景分表设计 |

| 维度优化 |

多个DIMENSION字段 |

减少DIMENSION字段 |

| 查询优化 |

复杂CTE+多表JOIN |

优化SQL |

| 执行频率 |

频率过高,设置随意 |

根据产品要求降低频率 |

| 成本监控 |

无 |

采用无服务方式监控TCU消耗成本 |

优化重构目标设定

基于当前业务现状分析,制定了以下三个核心优化目标:

- 性能优化: 通过对现有架构和业务场景梳理、数据表和查询sql的优化,将TCU消耗降至合理范围,确保系统在高并发场景下的稳定性和响应速度。

- 成本控制:在保证业务系统性能有效提升和达到预期目标前提下,实现Amazon Timestream费用的可控增长。

- AI驱动:结合Amazon Q Developer的AI能力全面提升时序数据库优化效能,通过智能代码生成、性能分析,推动团队在大规模IoT数据处理方面的技术能力升级。

三、通过Amazon Q Developer驱动问题诊断

为了准确诊断问题,我们利用Amazon Q Developer生成了完整的测试环境,精确模拟生产场景。我们设计了详细的提示工程来指导Amazon Q Developer生成测试工具。在这个过程中,我们经历了多轮提示工程的迭代优化,从最初的简单需求逐步完善为详细的技术规范。

第一轮:初始需求

AWS TimeStream性能压测工具开发需求

项目背景:

使用AWS TimeStream存储IoT设备数据,存在严重性能问题。需要开发Python工具严格模拟真实业务场景,重现TCU达到配额上限的性能瓶颈。

AWS环境要求:

• Region:[region]

• 数据库:[database_name]

• 表:[table_name]

• 数据规模:[数十万]条记录

表结构:

| 列名 | 类型 | TimeStream属性类型 |

|------|------|-------------------|

| deviceNo | varchar | DIMENSION |

| systemId | varchar | DIMENSION |

| time | timestamp | TIMESTAMP |

| value | double | MULTI |

| measure_name | varchar | MEASURE_NAME |

第二轮:完善表结构与查询需求

AWS TimeStream性能压测工具开发需求

项目背景:

使用AWS TimeStream存储IoT设备数据,存在严重性能问题。需要开发Python工具严格模拟客户场景,重现TCU达到配额上限的性能瓶颈。

AWS环境要求:

• Region:[region]

• 数据库:[database_name]

• 表:[table_name]

• 数据规模:[数十万]条记录

表结构(完整版):

| 列名 | 类型 | TimeStream属性类型 | 说明 |

|------|------|-------------------|------|

| deviceNo | varchar | DIMENSION | 设备编号|

| systemId | varchar | DIMENSION | 系统ID |

| productKey | varchar | DIMENSION | 产品类型标识|

| name | varchar | DIMENSION | 属性名称 |

| modelKey | varchar | DIMENSION | 设备型号标识 |

| source | varchar | DIMENSION | 数据来源渠道 |

| time | timestamp | TIMESTAMP | 时间戳 |

| value | double | MULTI | 数值型属性值(必须>0) |

| stringValue | varchar | MULTI | 字符串属性值 |

| checkFailedMsg | varchar | MULTI | 检查失败消息 |

| requestId | varchar | MULTI | 请求ID |

| measure_name | varchar | MEASURE_NAME | 度量名称,固定值"metrics" |

需要支持复杂的CTE查询和时间窗口聚合查询。

第三轮我们进一步优化内容,完善所有字段定义、增加字段说明和约束、提供日志监控中我们发现的SQL语句

AWS TimeStream性能压测工具开发需求

项目背景:

使用AWS TimeStream存储IoT设备数据,存在严重性能问题。需要开发Python工具严格模拟客户场景,重现TCU达到配额上限的性能瓶颈。

AWS环境要求:

• Region:[region]

• 数据库:[database_name]

• 表:[table_name]

• 数据规模:[数十万]条记录

表结构(完整版):

| 列名 | 类型 | TimeStream属性类型 | 说明 |

|------|------|-------------------|------|

| deviceNo | varchar | DIMENSION | 设备编号|

| systemId | varchar | DIMENSION | 系统ID |

| productKey | varchar | DIMENSION | 产品类型标识|

| name | varchar | DIMENSION | 属性名称 |

| modelKey | varchar | DIMENSION | 设备型号标识 |

| source | varchar | DIMENSION | 数据来源渠道 |

| time | timestamp | TIMESTAMP | 时间戳 |

| value | double | MULTI | 数值型属性值(必须>0) |

| stringValue | varchar | MULTI | 字符串属性值 |

| checkFailedMsg | varchar | MULTI | 检查失败消息 |

| requestId | varchar | MULTI | 请求ID |

| measure_name | varchar | MEASURE_NAME | 度量名称,固定值"metrics" |

SQL查询(必须严格执行,不允许修改):

SQL1 - 复杂CTE查询(每5分钟执行):

WITH latest_record as (

select systemId, deviceNo, name, max(time) as latest_time

FROM [database_name].[table_name]

WHERE "value">0

AND "time"<=from_milliseconds(1748426399999)

AND ("deviceNo"='[device_1]' OR "deviceNo"='[device_2]' OR "deviceNo"='[device_3]')

AND ("name"='[metric_1]' OR "name"='[metric_2]' OR "name"='[metric_3]'

OR "name"='[metric_4]' OR "name"='[metric_5]' OR "name"='[metric_6]'

OR "name"='[metric_7]' OR "name"='[metric_8]' OR "name"='[metric_9]'

OR "name"='[metric_10]' OR "name"='[metric_11]' OR "name"='[metric_12]'

OR "name"='[metric_13]' OR "name"='[metric_14]' OR "name"='[metric_15]'

OR "name"='[metric_16]' OR "name"='[metric_17]' OR "name"='[metric_18]'

OR "name"='[metric_19]' OR "name"='[metric_20]' OR "name"='[metric_21]'

OR "name"='[metric_22]' OR "name"='[metric_23]' OR "name"='[metric_24]'

OR "name"='[metric_25]' OR "name"='[metric_26]' OR "name"='[metric_27]'

OR "name"='[metric_28]' OR "name"='[metric_29]' OR "name"='[metric_30]'

OR "name"='[metric_31]' OR "name"='[metric_32]' OR "name"='[metric_33]'

OR "name"='[metric_34]' OR "name"='[metric_35]' OR "name"='[metric_36]'

OR "name"='[metric_37]' OR "name"='[metric_38]' OR "name"='[metric_39]'

OR "name"='[metric_40]' OR "name"='[metric_41]' OR "name"='[metric_42]'

OR "name"='[metric_43]' OR "name"='[metric_44]')

group by systemId, deviceNo, name

)

SQL2 - 时间窗口聚合查询:

select BIN(time, 5m) as time, name, AVG(value) as value, modelKey, productKey, deviceNo

from [database_name].[table_name]

WHERE "systemId"='[system_id]'

AND "productKey"='[product_key]'

AND "time">=from_milliseconds(1748448000000)

AND "time"<=from_milliseconds(1748518157000)

AND ("name"='[metric_a]' OR "name"='[metric_b]' OR "name"='[metric_c]'

OR "name"='[metric_d]' OR "name"='[metric_e]' OR "name"='[metric_f]'

OR "name"='[metric_g]' OR "name"='[metric_h]')

group by name, BIN(time, 5m), productKey, modelKey, deviceNo

order by time asc

第四轮我们持续优化我们需要生成的模拟场景所需要的测试程序的相关要求

AWS TimeStream性能压测工具开发需求

项目背景:

使用AWS TimeStream存储IoT设备数据,存在严重性能问题。需要开发Python工具严格模拟客户场景,重现TCU达到配额上限的性能瓶颈。

AWS环境要求:

• Region:[region]

• 数据库:[database_name]

• 表:[table_name]

• 数据规模:[数十万]条记录

表结构(完整版):

| 列名 | 类型 | TimeStream属性类型 | 说明 |

|------|------|-------------------|------|

| deviceNo | varchar | DIMENSION | 设备编号|

| systemId | varchar | DIMENSION | 系统ID |

| productKey | varchar | DIMENSION | 产品类型标识|

| name | varchar | DIMENSION | 属性名称 |

| modelKey | varchar | DIMENSION | 设备型号标识 |

| source | varchar | DIMENSION | 数据来源渠道 |

| time | timestamp | TIMESTAMP | 时间戳 |

| value | double | MULTI | 数值型属性值(必须>0) |

| stringValue | varchar | MULTI | 字符串属性值 |

| checkFailedMsg | varchar | MULTI | 检查失败消息 |

| requestId | varchar | MULTI | 请求ID |

| measure_name | varchar | MEASURE_NAME | 度量名称,固定值"metrics" |

SQL查询(必须严格执行,不允许修改):

SQL1 - 复杂CTE查询(每5分钟执行):

WITH latest_record as (

select systemId, deviceNo, name, max(time) as latest_time

FROM [database_name].[table_name]

WHERE "value">0

AND "time"<=from_milliseconds(1748426399999)

AND ("deviceNo"='[device_1]' OR "deviceNo"='[device_2]' OR "deviceNo"='[device_3]')

AND ("name"='[metric_1]' OR "name"='[metric_2]' OR "name"='[metric_3]'

OR "name"='[metric_4]' OR "name"='[metric_5]' OR "name"='[metric_6]'

OR "name"='[metric_7]' OR "name"='[metric_8]' OR "name"='[metric_9]'

OR "name"='[metric_10]' OR "name"='[metric_11]' OR "name"='[metric_12]'

OR "name"='[metric_13]' OR "name"='[metric_14]' OR "name"='[metric_15]'

OR "name"='[metric_16]' OR "name"='[metric_17]' OR "name"='[metric_18]'

OR "name"='[metric_19]' OR "name"='[metric_20]' OR "name"='[metric_21]'

OR "name"='[metric_22]' OR "name"='[metric_23]' OR "name"='[metric_24]'

OR "name"='[metric_25]' OR "name"='[metric_26]' OR "name"='[metric_27]'

OR "name"='[metric_28]' OR "name"='[metric_29]' OR "name"='[metric_30]'

OR "name"='[metric_31]' OR "name"='[metric_32]' OR "name"='[metric_33]'

OR "name"='[metric_34]' OR "name"='[metric_35]' OR "name"='[metric_36]'

OR "name"='[metric_37]' OR "name"='[metric_38]' OR "name"='[metric_39]'

OR "name"='[metric_40]' OR "name"='[metric_41]' OR "name"='[metric_42]'

OR "name"='[metric_43]' OR "name"='[metric_44]')

group by systemId, deviceNo, name

)

SQL2 - 时间窗口聚合查询:

select BIN(time, 5m) as time, name, AVG(value) as value, modelKey, productKey, deviceNo

from [database_name].[table_name]

WHERE "systemId"='[system_id]'

AND "productKey"='[product_key]'

AND "time">=from_milliseconds(1748448000000)

AND "time"<=from_milliseconds(1748518157000)

AND ("name"='[metric_a]' OR "name"='[metric_b]' OR "name"='[metric_c]'

OR "name"='[metric_d]' OR "name"='[metric_e]' OR "name"='[metric_f]'

OR "name"='[metric_g]' OR "name"='[metric_h]')

group by name, BIN(time, 5m), productKey, modelKey, deviceNo

order by time asc

三阶段实施方案:

阶段一:创建表结构 + 验证

阶段二:生成测试数据 + 验证

阶段三:性能压测 + 验证

技术要求:

• Python 3.9+, boto3

• 必须使用[region]区域

• 批量写入优化

• 错误处理机制

最终优化的完整提示工程词如下所示:

AWS TimeStream性能压测工具开发需求 - timestreamdemo

项目背景:

使用AWS TimeStream存储IoT设备数据,存在严重性能问题。需要开发Python工具严格模拟客户场景,重现TCU达到100的性能瓶颈,为优化提供数据支撑。

AWS环境要求:

• Region:[region](必须使用此区域进行测试和验证)

• AWS凭证:必须使用~/.aws/credentials中的[global]配置

• 数据库:[database_name]

• 表:[table_name]

• 数据规模:[几十万]条记录(模拟12个小时时间跨度)

• 查询频率:极高频率并发查询

• 性能问题:TCU使用量目标100

表结构(严格按此实现):

| 列名 | 类型 | TimeStream属性类型 | 说明 |

|------|------|-------------------|------|

| deviceNo | varchar | DIMENSION | 设备编号|

| systemId | varchar | DIMENSION | 系统ID|

| productKey | varchar | DIMENSION | 产品类型标识 |

| name | varchar | DIMENSION | 属性名称,存储设备的各种属性名称 |

| modelKey | varchar | DIMENSION | 设备型号标识 |

| source | varchar | DIMENSION | 数据来源渠道 |

| time | timestamp | TIMESTAMP | 时间戳,记录数据产生的时间点 |

| value | double | MULTI | 数值型属性值,存储功率、电量等数值(必须>0) |

| stringValue | varchar | MULTI | 字符串属性值,存储字符串型的属性值 |

| checkFailedMsg | varchar | MULTI | 检查失败消息,记录数据校验失败时的错误信息 |

| requestId | varchar | MULTI | 请求ID,记录API请求的唯一标识符 |

| measure_name | varchar | MEASURE_NAME | 度量名称,固定值"metrics" |

SQL查询(必须严格执行,不允许修改):

SQL1 - 复杂CTE查询(每5分钟执行):

WITH latest_record as (

select systemId, deviceNo, name, max(time) as latest_time

FROM [database_name].[table_name]

WHERE "value">0

AND "time"<=from_milliseconds(1748426399999)

AND ("deviceNo"='[device_1]' OR "deviceNo"='[device_2]' OR "deviceNo"='[device_3]')

AND ("name"='[metric_1]' OR "name"='[metric_2]' OR "name"='[metric_3]'

OR "name"='[metric_4]' OR "name"='[metric_5]' OR "name"='[metric_6]'

OR "name"='[metric_7]' OR "name"='[metric_8]' OR "name"='[metric_9]'

OR "name"='[metric_10]' OR "name"='[metric_11]' OR "name"='[metric_12]'

OR "name"='[metric_13]' OR "name"='[metric_14]' OR "name"='[metric_15]'

OR "name"='[metric_16]' OR "name"='[metric_17]' OR "name"='[metric_18]'

OR "name"='[metric_19]' OR "name"='[metric_20]' OR "name"='[metric_21]'

OR "name"='[metric_22]' OR "name"='[metric_23]' OR "name"='[metric_24]'

OR "name"='[metric_25]' OR "name"='[metric_26]' OR "name"='[metric_27]'

OR "name"='[metric_28]' OR "name"='[metric_29]' OR "name"='[metric_30]'

OR "name"='[metric_31]' OR "name"='[metric_32]' OR "name"='[metric_33]'

OR "name"='[metric_34]' OR "name"='[metric_35]' OR "name"='[metric_36]'

OR "name"='[metric_37]' OR "name"='[metric_38]' OR "name"='[metric_39]'

OR "name"='[metric_40]' OR "name"='[metric_41]' OR "name"='[metric_42]'

OR "name"='[metric_43]' OR "name"='[metric_44]')

group by systemId, deviceNo, name

)

SQL2 - 时间窗口聚合查询:

select BIN(time, 5m) as time, name, AVG(value) as value, modelKey, productKey, deviceNo

from [database_name].[table_name]

WHERE "systemId"='[system_id]'

AND "productKey"='[product_key]'

AND "time">=from_milliseconds(1748448000000)

AND "time"<=from_milliseconds(1748518157000)

AND ("name"='[metric_a]' OR "name"='[metric_b]' OR "name"='[metric_c]'

OR "name"='[metric_d]' OR "name"='[metric_e]' OR "name"='[metric_f]'

OR "name"='[metric_g]' OR "name"='[metric_h]')

group by name, BIN(time, 5m), productKey, modelKey, deviceNo

order by time asc

三阶段实施方案:

阶段一:创建表结构 + 验证

• 在[region]区域创建TimeStream数据库和表

• TimeStream表创建时必须通过写入样本数据来定义字段结构

• 写入包含所有维度字段和度量字段的样本记录

• 验证表结构、分区键、保留策略

• 验证区域配置正确性

• 验证通过后进入阶段二

阶段二:生成测试数据 + 验证

• 在[region]区域生成[几十]万条精确匹配SQL查询条件的数据

• 设备:'[name_1]', '[name_2]', '[[name_3]'

• 属性:SQL1中[数量]个属性 + SQL2中[数量]个属性

• 时间范围:12小时时间跨度,确保[数量]万条记录覆盖完整时间范围

• 批量大小:10-20条记录/批次,批次间隔至少1秒

• 错误处理:必须捕获并记录所有RejectedRecords的详细信息

• 断点续传:支持从失败的批次开始续传,避免重复写入数据

• 大量数据处理:当出现RejectedRecordsException时,自动跳过被拒绝的记录,继续处理后续批次

• 重试机制:对于临时性错误(如限流),实现指数退避重试策略

• 验证数据量、分布、质量

• 验证通过后进入阶段三

阶段三:性能压测 + 验证[region]

• TCU压力测试策略:

- SQL1(复杂CTE查询):50个并发线程,每5分钟执行一次

- SQL2(时间窗口聚合):50个并发线程,每1小时执行一次

- 总计100个并发线程进行极限压力测试

- 动态12小时时间范围:覆盖所有[数量]万条记录

- 动态时间窗口:5m, 1h轮换

• TCU消耗最大化策略:

- 12小时大范围扫描:最大化内存和CPU使用

- 100线程并发:最大化并行处理能力

- 复杂CTE+聚合查询:最大化计算复杂度

• 实时TCU监控:每30秒监控

• 目标:快速实现100TCU瓶颈

工程结构:

timestreamdemo/

├── src/

│ ├── __init__.py

│ ├── config.py # 包含region配置

│ ├── timestream_setup.py # 阶段一

│ ├── data_generator.py # 阶段二

│ ├── load_tester.py # 阶段三

│ ├── timestream_client.py

│ ├── validator.py

│ └── monitor.py

├── config.yaml # 默认region

├── requirements.txt

├── README.md

└── main.py

技术要求:

• Python 3.9+, boto3

• 所有AWS操作必须在[region]区域执行

• AWS凭证配置:必须使用~/.aws/credentials中的[global]配置文件

• TimeStream表结构:必须通过写入样本数据来定义字段结构,不能只创建空表

• 时间戳限制:使用12小时时间范围,即当前时间前15分钟到前12小时内,确保数据生成过程中时间戳始终有效

• 批量写入优化:使用小批次(10-20条/批次)和适当的等待时间(1秒)避免限流

• 错误处理:必须捕获并显示RejectedRecords的详细错误信息,包括具体的拒绝原因

• 数据验证:每条记录写入前必须验证时间戳格式和字段值的有效性

• 断点续传:支持从指定批次开始续传数据生成,避免重复工作

• 容错处理:对于RejectedRecordsException,记录错误但不中断整个数据生成进程

• 重试策略:对于网络或临时性错误,实现重试机制(仅1次)

• 动态SQL调整:性能测试时动态计算并替换SQL中的时间戳条件,确保查询能够匹配生成的数据

• 简洁实用的代码,避免过度设计

• 每阶段必须验证成功才能继续

• 详细的执行日志和验证报告

• 支持分阶段执行和单独验证

• 区域验证和错误提示

执行命令:

bash

python main.py --stage setup --validate # 在[region]创建表+验证

python main.py --stage generate --validate # 在[region]生成数据+验证

python main.py --stage test --validate # 在[region]压测+验证

成功标准:

在[region]区域快速验证TCU使用量达到100的性能瓶颈场景。

请提供完整的Python代码实现。

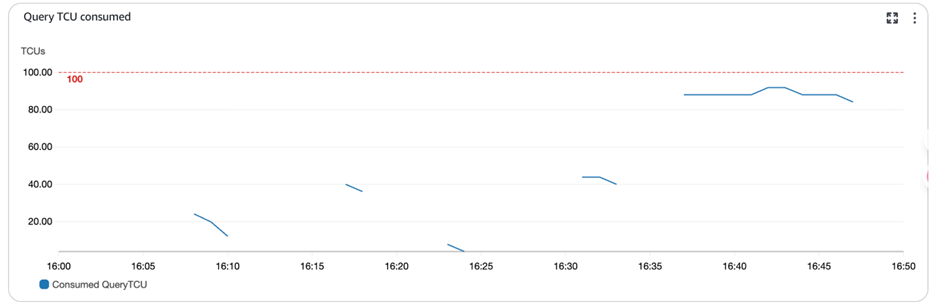

通过上面多轮迭代优化,我们的提示工程词从最初的简单需求发展为详细的技术规范。每一轮都针对Amazon Q Developer的反馈和生成代码的问题进行了针对性改进。通过精心设计的提示工程与Amazon Q Developer交互,我们成功在测试环境中复现了生产环境的性能瓶颈。整个过程完全模拟了生产环境的真实场景,包括SQL语句逻辑、表结构设计以及实际执行频率,最终帮助我们快速定位并识别了关键性能问题。

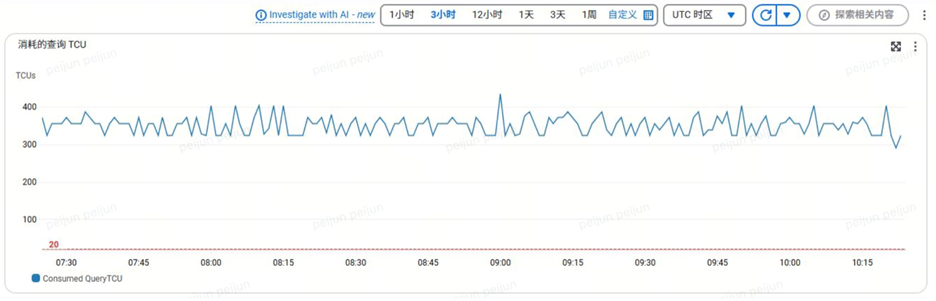

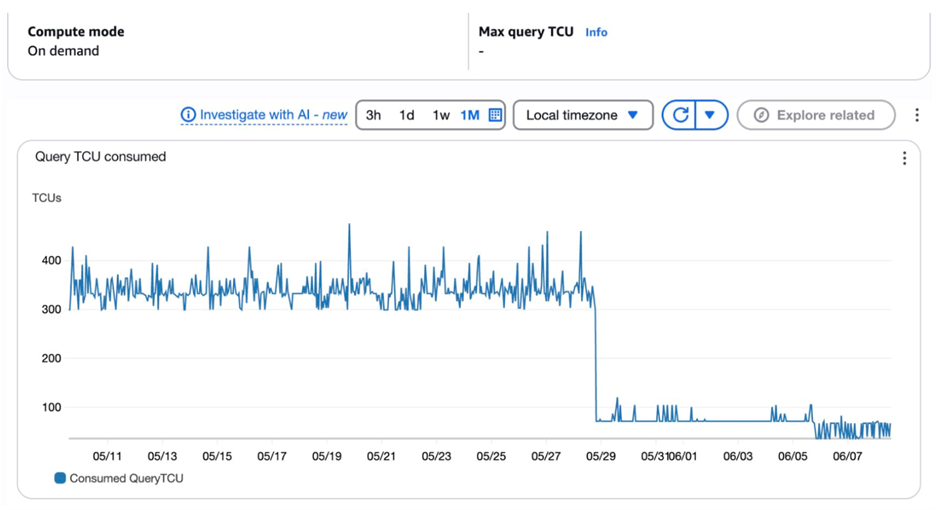

而真实生产环境的监控数据更加直观地验证了我们的分析。从生产环境监控截图可以清晰看到,TCU(Transaction Compute Units)峰值达到了300+,远超正常预期范围,这与我们通过模拟测试发现的性能问题完全吻合,进一步确认了问题的严重性和我们分析的准确性。

通过Amazon Q Developer生成的测试工具,我们成功复现了生产环境的性能问题。

四、AI驱动的优化策略制定

基于问题诊断结果,Amazon Q Developer提供了系统性的优化建议:

1、系统架构优化建议

- 监控告警完善:建立完整的性能监控体系

- 接口逻辑拆分

2、数据模型重构建议

- 按查询模式分表:将单表拆分为功能专用表

- 标准化度量模式:采用measure_name/measure_value标准模式

3、SQL优化

- 消除复杂JOIN:通过表结构优化减少JOIN需求

- 减少扫描范围:通过分表减少数据扫描量

- 优化时间窗口:合理设置查询时间范围

五、架构设计优化

根据第二章技术架构分析以及对性能问题重现,结合我们制定的优化策略,我们可以直接给出现有架构的缺陷:

单表设计缺陷

- 所有IoT数据存储在一个表中

- 多个不同类型的指标混合存储

- 查询时需要扫描全部数据类型

查询模式不匹配

- 功率趋势查询和能量累计查询混合

- 无法针对不同查询模式优化

- 导致不必要的数据扫描

维度设计不当

- 维度基数过高,影响查询性能

- 非查询字段占用DIMENSION资源

我们在保证现有的Iot平台整体架构逻辑设计基础上不变的情况下,重点对于数据读写Amazon Timestream部分进行了优化设计。如下图所示:

相比于最初的架构设计,优势在于:

数据分离存储

- 按业务特性分表存储

- 减少查询扫描范围

- 提高查询效率

完善监控体系

专用查询接口

- 针对不同查询模式优化

- 减少复杂JOIN操作

- 提升查询性能

六、数据模型优化

1、[table1]

用于存储实时功率相关的测量数据,适用于时间分组聚合和趋势分析。

|

列名 |

数据类型 |

TimeStream 属性类型 |

描述 |

| 1 |

deviceNo |

varchar |

DIMENSION |

设备唯一标识符,主要查询筛选条件 |

| 2 |

systemId |

varchar |

DIMENSION |

系统标识符,常用于查询筛选 |

| 3 |

productKey |

varchar |

DIMENSION |

产品类型标识,用于区分不同类型产品 |

| 4 |

time |

timestamp |

TIMESTAMP |

数据记录时间戳 |

| 5 |

measure_name |

varchar |

MEASURE_NAME |

相关属性名称 |

| 6 |

measure_value::double |

double |

MEASURE_VALUE |

对应数值 |

| 7 |

measure_value::varchar |

varchar |

MEASURE_VALUE |

字符串类型的属性值(当需要时) |

| 8 |

modelKey |

varchar |

MEASURE |

设备型号标识,作为附加信息,不作为主要查询条件 |

| 9 |

source |

varchar |

MEASURE |

数据来源标识,作为附加信息 |

- [table2]

用于存储设备能量数据,适合最新记录查询和历史统计分析。

|

列名 |

数据类型 |

TimeStream 属性类型 |

描述 |

| 1 |

deviceNo |

varchar |

DIMENSION |

设备唯一标识符,主要查询筛选条件 |

| 2 |

systemId |

varchar |

DIMENSION |

系统标识符,常用于查询筛选 |

| 3 |

productKey |

varchar |

DIMENSION |

产品类型标识,用于区分不同类型产品 |

| 4 |

time |

timestamp |

TIMESTAMP |

数据记录时间戳 |

| 5 |

measure_name |

varchar |

MEASURE_NAME |

相关属性名称 |

| 6 |

measure_value::double |

double |

MEASURE_VALUE |

对应的累计数值 |

| 7 |

measure_value::varchar |

varchar |

MEASURE_VALUE |

字符串类型的属性值(当需要时) |

| 8 |

modelKey |

varchar |

MEASURE |

设备型号标识,作为附加信息 |

| 9 |

source |

varchar |

MEASURE |

数据来源标识,作为附加信息 |

- [metadata_table]

用于存储不常查询的元数据和系统信息,减少主表的查询负担。

|

列名 |

数据类型 |

TimeStream 属性类型 |

描述 |

| 1 |

deviceNo |

varchar |

DIMENSION |

设备唯一标识符 |

| 2 |

requestId |

varchar |

DIMENSION |

API请求ID,用于跟踪 |

| 3 |

time |

timestamp |

TIMESTAMP |

数据记录时间戳 |

| 4 |

measure_name |

varchar |

MEASURE_NAME |

元数据属性名,如’errorCode’, ‘statusMessage’ |

| 5 |

measure_value::varchar |

varchar |

MEASURE_VALUE |

对应的元数据值 |

| 6 |

systemId |

varchar |

MEASURE |

系统标识符(作为附加信息) |

| 7 |

productKey |

varchar |

MEASURE |

产品类型(作为附加信息) |

优化前后对比:

|

A |

B |

C |

D |

| 1 |

指标 |

优化前 |

优化后 |

效果 |

| 2 |

DIMENSION字段数 |

6 |

3 |

减少50% |

| 3 |

维度基数 |

高 |

低 |

查询效率提升 |

| 4 |

表数量 |

1 |

3 |

按业务拆分 |

优化的维度设计:

- 将非筛选字段改为MEASURE,减少维度基数

- 在单表设计中,每次查询都会扫描整个表,无论您是查询功率数据还是能量累计数据

- 拆分后,查询只需扫描包含目标数据类型的表,通常可以减少 50-70% 的扫描数据量

- 区分为功率趋势查询和累计能量查询

标准化的measure_name/measure_value使用:

- 取消原来的name(DIMENSION)+value(MULTI)设计

- 采用标准的measure_name和对应measure_value模式

合理的表分区策略:

- 按数据特性和查询模式分表,避免扫描不必要的数据

- 功率数据和累计能量数据分离,优化各自的查询性能

元数据分离:

- 将requestId、checkFailedMsg等辅助信息移至专门的元数据表

- 减轻主表负担,提高查询和写入性能

优化前SQL

WITH latest_record as (

select systemId, deviceNo, name, max(time) as latest_time

FROM [database_name].[table_name]

WHERE "value">0

AND "time"<=from_milliseconds(1748426399999)

AND ("deviceNo"='[device_1]' OR "deviceNo"='[device_2]' OR "deviceNo"='[device_3]')

AND ("name"='[metric_1]' OR "name"='[metric_2]' OR "name"='[metric_3]'

OR "name"='[metric_4]' OR "name"='[metric_5]' OR "name"='[metric_6]'

OR "name"='[metric_7]' OR "name"='[metric_8]' OR "name"='[metric_9]'

OR "name"='[metric_10]' OR "name"='[metric_11]' OR "name"='[metric_12]'

OR "name"='[metric_13]' OR "name"='[metric_14]' OR "name"='[metric_15]'

OR "name"='[metric_16]' OR "name"='[metric_17]' OR "name"='[metric_18]'

OR "name"='[metric_19]' OR "name"='[metric_20]' OR "name"='[metric_21]'

OR "name"='[metric_22]' OR "name"='[metric_23]' OR "name"='[metric_24]'

OR "name"='[metric_25]' OR "name"='[metric_26]' OR "name"='[metric_27]'

OR "name"='[metric_28]' OR "name"='[metric_29]' OR "name"='[metric_30]'

OR "name"='[metric_31]' OR "name"='[metric_32]' OR "name"='[metric_33]'

OR "name"='[metric_34]' OR "name"='[metric_35]' OR "name"='[metric_36]'

OR "name"='[metric_37]' OR "name"='[metric_38]' OR "name"='[metric_39]'

OR "name"='[metric_40]' OR "name"='[metric_41]' OR "name"='[metric_42]'

OR "name"='[metric_43]' OR "name"='[metric_44]')

group by systemId, deviceNo, name

)

对应优化后SQL

SELECT

systemId,

value,

stringValue,

deviceNo,

modelKey,

name,

time,

requestId,

productKey

FROM (

SELECT *,

ROW_NUMBER() OVER (

PARTITION BY systemId, deviceNo, name

ORDER BY time DESC

) AS row_num

FROM [database_name].[table_name]

WHERE

time BETWEEN from_milliseconds(1748480400000) AND from_milliseconds(1748483999999)

AND (systemId = [systemId])

AND name IN (

'metric_1', 'metric_2', '[metric_N]'

)

)

WHERE row_num = 1

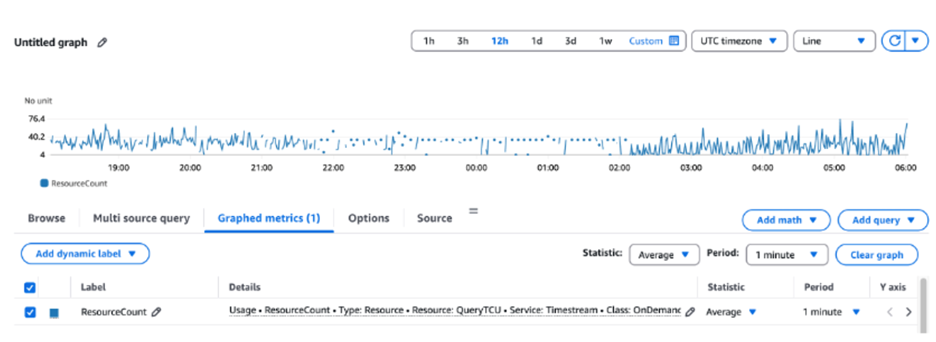

优化后,整体数据扫描量:减少60-70%,查询响应时间:提升80%,TCU消耗:减少75%。优化后测试结果监控如下图所示:

最终通过架构优化、数据模型重构和代码优化,成功实现TCU消耗大幅降低,日均费用显著削减,取得了理想的成本优化效果。

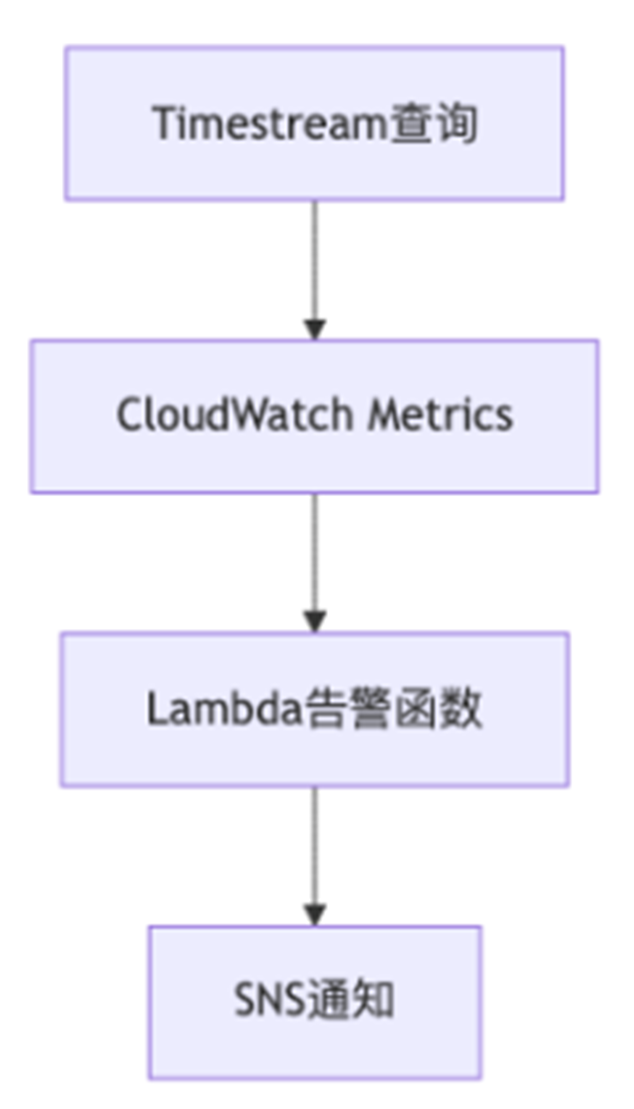

六、TCU监控

在项目初期,由于架构设计缺陷和代码中的查询优化不当,出现了TCU消耗异常增长的情况,还导致了不必要的成本支出,凸显了实时监控的重要性。在现有的架构基础上,我们构建了基于serveless架构的TCU监控。流程如下图所示:

1、创建CloudWatch Alarm,TCU监控配置

ResourceCount:检测账号下TCU用量,可以在所需的时间段内进行监QueryTCU控,以监控账户中配置的计算单元。该指标每 15 分钟发出一次。

2、创建SNS。

3、Lambda函数订阅到SNS Topic: timestream-tcu-alerts,同时创建lambda函数环境变量DINGTALK_WEBHOOK_URL。

def lambda_handler(event, context):

print(f"Received event: {json.dumps(event)}")

# 钉钉机器人Webhook URL (从环境变量获取)

dingtalk_webhook = os.environ.get('DINGTALK_WEBHOOK_URL')

if not dingtalk_webhook:

print("Missing DINGTALK_WEBHOOK_URL environment variable")

return {

'statusCode': 400,

'body': json.dumps('Missing DINGTALK_WEBHOOK_URL environment variable')

}

try:

# 解析SNS消息

sns_message = json.loads(event['Records'][0]['Sns']['Message'])

print(f"SNS message: {json.dumps(sns_message)}")

# 提取告警信息

alarm_name = sns_message.get('AlarmName', 'Unknown Alarm')

alarm_description = sns_message.get('AlarmDescription', '')

new_state = sns_message.get('NewStateValue', 'UNKNOWN')

reason = sns_message.get('NewStateReason', '')

timestamp = sns_message.get('StateChangeTime', '')

region = sns_message.get('Region', 'us-east-1')

# 提取指标信息

metric_name = sns_message.get('MetricName', '')

namespace = sns_message.get('Namespace', '')

threshold = sns_message.get('Threshold', '')

# 格式化时间

if timestamp:

try:

# 处理不同的时间格式

if timestamp.endswith('Z'):

timestamp = timestamp[:-1] + '+00:00'

dt = datetime.fromisoformat(timestamp)

formatted_time = dt.strftime('%Y-%m-%d %H:%M:%S UTC')

except:

formatted_time = timestamp

else:

formatted_time = datetime.now().strftime('%Y-%m-%d %H:%M:%S')

# 根据告警状态设置图标和消息

if new_state == 'ALARM':

icon = '?'

state_text = '告警触发'

urgency = '【紧急】'

elif new_state == 'OK':

icon = '✅'

state_text = '恢复正常'

urgency = '【恢复】'

else:

icon = '⚠️'

state_text = '数据不足'

urgency = '【提醒】'

# 构建详细的告警消息

message_content = f"""{urgency} TimeStream TCU监控告警

{icon} 告警状态: {state_text}

? 告警名称: {alarm_name}

? 区域: {region}

? 监控指标: {namespace}/{metric_name}

⚡ 阈值: > {threshold} TCU

? 告警描述: {alarm_description}

? 触发原因: {reason}

⏰ 告警时间: {formatted_time}

请立即检查TimeStream使用情况:

• 查看CloudWatch控制台监控图表

• 检查当前查询负载和复杂度

• 考虑优化查询或调整资源配置"""

# 构建钉钉消息

dingtalk_message = {

"msgtype": "text",

"text": {

"content": message_content

}

}

# 发送到钉钉

http = urllib3.PoolManager()

response = http.request(

'POST',

dingtalk_webhook,

body=json.dumps(dingtalk_message),

headers={'Content-Type': 'application/json'}

)

print(f"DingTalk response status: {response.status}")

print(f"DingTalk response data: {response.data}")

if response.status == 200:

return {

'statusCode': 200,

'body': json.dumps('Alert sent to DingTalk successfully')

}

else:

return {

'statusCode': response.status,

'body': json.dumps(f'Failed to send alert to DingTalk: {response.data.decode()}')

}

except Exception as e:

print(f"Error processing alarm: {str(e)}")

import traceback

traceback.print_exc()

# 发送错误通知到钉钉

try:

error_message = {

"msgtype": "text",

"text": {

"content": f"❌ TimeStream告警处理失败\n\n错误信息: {str(e)}\n时间: {datetime.now().strftime('%Y-%m-%d %H:%M:%S')}\n\n请检查Lambda函数日志。"

}

}

if dingtalk_webhook:

http = urllib3.PoolManager()

http.request(

'POST',

dingtalk_webhook,

body=json.dumps(error_message),

headers={'Content-Type': 'application/json'}

)

except:

pass

return {

'statusCode': 500,

'body': json.dumps(f'Error processing alarm: {str(e)}')

}

4、Amazon Timestream费用监控,通过配置费用日账单告警,密切关注数据库日费用;如果超过前一天的10%,触发告警至钉钉群机器人。

这套基于CloudWatch + Lambda + SNS的serverless监控方案具有以下优势:

- 零运维:完全托管的服务,无需维护基础设施

- 弹性扩展:自动适应业务增长

- 成本效益:按使用量付费,避免资源浪费

通过这套监控体系,用户能够实时掌握Timestream的使用情况,为业务决策提供数据支撑,确保在快速发展的同时保持成本效益的最优平衡。

七、结论

本blog着重介绍通过Amazon Q Developer的AI驱动能力,结合Amazon Timestream时序数据库服务,实现IoT设备的性能优化与成本控制实践。文章涵盖了问题诊断、架构重构、数据模型优化、SQL查询优化和AI辅助开发等核心环节,展示了如何实现TCU消耗大幅降低和日均成本显著削减的完整优化过程。同时强调了对于云上Serverless相关应用在生产环境中建立成本动态监控告警机制的重要性,确保资源使用的可控性和成本的可预测性。

核心贡献:

- 方法论创新:建立了AI驱动的时序数据库优化方法论,为行业提供了可参考的最佳实践。

- 技术突破:验证了Amazon Q Developer在复杂系统优化中的实际价值和应用潜力。

- 商业价值:实现了显著的成本节约和性能提升,证明了技术优化的商业价值。

实践价值:

希望当您面临大规模IoT时序数据性能瓶颈和成本挑战时,本文的优化方法论和AI驱动实践能够为您提供有价值的参考,助力实现时序数据库的高效管理、挖掘IoT数据中的业务价值,推动企业数字化转型和降本增效目标的达成。随着IoT设备规模的不断扩大和数据复杂度的增加,AI驱动的数据库优化将成为企业数字化转型的重要支撑。我们相信,通过持续的技术创新和实践探索,能够为更多企业提供高效、经济的IoT数据处理解决方案。

参考文档

1、https://aws.amazon.com/blogs/database/understanding-and-optimizing-amazon-timestream-compute-units-for-efficient-time-series-data-management/

2、https://aws.amazon.com/timestream/pricing/

3、Amazon Q Developer Documentation

*前述特定亚马逊云科技生成式人工智能相关的服务目前在亚马逊云科技海外区域可用。亚马逊云科技中国区域相关云服务由西云数据和光环新网运营,具体信息以中国区域官网为准。

本篇作者

AWS 架构师中心: 云端创新的引领者

探索 AWS 架构师中心,获取经实战验证的最佳实践与架构指南,助您高效构建安全、可靠的云上应用

|

|