- Generative KI›

- Amazon Bedrock›

- Integritätsschutz

Amazon-Bedrock-Integritätsschutz

Implementieren Sie Schutzmaßnahmen, die auf Ihre Anwendungsanforderungen und verantwortungsvollen KI-Richtlinien zugeschnitten sind.

Verantwortungsvolle KI-Anwendungen mit Integritätsschutz entwickeln

Amazon-Bedrock-Integritätsschutz bietet konfigurierbare Schutzmaßnahmen, um die sichere Entwicklung generativer KI-Anwendungen in großem Maßstab zu unterstützen. Dank eines konsistenten und standardisierten Ansatzes für verschiedenste Basismodelle, darunter von Amazon Bedrock unterstützte Basismodelle, optimierte Modelle und Modelle, die außerhalb von Amazon Bedrock gehostet werden, bietet der Integritätsschutz branchenführende Sicherheitsvorkehrungen:

- Verwendet Automated Reasoning, um KI-Halluzinationen zu minimieren, und identifiziert korrekte Modellantworten mit einer Genauigkeit von bis zu 99 % – die erste und einzige Sicherheitsvorkehrung für generative KI, die dies leistet.

- Branchenführende Schutzmaßnahmen für Texte und Bilder, sodass Kunden bis zu 88 % der schädlichen multimodalen Inhalte blockieren können

Remitly Transforms Customer Support with Speed and Trust using Amazon Bedrock

KONE Powers Responsible AI Field Service with Amazon Bedrock

Einheitliches Sicherheitsniveau für alle Anwendungen und Modelle der generativen KI

Integritätsschutz ist die einzige Funktion für verantwortungsbewusste KI eines großen Cloud-Anbieters, die Sie beim Aufbau und der Anpassung von Sicherheits-, Datenschutz- und Wahrheitsgarantien für Ihre Anwendungen mit generativer KI unterstützt. Es bewertet Benutzer-Eingaben und Modellantworten auf der Grundlage von anwendungsspezifischen Richtlinien und bietet damit eine zusätzliche Schutzebene, die über die nativ verfügbaren Funktionen hinausgeht. Sicherheitsvorkehrungen von Integritätsschutz können über die ApplyGuardrail-API auf Modelle angewendet werden, die auf Amazon Bedrock gehostet werden, sowie auf Modelle von Drittanbietern (wie OpenAI und Google Gemini). Sie können auch Integritätsschutz mit einem Agenten-Framework wie Strands Agents verwenden, einschließlich Agenten, deren Bereitstellung mit Amazon Bedrock AgentCore erfolgt. Integritätsschutz unterstützt die Filterung von Halluzinationen und verbessert die sachliche Genauigkeit durch kontextbezogene Überprüfungen anhand von RAG-Inhalten und Automated Reasoning, um nachweislich wahrheitsgemäße Antworten zu liefern. Weitere Informationen finden Sie in der schrittweisen Anleitung zur Implementierung des Amazon-Bedrock-Integritätsschutzes.

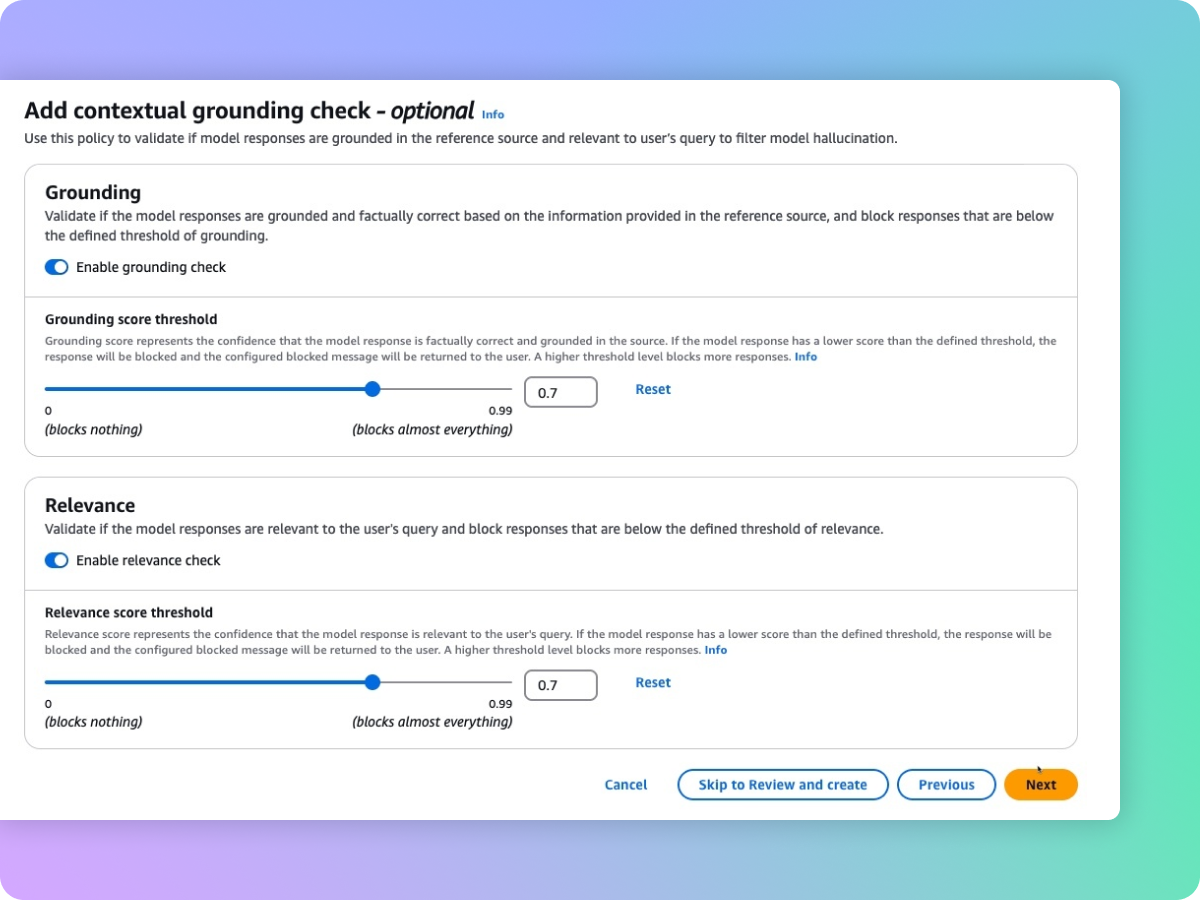

Erkennen von Halluzinationen in Modellantworten mithilfe von kontextuellen Erdungstests

Kunden müssen wahrheitsgemäße und vertrauenswürdige generative KI-Anwendungen bereitstellen, um das Vertrauen der Nutzer zu bewahren und zu stärken. Allerdings können Basismodelle aufgrund von Halluzinationen falsche Informationen erzeugen: Sie weichen von den Quellinformationen ab, vermischen mehrere Informationen oder erfinden neue Informationen. Der Integritätsschutz unterstützt kontextbezogene Integritätsprüfungen, um Halluzinationen zu erkennen und zu filtern, wenn die Antworten nicht in den Quellinformationen begründet sind (beispielsweise sachlich falsche oder neue Informationen) und für die Anfrage oder Anweisung des Benutzers irrelevant sind. Kontextbezogene Integritätsprüfungen können dabei helfen, Halluzinationen für RAG-, Zusammenfassungs- und Konversationsanwendungen zu erkennen, bei denen die Quellinformationen als Referenz zur Validierung der Modellantwort verwendet werden können.

Automated Reasoning identifiziert korrekte Modellantworten mit einer Genauigkeit von bis zu 99 %, um Halluzinationen zu minimieren.

Automated-Reasoning-Prüfungen im Amazon-Bedrock-Integritätsschutz sind die erste und einzige Schutzmaßnahme für generative KI, die dabei hilft, faktische Fehler durch Halluzinationen zu verhindern, indem sie logisch korrekte und überprüfbare Argumente liefert, die erklären, warum Antworten richtig sind. Automated Reasoning hilft, Halluzinationen abzuschwächen, indem fundierte mathematische Techniken verwendet werden, um die generierten Informationen zu validieren, zu korrigieren und logisch zu erklären. So wird sichergestellt, dass die Ergebnisse mit bekannten Fakten übereinstimmen und nicht auf erfundenen oder inkonsistenten Daten basieren. Entwickler können eine Automated-Reasoning-Richtlinie erstellen, indem sie ein vorhandenes Dokument hochladen, das den richtigen Lösungsbereich definiert, z. B. eine HR-Richtlinie oder ein Betriebshandbuch. Amazon Bedrock generiert dann eine Automated-Reasoning-Richtlinie und führt die Benutzer durch das Testen und Verfeinern dieser Richtlinie. Zur Validierung der generierten Inhalte anhand einer Automated-Reasoning-Richtlinie müssen Benutzer die Richtlinie im Integritätsschutz aktivieren und sie mit einer Liste von Automated-Reasoning-Richtlinien konfigurieren. Dieser auf Logik basierende algorithmische Überprüfungsprozess stellt sicher, dass die von einem Modell generierten Informationen mit bekannten Fakten übereinstimmen und nicht auf fabrizierten oder inkonsistenten Daten basieren. Diese Prüfungen liefern nachweislich wahrheitsgetreue Antworten von generativen KI-Modellen und ermöglichen es Softwareanbietern, die Zuverlässigkeit ihrer Anwendungen für Anwendungsfälle in den Bereichen Personal, Finanzen, Recht, Compliance und mehr zu verbessern. Sehen Sie sich die Video-Tutorials an, um mehr zu erfahren.

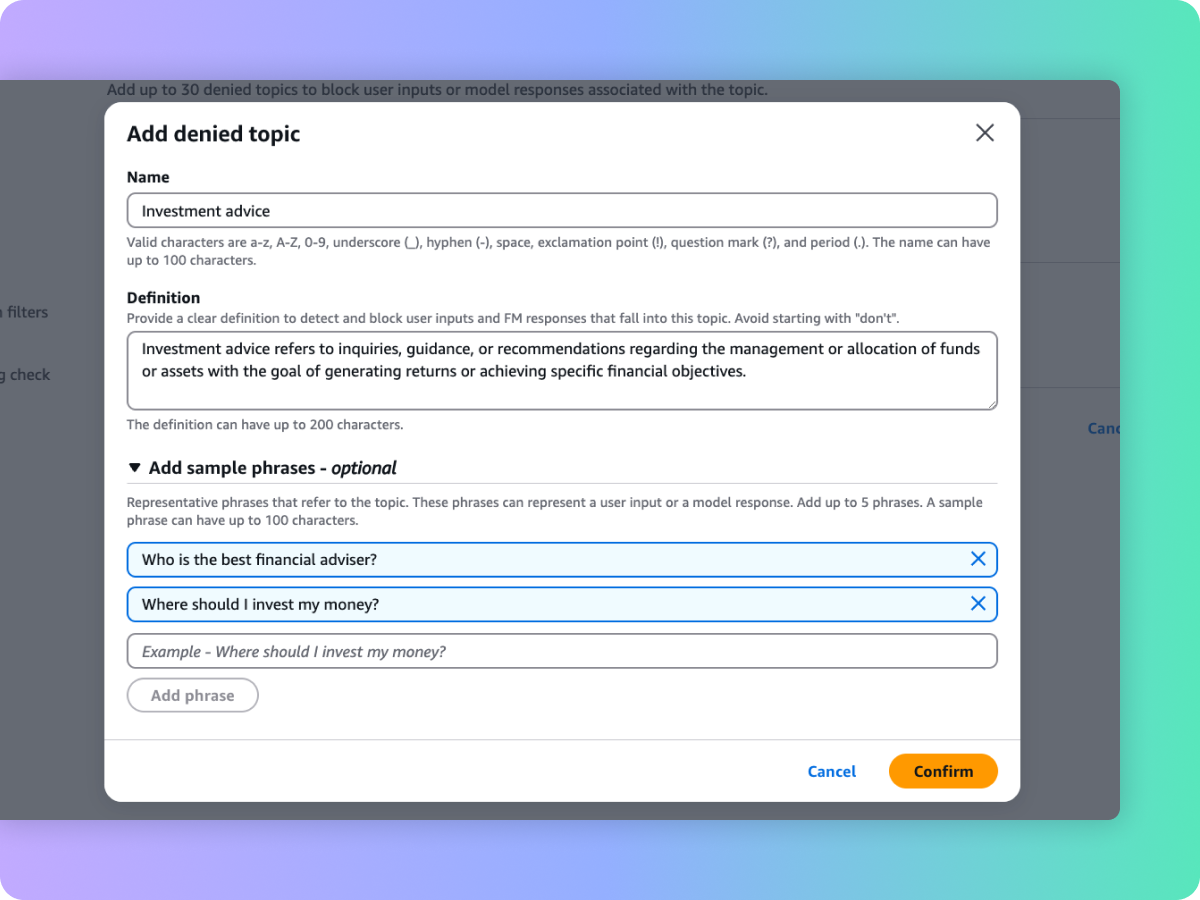

Unerwünschte Themen in generativen KI-Anwendungen blockieren

Unternehmensleitende erkennen die Notwendigkeit, Interaktionen innerhalb generativer KI-Anwendungen zu verwalten, um ein relevantes und sicheres Nutzererlebnis zu gewährleisten. Diese möchten die Interaktionen weiter anpassen, damit sie sich auf Themen konzentrieren, die für ihr Unternehmen relevant sind, und sich an den Unternehmensrichtlinien orientieren. Mithilfe einer kurzen Beschreibung in natürlicher Sprache hilft Ihnen der Integritätsschutz dabei, eine Reihe von Themen zu definieren, die im Kontext Ihrer Anwendung zu vermeiden sind. Integritätsschutz hilft bei der Erkennung und Blockierung von Benutzereingaben und FM-Antworten, die in die Kategorie der eingeschränkten Themen fallen. Beispielsweise kann ein Bankassistent so konzipiert werden, dass er Themen im Zusammenhang mit Anlageberatung vermeidet.

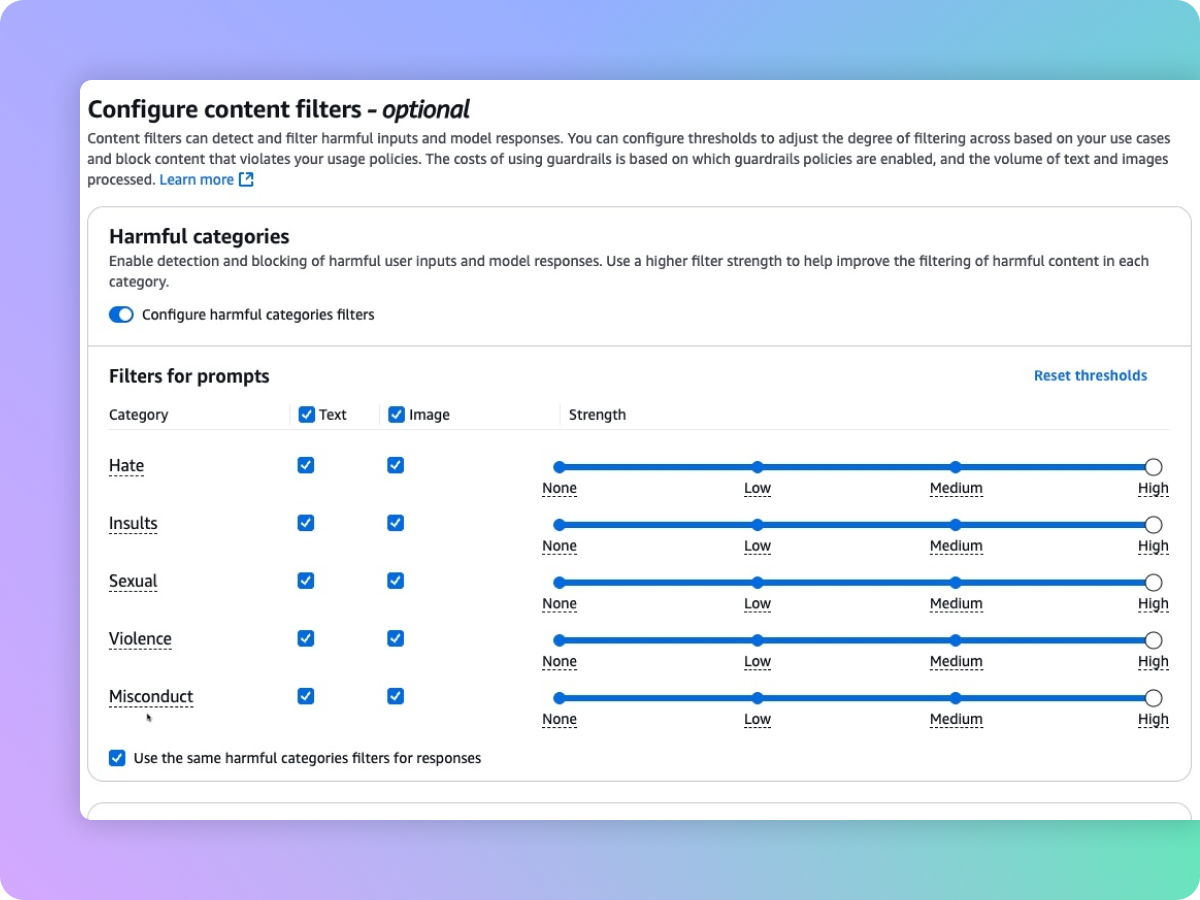

Filtern schädlicher multimodaler Inhalte auf der Grundlage Ihrer Richtlinien für verantwortungsvolle KI

Integritätsschutz bietet Inhaltsfilter mit konfigurierbaren Schwellenwerten für toxische Text- und Bildinhalte. Der Schutz hilft bei der Filterung schädlicher multimodaler Inhalte, die u. a. Hassreden, Beleidigungen, Sex, Gewalt und Fehlverhalten (einschließlich krimineller Aktivitäten) enthalten, und trägt zum Schutz vor Prompt-Angriffen bei (Promptinjektion und Jailbreak). Mithilfe von Inhaltsfiltern werden die Benutzereingaben und die Antworten des Modells automatisch ausgewertet, um unerwünschte und potenziell schädliche Texte und/oder Bilder zu erkennen und zu verhindern. Beispielsweise kann eine E-Commerce-Website ihren Online-Assistenten so gestalten, dass unangemessene Ausdrücke wie Hassreden oder Beleidigungen vermieden werden.

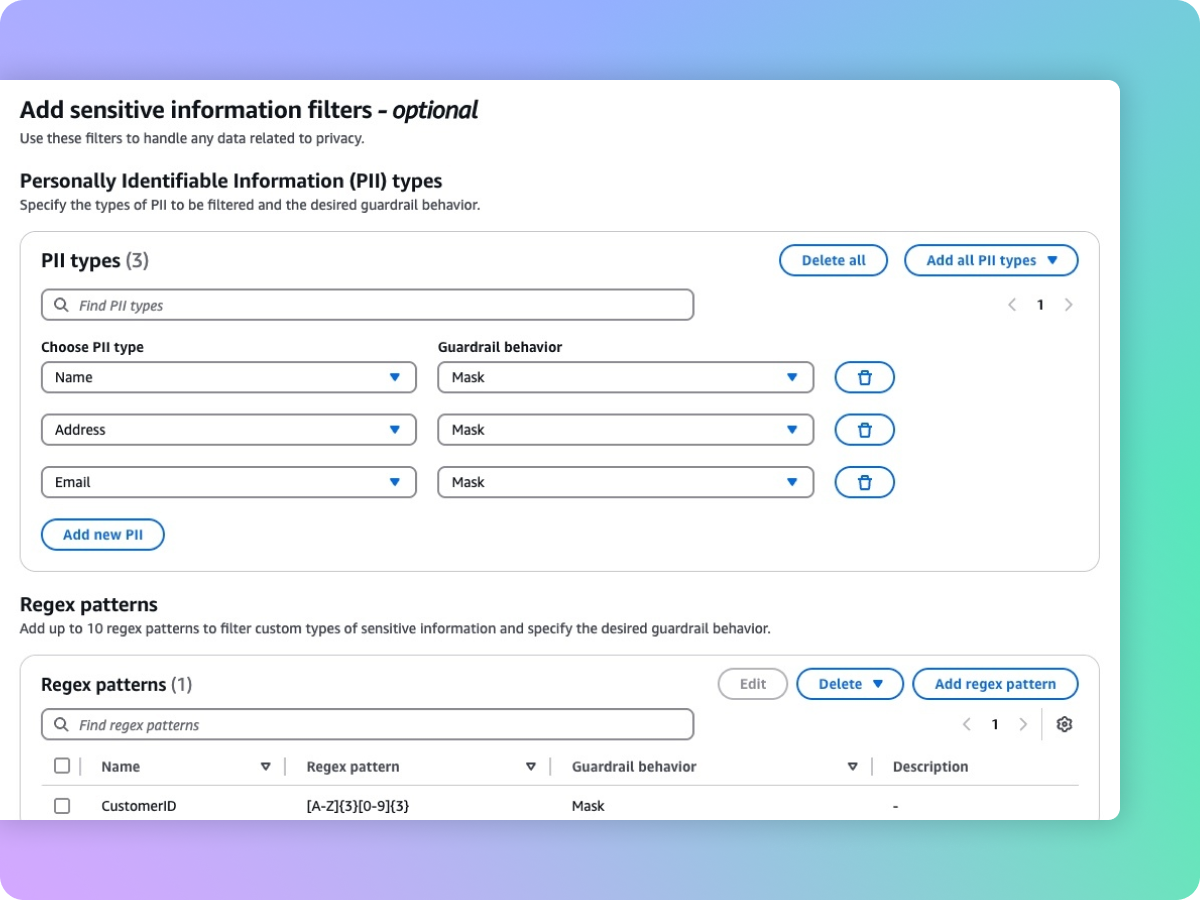

Vertrauliche Informationen wie PII zum Schutz der Privatsphäre schwärzen

Integritätsschutz hilft Ihnen dabei, vertrauliche Inhalte wie persönlich identifizierbare Informationen (PII) in Benutzereingaben und FM-Antworten zu erkennen. Sie können aus einer Liste vordefinierter PII auswählen oder mithilfe regulärer Ausdrücke (RegEx) einen benutzerdefinierten Typ vertraulicher Informationen definieren. Je nach Anwendungsfall können Sie Eingaben, die vertrauliche Informationen enthalten, selektiv ablehnen oder sie in FM-Antworten zensieren. So können Sie z. B. in einem Callcenter die persönlichen Daten der Benutzer bei der Erstellung von Zusammenfassungen aus Gesprächsprotokollen von Kunden und Kundendienstmitarbeitenden schwärzen.

Nächste Schritte

Haben Sie die gewünschten Informationen gefunden?

Ihr Feedback hilft uns, die Qualität der Inhalte auf unseren Seiten zu verbessern.