Amazon Web Services 한국 블로그

[기술 백서] Amazon EMR 마이그레이션 가이드

전 세계의 많은 비즈니스 영역에서 Apache Hadoop 및 Apache Spark 과 같은 새로운 빅 데이터 처리 및 분석 프레임워크를 도입을 시도해 왔으나 이러한 기술을 온프레미스 데이터 레이크 환경에서 운영하기 위해 해결해야 하는 과제들이 있습니다. 뿐만 아니라 현재 배포 공급업체와의 장기적인 문제도 고려가 필요합니다.

이러한 문제들을 다루기 위해 AWS는 Amazon EMR 마이그레이션 가이드 (2019년 6월에 초판 게시)를 만들어 게시했습니다. 이 가이드는 온프레미스 빅 데이터 배포를 EMR로 이동하는 방법을 계획에 필요한 기술 조언들이 담긴 포괄적인 설명서입니다.온프레미스 빅 데이터 환경에는 민첩성 결여, 과도한 비용 및 관리 부담과 같은 일반적인 문제들이 잠재해 있습니다.

IT 조직에서는 리소스를 프로비저닝하고, 균일하지 않은 대규모 워크로드를 처리하고, 빠른 속도로 변화하는 커뮤니티 기반 오픈소스 소프트웨어 혁신에 대한 정보를 숙지하는 동시에 이러한 문제를 해결해야 합니다. 기반 하드웨어 및 소프트웨어 인프라의 평가, 선택, 구매, 수신, 배포, 통합, 프로비저닝, 패치 적용, 유지 관리, 업데이트 및 지원으로 인한 작업 지연 및 부담 또한 빅 데이터 환경 운영에 적지않은 부정적인 영향을 미칩니다.

또 하나, 작지만 중요한 문제인 Apache Hadoop 및 Apache Spark의 데이터 센터 배포 방식은 컴퓨팅 리소스와 스토리지 리소스를 동일 서버에 배포하기 때문에 스케일링이 필요할때 경직된 구조를 갖게 됩니다. 즉, 워크로드에 따라 디스크 용량, 처리성능 및 시스템 메모리에 대한 요구사항이 다름에도 불구하고 경직된 구조로 인해 거의 모든 온프레미스 환경에서는 사용되지 않는 디스크 용량, 처리 성능 또는 시스템 메모리에 대해 과다한 비용을 지출하게 됩니다.

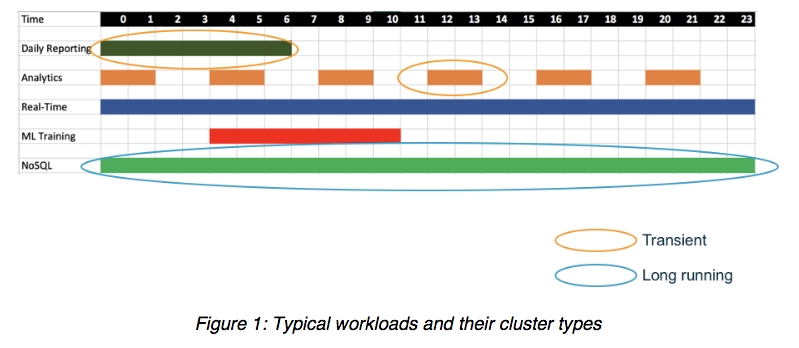

일반적인 워크로드는 다양한 빈도 및 시간으로 서로 다른 유형의 클러스터에서 실행됩니다. 이러한 빅 데이터 워크로드는 동일한 공유 기반 스토리지 또는 데이터 레이크에 액세스하면서 가장 효율적인 시간에 가장 효율적인 방법으로 실행될 수 있어야 합니다. 아래의 그림 1의 설명을 참조하십시오.

빅 데이터(및 기계학습)를 클라우드로 마이그레이션 하면 해 빅 데이터 환경의 성공적인 구현뿐만 아니라 스마트한 비즈니스를 위한 많은 장점을 얻을 수 있습니다. AWS와 같은 클라우드 인프라 서비스 공급자는 광범위한 온디맨드 및 탄력적 컴퓨팅 리소스와 복원력이 뛰어나고 경제적인 영구 스토리지뿐만 아니라 최신의 친숙한 빅 데이터 애플리케이션 개발 및 운영 환경에 대한 관리형 서비스를 제공합니다. 이를 통해 데이터 엔지니어, 개발자, 데이터 과학자 및 IT 직원들은 데이터를 준비하고 유용한 통찰력을 추출하는 데 집중할 수 있습니다.

Amazon EMR, AWS Glue 및 Amazon S3 같은 서비스를 사용하면 복원력이 뛰어난 관리형 통합 환경을 제공하므로 온프레미스 접근 방식의 많은 문제를 즉시 완화하면서도 컴퓨팅과 스토리지를 독립적으로 분리하고 확장할 수 있게 해줍니다. 이러한 서비스 접근 방식을 활용하면 빅 데이터 및 데이터 레이크 환경의 속도, 대응 능력, 사용 편의성 및 경제성을 개선할 수 있습니다.

또한, 기존 온프레미스에서의 Apache Hadoop 및 Apache Spark에 대한 일반적인 통념이 항상 클라우드 기반 배포에서 최상의 전략은 아닙니다. 클라우드에서 클러스터 노드를 실행하는 형태의 단순한 리프트앤시프트 접근 방식은 개념적으로는 간편하지만 실제로는 최적의 접근 방식은 아닙니다. 빅 데이터를 클라우드 아키텍처로 마이그레이션하면서 최대한의 이점을 얻으려면 많은 설계 의사 결정을 거쳐야 합니다.

이를 위해 가이드에는 다음에 대한 모범 사례를 제시합니다.

- 데이터, 애플리케이션 및 카탈로그 마이그레이션

- 영구 및 임시 리소스 사용

- 보안 정책, 액세스 제어 및 감사 로그 구성

- 비용 예측 및 절감과 가치 극대화

- AWS 클라우드를 HA(고가용성) 및 DR(재해 복구)에 활용

- 일반적인 관리 작업 자동화

이 가이드는 전문 서비스를 대체할 용도로 만들어진 것은 아니지만 빅 데이터 및 데이터 레이크 환경을 클라우드로 마이그레이션하는 것과 관련된 광범위한 일반적인 질문과 시나리오에 대해 다룹니다.

빅 데이터 플랫폼을 클라우드로 마이그레이션하는 여정을 시작할 때는 먼저 마이그레이션을 어떻게 접근할지를 결정해야 합니다. 한 가지 접근 방식은 플랫폼의 아키텍처를 변경하여 클라우드의 이점을 극대화하는 방식이고, 리프트앤시프트라고 하는 다른 접근 방식은 기존 아키텍처를 클라우드에 그대로 마이그레이션하는 방식입니다. 마지막 옵션은 하이브리드 접근 방식인데 이 접근 방식에서는 리프트앤시프트와 아키텍처 변경을 함께 사용합니다. 두 접근 방식에는 모두 장점과 단점이 있기 때문에 결정하기가 쉽지 않을 수 있습니다.

리프트앤시프트 접근 방식은 일반적으로 더 간단하고 불확실성과 위험이 적습니다. 또한 데이터 센터 임대가 만료되는 등 작업 기한이 촉박한 경우에는 이 접근 방식이 더 낫습니다. 그러나 리프트앤시프트의 단점은 경제적이지 않다는 것과 기존 아키텍처를 클라우드의 솔루션으로 바로 매핑하지 못할 수 있다는 것입니다.

아키텍처 변경 접근 방식에는 비용 최적화 및 효율성과 같은 많은 장점이 있습니다. 아키텍처를 변경할 경우 최신의 가장 우수한 소프트웨어로 전환할 수 있고, 기본 클라우드 도구와의 통합 기능이 개선되며, 기본 클라우드 제품 및 서비스를 활용하여 운영 부담을 줄일 수 있습니다.

가이드에는 Apache Spark 및 하둡 에코시스템의 관점에서 본 각 마이그레이션 접근 방식의 장점과 단점이 나와 있습니다. 자세한 내용을 확인하시려면 지금 Amazon EMR 마이그레이션 가이드를 다운로드하십시오.

워크플로에 적합한 접근 방식을 결정하는 데 도움이 되는 일반적인 리소스가 필요하다면 클라우드로의 마이그레이션을 수행하는 모범 사례가 개괄적으로 설명되어 있는 엔터프라이즈용 클라우드 모범 사례 ebook을 참조하십시오.

– Nikki Rouda, AWS 수석 제품 마케팅 담당 – 데이터레이크 및 빅데이터

Nikki 는 20년이 넘는 시간 동안 40개 이상의 국가에서 엔터프라이즈의 분석 및 IT 인프라 관련 솔루션을 개발하고 구현하는 일을 지원했습니다. Nikki 씨는 브라운대학교에서 지구 물리학 및 수학을 전공했으며 캠브리지대학교에서 MBA를 이수했습니다.