AWS 기술 블로그

하이퍼엑셀(HyperAccel), Amazon EC2 F2 Instance 기반 LPU로 고효율 LLM 추론 서비스 구축

Amazon EC2 F2 인스턴스는 AWS가 제공하는 FPGA(Field-Programmable Gate Array) 기반 컴퓨팅 인스턴스로, 고객이 하드웨어 가속이 필요한 워크로드를 클라우드 환경에서 유연하게 실행할 수 있도록 설계되었습니다. FPGA는 프로그래밍 가능한 하드웨어 칩으로, 특정 연산에 최적화된 맞춤형 로직을 구현할 수 있어 범용 프로세서 대비 높은 성능과 전력 효율을 제공합니다.

F2 인스턴스는 AMD Virtex UltraScale+ HBM VU47P FPGA를 탑재하고 있으며, 머신러닝 추론, 비디오 처리, 금융 분석, 유전체학(Genomics) 등 연산 집약적인 작업에 적합합니다. 특히 AWS는 FPGA Developer AMI(Amazon Machine Image)와 HDK(Hardware Development Kit)를 함께 제공해, 개발자가 FPGA 설계부터 배포까지 하나의 통합된 환경에서 수행할 수 있도록 지원합니다. 또한 AFI(Amazon FPGA Image) 형태로 FPGA 구성을 패키징하면, 필요할 때마다 동일한 하드웨어 환경을 즉시 재현할 수 있어 운영 효율성이 높습니다.

하이퍼엑셀은 이러한 F2 인스턴스의 특성을 활용해, 자사의 LPU(LLM Processing Unit) 아키텍처를 클라우드 환경으로 확장했습니다. 기존에는 물리 서버를 통해서만 제공되던 LPU 기반 LLM 추론 환경을 AWS 클라우드에 구현함으로써, 고객이 장비 제약 없이 온디맨드 방식으로 LPU의 성능을 체험하고 활용할 수 있는 기반을 마련했습니다.

본 사례는 하이퍼엑셀이 F2 인스턴스를 통해 어떻게 LPU 기반 추론 서비스를 구축했으며, 이를 통해 PoC 운영 효율성과 비용 구조를 어떻게 개선했는지를 소개합니다.

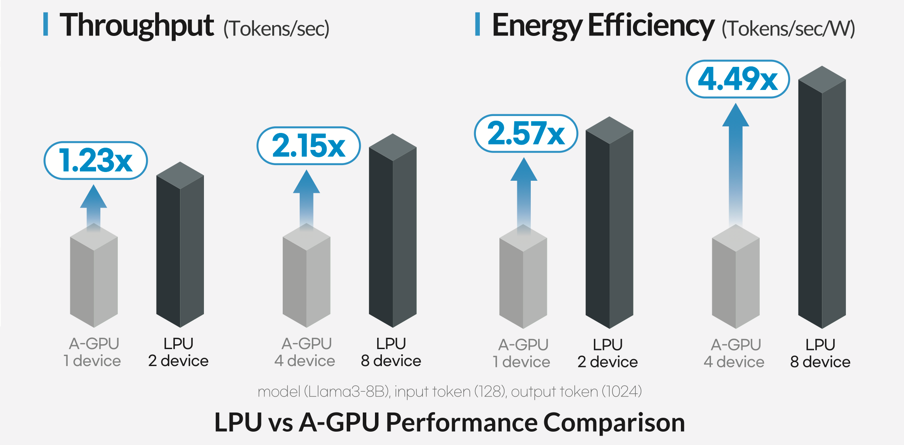

하이퍼엑셀(HyperAccel)은 LLM(Large Language Model)을 서비스에 도입하려는 기업들이 GPU 기반 인프라에서 겪는 높은 비용, 전력 소모, 확장성 한계를 해결하는 것을 목표로 LPU라는 새로운 프로세서를 개발하는 AI반도체 펩리스 스타트업입니다. LPU는 트랜스포머 기반 모델의 연산 특성에 맞춰 설계된 전용 아키텍처로, 경쟁력 있는 디바이스 비용으로 A100 GPU 대비 최대 2.15배 높은 추론 처리량, 최대 4.49배 높은 전력 효율을 제공합니다.

그림 1. LPU와 GPU의 LLM 추론 성능 비교

그림 1과 같이 기존 GPU대비 뛰어난 전력 효율성과 처리 성능을 통해, LPU는 LLM 추론 워크로드를 운영해야 하는 기업·기관이 운영 비용을 줄이면서도 더 빠른 응답 속도를 확보할 수 있도록 돕습니다.

LPU는 GPT, Llama, Qwen3 등 다양한 LLM을 지원하며, HyperAccel SDK를 통해 기존 추론 코드와 유사한 방식으로 쉽게 사용할 수 있습니다. 아래 예시는 실제 사용 코드로, generate 호출과 같이 HuggingFace 스타일의 친숙한 API 패턴을 유지하여 개발자가 쉽게 사용할 수 있도록 설계되어 있습니다.

from hyperdex.transformers import AutoModelForCausalLM

model = AutoModelForCausalLM.from_pretrained(

model_id=model_id,

device_map={"lpu": lpu_device}

)

output_ids = model.generate(

input_ids,

max_new_tokens=512,

# Sampling

do_sample=True,

top_p=0.7,

top_k=1,

temperature=1.0,

repetition_penalty=1.2

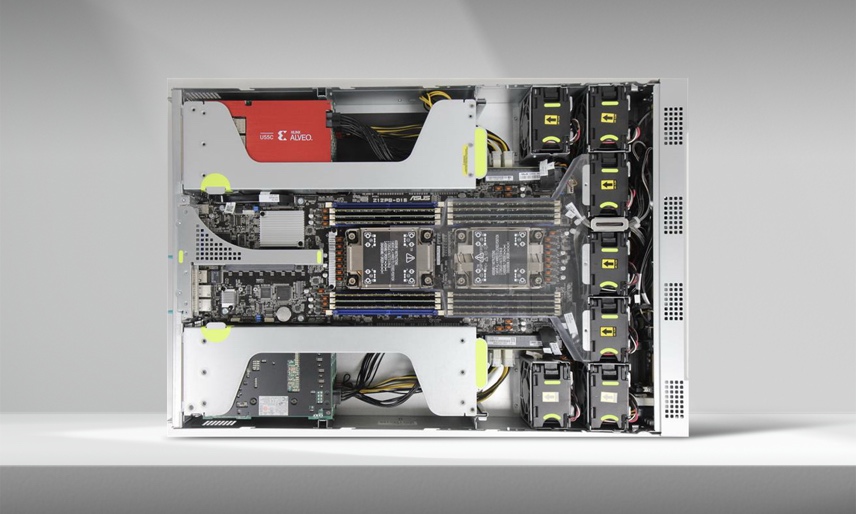

) 현재 하이퍼엑셀은 AMD U55C FPGA(Field-Programmable Gate Array) 기반 LPU를 탑재한 오리온(Orion) 서버를 제공하며, 실제 산업 현장에서 PoC(Proof of Concept)를 수행해 LPU의 성능과 효율성을 검증하고 있습니다.

그림 2. LPU를 탑재한 오리온 서버

AWS를 선택한 배경 및 목표

하이퍼엑셀은 그동안 고객이 LPU의 성능을 직접 경험할 수 있도록 여러 형태의 PoC 환경을 제공해 왔습니다. 그러나 하드웨어를 직접 테스트하는 방식이었기 때문에 물리 장비에 대한 의존도가 높았고 PoC 접근성이 낮다는 어려움이 있었습니다. 예를 들어 고객이 LPU를 사용하려면 LPU가 장착된 서버에 직접 접근해야 했고, 이를 위해 하이퍼엑셀에서 서버를 제공하거나 고객사 인프라에 LPU를 장착해야 했습니다. 이 과정은 확장성과 운영 효율 측면에서 개선이 필요했습니다.

기존 방식의 주요 어려움들은 다음과 같습니다.

- 반복되는 수작업과 인력 소모

PoC 요청이 늘어날수록 제한된 수량의 서버를 반복적으로 재사용하며 운영해야 했습니다. 사내 서버를 제공할 경우, 엔지니어가 서버 한 대를 준비할 때마다 OS 설치부터 최종 동작 확인까지 약 3시간이 소요되었습니다. 또한 서버마다 드라이버와 런타임 툴체인 버전이 달라 업데이트 시점마다 환경을 다시 맞춰야 했고, 이러한 수작업이 엔지니어 리소스를 지속적으로 잠식했습니다. - 외부 접속에 따른 보안·운영 부담

외부 고객을 위한 접속을 열어야 했기 때문에 내부망 노출 위험이 상존했습니다. 서버실 환경 변화에 따른 PoC 품질 영향 등 보안·운영 측면에서도 많은 리소스가 필요했습니다. - 복잡한 승인 절차로 인한 긴 대기 시간

고객이 PoC를 요청하면 담당 엔지니어 승인, 장비 할당, 환경 세팅 등 여러 단계를 순차적으로 거쳐야 했으며, 이 과정만으로도 평균 수일이 소요되었습니다. 그 결과, 고객이 LPU 환경에 실제로 접근하기까지 시간이 오래 걸리는 문제가 있었습니다. - 환경 불일치로 인한 일관성 저하

서버마다 업데이트 버전 차이가 있어 PoC 환경 간 설정이 달라지는 경우가 잦았습니다. 이로 인해 항상 동일한 조건에서 LPU 성능을 보여주기 어렵고, 최적의 사용 경험을 제공하는 데 제약이 있었습니다.

이러한 문제를 해소하기 위해 하이퍼엑셀은 LPU 서버를 필요할 때 즉시 사용할 수 있는 온디맨드 접근성과, 물리 서버 수량 및 내부망 접근 제약에서 벗어난 운영 환경을 구축하기 위해 클라우드로의 전환을 결정했습니다. 클라우드 전환을 통해 달성하고자 한 핵심 목표는 다음 두 가지입니다.

- 고객이 물리 장비 없이도 AWS 상의 서버를 통해 LPU 추론 성능을 바로 사용할 수 있는 환경 구성

- PoC 운영 과정에서 발생하는 복잡한 절차와 인적·컴퓨팅 리소스 낭비를 근본적으로 절감

F2 인스턴스 기반 LPU 구현 과정

하이퍼엑셀은 고객이 물리 장비 없이도 LPU 기반 추론을 바로 사용할 수 있는 환경을 제공하기 위해 Amazon EC2 F2 인스턴스를 선택했습니다. F2는 기존 오리온 서버에 사용된 AMD U55C FPGA와 유사한 구성을 갖추고 있으며, FPGA Developer AMI를 통해 설계·시뮬레이션·배포를 하나의 환경에서 빠르게 수행할 수 있다는 점이 큰 장점입니다.

- LPU 하드웨어 구현

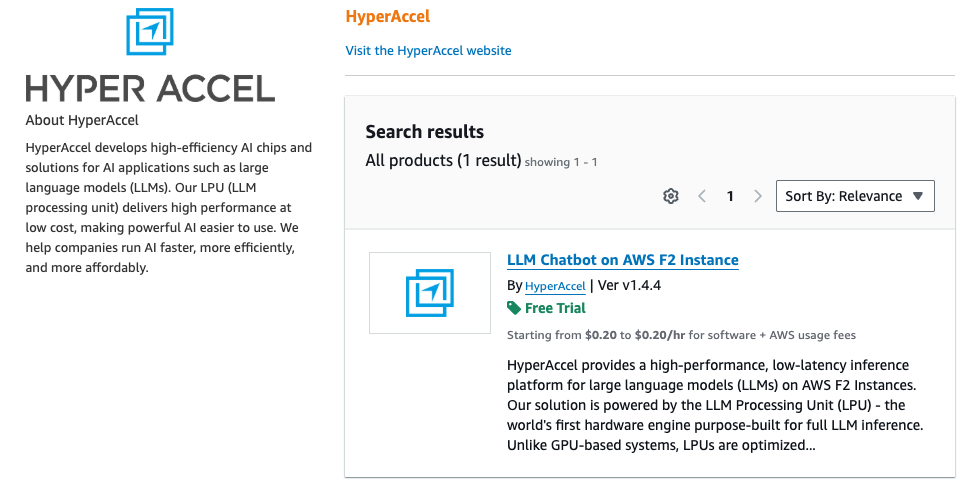

하이퍼엑셀은 FPGA Developer AMI의 Vivado 개발 환경과 AWS HDK를 활용해 그림 4처럼 LPU 아키텍처를 F2 인스턴스의 FPGA에 맞게 재구성했습니다. 이후 서버와 FPGA 간 인터페이스를 정의하고, 인스턴스 구동 시 즉시 로드할 수 있도록 AFI 형태로 패키징 해, 필요할 때마다 같은 이미지를 반복 사용 가능한 형태로 정리했습니다. 이 이미지는 AWS Marketplace에 등록되어 있습니다.

그림 3. AWS Marketplace에 등록된 HyperAccel AFI

그림 4. LPU 아키텍처

- 런타임 통합

AWS SDK(Software Development Kit)를 기반으로 FPGA에 접근 가능한 API 레벨 인터페이스를 구현한 뒤, 하이퍼엑셀의 런타임 툴체인인 HyperDex Toolchain과 이를 통합했습니다. 이를 통해 클라우드 상에서도 온프레미스와 동일한 방식으로 LPU를 제어할 수 있는 완전한 LPU 실행 환경을 구축했습니다. - 사용자 친화적 환경 제공

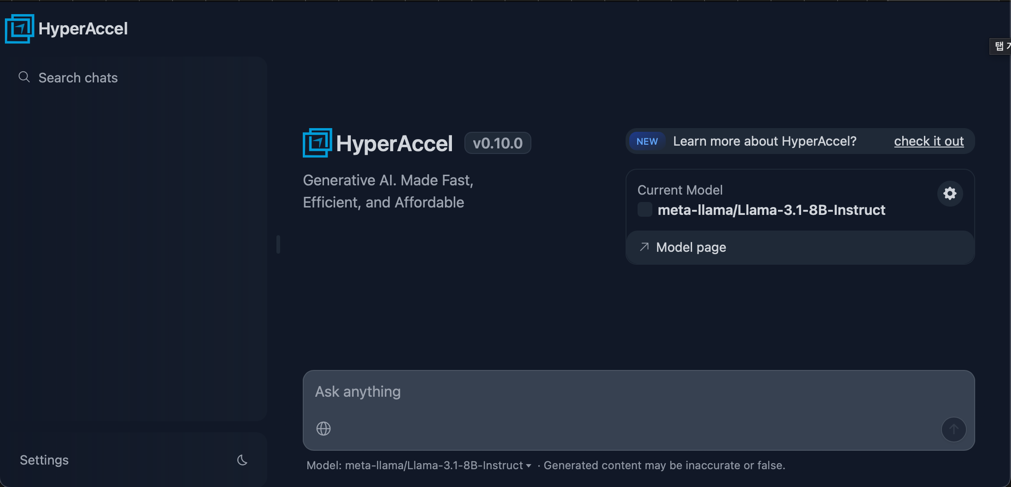

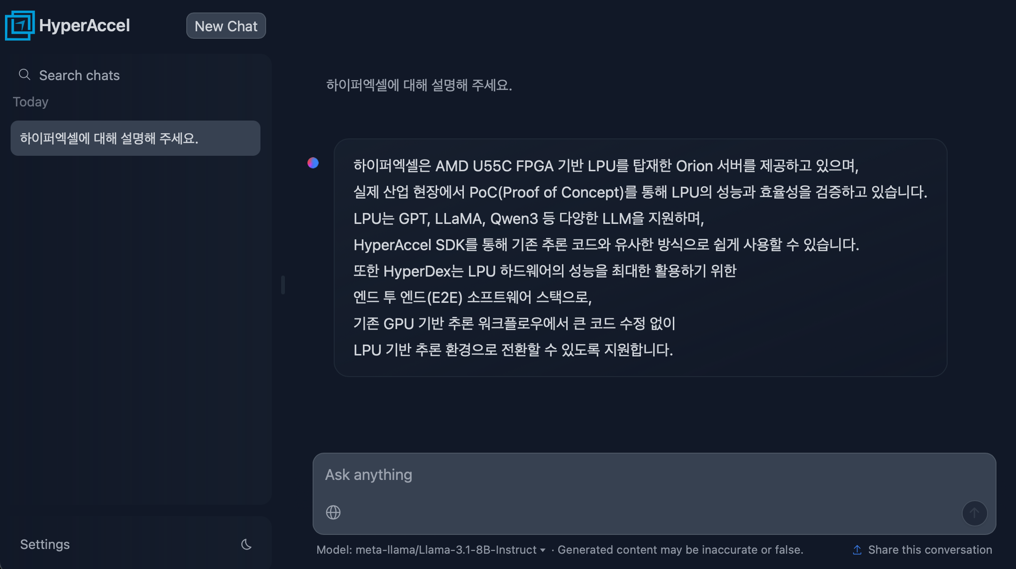

하이퍼엑셀은 고객이 별도의 초기 설정 없이 LPU를 직접 체험할 수 있도록 개발 환경을 하나의 AMI로 구성해 AWS Marketplace를 통해 제공합니다. AMI에는 Chat UI, vLLM 플러그인, Docker 실행 환경, HyperDex Toolchain이 사전 설치되어 있습니다. 사용자는 Marketplace에서 AMI를 선택해 EC2 인스턴스를 실행한 뒤, 백엔드(vLLM)와 프론트엔드(Chat UI)를 순서대로 구동하면 웹 기반 Chat UI를 통해 LPU의 추론 결과를 즉시 확인할 수 있습니다. Chat UI를 통해 터미널에 익숙하지 않은 사용자들도 웹 기반 인터페이스로 편리하게 모델을 설정하고, 실시간 스트리밍으로 출력 기능을 통해 직관적으로 LPU를 사용할 수 있습니다. 모든 구성 요소는 Marketplace를 통해 버전 일관성을 유지하면서 중앙에서 관리됩니다.

그림 5. Chat UI 초기 화면

그림 6. Chat UI 사용 예시 화면

결과

Amazon EC2 F2 인스턴스 기반의 LPU 시스템을 구축함으로써, 하이퍼엑셀은 온프레미스 기반 PoC 운영 과정에서 반복적으로 발생하던 물리 장비 제공, 환경 설정, 보안 관리, 운영 비용 부담을 근본적으로 해소했습니다. 이번 마이그레이션을 통해 하이퍼엑셀은 운영의 효율성과 사용자 경험을 동시에 개선했으며, 다음과 같은 구체적인 성과를 확인할 수 있었습니다.

- PoC 환경 구축 시간 대폭 단축 (약 90% 이상 절감)

기존 온프레미스 환경에서는 서버 한 대를 준비하기 위해 엔지니어가 OS 설치부터 드라이버 설정, 최종 동작 확인까지 평균 3시간이 소요되었습니다. 이를 AWS Marketplace 기반 AMI로 대체함으로써, 고객은 인스턴스 실행 후 약 15분 이내에 LPU 추론 환경을 바로 사용할 수 있게 되었고, PoC 준비에 소요되는 시간과 인적 리소스를 크게 줄일 수 있었습니다. - GPU 대비 실제 추론 비용 최대 70% 절감

EC2 H100 GPU 인스턴스(p5.4xlarge)의 시간당 비용이 약 6.88달러 수준인 반면, F2 인스턴스(f2.6xlarge)는 시간당 약 1.98달러로 고성능 추론 환경을 제공합니다. 이를 통해 하이퍼엑셀은 PoC 단계를 넘어 상용 LLM 추론 서비스 환경에서도 경쟁력 있는 비용 구조를 확보했습니다. - 보안성 및 운영 안정성 향상, 물리 장비 관리 제거

고객은 사내 내부망 접근이나 별도의 장비 배송 없이 AWS 환경에서 LPU 추론을 안전하게 체험할 수 있으며, 온프레미스 장비 장애나 구성 환경 차이로 인한 영향을 받지 않습니다. 클라우드 기반 AMI 환경을 통해 항상 동일한 조건의 LPU 실행 환경을 제공할 수 있었고, 보안과 운영 측면에서의 부담도 크게 완화되었습니다. 이러한 구조는 하이퍼엑셀이 PoC 단계를 넘어 글로벌 LPU-as-a-Service 모델로 확장할 수 있는 기반이 되었습니다. - 사용자 편의성 및 개발 생산성 향상

AMI 기반 환경을 통해 고객은 F2 인스턴스를 실행하는 즉시 LPU 기반 챗봇을 바로 사용하거나 자체 모델 서빙 환경을 손쉽게 구축할 수 있습니다. HyperDex Toolchain은 Hugging Face 스타일의 모델 실행 인터페이스를 제공해 기존 워크플로우와 자연스럽게 연동되며, vLLM 기반의 generate() API를 지원합니다. 또한 OpenAI API와 호환되는 completions(), chat.completions() 인터페이스를 함께 제공함으로써, 기존 추론 코드를 최소한의 수정만으로 LPU 환경에 재사용할 수 있도록 했습니다.

향후 계획

하이퍼엑셀은 AWS 클라우드의 확장성과 유연성을 바탕으로 F2 인스턴스 기반 LPU 환경을 지속적으로 고도화하고, 고객이 선택할 수 있는 모델과 기능의 폭을 점진적으로 확대해 나갈 계획입니다. 이를 통해 단순 PoC 환경을 넘어, 실제 서비스 운영이 가능한 LLM 추론 플랫폼으로 발전시키는 것을 목표로 하고 있습니다. 이를 위해 하이퍼엑셀은 다음 세 가지 기술 방향을 중심으로 로드맵을 수립했습니다.

- GPT-OSS 등 신규 LLM 지원 확대

최근 LLM 생태계는 빠르게 확장되며, 새로운 구조와 특성을 가진 모델들이 지속적으로 등장하고 있습니다. 기업과 서비스 제공자는 특정 모델에 종속되지 않고, 서비스 목적과 비용 구조에 따라 최적의 모델을 선택하길 원하고 있습니다. 하이퍼엑셀은 이러한 요구에 대응해 MoE(Mixture of Experts) 구조를 포함한 GPT-OSS 등 신규 LLM을 지원함으로써, 고객이 AWS F2 기반 LPU 환경에서 다양한 모델을 유연하게 활용할 수 있도록 할 계획입니다. - MXFP4 Quantization 기반 추론 성능 고도화

하이퍼엑셀은 LPU의 활용성을 더욱 높이기 위해 MXFP4 기반 양자화 기술을 개발 중입니다. 이를 통해 동일한 하드웨어 자원에서 더 큰 모델을 구동하거나 더 높은 추론 처리량을 확보할 수 있어, 비용 효율성을 더욱 높일 수 있을 것으로 기대합니다. 예를 들어, H100 기반 GPU 인스턴스(p5.4xlarge)가 시간당 약 6.88달러 수준인 반면, F2 인스턴스(f2.6xlarge)는 시간당 약 1.98달러 수준에서 LLM 추론이 가능해, 서비스 단위 운영에서 비용 효율성이 더욱 크게 향상될 것으로 기대하고 있습니다. - 다양한 서비스 실증 사례 도출

하이퍼엑셀은 단순 PoC 단계를 넘어, LPU-as-a-Service 형태로 실제 서비스 환경에 LPU 기반 추론을 적용하는 실증 사례를 지속적으로 확대해 나갈 계획입니다. 이를 통해 LPU 기반 추론 플랫폼이 실운영 환경에서도 서비스 안정성, 지연시간, 처리량 요구사항을 충족할 수 있음을 체계적으로 검증하고자 합니다. 또한, 다양한 산업·서비스 유형에서의 적용 결과를 레퍼런스로 축적함으로써, 고객이 운영 관점에서의 효과와 신뢰성을 명확히 확인하고 안심하고 도입할 수 있는 기반을 마련할 예정입니다.

하이퍼엑셀은 이러한 기술 로드맵과 AWS의 글로벌 클라우드 인프라를 결합해, LPU 기반 LLM 추론 환경을 실제 서비스 운영 수준까지 안정적으로 확장할 수 있도록 지속적으로 지원해 나갈 예정입니다.