亚马逊AWS官方博客

借助全新 Amazon EC2 P6-B300 实例加速大规模 AI 应用

今天,我们宣布 Amazon Elastic Compute Cloud(Amazon EC2)P6-B300 实例正式发布。这是我们新一代的 GPU 平台,采用 NVIDIA Blackwell Ultra GPU 加速。与上一代实例相比,这些实例的网络带宽提升了 2 倍,GPU 内存提升了 1.5 倍,为大规模 AI 应用打造了一个性能均衡的平台。

凭借这些改进,P6-B300 实例成为大规模 AI 模型训练与推理的理想选择,尤其适用于采用混合专家模型(MoE)、多模态处理等复杂技术的场景。对于需要处理万亿参数模型并在数千个 GPU 上进行分布式训练的组织而言,这些实例在计算、内存和网络能力方面实现了完美平衡。

与前代产品相比的改进之处

P6-B300 实例提供 6.4Tbps 的 Elastic Fabric Adapter(EFA)网络带宽,支持大型 GPU 集群之间的高效通信。这些实例配备 2.1TB 的 GPU 内存,允许大型模型驻留在单个 NVIDIA NVLink 域中,从而显著减少模型分片和通信开销。这些实例结合 EFA 网络以及 AWS Nitro System 的先进虚拟化和安全功能,可为 AI 工作负载提供前所未有的速度、规模和安全性。

EC2 P6-B300 实例的规格如下。

| 实例大小 | vCPU | 系统内存 | GPU | GPU 内存 | GPU 间互连 | EFA 网络带宽 | ENA 带宽 | EBS 带宽 | 本地存储 |

| P6-B300.48xlarge | 192 | 4TB | 8x B300 GPU | 2144GB HBM3e | 1800 GB/s | 6.4 Tbps | 300 Gbps | 100 Gbps | 8x 3.84TB |

注意事项

在持久化存储方面,AI 工作负载主要根据性价比方面的考虑,组合使用高性能持久化存储选项,包括适用于 Lustre 的 Amazon FSx、Amazon S3 Express One Zone 存储类和 Amazon Elastic Block Store(Amazon EBS)。例如,P6-B300 实例配备的专属 300Gbps 弹性网络适配器(ENA)网络,可实现与 S3 Express One Zone 存储类的高吞吐量热存储访问,支持大规模训练工作负载。如果您使用适用于 Lustre 的 FSx,现在可以将 EFA 与 NVIDIA GPUDirect Storage(GDS)结合使用,在 P6-B300 实例上实现高达 1.2Tbps 的 Lustre 文件系统吞吐量,从而快速加载您的模型。

现已推出

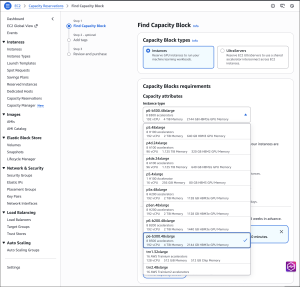

P6-B300 实例现已通过适用于 ML 的 Amazon EC2 容量块和节省计划在美国西部(俄勒冈州)AWS 区域提供。

如需按需预订 P6-B300 实例,请联系您的客户经理。和 Amazon EC2 一样,您只需为实际使用的资源付费。有关更多信息,请参阅 Amazon EC2 定价。查看完整的加速型计算实例系列,帮助您开始迁移应用程序。

要了解更多信息,请访问我们的 Amazon EC2 P6-B300 实例页面。请将反馈发送至 AWS re:Post for EC2 或通过您常用的 AWS Support 联系方式发送反馈。

– Veliswa

AWS 架构师中心: 云端创新的引领者探索 AWS 架构师中心,获取经实战验证的最佳实践与架构指南,助您高效构建安全、可靠的云上应用 |

|