Amazon Web Services ブログ

近日登場 – コンピューティング能力と GPU を増強した Snowball Edge

お客様のニーズに基づいたイノベーションが実現するのを目の当たりにする経験は、飽きることがありません。 AWS のお客様からペタバイト単位のデータを AWS に出し入れする簡単な方法が必要だという要望をいただいたとき、私たちは AWS Snowball でお応えしました。その後、AWS にデバイスを送信してデータを戻す前に (多くの場合、オフラインで) ローカルデータ処理やフィルタリングを行いたいという要望をお客様からいただいたときは、AWS Lambda 関数を使用してローカル処理を行える AWS Snowball Edge を提供しました。今年の始めには、EC2 コンピューティングインスタンスのサポートを追加し、デバイスごとに最大 10 個の AMI を事前ロードできるサイズと機能を備えた 6 つのインスタンスが利用可能になりました。

素晴らしい進歩ですが、これで終わりではありません!

コンピューティング能力と GPU の増強

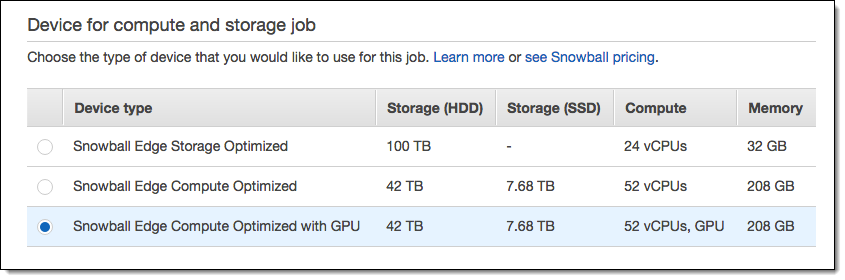

嬉しいことに、私たちは 2 つの新しい Snowball Edge オプションを提供する準備ができています。それは、Snowball Edge Compute Optimized と Snowball Edge Compute Optimized with GPU です (元の Snowball Edge は、Snowball Edge Storage Optimized という名称になりました)。どちらのオプションにも、42 TB の S3 対応ストレージと 7.68 TB の NVMe SSD ストレージが含まれており、最大 52 個のvCPU と 208 GiB のメモリを消費するインスタンスを任意の組み合わせで実行できます。追加された処理能力により、エッジでさらに多くのタイプの処理を行うことができます。

インスタンスの仕様は次のとおりです。

| インスタンス名 | vCPUs | メモリ |

| sbe-c.small / sbe-g.small

|

1 | 2 GiB |

| sbe-c.medium / sbe-g.medium

|

1 | 4 GiB |

| sbe-c.large / sbe-g.large

|

2 | 8 GiB |

| sbe-c.xlarge / sbe-g.xlarge

|

4 | 16 GiB |

| sbe-c.2xlarge / sbe-g.2xlarge

|

8 | 32 GiB |

| sbe-c.4xlarge / sbe-g.4xlarge

|

16 | 64 GiB |

| sbe-c.8xlarge / sbe-g.8xlarge

|

32 | 128 GiB |

| sbe-c.12xlarge / sbe-g.12xlarge

|

48 | 192 GiB |

Snowball Edge Compute Optimized with GPU は、リアルタイムのフルモーション動画の解析と処理、機械学習の推論などの高度に並列化された計算集約処理に使用できるオンボード GPU を備えています。GPU にアクセスするには、sbe-g インスタンスを起動します。

これまでと同様に、コンソールを使用して必要なオプションを選択できます。

Compute Optimized デバイスは、Storage Optimized デバイスよりほんの少し大きいだけです。下の写真では、それらを Amazon のドアデスクに並べて置いています。

ご期待下さい!

さらに多くの情報をまもなくお伝えする予定です。お楽しみに!

— Jeff;