- 機械学習›

- Amazon SageMaker AI›

- Amazon SageMaker AI MLOps

MLOps 用 Amazon SageMaker

高性能の本番 ML モデルを迅速かつ大規模に提供

Amazon SageMaker MLOps を利用すべき理由

仕組み

SageMaker MLOps の利点

モデル開発を加速させる

標準化されたデータサイエンス環境をプロビジョニング

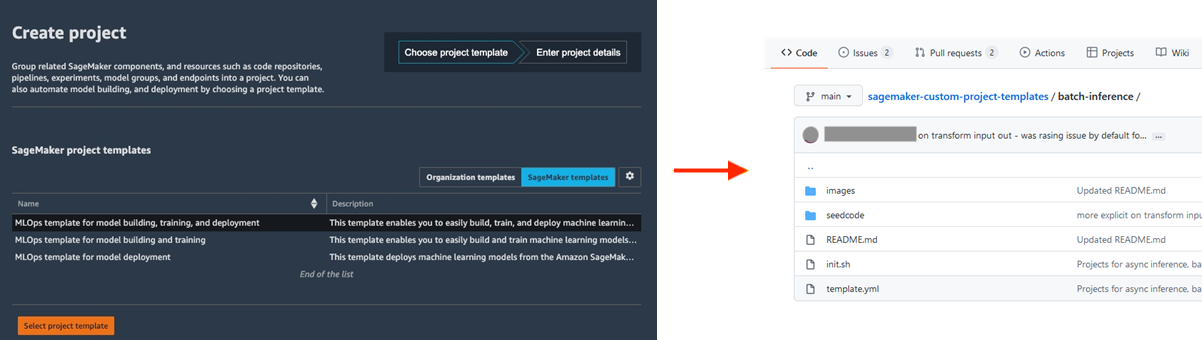

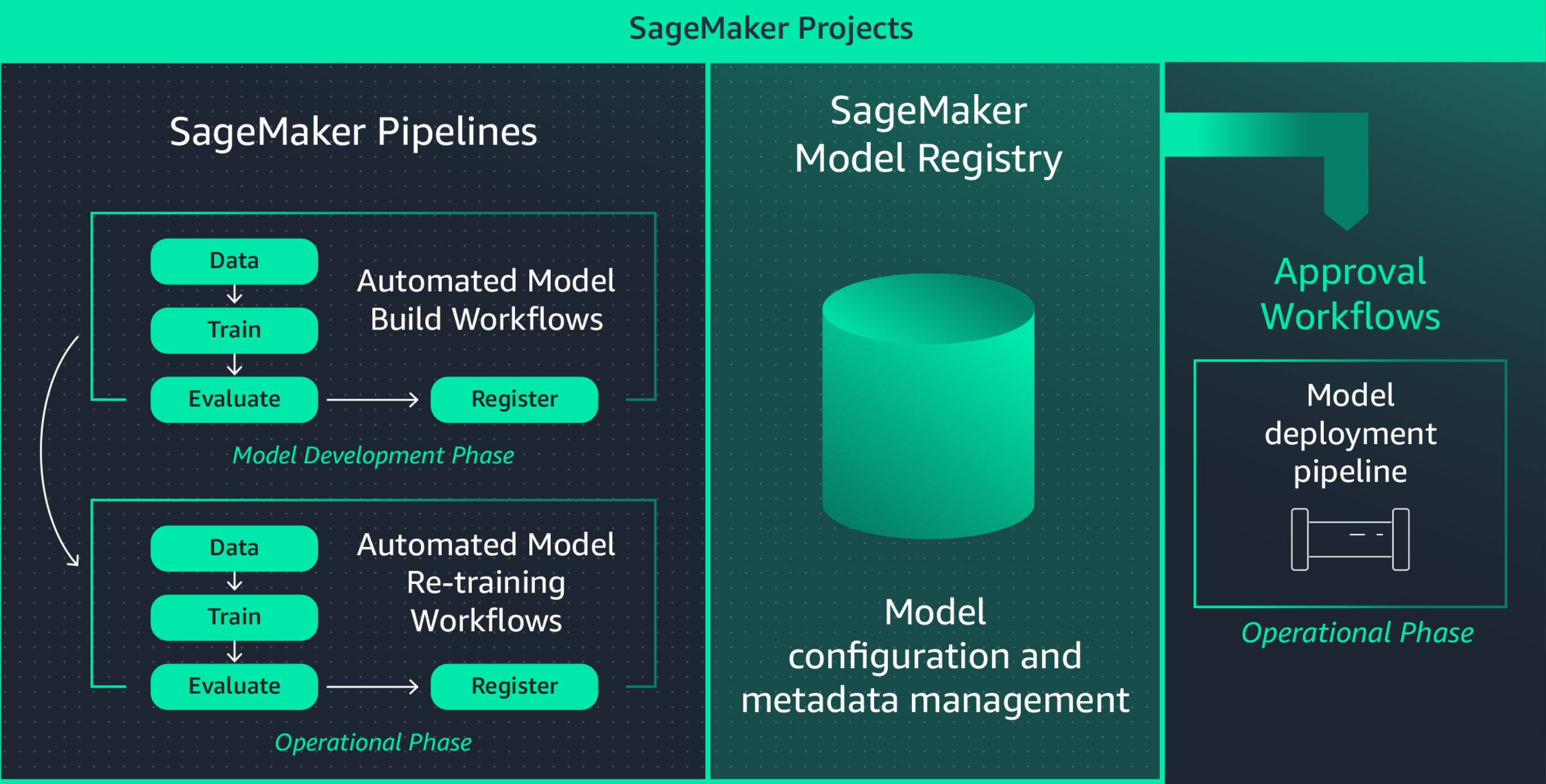

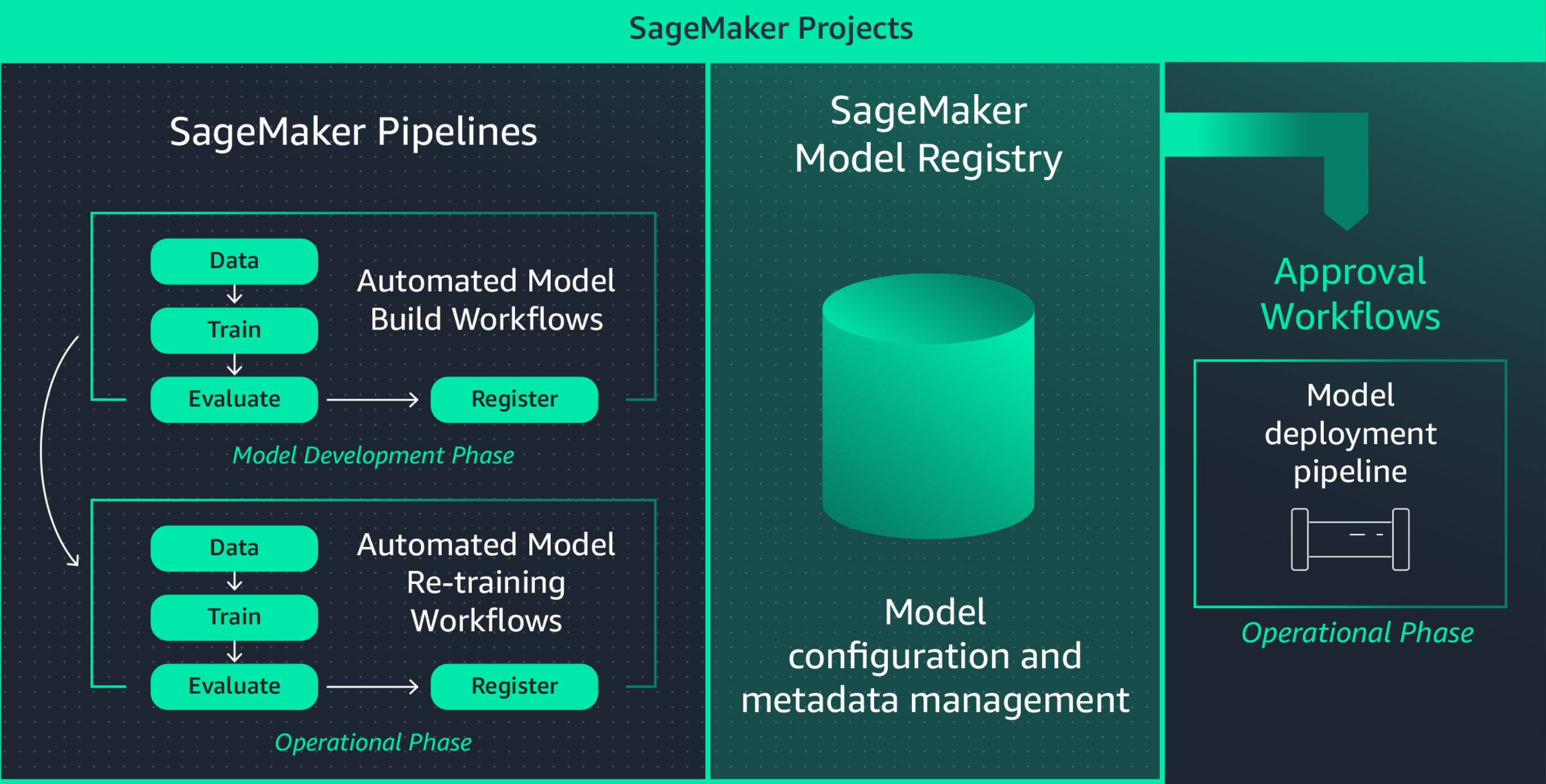

ML 開発環境を標準化すると、新しいプロジェクトの立ち上げ、プロジェクト間でのデータサイエンティストのローテーション、ML のベストプラクティスの実装が容易になるため、データサイエンティストの生産性が向上し、最終的にはイノベーションのペースが向上します。Amazon SageMaker Projects は、十分にテストされた最新のツールとライブラリ、ソース管理リポジトリ、ボイラープレートコード、および CI/CD パイプラインを使用して、標準化されたデータサイエンティスト環境を迅速にプロビジョニングするためのテンプレートを提供します。

機械学習の実験中に MLflow を使用して共同作業を行う

ML モデル構築は反復的なプロセスです。何百ものモデルをトレーニングして、最適なモデル精度を実現するために最適なアルゴリズム、アーキテクチャ、パラメータを見つける必要があります。MLflow を使用すると、トレーニングのイテレーション全体の入力と出力を追跡できるため、試験の再現性が向上し、データサイエンティスト間のコラボレーションが促進されます。フルマネージドの MLflow 機能を使用すると、各チームの MLflow 追跡サーバーを作成できるため、ML 実験中にコラボレーションを効率的に行えます。

Amazon SageMaker と MLflow を併用すると、機械学習ライフサイクルをエンドツーエンドで管理し、モデルトレーニングと実験の追跡を効率的に行い、さまざまなフレームワークや環境での再現性を高められます。進行中のトレーニングジョブを視覚化し、同僚と実験を共有し、実験から直接モデルを登録できる単一のインターフェイスとなります。

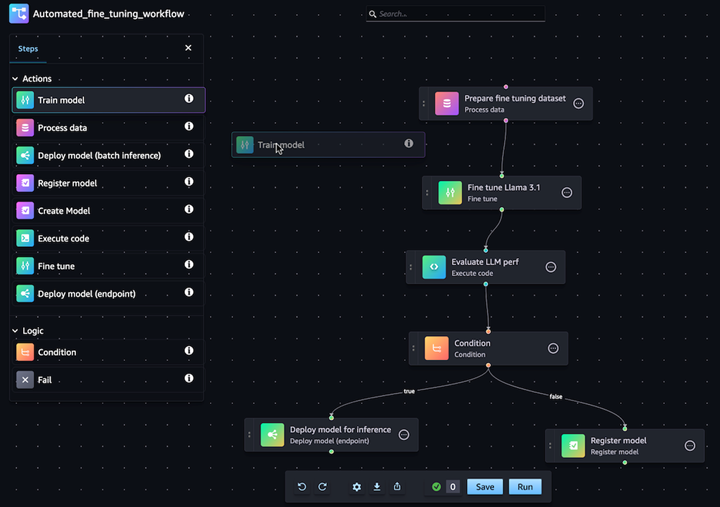

生成 AI モデルのカスタマイズワークフローを自動化

Amazon SageMaker Pipelines を利用すると、データ処理、モデルトレーニング、微調整、評価、およびデプロイのエンドツーエンドの ML ワークフローを自動化できます。Pipelines ビジュアルエディタで数回クリックするだけで、独自のモデルを構築したり、SageMaker Jumpstart から基盤モデルをカスタマイズしたりできます。定期的に、または特定のイベント (S3 の新しいトレーニングデータなど) がトリガーされたときに自動的に実行するように、SageMaker Pipelines を設定できます。

本番でモデルを容易にデプロイおよび管理

トラブルシューティングのためにモデルを迅速に再現

多くの場合、モデルの動作をトラブルシューティングし、根本原因を特定するために、実稼働環境でのモデルの再現が必要になります。これを支援するため、Amazon SageMaker はワークフローのすべてのステップをログに記録し、トレーニングデータ、構成設定、モデルパラメータ、学習勾配などのモデルアーティファクトの監査証跡を作成します。リネージトラッキングを使用すると、モデルを再作成して潜在的な問題をデバッグできます。

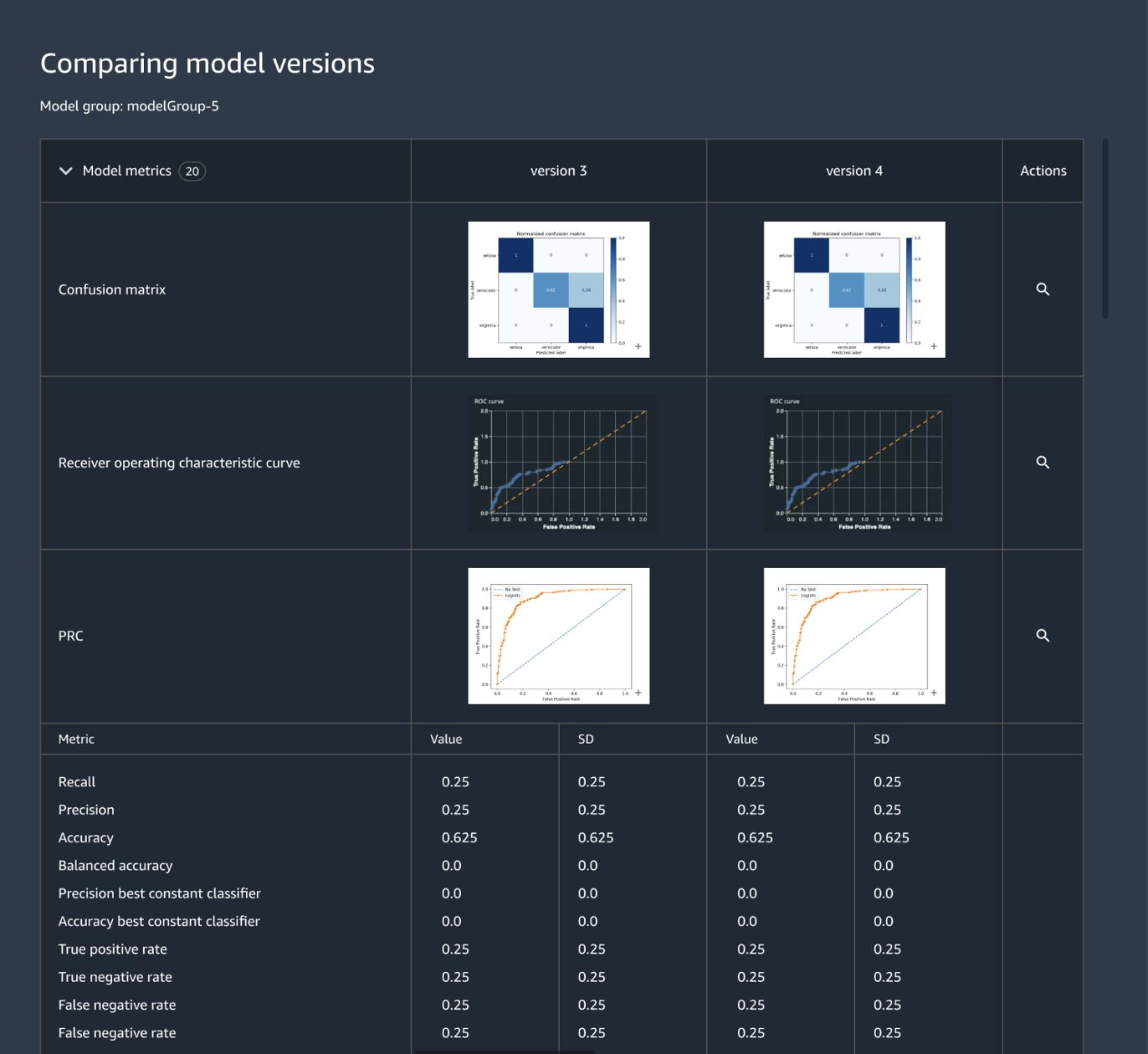

モデルのバージョンを一元的に追跡および管理

ML アプリケーションの構築には、モデル、データ パイプライン、トレーニングパイプライン、および検証テストの開発が含まれます。Amazon SageMaker Model Registry を使用すると、モデルのバージョン、ユースケースのグループ化などのメタデータ、モデルのパフォーマンスメトリクスベースラインを中央リポジトリで追跡でき、ビジネス要件に基づいてデプロイに適したモデルを容易に選択することができます。さらに、SageMaker Model Registry は、監査とコンプライアンスのための承認ワークフローを自動的に記録することができます。

コードで機械学習インフラストラクチャを定義

一般に「infrastructure-as-code」と呼ばれる、宣言型構成ファイルによるインフラストラクチャのオーケストレーションは、ML インフラストラクチャをプロビジョニングし、CI/CD パイプラインまたはデプロイツールで指定されたとおりにソリューションアーキテクチャを実装するための一般的なアプローチです。Amazon SageMaker Projects を使用すると、事前に構築されたテンプレートファイルを使用して「infrastructure-as-code」を作成できます。

統合とデプロイ (CI/CD) ワークフローを自動化

ML 開発ワークフローは、統合およびデプロイのワークフローと統合して、本番アプリケーション用の新しいモデルを迅速に提供する必要があります。Amazon SageMaker Projects は、開発環境と本番環境の間のパリティの維持、ソースとバージョンの管理、A/B テスト、エンドツーエンドの自動化など、CI/CD プラクティスを ML にもたらします。その結果、モデルが承認されるとすぐに実稼働に移行でき、俊敏性が向上します。

さらに、Amazon SageMaker は、エンドポイントの可用性を維持し、デプロイのリスクを最小限に抑えるのに役立つ組み込みのセーフガードも提供します。SageMaker は、ブルー/グリーンデプロイなどのデプロイのベストプラクティスのセットアップとオーケストレーションを処理して可用性を最大化し、それらを自動ロールバックメカニズムなどのエンドポイント更新メカニズムと統合して、問題を早期に自動的に特定し、本番に大きな影響が生じる前に是正措置を講じるのを支援します。

モデルを継続的に再トレーニングして予測品質を維持

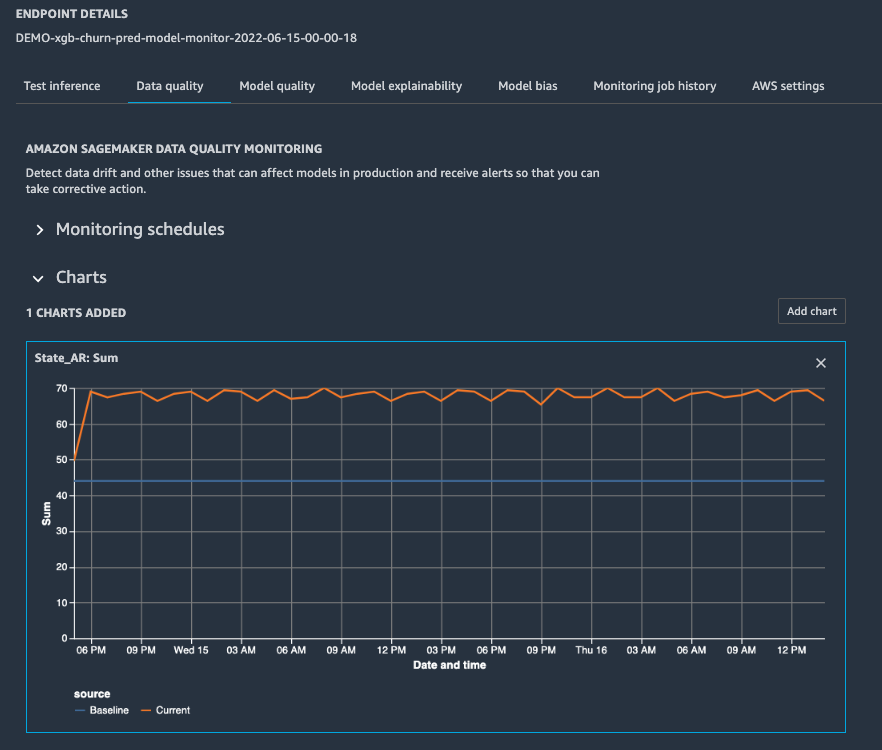

モデルが本番環境に入ると、オンコールのデータサイエンティストが問題をトラブルシューティングして再トレーニングをトリガーできるように、アラートを構成してパフォーマンスを監視する必要があります。Amazon SageMaker Model Monitor は、モデルのドリフトとコンセプトのドリフトをリアルタイムで検出し、アラートを送信することで品質を維持するのに役立ちます。これにより、すぐにアクションを実行できます。SageMaker Model Monitor は、予測の総数と比較して正しい予測の数を測定する精度など、モデルのパフォーマンス特性を常に監視しているため、異常に対処できます。SageMaker Model Monitor は SageMaker Clarify と統合されており、潜在的なバイアスの可視性を向上させます。

パフォーマンスとコストのためにモデルのデプロイを最適化

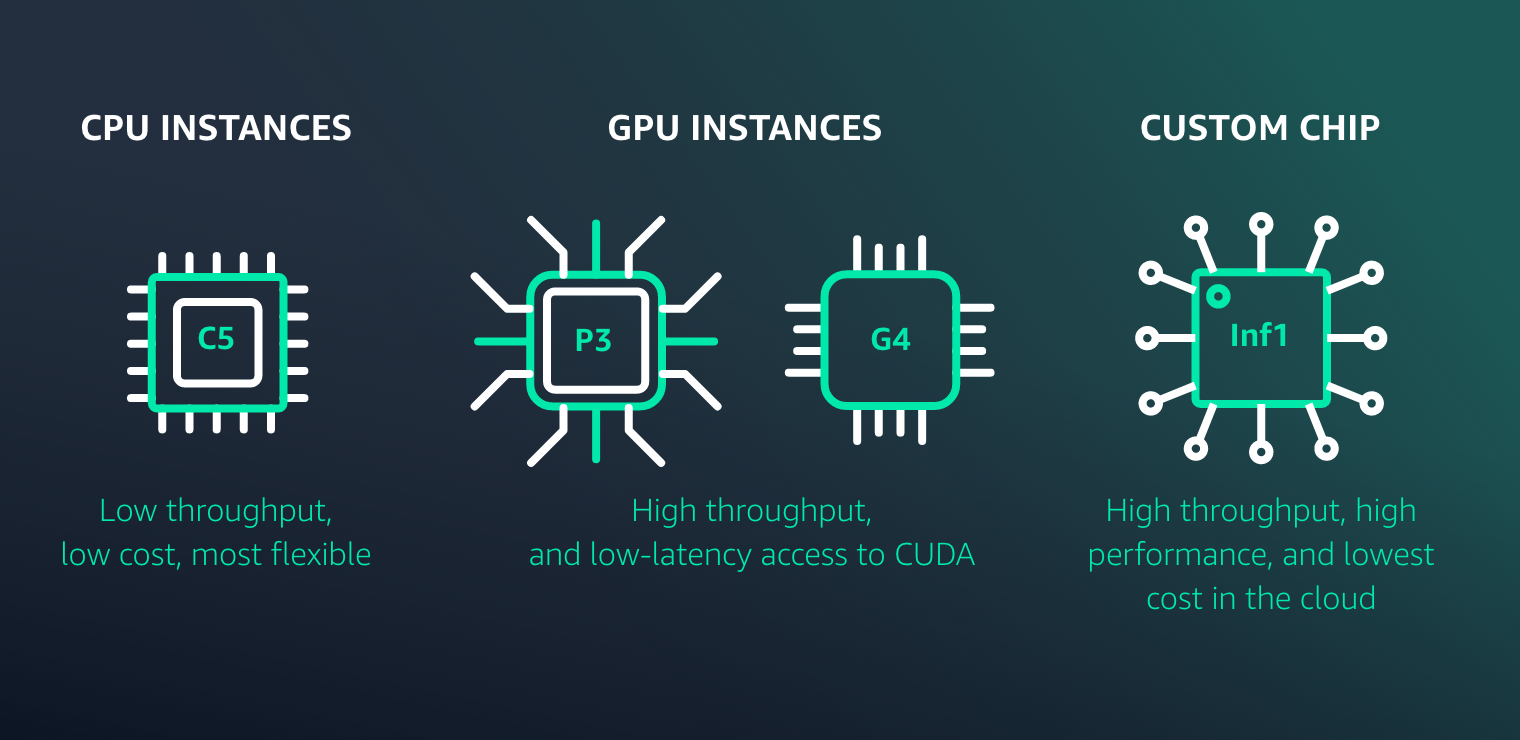

Amazon SageMaker を使用すると、あらゆるユースケースで高性能かつ低コストで推論用の ML モデルを簡単にデプロイできます。幅広い機械学習インフラストラクチャとモデルデプロイオプションを提供し、あらゆる機械学習推論のニーズを満たすことができます。

最新情報

Launch Amazon SageMaker Autopilot experiments from Amazon SageMaker Pipelines to easily automate MLOps workflows

2022 年 11 月 30 日

Amazon SageMaker Pipelines now supports the testing of machine learning workflows in your local environment

2022 年 8 月 17 日

Amazon SageMaker Pipelines now supports sharing of pipeline entities across accounts

2022 年 8 月 9 日

MLOps Workload Orchestrator adds support for Amazon SageMaker Model Explainability and Model Bias Monitoring

2022 年 2 月 2 日