Amazon SageMaker を選ぶ理由は何ですか?

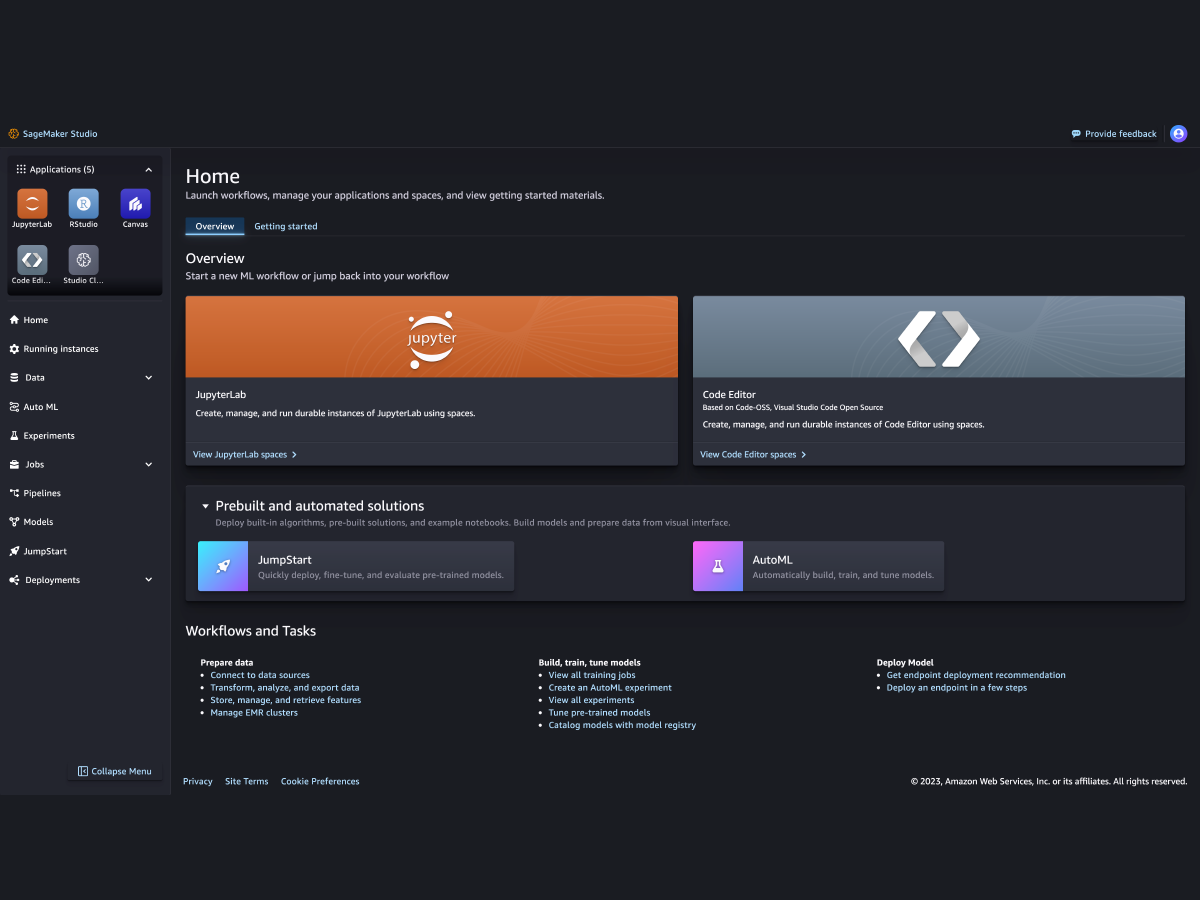

Amazon SageMaker は、あらゆるユースケースで高性能で低コストの機械学習 (ML) を実現する幅広いツールを統合した完全マネージド型サービスです。SageMaker では、ノートブック、デバッガー、プロファイラー、パイプライン、MLOps などのツールを使用して、ML モデルを大規模に構築、トレーニング、デプロイできます。しかも、すべてを 1 つの統合開発環境 (IDE) で行えます。SageMaker は、アクセス制御の簡素化と ML プロジェクトの透明性により、ガバナンス要件をサポートします。さらに、FM の微調整、実験、再トレーニング、デプロイを行うための専用ツールを使用して、独自の FM、つまり膨大なデータセットでトレーニングされた大規模モデルを構築できます。 SageMaker では、公開されている FM を含む何百もの事前トレーニング済みモデルにアクセスでき、数回クリックするだけでデプロイできます。

Amazon SageMaker を選ぶ理由は何ですか?

Amazon SageMaker は、あらゆるユースケースで高性能で低コストの機械学習 (ML) を実現する幅広いツールを統合した完全マネージド型サービスです。SageMaker では、ノートブック、デバッガー、プロファイラー、パイプライン、MLOps などのツールを使用して、ML モデルを大規模に構築、トレーニング、デプロイできます。しかも、すべてを 1 つの統合開発環境 (IDE) で行えます。SageMaker は、アクセス制御の簡素化と ML プロジェクトの透明性により、ガバナンス要件をサポートします。さらに、FM の微調整、実験、再トレーニング、デプロイを行うための専用ツールを使用して、独自の FM、つまり膨大なデータセットでトレーニングされた大規模モデルを構築できます。 SageMaker では、公開されている FM を含む何百もの事前トレーニング済みモデルにアクセスでき、数回クリックするだけでデプロイできます。

SageMaker のメリット

より多くの人が機械学習でイノベーションが可能に

-

ビジネスアナリスト

-

データサイエンティスト

-

機械学習エンジニア

-

ビジネスアナリスト

-

-

データサイエンティスト

-

-

機械学習エンジニア

-

主要な ML フレームワーク、ツールキット、プログラミング言語への対応