AWS 기술 블로그

LG유플러스, Bedrock AgentCore를 활용한 손쉬운 클라우드 Agent 구현 사례

UCMP 소개

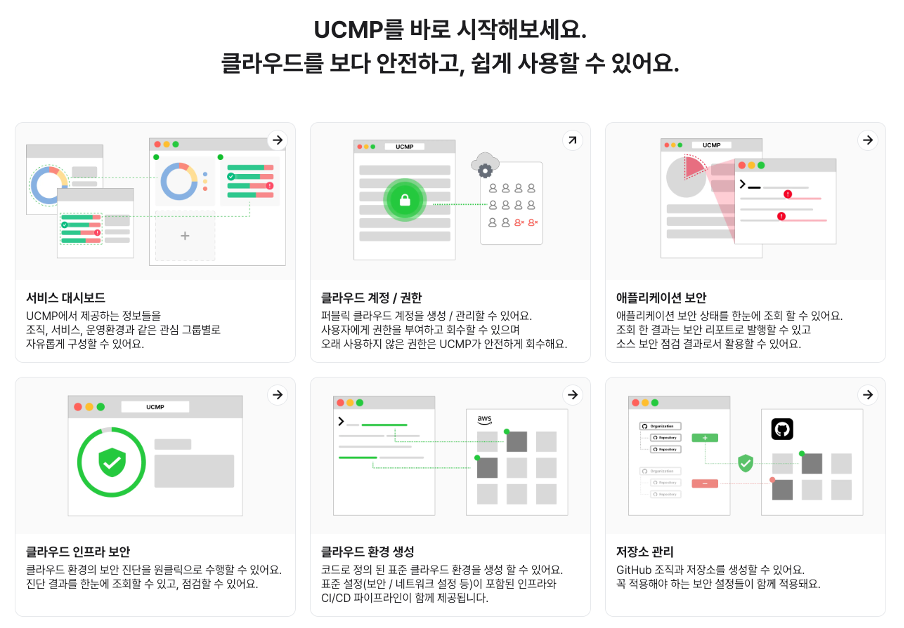

오늘날 대부분의 기업들은 AWS, GCP, Azure 등 다양한 클라우드 환경을 활용해 서비스를 개발하고 있습니다. 하지만 클라우드 사업자마다 계정 구조와 운영 정책이 달라 사용자 입장에서는 환경마다 서로 다른 방식으로 관리해야 하는 불편함이 있습니다. 이러한 문제를 해결하고 일관된 사용자 경험으로 클라우드를 운영할 수 있도록 LG유플러스는 자체 클라우드 관리 플랫폼 UCMP(Uplus Cloud Management Platform)를 구축해 멀티 클라우드 환경을 통합 관리하고 있습니다.

UCMP를 통해 사용자들은 분산된 클라우드 정보를 한곳에서 확인할 수 있게 되었고 최근에는 빠른 의사결정과 운영 효율화를 지원하기 위해 다양한 AI 활용 방안을 검토하였습니다. 이 과정에서 수백 개의 AWS 계정을 관리하는 UCMP 환경에서는 다수의 사용자가 동시에 접근하더라도 안정적으로 확장 가능한 Agent 인프라가 필수적이었습니다.

이번 글에서는 LG유플러스가 이러한 조건을 고려해 AWS Bedrock AgentCore Runtime을 선택한 이유와 이를 기반으로 Agent를 빠르고 안전하게 개발·배포한 과정을 소개합니다.

왜 클라우드 관리에 AI Agent를 도입했을까?

UCMP는 최적의 클라우드 환경을 유지하기 위해 다양한 클라우드 데이터를 한눈에 확인할 수 있는 기능들을 제공하고 있지만 모든 세부 항목을 담기에는 한계가 있었습니다. 일부 정보는 여전히 계정별 콘솔에 로그인해 확인해야 했고 사용자들은 이 과정에서 불편함을 느끼곤 했습니다.

이러한 한계를 해소하기 위해 LG유플러스는 AI Agent를 도입해 UCMP를 ‘필요한 정보를 스스로 제공하는 플랫폼’으로 발전시키고 있습니다. UCMP Agent는 단순한 질의응답을 넘어 실제 클라우드 데이터를 수집하고 분석해 의미 있는 정보를 제공할 수 있습니다. 이를 통해 개발자, 운영자, 사업 담당자 모두가 UCMP 내에서 필요한 내용을 쉽게 확인할 수 있게 되었습니다.

왜 AgentCore Runtime을 선택했는가?

AI Agent를 프로덕션 환경에 배포하는 것은 생각보다 복잡한 과제입니다. Agent는 일반적인 API 서버와 달리 사용자별로 독립된 대화 세션을 유지해야 하고 LLM 호출과 외부 도구 실행을 반복하는 복잡한 워크플로우를 처리해야 합니다. 특히 LG유플러스처럼 대규모 세션 처리가 예상되는 환경에서는 탄력적인 인프라 선택이 더욱 중요합니다.

기존 배포 옵션의 한계

AWS Lambda는 서버리스 환경으로 관리 부담이 적지만, 15분의 실행 시간 제한이 있습니다. 복잡한 클라우드 분석 작업이나 여러 계정을 순회하며 데이터를 수집하는 작업은 15분을 초과할 수 있어 적합하지 않았습니다.

Amazon EKS는 실행 시간 제한이 없고 유연한 확장이 가능하지만, 클러스터 관리, Pod 스케일링 설정, 리소스 최적화 등 운영 부담이 큽니다. 특히 세션별로 격리된 환경을 제공하려면 추가적인 아키텍처 설계가 필요합니다.

AgentCore Runtime의 차별점

AWS Bedrock AgentCore Runtime은 AI Agent 배포를 위해 특별히 설계된 서버리스 런타임 환경입니다. Lambda의 관리 편의성과 EKS의 유연성을 결합하면서도, Agent 특화 기능을 제공합니다.

| Bedrock AgentCore Runtime | Lambda | EKS | |

| 실행단위 | 세션(대화) | 함수 | Pod |

| 리소스 | 세션별로 유연하게 할당

(최대 4vCPU/16GB) |

함수별 고정 | Pod 스펙 고정 |

| 실행시간 | 최대 8시간 | 최대 15분 | 제약 없음 |

| 세션 격리 | MicroVM 완전 격리 | 함수 레벨 격리 | 직접 구현 필요 |

| 스케일링 | 수백만 세션 자동 확장 | 최대 1000개 동시 실행 | HPA/Cluster Autoscaler |

| 과금 구조 | 활성 처리 시간만 과금 | 실행 시간 전체 과금 | Pod 실행 시간 전체 과금 |

| 운영 부담 | 완전 관리형 | 완전 관리형 | 사용자 관리 |

| Agent 특화 기능 | 세션 관리, 단기 메모리, 모니터링 내장 | 직접 개발 필요 | 직접 개발 필요 |

AgentCore Runtime의 가장 큰 장점은 세션별 격리된 microVM 환경입니다. 각 사용자 세션은 독립된 CPU, 메모리, 파일시스템을 가진 microVM에서 실행되어 세션 간 데이터 오염을 원천적으로 차단합니다. 이는 대규모 동시 세션을 안정적으로 처리하는 데 핵심적인 요소입니다.

또한 소비 기반 과금 모델도 매력적입니다. Agent는 LLM 응답을 기다리는 I/O 대기 시간이 많은데, AgentCore Runtime은 실제 CPU가 활성화된 시간만 과금합니다. Lambda나 EKS처럼 대기 시간까지 과금되지 않아 비용 효율적입니다.

마지막으로 프레임워크와 모델의 독립성입니다. Strands-Agents SDK, LangGraph, CrewAI 등 어떤 Agent 프레임워크든 사용할 수 있고, Bedrock 모델뿐 아니라 Anthropic, OpenAI 등 다양한 LLM을 자유롭게 선택할 수 있습니다.

AWS 공식 MCP Server 활용

Agent가 실제로 유용하려면 외부 시스템과 통신하고 데이터를 가져오며 작업을 수행할 수 있어야 합니다. 하지만 각 도구마다 다른 API 형식과 인증 방식을 사용한다면 Agent 개발은 복잡해집니다.

Model Context Protocol(MCP)은 이 문제를 해결하기 위한 개방형 표준 프로토콜입니다. MCP는 Agent가 외부 도구와 통신하는 방식을 표준화하여, 마치 IDE에 확장 프로그램을 추가하듯 Agent에 새로운 기능을 손쉽게 추가할 수 있게 합니다.

AWS는 Cost Explorer, CloudTrail, Security Hub 등 주요 서비스를 위한 공식 MCP Server를 제공합니다. UCMP Agent는 이러한 MCP Server들을 활용해 비용 분석, 변경 이력 추적, 보안 점검 등의 기능을 구현했습니다. 새로운 기능이 필요할 때는 해당하는 MCP Server를 추가하기만 하면 되어 확장성이 뛰어납니다.

UCMP Agent 아키텍처

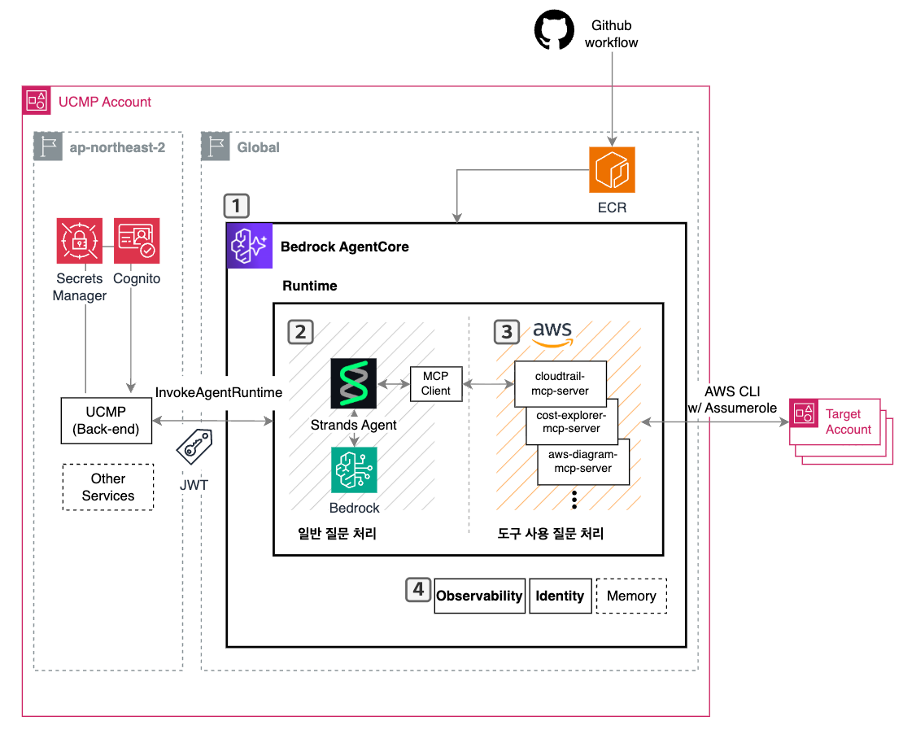

UCMP Agent는 다음과 같이 구성되어 있으며, 핵심적인 Agent 기능에 AWS의 AI 기술을 활용하고 있습니다.

UCMP 아키텍처

핵심 컴포넌트

(1) Runtime: AWS Bedrock AgentCore

Agent의 실행 환경입니다. 앞서 설명한 것처럼 세션별 격리, 자동 스케일링, 소비 기반 과금 등의 장점을 제공합니다. 개발자는 인프라 관리 없이 Agent 로직에만 집중할 수 있습니다.

(2) Agent Framework: Strands-Agents SDK

Agent의 두뇌 역할을 하는 오픈소스 프레임워크입니다. Strands Agents SDK는 AWS가 개발하고 제공하는 오픈소스 SDK로, Amazon Bedrock을 비롯한 AWS 서비스와 네이티브하게 통합됩니다. Agentic Loop를 구현하여 LLM이 상황을 판단하고 필요한 도구를 선택해 실행하며 결과를 관찰해 다음 행동을 결정하게 됩니다.

(3) Tools: AWS MCP Servers

Agent가 사용할 수 있는 도구들입니다. Cost Explorer MCP Server는 비용 데이터를 분석하고, CloudTrail MCP Server는 변경 이력을 추적하며, Diagram MCP Server는 아키텍처 다이어그램을 생성합니다. 중요한 점은 이러한 MCP Server들이 Agent 코드와 함께 AgentCore Runtime에 배포된다는 것입니다. 별도의 서버를 운영할 필요가 없습니다.

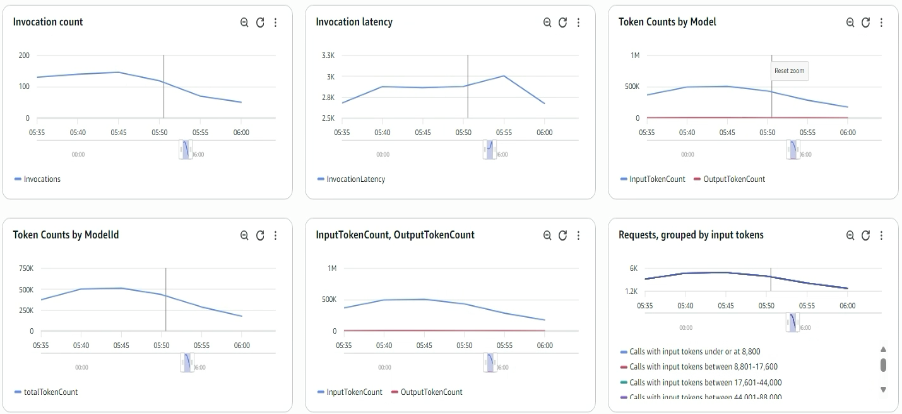

(4) Observability: CloudWatch + CloudWatch Generative AI Observability

Agent의 동작을 모니터링하고 디버깅하는 도구입니다. AgentCore는 기본 메트릭(세션 수, 호출 수, 레이턴시, 에러율, 토큰 사용량, 리소스 사용량)을 자동으로 생성하며, 이는 CloudWatch에 저장됩니다. CloudWatch의 Generative AI Observability 대시보드는 Agent의 추론 과정, 도구 호출, 실행 경로를 시각화하고 상세히 추적합니다. 세션 추적을 통해 사용자와 Agent 간의 전체 대화 흐름을 모니터링하며, OpenTelemetry 계측을 통해 유저 프롬프트부터 응답까지 전 과정을 추적하여 빠른 디버깅과 품질 감사를 지원합니다.

동작흐름

UCMP Agent의 전체 동작흐름은 다음과 같습니다.

- 사용자가 UCMP를 통해 Agent에게 질문을 보냅니다.

- AgentCore Runtime이 세션을 생성하고 격리된 microVM에서 Agent를 실행합니다.

- Strands Agent가 질문을 분석하고 필요한 MCP Server를 호출합니다.

- MCP Server가 AWS 서비스(Cost Explorer, CloudTrail 등)에서 데이터를 수집합니다.

- Agent가 수집된 데이터를 분석하고 사용자에게 인사이트를 제공합니다.

- 모든 과정이 CloudWatch에 기록되며, CloudWatch의 Generative AI Observability 대시보드에서 전체 실행 흐름을 추적하고 분석할 수 있습니다.

구현상세

AgentCore Runtime에 Agent 배포

AgentCore Runtime에 Agent를 배포하는 과정은 매우 간단합니다. Agent 코드에 entrypoint를 정의하고, 설정 파일을 작성한 후 배포하면 됩니다.

Agent Entrypoint 정의

@app.entrypoint 데코레이터를 사용해 Agent의 진입점을 정의합니다. payload에는 사용자 요청이, context에는 세션 정보가 담겨 있습니다.

배포 설정 (.bedrock_agentcore.yaml)

이 설정 파일은 Agent의 위치, 실행 환경, 인증 방식을 정의합니다. UCMP는 Amazon Cognito를 통한 JWT 인증을 적용해 인가된 사용자만 Agent에 접근할 수 있도록 했습니다.

배포 후 모니터링

배포가 완료되면 AWS 콘솔에서 Agent의 상태를 실시간으로 모니터링할 수 있습니다. 모델, 런타임, 엔드포인트 단위로 상태를 확인하고 관리할 수 있어 운영이 편리합니다.

모니터링 화면

Strands-Agents SDK로 Agent 개발

Agent

프레임워크를 선택할 때 가장 중요하게 고려한 점은 운영 환경에서의 안정성과 AWS 서비스와의 통합성이었습니다. LangChain이나 LangGraph 같은 오픈소스 프레임워크도 훌륭하지만, AWS가 공식 제공하는 Strands-Agents SDK는 Bedrock 및 다른 AWS 서비스와 네이티브하게 통합되어 별도의 설정 없이 안정적으로 동작합니다.

Bedrock 모델 및 Guardrail 설정

Bedrock Guardrail을 적용해 Agent가 부적절한 응답을 생성하거나 민감한 정보를 노출하지 않도록 보호합니다. Guardrail은 콘텐츠 필터링, PII 마스킹, 주제 제한 등의 기능을 제공합니다.

MCP Tool 정의

Strands SDK의 `AgentTool` 인터페이스를 구현해 MCP Server를 Agent의 도구로 등록합니다. `run` 메서드는 동기 호출을, `stream` 메서드는 스트리밍 응답을 처리합니다.

ReAct 패턴으로 동작하는 Agent

Strands SDK는 내부적으로 ReAct(Reason → Act → Observe → Next) 패턴을 따릅니다. 다만 Strands SDK는 model-driven approach를 채택하여, 개발자가 명시적으로 각 단계를 구현할 필요 없이 LLM이 자율적으로 reasoning과 action을 결정합니다.

예를 들어 사용자가 “지난달 비용이 가장 많이 증가한 계정을 알려줘”라고 질문하면:

- Reason: LLM이 “비용 데이터를 조회해야겠다”고 판단하고 tool_use 응답 반환

- Act: Cost Explorer MCP Server의 비용 조회 도구 호출

- Observe: 도구 실행 결과(계정별 비용 증가율 데이터)를 대화 컨텍스트에 추가

- Reason → Act: LLM이 결과를 분석하여 추가 조회가 필요하면 반복, 충분하면 최종 응답 생성

이런 방식으로 Agent는 복잡한 질문도 단계적으로 해결할 수 있습니다. 핵심은 개발자가 각 단계를 명시적으로 코딩하지 않아도, LLM이 도구 사양과 대화 컨텍스트를 기반으로 자율적으로 판단한다는 점입니다.

MCP Server 통합

Agent가 사용할 도구를 정의하고 관리하기 위해 UCMP는 AWS가 공식 제공하는 MCP Server들을 활용하고 있습니다. 중요한 점은 이러한 MCP Server들이 별도의 서버로 운영되는 것이 아니라, Agent 코드와 함께 AgentCore Runtime에 배포된다는 것입니다.

MCP Server 설정

초기에는 `uvx` 패키지 매니저를 통해 MCP Server를 설치하는 방식을 고려했지만 최종적으로는 MCP Server 코드를 직접 Agent 프로젝트에 포함시켜 배포하는 방식을 선택했습니다. 이렇게 하면 버전 관리가 명확하고, 배포 과정이 단순해집니다.

동적 도구 발견

Agent가 시작될 때 설정된 MCP Server들을 순회하며 각 Server가 제공하는 도구들을 자동으로 발견합니다. 이 방식의 장점은 새로운 MCP Server를 추가할 때 Agent 코드를 수정할 필요 없이 설정만 추가하면 된다는 것입니다.

예를 들어 Security Hub MCP Server를 추가하고 싶다면 이렇게 설정만 추가하면 Agent는 자동으로 Security Hub 관련 도구들을 사용할 수 있게 됩니다.

운영모니터링

프로덕션 환경에서 Agent를 안정적으로 운영하려면 실시간 모니터링과 디버깅 기능이 필수적입니다. AgentCore Runtime은 CloudWatch와 통합된 Generative AI Observability를 제공해 Agent의 동작을 상세히 추적할 수 있습니다.

CloudWatch 기본메트릭

AgentCore Runtime은 다음과 같은 핵심 메트릭을 자동으로 수집합니다:

- 세션 수(Session Count): 동시 활성 세션 수를 추적해 부하 상황을 파악

- 레이턴시(Latency): 요청부터 응답까지 걸린 시간

- 에러율(Error Rate): 시스템 에러와 사용자 에러를 구분해 추적

- 토큰 사용량(Token Usage): LLM 호출에 사용된 입력/출력 토큰 수

- 리소스 사용량: CPU 및 메모리 사용률 (1분 단위)

이러한 메트릭은 계정, Agent Runtime, Endpoint 레벨에서 확인할 수 있어 세밀한 모니터링이 가능합니다.

Generative AI Observability 대시보드

CloudWatch의 Generative AI Observability는 Agent 특화 모니터링 기능을 제공합니다:

- Trace 시각화: Agent의 추론 과정을 단계별로 시각화

- 세션별 추적: 특정 사용자 세션의 전체 대화 흐름을 추적

- 에러 분석: 에러를 유형별로 분류하고 원인 파악

- 성능 최적화: 병목 구간 식별

실제 운영 경험

UCMP Agent는 상용화 이후 안정적으로 동작하고 있으며 향후 기능 확장에 따라 예상되는 대규모 동시 세션 처리에도 대응 할 수 있도록 준비되어 있습니다. Generative AI Observability 덕분에 특정 세션에서 발생한 문제를 빠르게 파악하고 해결할 수 있었습니다. 예를 들어 특정 MCP Server 호출이 느린 경우 Trace 시각화를 통해 병목 구간을 식별하고 최적화할 수 있습니다.

실제 활용 사례

위와 같이 배포한 UCMP Agent는 다양한 클라우드 관리 업무를 자동화할 수 있습니다. 현재 적용 중인 주요 사례들을 소개합니다.

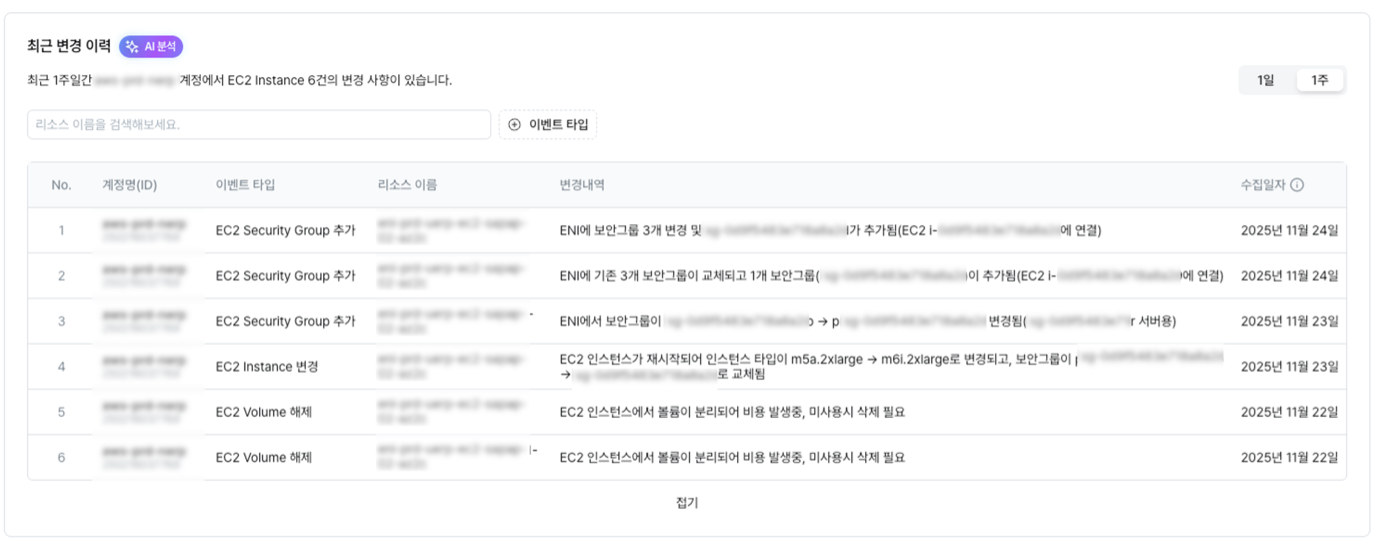

1. 계정별 주요 변경 이력 추적

UCMP의 최근 변경 이력 화면

클라우드 계정에서는 다양한 사용자와 자동화 도구의 작업으로 인해 하루에도 수많은 로그가 생성됩니다. 이 중에서 의미 있는 변경점을 찾아 모니터링하는 일은 쉽지 않습니다. UCMP Agent는 CloudTrail MCP Server를 활용해 주요 이벤트 유형을 지속적으로 추적합니다:

- EC2 인스턴스 생성/삭제

- IAM 정책 변경

- S3 버킷 설정 변경

- 보안 그룹 규칙 수정

이를 통해 계정 관리자는 자신의 계정에서 발생한 주요 이벤트를 한눈에 파악하고 즉시 대응할 수 있습니다.

2. 계정별 FinOps 리포트 자동화

UCMP의 비용 현황 분석/리포트 화면

FinOps는 클라우드 운영에서 가장 중요한 과제 중 하나지만, 여전히 일부 담당자 중심으로만 진행되는 경우가 많습니다. UCMP는 이러한 한계를 넘어 모든 구성원이 비용 관리에 자연스럽게 참여할 수 있도록 FinOps 활동을 활성화하는 데 초점을 맞추고 있습니다.

UCMP Agent는 Cost Explorer MCP Server를 기반으로 비용 데이터를 분석하고 계정별 맞춤 리포트를 자동으로 생성합니다:

- 월별/주별 비용 추이

- 서비스별 비용 분석

- 비용 증가율이 높은 리소스 식별

- 비용 최적화 권장 사항

이를 통해 개발자, 운영자, 사업 담당자 모두가 비용 현황을 손쉽게 확인하고 비용 최적화 문화를 일상적인 업무로 정착시킬 수 있습니다.

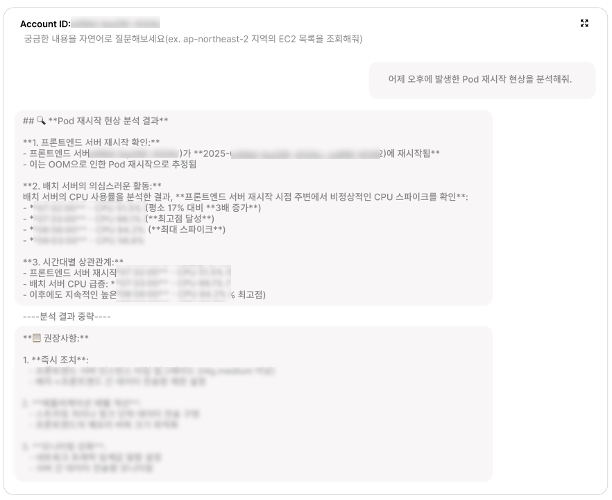

3. 자연어 기반 트러블슈팅

UCMP의 자연어 기반 트러블슈팅 화면

개발자와 운영자에게 트러블슈팅은 언제나 어려운 과제입니다. 담당자의 클라우드 역량, 경험 혹은 서비스에 대한 이해도에 따라 트러블슈팅에 소요되는 시간은 천차만별입니다.

UCMP Agent는사용자의 단순한 질문에 대한 답변부터 복잡한 트러블슈팅까지 상황에 맞는 분석과 실행 방안을 제시합니다:

- “왜 이 Lambda 함수가 느린가요?” → CloudWatch Logs 분석, X-Ray 트레이스 확인

- “이 EC2 인스턴스에 접속이 안돼요” →보안 그룹, 네트워크 ACL, 라우팅 테이블 점검

- “S3 버킷 접근 권한 설정이 맞나요?” → IAM 정책, 버킷 정책, ACL 분석

복잡한 AWS CLI 명령어나 콘솔 메뉴를 찾아다닐 필요 없이, 자연어로 질문하면 Agent가 필요한 정보를 수집하고 분석해 해결 방안을 제시합니다. 이는 클라우드 경험이 적은 개발자도 빠르게 문제를 해결할 수 있게 하여 전체 팀의 생산성을 높입니다.

운영 경험과 교훈

UCMP Agent를 프로덕션 환경에서 운영하며 얻은 주요 경험을 공유합니다.

대규모 세션 처리 준비 완료

AgentCore Runtime의 세션별 microVM 격리 구조는 대규모 동시 세션을 안정적으로 처리할 수 있도록 설계 되었습니다. 현재 상용 환경에서 우수한 확장성을 확인하고 있으며 각 세션이 독립된 환경에서 실행되어 세션 간 간섭이 없고 자동 스케일링으로 부하가 증가해도 성능 저하 없이 대응할 수 있습니다.

비용효율성

소비 기반 과금 모델이 실제로 비용 절감에 큰 도움이 되고 있습니다. Agent는 LLM 응답을 기다리는 I/O 대기 시간이 많은데, AgentCore Runtime은 실제 CPU가 활성화된 시간만 과금합니다. 대기 시간에 대한 과금이 발생하는 Lambda나 EKS와 비교하면 더 비용효과적인 솔루션입니다.

확장성

새로운 기능을 추가할 때 MCP Server만 추가하면 되어 확장이 매우 쉽습니다. 예를 들어 보안 점검 기능을 추가하고 싶다면 Security Hub MCP Server를 설정에 추가하기만 하면 됩니다. Agent 코드를 수정할 필요가 없어 개발 속도가 빠릅니다.

운영편의성

완전 관리형 서비스라 인프라 운영 부담이 없습니다. 서버 패치, 스케일링 설정, 로드 밸런싱 등을 신경 쓸 필요 없이 Agent 로직 개발에만 집중할 수 있었습니다. Generative AI Observability를 통한 상세한 모니터링도 문제 해결 시간을 크게 단축시키고 있습니다.

결론

UCMP Agent는 단순한 AI 기능이 아닌 차세대 클라우드 관리 플랫폼으로 가는 여정의 시작입니다. 현재 개발/계획 중인 기능 외에도 다양한 MCP Server 연동을 통해 클라우드를 보다 효율적이고 지능적으로 사용할 수 있도록 확장해 나갈 예정입니다.

AgentCore Runtime은 대규모 동시 세션 처리나 복잡한 워크플로우가 필요한 프로덕션 환경에 AI Agent를 구축하려는 조직에게 최적의 실행환경을 제공합니다.