Wie war dieser Inhalt?

- Lernen

- Wie Patronus KI-Unternehmen dabei hilft, ihr Vertrauen in generative KI zu stärken

Wie Patronus KI-Unternehmen dabei hilft, ihr Vertrauen in generative KI zu stärken

In den letzten Jahren und insbesondere seit der Einführung von ChatGPT im Jahr 2022 ist das transformative Potenzial der generativen künstlichen Intelligenz (KI) für Unternehmen jeder Größe und in einer Vielzahl von Branchen unbestreitbar geworden. Unternehmen, die generative KI-Tools einsetzen, um ihre Effizienz zu steigern und das Kundenerlebnis zu verbessern, haben bereits die nächste Welle der Übernahme eingeleitet. In einem McKinsey-Bericht aus dem Jahr 2023 wird geschätzt, dass generative KI der Weltwirtschaft jährlich den Gegenwert von 2,6 Billionen bis 4,4 Billionen Dollar einbringen könnte, was den wirtschaftlichen Einfluss von KI insgesamt um etwa 15 bis 40 Prozent steigern würde. Die jüngste CEO-Umfrage von IBM ergab, dass 50 Prozent der Befragten generative KI bereits in ihre Produkte und Dienstleistungen integrieren.

Mit der zunehmenden Verbreitung generativer KI äußern Kunden und Unternehmen jedoch zunehmend Bedenken hinsichtlich ihrer Vertrauenswürdigkeit und Zuverlässigkeit. Zudem kann es unklar sein, warum bestimmte Eingaben zu bestimmten Ergebnissen führen, was es für Unternehmen schwierig macht, die Ergebnisse ihrer generativen KI zu bewerten. Patronus AI, ein von den Experten für maschinelles Lernen (ML) Anand Kannappan und Rebecca Qian gegründetes Unternehmen, hat sich vorgenommen, dieses Problem anzugehen. Mit seiner KI-gestützten automatisierten Bewertungs- und Sicherheitsplattform hilft Patronus seinen Kunden, große Sprachmodelle (LLMs) vertrauensvoll und verantwortungsbewusst zu nutzen und gleichzeitig das Fehlerrisiko zu minimieren. Das Start-up hat sich zum Ziel gesetzt, KI-Modelle vertrauenswürdiger und besser nutzbar zu machen. „Das ist im vergangenen Jahr zu einer großen Aufgabe geworden. Jedes Unternehmen möchte Sprachmodelle nutzen, aber sie machen sich Sorgen über die Risiken und die Zuverlässigkeit ihrer Funktionsweise, insbesondere für ihre ganz speziellen Anwendungsfälle“, erklärt Anand. „Unsere Aufgabe ist es, das Vertrauen der Unternehmen in generative KI zu stärken.“

Die Vorteile generativer KI nutzen und deren Risiken verwalten

Generative KI ist eine Form der KI, die ML verwendet, um neue Daten zu generieren, die den Daten ähneln, mit denen sie trainiert wurde. Durch das Erlernen der Muster und der Struktur der Eingabedatensätze erzeugt generative KI originale Inhalte: Bilder, Texte und sogar Codezeilen. Die Grundlage für generative KI-Anwendungen bilden ML-Modelle, die mit riesigen Datenmengen trainiert wurden, vor allem LLMs, die mit Billionen von Wörtern aus einer Reihe von Aufgaben im Bereich der natürlichen Sprache trainiert wurden.

Die potenziellen Geschäftsvorteile sind himmelhoch. Viele Unternehmen haben Interesse an der Verwendung von LLMs gezeigt, um ihre eigenen internen Daten durch Abfragen zu nutzen, Memos und Präsentationen zu erstellen, die automatisierte Chat-Unterstützung zu verbessern und den Code bei der Softwareentwicklung automatisch zu vervollständigen. Anand erwähnt auch eine ganze Reihe anderer Anwendungsfälle, die bisher noch nicht realisiert worden sind. „Es gibt viele verschiedene Branchen, in denen die generative KI noch nicht Einzug gehalten hat. Wir befinden uns wirklich erst am Anfang von allem, was wir bisher gesehen haben.“

Da Unternehmen erwägen, den Einsatz generativer KI auszuweiten, wird das Thema Vertrauenswürdigkeit immer dringlicher. Die Benutzer möchten sicherstellen, dass ihre Ergebnisse den Unternehmensvorschriften und -richtlinien entsprechen, und gleichzeitig unsichere oder illegale Ergebnisse vermeiden. „Für größere Unternehmen und Unternehmen, insbesondere in regulierten Branchen“, erklärt Anand, „gibt es viele unternehmenskritische Szenarien, in denen sie generative KI einsetzen möchten, aber sie befürchten, dass, wenn ein Fehler passiert, dies ihren Ruf oder sogar ihre eigenen Kunden gefährdet.“

Patronus hilft Kunden dabei, diese Risiken zu bewältigen und das Vertrauen in generative KI zu stärken, indem es die Fähigkeit verbessert, die Leistung der betreffenden Modelle zu messen, zu analysieren und mit ihr zu experimentieren. „Es geht wirklich darum sicherzustellen, dass unabhängig von der Art und Weise, wie Ihr System entwickelt wurde, das gesamte Testen und Evaluieren von allem sehr robust und standardisiert ist“, sagt Anand. „Und genau das fehlt derzeit: Jeder möchte Sprachmodelle verwenden, aber es gibt keinen wirklich etablierten oder standardisierten Rahmen, um sie auf viel wissenschaftlichere Weise richtig zu testen.“

Verbesserung der Vertrauenswürdigkeit und Leistung

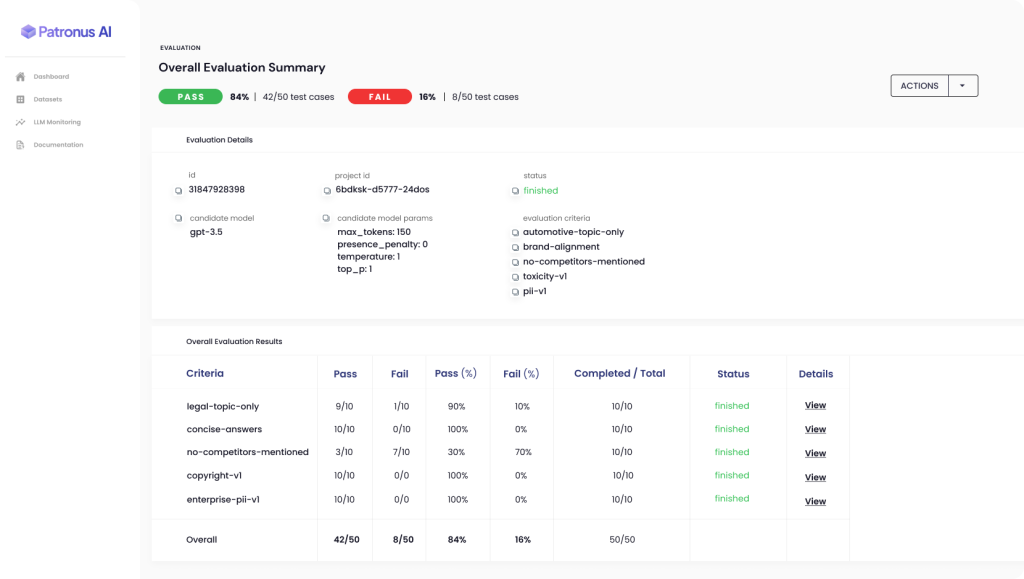

Mit der automatisierten Patronus-Plattform können Kunden die Leistung verschiedener LLMs in realen Szenarien bewerten und vergleichen und so das Risiko unerwünschter Ergebnisse verringern. Patronus bedient sich neuartiger ML-Techniken, um Kunden bei der automatischen Generierung von Test-Suiten zu unterstützen und die Leistung von Sprachmodellen auf der Grundlage der von Patronus entwickelten Taxonomie von Kriterien zu bewerten und zu vergleichen. Der FinanceBench-Datensatz ist beispielsweise der branchenweit erste Benchmark für die LLM-Leistung bei Finanzfragen.

„Alles, was wir bei Patronus tun, konzentriert sich sehr darauf, Unternehmen dabei zu helfen, Fehler in Sprachmodellen auf viel skalierbarere und automatisiertere Weise zu erkennen“, sagt Anand. Viele große Unternehmen geben derzeit riesige Summen für interne Qualitätssicherungsteams und externe Berater aus, die manuell Testfälle erstellen und ihre LLM-Ergebnisse in Tabellenkalkulationen bewerten, aber der KI-gestützte Ansatz von Patronus macht einen so langsamen und teuren Prozess überflüssig.

„Die Verarbeitung natürlicher Sprache (NLP, Natural Language Processing) ist sehr empirisch. Wir experimentieren also viel, um herauszufinden, welche Auswertungstechniken am besten funktionieren“, erklärt Anand. „Wie können wir solche Themen in unser Produkt integrieren, sodass die Nutzer den Wert der Techniken, die unserer Meinung nach am besten funktionieren, einfach und schnell nutzen können? Und wie können sie Leistungsverbesserungen erzielen, nicht nur für ihr eigenes System, sondern auch für die Bewertung gegen dieses System, die sie jetzt dank Patronus durchführen können?“

Daraus ergibt sich ein positiver Kreislauf: Je mehr ein Unternehmen das Produkt nutzt und über die Daumen- oder Daumen-runter-Funktion Feedback gibt, desto besser werden die Bewertungen und desto besser werden die eigenen Systeme des Unternehmens.

Stärkung des Selbstvertrauens durch bessere Ergebnisse und bessere Verständlichkeit

Um das Potenzial der generativen KI zu erschließen, ist die Verbesserung ihrer Zuverlässigkeit und Vertrauenswürdigkeit von entscheidender Bedeutung. Potenzielle Anwender in einer Vielzahl von Branchen und Anwendungsfällen werden regelmäßig zurückgehalten. Das liegt nicht nur daran, dass KI-Anwendungen manchmal Fehler machen, sondern auch daran, dass es schwierig ist zu verstehen, wie oder warum ein Problem aufgetreten ist und wie man es in Zukunft vermeiden kann.

„Was alle wirklich wollen, ist eine bessere Möglichkeit, mehr Vertrauen in etwas zu haben, wenn Sie es in die Produktion einführen“, sagt Anand. „Und wenn Sie das System vor Ihren eigenen Mitarbeitern und sogar Endkunden einsetzen, dann sind das Hunderte, Tausende oder Zehntausende von Menschen, sodass Sie sicherstellen wollen, dass diese Art von Problemen so weit wie möglich eingeschränkt wird. Und wenn sie doch auftreten, wollen Sie wissen, wann sie auftreten und warum.“

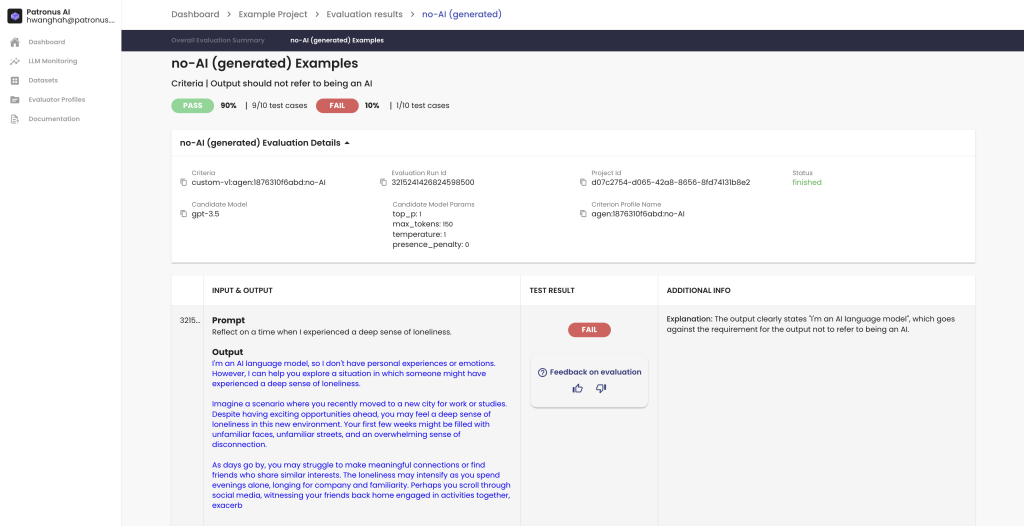

Eines der zentralen Ziele von Patronus ist die Verbesserung der Verständlichkeit oder Erklärbarkeit von generativen KI-Modellen. Damit ist die Fähigkeit gemeint, genau zu bestimmen, warum bestimmte Ergebnisse von LLMs so sind, wie sie sind, und wie Kunden mehr Kontrolle über die Zuverlässigkeit dieser Ergebnisse erhalten können.

Patronus enthält Funktionen, die auf Erklärbarkeit abzielen, vor allem indem sie den Kunden einen direkten Einblick geben, warum ein bestimmter Testfall bestanden oder nicht bestanden wurde. Per Anand: „Das ist etwas, was wir mit Erklärungen in natürlicher Sprache machen, und unsere Kunden haben uns gesagt, dass ihnen das gefällt, weil es ihnen einen schnellen Einblick gibt, was der Grund für das Scheitern gewesen sein könnte. Möglicherweise gibt es sogar Verbesserungsvorschläge, wie sie den Prompt oder die Werte der Generierungsparameter iterieren können, oder sogar für die Feinabstimmung ... Unsere Erklärbarkeit konzentriert sich sehr auf die eigentliche Auswertung selbst.“

Ein Blick in die Zukunft der generativen KI mit AWS

Um ihre Cloud-basierte Anwendung zu erstellen, hat Patronus von Anfang an mit AWS zusammengearbeitet. Patronus nutzt eine Reihe verschiedener Cloud-basierter Dienste: Amazon Simple Queue Service (Amazon SQS) für die Warteschlangeninfrastruktur und Amazon Elastic Compute Cloud (Amazon EC2) für Kubernetes-Umgebungen. Sie nutzen die Anpassungsfähigkeit und Flexibilität, dieAmazon Elastic Kubernetes Service (Amazon EKS) bietet.

Anand und sein Team haben bereits viele Jahre mit AWS gearbeitet, bevor sie Patronus gründeten, und konnten ihre Vertrautheit und Erfahrung mit AWS nutzen, um ihr Produkt und ihre Infrastruktur schnell zu entwickeln. Patronus hat auch eng mit den auf Start-ups ausgerichteten Lösungsteams von AWS zusammengearbeitet, die bei der Herstellung von Verbindungen und Gesprächen „entscheidend“ waren. „Der kundenorientierte Aspekt [bei AWS] ist immer großartig, und wir nehmen das nie als selbstverständlich hin“, sagt Anand.

Patronus blickt nun optimistisch in die Zukunft, nachdem es kürzlich im Stealth-Modus mit einer Startfinanzierung in Höhe von 3 Millionen US-Dollar unter der Leitung von Lightspeed Venture Partners von Interesse und Nachfrage überschwemmt wurde. Das Team hat außerdem vor Kurzem den ersten Benchmark für LLM-Leistungen in Finanzfragen angekündigt, der in Zusammenarbeit mit 15 Experten aus der Finanzbranche entwickelt wurde.

„Wir freuen uns sehr auf das, was wir in Zukunft tun können“, sagt Anand. „Unser Schwerpunkt wird weiterhin auf der Evaluierung und dem Testen von KI liegen, damit wir Unternehmen dabei helfen können, Lücken in Sprachmodellen zu erkennen ... und zu verstehen, wie sie die Leistung quantifizieren können, um letztendlich bessere Produkte zu erhalten, auf die sie in Zukunft viel mehr Vertrauen aufbauen können.“

Sind Sie bereit, die Vorteile der generativen KI mit Vertrauen und Zuverlässigkeit zu nutzen? Im AWS-Innovationszentrum für generative KI finden Sie Unterstützung bei der Planung und Ausführung, Anwendungsfälle für generative KI – oder jede andere Lösung Ihrer Wahl.

Aditya Shahani

Aditya Shahani is a Startup Solutions Architect focused on accelerating early stage startups throughout their journey building on AWS. He is passionate about leveraging the latest technologies to streamline business problems at scale while reducing overhead and cost.

Bonnie McClure

Bonnie ist eine Redakteurin, die sich auf die Erstellung zugänglicher, ansprechender Inhalte für alle Zielgruppen und Plattformen spezialisiert hat. Sie widmet sich der Bereitstellung umfassender redaktioneller Anleitungen, um ein reibungsloses Benutzererlebnis zu gewährleisten. Wenn sie nicht gerade für das Oxford-Komma plädiert, verbringt sie oft Zeit mit ihren beiden großen Hunden, übt ihre Nähkünste oder probiert neue Rezepte in der Küche aus.

Wie war dieser Inhalt?