¿Qué le pareció este contenido?

- Aprender

- Cómo Patronus AI ayuda a las empresas a aumentar su confianza en la IA generativa

Cómo Patronus AI ayuda a las empresas a aumentar su confianza en la IA generativa

En los últimos años, y especialmente desde el lanzamiento de ChatGPT en 2022, el potencial transformador de la inteligencia artificial (IA) generativa se ha vuelto innegable para las organizaciones de todos los tamaños y en una amplia gama de sectores. La próxima ola de adopción ya ha comenzado, y las empresas se apresuran a adoptar herramientas de IA generativa para impulsar la eficiencia y mejorar las experiencias de los clientes. Un informe de McKinsey de 2023 estimó que la IA generativa podría agregar el equivalente a entre 2,6 y 4,4 billones de dólares en valor a la economía mundial al año, lo que aumentaría el impacto económico general de la IA entre un 15 y un 40 por ciento, mientras que la última encuesta de directores ejecutivos de IBM reveló que el 50 por ciento de los encuestados ya estaba integrando la IA generativa en sus productos y servicios.

Sin embargo, a medida que la IA generativa se generaliza, los clientes y las empresas expresan cada vez más su preocupación por su fiabilidad y la confianza que el usuario puede tener en ella. Es posible que no quede claro por qué unas entradas determinadas conducen a determinados resultados, lo que dificulta que las empresas evalúen los resultados de su IA generativa. Patronus AI, una empresa fundada por los expertos en machine learning (ML) Anand Kannappan y Rebecca Qian, se ha propuesto abordar este problema. Con su plataforma automatizada de evaluación y seguridad basada en la inteligencia artificial, Patronus ayuda a sus clientes a utilizar modelos de lenguaje de gran tamaño (LLM) con confianza y responsabilidad, al tiempo que minimiza el riesgo de errores. El objetivo de la startup es hacer que los modelos de IA sean más fiables y utilizables. “Esa se convirtió en la gran pregunta del año pasado. Todas las empresas desean utilizar modelos de lenguaje, pero les preocupan los riesgos e incluso solo la fiabilidad de su funcionamiento, especialmente para sus casos de uso muy específicos”, explica Anand. “Nuestra misión es aumentar la confianza de las empresas en la IA generativa”.

Aprovechar los beneficios y gestionar los riesgos de la IA generativa

La IA generativa es un tipo de IA que utiliza el ML para generar nuevos datos similares a los datos con los que se entrenó. Al aprender los patrones y la estructura de los conjuntos de datos de entrada, la IA generativa produce contenido original: imágenes, texto e incluso líneas de código. Las aplicaciones de IA generativa se basan en modelos de ML que se han entrenado previamente en grandes cantidades de datos, sobre todo en LLM, que se han entrenado con billones de palabras para una variedad de tareas del lenguaje natural.

Los posibles beneficios empresariales son altísimos. Las empresas han mostrado interés en utilizar los LLM para aprovechar sus propios datos internos mediante la recuperación, producir notas y presentaciones, mejorar la asistencia automatizada por chat y completar automáticamente la generación de código en el desarrollo de software. Anand también señala toda la gama de otros casos de uso que aún no se han concretado. “Hay muchos sectores diferentes que la IA generativa aún no ha revolucionado. La verdad es que estamos en las primeras etapas de todo lo que hemos visto hasta ahora”.

A medida que las organizaciones consideran ampliar el uso de la IA generativa, la cuestión de la fiabilidad se vuelve más apremiante. Los usuarios quieren asegurarse de que sus productos cumplen con las normativas y políticas de la empresa y, al mismo tiempo, evitar resultados inseguros o ilegales. “Para las compañías y empresas más grandes, especialmente las de los sectores regulados”, explica Anand, “hay muchas situaciones críticas en las que desean utilizar la IA generativa, pero les preocupa que, si se comete un error, ponga en riesgo su reputación o incluso la de sus propios clientes”.

Patronus ayuda a los clientes a gestionar estos riesgos y a aumentar la confianza en la IA generativa al mejorar la capacidad de medir, analizar y experimentar con el rendimiento de los modelos en cuestión. “En realidad, se trata de garantizar que, independientemente de la forma en que se haya desarrollado el sistema, las pruebas y la evaluación generales de todo sean muy sólidas y estandarizadas”, afirma Anand. “Y eso es lo que realmente falta en este momento: todo el mundo quiere usar modelos de lenguaje, pero no existe un marco realmente establecido o estandarizado sobre cómo probarlos correctamente de una manera mucho más científica”.

Mejorar la fiabilidad y el rendimiento

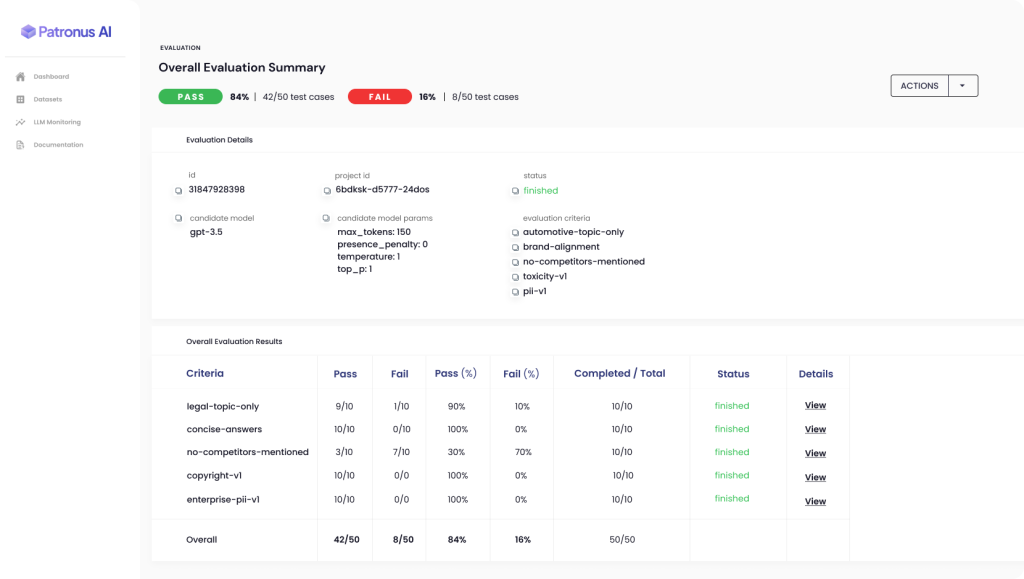

La plataforma automatizada Patronus permite a los clientes evaluar y comparar el rendimiento de diferentes LLM en situaciones del mundo real, lo que reduce el riesgo de resultados no deseados. Patronus utiliza técnicas novedosas de ML para ayudar a los clientes a generar automáticamente conjuntos de pruebas conflictivos y puntuar y comparar el rendimiento de los modelos de lenguaje basándose en la taxonomía de criterios exclusiva de Patronus. Por ejemplo, el conjunto de datos de FinanceBench es el primer punto de referencia del sector para medir el rendimiento de los LLM en cuestiones financieras.

“Todo lo que hacemos en Patronus se centra en ayudar a las empresas a detectar los errores en los modelos de lenguaje de una manera mucho más escalable y automatizada”, afirma Anand. Actualmente, muchas grandes empresas están gastando enormes cantidades de dinero en equipos internos de control de calidad y consultores externos, que crean manualmente casos de prueba y clasifican los resultados de su LLM en hojas de cálculo, pero el enfoque basado en la inteligencia artificial de Patronus ahorra la necesidad de un proceso tan lento y costoso.

“El procesamiento de lenguaje natural (NLP) es bastante empírico, por lo que estamos realizando mucho trabajo de experimentación para, en última instancia, determinar qué técnicas de evaluación funcionan mejor”, explica Anand. “¿Cómo podemos incluir este tipo de cosas en nuestro producto para que las personas puedan aprovechar el valor... de las técnicas que hemos descubierto que funcionan mejor, con mucha facilidad y rapidez? ¿Y cómo pueden mejorar el rendimiento, no solo para su propio sistema, sino también para la evaluación comparándola con ese sistema que han podido realizar ahora gracias a Patronus?”

El resultado es un círculo virtuoso: cuanto más utilice una empresa el producto y dé su opinión mediante la característica de aprobación o desaprobación, mejores serán sus evaluaciones y, como resultado, mejores serán los propios sistemas de la empresa.

Aumentar la confianza mediante la mejora de los resultados y la comprensión

Para aprovechar el potencial de la IA generativa, es vital mejorar su fiabilidad y la confianza en ella. Los posibles usuarios de diversos sectores y casos de uso se ven frenados con frecuencia, no solo por el hecho de que las aplicaciones de IA a veces cometen errores, sino también por la dificultad de entender cómo o por qué se ha producido un problema y de cómo evitar que vuelva a ocurrir en el futuro.

“Lo que todo el mundo realmente pide es una forma mejor de tener mucha más confianza en algo cuando se pone en producción”, afirma Anand. “Y cuando se lo plantea a sus propios empleados, e incluso a los clientes finales, se trata de cientos, miles o decenas de miles de personas, por lo que debe asegurarse de que ese tipo de desafíos se limiten en la medida de lo posible. Y, en el caso de los que ocurren, querrá saber cuándo ocurren y por qué”.

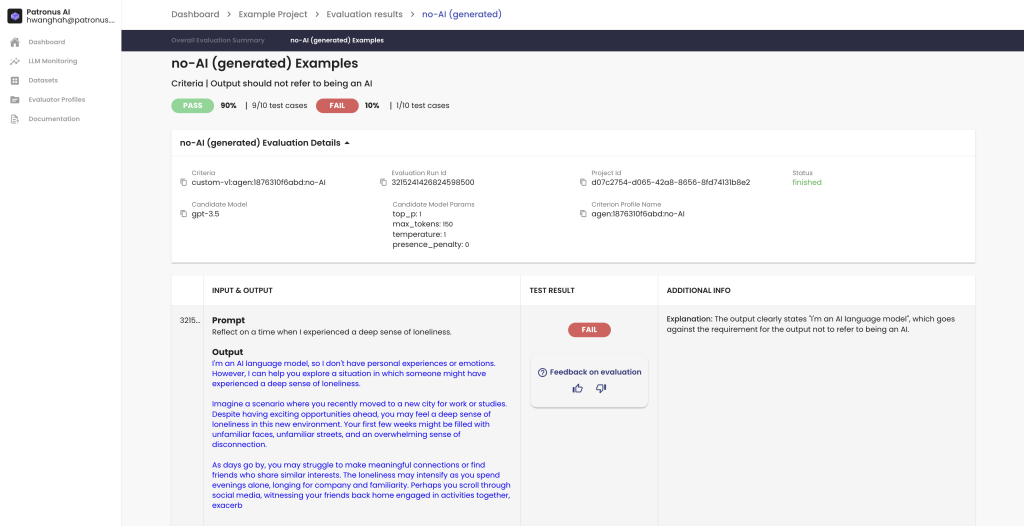

Uno de los objetivos clave de Patronus es mejorar la comprensibilidad o la explicabilidad de los modelos de IA generativa. Esto se refiere a la capacidad de identificar por qué ciertos resultados de los LLM son como son y cómo los clientes pueden obtener un mayor control sobre la fiabilidad de esos resultados.

Patronus incorpora características destinadas a facilitar la explicación, principalmente al brindar a los clientes una visión directa de por qué se aprobó o no un caso de prueba en particular. De acuerdo con Anand: “Eso es algo que hacemos con las explicaciones en lenguaje natural, y nuestros clientes nos han dicho que les ha gustado, porque les da una idea rápida de cuál podría haber sido la razón por la que las cosas han fallado y, tal vez, incluso sugerencias para mejorar la forma en que pueden repetir los valores de los parámetros de solicitud o generación, o incluso para ajustarlos con precisión... Nuestra explicabilidad se centra en gran medida en la evaluación en sí misma”.

Asegurar el futuro de la IA generativa con AWS

Para crear su aplicación basada en la nube, Patronus ha trabajado con AWS desde el principio. Patronus utiliza una gama de diferentes servicios basados en la nube; Amazon Simple Queue Service (Amazon SQS) para la infraestructura de colas y Amazon Elastic Compute Cloud (Amazon EC2) para los entornos de Kubernetes. Aprovechan la personalización y la flexibilidad que ofrece Amazon Elastic Kubernetes Service (Amazon EKS).

Tras trabajar con AWS durante muchos años antes de que él ayudara a fundar Patronus, Anand y su equipo pudieron aprovechar su familiaridad y experiencia con AWS para desarrollar rápidamente sus productos e infraestructuras. Patronus también ha trabajado en estrecha colaboración con los equipos de soluciones de AWS centrados en las startups, que han desempeñado un papel fundamental a la hora de establecer conexiones y conversaciones. “El aspecto centrado en el cliente [en AWS] siempre es fantástico y nunca lo damos por sentado”, afirma Anand.

Patronus ahora mira con optimismo hacia el futuro, ya que se ha visto inundado de interés y demanda tras su reciente lanzamiento desde el modo sigiloso, con 3 millones de dólares en financiación inicial liderados por Lightspeed Venture Partners. El equipo también ha anunciado recientemente el primer valor de referencia para medir el rendimiento de los LLM en cuestiones financieras, diseñado conjuntamente con 15 expertos en el sector financiero.

“Estamos muy entusiasmados con lo que vamos a poder hacer en el futuro”, afirma Anand. “Y seguiremos centrándonos en la evaluación y las pruebas de la IA para poder ayudar a las empresas a identificar las brechas en los modelos de lenguaje... y a entender cómo pueden cuantificar el rendimiento y, en última instancia, obtener mejores productos con los que puedan generar mucha más confianza en el futuro”.

¿Está preparado para aprovechar los beneficios de la IA generativa con confianza y fiabilidad? Visite el Centro de innovación de IA generativa de AWS para obtener orientación, planificación, soporte de ejecución, casos de uso de IA generativa o cualquier otra solución de su elección.

Aditya Shahani

Aditya Shahani is a Startup Solutions Architect focused on accelerating early stage startups throughout their journey building on AWS. He is passionate about leveraging the latest technologies to streamline business problems at scale while reducing overhead and cost.

Bonnie McClure

Bonnie es una editora especializada en crear contenido accesible y atractivo para todos los públicos y plataformas. Se dedica a brindar una guía editorial integral para brindar una experiencia de usuario perfecta. Cuando no está abogando por la coma de Oxford, puedes encontrarla pasando tiempo con sus dos perros grandes, practicando sus habilidades de costura o probando nuevas recetas en la cocina.

¿Qué le pareció este contenido?