Amazon Web Services ブログ

新しい Amazon EC2 P6-B300 インスタンスで大規模な AI アプリケーションを高速化

2025 年 11 月 18 日、NVIDIA Blackwell Ultra GPU によって高速化された次世代 GPU プラットフォームである Amazon Elastic Compute Cloud (Amazon EC2) P6-B300 インスタンスの一般提供をお知らせします。これらのインスタンスは、前世代のインスタンスと比較して 2 倍のネットワーク帯域幅と 1.5 倍の GPU メモリを提供し、大規模な AI アプリケーション向けにバランスの取れたプラットフォームを構築します。

これらの改善を経た P6-B300 インスタンスは大規模な AI モデル、特に Mixture of Experts (MoE) やマルチモーダル処理などの高度な手法を採用している AI モデルのトレーニングと提供に最適です。1 兆パラメータのモデルを扱い、何千もの GPU にわたる分散トレーニングを必要とする組織に対して、これらのインスタンスはコンピューティング、メモリ、ネットワーク機能の完璧なバランスを提供します。

前モデルと比較して加えられた改善点

P6-B300 インスタンスは 6.4 Tbps の Elastic Fabric Adapter (EFA) ネットワーク帯域幅を提供し、大規模な GPU クラスター間の効率的な通信をサポートします。これらのインスタンスには 2.1 TB の GPU メモリが搭載されているため、大規模モデルを 1 つの NVLink ドメイン内に配置できます。その結果、モデルのシャーディングと通信のオーバーヘッドが大幅に削減されます。これらのインスタンスを EFA ネットワーキングと AWS Nitro System の高度な仮想化およびセキュリティ機能と組み合わせると、AI ワークロードにおいて前例のないスピード、スケール、セキュリティが実現します。

EC2 P6-B300 インスタンスの仕様は次のとおりです。

| インスタンスサイズ | vCPU | システムメモリ | GPU | GPU メモリ | GPU から GPU への相互接続 | EFA ネットワーク帯域幅 | ENA 帯域幅 | EBS 帯域幅 | ローカルストレージ |

| P6-B300.48xlarge | 192 | 4TB | 8x B300 GPU | 2,144 GB HBM3e | 1,800 GB/秒 | 6.4 Tbps | 300 Gbps | 100 Gbps | 8x 3.84TB |

知っておくと便利な情報

永続的ストレージに関しては、料金パフォーマンスの考慮事項によって、AI ワークロードは主に Amazon FSx for Lustre、Amazon S3 Express One Zone、Amazon Elastic Block Store (Amazon EBS) などの高性能な永続的ストレージオプションを組み合わせて使用します。例を挙げると、P6-B300 の専有 300 Gbps Elastic Network Adapter (ENA) ネットワーキングにより、S3 Express One Zone を使用した高スループットのホットストレージアクセスが可能になり、大規模なトレーニングワークロードをサポートできます。FSx for Lustre を使用している場合、EFA と GPUDirect Storage (GDS) を組み合わせて P6-B300 インスタンスの Lustre ファイルシステムへの最大 1.2 Tbps のスループットを実現し、モデルをすばやくロードできるようになりました。

今すぐご利用いただけます

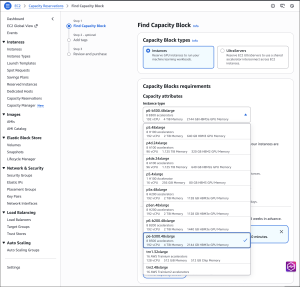

P6-B300 インスタンスは、米国西部 (オレゴン) AWS リージョンの Amazon EC2 Capacity Blocks for ML および Savings Plan でご利用いただけるようになりました。

P6-B300 インスタンスのオンデマンド予約については、アカウントマネージャーにお問い合わせください。Amazon EC2 でのいつものお支払いと同様に、お支払いいただくのは使用した分の料金のみです。詳細については、「Amazon EC2 の料金」をご覧ください。アプリケーションの移行を開始するのに役立つ、高速コンピューティングインスタンスのフルコレクションをご覧ください。

詳細については、Amazon EC2 P6-B300 インスタンスのページをご覧ください。AWS re:Post for EC2 に、または通常の AWS サポート担当者を通じて、ぜひフィードバックをお寄せください。

– Veliswa

原文はこちらです。