AWS Startup ブログ

Livetoon 社、サーバーコストを 2 割削減し運用負荷も低減。AWS Graviton 移行と自社開発 TTS がもたらしたアーキテクチャの進化

近年、AI 技術の急速な発展により、これまでにない多様なビジネスが次々と生まれています。そして、その根幹を支えるインフラのコスト最適化は、事業の持続可能性を左右する重要なテーマです。エンタメと AI 技術を融合させた事業を展開する株式会社 Livetoon も、かつては深刻なサーバー費用増加の課題に直面していました。

ですが同社は、アマゾン ウェブ サービス ジャパン合同会社(以下、AWS ジャパン)の社員とのディスカッションを通じてアーキテクチャを抜本的に改善しました。優れたコストパフォーマンスを発揮する AWS Graviton2 プロセッサ搭載の Amazon EC2 G5g インスタンスを導入し、この課題を乗り越えたのです。

この挑戦の裏側について、AWS ジャパン スタートアップ事業本部 アカウントマネージャーの小林 主典とソリューションアーキテクトの大越 雄太が、Livetoon 社 取締役・CTO の長嶋 大地 氏と開発マネージャーの土川 敦也 氏にお話を伺いました。ビジネス成長を加速させるアーキテクチャのあり方とは?

事業の核となる、最高クラスの Speech-to-Speech 技術

小林:Livetoon のお二人から、簡単な事業紹介と自己紹介をお願いできますか。

長嶋:Livetoon は「AI が人類と共生し、人類に更なる自由と幸福をもたらし続ける世界」をビジョンに掲げ、AI キャラクターの社会実装を目指しています。10 ~ 20 年後には、誰もが AI エージェントや AI キャラクターを持ち、相談や依頼をする世界が来ると予測しており、私たちはその先駆者となるべく事業に取り組んでいます。事業内容としては、toC 向けのアプリ「kaiwa」を主軸とし、そこから派生した BtoBtoC のソリューションも展開しています。

株式会社 Livetoon 長嶋 大地 氏

私たちの事業の基盤となるのは、Livetoon STS と呼んでいる Speech-to-Speech(STS)技術です。これは、ユーザーが音声で話しかけると、AI が思考し、音声で応答する対話形式のコミュニケーションを実現するものです。

Speech-to-Speech のアーキテクチャには単一モデル形式とパイプライン形式があります。単一モデル形式は応答が速い一方、思考の深さに課題があります。そのため、私たちは各モジュールを個別に改良でき、柔軟なカスタマイズが可能なパイプライン形式を採用しています。音声をテキストに変換する Speech-to-Text(STT)、大規模言語モデル(LLM)、テキストを音声に合成する Text-to-Speech(TTS)を組み合わせています。

一方で、パイプライン形式の問題は応答速度が遅くなる点です。私たちはこの課題を解決するため、パイプライン全体の最適化を進めています。中でも、ユーザー体験の質を大きく左右する TTS に最も力を入れており、現行最高峰モデルを超える読み上げ精度と処理速度を達成しています。

参考:Livetoon、最高クラス(最高精度・最速)の音声合成モデルを開発

私自身の経歴についてもお話しすると、もともとは大分県で医師として働いていました。その頃に、ChatGPT や画像生成 AI の Stable Diffusion が登場していました。公開当初の Stable Diffusion はデータセットの影響で、例えば「日本人」と指定しても、ステレオタイプなアジア人の画像が生成されがちでした。私は趣味でモデルの改良を行い、この課題の解決に成功しました。

それを機に、AI エンジニアへと転身しました。医師のキャリアにはいつでも戻れますが、AI に関する事業は今この時代だからこそ取り組む意義があると思ったためです。そして、昨年夏頃に Livetoon と東大病院の AI チームに参画するため上京しました。Livetoon では CTO として、AI 関連の開発全般を統括しています。

株式会社 Livetoon 土川 敦也 氏

土川:私は現在、社会人修士として大学院に在籍しながら、Livetoon で開発マネージャーとして働いています。学部4年生の頃から、SIer 向けのバーティカル SaaS を開発する企業でテックリードを務めていました。ChatGPT の登場などで AI への興味が深まったことに加え、もともとアニメやゲームなどのキャラクターが好きだったこともあり、昨年の12月に Livetoon へ参画しました。入社当初はフロントエンド担当でしたが、ゆるくフルスタック志向なため、現在はバックエンドやインフラ、Unity 製アプリも担当しています。

障害が頻発しインフラ費用も高騰していた。突破口となった AWS Graviton

大越:今回のインタビューでは、御社のアーキテクチャの変遷についてお聞きします。まず、旧アーキテクチャが抱えていた課題から伺わせてください。

土川:私たちの提供する会話 AI「kaiwa」の旧アーキテクチャが抱えていた課題は大きく 2 点ありました。1つは TTS のモデルがキャラクターごとに独立しておりコストが高いこと、もう1つはアーキテクチャが複雑で運用の難易度が高かったことです。

まずコストについてですが、当時は 6 体のキャラクターを運用しており、メインサーバーとバックアップを合わせると、最低でも常時 12 基の GPU が必要な計算でした。GPU 費用だけで月額 200 万円に達しかねない状況で、コスト最適化が急務でした。

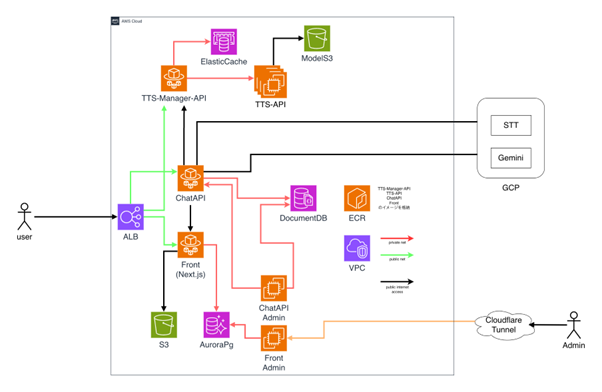

次に運用面ですが、これらの TTS サーバーのスケーリングを管理するシステムを自社で構築していました。管理サーバー(図中の TTS-Manager-API)の Amazon ECS から AWS の SDK(Boto3)経由で TTS 用の Amazon EC2 インスタンスを起動し、モデルの配置やヘルスチェックまでを独自に制御する仕組みです。この運用が非常に困難で、当時は定期的に障害が発生していました。

旧アーキテクチャの全体像

長嶋:このままではまずいと思い、アーキテクチャを根本から改善したいと AWS のお二人に助けを求めたのが、相談のきっかけでした。

大越:実は、このご相談をいただく前から長嶋さんとは面識があったんですよね。エンジニアの交流イベントで、偶然お会いしました。

長嶋:イベントの場で Livetoon の話をしたところ、偶然にも大越さんが弊社の担当だったことが判明しました。不思議なご縁ですよね(笑)。

2025 年 5 月頃から、AWS のお二人に相談を始めました。「とにかく安い GPU はないでしょうか」とカジュアルにお聞きしたところ、「AWS Graviton2 プロセッサを搭載した G5g インスタンスを使う選択肢もありますよ」とご提案いただきました。

土川:そのご提案を聞いて調べてみたところ「ARM64 と NVIDIA GPU は共存できるのか」という点にまず衝撃を受けました。その上、サーバーコストも2割近く安くなることがわかり、これはもう採用するしかないと即決しました。

AMI、PyTorch、世代差の問題を乗り越え、移行に成功

大越:旧アーキテクチャを拝見した際、まず自前の Auto Scaling の仕組みが非常に複雑になっている点がネックだと感じました。そこで、「1. このまま自作の仕組みを改良する」「2. Amazon EC2 の Auto Scaling 機能を活用する」「3. Amazon SageMaker のようなマネージドサービスに移行する」という 3 つの選択肢を提示しました。

Livetoon 社は既に AI・ML の運用体制が整っており、フルスクラッチでインフラを構築できる高い技術力をお持ちでした。その状況で今から Amazon SageMaker を採用するのは、移行コストがかかるわりに利点が少ないです。そこで、現在のアーキテクチャを活かしつつ運用を効率化できる最適な落としどころとして、Amazon EC2 の Auto Scaling と G5g インスタンスを組み合わせる方法が良いのではないかと考え、ご提案しました。

AWS ジャパン 小林 主典

小林:AWS Graviton は、多くのサーバーで採用されている x86 系とは異なる ARM アーキテクチャをベースにしているため、移行には一手間かかる場合があります。その手間とコスト削減効果のバランスが採用のポイントになりますが、Livetoon 社はその課題を見事に解決されたと感じています。移行の流れについて、ぜひ詳しく教えてください。

土川:その通りで、安定稼働に至るまでには、大きく分けて 3 つの技術的な壁がありました。1 つ目の壁は、AMI の自作です。 私たちが使いたい Linux ディストリビューションや NVIDIA ドライバ、 ECS エージェントなど、必要なソフトウェアを組み合わせた公式の AMI が提供されていなかったため、まず自分たちで最適な環境をゼロから構築する必要がありました。

2 つ目の壁が、機械学習ライブラリ PyTorch 自体のビルドを伴う推論環境構築です。 PyTorch は、ハードウェアやCUDA、PyTorch 本体、Python という4つの要素のうち「ある要素のバージョンが違う」だけでも安定して動作しないことが多いです。この組み合わせを見つけ出す作業が大変でした。

そして3つ目の壁が、開発環境とのアーキテクチャの世代差です。 当初、開発に使っていた Mac と、G5g インスタンスの AWS Graviton プロセッサは、同じ ARM アーキテクチャでも世代が異なっていました。そのため、開発環境でビルドしたものがサーバーでは動かない、という問題が発生しました。これらの問題を一つひとつ試行錯誤しながら乗り越え、最終的に移行を成功させられた時は、本当に嬉しかったですね。

大越:Livetoon 社が独自の TTS を生み出したことが、さらなるアーキテクチャ改善につながったと伺っています。その経緯についてもお聞かせいただけますか。

長嶋:私たちが以前に使っていた TTS モデルは、表現力・速度ともに満足のいかないもので、生成速度についてはおよそ 300 ミリ秒程度でした。そこで私たちはより自然で表現力のある音声を目指して、一からフルスクラッチでモデルを構築することにしました。

最初期のモデルはクオリティを最優先し非常に高品質な音声を生成できた一方、生成速度は約 500 ミリ秒と遅く、リアルタイム応答には課題が残っていました。どうすれば高速化できるかを検討する中で、「特定の処理を事前に計算しておけば、生成時のプロセスを大幅にショートカットできるのではないか」というアイデアを思いついたんです。

この設計を実装してみたところ、生成速度は一気に 120 ミリ秒まで向上しました。これが、冒頭で申し上げた「現行最高峰モデルを超える読み上げ精度と処理速度を達成した」という事例です。

さらに、この高速化は副次的に「一石三鳥」とも言える効果をもたらしました。キャラクターの感情をベクトルとして定義し、即座に音声に反映させることが可能になりました。また、この設計を応用することで、1つのモデルで複数キャラクターの音声を生成することもできるようになりました。

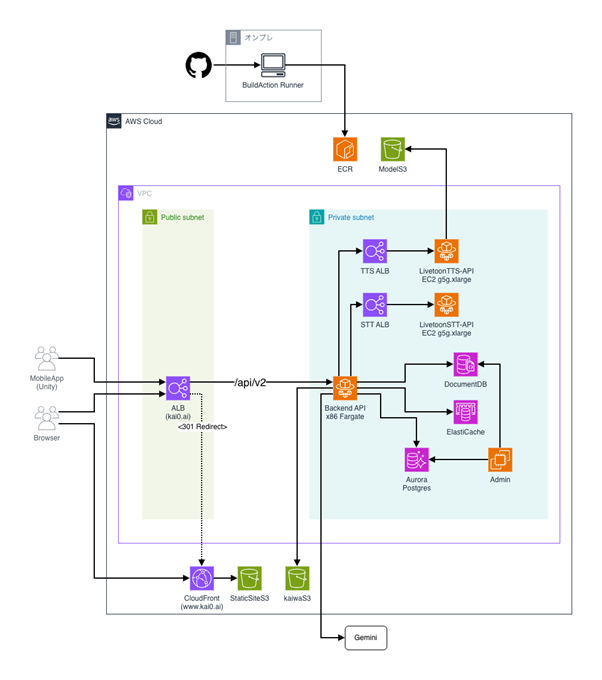

新アーキテクチャの全体像

土川:この新しいモデルのおかげで、旧来の TTS サーバーのスケーリング管理システムを廃止し、Amazon ECS の標準機能で代替することが可能になりました。結果として、非常にシンプルな構成を実現できました。

新アーキテクチャではバックエンド API を一本化して、開発言語も Python から C# へと変更しました。この C# で構築されたバックエンド上では、TTS や STT 以外の、RAG や感情分析を行う各種モデルが動いています。TTS や STT については、従来通り Python ベースのシステムとして運用しています。

今後は、TTS で生成した音声データのキャッシュを格納している Amazon ElastiCache を Amazon DynamoDB へと移行するなど、さらなるアーキテクチャの改善を目指しています。

成長の「天井」を越えるために、アーキテクチャの最適化を

小林:事業やシステムの今後の目標についてお聞かせください。

長嶋:会社のビジョンとしては、まず自社アプリ「kaiwa」をさらに成長させていきたいです。それに伴い、当社の強みである音声対話ソリューションを世界に提供していくことが、当面の目標です。

土川:エンジニアリングの観点では、会社の成長に直結するものをひたすら開発していくことが重要だと考えています。その上で、個人的に取り組みたいこととしては、AWS Graviton プロセッサをさらに活用し、一層のコスト削減を推進していきたいです。

AWS ジャパン 大越 雄太

大越:では最後に、読者のみなさまへ向けてコメントをお願いします。

長嶋:伝えたいことは 2 点あります。1点目は、AWS の方々は非常に親身にサポートしてくださるので、ぜひ積極的に相談してほしいということです。専門家に相談することで問題が迅速に解決したり、次のフェーズに向けたヒントを得られたりすることが多々あります。

また、技術的な支援だけではなく、AWS が主催するイベントに招待していただいたり、さまざまなステークホルダーの方々とつないでいただいたりといったビジネス的な支援も、スタートアップにとっては非常に魅力的です。私たちは先日テックイベント「AWS Unicorn Day Tokyo 2025」に出展したのですが、ここでも多くの方々との出会いがありました。

2点目は、そうした支援を受ける側の責任についてです。提案していただいた技術は検証し、かつ企業や人とのつながりも活かして、「紹介して良かった」と思っていただけるような成果を出すことが大事だと考えています。

土川:スタートアップは MVP 開発のフェーズでは、とにかくサービスを素早く立ち上げることが多いと思います。しかし、次の成長フェーズではコスト最適化が極めて重要になります。専門家のサポートを得ながら、AWS Graviton のような技術にも積極的に挑戦していくべきだと考えています。

小林:AI を活用したサービスでは「いかにして収益化するか」が課題です。事業をスケールさせていくフェーズではコスト削減が非常に重要になるため、どのようなアーキテクチャでコストを最適化していくかを慎重に検討する必要があります。何かお困りの際は、ぜひ我々にご相談ください。

大越:多くのスタートアップが、成長の過程で技術的負債やコスト構造が足かせとなり、成長が鈍化する「天井」にぶつかります。Livetoon 社は初期段階からその点を見据えて行動しているため、今後も天井にぶつかることなく、さらに成長されるだろうと期待しています。本日はありがとうございました。