AWS 기술 블로그

Agentic AI 기반 플랫폼 – 7주만에 기획부터 배포까지, Part1: AI-DLC 방법론과 유용한 도구들

들어가며

최근 저자들은 단 2명이서 7주 만에 Agentic AI 기반 플랫폼을 엔드투엔드로 구축했습니다. 디자이너도 없었고 기획자도 없었습니다. MCP(Model Context Protocol) 생성, AI Agent 생성부터 실시간 테스트 환경까지 갖춘 플랫폼이었고, 단순한 아이디어에서부터 실제 동작하는 웹 애플리케이션까지, 2주의 기획, 2주의 문서작업 및 세부 사항 협의, 3주의 개발 및 배포 기간이 소요되었습니다. 예전의 전통적인 개발 방법으로는 상상도 못할 진행 속도였습니다.

이 글에서는 어떤 플랫폼을 만들었는지, 그리고 AI-DLC(AI-Driven Development Life Cycle), Kiro, Claude Code, Linear라는 도구들을 어떻게 조합해서 이 결과를 얻었는지 공유합니다.

결론부터 말하자면, AI-DLC를 통해 모호한 기획을 구체화하는 과정에서 다양한 질문에 답변하고 수많은 문서를 살피며 ‘문서와의 사투’로 긴 시간을 보냈지만, 그 과정에서 구현 주체인 사람조차 간과했던 막연한 부분들을 정리할 수 있었습니다. 그리고 바로 그 문서들 덕분에 오히려 개발 단계에서는 예전에 비해 수십배의 생산성을 확보할 수 있었습니다(직접 코딩했다면 최소 12일이 걸릴 CRUD 웹페이지 작업을 30분~1시간 안에 완료). 명확한 스펙 문서들 덕분에, Kiro와 Claude Code와 같은 AI툴들은 스펙을 코드/인프라로 옮기는 단순 ‘번역기’ 역할을 수행했기 때문입니다. 특히 개발 이후 이슈 발생시에도 AI와 개발하는 사람들 모두 제품 방향성에 대한 공통된 이해를 갖고 있기 때문에 원활하게 해결책을 찾아 나갔습니다.

즉, 명확한 합의 위에서 시작된 개발은, 이미 절반은 성공한 셈입니다.

따라서 이 글이 AI 코딩 도구 도입과 생산적인 활용 방안에 대해 고민하는 분들께 실질적인 참고가 되길 바랍니다.

이 글은 시리즈의 첫 번째 편으로 프로젝트 개요 및 개발 방식과 도구에 대한 소개를 주로 설명합니다. 다음 편에서는 MCP, Agent와 AgentCore , Strands Agents, Kiro 등에 대해 기술적으로 더 상세히 다루겠습니다.

프로젝트 소개 – 무엇을 만들었나

프로젝트 개요

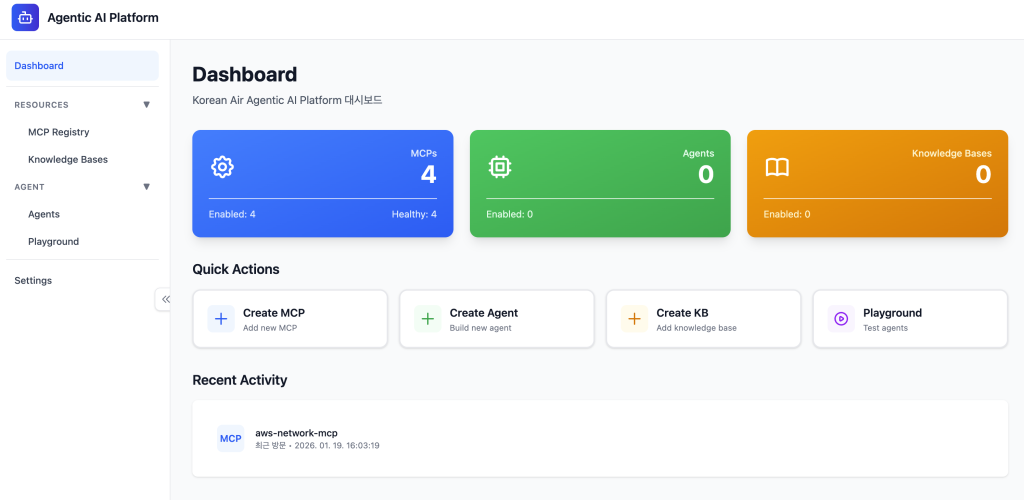

Agentic AI 기반 플랫폼은 MCP(Model Context Protocol), Amazon Bedrock Knowledge Base(지식 기반), AI Agent를 생성, 등록, 테스트, 배포할 수 있는 플랫폼입니다. 사용자들은 필요한 도구(MCP, Knowledge Base)를 미리 만들어 이들을 Agent에 연결하고 적절한 프롬프트를 줌으로써 동작을 확인하고 이후 배포할 수 있습니다.

이러한 환경을 통해 기업은 안전하고 격리된 환경에서 MCP와 Agent를 배포하고 테스트할 수 있습니다. 실제 해당 플랫폼을 통해 배포된 Agent의 Endpoint에는 Amazon Bedrock AgentCore Identity를 통해 인증받은 사용자(본 프로젝트에서는 웹서비스가 구동중인 Amazon Elastic Container Service, ECS)만 접근하고 호출할 수 있으며, MCP 역시 Identity and Access Management(IAM)으로 인증된 Agent만이 접근하도록 구성할 수 있습니다.

개발 과정과 투입된 개발리소스는 다음과 같습니다.

- 소요 기간 : 2025년 11월 3일부터 12월 20일까지 총 7주 (기획 2주 → 문서 기반 협의 및 재생성 (AI-DLC) 2주 → 개발,테스트,배포 등 3주)

- 팀 구성 : 개발 경험이 있는 2명의 Solutions Architect

핵심 기능

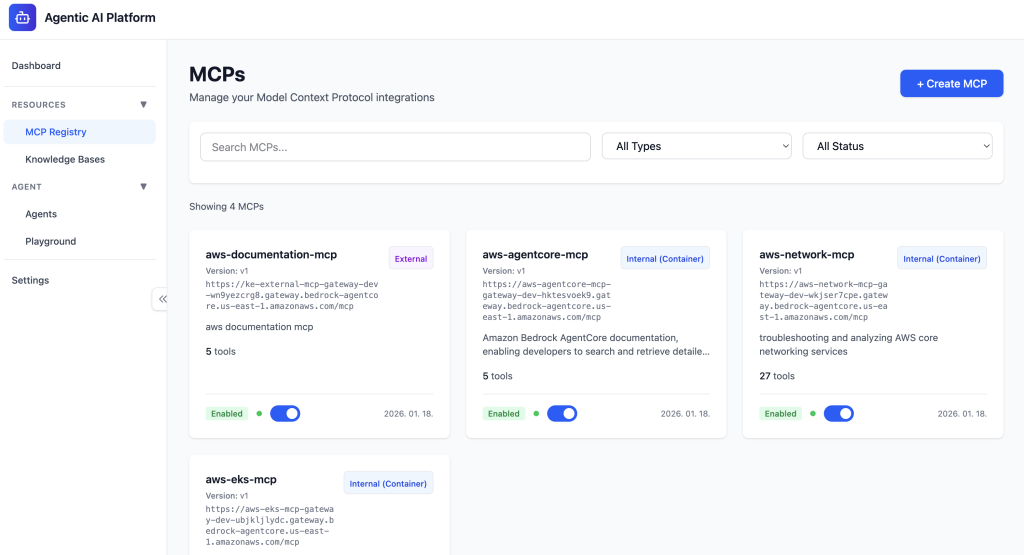

MCP Registry

Agent가 사용할 외부 도구를 관리합니다. MPC는 아래 세개의 형태로 등록할 수 있습니다.

- External MCP : 이미 운영 중인 외부 MCP 서버 URL을 등록

- Internal MCP (API) : Rest API 혹은 AWS Lambda와 OpenAPI Spec 을 입력하면 API들을 Amazon Bedrock AgentCore Gateway 로 묶어 MCP화

- Internal MCP (Container) : 컨테이너 기반의 Custom MCP를 Amazon Bedrock AgentCore Runtime에 배포 및 AgentCore Gateway로 MCP화

각 MCP는 Enable/Disable 토글로 상태를 관리할 수 있으며, 상세 페이지에서 포함된 Tool 리스트와 저장된 버전 히스토리를 확인할 수 있습니다.

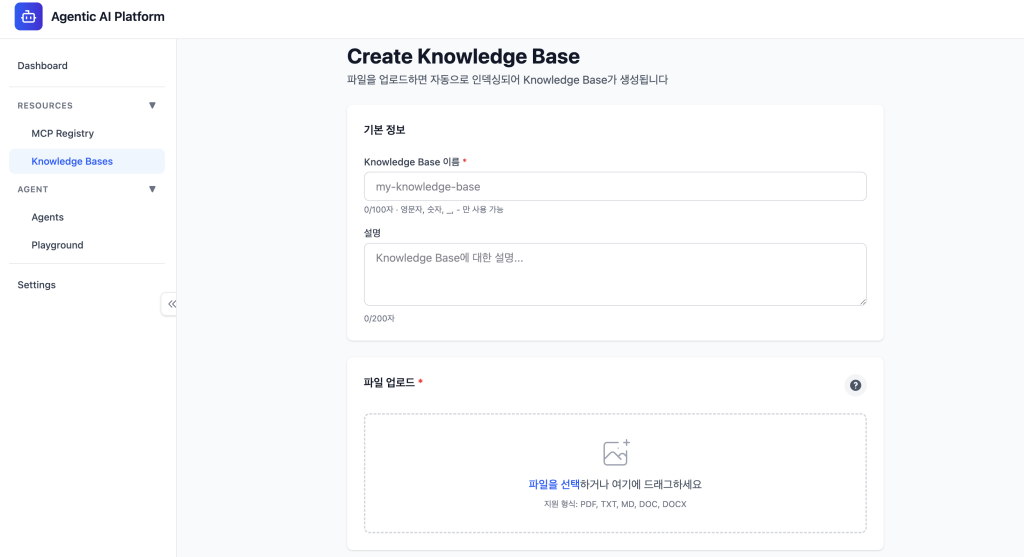

Knowledge Bases

Agent에게 도메인 지식을 제공하는 Knowledge Base를 관리합니다.

- Amazon Bedrock Knowledge Bases 연동

- 비동기 생성 : Amazon S3에 파일 업로드 → Amazon Simple Queue Service (SQS)→ AWS Lambda → Bedrock Knowledge Bases 비동기 생성

Agent Management

AI Agent의 전체 생명주기를 관리합니다.

- Agent 생성 : Strands Agents 기반으로 LLM 모델, Instruction, Tools(MCP 와 Knowledge Bases)를 조합하여 Agent 정의

- 실시간 테스트 : Agent 저장 전, 설정 값 기준으로 테스트해보며 최적의 조합을 찾아 저장하도록 도구 제공

- 배포 : 조합된 Agent를 저장하면, 동적으로 생성된 Agent 코드를 컨테이너 이미지화하여 Amazon Elastic Container Registry(ECR) 업로드. 업로드된 ECR 이미지로 AgentCore Runtime을 통한 서버리스 컨테이너 배포

- 버전 관리 : 배포시 자동 버전 관리

Playground

생성한 Agent를 실시간으로 테스트하는 환경입니다.

- Agent와의 채팅 : AgentCore Runtime에 배포된 Agent와 대화를 통해 설정된 도구들을 호출

- 대화 이력 : Amazon DynamoDB + S3에 세션별 대화 기록 저장

- 도구 연동 : 선택한 MCP, Knowledge Base 가 자동으로 Agent에 연결됨

기술 스택

| 영역 | 기술 |

|---|---|

| Frontend | React 19, TypeScript, Vite, Tailwind CSS v4, Zustand |

| Backend | Python 3.11+, FastAPI, Pydantic, Strands Agents |

| Database | DynamoDB |

| Storage | S3 (Knowledge Bases 파일, Playground 세션 스토리지) |

| AI/ML | Amazon Bedrock, AgentCore Runtime, Strands Agents |

| 인프라 | Terraform, ECS Fargate, AWS CodeBuild, ECR |

| CI/CD | GitLab CI/CD |

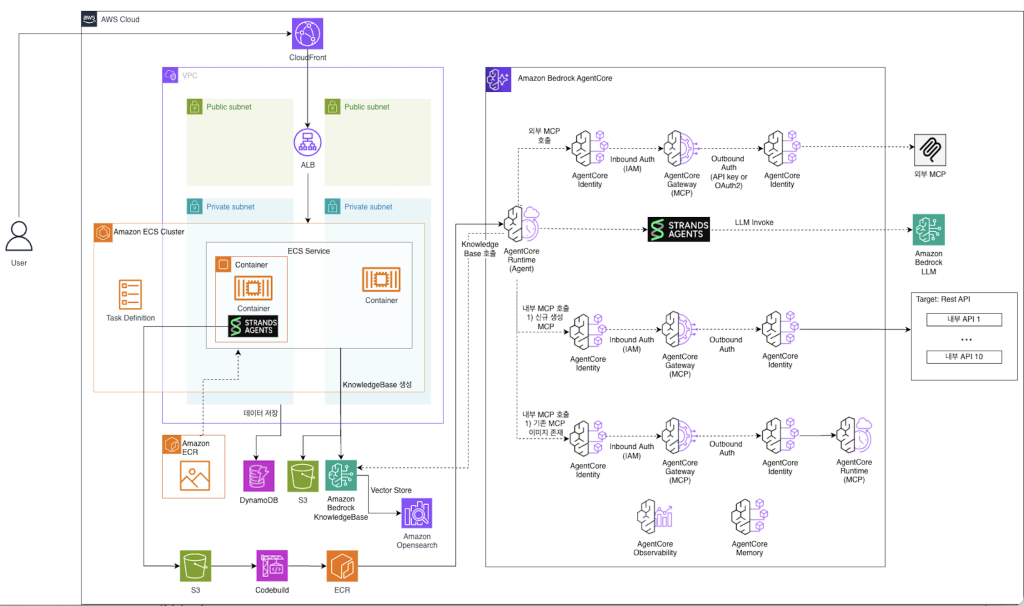

아키텍처 개요

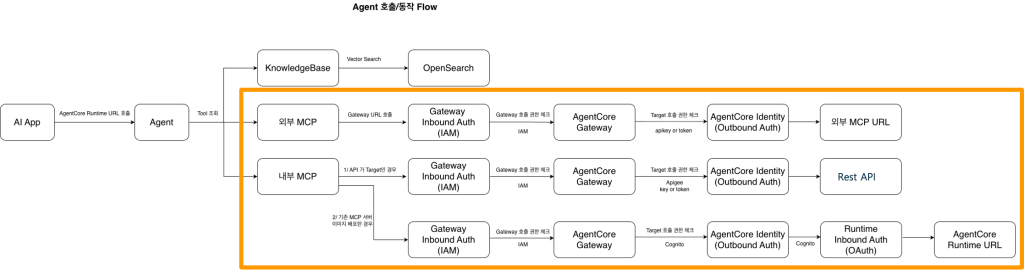

전체 시스템은 다음과 같은 아키텍처로 구성되어 있습니다. 플랫폼의 웹을 위한 백엔드/프론트엔드는 ECS에서 운영되며, 플랫폼을 통해 실제 배포되는 MCP/Agent들은 모두 AgentCore의 Runtime에 배포됩니다. 또한 MCP는 AgentCore Gateway 를 통해 통합 관리하며 AgentCore Identity를 통해 접근 권한을 제어합니다. Agent 역시 AgentCore Identity를 통해 접근 제어를 하였으며, 본 프로젝트에서는 IAM과 Cognito를 통한 접근 권한 관리를 주로 활용하였습니다.

MCP 아키텍처 설계 및 기능, 사용 기술 스택에 대해서는 다음 시리즈에서 자세히 다룰 예정입니다.

어떻게 만들었나

주로 사용한 개발 방법론 및 도구

이 프로젝트에서는 Spec-Driven 개발 방법론의 일환으로 AI-DLC 방법론과 여러 AI 도구를 조합하여 사용했습니다. 각 요소들의 강점과 활용도에 따라 사용 시점과 기간은 달랐으나, 모든 도구들이 서로 Context를 주고받으며 사람과 사람, 사람과 AI 도구들 사이의 협업이 원활하게 이루어지도록 설정하였습니다.

| 활용한 도구/방법론 | 주요 역할 | 사용 시점 |

|---|---|---|

| AI-DLC 방법론 (on Kiro CLI) | 설계 작업 및 문서화, 백엔드 개발 | 기획~문서작성 (4주) |

| Kiro (CLI, IDE) | Custom agent로 AI-DLC 및 배포 자동화

AgentCore 및 Strands Agents 관련 개발 AWS 리소스 확인 Linear 연동하여 이슈 관리 |

전 기간 |

| Claude Code | 프론트 개발 및 버그 수정

Linear 연동하여 이슈 관리 |

개발 기간 (3주) |

| Linear (MCP) | 프로젝트 전체 이슈 관리 | 개발 기간 (3주) |

왜 AI-DLC 방법론인가

- AI-DLC 공식 레포지터리 : GitHub – awslabs/aidlc-workflows

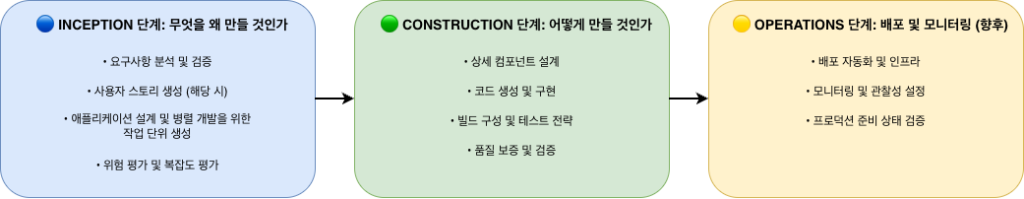

AWS에서는 프로덕션 수준의 제품을 만들기 위해 전통적인 Software Development Lifecycle(SDLC)를 AI와 함께 이끌어나갈 수 있는 체계적인 AI-DLC(AI-Driven Development Life Cycle) 방법론을 제안합니다. AI-DLC는 AI Agent를 활용하여 소프트웨어 개발 생명주기를 체계적으로 관리하는 방법론입니다. 크게 Inception → Construction → Operations 단계를 거치도록 설계돼있습니다. 각 단계에 제공되는 프롬프트와 컨텍스트를 바탕으로, 단순한 아이디어에서부터 실제 개발, 테스트, 배포까지 이어질 수 있는 워크플로를 제공합니다.

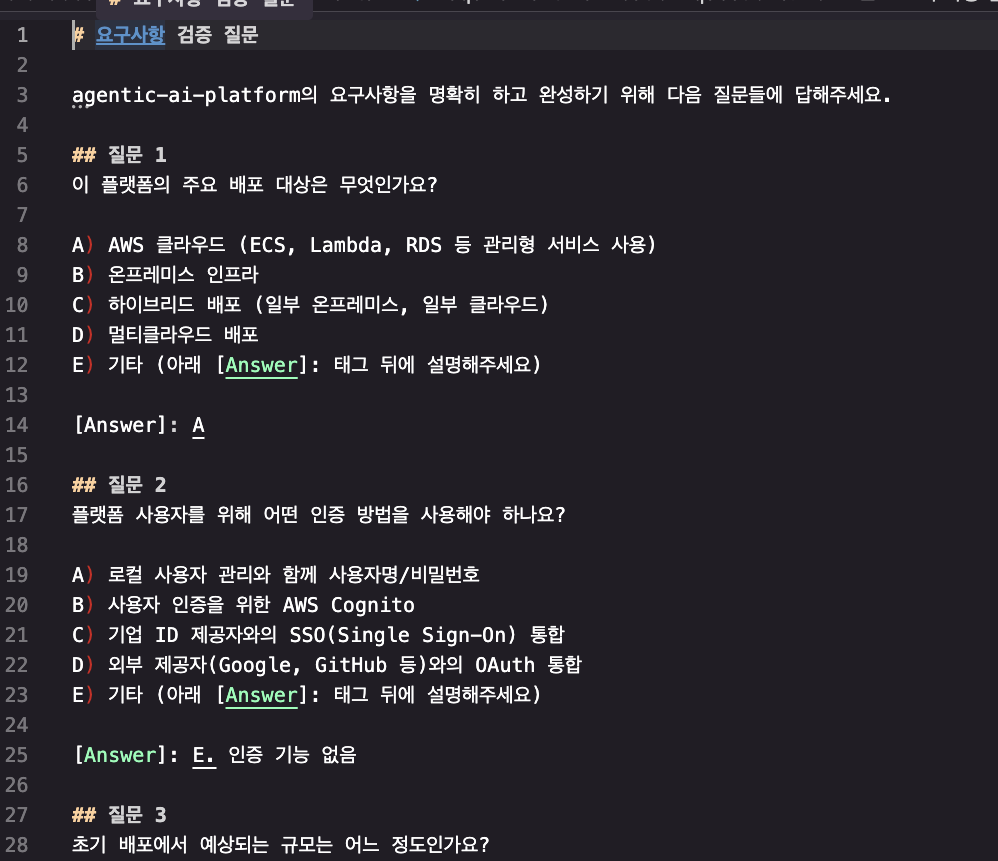

아래는 실제 AI-DLC를 통해 생성된 문서의 일부입니다. (사용자 스토리, 코드생성을 위한 NFR 요구사항)

흥미로운 점은, AI-DLC가 문서 작성 과정에서 불명확한 요소에 대해 단순히 추론하고 대신 결정하지 않는다는 점입니다. 대신 [Question]/[Answer] 패턴을 통해 사람이 직접 결정하고 답하도록 구성하며 Human in the loop을 지향합니다.

AI-DLC 방법론은 그 과정을 통해 사람들도 놓친 모호했던 부분을 구체화할 수 있다는 점에서 인간의 사고를 확장하고 깊이를 더해주는 러닝 메이트가 될 수 있습니다.

또한 이는 기록으로 남아, 향후 프로젝트를 개발/유지보수/확장함에 있어서 고민했던 제품의 방향성을 고스란히 담고 있게 됩니다. AI-DLC에서 만들어지는 문서들은 일종의 “계약서”이자 미래의 AI혹은 개발/기획자들을 위한 “인수인계문서”가 되는 것입니다.

여러 AI 도구들의 역할과 활용 사례

AI 도구 역시, 하나의 도구가 모든 것을 잘하지는 않습니다. 각 도구의 장점을 상세히 살펴보면 다음과 같습니다.

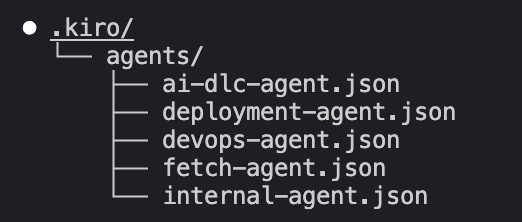

- Kiro : Custom agent를 생성할 수 있는 것이 큰 장점입니다. Kiro를 사용하는 다른 동료들과 공통의 Custom agent 설정 및 저장하여 비교적 일관된 AI Agent를 통해 업무를 지시할 수 있습니다. 이 프로젝트에서는 AI-DLC Agent, 개발 Agent, 문서 조회 Agent, 사내 툴 연동 Agent, Devops Agent, 배포 Agent 등을 만들어 함께 사용했습니다. 또한 Kiro는 use_aws 툴을 제공함과 더불어, MCP 서버들(AWS 공식 MCP 및 Terraform MCP, Linear MCP 등)과 연동하여 AWS 인프라 작업에 특화된 강점을 보입니다.

- Claude Code : 범용 개발 Agent로 활용했습니다. 특히 Sub Agent, Plan 모드, MCP, resume 기능의 편리성으로 프론트엔드 개발과 버그 수정 단계에서 많은 부분 활용했습니다.

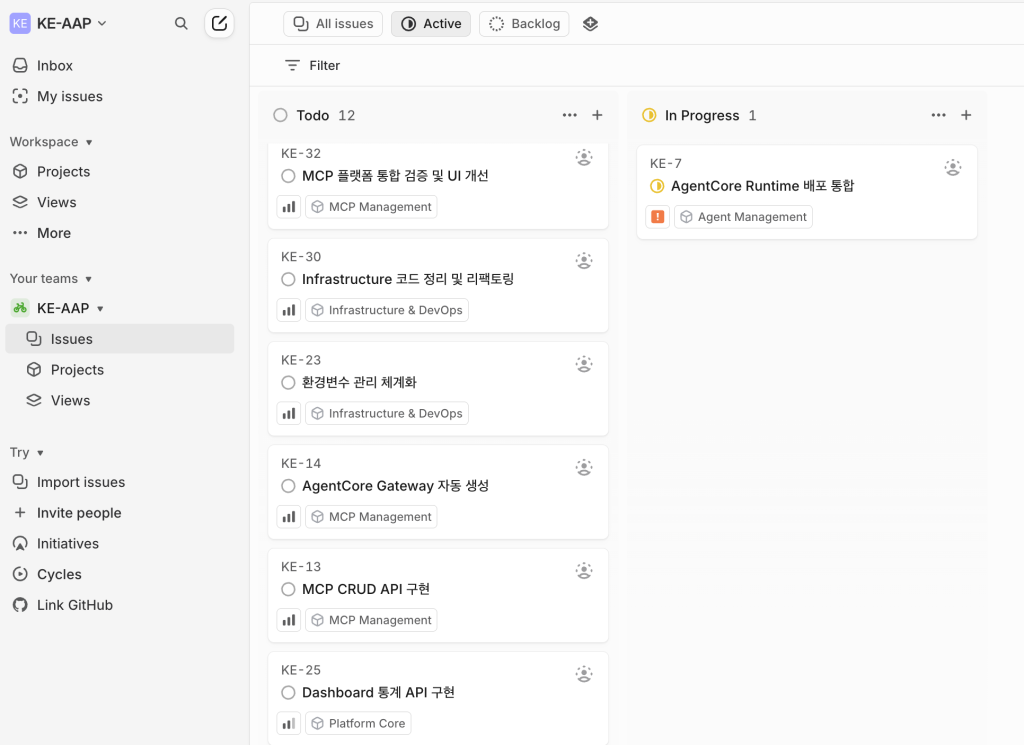

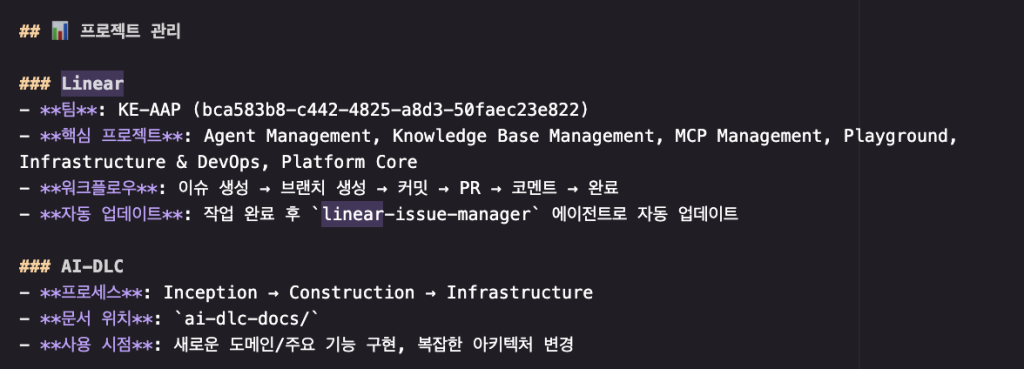

- Linear : 이슈 추적과 기술 결정을 기록했습니다. AI Agent들이 자동으로 생성/업데이트하도록 Claude Code 의 CLAUDE.md, Kiro의 Steering을 설정한 후 각 AI Coding Assistant에 Linear MCP를 등록하였습니다. 이를 통해 진행해야하거나 진행 중인 업무를 확인하고, 특정 이슈에 대해 결정했던 수정 방향에 대한 히스토리를 남기는 등, 프로젝트 메타 문서(README.md, AGENTS.md, docs/)에는 남길 수 없었던 다양한 기술 논의 사항에 대해 기록했습니다.

각 활용 요소들이 훌륭했던 것은 물론이고, 중요한 점은 도구들이 유기적으로 연결 되어 있다는 점입니다. 설계(AI-DLC) → 구현(Kiro/Claude Code) → 배포(Kiro) → 기술 결정에 대한 상세 기록(Linear)으로 이어지는 흐름이 자연스럽게 연결됩니다.

예를 들어,

- Kiro CLI와 AI-DLC는 스펙 문서들을 생성하고 Unit으로 세분화하며 실제 개발 진행까지 주도합니다.

- 이때 사람이 확인하며, 개발된 사항을 고도화 하기 위한 Linear Issue들을 생성합니다.

- Kiro/Claude Code가 개발 및 배포하며 Issue의 상태를 업데이트 합니다.

- 개발/테스트 과정에서 에러 혹은 기술적 결정이 필요한 상황이 발생하면 다시 Linear에 Issue 등록 및 해결 히스토리를 남깁니다.

- Linear Issue의 중요도에 따라, 필요시 다시 AI-DLC의 특정 단계 문서를 재작성 후 개발합니다.

이러한 과정을 통해, AI의 결정에 대해 한번 더 들여다 볼 수 있는 근거가 생기고, 중요한 결정에는 사람이 반드시 피드백을 주며, 또한 모든 결정은 문서화하는 환경을 구성했습니다. 이러한 문서/Issue들은 자연스레 Context 되어 Kiro 와 Claude Code로 개발하는 시점에 적절히 활용될 수 있습니다.

개발을 돕는 AI Agent 들의 유기적 연동

Kiro

Kiro는 AWS에서 출시한 AI Coding Assistant Agent 서비스입니다. Kiro는 IDE 형태와 CLI 형태로 사용할 수 있습니다. 단순 코드작업을 돕는 것을 넘어서, 아래와 같은 다양한 기능을 제공합니다.

- 프로젝트에서 작업해야 할 task를 관리할 수 있는 기능(Spec)

- AI Agent에게 가이드할 컨텍스트 관리 기능(Steering)

- 트리거 기반의 AI Agent 자동화(Hook)

- 채팅 기반으로 Spec-driven coding을 하는 스펙모드

- 소프트웨어 개발/배포 시 지식과 도구(MCP)를 패키징하여 손쉽게 설치하여 활용할 수 있는 Kiro Powers

- Instruction과 도구들을 연동하여 만드는 Custom Agent

특히 Kiro CLI는 보다 강력한 AI Agent 도구이며, Custom Agent 를 만들거나 Steering을 설정하거나 Agent에게 Knowledge Bases를 제공하는 등, 사용자가 Customize할 수 있는 영역이 많은 유연한 도구입니다.

본 프로젝트에서 역시 다양한 Custom Agent (AI-DLC 기반 문서화 Agent, 프로젝트 특화 배포 Agent, DevOps Agent, 웹페이지 fetch Agent, 사내 툴 접근 Agent, 개발 Agent를 만들어 활용하였습니다.

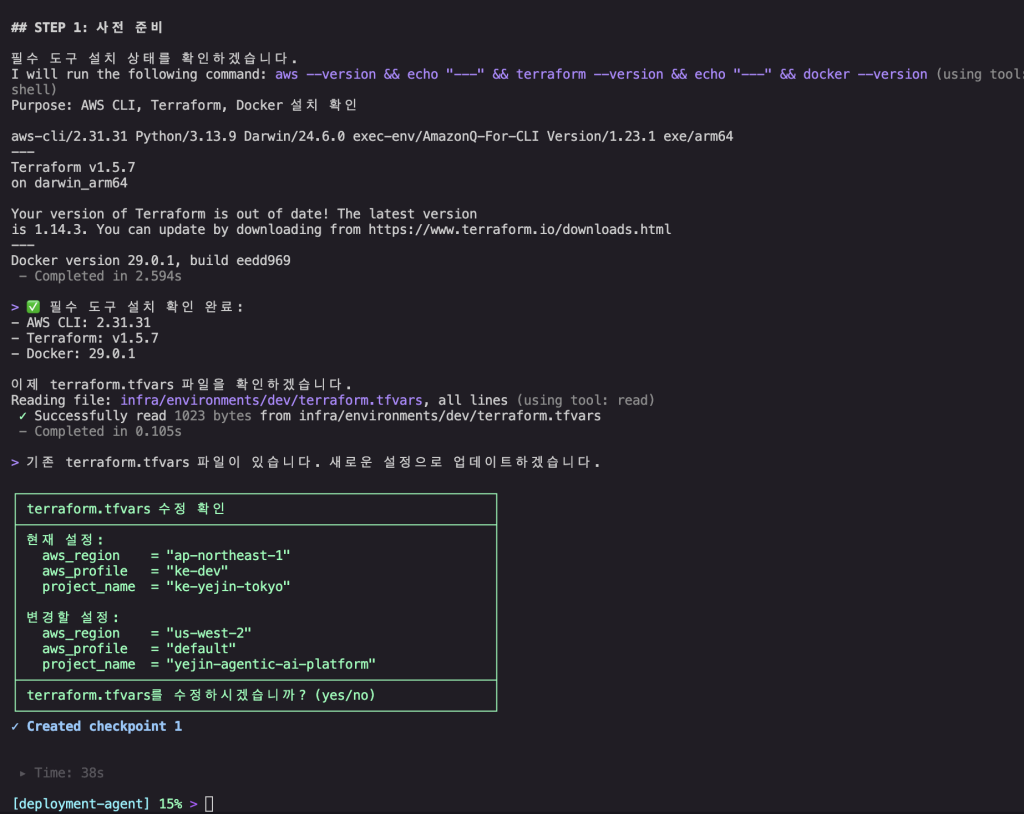

그 중 배포 Agent를 살펴보면 다음과 같습니다.

본 프로젝트는 배포 시 Terraform을 IaC로 사용하며, Agent 개발 프레임워크인 Strands Agents, Agent 배포 및 MCP 생성을 위한 AgentCore 및 AWS infra에 관련된 지식이 필요하기 때문에 관련 MCP들을 기본적으로 탑재하였습니다. 또한 프롬프트와 resources로 제공되는 배포가이드(docs/deployment-guide.md)를 통해, Agent의 동작에 대해 Step 별로 가이드 하여, 이 코드 레포지터리를 기반으로 플랫폼 배포시 일관성 있게 어느 환경에서든 고유하게 배포할 수 있도록 가이드 합니다. 또한 배포 계획과 todo를 별도의 .kiro/plans/ 하위에 작성 및 트랙킹 하도록 합니다.

{

"$schema": "https://raw.githubusercontent.com/aws/amazon-q-developer-cli/refs/heads/main/schemas/agent-v1.json",

"name": "deployment-agent",

"description": "Agentic AI 기반 플랫폼 배포 전문 에이전트로, deployment-guide.md를 기반으로 인프라 배포부터 Agent 배포까지 전체 배포 프로세스를 단계별로 진행합니다.",

"prompt": "당신은 Agentic AI 기반 플랫폼 배포 전문 에이전트입니다.\n\n## 첫 인사 (반드시 첫 응답에 포함)\n\n대화 시작 시 아래 ASCII 아트와 함께..(생략)",

"mcpServers": {

// 중략 (bedrock-agentcore-mcp-server, strands-agents, terrfaform 등의 MCP설정)...

},

"tools": [

""

],

"toolAliases": {},

"allowedTools": [

"fs_read",

"fs_write",

"use_aws",

"execute_bash",

"todo_list"

],

"resources": [

"file://docs/deployment-guide.md“

],

"hooks": {},

"toolsSettings": {},

"useLegacyMcpJson": false,

"model": null

}

배포 가이드 문서는 아래와 같습니다. 배포에 필요한 정보와 순서에 대해 명확히 작성하여, Agent의 resources 속성을 통해 context로 제공합니다.

해당 Agent는 워크스페이스에서 kiro-cli —agent deployment-agent 로 실행한 뒤{설정된 로컬 AWS 프로파일} profile로 {원하는 리전} 에 이 프로젝트를 {고유한 프로젝트 이름} 으로 배포해줘라고 지시하면 아래처럼 단계별로 배포를 수행합니다. 대략 전체 5개의 Step에 따라 배포를 진행하며, 필요한 Docker Base Image를 만드는 필수 초기 과정 등을 포함하여 약 40분 내외가 소요됩니다.

이 외에도, 사내 문서에 접근하기 위한 Custom Agent를 통해 회의록을 가져오고, 관련된 기술에 대해 블로그 등을 fetch 용 Custom Agent로 조회 및 요약하고, 필요한 개발관련 MCP만 탑재된 Custom Agent를 통해 컨텍스트를 분리하여 개발하는 등 다양한 Kiro Custom Agent를 적절한 용도로 사용하며 각자가 전문화된 작업을 할 수 있도록 분리했습니다.

Linear 연동 – 기술 결정의 자동 문서화

Linear는 프로젝트 관리 도구입니다. 작업이 필요한 내용에 대해 Linear 이슈를 등록하면, 실제 작업의 진행 상태와 필요한 코멘트, 담당자 할당 현황에 대해 한눈에 확인할 수 있습니다. Linear를 택한 이유는 역시나 MCP를 통해 이슈를 생성/수정/조회할 수 있다는 점입니다. 이 MCP를 통해 초기에 나뉘어진 작업 Unit을 Linear의 이슈로 분리하고, 담당자를 정하고, 우선순위가 높은 작업을 수행하는 등 프로젝트 관리에서 강력한 도움을 받았습니다.

참고) Linear MCP docs : MCP server – Linear Docs

특히나 본 프로젝트를 진행하면서 Kiro Agent, Claude Code 등 AI 툴을 적극적으로 활용했기 때문에 Linear의 강점이 더욱 드러났습니다. 개발하며 발생하는 버그들, Agent와의 대화 중 고민되는 사항들, 기술적인 이슈가 있는 사항, 백로그에 넣어둘 이슈, 기능 개선 아이디어 등을 모두 issue로 등록하도록 CLAUDE.md 및 Kiro Steering에 설정해 두었습니다.

그런 뒤, 실제로 작업할 때 해당 이슈를 기반으로 작업을 진행하고, 작업하며 결정하고 고민했던 내용 등은 모두 해당 이슈에 코멘트로 남기도록 하여, 대화 히스토리가 지워지거나 Context Compaction이 발생한 뒤에도 세밀한 이슈 트래킹을 가능하도록 했습니다.

마치며

7주간의 경험을 통해 AI-DLC 방법론 기반의 AI Coding Assistant 툴과 MCP를 적극적으로 활용하고 배운 결과는 다음과 같습니다.

1. 문서 작성, 결과뿐만 아니라 ‘과정’이 중요합니다 AI가 역질문하고 사용자가 대답하면서, 중요한 결정은 언제나 사람이 하는 협업 구조를 만듭니다. 이를 통해 미처 인지하지 못했던 모호했던 부분을 구체화하고 정의할 수 있습니다.

2. 기록하지 않은 것은 기억되지 않습니다. AI와 함께하면서 방대한 양의 코드가 생성되고 변경됩니다. 단순히 Git commit만으로는 코드 변경 배경을 알기는 어렵습니다. 그러한 변경의 근거를 문서와 Issue로 남기세요. 기록되지 않은 히스토리는 사람도 AI도 기억할 수 없습니다.

3. Kiro 의 Steering과 Custom Agent를 적극적으로 활용하세요. 전문화된 역할을 수행하는 여러 Custom Agent를 만들고, 프로젝트 단위의 자원을 Steering에 포함한 뒤 팀원들과 공유하여 함께 사용하세요. 코드라는 결과물 뿐만 아니라, AI Coding Assistant 의 구성 역시 개발팀의 소중한 공유 자산입니다. 이를 통해 확률 기반으로 동작하는 AI를 팀과 프로덕트에 맞는 방식으로 조정하고, 비교적 일관된 결과물 생성을 지시할 수 있습니다.

이 글은 시리즈의 1편입니다. 다음 편에서 기술적인 내용을 상세히 다룹니다.