このコンテンツはいかがでしたか?

- 学ぶ

- Proto が Amazon Bedrock で最先端のアバターに命を吹き込む方法

Proto が Amazon Bedrock で最先端のアバターに命を吹き込む方法

.png)

オーストラリアの患者は、英国の医師による緊急の専門医療を必要とします。ロボット企業は、機械を輸送する手間をかけずに、最新の発明品を潜在的な投資家にデモンストレーションする必要があります。新しいホテルは、プレミアムな体験でゲストを驚かせたいと考えています。Proto は、生成 AI を搭載したホログラムにより、これらすべてのこと、そしてそれ以上のことを実現します。

Proto は生成人工知能 (AI) を活用してリアルなアバターを作成し、それを印象的な 7 フィートのホログラムマシンに送ります。アバターは本物の会話をしたり、情報を提供したり、タスクを支援したり、楽しませたりすることができます。広告や小売、エンターテインメント、交通、ホスピタリティ、教育、トレーニング、ヘルスケアなどの業界で既に活躍しており、フォーチュン 500 企業や世界で最も有名なスポーツチームやセレブリティにサービスを提供しています。

そのため、緊急治療を必要とする患者は、何千マイルも離れた専門医が遠隔で診察を受けることができます。ロボット企業は、高価な機器の輸出に伴うコストや複雑さに悩まされることなく、最新の製品を披露できます。また、ホテルでは、実物大のチャットボットでゲストを迎え、パーソナライズされたデジタルコンシェルジュサービスを提供することで、競合他社との差別化を図ることができます。

これらのユースケースにはそれぞれ、特性 (コスト、レイテンシー、精度など ) があり、ある基盤モデル (FM) を他のモデルよりも優先して選択しなければなりません。そのため、Proto は特定のユースケースに基づいて AI で強化されたアバターの実験、テスト、適応を容易にするソリューションを必要としていました。Amazon Bedrock への移行によってこのソリューションが提供され、Proto は評価、実験、デプロイ、カスタマイズが容易な FM の幅広い選択肢にアクセスできるようになりました。

Amazon Bedrock による改善と合理化

この分野のリーダーであるにもかかわらず、より低いレイテンシー、よりリアルなエンゲージメント、より正確なエンゲージメントを求める市場の要求に応えるため、Proto は AI アバターを改善する方法を模索していました。Proto のアバターは、何千人もの視聴者にブロードキャストしたり、1 人のユーザー向けにカスタマイズしたり、リアルタイムの情報を伝えたり、高度なトレーニングを提供したりすることができます。目的や業界が何であれ、ユースケースに合わせたアバターペルソナを提供しながら、高度なリアリズム、正確さ、セキュリティを提供する必要があります。例えば、バーチャルホテルのコンシェルジュはゲストの体験を向上させるために特定の微調整が必要ですが、バーチャル美術教師は言語を絵に加工する柔軟性を必要とします。

重要なのは、Proto がアプリケーションの構築と管理のプロセスを合理化したいとも考えていたことです。これは、Proto が過去にさまざまなサービスやツールを使用していたために複雑になっていました。一連の AWS のサービスを使用していましたが、構築には別のプロバイダーを使用していたのです。

生成 AIは急速に進化する分野であり、プレーヤーは製品を革新し続け、顧客に最高のサービスを提供することを求められています。そのためには、手間のかかる作業を支援する柔軟なツールに支えられた人的時間とリソースが必要です。Proto のレガシー環境は複数のソリューションに分散されていたため、既存の AWS のサービスの管理や新しい AWS のサービスのデプロイが困難でした。Amazon Bedrock ベースのアプローチにより、Proto はアバターを継続的に反復処理し、リアルタイムのユーザーインタラクションに基づいてアバターを適応させることができます。これにより、コンテンツがどのコンテキストにも常に適切であることが保証されます。例えば、Proto は特定のトピックが適切かどうかをその場で判断し、やり取りの途中でガイドライン (ガードレールと呼ばれる) を設定して、これらのエンゲージメントを安全に保つことができます。

これらの要因と最新の生成 AI ツールの必要性から、Proto は Amazon Bedrock の Anthropic のClaude に移行することを決定しました。これにより、同社では AI アバターとその作成プロセスを改善することができました。

Amazon Bedrock を使用する理由

Amazon Bedrock は、単一の API を通じて種々の高性能な基盤モデルを提供するとともに、スタートアップがセキュリティ、プライバシー、責任ある AI により生成 AI アプリケーションを構築するために必要な幅広い機能を提供するフルマネージドサービスです。

Amazon Bedrock により、さまざまなユースケースに最適な FM を簡単に試して評価したり、微調整や検索拡張生成 (RAG) などの手法を使用して独自のデータでプライベートにカスタマイズしたり、独自のエンタープライズシステムとデータソースを使用してタスクを実行するエージェントを構築したりできます。

Amazon Bedrock はサーバーレスでもあるため、スタートアップはインフラストラクチャを管理する必要がありません。また、使い慣れた AWS のサービスを使用して、生成 AI 機能をアプリケーションに安全に統合してデプロイできます。

移行の仕組み

Proto は Amazon Bedrock に移行し、主要なカンファレンスで会話型アバターのデモンストレーションをするために、Amazon Bedrock で視聴できる FM である Anthropic の Claude Instant を選びました。同社はこのモデルを微調整して AI アバターを最適化し、インタラクションを設定、対象者、コンテキストに適したものにするためのガードレールを設置しました。

Amazon Bedrock により、Proto は次の開発段階に進む前にさまざまな FM のパフォーマンスをテストできました。つまり、各ユースケースで最も費用対効果の高いソリューションを選択できたということです。これは簡単なプロセスだったので、ワークフローやデプロイパイプラインには影響しませんでした。どちらも AI 開発の最前線に留まりたいスタートアップにとって重要です。Proto の最高製品責任者兼 AI 責任者である Raffi Kryszek 氏は、「Amazon Bedrock のおかげで、コードを 1 行変更するだけで、さまざまな基本モデルから調達したアバターのパフォーマンスをテストできました」と説明しています。

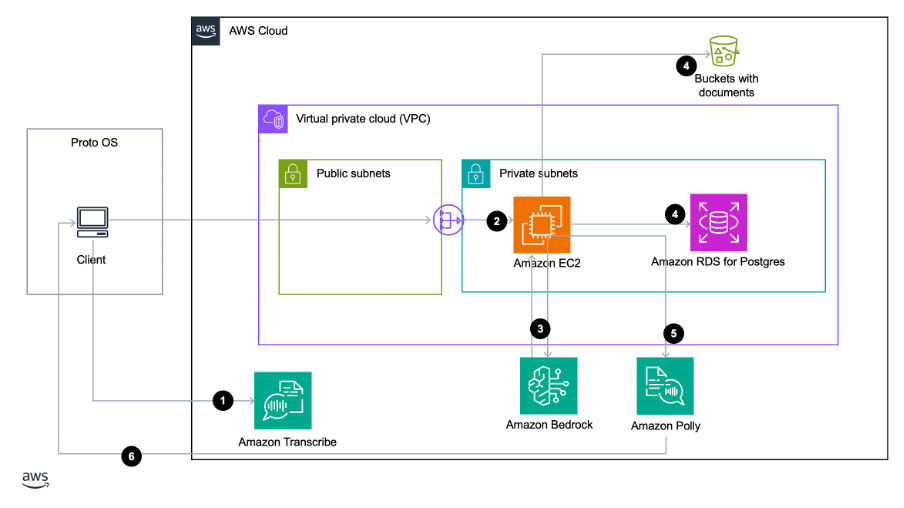

Proto はまた、テキストを本物そっくりの音声に変換するクラウドサービスである Amazon Polly と、音声をテキストに自動的に変換する音声認識サービスである Amazon Transcribe もデプロイしました。これにより、日本語、韓国語、スペイン語などのさまざまな言語での会話をサポートするようにソリューションを柔軟に調整できるようになりました。

提供されるサービスの範囲に加えて、Amazon Bedrock の特定の機能により、移行中のスムーズなプロセスが保証され、Proto は成長に合わせて最新の生成 AI ツールに迅速に適応して活用できるようになりました。

移行の要点は、API の再構成でした。Proto のユーザーインターフェイスと Amazon Bedrock サービス間のシームレスな通信を確保するために、両方のシステムの内部動作を深く掘り下げる必要がありました。Proto の技術チームは Amazon Bedrock API を使用してコードをすばやくリファクタリングし、Claude 独自のプロンプトフォーマット技術を使用してアバター応答の品質を高めました。

この移行は、モデルの応答を制御するようにパラメータを調整するという推論パラメータのカスタマイズに対するプロトのアプローチに極めて重要な変化をもたらしました。このプロセスでは、Amazon Bedrock の API 機能を包括的に使用し、チームは応答生成を微調整するために豊富な設定オプションを活用しました。これには、温度とトップ K の設定が含まれていました。

温度をより適切に処理することで、創造性と忠実性をより細かく制御できるようになります。ヘルスケア企業が医療情報を提供するために使用するような情報提供型 AI アバターの場合、Proto は正確性と関連性を優先して、より低い温度設定を選択できます。このように温度を調整できるということは、Proto がさまざまな種類の AI アバターを導入するさまざまな顧客のニーズを満たすために、より細かいアプローチを取ることができるということです。重要なのは、Amazon Bedrock によってユーザーに課せられる技術的要求が軽減されるため、チームがこれを以前よりもはるかに迅速かつ簡単に行えるようになったことです。

Proto は、トップ K 設定の制御に関しても、キャリブレーションプロセスの精度を高めることができます。温度と同様に、トップ K 設定は、調整してモデル応答を制限したり影響を与えたりすることができる推論パラメータのもう 1 つのカテゴリです。

トップ K は、モデルがシーケンス内の次のトークンについて検討する最も可能性の高いオプションの数です。これは文中の次の単語になる可能性があるため、テキスト生成を制御し、テキストの一貫性と正確性を確保する上で、トップ K の設定が重要になります。値を小さくすると、モデルが選択できるオプションのプールのサイズが、最も可能性の高いオプションに縮小されます。これは、技術文書など、より予測可能で焦点を絞ったアウトプットに利用できる可能性があります。値が大きいほどこのプールのサイズが大きくなり、モデルでは可能性の低いオプションを検討できるようになります。これはクリエイティブなストーリーテリングに利用でき、物語の豊かさと予測不可能性を高めるために、より多様な単語の選択肢が望まれる場合に使用できます。

この機能を活用することで、Proto はユースケースに応じてさまざまな AI アバターの出力を慎重にカスタマイズし、パフォーマンスと品質を最適化することができました。

最後に、Proto は Claude のプロンプトエンジニアリング能力の恩恵を受けました。チームはパラメータ調整の一連のベストプラクティスを開発し、AI の応答性と関連性を高めました。このオーダーメイドのアプローチは、基盤となる AI モデルの能力と制約を理解することの重要性を浮き彫りにしています。そうすることで、デベロッパーがこのテクノロジーを十分に活用して、デプロイする AI アバター、対象者、ニーズなどの特定の要件を満たすことができるようになります。

高レベルアーキテクチャの実装

Amazon Bedrock を使用することで、Proto は AI アバターがユーザーのクエリに応答する方法を改善することができました。アーキテクチャは、ユーザーが質問を投げかけるところから始まり、その質問が Amazon Bedrock に転送されます。RAG プロセスでは、リアルタイムのユーザー入力と、Proto 独自のデータや外部データリポジトリからの深いインサイトが統合されます。これにより、正確で関連性の高いプロンプトが生成され、クエリを提起したユーザーに合わせてパーソナライズされた会話が可能になります。

Proto は埋め込みのチャンクサイズを選択できるため、AI アバターが提供する応答で使用する情報の量を増減できます。埋め込みは小さいほど、プロンプトに多くの記憶を追加できるパーソナルアシスタントなどのアプリケーションに最適です。一方、埋め込みサイズが大きいほど、情報が散らばらないように文書が分かれている場合に便利です。

プロンプトが拡張されると、Claude を含む厳選された高度な AI モデルによって処理されます。各 Proto アプリケーション内では、一意のアバター ID がこれらのクエリを指示し、適切なデータベースを参照することで、正確で状況に応じた応答が可能になります。

その後、応答が Amazon Polly に送信され、アバターが話す各単語が正確なリップシンクで視覚的に表現されるだけでなく、高速で配信されるので、視覚的にもインタラクティブ的にもシームレスな応答が得られます。AI アバターがユーザーに話しかけると、より人間のように見え、会話は限りなくリアルタイムに近いものになります。

まとめ

移行の結果、Protoは現在、最先端の生成 AI ツールを使用して、最も革新的な生成 AI アプリケーションを顧客に提供しています。フルマネージドサービスとして Amazon Bedrock に切り替えたことで、Proto のチームは複数の基本モデルをサポートするためのソリューションの再設計に時間を費やす必要がなくなりました。これで、チームはエンドユーザーのニーズに合わせて製品を構築、スケーリング、最適化し、結果としてスタートアップを成長させるという、重要なことに集中できるようになりました。

これらの製品の最適化は既に明らかになっています。Proto は、マネージドマイグレーションの一環として API の再構成に注力することで、アバターの機能を強化し、会話型 AI 技術の最前線に留まるようにしています。これらをさまざまな分野に合わせて調整し、そのスピードを高めることによって、同社は幅広い顧客ベースにより良いサービスを提供し、競争力のあるスピードで複数の業界に進出することができます。

ワークロードとアプリケーションの AWS への移行は、ほんの始まりに過ぎません。Proto はこれをさらに一歩進めて、AWS の生成 AI 機能を適応させ、活用しています。現在、この分野のリーダーが提供するツールの調整から、顧客に有意義なエンゲージメントをもたらすテクノロジーの導入まで、ワークフロー全体でこれらの機能を利用しています。

AWS への移行により、チームの (技術的) 負荷が軽減され、創造力が拡大し、セキュリティ、プライバシー、責任ある AI を備えた独自の生成 AI アプリケーションの構築、スケーリング、デプロイがより簡単になりました。生成 AI の導入を検討しているスタートアップでも、現在のワークフローや製品を最適化して強化したい場合でも、AWS Migration Acceleration Program は選択肢を模索し、Amazon Bedrock がどのように役立つかを詳しく知るのに役立ちます。

Shaun Wang 氏と Tony Gabriel Silva 氏による寄稿記事

Aymen Saidi

Aymen is a Principal Solutions Architect in the AWS EC2 team, where he specializes in cloud transformation, service automation, network analytics, and 5G architecture. He’s passionate about developing new capabilities for customers to help them be at the forefront of emerging technologies. In particular, Aymen enjoys exploring applications of AI/ML to drive greater automation, efficiency, and insights. By leveraging AWS's AI/ML services, he works with customers on innovative solutions that utilize these advanced techniques to transform their network and business operations.

Hrushikesh Gangur

Hrushikesh Gangur は、AWS 機械学習とネットワーキングサービスの両方の専門知識を備えた、AI/ML スタートアップのための Principal Solutions Architect です。生成系 AI、自律走行車、ML プラットフォームを構築するスタートアップが AWS 上で効率的かつ効果的にビジネスを運営できるようサポートしています。

Nolan Cassidy

Nolan Cassidy is the Lead R & D Engineer at Proto Hologram, specializing in holographic spatial technology. His pioneering work integrates AI and advanced communication systems to develop low-latency, highly interactive experiences, enabling users to feel present in one location while physically being in another.

このコンテンツはいかがでしたか?