Amazon Web Services ブログ

AWS で NVIDIA Cosmos world foundation models を実行

本記事は 2025/11/24 に公開された “Running NVIDIA Cosmos world foundation models on AWS” を翻訳したものです。

自律走行車、ロボティクス、スマートファクトリー向けのフィジカル AI システムの開発においては、高品質かつ十分なトレーニングデータを生成するということが非常に重要な課題となります。このブログでは、Amazon Web Services (AWS) 上で NVIDIA CosmosTM ワールドファウンデーションモデル(WFM)をデプロイして、大規模に高品質の合成データを生成する方法を示します。また、異なるユースケースに最適化された 2 つの本番環境向けアーキテクチャを紹介します。

フィジカル AI により、システムは複雑かつ動的な環境で知覚、感知、推論、および自律的な行動ができます。しかし、これらのモデルの事前トレーニングと事後トレーニングには、膨大な量の高品質な実演例が必要です。ビデオからの既存の実演例や、人間が作成する新しい実演例は限られており、十分なデータを提供できません。合成データの生成は、このデータギャップの課題を克服し、フィジカル AI を進化させて、業界全体でビジネスを変革する高度な新しい行動を可能にするために重要です。

Cosmos オープン WFM はこのギャップを埋め、シナリオの合成、ドメインのランダム化、および空間推論を通じて、自律走行車、ヒューマノイドロボット、スマートファクトリー、およびビデオ分析 AI エージェント向けのフィジカル AI の開発を可能にします。Cosmos モデルを最大限に活用するには、慎重に設計され、構成された管理インフラストラクチャが必要です。このインフラストラクチャは、スケーラブルでコスト効率が高い必要があります。

このブログでは、AWS インフラストラクチャ上で Cosmos WFM をデプロイするためのシステムアーキテクチャと実装のベストプラクティスを紹介します。これにより、エンタープライズグレードのスケーラビリティ、セキュリティ、パフォーマンスを実現します。また、コスト効率性、簡単な管理、および再現可能なデプロイメントも提供します。

フィジカル AI データパイプラインの課題

大規模言語モデル(LLM)は、インターネット上の何十年にもわたるデジタル化されたテキスト、書籍、ウェブサイト、ビデオ、会話などの事実上無制限のトレーニングデータを利用しています。この膨大なコーパスにより、モデルはスケールで言語パターン、推論、および知識表現を学習できます。しかし、フィジカル AI システムは根本的に異なる課題に直面しています:「データ不足問題」です。

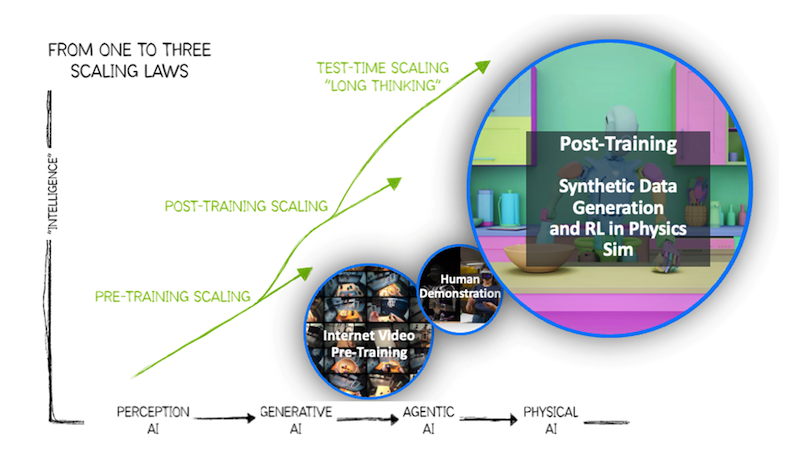

図 1: フィジカル AI のための合成データ生成の進化

インターネット上のテキストとは異なり、物理的相互作用のデータは不足しています。オブジェクトを操作したり、環境をナビゲートしたり、器用なタスクを実行したりするには、行動をクローンする模倣学習などの現在の技術が必要です。これには、実際の物理的相互作用で取得された現実のセンサーデータ(カメラ映像、力の測定、感覚フィードバックなど)が必要です。このデータを収集するにはコストや時間がかかり、しばしば危険です。

そこで合成データの生成が不可欠になります。Cosmos WFM は物理的に妥当性のあるシナリオを合成します。これには、写実的な光の変化、オブジェクトのテクスチャ、カメラアングル、および動きの軌跡が含まれます。これにより、開発サイクルが加速し、モデルの堅牢性が向上し、フィジカル AI が経済的に実行可能になります。

Cosmos WFM 概要

Cosmos は、WFM を活用してフィジカル AI を進化させるために設計されたプラットフォームです。その中核には、事前トレーニングされたマルチモーダルモデルである Cosmos オープン WFM があり、開発者が世界の状態をビデオとして生成し、フィジカル AI の推論や事後トレーニングを行い、特殊なフィジカル AI モデルを開発できます。Cosmos プラットフォームは 3 つのモデルで構成されています:

Cosmos Predict

画像、深度マップ、センサーデータ、テキストプロンプトなどの初期条件から、物理的・時間的に正しい未来の状態を動画で生成するモデルです。

Cosmos Transfer

テキストプロンプトと実世界のデータ、シミュレーションから得られた複数の空間制御入力を使用して、フィジカル AI 開発のための物理学を意識した世界状態の映像を生成します。Transfer は、照明、背景、天候、色、テクスチャなどの多様性を追加することで、与えられたデータセットを拡張および増殖させることができます。

Cosmos Reason

Cosmos Reason は、物理 AI のためのオープンでカスタマイズ可能な推論ビジョン言語モデル(VLM)です。この VLM により、ロボットやビジョン AI エージェントは、事前知識、物理学、常識を使用して現実世界を理解し、行動できます。このモデルは物理的推論リーダーボードでトップを獲得し、データアノテーションや批評、ロボット計画とトレーニング、業界全体でのビデオ分析 AI エージェントの作成など、さまざまなユースケースに適用できます。Cosmos Reason は、NVIDIA Blueprint for Video Search and Summarization(VSS)でビデオ分析 AI エージェントの開発に使用されています。

これらのモデルを特定のドメイン向けに構築、カスタマイズ、デプロイするには、開発者は NVIDIA Cosmos Cookbook を活用できます。推論、事後トレーニング、ファインチューニングのためのステップバイステップのワークフロー、技術的なレシピ、具体的な例を提供します。

AWS 上で Cosmos WFM を実行するためのアーキテクチャ

AWS は次の 2 つのデプロイメントオプションがあります:

-

– リアルタイム推論:NVIDIA NIM マイクロサービスを Amazon Elastic Kubernetes Service (Amazon EKS) で低遅延のインタラクティブアプリケーション用に使用できます。NVIDIA NIM マイクロサービスは、組織が NVIDIA GPU 上で AI モデルを実行できる一連の高速化されたされた推論マイクロサービスです。

– バッチ推論:コンテナ化されたモデルを AWS Batch で高スループットのオフラインワークロード用に使用できます。

NIM-on-EKS パターンは、常時稼働する GPU 対応 Pods で応答遅延と可用性を優先します。一方、AWS Batch パターンは、ジョブの投入をトリガーとしたコンピューティングプロビジョニングを通じて、コスト効率と弾力的なスループットを最適化します。これらのアーキテクチャを選択する際は、レイテンシー要件、推論量パターン、コスト制約、および物理 AI 開発パイプラインの統合ポイントを考慮する必要があります。

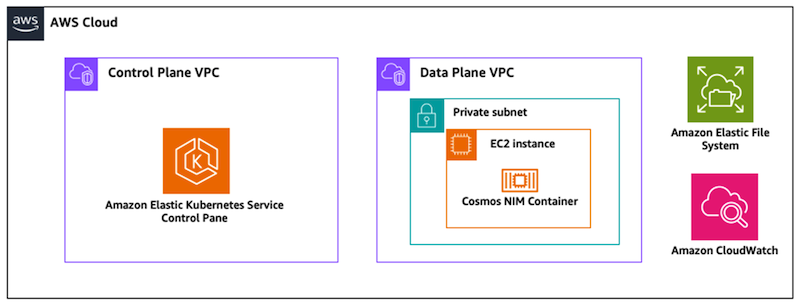

オプション 1:ライブ推論の実行– Amazon EKS 上の Cosmos NIM マイクロサービス

Amazon EKS 上の Cosmos NIM マイクロサービスオプションは、エンタープライズグレードのオーケストレーション、自動スケーリング、および簡素化された運用を提供します。これは、高可用性、動的スケーリング、およびクラウドネイティブな統合を必要とする本番環境のデプロイメントに推奨されるアプローチです。Cosmos NIM マイクロサービスは、最適化された推論エンジンを備えた Cosmos モデルをパッケージ化し、手動構成の複雑さを解消します。このパターンのデプロイメントのステップバイステップガイドについては、“Deploying generative AI applications with NVIDIA NIMs on Amazon EKS”ブログ投稿を参照してください。

アーキテクチャ図

図 2: Amazon EKS 上での Cosmos NIM マイクロサービスを使用したライブ推論の実行のアーキテクチャ

利点

-

– エンタープライズグレードのオーケストレーション: Kubernetes は宣言型構成、自動ロールアウトとロールバック、ポッド再起動による自己修復、および手動構成なしのサービスディスカバリーを提供します。

– 高可用性: マルチポッドデプロイメントにより、単一障害点がなくなります。クロス AZ ノード配置により、アベイラビリティーゾーンの障害を回避できます。ローリングアップデートにより、デプロイメント中のサービス可用性が維持されます。

– 運用の簡素化: マネージドコントロールプレーンにより、ノードのメンテナンスが不要になります。自動アップグレードにより、クラスターのコンポーネントが最新の状態に保たれます。AWS サービスとの統合により、統一されたモニタリングとセキュリティが提供されます。

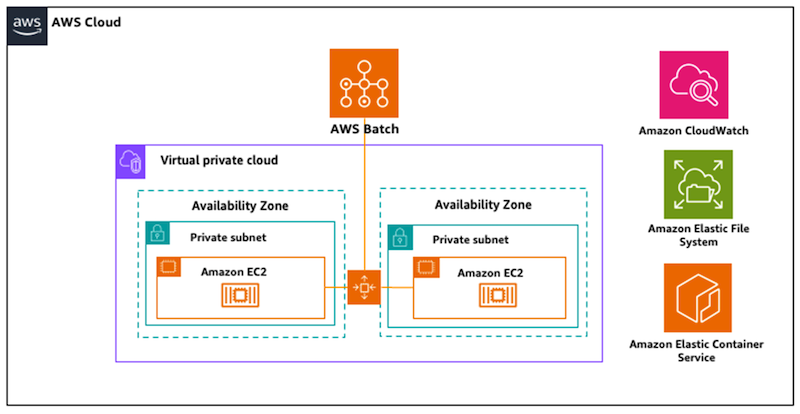

オプション 2: バッチ推論の実行 – AWS Batch 上の Cosmos コンテナ

AWS Batch は、大規模なバッチコンピューティングワークロードを実行するためのフルマネージドサービスを提供し、オフライン推論シナリオのための Cosmos WFM のデプロイメントに理想的なプラットフォームとなります。このアーキテクチャにより、軌跡データの合成、シーンバリエーション、または環境予測の生成など、大量の物理 AI データを処理できます。常時インフラストラクチャを維持する必要なく、AWS Batch によってオーケストレーションされるコンテナ化された Cosmos モデルを活用します。ジョブキューの需要に基づいて、自動的に最適なコンピュートリソース(GPU 対応 EC2 インスタンス)をプロビジョニングします。また、Amazon S3 または Amazon EFS からの入力データを元に、バッチジョブを開始することができます。これらのジョブは、ビデオ生成、シーン補完、または物理シミュレーションなどの推論タスクを実行します。この結果は、ロボットトレーニングパイプラインや自律システム開発ワークフローといった後段の処理のために EFS に書き戻されます。Amazon CloudWatch との統合は包括的なモニタリングを提供し、AWS IAM ポリシーはモデルアーティファクトとデータリポジトリへの安全な最小特権アクセスを保証します。このパターンのデプロイメントのステップバイステップガイドについては、このワークショップを参照してください。

アーキテクチャ図

図 3: AWS Batch で Cosmos コンテナを使用してバッチ推論を実行するためのリファレンスアーキテクチャ

利点

-

– コスト最適化: 動的スケーリングにより、AWS Batch は推論ジョブが実行される時のみ GPU コンピュートリソースをプロビジョニングし、完了時にインスタンスを終了します。この従量課金モデルにより、アイドルインフラストラクチャに関連するコストが排除され、特にデータセット拡張や夜間の合成データ生成などの断続的なワークロードに有効です。さらに、スポットインスタンスの活用によってコンピュートコストを削減することも可能です。

– 運用管理の簡素化: マネージドサービスにより、自動ジョブスケジューリング、リソースプロビジョニング、依存関係管理、再試行ロジックにより、インフラストラクチャの複雑さが軽減され、クラスターの操作ではなくモデルの最適化に集中できます。

– 大規模データ生成のための弾力的なスループット: AWS Batch は、単一ジョブから数千の並列推論タスクまで、フィジカル AI トレーニングのための大規模なデータセットを処理します。この弾力的な演算能力により、価値実現までの時間を加速し、ロボットポリシー開発と自律システム検証における繰り返しを高速化できます。

まとめ

AWS で Cosmos WFM を実行すると、大規模な物理 AI 機能を利用できます。このブログでは、異なる組織のニーズと制約に最適化された 2 つの本番環境向けアーキテクチャを紹介しました。 AWS モデルマーケットプレイス上で提供されている Cosmos Reason 推論ビジョン言語モデルを導入し、高度な空間-時間的理解と物理的常識を活用して AI プロジェクトを強化し、よりスマートなロボット計画、ビデオ分析、および最先端の効率性と推論機能を備えた自動データ注釈を可能にするかをご確認ください。

著者注: この技術ガイドは、Cosmos プラットフォームの機能、AWS のベストプラクティス、および大規模モデルデプロイメントの一般原則に基づいています。具体的な実装の詳細は、お客様の要件、最新の NVIDIA NIM マイクロサービスリリース、AWS サービスの更新、および組織のポリシーと制約によって異なる場合があります。最新の情報については、常に NVIDIA と AWS の最新のドキュメントを参照してください。

翻訳は、ソリューションアーキテクトの山本が担当しました。