Amazon Web Services ブログ

金融サービスにおける機械学習のベストプラクティス

本投稿は、金融サービスのお客様が AWS でエンドツーエンドの機械学習ソリューションを構築して運用化する支援をしている Stefan Natu 、Amazon SageMaker のシニア事業開発マネージャーである Kosti Vasilakakis 、アマゾン ウェブ サービス、ワールドワイド金融サービス事業開発の資本市場スペシャリストである Alvin Huang 、アマゾン ウェブ サービスのプリンシパル機械学習アーキテクチャ兼 AI/ML ソリューションアーキテクチャのシニアマネージャー であるDavid Ping の4名による寄稿を翻訳したものです。

先日、AWS は機械学習 (ML) ワークフローを構築している金融機関のためのセキュリティとモデルガバナンスに関する考慮事項の要点をまとめた新しいホワイトペーパー、金融サービスにおける機械学習のベストプラクティスを公開しました。このホワイトペーパーは、セキュリティとコンプライアンスに関する一般的な考慮事項について説明し、エンドツーエンドの例を詳しく説明するハンズオンデモとワークショップの提供を目的としています。このホワイトペーパーでは金融サービスの考慮事項に着目していますが、認証とアクセスの管理、データとモデルのセキュリティ、および ML 運用化 (MLOps) のベストプラクティスに関する情報のほとんどは、ヘルスケアなどのその他の規制対象業界にも当てはまります。

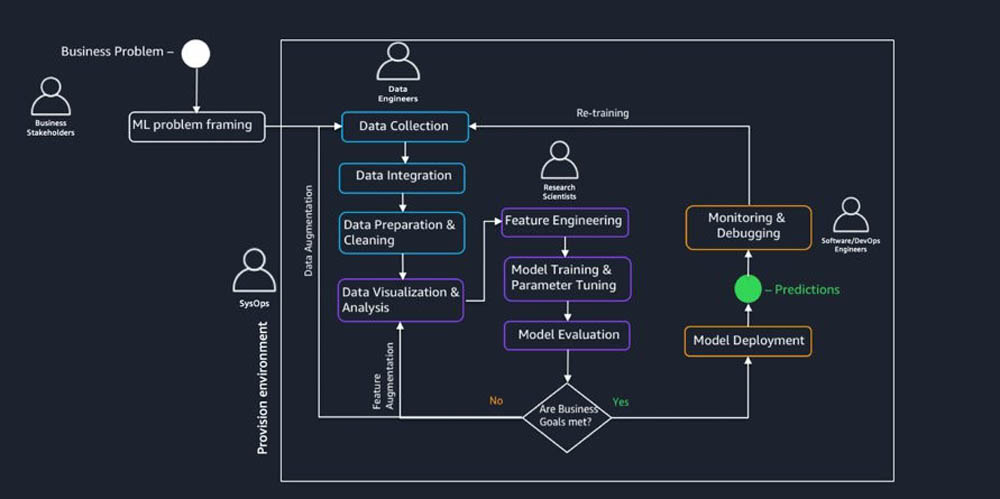

次の図にあるように、一般的な ML ワークフローには複数のステークホルダーが関与します。ワークフローを適切に制御して運用化するには、ビジネスステークホルダー、SysOps 管理者、データエンジニア、ソフトウェアエンジニア、および DevOps エンジニアを含めた複数のチームと連携する必要があります。

このホワイトペーパーでは、各チームのための考慮事項を説明すると共に、Amazon SageMaker と AWS のその他サービスを使用して ML ワークロードを構築、トレーニング、およびデプロイする方法の例と図解も提供します。具体的には、規制された環境でワークロードを実行するお客様からのフィードバックに基づいて、以下のトピックを取り上げています。

- セキュアな ML 環境のプロビジョニング – これには以下が含まれます。

- コンピューティングとネットワークの分離 – インターネット接続がないお客様のプライベートネットワークに Amazon SageMaker をデプロイする方法。

- 認証と認可– マルチテナンシーを使用せずに、制御された手法でユーザーを認証し、これらのユーザーをそれぞれの AWS Identity and Access Management (IAM) アクセス許可に基づいて認可する方法。

- データ保護 – お客様提供の暗号化キーを使用して、転送時および保管時のデータを暗号化する方法。

- 監査能力 – 悪意のあるアクティビティを特定し、それらを防ぐために、あらゆる時点で誰が何をしたかを監査、防止、および検出する方法。

- ML ガバナンスの確立 – これには以下が含まれます。

- トレーサビリティ – データの準備、モデル開発、およびトレーニングイテレーションから ML のモデルのつながりをトレースする手法と、任意の時点で誰が何をしたかを監査する方法。

- 説明可能性と解釈可能性 – トレーニングされたモデルを説明して解釈し、特徴量重要度を取得する上で役立つ手法。

- モデルモニタリング – データドリフトを防ぎ、ユーザー定義のルールに自動で対応するために本番環境のモデルをモニタリングする方法。

- 再現可能性 – モデルのつながりと保存されたアーティファクトに基づいて ML モデルを再現する方法。

- ML ワークロードの運用化 – これには以下が含まれます。

- モデル開発ワークロード – 開発環境で自動化されたレビュープロセスと手動のレビュープロセスを構築する方法。

- 運用前のワークロード – AWS CodeStar スイートと AWS Step Functions を使用して自動化された CI/CD パイプラインを構築する方法。

- 本番環境および継続的なモニタリングのワークロード – 継続的なデプロイメントと自動化されたモデルモニタリングを組み合わせる方法。

- 追跡とアラート – モデルメトリクス (運用および統計) を追跡し、異常が検知された場合に適切なユーザーにアラートを発行する方法。

セキュアな ML 環境のプロビジョニング

適切に制御されたセキュアな ML ワークロードは、プライベートで分離されたコンピューティング環境とネットワーク環境を確立することから始まります。これは、規制対象業界、中でもモデルの構築やトレーニングのために PII データを扱う業界では特に重要です。Amazon SageMaker、および Jupyter ノートブック、トレーニングインスタンス、ホスティングインスタンスなどの関連コンポーネントをホストする Amazon Virtual Private Cloud (VPC) は、インターネット接続がないプライベートネットワークにデプロイされる必要があります。

さらに、これらの Amazon SageMaker リソースは VPC 環境に関連付けることができます。こうすることにより、セキュリティグループなどのネットワークレベルのコントロールを適用して、Amazon SageMaker リソースへのアクセスと、環境へのデータの出入りを制御することができるようになります。Amazon SageMaker と Amazon Simple Storage Service (Amazon S3) などの AWS のその他サービスとの間の接続は、VPC エンドポイントまたは AWS PrivateLink を使用して確立できます。以下の図は、セキュアな Amazon SageMaker デプロイメントの推奨リファレンスアーキテクチャを説明するものです。

次のステップは、認可されたユーザーのみが適切な AWS のサービスにアクセスできるようにすることです。IAM は、Amazon SageMaker リソース、Amazon S3 内のデータ、および API エンドポイントへのアクセスなど、ML 環境におけるさまざまな側面に対する予防的コントロールを作成するために役立ちます。AWS のサービスには RESTful API を使用してアクセスでき、API コールはすべて IAM によって認可されます。明示的なアクセス許可は、許可されるプリンシパル (ユーザー)、アクション (API コール)、およびリソース (Amazon S3 オブジェクトなど) の他、アクセスが付与される条件を指定する IAM ポリシードキュメントを通じて付与されます。金融サービスのためのセキュアな環境の構築、およびその他の Well-Architected の柱に関する詳しい情報については、このホワイトペーパーを参照してください。

さらに、ML 環境には機密データや知的財産が含まれている場合があることから、セキュアな ML 環境のための 3 番目の考慮事項はデータ暗号になります。AWS では、独自の暗号化キーを使用して、転送時および保管時の両方でデータ暗号化を有効にすることをお勧めしています。最後に、適切に制御されたセキュアな ML 環境のためのもうひとつの考慮事項は、モデル構成またはハイパーパラメータにおける変更などの、データやモデルへのアクセスと変更のすべてをログに記録する、堅牢で透過的な監査証跡です。これらすべての分野に関する詳細は、ホワイトペーパーに記載されています。

セルフサービスのプロビジョニングとオートメーションを可能にするため、管理者は AWS Service Catalog などのツールを使用して、データサイエンティスト用に反復可能な方法でこれらのセキュアな環境を作成できます。こうすることによって、データサイエンティストは AWS Single Sign-On を使ってセキュアなポータルにログインし、適切なセキュリティガードレールが設定され、それぞれの用途向けにプロビジョニングされたセキュアな Jupyter ノートブック環境を作成することができます。

ML ワークロードの運用化

最後のセクションでは、ML ワークロードの運用化に関するベストプラクティスをいくつか説明します。ここでは、おおまかな説明から始めて、その後 AWS ネイティブのツールとサービスを使用する特定のアーキテクチャを詳しく説明していきます。モデルをデプロイするプロセス、つまり従来のソフトウェアデプロイメントでは CI/CD (継続的インテグレーション/デプロイメント) と呼ばれるプロセスに加えて、規制対象業界の本番環境への ML モデルのデプロイメントには、実装的観点から見た追加の意味合いがある場合があります。

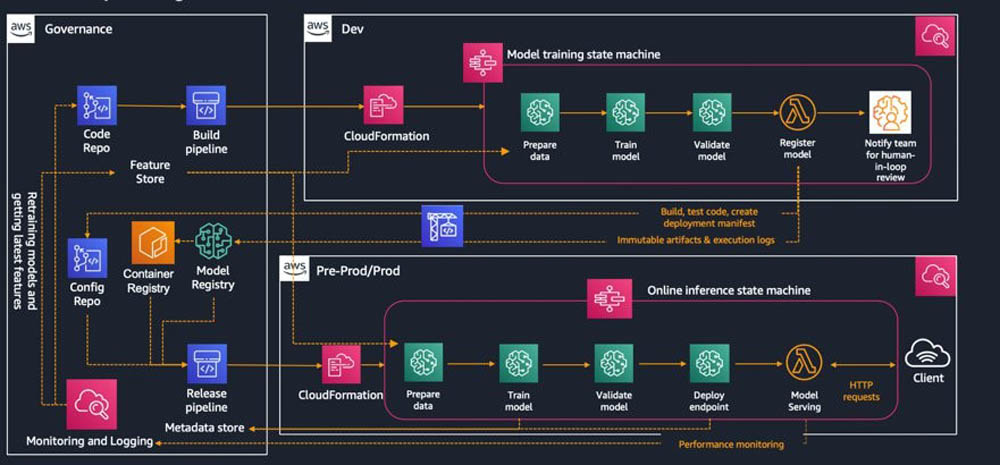

次の図は、エンタープライズ ML プラットフォームがガバナンス、監査、ロギング、およびレポート作成に関するガイドラインに対応しなければならない可能性がある、おおまかな要件の一部を示しています。

- 生データと関連するメタデータを管理するためのデータレイク

- 機械学習の特徴量と関連するメタデータを管理するための特徴量ストア (生データからone-hotエンコーディングやスケーリング変換などの生成された特徴量へのマッピング)

- トレーニング済みのモデルアーティファクトと関連するメタデータ (ハイパーパラメータ、トレーニング回数、および依存関係など) が含まれるモデルとコンテナレジストリ

- ソースコードの管理とバージョニングのためのコードリポジトリ (Git、AWS CodeCommit、または Artifactory など)

- トレーニングパイプラインとデプロイメントパイプラインのバージョニングと管理のためのパイプラインレジストリ

- アクセスログを管理するためのロギングツール

- 本番環境モニタリングとパフォーマンスログ

- 監査とレポート作成のためのツール

次の図は、AWS ネイティブのツールとサービスを使用する具体的な実装を説明するものです。Airflow や Jenkins などのスケジューリングおよびオーケストレーション用ツールもいくつか市場に流通していますが、具体性のため、今回は主に Step Functions に着目します。

ホワイトペーパーでは、前出の図の各部分、具体的には以下のワークロードについて詳しく説明しています。

- モデルの開発

- 運用前

- 本番環境と継続的なモニタリング

まとめ

金融サービスにおける機械学習のベストプラクティスのホワイトペーパーは、こちらから入手できます。このホワイトペーパーを今すぐ入手して、セキュアで適切に制御された ML ワークフローを構築する方法の例証にお役立てください。また、ご質問等がございましたら、いつでも著者にご連絡ください。ジャーニーを進めるにあたって、機械学習ワークロードに適用される AWS Well-Architected の原則に関するレンズについて、こちらのホワイトペーパーもご覧ください。ビデオデモチュートリアルと、以下の 2 つのワークショップもご利用いただけます。

- Build a secure ML environment with SageMaker

- Provision a secure ML environment with SageMaker and run an end-to-end example

About the authors

Stefan Natu は、アマゾン ウェブ サービスのシニア機械学習スペシャリストです。Stefan は、金融サービスのお客様が AWS でエンドツーエンドの機械学習ソリューションを構築して運用化するお手伝いをしています。理論物理学を学んだ Stefan は、これまでにも小売およびエネルギーの垂直市場で数多くのデータサイエンス問題に取り組んできました。余暇には、機械学習のブログを読むこと、旅行、ギター演奏、およびニューヨーク市内のフードシーンを探検することを楽しんでいます。

Stefan Natu は、アマゾン ウェブ サービスのシニア機械学習スペシャリストです。Stefan は、金融サービスのお客様が AWS でエンドツーエンドの機械学習ソリューションを構築して運用化するお手伝いをしています。理論物理学を学んだ Stefan は、これまでにも小売およびエネルギーの垂直市場で数多くのデータサイエンス問題に取り組んできました。余暇には、機械学習のブログを読むこと、旅行、ギター演奏、およびニューヨーク市内のフードシーンを探検することを楽しんでいます。

Kosti Vasilakakis は、エンドツーエンドの機械学習のための AWS のフルマネージドサービスである Amazon SageMaker のシニア事業開発マネージャーで、金融サービス企業とテクノロジー企業が ML でさらに多くの目標を達成するための支援に焦点を当てています。Kosti は、キュレーションされたワークショップ、ハンズオンガイダンスセッション、および事前にパッケージ化されたオープンソースソリューションも先導して、お客様が迅速かつ安全により優れた ML モデルを構築することを確実にしています。仕事以外では、世界旅行、哲学、テニスを楽しんでいます。

Kosti Vasilakakis は、エンドツーエンドの機械学習のための AWS のフルマネージドサービスである Amazon SageMaker のシニア事業開発マネージャーで、金融サービス企業とテクノロジー企業が ML でさらに多くの目標を達成するための支援に焦点を当てています。Kosti は、キュレーションされたワークショップ、ハンズオンガイダンスセッション、および事前にパッケージ化されたオープンソースソリューションも先導して、お客様が迅速かつ安全により優れた ML モデルを構築することを確実にしています。仕事以外では、世界旅行、哲学、テニスを楽しんでいます。

Alvin Huang は、アマゾン ウェブ サービス、ワールドワイド金融サービス事業開発の資本市場スペシャリストで、データレイクと分析、および人工知能と機械学習に焦点を当てています。Alvin は 19 年を超える金融サービス業界経験を持っており、AWS への入社前には J.P. Morgan Chase & Co, のエグゼクティブディレクターを務めて、北米およびラテンアメリカの貿易監視チームを管理し、グローバルな貿易監視の開発を先導しました。ラトガース大学では定量的リスク管理コースを教え、ラトガース大学の数理ファイナンス修士プログラム (MSMF) 諮問委員会の一員でもあります。

Alvin Huang は、アマゾン ウェブ サービス、ワールドワイド金融サービス事業開発の資本市場スペシャリストで、データレイクと分析、および人工知能と機械学習に焦点を当てています。Alvin は 19 年を超える金融サービス業界経験を持っており、AWS への入社前には J.P. Morgan Chase & Co, のエグゼクティブディレクターを務めて、北米およびラテンアメリカの貿易監視チームを管理し、グローバルな貿易監視の開発を先導しました。ラトガース大学では定量的リスク管理コースを教え、ラトガース大学の数理ファイナンス修士プログラム (MSMF) 諮問委員会の一員でもあります。

David Ping は、アマゾン ウェブ サービスのプリンシパル機械学習アーキテクチャ兼 AI/ML ソリューションアーキテクチャのシニアマネージャーです。David はエンタープライズカスタマーが AWS で機械学習ソリューションを構築し、運用するお手伝いをしています。ハイキングと、最新の機械学習の進歩を観察することが好きです。

David Ping は、アマゾン ウェブ サービスのプリンシパル機械学習アーキテクチャ兼 AI/ML ソリューションアーキテクチャのシニアマネージャーです。David はエンタープライズカスタマーが AWS で機械学習ソリューションを構築し、運用するお手伝いをしています。ハイキングと、最新の機械学習の進歩を観察することが好きです。

翻訳はソリューションアーキテクトの澤野佳伸が担当しました。原文はこちらです。