各行各业的企业都在寻求由人工智能(AI)推动转型,以此促进业务创新,改善客户体验和落实改进措施。支持 AI 应用程序的机器学习(ML)模型变得越来越复杂,导致底层计算基础设施成本不断上升。高达 90% 用于开发和运行机器学习应用程序的基础设施支出通常用于推理。客户正寻求经济高效的基础架构解决方案,以便在生产中部署他们的机器学习应用程序。

Amazon EC2 Inf1 实例可提供高性能且低成本的机器学习推理。与同类 Amazon EC2 实例相比,这些实例的吞吐量可提高多达 2.3 倍,每次推理的成本可降低多达 70%。Inf1 实例的构建目的就是用于支持 ML 推理应用程序。它们具有多达 16 个 AWS Inferentia 芯片,这是由 AWS 专门设计和打造的高性能 ML 推理芯片。另外,Inf1 实例包含第二代英特尔至强可扩展处理器以及高达 100Gbps 的网络,可实现高吞吐量推理。

客户可以借助 Inf1 实例,运行大规模 ML 推理应用程序,例如搜索、建议引擎、计算机视觉、语音识别、自然语言处理(NLP)、个性化和欺诈检测。

开发人员可以使用 AWS Neuron 开发工具包将其 ML 模型部署到 Inf1 实例,该开发工具包集成了 TensorFlow、PyTorch 和 Apache MXNet 等受欢迎的 ML 框架。 您可以继续使用相同的机器学习工作流,并且只需最少的代码更改即可将应用程序无缝迁移到 Inf1 实例上,且无需与供应商特定相关的解决方案进行捆绑。

使用 Amazon SageMaker、预配置了 Neuron 开发工具包的 AWS Deep Learning AMI(DLAMI)、用于容器化 ML 应用程序的 Amazon Elastic Kubernetes Service(Amazon EKS)或 Amazon Elastic Container Service(Amazon ECS),轻松开始使用 Inf1 实例。

优势

每次推理的成本降低多达 70%

使用 Inf1,开发人员可以显著降低其 ML 生产部署的成本。Inf1 实例结合了低实例成本和高吞吐量,与同类 Amazon EC2 实例相比,可将每次推理成本降低高达 70%。

易用性和代码可移植性

Neuron 开发工具包与常用的 ML 框架集成,如 TensorFlow、PyTorch 和 MXNet。开发者可以继续使用相同的机器学习工作流,并且只需最少的代码更改即可将应用程序无缝迁移到 Inf1 实例上。这使得他们可以灵活使用所选 ML 框架、最能满足其需求的计算平台以及最新技术,无需受与供应商特定相关的解决方案束缚。

吞吐量提高至 2.3 倍

与同类 Amazon EC2 实例相比,Inf1 实例的吞吐量可提高多达 2.3 倍。 支持 Inf1 实例的 AWS Inferentia 芯片针对小批量的推理性能进行了优化,使实时应用程序能够最大限度提升吞吐量并满足延迟要求。

超低延迟

AWS Inferentia 芯片配有较大的芯片上内存容量,允许直接在芯片上缓存 ML 模型。您可以使用 NeuronCore Pipeline 等功能部署您的模型,由此无需使用外部内存资源。通过 Inf1 实例,您可以在接近实时延迟的情况下部署实时推理应用程序,而不会影响带宽。

支持各种 ML 模型和数据类型

Inf1 实例支持许多常用 ML 模型架构,例如用于图像识别/分类的 SSD、VGG 和 ResNext,以及用于 NLP 的 Transformer 和 BERT。此外,Neuron 中对 HuggingFace 模型存储库的支持使客户只需更改一行代码即可使用经过预先训练或微调的模型轻松编译和运行推理。支持使用混合精度的多种数据类型,包括 BF16 和 FP16,以满足各种模型和性能需求。

功能

由 AWS Inferentia 提供支持

AWS Inferentia 是一种 ML 芯片,由 AWS 专门打造,旨在以低成本提供高性能推理。每个 AWS Inferentia 芯片都搭载了四个第一代 NeuronCore,提供高达每秒 128 兆次运算(TOPS)的性能,并支持 FP16、BF16 和 INT8 数据类型。AWS Inferentia 芯片还具有大量的芯片上内存,可用于缓存大型模型,这对于需要频繁访问内存的模型尤为有利。

使用 AWS Neuron 部署热门机器学习框架

AWS Neuron SDK 由编译器、运行时系统驱动程序和分析工具组成。它支持使用 Inf1 实例部署在常用框架(例如 TensorFlow、PyTorch 和 MXNet)中创建和训练的复杂神经网络模型。NeuronCore Pipeline 还支持您使用高速物理芯片间互联将大型模型进行拆分,以便在多个 Inferentia 芯片上执行,从而提供高推理吞吐量和更低的推理成本。

高性能联网和存储

对于需要访问高速网络的应用程序,Inf1 实例可提供高达 100Gbps 的联网吞吐量。新一代弹性网络适配器(ENA)和 NVM Express(NVMe)技术为 Inf1 实例提供了高吞吐量、低延迟的联网接口和 Amazon Elastic Block Store(Amazon EBS)。

基于 AWS Nitro System

AWS Nitro 系统是丰富的构建块集合,可将许多传统虚拟化功能卸载到专用硬件和软件中,以提供高性能、高可用性和高安全性,同时还可降低虚拟化开销。

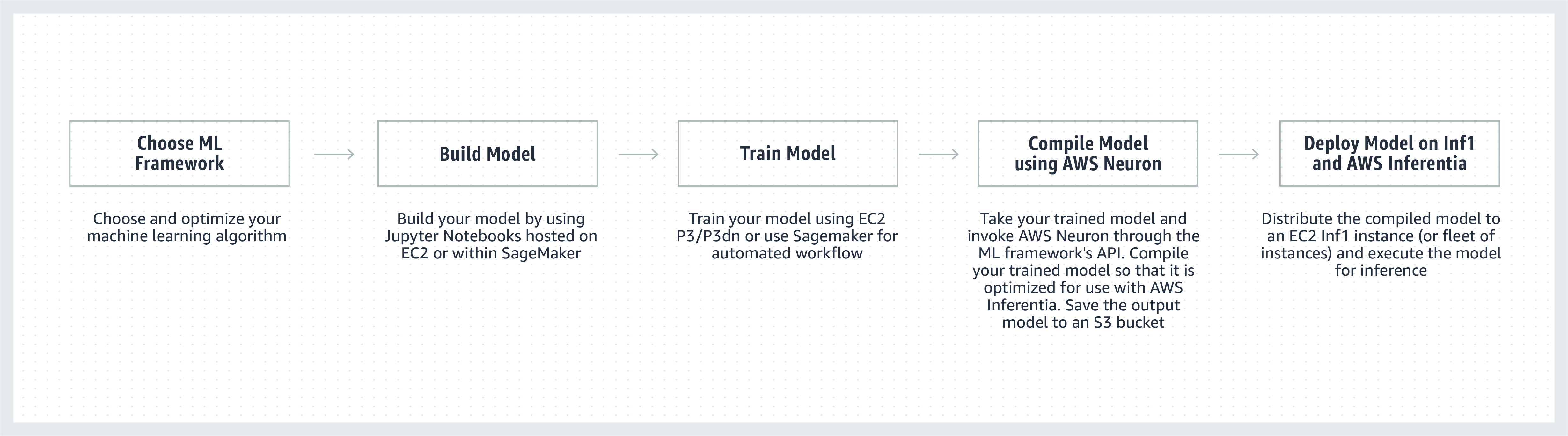

工作原理

客户评价

Airbnb 是一个社区市场,成立于 2008 年,总部位于旧金山,其拥有超过 400 万名房东,接待过超过 9 亿名旅客,业务几乎遍及全球各个国家/地区。

“Airbnb 的社区支持平台为我们由全球数百万旅客和房东组成的社区提供了智能、可扩展和卓越的服务体验。我们一直在寻找方法来提高我们的客服聊天机器人应用程序所使用的 NLP 模型的性能。我们看到,与用于基于 PyTorch 的 BERT 模型的基于 GPU 实例相比,使用由 AWS Inferentia 提供支持的 Amazon EC2 Inf1 实例时,吞吐量提高了 2 倍。我们期待在未来将 Inf1 实例用于其他模型和使用案例。”

Bo Zeng,Airbnb 工程经理

“我们将 ML 融入 Snapchat 的很多方面,在此领域探索创新是重中之重。我们一听说 Inferentia 就开始与 AWS 合作采用 Inf1/Inferentia 实例来帮助我们进行 ML 部署,包括性能和成本方面。我们用自己的推荐模型开始,并期待未来将更多模型用于 Inf1 实例。”

Nima Khajehnouri,Snap Inc. 工程副总裁

“通过 Sprinklr 的 AI 驱动型统一客户体验管理(统一 CXM)平台,公司能够收集多个渠道中的实时客户反馈,并将其转化为可实施的洞察 – 从而形成主动的问题解决方法、增强的产品开发、改进的内容营销、更好的客户体验,等等。使用 Amazon EC2 Inf1,我们能够显著地提高我们的 NLP 模型之一的性能,还能提高我们的计算机视觉模型之一的性能。我们期待继续使用 Amazon EC2 Inf1 更好地为全球客户服务。”

Vasant Srinivasan,Sprinklr 产品工程高级副总裁

“我们一流的 NLP 产品 Finch for Text 让用户能够在海量文本中提取多种类型实体、消除歧义和丰富其内容。Finch for Text 需要大量的计算资源来为我们的客户在全局数据源上提供低延迟丰富内容。现在,我们使用在 PyTorch NLP、翻译和实体词义排歧模型中使用 AWS Inf1 实例。在保持推理速度和性能的同时,我们能够通过最小的优化降低 80% 以上的推理成本(对于 GPU)。这一改进使我们的客户能够在全球范围内实时丰富其流媒体数据源上的法语、西班牙语、德语和荷兰语文本,这对我们的金融服务、数据聚合器和公共部门客户至关重要。”

Scott Lightner,Finch Computing 首席技术官

“我们以多种语言、不同的格式(图像、视频、音频、文本传感器、所有这些类型的组合)对世界各地成千上万个来源的多种类型的事件发布提醒。考虑到这种规模,优化速度和成本对我们的业务至关重要。借助 AWS Inferentia,我们降低了模型延迟,使每美元吞吐量提高了 9 倍。这使我们能够部署更复杂的 DL 模型,在控制成本的同时,使处理的数据量增加 5 倍,从而提高模型的准确性并增强平台的功能。”

Alex Jaimes,Dataminr 首席科学家兼人工智能高级副总裁

“Autodesk 正在通过使用 Inferentia 来推进我们的人工智能虚拟助手 — Autodesk 虚拟代理(AVA)的认知技术。AVA 通过应用自然语言理解(NLU)和深度学习(DL)技术来提取查询背后的上下文、意图和意义,每月解答超过 10 万个客户问题。试用 Inferentia 后,对于 NLU 模型,我们能够获得比 G4dn 高 4.9 倍的吞吐量,并期望在基于 Inferentia 的 Inf1 实例上运行更多的工作负载。”

inghui Ouyang,Autodesk 高级数据科学家

Amazon 服务使用 Amazon EC2 Inf1 实例

Amazon Advertising 可帮助各种规模的企业在客户购物过程的每个阶段与其建立联系。每天都有数以百万计的文本和图像广告经过审核和分类,以确保提供最佳的客户体验。

“对于我们的文本广告处理,我们在基于 AWS Inferentia 的 Inf1 实例上全局部署了基于 PyTorch 的 BERT 模型。通过从 GPU 迁移到 Inferentia,我们能够在获得近似性能的前提下将成本降低 69%。为 AWS Inferentia 编译和测试我们的模型只用了不到三周的时间。使用 Amazon SageMaker 将我们的模型部署到 Inf1 实例可确保我们的部署具有可扩展性且易于管理。当我第一次分析编译的模型时,AWS Inferentia 的性能令人印象深刻,我实际上不得不重新运行基准测试以确保它们是正确的! 我们计划未来将我们的图像广告处理模型迁移到 Inferentia。我们已经对这些模型的基于 GPU 的可比较实例进行了基准测试,其延迟降低了 30%,成本节省了 71%。”

Yashal Kanungo,Amazon Advertising 应用科学家

阅读新闻博客 »

“Amazon Alexa 的 AI 和基于机器学习的智能技术由 AWS 提供支持,目前已在 1 亿多台设备上可用。我们向客户承诺,Alexa 将始终致力于变得更智能、更对话化、更主动、更令人满意。实现这一承诺需要持续改进响应时间和机器学习基础设施成本,因此我们很高兴使用 Amazon EC2 Inf1 实例来降低 Alexa 文字转语音的推理延迟和每次推理成本。借助 Amazon EC2 Inf1 实例,我们将能够为每月使用 Alexa 的数千万客户提供更好的服务。”

Tom Taylor,Amazon Alexa 高级副总裁

“我们持续地创新,以进一步改善客户体验并压低我们的基础设施成本。将基于 Web 的问答(WBQA)工作负载从基于 GPU 的 P3 实例迁移到基于 AWS Inferentia 的 Inf1 实例不仅帮助我们将推理成本降低了 60%,还将端到端延迟减少了超过 40%,由此通过 Alexa 增强了客户的问答体验。在将 Amazon SageMaker 用于我们基于 TensorFlow 的模型后,切换到 Inf1 实例的流程变得更加直接和易于管理。现在,我们在全球使用 Inf1 实例运行这些 WBQA 工作负载,并持续优化其用在 AWS Inferentia 中的性能以进一步降低成本,减少延迟。”

Eric Lind,Alexa AI 软件开发工程师

“Amazon Prime Video 使用计算机视觉 ML 模型分析直播活动的视频质量,以确保 Prime Video 会员获得最佳观看体验。我们在 EC2 Inf1 实例上部署了我们的图像分类 ML 模型,并能够获得 4 倍的性能改进和高达 40% 的成本节省。我们现在希望利用这些节省的成本来创新和构建先进的模型,以便检测更复杂的缺陷,如音频和视频文件之间的同步差距,从而为 Prime Video 会员提供更强的观看体验。”

Victor Antonino,Amazon Prime Video 解决方案架构师

“Amazon Rekognition 是一种简单的图像和视频分析应用程序,可帮助客户识别物体、人、文本和活动。Amazon Rekognition 需要高性能的深度学习基础设施,以便可以每天为客户分析数十亿图像和视频。使用基于 AWS Inferentia 的 Inf1 实例运行对象分类之类的 Amazon Rekognition 模型,与在 GPU 上运行这些模型相比,可将延迟降低 8 倍,将吞吐量提高 2 倍。根据这些结果,我们将 Amazon Rekognition 移动到 Inf1,从而使我们的客户能够更快地获取准确结果。”

Rajneesh Singh,Amazon Rekognition 和视频软件工程总监

定价

* 所示价格适用于美国东部(弗吉尼亚北部)AWS 区域。一年期和三年期预留实例的价格适用于“部分预付费用”付款方式或“无预付费用”(针对没有“部分预付费用”选项的实例)。

Amazon EC2 Inf1 以按需实例、预留实例或 Spot 实例的形式在美国东部(弗吉尼亚北部)和美国西部(俄勒冈)AWS 区域推出。

开始使用

使用 Amazon SageMaker

SageMaker 使您能够更轻松地在生产环境中编译您训练好的 ML 模型并将其部署到 Amazon Inf1 实例上,以便开始以低延迟生成实时预测。AWS Neuron 是 AWS Inferentia 的编译器,它与 Amazon SageMaker Neo 集成,帮助您编译经过训练的 ML 模型,以便在 Inf1 实例上以最佳方式运行。借助 SageMaker,您可以轻松在跨多个可用区的 Inf1 实例的 auto-scaling 集群上运行您的模型,以交付高性能和高可用性实时推理。通过 GitHub 上的示例了解如何使用 SageMaker 部署到 Inf1。

使用 DLAMI

DLAMI 可以为机器学习从业人员和研究人员提供基础设施和各种工具,从而加快在云中进行任意规模的深度学习的速度。AWS Neuron SDK 已预安装在 DLAMI 中,可在 Inf1 实例上以最佳方式编译和运行您的 ML 模型。为了帮助指导您完成入门流程,请访问 AMI 选择指南和更多深度学习资源。请参阅 AWS DLAMI 入门指南,了解如何将 DLAMI 与 Neuron 配合使用。

使用 Deep Learning Containers

现在,开发人员可以在 Amazon EKS(一项完全托管的 Kubernetes 服务)以及 Amazon ECS(Amazon 的完全托管容器编排服务)中部署 Inf1 实例。详细了解如何在 Amazon EKS 上开始使用 Inf1,或者如何开始使用 Amazon ECS。有关在 Inf1 实例上运行容器的更多详细信息,请参阅 Neuron 容器工具教程页面。AWS Deep Learning Containers 中还预装了 Neuron。

博客和文章

Amazon Search 如何使用 AWS Inferentia 将 ML 推理成本降低 85%

作者:Joao Moura、Jason Carlson、Jaspreet Singh、Shaohui Xi、Shruti Koparkar、Haowei Sun、Weiqi Zhang 和 Zhuoqi Zhangs,2022 年 9 月 22 日

作者:MIT Technology Review Insights,2021 年 11 月 1 日

使用 Amazon SageMaker 为计算机视觉推理选择最佳的 AI 加速器和模型编译

作者:Davide Galliteli 和 Hasan Poonawala,2021 年 10 月 19 日

作者:MIT Technology Review Insights,2021 年 10 月 15 日

使用 AWS Inferentia 在 Amazon EKS 上提供 3000 个深度学习模型,每小时费用不到 50 USD

作者:Alex Iankoulski、Joshua Correa、Mahadevan Balasubramaniam 和 Sundar Ranganatha,2021 年 9 月 30 日

利用 AWS Inferentia 上开箱即用的 PyTorch 自然语言处理应用程序实现 12 倍的吞吐量和最低延迟

作者:Fabio Nonato de Paula 和 Mahadevan Balasubramaniam,2021 年 5 月 4 日

如何使用 AWS Inferentia 将用于 Autodesk Ava 聊天机器人的 PyTorch NLP 模型性能提高 4.9 倍

作者:Binghui Ouyang,2021 年 4 月 7 日

大多数 Alexa 现已在更快、更具成本效益的 Amazon EC2 Inf1 实例上运行

作者:Sébastien Stormacq,2020 年 11 月 12 日

宣布在 Amazon SageMaker 中提供 Inf1 实例,以获得高性能且经济高效的机器学习推理

作者:Julien Simon,2020 年 4 月 22 日

作者:Julien Simon,2020 年 08 月 14 日

在基于 AWS Inferentia 的 Inf1 实例上部署 TensorFlow OpenPose,显著提高性价比

作者:Fabio Nonato De Paula 和 Haichen Li,2020 年 7 月 22 日

作者:Julien Simon,2020 年6 月 15 日

Amazon EC2 更新 - 使用 AWS Inferentia 芯片获得高性能、低成本推理的 Inf1 实例

作者:Jeff Barr,2019 年 12 月 3 日

AWS Inferentia 目前可在 11 个 AWS 区域提供,在大规模运行对象检测模型方面性能一流。

作者:Gadi Hutt,2020 年 09 月 28 日