Amazon Web Services ブログ

新機能: 機械学習と HPC 向けの GPU 搭載 EC2 P4 インスタンス

Amazon EC2 チームは、約 10 年にわたり、GPU を搭載したインスタンスをお客様に提供してきました。第 1 世代の クラスター GPU インスタンスは 2010 年後半にリリースされ、続いて G2 (2013)、P2 (2016)、P3 (2017)、G3 (2017)、P3dn (2018)、および G4 (2019) インスタンスを作成します。世代を重ねるごとに、GPU を最大限に活用できるように、十分な CPU パワー、メモリ、ネットワーク帯域幅とともに、ますます機能が向上した GPU が組み込まれています。

新しい EC2 P4 インスタンス

今日は、GPU を搭載した新しい P4 インスタンスについてお話したいと思います。これらのインスタンスは、最新の Intel® Cascade Lake プロセッサーを搭載し、最新の NVIDIA A100 Tensor Core GPU を 8 つ搭載しています。各 GPU は NVLink によって他のすべての GPU に接続され、NVIDIA GPUDirect をサポートしています。2.5 PetaFLOPS の浮動小数点パフォーマンスと 320 GB の高帯域幅 GPU メモリを備えたインスタンスは、P3 インスタンスと比較して、最大 2.5 倍の深層学習パフォーマンスを実現し、トレーニングのコストを最大 60% 削減できます。

P4 インスタンスには、1.1 TB のシステムメモリと 8 TB の NVME ベースの SSD ストレージが含まれており、1 秒あたり最大 16 ギガバイトの読み取りスループットを提供できます。

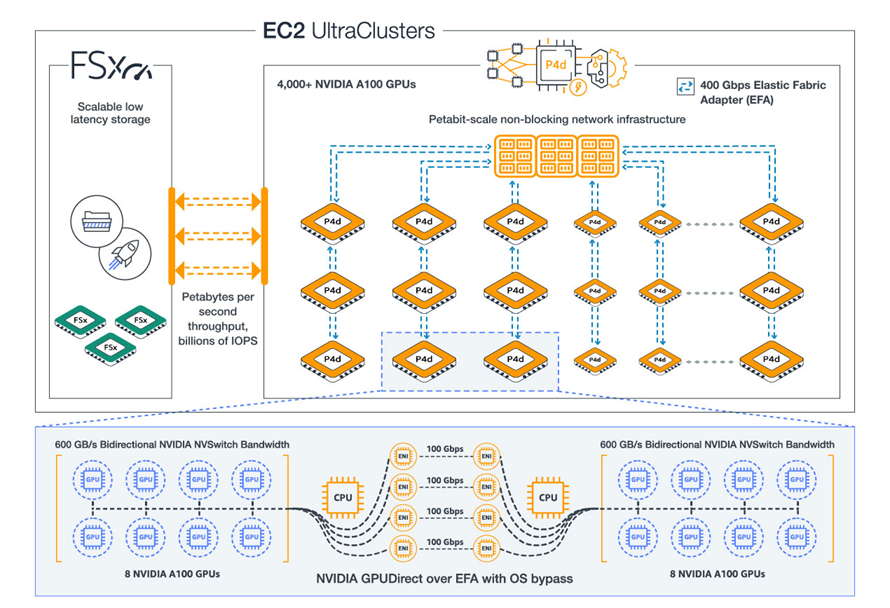

ネットワークに関しては、P4 インスタンス用に特別に設計された、ペタビット規模のノンブロッキング専用ネットワークファブリック (EFA 経由でアクセス可能) への 4 つの 100 Gbps ネットワーク接続と、最大 80K IOPS をサポートできる 19 Gbps の EBS 帯域幅にアクセスできます。

EC2 UltraClusters

NVIDIA A100 GPU、NVIDIA GPUDirect のサポート、400 Gbps のネットワーク、ペタビット規模のネットワークファブリック、S3、Amazon FSx for Lustre、AWS ParallelCluster などの AWS サービスにアクセスすることにより、4,000 台以上の GPU を備えたオンデマンド EC2 UltraClusters を作成するために必要なすべてが提供されます。

これらのクラスターは、自然言語処理、オブジェクトの検出と分類、シーンの理解、地震分析、天気予報、財務モデリングなど、最も高度なスーパーコンピューター規模の機械学習と HPC ワークロードを処理することができます。

今すぐ利用可能

P4 インスタンスは 1 つのサイズ (p4d.24xlarge) で利用可能であり、今日では、米国東部 (バージニア北部) および米国西部 (オレゴン) リージョンで起動できます。AMI には、NVIDIA A100 ドライバーと最新の ENA ドライバーが必要です (深層学習コンテナは既に更新済み)。

複数の P4 を使用して分散型トレーニングジョブを実行している場合は、EFA および MPI 互換アプリケーションを使用して、400 Gbps のネットワークとペタビット規模のネットワークファブリックを最大限に活用できます。

P4 インスタンスは、オンデマンド、Savings Plan、リザーブドインスタンス、およびスポットの形式で購入できます。Amazon SageMaker や Amazon Elastic Kubernetes Service などのマネージド AWS サービスで P4 インスタンスを使用する際のサポートについては、現在進行中であり、今年の後半に利用可能になる予定です。

Dave から話を続ける

私の同僚の Dave Brown は、P4 インスタンスについてさらに多くのことを話しています。

詳細

前世代 (P3) インスタンスと比較した P4d インスタンスのパフォーマンスについては、Amazon EC2 P4d Instances in UltraClusters をお読みください。料金やその他の技術的な詳細については、P4 インスタンスについてお読みください。