AWS 기술 블로그

CJ 온스타일 라이브 커머스, Agentic AI로 고객 소통의 새로운 차원을 열다

이 블로그는 CJ온스타일의 고경락, 신영화, 성홍규, 송진호, 기수진 님과 AWS 변상규, 서지혜, Yash Shah, Charlie Chang 님께서 작성 해주셨습니다.

들어가며: 실시간 소통이 만드는 차별화 된 쇼핑 경험

![]()

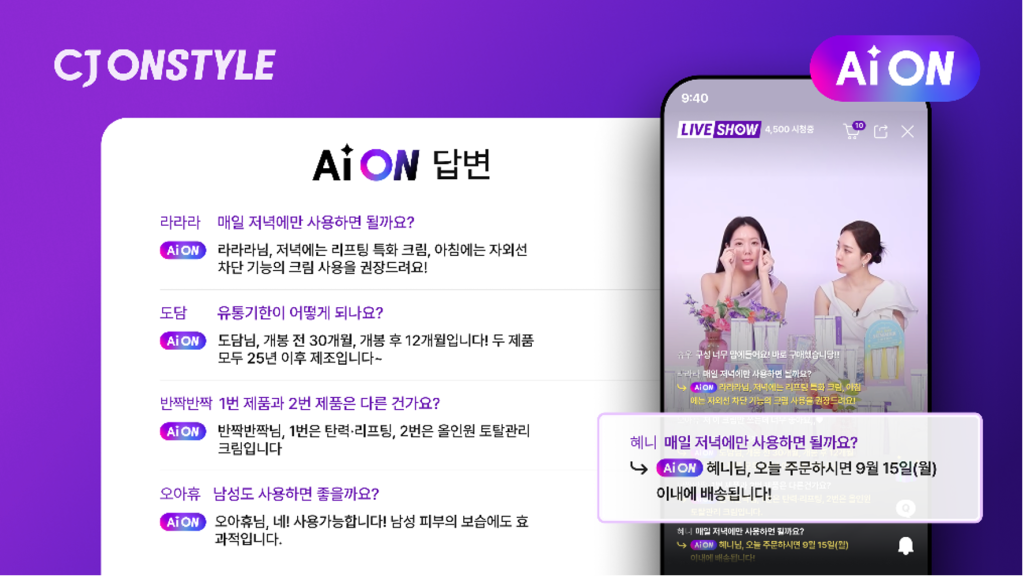

CJ온스타일은 모바일과 TV, 이커머스를 연결해 영상 콘텐츠를 중심으로 한 차별화된 커머스 경험을 제공하는 커머스 플랫폼입니다. 특히 CJ온스타일은 모바일 라이브 커머스 1위(회당 거래액 기준) 플랫폼으로 고객과의 실시간 소통을 통해 차별화된 쇼핑 경험을 제공하는 핵심 채널로 자리잡고 있습니다.

라이브 커머스의 성공은 고객의 궁금증을 얼마나 빠르고 정확하게 해결해주느냐에 달려있습니다. 하지만 실시간으로 쏟아지는 수많은 질문들을 한정된 인력으로 모두 처리하기엔 한계가 있었습니다. 이런 과제를 해결하기 위해 CJ ENM은 AWS Generative AI Innovation Center와 함께 실시간 고객 응대 AI Agent 인 AiON을 개발했습니다.

실제로 모바일 라이브 방송에서 시범 운영한 결과 답변율이 평균 대비 3배 증가하고 만족도 85.7%를 기록했습니다. 또한 평균 20초 내 답변 생성으로 대기시간을 최소화하며 방송 몰입도 향상에 기여 했습니다. CJ온스타일은 6개 인기 프로그램에 AiON을 적용해 9월 테스트 완료하였으며 10월부터 단계적으로 확대할 예정입니다.

라이브 커머스의 기술적 도전 과제

CJ 온스타일의 라이브 커머스 플랫폼은 실시간 방송 중 평균 분당 50-100개의 고객 코멘트를 처리해야 하는 상황에 직면해 있습니다. 이 중 약 23% 정도가 실제 제품 관련 질문이며, 제한된 인력으로 처리할 수 있는 질문의 개수와 답변의 정확도에 한계가 있었습니다.

특히 방송별로 질문의 난이도가 다르고 고객응대 담당자의 응답률이 고르지 않았으며, 실제로는 많은 질문에 대응 할 수 없는 상황 이였습니다. 고객 참여도를 높이고 이를 통한 매출 증대를 유도하기 위해 다음과 같은 요구사항과 목표를 설정하고 프로젝트를 시작했습니다.

- 빠른 응답 속도: 문 유형을 신속하게 분류하고 의도에 맞는 대응을 제공하되, 간단한 질문은 수초 내, 복잡한 질문이라도 최대 10초 내 답변 생성을 목표로 했습니다.

- 높은 응답률: 고객 문의에 대해 응답률을 2배로 끌어 올리는 것을 목표로 하였습니다.

- 정확한 정보 제공: 방송 전 제품 정보(배송, 옵션, 가격 등)를 구조화하여 저장하고, 실시간 방송 중 재고나 가격 등 변경 정보를 즉시 반영할 수 있는 시스템 구축이 필요했습니다. 또한 고객 코멘트 히스토리를 분석하여 이전 대화 맥락을 파악하고 연관성 있는 답변을 제공하는 것도 중요한 요구 사항 이었습니다.

- 지능형 고객 응대: 방송 특성에 맞는 응답 톤을 설정하고, 고객의 감정이나 관심 상태를 파악하여 불만이나 관심도를 분석할 수 있는 기능이 요구되었습니다.

이러한 포괄적인 요구사항들을 만족시키기 위해 CJ 온스타일은 AWS의 최신 생성형 AI 기술과 서버리스 아키텍처를 활용한 혁신적인 멀티 에이전트 시스템을 구축하게 되었습니다. 이를 통해 라이브 커머스에서의 고객 소통 경험을 근본적으로 혁신하고, 더 높은 고객 만족도와 매출 증대를 실현할 수 있는 기반을 마련했습니다.

문제 해결을 위한 접근 방식

CJ 온스타일의 라이브 커머스 환경에서 실시간 대량 질문 처리라는 기술적 도전을 해결하기 위해 다음과 같은 핵심 접근 방식을 채택했습니다:

1. 데이터 중심 설계 (Data-Driven Architecture)

- 과거 고객 질문 데이터를 머신러닝 군집화로 분석하여 5가지 핵심 질문 유형 도출

- 질문 패턴 기반으로 최적화된 정보 추출 및 응답 전략 수립

2. 멀티 에이전트 분산 처리 (Multi-Agent Distributed Processing)

- 단일 거대 모델 대신 전문화된 에이전트들의 협업 시스템 구축

- Co-Ordinator Agent를 통한 지능형 작업 분배 및 오케스트레이션

3. 서버리스 확장성 아키텍처 (Serverless Scalable Architecture)

- AWS Step Functions와 AWS Lambda를 활용한 병렬 처리로 대용량 데이터 처리 시간 단축

- 트래픽 변동에 자동 대응하는 탄력적 인프라 구성

4. 실시간 최적화 전략 (Real-time Optimization Strategy)

- 질문 복잡도별 차등 처리를 통한 응답 속도 최적화

- 컨텍스트 인식 기반 개인화된 응답 생성

시스템 아키텍처

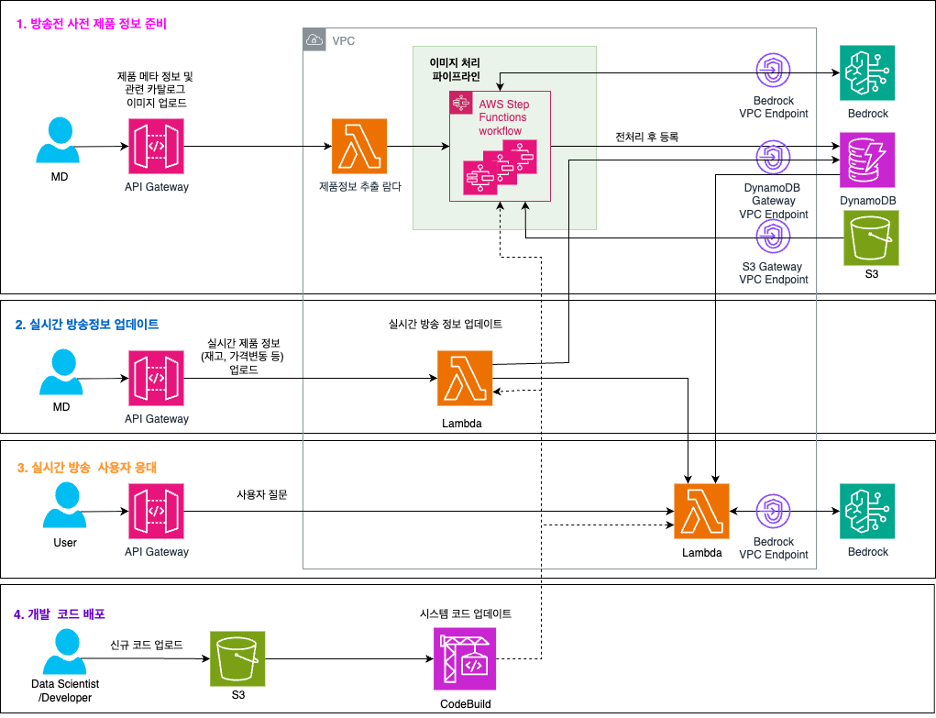

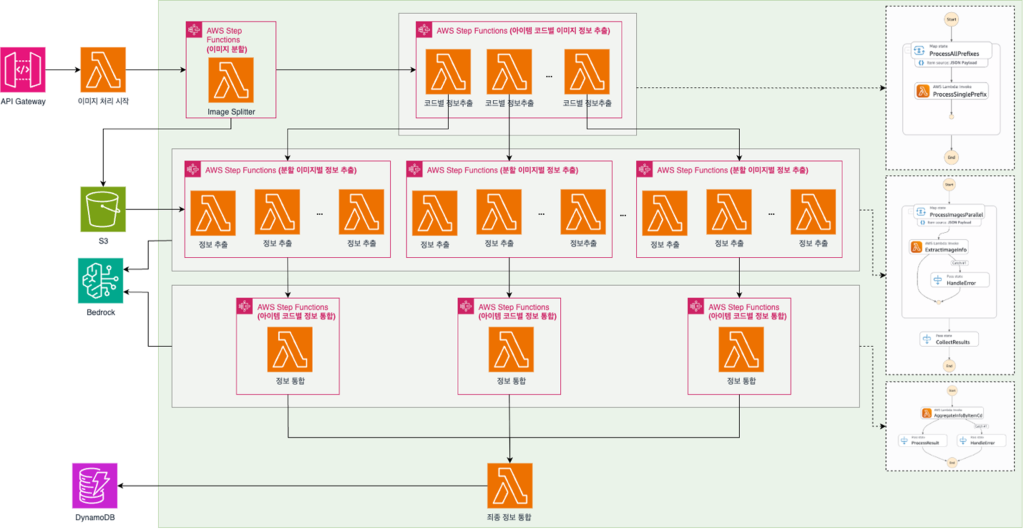

아래는 구현된 시스템의 간략한 아키텍처 입니다.

그림1. 시스템 아키텍처

1. 방송된 사전 제품 정보 준비

- MD (Merchandise)가 제품 정보를 업로드 하면, S3에 저장되고 AWS Step Functions workflow를 통해 처리됩니다.

- 처리된 정보는 Amazon Bedrock 를 통해 구조화된 정보형태로 뽑아져 Amazon DynamoDB에 저장됩니다.

2. 실시간 방송정보 업데이트

- MD가 실시간으로 제품 정보(재고, 가격변동 등)를 업데이트하면 AWS Lambda를 통해 즉시 처리되어 Aamzon DynamoDB에 추가 됩니다.

3. 실시간 방송 시청자 응대

- 사용자가 질문을 하면 Aamzon API Gateway를 거쳐 AWS Lambda에서 처리되고, Amazon Bedrock을 통해 AI 응답을 생성합니다

- Amazon DynamoDB에서 관련 제품 정보를 조회하여 정확한 답변을 제공합니다.

4. 개발 코드 배포

- Data Scientist/Developer가 Amazon S3에 코드를 업로드하면 AWS CodeBuild를 통해 자동 배포됩니다.

다음 섹션에서는 보다 심도있게 AI Agent 구현을 위해 적용하였던 기술들에 대해 상세히 알아보도록 하겠습니다.

AI Agent를 위한 데이터 준비

고객 질문 분석 기반 데이터 추출 Agent 설계

CJ 온스타일에서 라이브 방송에 사용되는 데이터는 텍스트 형태의 제품 정보 메타 데이터와 공급 업체가 제공하는 이미지 형태의 상품 기술서입니다. 상품 기술서 이미지에서 정보를 추출하기 위해 OCR 기능을 제공하는 모델을 사용할 수도 있지만, 이미지 사이즈와 형태가 불특정하고 제품과 직접적으로 관련 없는 정보도 포함되는 경우가 있어 보다 스마트한 방식의 데이터 추출이 필요했습니다.

이를 해결하기 위해 과거 라이브 방송 사용자 채팅 이력을 머신 러닝 군집화 작업을 진행하여 분석하였습니다.

구체적인 분석 단계

- 임베딩 벡터 변환 – 첫 번째 단계에서는 식별된 고객 질문들을 Amazon Bedrock Titan v2 모델을 사용하여 임베딩 벡터로 변환했습니다. 이 과정을 통해 각 질문은 1024차원의 벡터로 표현되어 수치적 분석이 가능한 형태로 변환되었습니다.

- 차원 축소 – 두 번째 단계에서는 고차원 벡터를 UMAP(Uniform Manifold Approximation and Projection) 기법을 활용하여 2차원 벡터로 변환했습니다. 이 과정에서 고차원 공간에서의 거리 관계를 최대한 보존하면서도 시각화가 가능한 형태로 데이터를 압축했습니다.

- 클러스터링 – 세 번째 단계에서는 차원 축소된 데이터 포인트들을 HDBSCAN(Hierarchical Density-Based Spatial Clustering) 알고리즘을 사용하여 군집화했습니다. 하이퍼 파라미터는 min_samples=20으로 설정했으며, 이는 주관적 판단에 따라 선택되었습니다. 그 결과 총 38개의 서로 다른 클러스터가 생성되었습니다.

- 클러스터 분석 및 요약 – 마지막 단계에서는 각 클러스터에 속한 텍스트들을 Amazon Bedrock Claude Sonnet 3.7 모델을 활용하여 의미론적으로 요약했습니다. 동시에 동일한 LLM을 통해 각 클러스터 내에서 일관성이 없거나 다른 성격의 텍스트들을 탐지하고 분류하는 작업을 수행했습니다.

분석 결과

이를 통해 질문이 크게 5가지 유형(주문/결제, 배송/설치, 방송/이벤트, 구매인증, 제품 상세정보)으로 분류됨을 확인할 수 있었습니다. 이러한 군집화 결과를 바탕으로 고객 질문 유형에 최적화된 정보를 추출하는 AI Agent 워크플로우를 구축하기로 결정했습니다.

그림2. 질문 유형 군집화 결과

Group 1: 주문 및 결제 관련

-쿠폰/할인 관련 문의 (쿠폰 위치, 적용 가능 여부, 할인 금액 등)

-카드 할인/결제 관련 문의 (카드사별 할인, 무이자 할부, 결제 방법 등)

-적립금 관련 문의 (적립금 확인, 지급 시기, 사용 방법 등)

-제품 가격 관련 문의 (가격 확인, 인상/인하, 적정성 등)

Group 2: 배송 및 설치 관련

-배송 관련 문의 (배송 시기, 배송일 지정, 배송비 등)

-설치 관련 문의 (설치 일정, 비용, 방법, 직배수 설치 등)

Group 3: 방송 및 이벤트 관련

-방송 일정 관련 문의 (다음 방송 시간, 특정 제품 방송 일정 등)

-선착순 이벤트 관련 문의 (선착순 포함 여부 확인, 마감 여부 등)

-출연자 관련 문의 (의상, 개인 정보, 착용 제품 등)

Group 4: 인증 관련

-구매인증 관련 문의 (인증 방법, 확인, 혜택, 규칙 등)

-주문번호 인증 관련 문의 (인증 필요성, 방법, 혜택 등)

Group 5: 제품 정보 관련

-품절/재입고 관련 문의 (품절 여부, 재입고 시기 등)

-제품 사양/기능 관련 문의 (제품 차이점, 기능, 사용법 등)

-사이즈/색상 관련 문의 (의류 사이즈, 제품 색상, 추천 등)

-제품 구성/구매 관련 문의 (세트 구성, 구매 방법, 사은품 등)

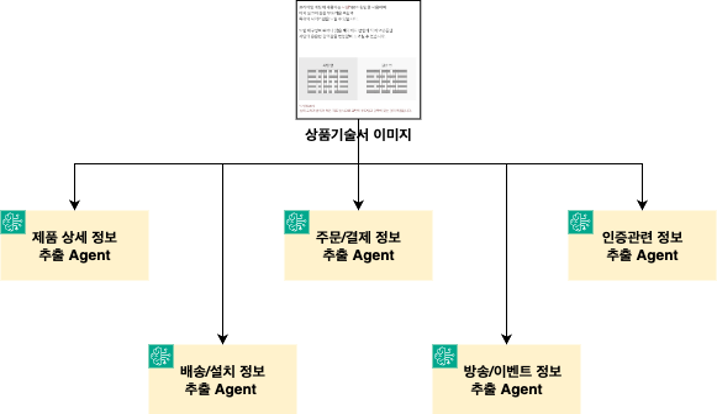

그림3. 정보 추출 Agent

하나의 이미지에 질문 유형별로 대응할 수 있도록 정보를 추출하는 Agent들은 다음과 같습니다.

- 제품상세 AGENT: 스펙, 기능, 재질 정보 등등

- 배송/설치 AGENT: 배송비, 기간, 설치 서비스 등등

- 주문/결제 AGENT: 가격, 할인, 결제 방법 등등

- 방송/이벤트 AGENT: 특가, 혜택, 이벤트 정보 등등

- 인증 AGENT: 구매 인증, 주문번호 인증, 회원 인증 등등

실험을 통해, 하나의 Agent가 모든 정보를 추출하는 것보다, 각각의 페르소나를 가진 Agent가 정보를 추출하는것이 보다 효과적인걸 알 수 있었습니다. 뿐만 아니라, 5개의 Agent 가 병렬적으로 동작을 수행함으로서, 추출 진행 시간도 줄일 수 있었습니다. 이런 병렬 처리 방식으로 이미지 당 정보 추출 시간을 약 3-5초 정도로 줄일 수 있었습니다.

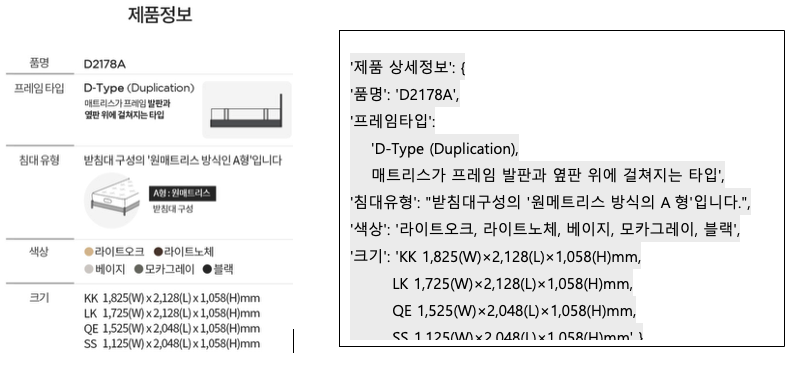

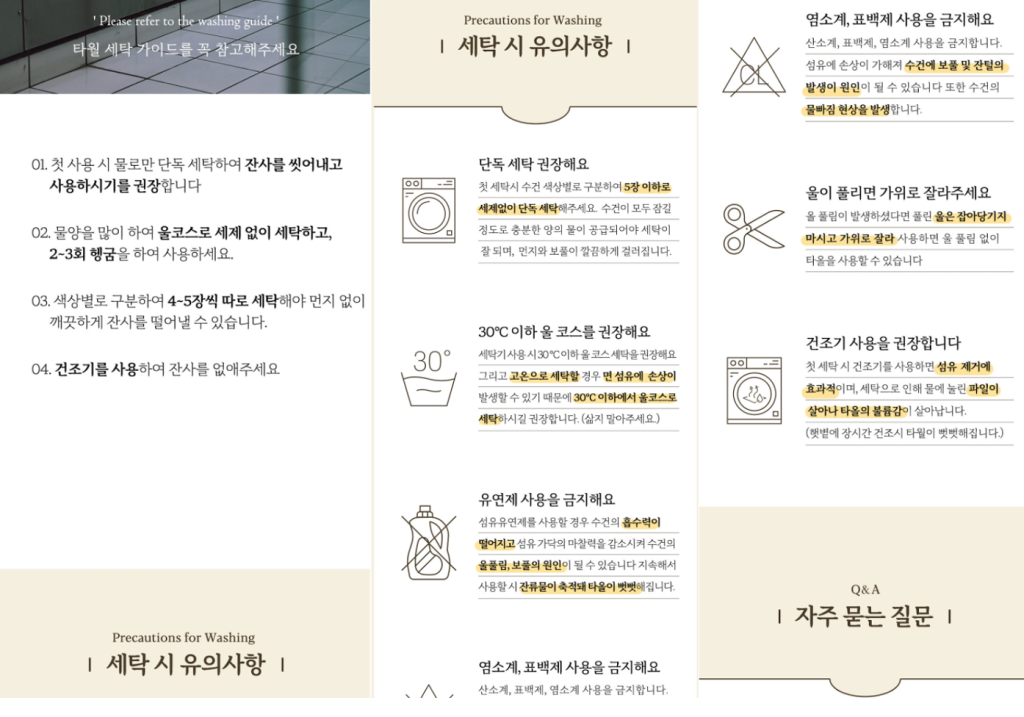

다음은 상품 기술서에서 추출된 제품 상세 정보 예시 입니다.

그림4. 상품기술서 이미지 및 추출 정보 예시

대용량 이미지 기반 병렬 정보 추출

이미지 분할 및 정보 추출 워크플로우

CJ 온스타일의 라이브 커머스에서는 한 방송당 여러 종류의 상품을 소개하고 판매하며, 각 상품마다 상세한 기술서가 이미지 형태로 제공됩니다. 위 그림에서 확인할 수 있듯이, 홈쇼핑의 특성상 다양한 상품을 다루기 때문에 한 방송당 1번, 2번, N번 등 여러 종류의 상품 기술서가 존재하게 됩니다.

이러한 상품 기술서에는 제품의 다양한 특성과 옵션 정보들이 포함되어 있으며, 모바일 사용자의 편의성을 위해 여러 이미지를 세로로 길게 연결한 하나의 긴 파일 형태로 제작됩니다. 하지만 스마트폰 화면에서의 가독성을 위해 제작된 긴 형태의 상품 기술서는 멀티모달 모델이 한 번에 처리하기에는 너무 큰 크기를 가지고 있습니다.

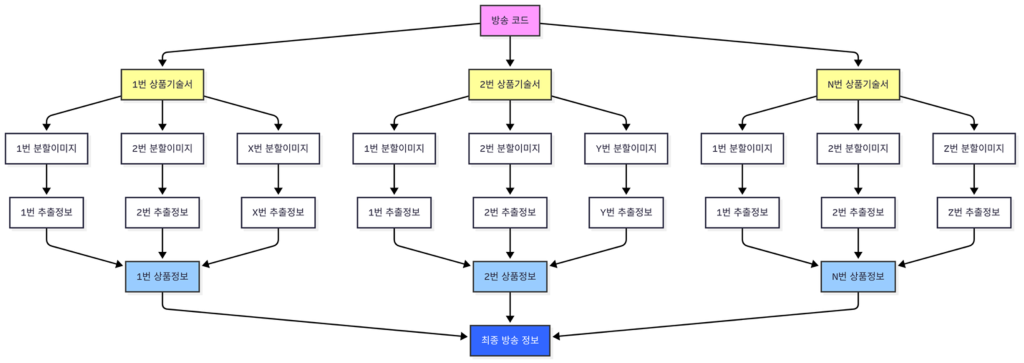

그림5. 상품 기술서 이미지 분할 예시

따라서 모델이 효과적으로 처리할 수 있도록 각 상품 기술서를 적절한 크기로 분할해야 합니다. 그림에서 보는 바와 같이, 하나의 상품 기술서는 1번 분할이미지, 2번 분할이미지, X번 분할이미지 등 여러 개의 작은 이미지로 나뉘게 됩니다.

각 분할된 이미지는 Amazon Bedrock의 Claude Sonnet 3.7모델을 통해 개별적으로 처리되어 해당 구간의 제품 정보를 추출합니다. 이 과정에서 분할된 이미지의 하단부에 위치한 정보가 다음 구간으로 넘어가면서 누락되는 것을 방지하기 위해 중첩(overlap) 방식을 적용하여 분할 이미지 간 일정 부분이 겹치도록 처리합니다.

추출된 개별 정보들은 다시 통합 과정을 거쳐 각 상품별로 완전한 상품 정보가 구성됩니다.최종적으로 모든 상품의 정보는 하나로 취합되어 홈쇼핑 방송 정보로 통합됩니다.

한 방송당 처리해야 할 총 이미지 수는 많게는 600장을 넘어가며, 중첩 분할 처리까지 고려하면 실제 처리량은 이보다 훨씬 많아집니다. 더욱이 이러한 대용량 정보들이 방송 시작 직전에 업로드되는 경우가 많아, 제한된 시간 내에 대량의 이미지를 빠르고 정확하게 처리할 수 있는 확장 가능한 시스템 구축이 필수적이었습니다.

그림6. 상품 코드별 이미지 분할 및 정보 추출 개념도

AWS 서버리스 기반 병렬 처리 아키텍처

이 복잡한 워크플로우를 효율적으로 처리하기 위해 AWS Step Function의 여러개의 Workflow와 AWS Lambda 를 활용한 다음과 같은 시스템을 설계했습니다. 그럼 아래 그림은 해당 스탭의 상세 내용입니다.

그림7. 상품 코드별 이미지 분할 및 정보 추출 파이프라인 아키텍처

시스템 처리 흐름

고객이 방송용 원시 데이터(복수의 상품 기술서 및 방송 정보)를 S3에 업로드한 후, Amazon API Gateway 엔드포인트를 통해 이미지 전처리 AWS Lambda를 호출하면 다음과 같은 단계별 처리가 진행됩니다:

- 1단계: 이미지 분할 처리대용량 상품 기술서 이미지들을 멀티모달 모델이 처리할 수 있는 최적 크기로 병렬 분할하여 Amazon S3에 저장합니다.

- 2단계: AI 기반 정보 추출 각 분할된 이미지에서 Amazon Bedrock Claude Sonnet 4.0을 활용하여 제품 정보를 추출하고 결과를 Amazon S3에 저장합니다.

- 3단계: 상품별 정보 통합 동일 상품의 분할된 정보들을 취합하여 완전한 상품 정보를 구성한 후 Amazon S3에 저장합니다.

- 4단계: 방송 정보 최종 통합 모든 상품 정보를 하나의 방송 데이터로 통합하여 DynamoDB에 저장합니다.

실시간 정보 업데이트 파이프라인

실시간으로 방송 중 변경되는 정보(재고, 가격 등)는 별도의 업데이트 파이프라인을 통해 동일한 DynamoDB에 즉시 반영됩니다.

성능 최적화 결과

이러한 병렬 처리 아키텍처를 통해 순차 처리 시 수 백 시간이 소요될 수 있는 프로세스를 약 10분 내로 단축하여 획기적인 성능 향상을 달성했습니다.

Agentic AI 기반 실시간 지능형 응답 시스템

앞서 살펴본 데이터 준비 과정을 통해 구조화된 제품 정보가 준비되었다면, 이제 실제로 고객의 질문이 들어왔을 때 AI 에이전트들이 어떻게 협업하여 실시간으로 지능형 응답을 생성하는지 살펴보겠습니다.

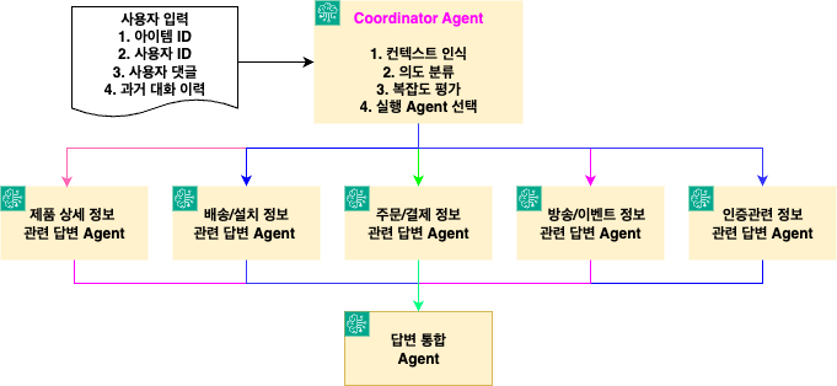

멀티 에이전트 협업을 통한 고도화된 질문 처리

라이브 커머스 환경에서는 다양한 형태의 고객 코멘트가 실시간으로 유입되지만, 이 중 실질적인 질문에 해당하는 것은 일부에 불과합니다. 이러한 환경에서 효율적인 응답 시스템을 구축하기 위해 Amazon Nova Pro를 활용하여 1초 이내에 질문 여부를 판별하는 Agentic AI 시스템을 설계했습니다.

그림 8. 멀티 에이전트 아키텍처

Co-Ordinator Agent의 지능형 오케스트레이션

위 아키텍처에서 핵심 역할을 담당하는 Co-Ordinator Agent는 단순한 라우팅을 넘어 고도의 분석과 의사결정을 수행합니다. 인입된 고객 코멘트(분홍색 박스)에 대해 다음과 같은 지능형 처리를 진행합니다:

- 컨텍스트 인식: 고객의 과거 코멘트 히스토리를 분석하여 개인화된 응답 전략을 수립

- 의도 분류: 5가지 주요 도메인(주문/결제, 배송/설치, 방송/이벤트, 구매인증, 제품 상세정보)에 대한 지능형 분류

- 복잡도 평가: 질문의 난이도와 필요한 정보 범위를 판단하여 최적의 에이전트 조합 결정

- 실행 Agent 선택: 단일 전문 에이전트 또는 다중 에이전트 협업이 필요한지 실시간으로 판단

전문화된 에이전트 생태계

각 전문 에이전트는 특정 도메인에 특화된 지식과 처리 능력을 보유하며, Co-Ordinator Agent의 지시에 따라 독립적으로 또는 협업하여 작업을 수행합니다. 이러한 에이전트들은 앞서 구축된 구조화된 제품 정보를 바탕으로 정확하고 신속한 응답을 생성합니다.

Agentic AI 아키텍처의 성능 이점

전통적인 단일 모델 접근 방식 대신 멀티 에이전트 시스템을 채택한 이유는 다음과 같습니다. 모든 정보를 하나의 거대한 시스템 프롬프트에 포함할 경우, Transformer 아키텍처의 O(n²) 복잡도로 인해 응답 지연이 발생합니다. 반면 각 에이전트가 특화된 영역의 정보만을 처리함으로써 정확성과 속도를 동시에 확보할 수 있습니다.

이러한 Agentic AI 시스템을 통해 고객 질문의 복잡성과 다양성에 적응적으로 대응하면서도 일관된 고품질의 실시간 응답을 제공할 수 있게 되었습니다.

시스템 도입 성과 및 실증 결과

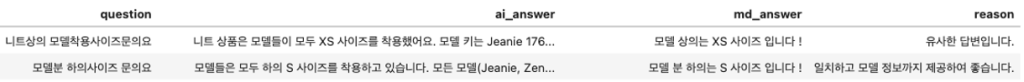

AI 응답 품질 검증

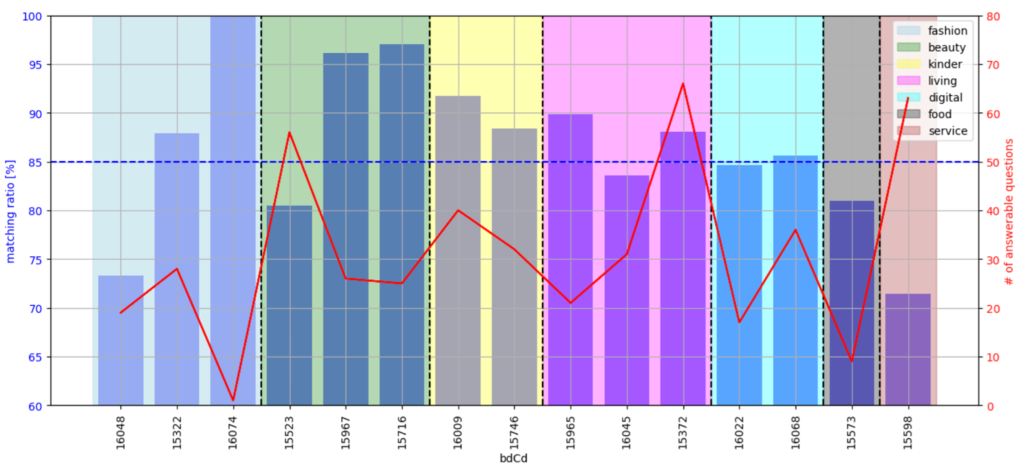

시스템 도입 전 과거 방송 15개 대상으로 AI 답변의 신뢰성 검증을 위해 기존 질문이 MD의 답변과 일치한지에 대한 테스트를 진행해 보았습니다. Amazon Bedrock의 Claude Sonnet 3.7 모델을 활용한 LLM-as-Judge방식으로 에이전트를 평가자로 적용했으며, MD가 응답한 댓글들만을 대상으로 검토했습니다. AI 답변이 MD 답변보다 길어지는 경향이 있기 때문에, 아래 그림에서 보는 바와 같이 AI 답변이 MD 답변을 포괄하는 경우 일치하는 것으로 평가했습니다.

그림 9. AI 답변과 기존 담당자 답변 비교 예시

AI 응답의 신뢰성을 검증하기 위해 동일한 질문에 대한 반복 테스트를 실시했습니다. 가장 낮은 temperature와 top k 설정을 적용하여 응답의 일관성을 최대화하려 했으나, LLM의 특성상 미묘하게 다른 응답이 생성되는 현상을 확인할 수 있었습니다. 이러한 변동성으로 인해 측정된 일치율은 테스트마다 차이를 보였으며 단일 응답 케이스에서 85%의 일치도를 기록했습니다.

그림 10. 방송별 AI 답변과 담당자 답변 일치도 평가 결과 (bdCd: 방송코드)

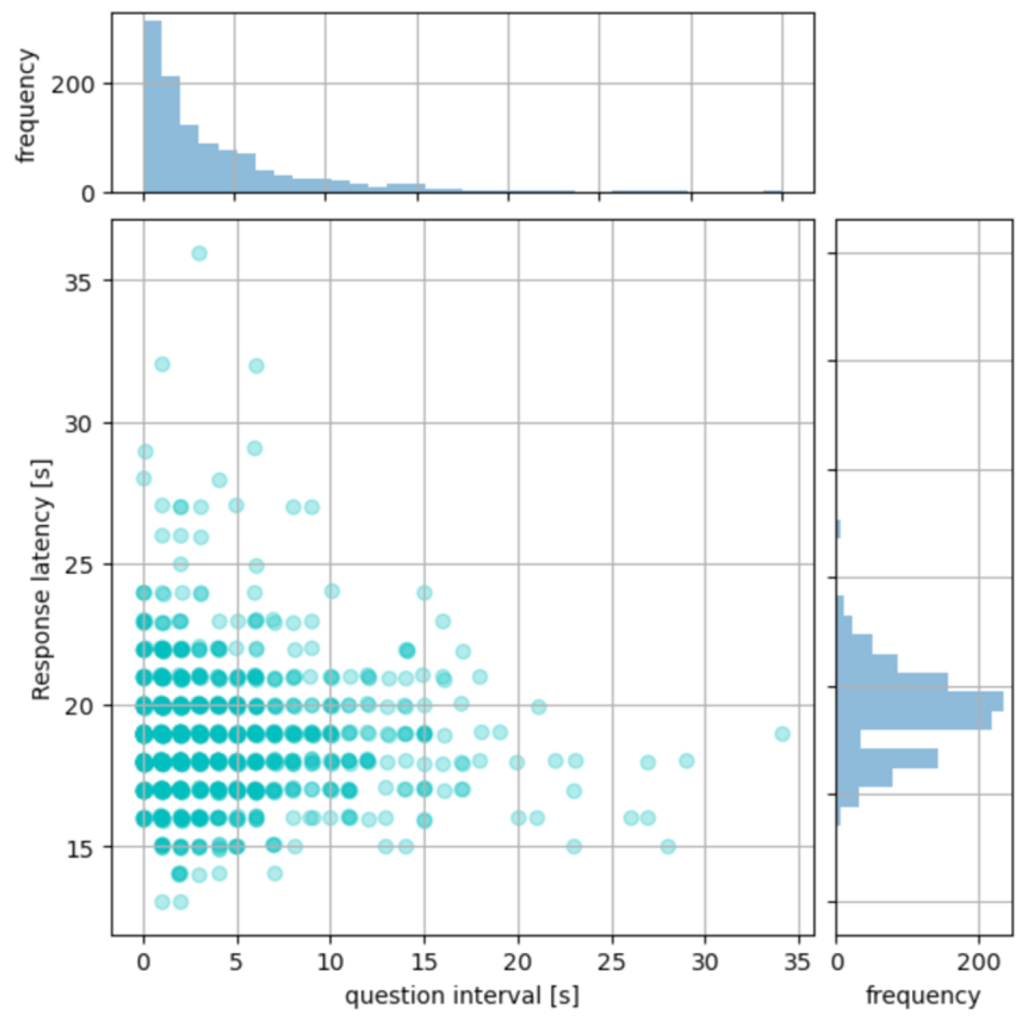

AI 응답 속도 및 트래픽 영향 분석

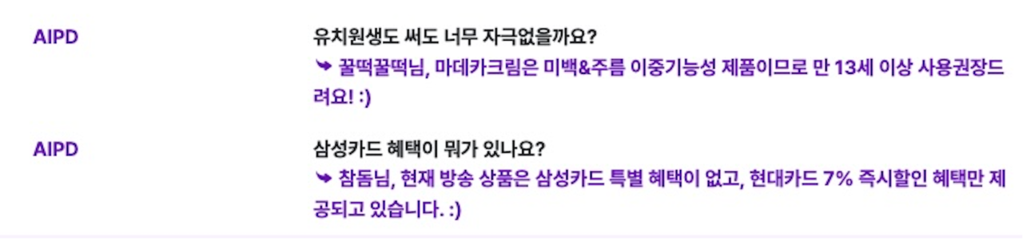

여기에서는 2025년 9월에 진행된 두 개의 라이브 홈쇼핑 방송에 실제로 Agentic AI 기반 실시간 지능형 응답 시스템이 적용된 결과를 바탕으로 응답 속도와 트래픽 부하에 따른 영향도에 대해 알아보도록 하겠습니다. 총 1098개의 코멘트에 대해 AI가 응답을 제공하였는데 아래는 일부 질문과 응답 예시입니다.

아래 그래프에서 수평축(question interval)은 이전 질문으로부터 경과시간을 의미하며, 이 값이 작을수록 단시간 내에 많은 질문이 집중되는 높은 트래픽 상황을 나타냅니다. 수직축은 AI 처리시간(Response latency)을 보여주며, 이는 시청자가 질문 후 답변을 받기까지의 소요 시간입니다.

분석 결과, 두 변수 간의 상관관계는 거의 없는 것으로 나타났습니다(Pearson coefficient: -0.05). 이는 트래픽이 집중되는 상황에서도 AI 응답 처리 성능에는 거의 영향을 주지 않음을 의미합니다.

AI 응답 시간의 차이는 트래픽 부하보다는 질문의 복잡성과 난이도에 따른 것으로 분석됩니다. 단순한 제품 정보 문의의 경우 빠른 응답이 가능하지만, 복잡한 비교 분석이나 상세한 설명이 필요한 질문의 경우 더 많은 정보 검색과 검증 과정이 필요하기 때문에 응답 시간이 길어지는 경향을 보입니다.

그림 11. 응답 시간 및 질문 간 간격 비교

Agentic AI Application 구현을 위한 AWS의 강점

CJ 온스타일의 성공적인 Agentic AI 시스템 구축은 AWS의 통합된 AI/ML 서비스와 서버리스 아키텍처가 제공하는 독특한 장점들이 결합된 결과입니다.

1. 통합된 AI/ML 서비스 생태계

- Amazon Bedrock을 통한 다양한 Foundation Model 원스톱 액세스

- 모델별 특성에 맞는 최적 선택 및 조합 가능 (Nova Pro, Claude Sonnet 등)

2. 서버리스 기반 확장성

- AWS Lambda와 AWS Step Functions의 완벽한 통합으로병렬 처리 지원

- 트래픽 급증 시에도 자동 스케일링으로 안정적 서비스 제공

3. 실시간 데이터 처리 최적화

- Amazon API Gateway + AWS Lambda 조합으로 밀리초 단위 응답 시간 달성

- Amazon DynamoDB의 고성능 NoSQL로 실시간 정보 업데이트 및 조회

4. 개발 및 운영 효율성

- CodeBuild를 통한 자동 배포 파이프라인으로 빠른 개발 사이클 지원

- CloudWatch 모니터링으로 실시간 성능 추적 및 최적화

5. 비용 효율성

- 사용량 기반 과금으로 초기 투자 부담 최소화

- 서버리스 아키텍처로 유지보수 비용 절감

맺음말

CJ 온스타일의 Agentic AI 도입 사례는 전통적인 라이브 커머스의 한계를 혁신적으로 극복한 성공 모델입니다. 답변율 3배 증가, 85.7% 고객 만족도, 평균 20초 내 응답이라는 정량적 성과는 단순한 기술 도입을 넘어 고객 경험의 근본적 변화를 보여줍니다.

이 프로젝트의 핵심 성공 요인은 데이터 기반 설계, 멀티 에이전트 협업, 서버리스 확장성이라는 세 가지 축이 AWS의 통합 AI 플랫폼 위에서 완벽하게 조화를 이룬 점입니다. 특히 고객 질문 패턴 분석을 통한 전문화된 에이전트 설계와 실시간 대용량 처리를 위한 병렬 아키텍처는 향후 유사 프로젝트의 참고 모델이 될 것입니다.

AWS Generative AI 기술과 서버리스 아키텍처의 결합은 단순히 기술적 우수성을 넘어 비즈니스 가치 창출이라는 실질적 성과로 이어졌습니다. 이는 생성형 AI가 실험적 기술에서 핵심 비즈니스 인프라로 진화했음을 보여주는 대표적 사례로, 다른 기업들의 AI 전환 전략에 중요한 인사이트를 제공합니다.

향후 계획

CJ 온스타일은 이번 AI 시스템을 모바일 라이브 방송에서 성공적으로 운영한 결과를 바탕으로, 향후 모든 라이브 커머스 방송으로 적용 범위를 단계적으로 확대해 나갈 예정입니다. 초기 도입 성과에서 확인된 응답률 향상과 고객 만족도 증대를 토대로, 더 많은 방송에서 고객들이 실시간으로 정확한 정보를 받을 수 있는 환경을 구축하고자 합니다. 이를 통해 CJ 온스타일은 라이브 커머스 플랫폼에서의 차별화된 경쟁 우위를 지속적으로 강화하고, 궁극적으로 전체 고객 경험의 혁신을 실현할 계획입니다. AWS의 생성형 AI 기술과 함께 구축한 이 시스템이 향후 라이브 커머스 업계 전반의 새로운 표준이 될 것으로 기대됩니다.