O que é RLHF?

O Reinforcement Learning from Human Feedback (RLHF – Aprendizado por reforço com base no feedback humano) é uma técnica de machine learning (ML) que usa feedback humano para otimizar modelos de ML para autoaprendizagem com mais eficiência. As técnicas de aprendizado por reforço (RL) treinam o software para tomar decisões que maximizem as recompensas, tornando seus resultados mais precisos. O RLHF incorpora o feedback humano na função de recompensas, para que o modelo de ML possa realizar tarefas mais alinhadas aos objetivos, desejos e necessidades humanos. O RLHF é usado em todas as aplicações de inteligência artificial generativa (IA generativa), inclusive em grandes modelos de linguagem (LLM).

Por que o RLHF é importante?

As aplicações de inteligência artificial (IA) são abrangentes, desde carros autônomos até processamento de linguagem natural (PLN), preditores do mercado de ações e serviços de personalização de varejo. Independentemente da aplicação, o objetivo da IA é, em última análise, imitar as respostas, os comportamentos e a tomada de decisões humanas. O modelo de ML deve codificar a entrada humana como dados de treinamento para que a IA imite os humanos mais de perto ao concluir tarefas complexas.

O RLHF é uma técnica específica usada no treinamento de sistemas de IA para parecerem mais humanos, juntamente com outras técnicas, como aprendizado supervisionado e não supervisionado. Primeiro, as respostas do modelo são comparadas às respostas de um humano. Em seguida, um humano avalia a qualidade das diferentes respostas da máquina, pontuando quais respostas parecem mais humanas. A pontuação pode ser baseada em qualidades humanas inatas, como simpatia, grau certo de contextualização e humor.

O RLHF é proeminente na compreensão da linguagem natural, mas também é usado em outras aplicações de IA generativa.

Leia sobre a inteligência artificial

Leia sobre o processamento de linguagem natural

Leia sobre a diferença entre aprendizado supervisionado e não supervisionado

Melhora a performance da IA

O RLHF torna o modelo de ML mais preciso. Você pode treinar um modelo que pode ser treinado em dados humanos pré-gerados, mas ter ciclos adicionais de feedback humano melhora significativamente a performance do modelo em comparação com seu estado inicial.

Por exemplo, quando o texto é traduzido de um idioma para outro, um modelo pode produzir um texto tecnicamente correto, mas que não soe natural para o leitor. Um tradutor profissional pode primeiro realizar a tradução, com a tradução gerada por máquina pontuada em comparação com ela, e então uma série de traduções geradas por máquina pode ser pontuada em termos de qualidade. A adição de treinamento adicional ao modelo o torna melhor na produção de traduções com som natural.

Apresenta parâmetros de treinamento complexos

Em alguns casos, na IA generativa, pode ser difícil treinar com precisão o modelo para determinados parâmetros. Por exemplo, como você define o clima de uma peça musical? Pode haver parâmetros técnicos, como tecla e tempo, que indiquem um certo humor, mas o espírito de uma peça musical é mais subjetivo e menos definido do que apenas uma série de detalhes técnicos. Em vez disso, você pode fornecer orientação humana onde os compositores criam peças temperamentais e, em seguida, rotular peças geradas por máquina de acordo com seu nível de mau humor. Isso permite que uma máquina aprenda esses parâmetros com muito mais rapidez.

Melhora a satisfação do usuário

Embora um modelo de ML possa ser preciso, ele pode não parecer humano. O RL é necessário para guiar o modelo em direção à melhor e mais envolvente resposta para usuários humanos.

Por exemplo, se você perguntasse a um chatbot como está o tempo lá fora, ele pode responder: “Está 30 graus Celsius com nuvens e alta umidade” ou pode responder: “A temperatura está em torno de 30 graus no momento. Está nublado e úmido, então o ar pode parecer mais denso!”. Embora ambas as respostas digam a mesma coisa, a segunda resposta parece mais natural e fornece mais contexto.

À medida que os usuários humanos avaliam quais respostas de modelo preferem, você pode usar o RLHF para coletar feedback humano e melhorar seu modelo para melhor atender pessoas reais.

Como funciona o RLHF?

O RLHF é realizado em quatro estágios antes que o modelo seja considerado pronto. Aqui, usamos o exemplo de um modelo de linguagem, um chatbot interno da base de conhecimento da empresa, que usa RLHF para refinamento.

Damos apenas uma visão geral do processo de aprendizagem. Existe uma complexidade matemática significativa no treinamento do modelo e no refinamento de sua política para RLHF. No entanto, os processos complexos são bem definidos no RLHF e geralmente têm algoritmos pré-construídos que simplesmente precisam de suas entradas exclusivas.

Coleta de dados

Antes de realizar tarefas de ML com o modelo de linguagem, um conjunto de prompts e respostas geradas por humanos é criado para os dados de treinamento. Esse conjunto é usado posteriormente no processo de treinamento do modelo.

Por exemplo, os prompts podem ser:

- “Onde fica o departamento de RH em Boston?”

- “Qual é o processo de aprovação de publicações nas redes sociais?”

- “O que o relatório do primeiro trimestre indica sobre as vendas em comparação com os relatórios trimestrais anteriores?”

Em seguida, um trabalhador do conhecimento da empresa responde a essas perguntas com respostas precisas e naturais.

Ajuste detalhado supervisionado de um modelo de linguagem

Você pode usar um modelo comercial pré-treinado como modelo básico para RLHF. Você pode ajustar o modelo à base de conhecimento interna da empresa usando técnicas como a geração aumentada de recuperação (RAG). Quando o modelo é ajustado, você compara sua resposta aos prompts predeterminados com as respostas humanas coletadas na etapa anterior. O grau de similaridade entre os dois pode ser calculado utilizando-se técnicas matemáticas.

Por exemplo, as respostas geradas por máquina podem receber uma pontuação entre 0 e 1, sendo 1 a mais precisa e 0 a menos precisa. Com essas pontuações, o modelo agora tem uma política projetada para formar respostas com pontuação mais próxima das respostas humanas. Essa política forma a base de todas as futuras tomadas de decisão do modelo.

Como criar um modelo de recompensa separado

O núcleo do RLHF é treinar um modelo de recompensa de IA separado com base no feedback humano e, em seguida, usar esse modelo como uma função de recompensa para otimizar a política por meio do RL. Dado um conjunto de várias respostas do modelo respondendo ao mesmo prompt, os humanos podem indicar sua preferência em relação à qualidade de cada resposta. Você usa essas preferências de classificação de resposta para criar o modelo de recompensa que estima automaticamente o quão alto um humano pontuaria em qualquer resposta ao prompt.

Otimize o modelo de linguagem com o modelo baseado em recompensas

O modelo de linguagem então usa o modelo de recompensa para refinar automaticamente sua política antes de responder aos prompts. Usando o modelo de recompensa, o modelo de linguagem avalia internamente uma série de respostas e, em seguida, escolhe a resposta com maior probabilidade de resultar na maior recompensa. Isso significa que ele atende às preferências humanas de uma maneira mais otimizada.

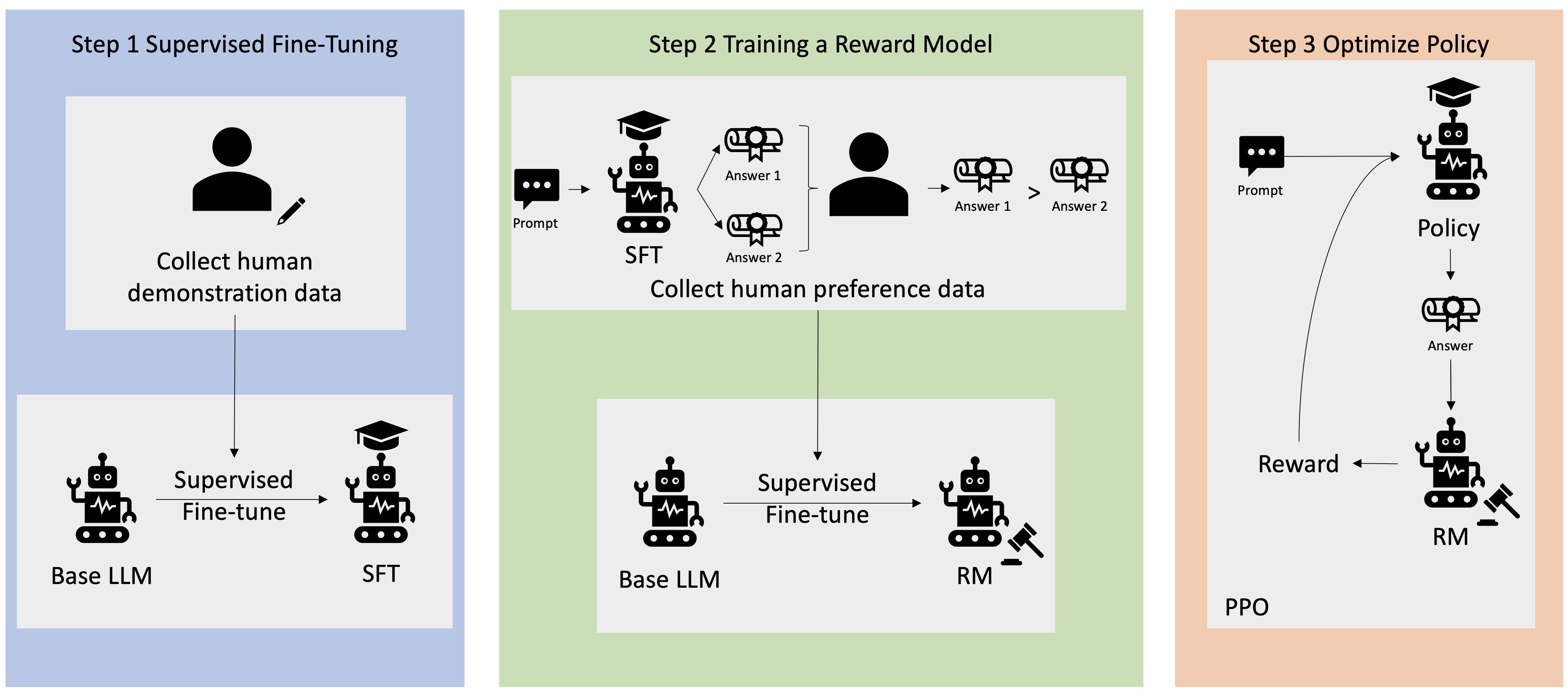

A imagem a seguir mostra uma visão geral do processo de aprendizado da RLHF.

Como o RLHF é usado no campo da IA generativa?

A RLHF é reconhecida como a técnica padrão do setor para garantir que os LLMs produzam conteúdo verdadeiro, inofensivo e útil. No entanto, a comunicação humana é um processo subjetivo e criativo, e a utilidade da produção do LLM é profundamente influenciada pelos valores e preferências humanos. Cada modelo é treinado de forma um pouco diferente e usa respondedores humanos diferentes, portanto, os resultados diferem até mesmo entre LLMs concorrentes. O grau em que cada modelo envolve valores humanos depende totalmente do criador.

As aplicações do RLHF vão além dos limites dos LLMs para outros tipos de IA generativa. Veja alguns exemplos:

- O RLHF pode ser usado na geração de imagens por IA: por exemplo, medindo o grau de realismo, tecnicidade ou humor da obra de arte

- Na geração de música, o RLHF pode ajudar na criação de músicas que combinam certos estados de espírito e trilhas sonoras com atividades

- O RLHF pode ser usado em um assistente de voz, orientando a voz a soar mais amigável, curiosa e confiável

Como a AWS pode ajudar com seus requisitos de RLHF?

O Amazon SageMaker Ground Truth oferece o conjunto mais abrangente de recursos human-in-the-loop para incorporar feedback humano em todo o ciclo de vida de ML para melhorar a precisão e a relevância do modelo. Você pode realizar várias tarefas intuitivas, desde a geração e anotação de dados até a geração de modelos de recompensas, revisão de modelos e personalização por meio de uma oferta gerenciada por autoatendimento ou pela AWS.

O SageMaker Ground Truth inclui um anotador de dados para recursos de RLHF. Você pode dar feedback direto e orientação sobre os resultados que um modelo gerou ao classificar, classificar ou fazer as duas coisas em suas respostas aos resultados de RL. Os dados, chamados de dados de comparação e classificação, são efetivamente um modelo de recompensa ou função de recompensa, que é então usado para treinar o modelo. Você pode usar dados de comparação e classificação para personalizar um modelo existente para seu caso de uso ou para ajustar um modelo criado do zero.

Comece a usar as técnicas de RLHF na AWS criando uma conta hoje mesmo.

Próximas etapas na AWS

Obtenha acesso instantâneo ao nível gratuito da AWS.