Amazon Web Services ブログ

Amazon Bedrockは、開発者がより賢く、より正確なAIモデルを構築する方法を簡素化する強化学習によるファインチューニングを追加しました

組織は、AI モデルを自社の具体的なビジネスニーズに適応させる際に、難しい選択を迫られます。平均的な結果しか出ない汎用モデルで妥協するか、高度なモデルカスタマイズの複雑さとコストに挑むかです。従来の方法では、小規模モデルでは性能が低く、大規模モデルでは高コストや複雑なインフラストラクチャの管理が必要になるという選択を強いられます。強化学習による微調整は、大規模なラベル付きデータセットではなくフィードバックを使ってモデルを訓練する高度な手法ですが、実装には通常、専門的な機械学習の知識、複雑なインフラ、および多大な投資が必要であり、特定のユースケースに必要な精度が得られる保証はありません。

2025 年 12 月 3 日、 Amazon Bedrock の強化微調整について発表しました。これは、フィードバックから学び、特定のビジネスニーズに合わせてより質の高いアウトプットを提供する、よりスマートで費用対効果の高いモデルを作成する新しいモデルカスタマイズ機能です。強化型微調整は、報酬信号に基づいてモデルが反復的に改善されるフィードバック駆動型のアプローチを使用し、基本モデルに比べて平均で 66% の精度向上をもたらします。

Amazon Bedrock は強化微調整のワークフローを自動化し、深い機械学習 (ML) の専門知識や大規模なラベル付きデータセットを必要とせずに、この高度なモデルカスタマイズ手法を日常の開発者が利用できるようにしています。

強化微調整の仕組み

強化学習の微調整は、ビジネス要件とユーザーの好みに合ったアウトプットを一貫してモデルが生成されるようにするという共通の課題に対処するために、強化学習の原則に基づいて構築されています。

従来のファインチューニングは大規模なラベル付きデータセットと高額な人的注釈を必要としますが、強化学習によるファインチューニングは異なるアプローチを取ります。固定された例から学習するのではなく、報酬関数を使って、特定のビジネス用途に対してどの応答が良いとされるかを評価・判断します。これは、膨大な量の事前ラベル付きトレーニングデータを必要とせずに、モデルが高品質な応答の条件を理解できるように教えるもので、Amazon Bedrock での高度なモデルカスタマイズをより手軽でコスト効果の高いものにします。

Amazon Bedrock で強化微調整を使用する利点は次のとおりです。

- 使いやすさ — Amazon Bedrock は複雑さの多くを自動化し、AI アプリケーションを構築する開発者が強化の微調整をより簡単に行えるようにします。Amazon Bedrock の既存の API ログを使用するか、データセットをトレーニングデータとしてアップロードしてモデルをトレーニングできるため、ラベル付けされたデータセットやインフラストラクチャの設定は不要です。

- モデルパフォーマンスの向上 — 強化による微調整により、基本モデルと比較してモデルの精度が平均 66% 向上し、より小さく、より速く、より効率的なモデルバリアントをトレーニングすることで、価格とパフォーマンスを最適化できます。これは Amazon Nova 2 Lite モデルと連携し、特定のビジネスニーズに合わせて品質と価格パフォーマンスを向上させ、他のモデルも間もなくサポートする予定です。

- セキュリティ — データはカスタマイズプロセス全体を通して安全な AWS 環境内に留まるため、セキュリティとコンプライアンスの懸念が軽減されます。

この機能は、モデルを柔軟に最適化するための次の 2 つの補完的なアプローチをサポートします。

- 検証可能な報酬を伴う強化学習 (RLVR) では、コード生成や数学推論などの客観的なタスクにルールベースの採点器を使用します。

- AI フィードバックによる強化学習 (RLAIF) では、指導のフォローやコンテンツのモデレーションなどの主観的なタスクに AI ベースのジャッジを採用しています。

Amazon Bedrockで補強材の微調整を始める

それでは、補強微調整ジョブの作成について順を追って見ていきましょう。

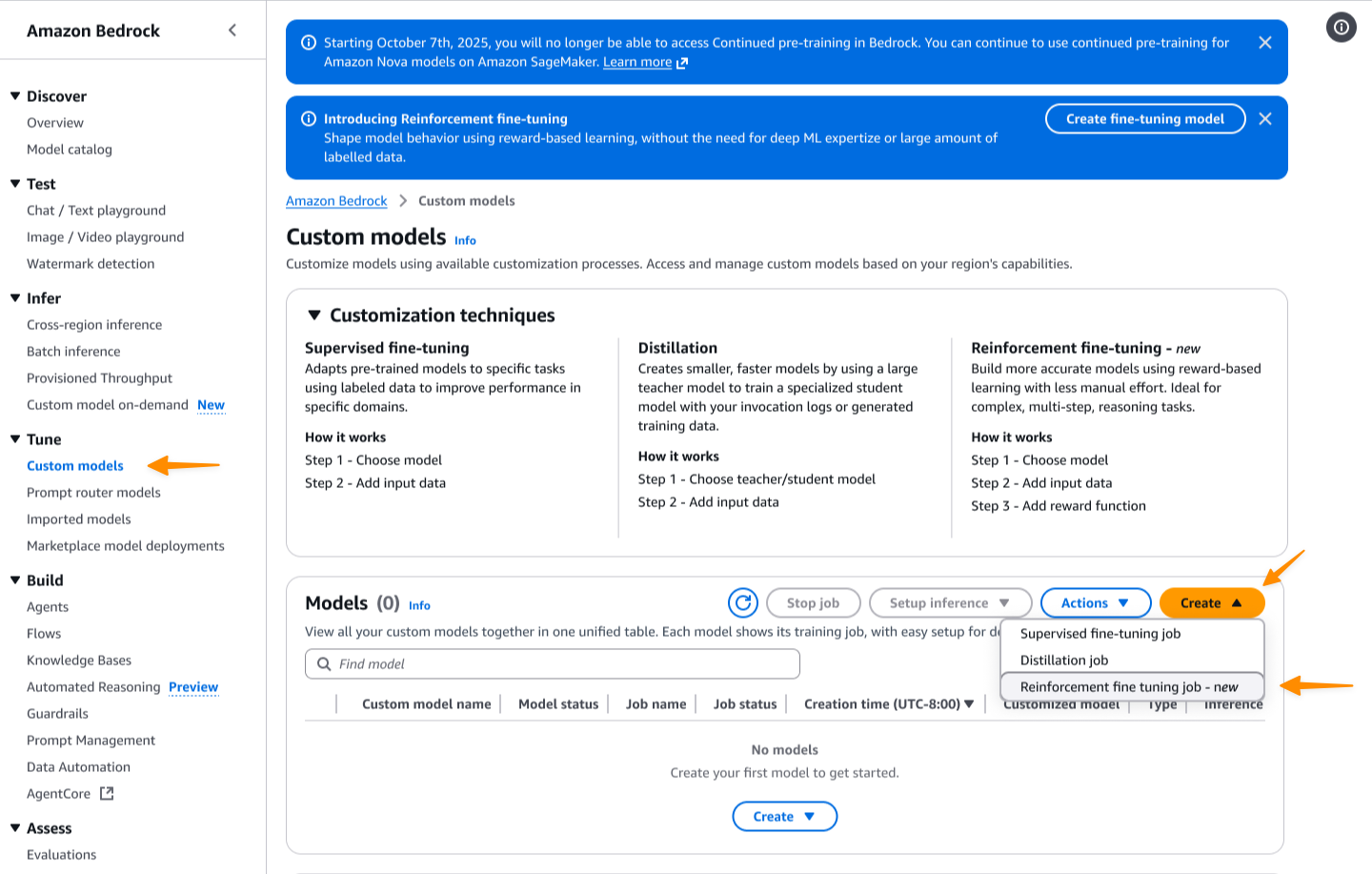

まず、 Amazon Bedrock コンソールにアクセスします。次に、「カスタムモデル」ページに移動します。[作成] を選択し、次に [強化微調整ジョブ] を選択します。

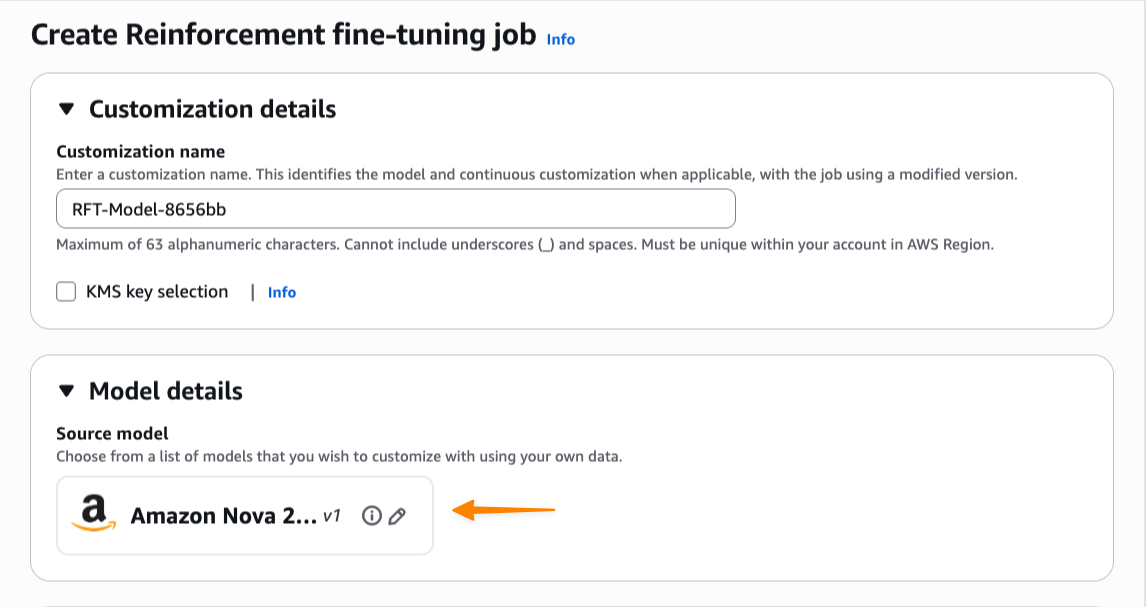

まずこのカスタマイズ作業の名前を入力し、次に基本モデルを選択します。発売時点では、補強の微調整により Amazon Nova 2 Lite がサポートされ、その他のモデルも間もなくサポートされる予定です。

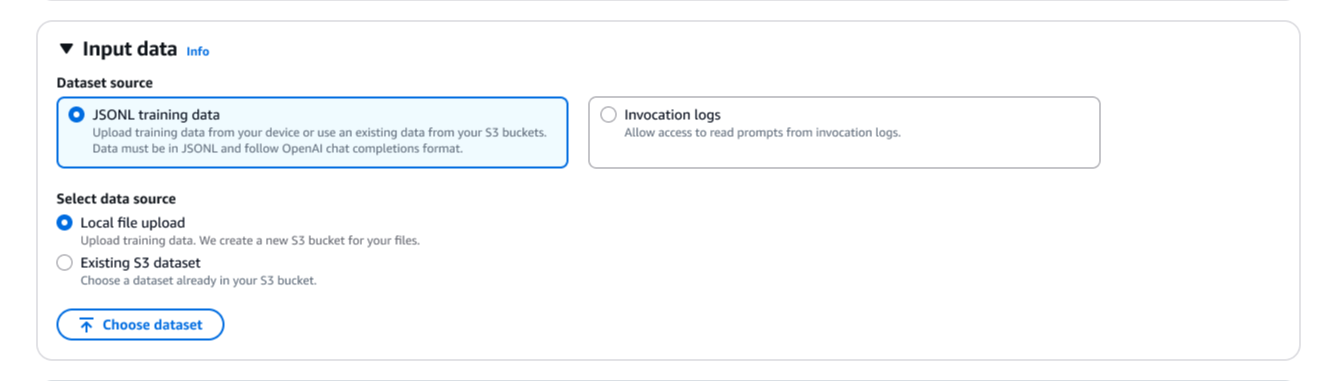

次に、トレーニングデータを提供する必要があります。保存されている呼び出しログを直接使用できるため、個別のデータセットをアップロードする必要がありません。新しい JSONL ファイルをアップロードしたり、 Amazon シンプルストレージサービス (Amazon S3) から既存のデータセットを選択したりすることもできます。強化微調整を行うと、トレーニングデータセットが自動的に検証され、OpenAI Chat Completions データ形式がサポートされます。呼び出しログを Amazon Bedrock 呼び出し形式または逆形式で提供すると、Amazon Bedrock はそれらをチャット完了形式に自動的に変換します。

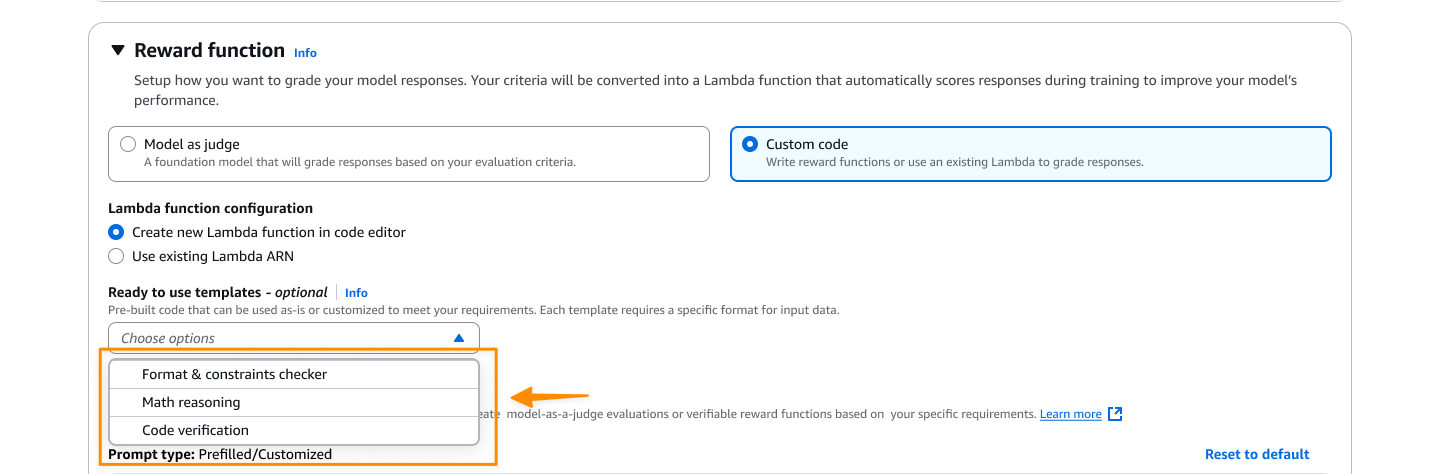

リワード機能の設定では、何が良い反応になるかを定義します。ここで私は二つの選択肢があります。客観的なタスクについては、カスタムコードを選択し、 AWS Lambda 関数を介して実行されるカスタム Python コードを記述できます。より主観的な評価を行う場合は、審査員としてモデルを選択するか、評価指示を出すことでファンデーションモデル(FM)を審査員として使用できます。

ここでは、カスタムコードを選択し、新しい Lambda 関数を作成するか、既存の Lambda 関数を報酬関数として使用します。提供されているテンプレートの1つから始めて、特定のニーズに合わせてカスタマイズできます。

学習率、バッチサイズ、エポックなどのデフォルトのハイパーパラメータをオプションで変更できます。

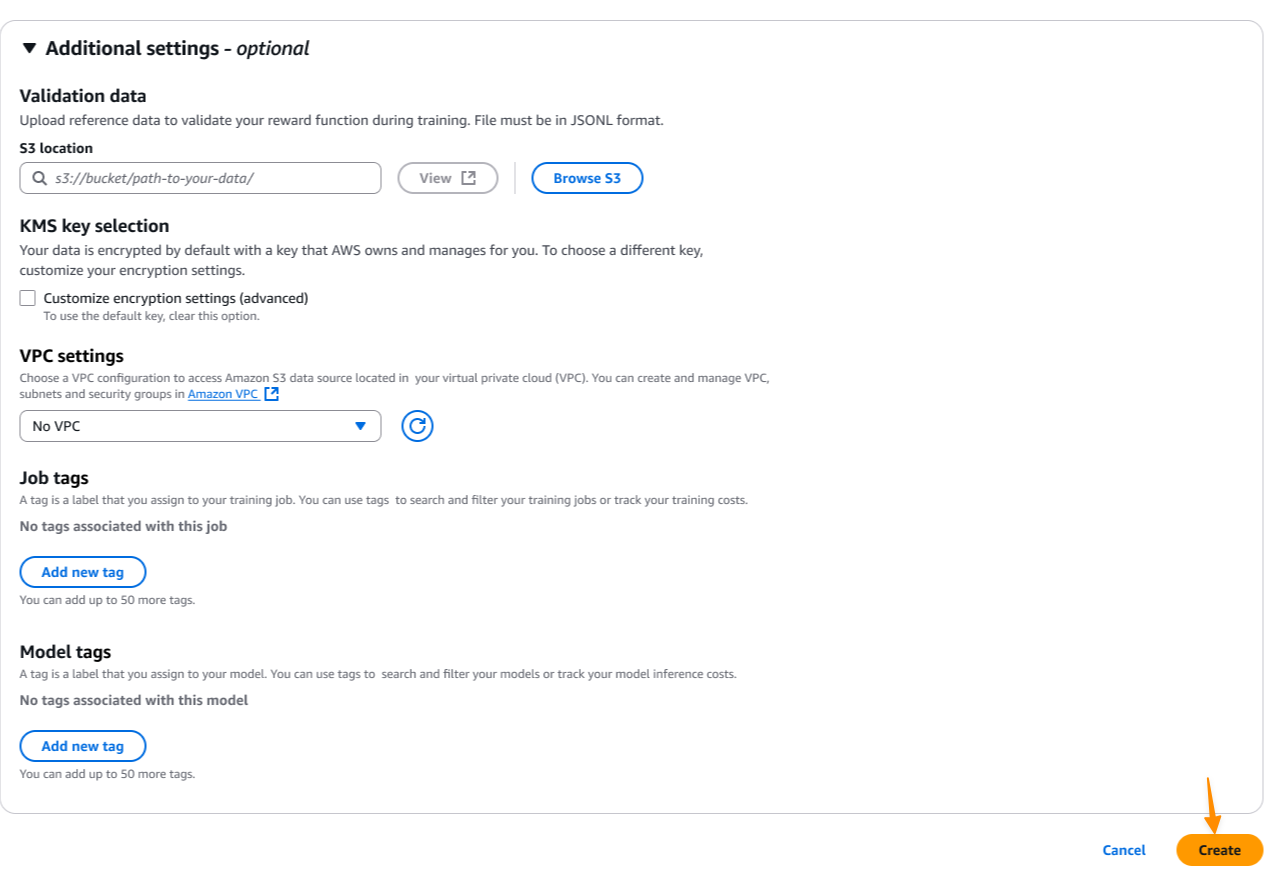

セキュリティを強化するために、組織のコンプライアンス要件を満たすように仮想プライベートクラウド (VPC) 設定と AWS Key Management Service (AWS KMS) 暗号化を設定できます。次に、[作成] を選択してモデルのカスタマイズジョブを開始します。

トレーニングの過程で、モデルがどのように学習しているかを理解するために、リアルタイムの指標を監視することができます。トレーニングメトリクスダッシュボードは、報酬スコア、損失曲線、時間経過に伴う精度の向上など、主要なパフォーマンス指標を表示します。これらの指標は、モデルが適切に収束しているかどうか、報酬関数が学習プロセスを効果的に導いているかどうかを理解するのに役立ちます。

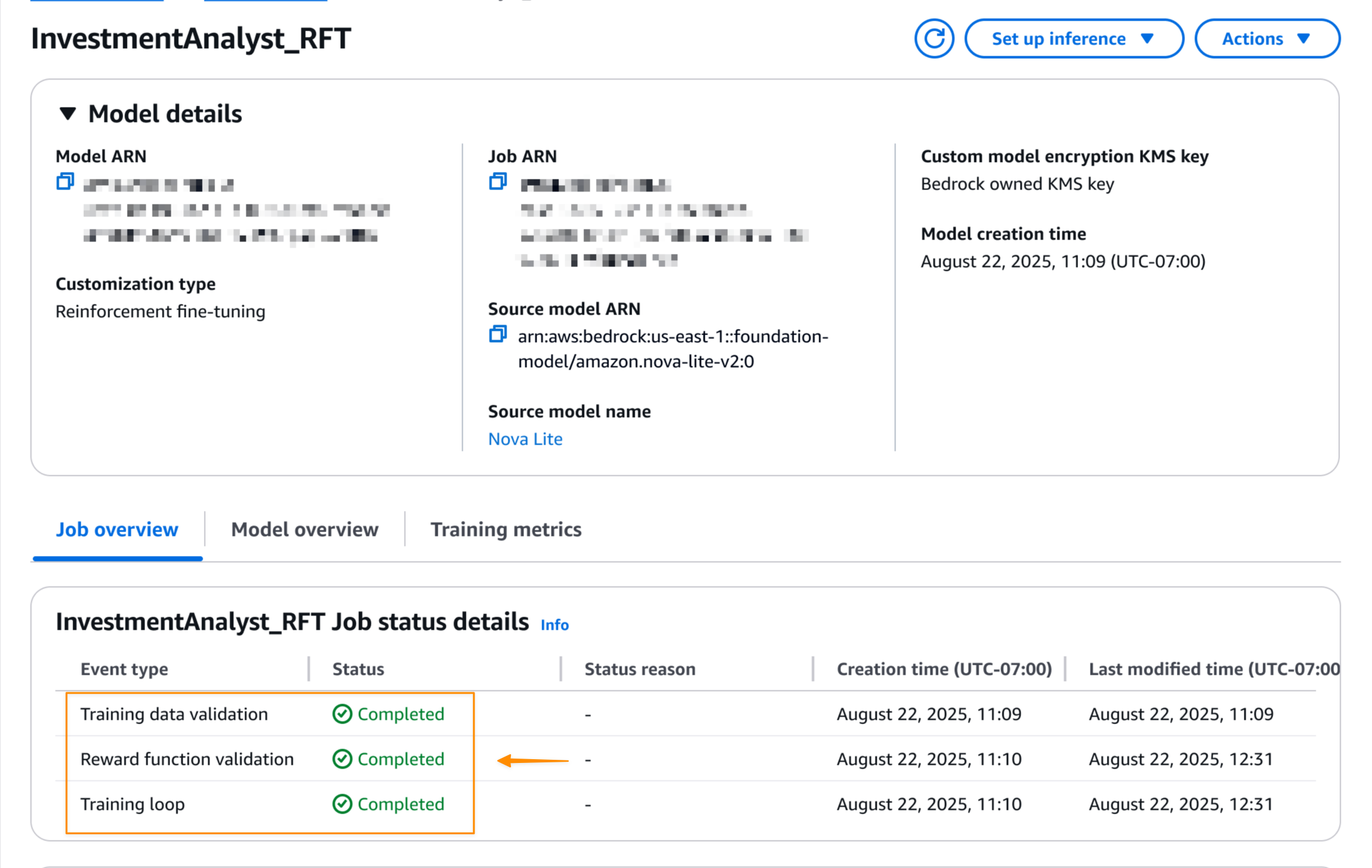

強化微調整ジョブが完了すると、モデルの詳細ページで最終的なジョブの状態を確認できます。

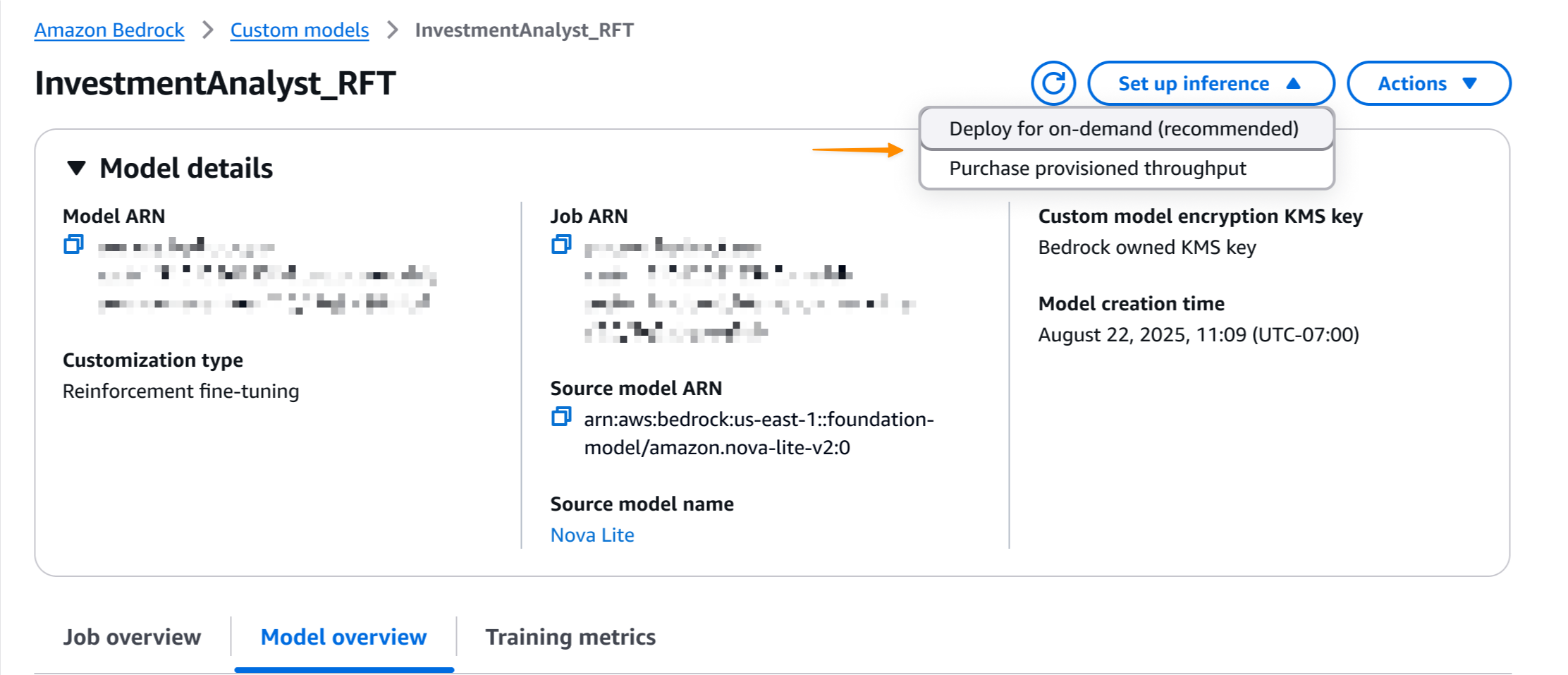

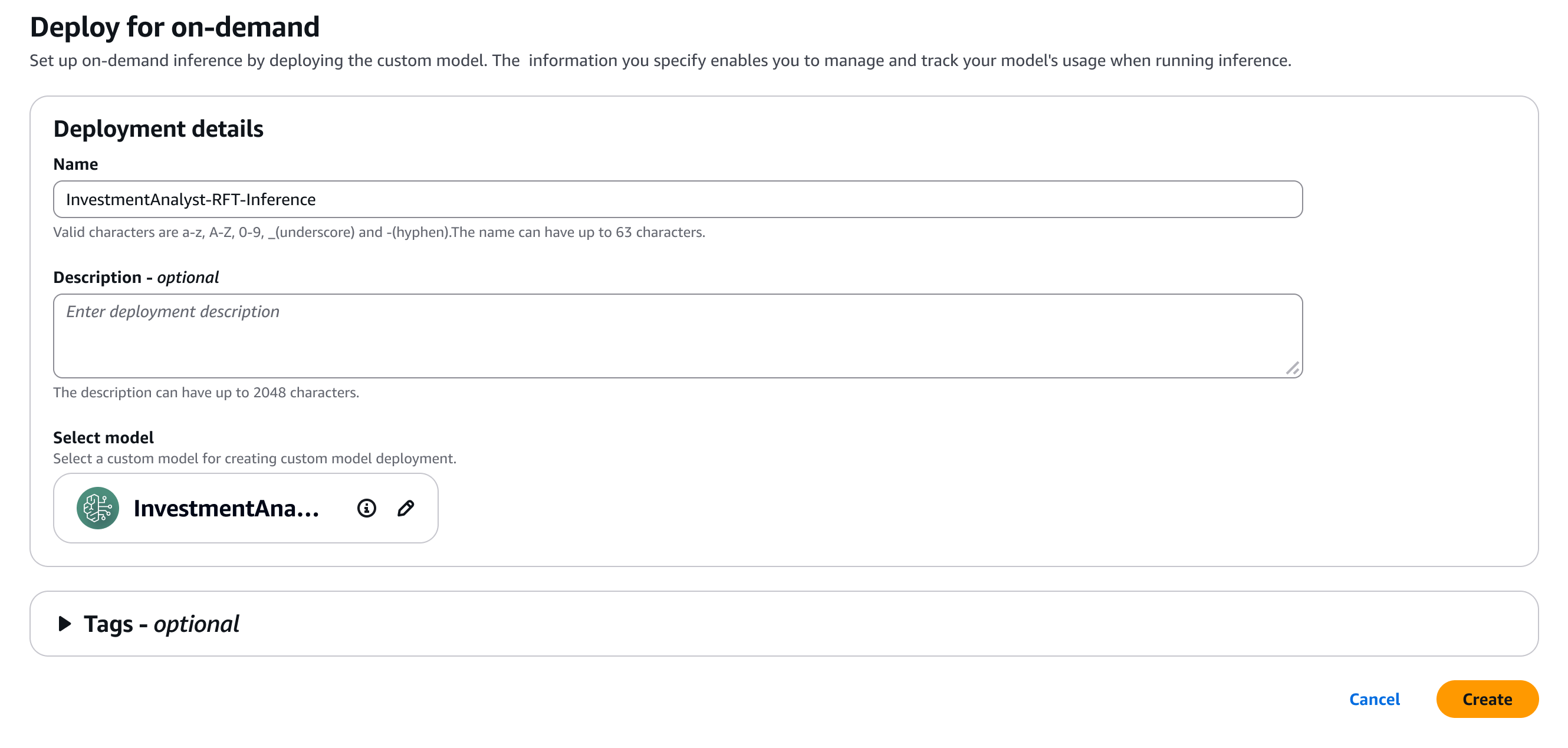

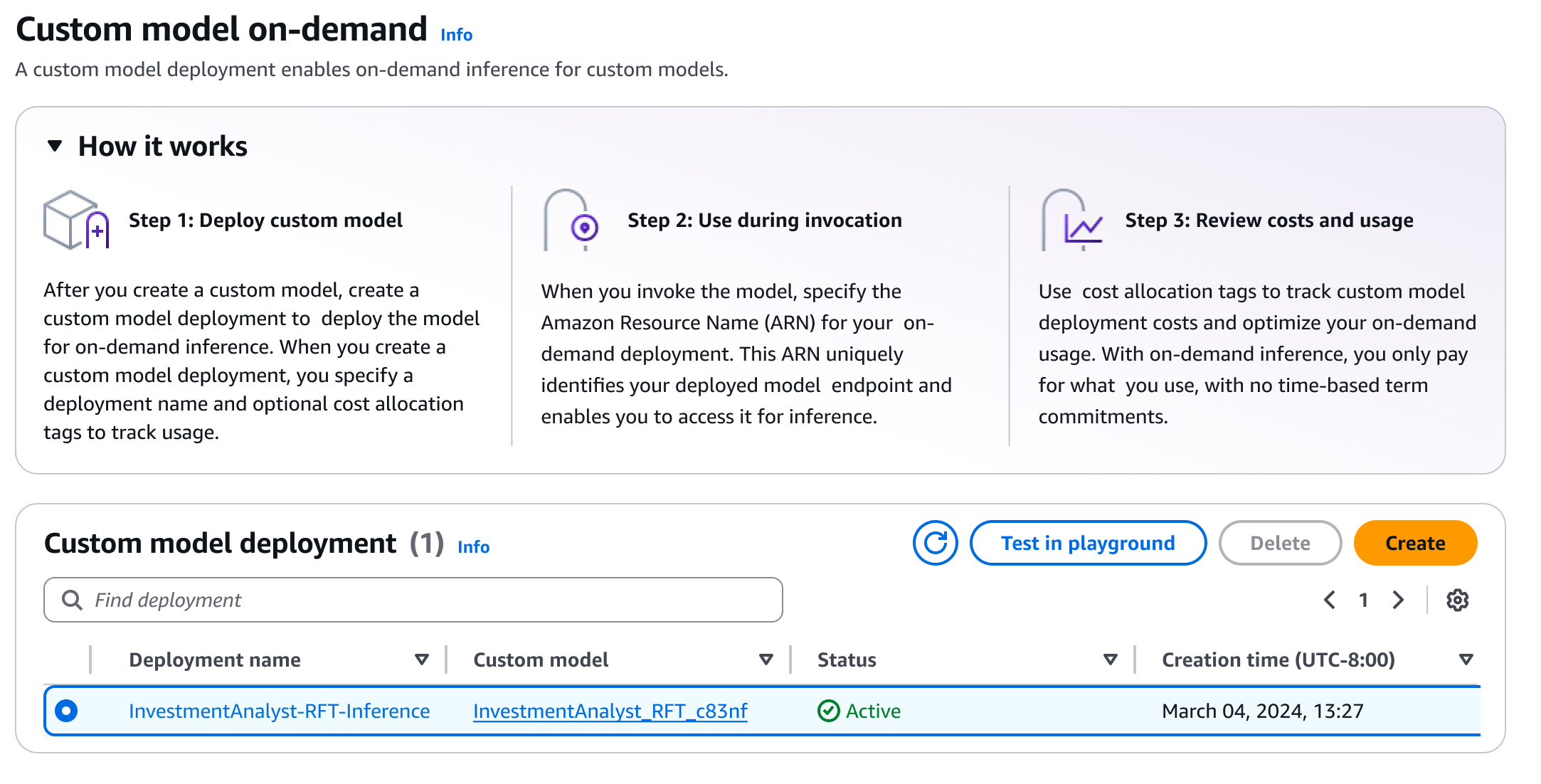

ジョブが完了すると、ワンクリックでモデルをデプロイできます。[推論の設定] を選択し、[オンデマンド用にデプロイ] を選択します。

ここでは、私のモデルの詳細をいくつか説明します。

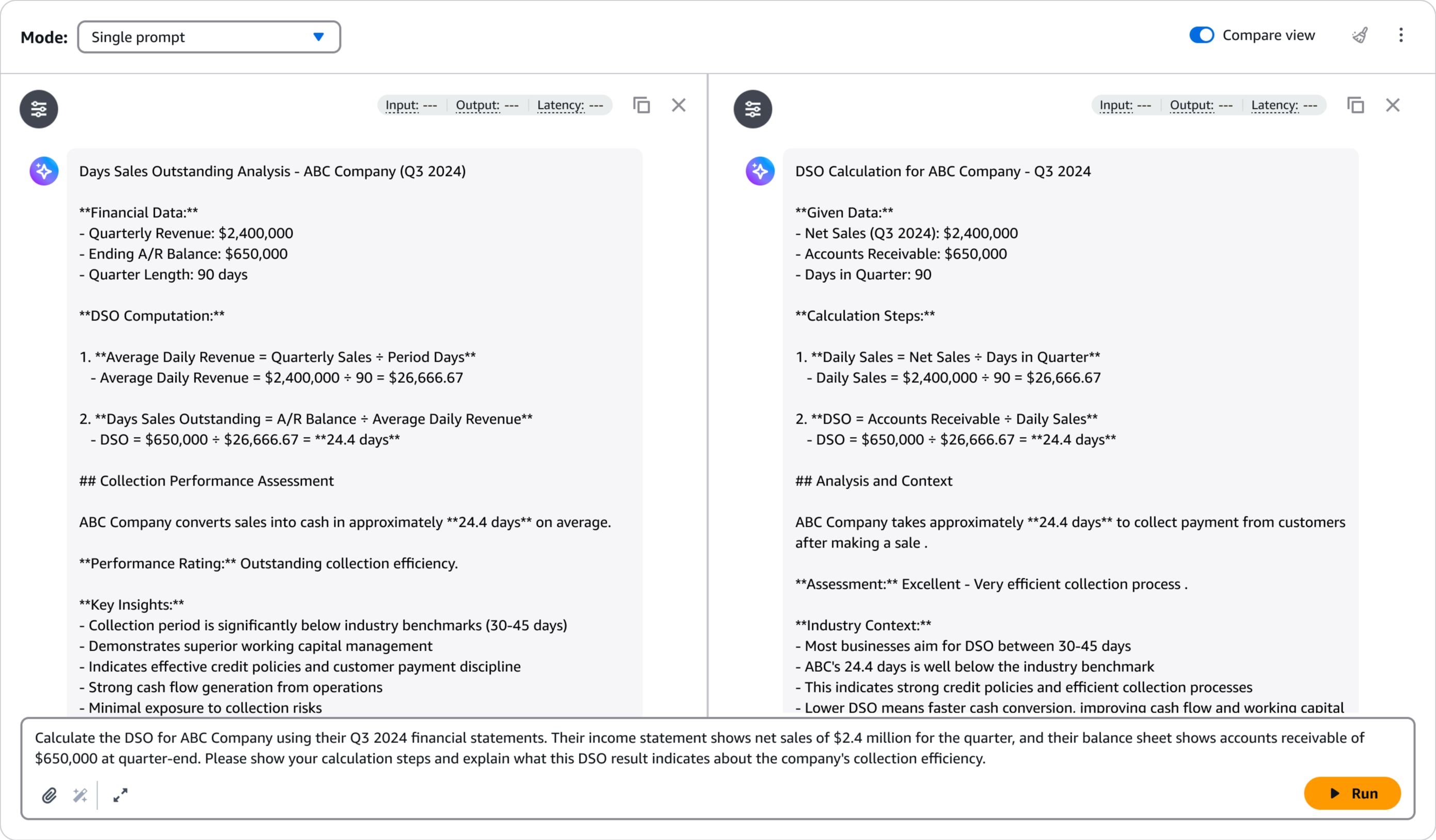

デプロイ後、Amazon Bedrock プレイグラウンドを使ってモデルのパフォーマンスを素早く評価できます。これにより、微調整したモデルをサンプルプロンプトでテストし、その応答をベースモデルと比較して改善点を検証できます。プレイグラウンドでテストを選択します。

Playground には直感的なインターフェイスがあり、迅速なテストとイテレーションが可能なため、本番アプリケーションに統合する前に、モデルが品質要件を満たしていることを確認できます。

インタラクティブデモ

Amazon Bedrock 強化の微調整が実際に行われているインタラクティブなデモをご覧になり、詳細をご覧ください。

その他の知っておくべきこと

留意点は以下のとおりです。

- テンプレート — 客観的タスクと主観的タスクの両方の一般的なユースケースをカバーする、すぐに使える報酬関数テンプレートが7つあります。

- 価格 — 価格設定の詳細については、 Amazon Bedrock の料金表ページを参照してください。

- セキュリティ — トレーニングデータとカスタムモデルは非公開のままであり、FM を一般に公開するための改善には使用されません。セキュリティを強化するために、VPC とAWS KMS の暗号化をサポートしています。

強化微調整のドキュメントにアクセスするか、Amazon Bedrock コンソールにアクセスして、強化の微調整を開始してください。

構築がうまくいきますように!

– Donnie

原文はこちらです。