Bagaimana konten ini?

- Pelajari

- Panduan Startup untuk GenAIOps di AWS Bagian 2: Esensial

Panduan Startup untuk GenAIOps di AWS Bagian 2: Esensial

Di Bagian 1, kami mengeksplorasi keuntungan mengadopsi GenAIOps sejak awal dan menjabarkan jalur yang berpusat pada aplikasi kami yang dirancang khusus untuk startups yang membangun produk yang didukung AI. Sekarang di Bagian 2, kami memberikan panduan yang dapat ditindaklanjuti untuk mengimplementasikan komponen penting yang akan membawa Anda dari prototipe hingga solusi siap produksi.

Jalur GenAIOps: hal penting

Kunci keberhasilan implementasi GenAIOps adalah membangun acuan dasar yang solid dengan kemampuan evaluasi yang tangguh sejak dini—menciptakan flywheel peningkatan berkelanjutan yang setiap iterasi dibangun berdasarkan pembelajaran dari yang sebelumnya. Hal ini mencegah utang teknis yang signifikan sambil memungkinkan eksperimen cepat.

Mari kita jelajahi cara mengimplementasikan komponen penting untuk setiap tahap jalur GenAIOps Anda menggunakan teknik efisien tetapi efektif. Informasi selengkapnya tentang AWS atau layanan pihak ketiga mana yang paling cocok untuk setiap langkah dapat ditemukan di kartu referensi cepat yang menyertainya.

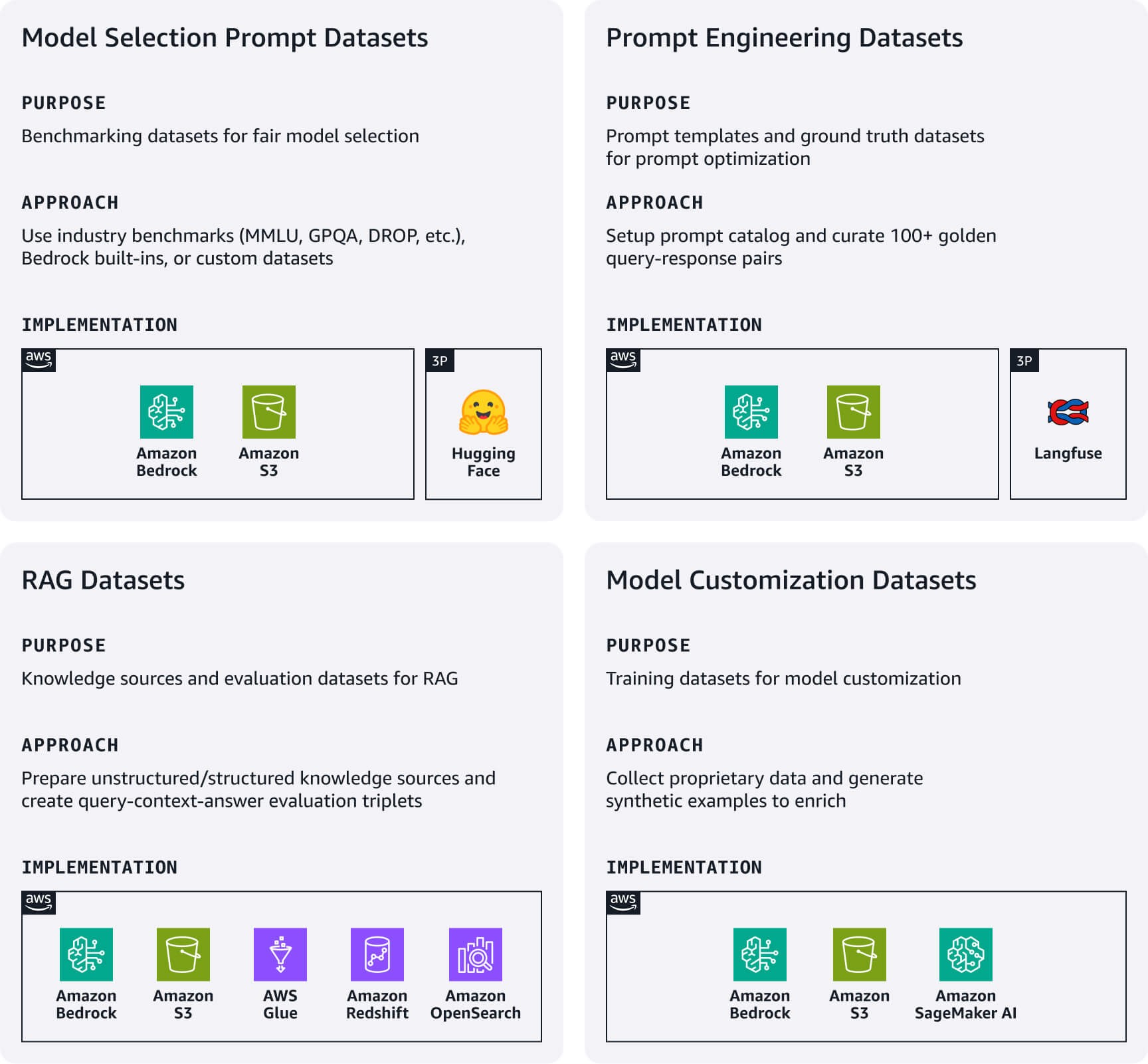

Rekayasa dan manajemen data

Buat jalur data ringan untuk mengelola artefak data penting yang secara langsung mendukung aplikasi AI Anda. Fokus pada set data utama berikut berdasarkan kasus penggunaan Anda.

Set data prompt pemilihan model: Set data prompt evaluasi terstandardisasi sangat penting untuk perbandingan model yang adil. Mulai set data tolok ukur standar industri (MMLU, GPQA, DROP, dll.), Set data evaluasi bawaan Amazon Bedrock, atau buat set data khusus domain kustom Anda sendiri. Hal ini berfungsi sebagai buku pedoman evaluasi model Anda—pertahankan mereka ketika model baru dirilis atau saat mempertimbangkan kembali pilihan model Anda.

Set data rekayasa prompt: Set data ini mencakup templat prompt dan set data kebenaran dasar Anda. Gunakan Manajemen Prompt Amazon Bedrock atau alternatif sumber terbuka seperti Langfuse untuk mengimplementasikan katalog prompt terpusat ke versi, uji, dan mengelola prompt. Selain itu, buat 100+ pasangan kueri-respons yang dikurasi manusia yang mewakili standar Anda untuk pengujian serta optimisasi prompt.

Set data Retrieval Augmented Generation (RAG): Mulai menyiapkan sumber pengetahuan eksternal Anda: untuk data tidak terstruktur seperti dokumentasi, prosesnya melibatkan penyerapan, pemotongan, dan pembuatan penyematan vektor menggunakan model dari Amazon Titan atau Cohere di Bedrock. Simpan sematan dalam basis data vektor terkelola seperti Amazon OpenSearch Nirserver atau Amazon S3 Vectors; untuk data terstruktur seperti data tabular, prosesnya mencakup pemrosesan sebelumnya, analisis skema, pengayaan metadata, serta memuat ke penyimpanan data terstruktur yang didukung. Untuk kedua tipe data, implementasikan mekanisme penyegaran data yang sederhana tetapi efektif untuk menjaga sumber pengetahuan Anda tetap terkini. Selain itu, buat set data evaluasi RAG dengan triplet kueri-konteks-jawaban untuk menguji akurasi pengambilan dan kualitas respons.

Set data kustomisasi model: Mulai mengumpulkan data kepemilikan Anda yang paling berharga. Hasilkan contoh pelatihan sintetis ketika data kepemilikan tidak mencukupi.

Kartu referensi cepat: sekilas rekayasa dan manajemen data

Sumber daya yang bermanfaat:

- Hasilkan data sintetis untuk mengevaluasi sistem RAG menggunakan Amazon Bedrock

- Pengantar untuk menyiapkan set data Anda sendiri untuk pelatihan LLM

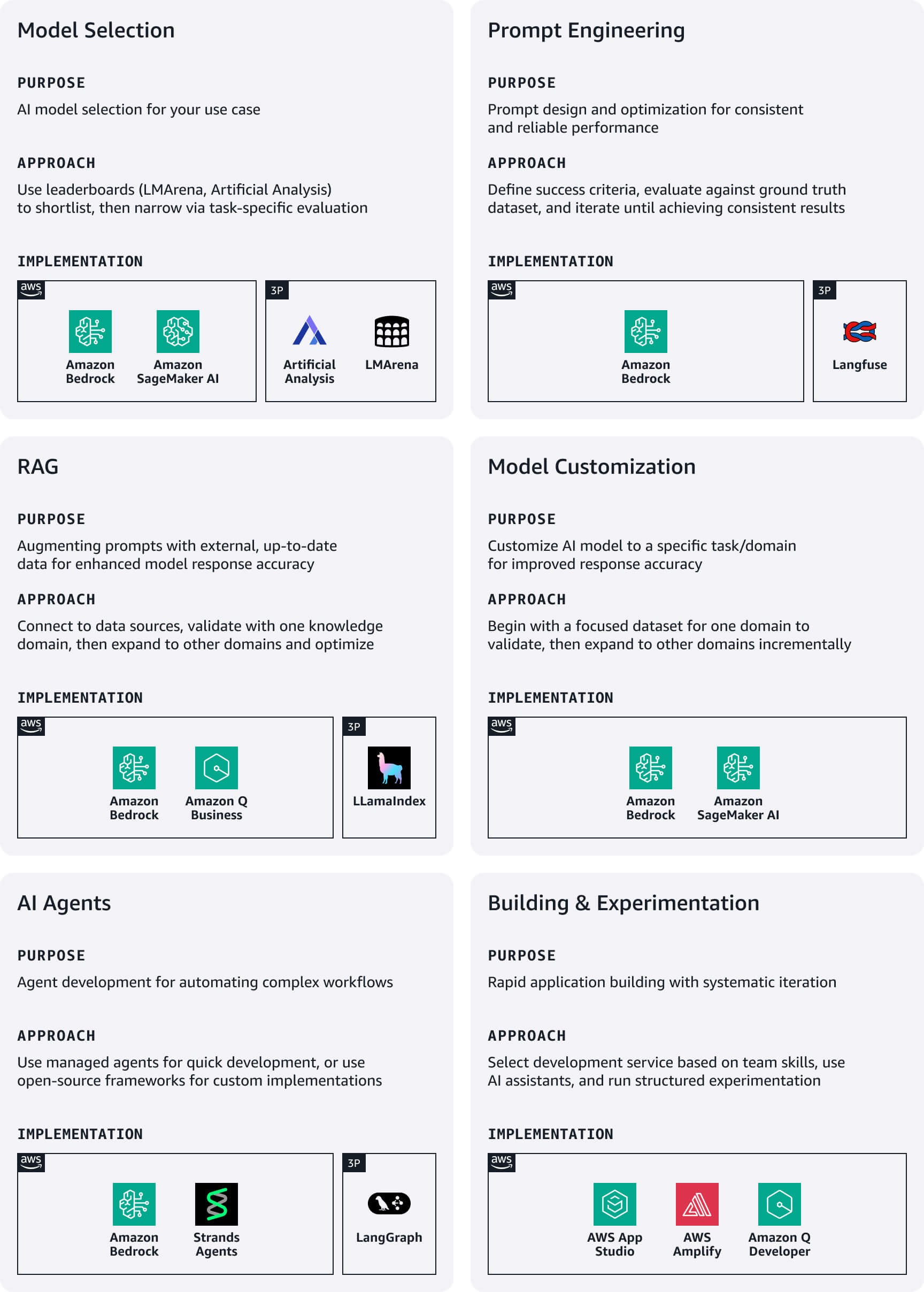

Pengembangan dan eksperimen

Selama pengembangan awal, startups harus memprioritaskan kecepatan dan kesederhanaan, dengan fokus pada eksperimen cepat melalui layanan kode rendah untuk mempercepat waktu masuk pasar.

Pemilihan model: Mulai tolok ukur publik seperti LMArena atau Analisis Buatan untuk membuat daftar pendek awal, kemudian mempersempit pemilihan melalui evaluasi khusus kasus penggunaan. Amazon Bedrock menyediakan akses ke keluarga model fondasi (FM) terkemuka. Untuk mengevaluasi model terpilih Anda, manfaatkan Evaluasi Amazon Bedrock atau Amazon SageMaker Clarify.

Rekayasa prompt: Tentukan kriteria keberhasilan yang jelas sejalan dengan tujuan bisnis dan buat metrik yang terukur untuk masing-masing. Buat draf prompt awal mengikuti pedoman desain untuk model pilihan Anda, kemudian evaluasi secara sistematis terhadap set data kebenaran dasar Anda. Manfaatkan optimisasi prompt Amazon Bedrock selama penyusunan dan penyempurnaan untuk perbaikan khusus model. Lakukan iterasi sampai mencapai hasil yang konsisten, lalu publikasikan prompt yang berhasil ke katalog prompt Anda dengan penentuan versi yang tepat.

RAG: Manfaatkan opsi RAG yang terkelola penuh di AWS untuk menyederhanakan implementasi penyimpanan data, penarik data, FM, dan orkestrator—yang secara signifikan mengurangi waktu pengembangan dan overhead operasional. Mulai menghubungkan sistem RAG Anda ke sumber data yang didukung, lalu integrasikan dengan FM untuk membuat alur kerja pembuatan tertambah yang lengkap. Mulai dengan satu domain pengetahuan terfokus untuk memvalidasi efektivitas sebelum memperluas ke sumber data tambahan. Manfaatkan teknik RAG canggih seperti modifikasi kueri dan peringkat ulang untuk meningkatkan relevansi respons.

Kustomisasi model: Gunakan set data pelatihan untuk menyesuaikan FM yang sudah dilatih sebelumnya untuk meningkatkan performa pada kasus penggunaan tertentu. Selalu mulai dengan rekayasa prompt, lalu pindah ke RAG jika konteks tambahan diperlukan. Hanya mengejar kustomisasi model jika pendekatan sebelumnya tidak memenuhi persyaratan Anda, dimulai dengan set data terfokus dari satu domain untuk memvalidasi peningkatan sebelum memperluas.

Agen AI: Buat asisten yang didukung AI yang dapat melakukan tugas kompleks dan berinteraksi dengan berbagai API dan layanan. Amazon Bedrock Agents secara otomatis menangani orkestrasi kompleks untuk memahami maksud pengguna, menentukan tindakan, membuat panggilan API, serta menyajikan hasil dalam bahasa alami. Untuk implementasi yang disesuaikan, pertimbangkan untuk menggunakan kerangka kerja sumber terbuka seperti Strands atau LangGraph.

Pembuatan aplikasi dan eksperimen: Pilih pendekatan pengembangan berdasarkan keahlian tim Anda dan persyaratan lini masa pengiriman. AWS menawarkan beberapa layanan yang cocok untuk startups (lihat di bawah), serta Amazon Q Developer berfungsi sebagai asisten yang didukung AI yang membantu Anda memahami, membangun, memperluas, dan mengoperasikan aplikasi AWS. Buat pendekatan eksperimen terstruktur yang memungkinkan peningkatan sistematis sambil mempertahankan iterasi cepat. Pertahankan log eksperimen dengan hipotesis, detail implementasi, dan metrik hasil, yang memastikan eksperimen memiliki kriteria keberhasilan yang jelas terkait dengan metrik bisnis alih-alih hanya metrik teknis.

Kartu referensi cepat: sekilas pengembangan dan eksperimen

Sumber daya yang bermanfaat:

- Mengevaluasi prompt dalam skala besar dengan Manajemen Prompt dan Alur Prompt untuk Amazon Bedrock

- Dari konsep hingga menjadi kenyataan: Menavigasi Perjalanan RAG dari bukti konsep hingga produksi

- Praktik terbaik untuk membangun aplikasi AI generatif yang tangguh dengan Amazon Bedrock Agents

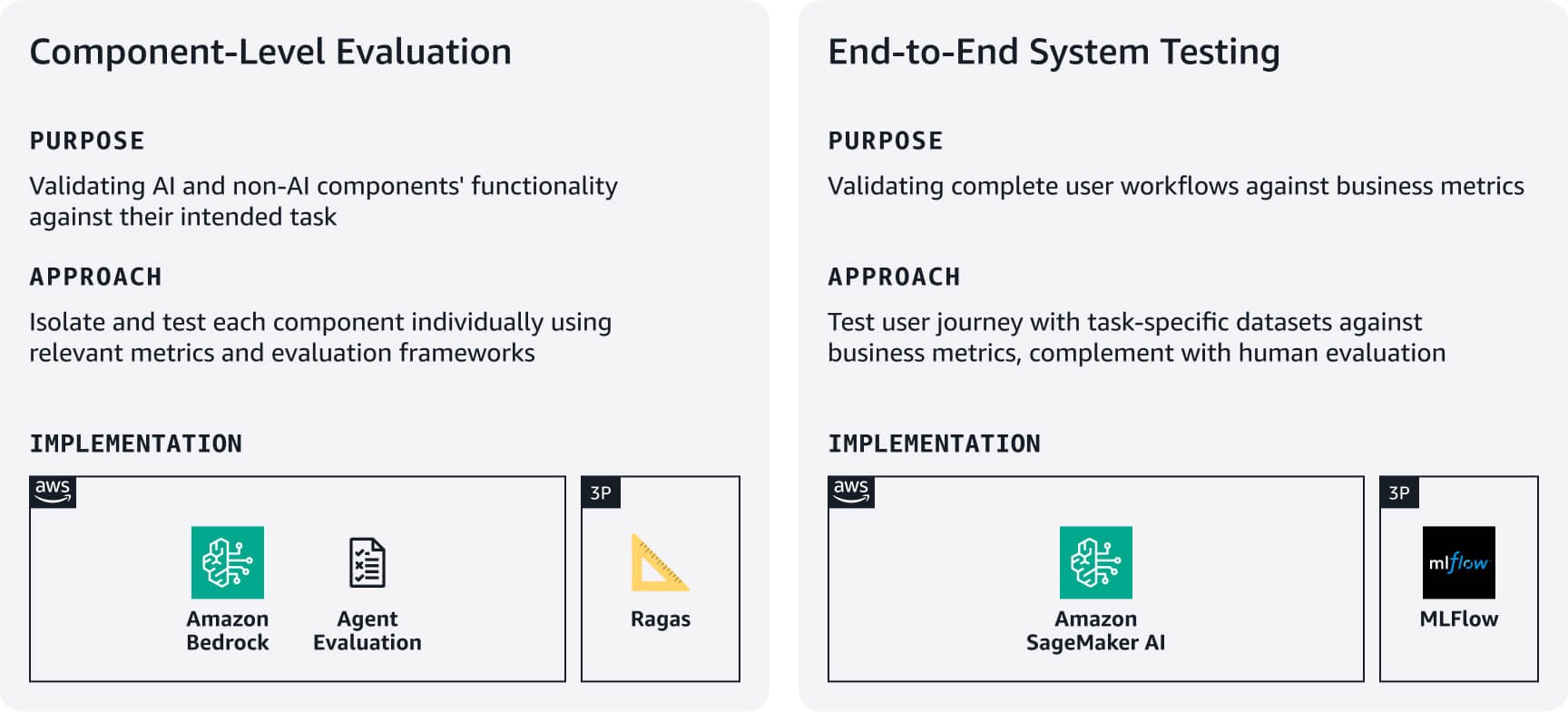

Pengujian dan evaluasi

Buat proses yang efisien tetapi ketat untuk memverifikasi aplikasi Anda bekerja dengan andal dan beperforma baik, menggunakan set data evaluasi yang dibuat pada tahap 1. Seimbangkan ketelitian menggunakan kecepatan startup dengan berfokus pada alur kerja pengguna yang paling penting terlebih dahulu.

Evaluasi tingkat komponen: Ukur seberapa baik komponen AI dan non-AI Anda melakukan tugas yang diinginkan. Misalnya, untuk sistem RAG, gunakan Evaluasi Amazon Bedrock atau kerangka kerja seperti RAGAS untuk menilai akurasi pengambilan dan kualitas pembuatan respons. Untuk agen, manfaatkan kerangka kerja seperti Evaluasi Agen atau pendekatan LLM sebagai juri untuk mengevaluasi metrik seperti laju penyelesaian tugas serta akurasi penggunaan keputusan/alat berdasarkan persyaratan kasus penggunaan Anda.

Pengujian sistem end-to-end: Uji alur kerja pengguna lengkap menggunakan set data evaluasi khusus tugas. Tentukan metrik keberhasilan yang sejalan dengan bisnis untuk setiap tugas inti, lalu validasikan bahwa komponen berfungsi dengan lancar di sepanjang perjalanan pengguna. Lengkapi pengujian otomatis dengan penilaian manusia terhadap kualitas respons, relevansi, dan keselarasan merek—aspek metrik otomatis sering terlewatkan. Gunakan hasil evaluasi ini untuk membuat acuan dasar, lalu tingkatkan secara berulang berdasarkan umpan balik pengguna dan dampak bisnis. Pertimbangkan untuk menggunakan MLFlow terkelola di SageMaker AI untuk melacak eksperimen di seluruh versi sistem.

Kartu referensi cepat: sekilas pengujian dan evaluasi

Sumber daya yang bermanfaat:

- Mengevaluasi respons RAG dengan Amazon Bedrock, LlamaIndex, dan RAGAS

- Penilaian Beban Kerja AI Generatif

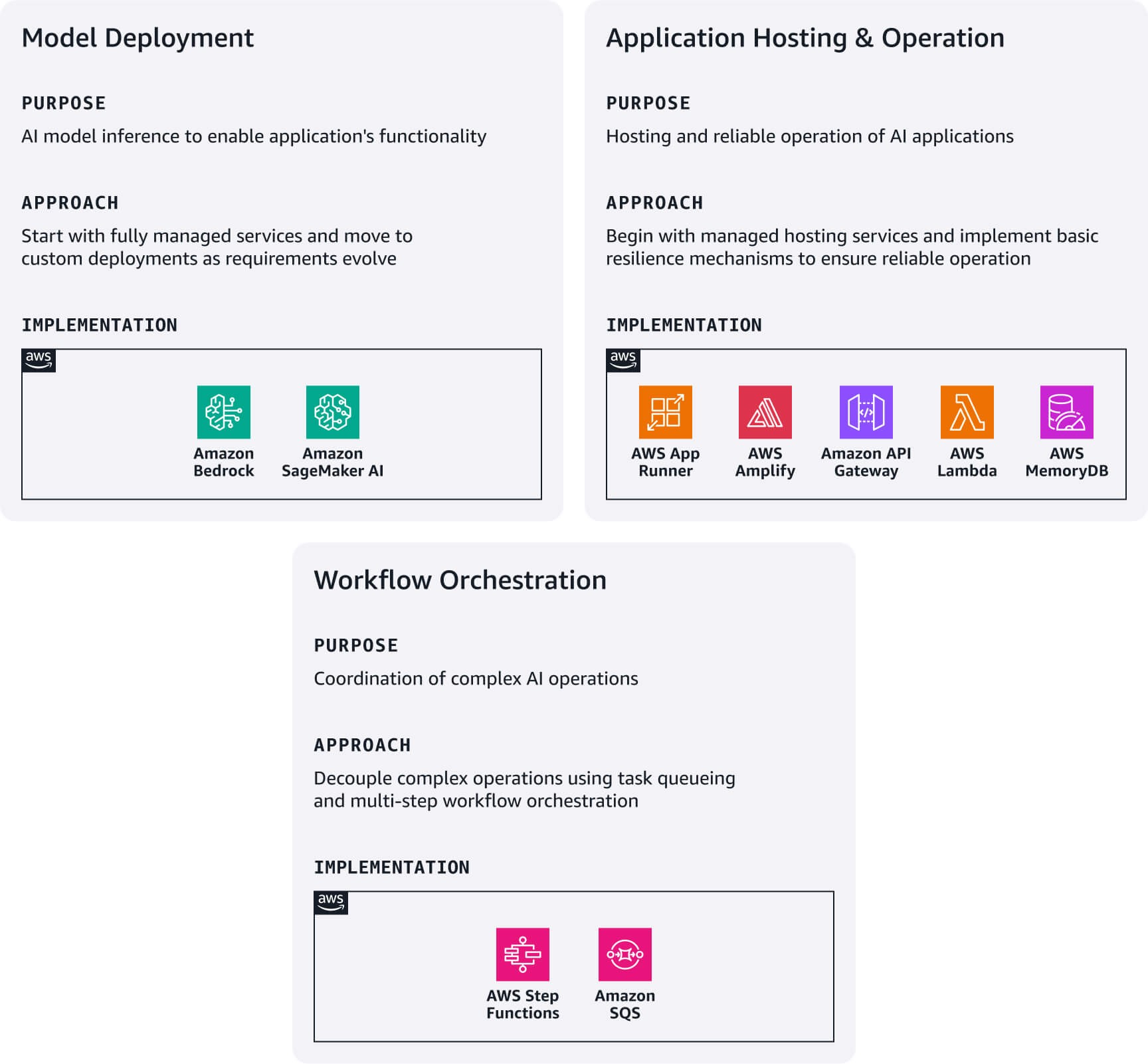

Deployment dan penyajian

Mulai dengan opsi deployment paling sederhana berdasarkan persyaratan teknis dan kemampuan tim Anda, lalu kembangkan arsitektur Anda seiring pertumbuhan. Ekosistem AWS menyediakan jalur peningkatan alami antara pola deployment ini tanpa memerlukan penulisan ulang lengkap arsitektural.

Deployment model: Mulai Amazon Bedrock untuk akses langsung ke FM melalui API terpadu. Jika Anda membutuhkan model khusus yang tidak tersedia di Bedrock, jelajahi Amazon Bedrock Marketplace atau Amazon SageMaker JumpStart untuk menemukan dan melakukan deployment model Anda langsung di SageMaker AI.

Hosting dan operasi aplikasi: Lakukan deployment aplikasi web modern menggunakan AWS Amplify Hosting. Buat layanan mikro ringan dengan mengintegrasikan fungsi AWS Lambda dengan Amazon API Gateway. Gunakan AWS App Runner sebagai titik entri Anda untuk melakukan deployment aplikasi terkontainerisasi. Untuk memastikan keandalan, implementasikan mekanisme balik sederhana—kembali ke respons model dasar saat pengambilan RAG gagal, beralih ke model cadangan saat model utama tidak tersedia, dan lakukan cache kueri umum menggunakan Amazon MemoryDB. Buat pemutus sirkuit untuk layanan dependen untuk mencegah kegagalan bertingkat. Pola-pola ini membentuk fondasi untuk strategi ketahanan yang lebih canggih seiring pertumbuhan basis pengguna Anda.

Orkestrasi alur kerja: Untuk operasi AI kompleks yang memerlukan pemisahan permintaan/respons, gabungkan Amazon SQS untuk antrean tugas dengan AWS Step Functions untuk mengatur alur kerja multilangkah. Pola ini sangat berharga untuk operasi yang memakan waktu seperti pemrosesan batch atau alur kerja yang melibatkan beberapa panggilan model.

Kartu referensi cepat: sekilas deployment & penyajian

Sumber daya yang bermanfaat:

Observabilitas dan penyempurnaan

Fokus pada observabilitas penting yang mendorong dampak bisnis langsung sambil meminimalkan kompleksitas.

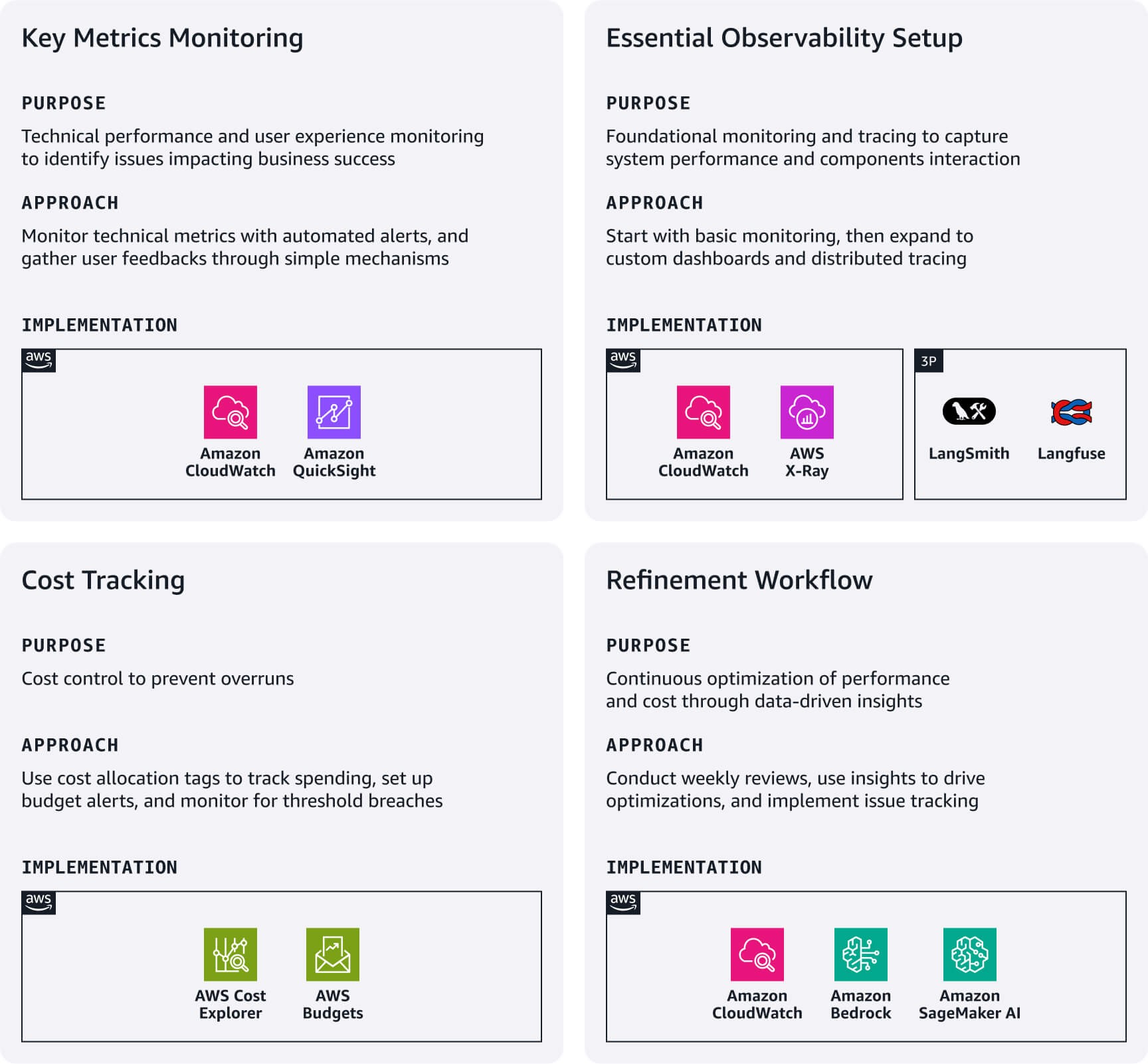

Pemantauan metrik utama: Fokus pada metrik performa teknis yang berlaku untuk kasus penggunaan Anda dan siapkan alarm CloudWatch untuk ambang kritis. Lacak pengalaman pengguna melalui mekanisme umpan balik sederhana (jempol ke atas/bawah), laju penyelesaian percakapan, dan pola penggunaan fitur. Hal ini sering mengungkapkan masalah metrik teknis yang terlewatkan serta secara langsung berdampak pada kesuksesan bisnis.

Pengaturan observabilitas penting: Gunakan Integrasi native Amazon CloudWatch dengan layanan seperti Bedrock dan SageMaker AI untuk pemantauan dasar. Untuk pola RAG yang kompleks, pertimbangkan untuk membuat dasbor CloudWatch kustom. Untuk mengambil interaksi antara berbagai komponen aplikasi, implementasikan pelacakan terdistribusi menggunakan Amazon X-Ray atau platform observabilitas LLM khusus seperti Langfuse atau LangSmith.

Pelacakan biaya: Gunakan tag alokasi biaya AWS untuk melacak pengeluaran berdasarkan fitur, lingkungan, atau segmen pelanggan. Siapkan AWS Budgets dengan filter berbasis tag untuk menerima pemberitahuan untuk anomali atau pelanggaran ambang.

Alur kerja penyempurnaan: Buat peninjauan mingguan dasbor operasional dan perincian biaya untuk mengidentifikasi peluang optimisasi. Gunakan wawasan untuk mendorong peningkatan segera seperti menyesuaikan panjang prompt, beralih model untuk beban kerja yang sensitif biaya atau latensi, atau mengoptimalkan strategi pengambilan berdasarkan pola penggunaan. Implementasikan sistem pelacakan masalah yang menghubungkan observasi produksi dengan tahap jalur tertentu yang memerlukan penyesuaian. Otomatiskan pengumpulan kueri dan respons bermasalah untuk menginformasikan skenario pengujian masa mendatang.

Kartu referensi cepat: sekilas observabilitas & penyempurnaan

Sumber daya yang bermanfaat:

- Lacak, alokasikan, dan kelola biaya dan penggunaan AI generatif Anda dengan Amazon Bedrock

- Menggunakan Wawasan Log CloudWatch untuk mengidentifikasi peluang peningkatan

Tata kelola dan pemeliharaan

Bentuk praktik tata kelola ringan yang melindungi startup Anda sambil mengaktifkan iterasi cepat. Hal ini membantu membangun kepercayaan pemangku kepentingan tanpa memperlambat kecepatan pengembangan.

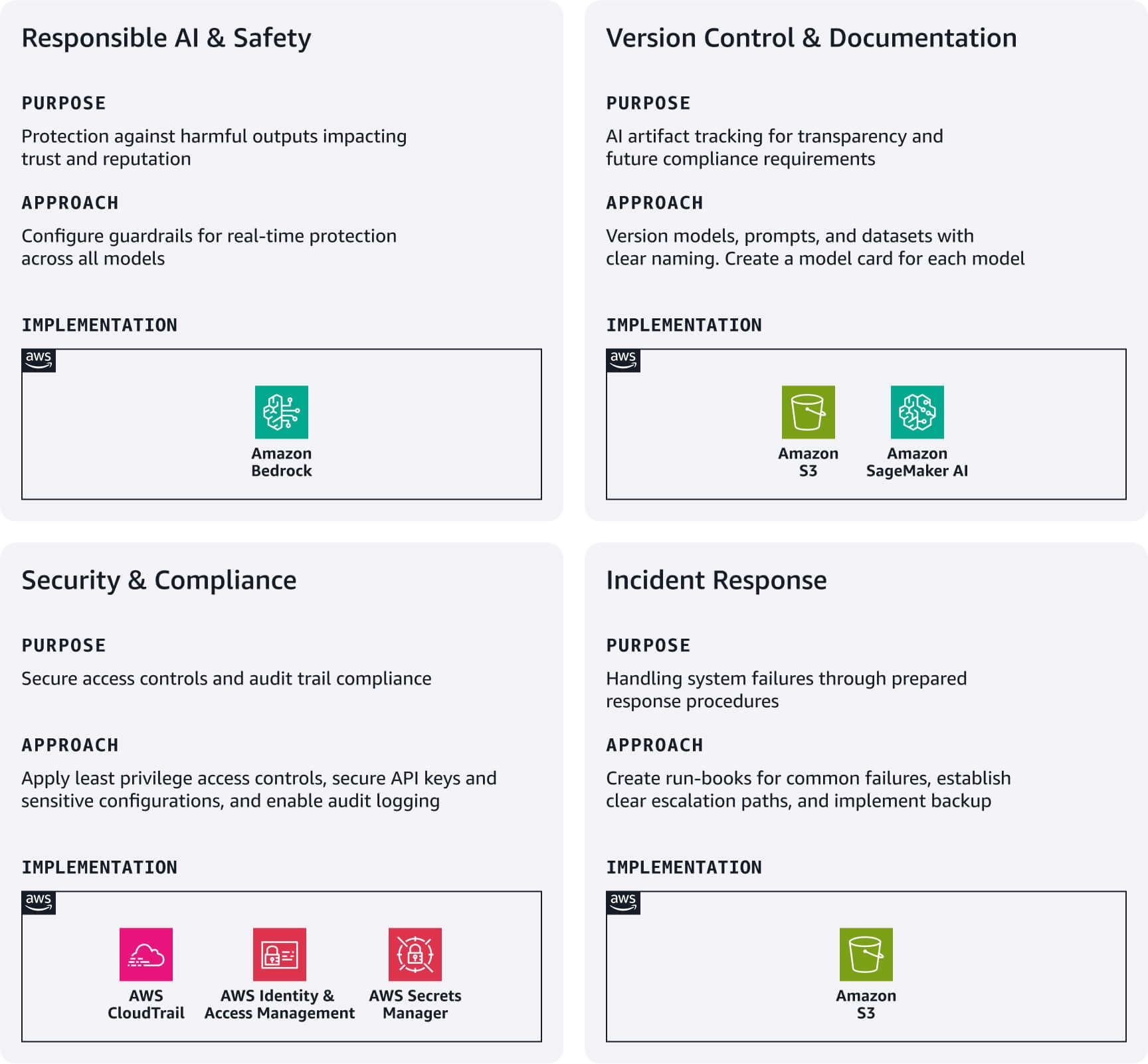

AI yang bertanggung jawab dan keamanan: Implementasikan Batasan Pengaman Amazon Bedrock sebagai garis pertahanan pertama Anda. Konfigurasikan filter konten untuk ujaran kebencian, kekerasan, dan konten lain yang tidak pantas atau tidak relevan sesuai kasus penggunaan Anda. Batasan pengaman ini berfungsi di seluruh model Bedrock maupun model eksternal, memberikan perlindungan waktu nyata tanpa memengaruhi kecepatan pengembangan.

Kontrol versi dan dokumentasi: Lacak artefak AI secara sistematis menggunakan Amazon S3 dengan penentuan versi diaktifkan, dan implementasikan konvensi penamaan yang jelas untuk model, prompt, serta set data. Buat kartu model ringan yang mendokumentasikan setiap tujuan, sumber data, batasan, dan metrik performa model AI—yang penting untuk transparansi dan persyaratan kepatuhan masa mendatang.

Keamanan dan kepatuhan: Konfigurasikan peran AWS IAM mengikuti prinsip hak akses paling rendah dengan peran terpisah untuk pengembangan, pengujian, dan produksi. Gunakan AWS Secrets Manager untuk kunci API serta konfigurasi sensitif. Aktifkan AWS CloudTrail untuk pencatatan audit otomatis, menciptakan fondasi kepatuhan yang penting.

Respons insiden: Kembangkan runbook sederhana untuk kegagalan umum: kesalahan model, penurunan performa, atau lonjakan biaya. Buat jalur eskalasi yang jelas dan implementasikan strategi pencadangan dasar untuk artefak penting.

Kartu referensi cepat: sekilas tata kelola dan pemeliharaan

Kesimpulan

Mengimplementasikan GenAIOps pada tahap awal startup tidak memerlukan investasi besar atau infrastruktur yang kompleks. Dengan berfokus pada elemen-elemen penting dari setiap tahap jalur dan memanfaatkan layanan yang dikelola AWS, Anda dapat membangun fondasi yang mendukung iterasi cepat sambil menetapkan praktik operasional yang akan memungkinkan pertumbuhan masa depan.

Ingat bahwa tujuan pada tahap ini bukanlah kesempurnaan tetapi niat—menciptakan sistem yang mengenali tantangan unik aplikasi AI sambil tetap sesuai dengan skala Anda saat ini. Mulai dengan hal-hal penting ini, ukur apa yang penting bagi pengguna Anda, dan dokumentasikan pembelajaran Anda.

Di Bagian 3, kami akan menunjukkan kepada Anda tentang cara mengembangkan praktik ini saat Anda mulai menskalakan operasi untuk memenuhi permintaan pelanggan yang terus meningkat.

Nima Seifi

Nima Seifi adalah Senior Solutions Architect di AWS, yang berbasis di California Selatan, tempat beliau mengkhususkan dalam bidang SaaS dan GenAIOps. Beliau menjabat sebagai penasihat teknis untuk perusahaan rintisan yang membangun di AWS. Sebelum bergabung di AWS, beliau bekerja sebagai arsitek DevOps di industri e-commerce selama lebih dari 5 tahun, setelah satu dekade bekerja di bidang R&D dalam teknologi internet seluler. Nima memiliki 20+ publikasi di jurnal dan konferensi teknis terkemuka serta memiliki 7 paten AS. Di luar pekerjaan, beliau gemar membaca, menonton film dokumenter, dan berjalan-jalan di pantai.

Anu Jayanthi

Anu Jayanthi bekerja dengan pelanggan Perusahaan Rintisan, memberikan advokasi dan panduan teknis strategis untuk membantu merencanakan dan membangun solusi menggunakan praktik terbaik AWS.

.jpg)

Pat Santora

Pat Santora adalah GenAI Labs Cloud Architect and Technologist dengan pengalaman lebih dari 25 tahun dalam mengimplementasikan solusi di cloud untuk korporasi dan perusahaan rintisan. Beliau telah berhasil meluncurkan banyak produk sejak awal, memimpin proyek rancang ulang analitik, serta mengelola tim jarak jauh dengan filosofi yang berpusat pada transparansi dan kepercayaan. Keahlian teknisnya mencakup perencanaan strategis, manajemen sistem, dan desain ulang arsitektural, dilengkapi dengan minat dalam bidang GenAI, Analitik, serta Big Data.

.jpg)

Clement Perrot

Clement Perrot membantu perusahaan rintisan tingkat atas mengakselerasi inisiatif AI mereka dengan memberikan panduan strategis tentang pemilihan model, implementasi AI yang bertanggung jawab, dan operasi machine learning yang dioptimalkan. Seorang pengusaha serial dan penerima penghargaan Inc 30 Under 30, beliau membawa keahlian mendalam dalam membangun serta menskalakan perusahaan AI, setelah mendirikan dan berhasil keluar dari beberapa perusahaan di teknologi konsumen dan AI korporasi.

Bagaimana konten ini?