概览

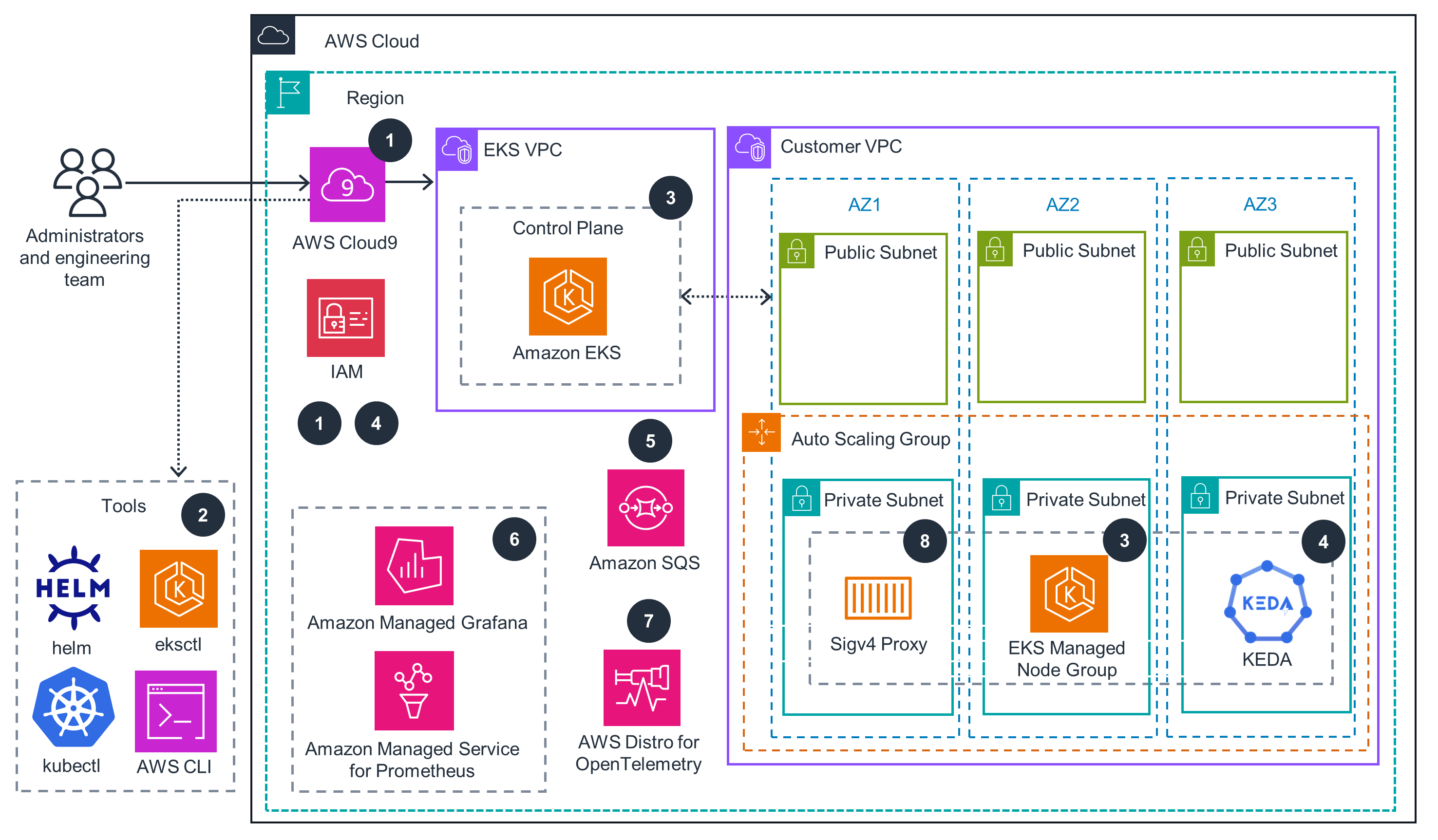

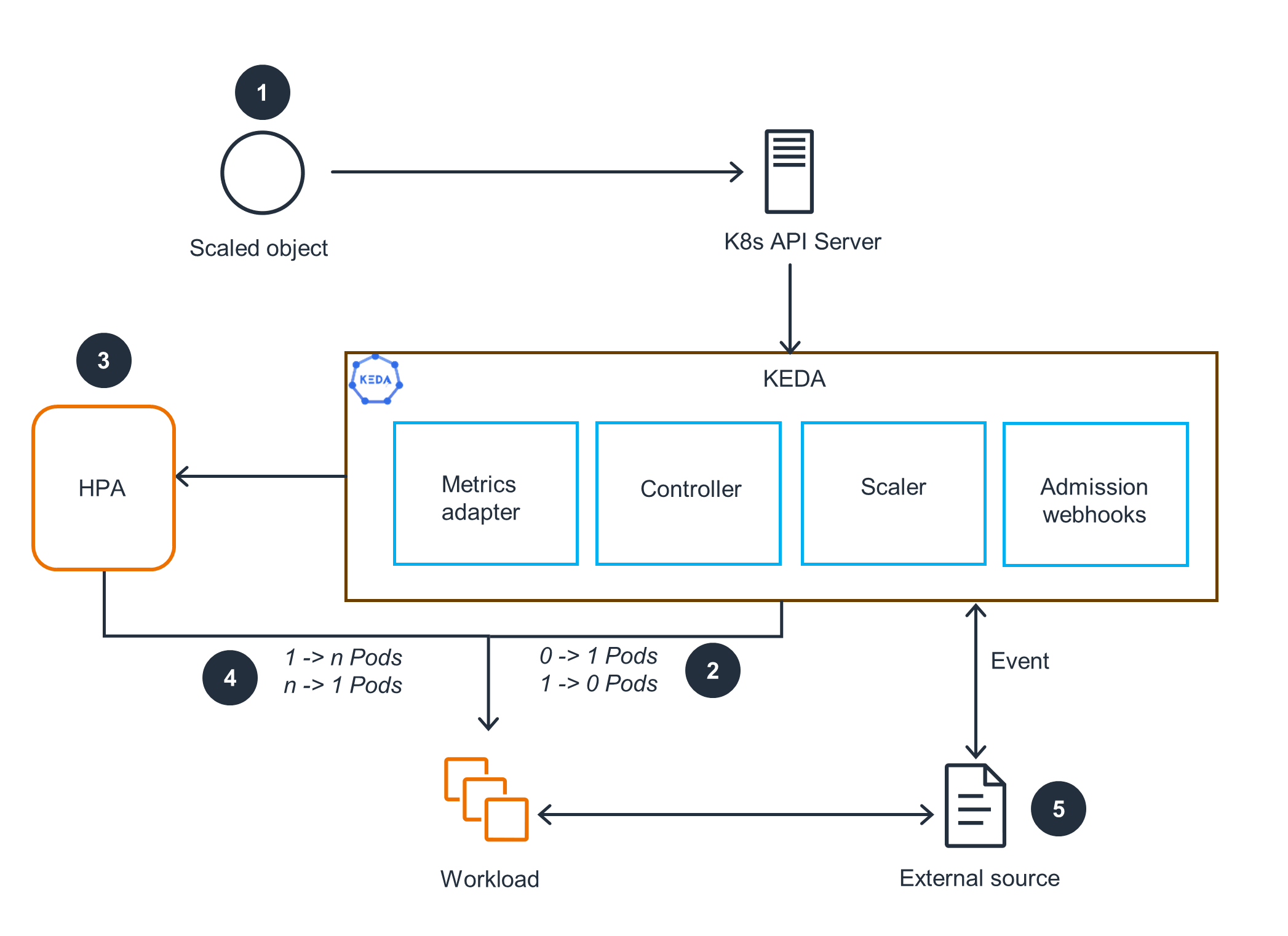

本指南演示了如何使用 Kubernetes Event-Driven Autoscaler(KEDA)为 Amazon Elastic Kubernetes Service(Amazon EKS)应用程序实施事件驱动型自动扩展。本指南展示了如何根据自定义指标,而不仅仅是 CPU 和内存利用率来扩展部署。KEDA 与 Kubernetes 集成,为事件驱动型工作负载扩展了自动扩展功能。通过本指南,您可以使用 KEDA 基于自定义指标的自动扩展功能,在 Amazon EKS 上优化资源预置,提高成本效率,并增强事件驱动型应用程序的客户体验。

Well-Architected 支柱

上面的架构图是按照 Well-Architected 最佳实践创建的解决方案示例。要做到完全的良好架构,您应该遵循尽可能多的 Well-Architected 最佳实践。

这种事件驱动型架构可用于定义精确的扩展规则,对应用程序如何响应特定事件或指标进行精细控制。通过使用 KEDA,可提高 Kubernetes 环境的效率、资源利用率和响应能力,从而推动卓越运营。

使用 IAM 角色获取临时凭证,以便访问各种 AWS 服务。为基于 Kubernetes 的应用程序集成原生身份验证和授权机制,以安全地与 Kubernetes API 服务器交互。通过精确定义 IAM 策略,授予最低的必要权限,可以有效减少未经授权的访问,加强环境的安全性。

在 Kubernetes 中使用容器组(pod)拓扑分布限制可以帮助您提高应用程序的可用性和弹性。此功能可控制容器组(pod)在不同故障域(例如主机或可用区)之间的分布。通过确保均衡、最佳的分布,可以最大限度地减少单个域内潜在故障的影响,从而增强应用程序的整体完整性。

Amazon EKS 集群的多可用区设置可实现低延迟性能。虽然可能会出现跨可用区的子网间流量,但预计由此产生的延迟对应用程序性能的影响极小。在需要更低延迟的情况下,您可以在单个可用区内引导流量,进一步优化网络性能。

KEDA 的自动容器组(pod)扩展功能有助于节省成本。通过根据自定义指标来启动扩展,您可以实现容器组(pod)最佳可用性,以满足应用程序的需求,避免过度配置和不必要的成本。

您可以通过 Kubernetes HPA 实现可持续的资源管理。KEDA 可利用此功能,根据自定义指标有效扩展工作负载,从而只运行所需的容器组(pod)。通过访问 60 多种不同的扩展器,您可以根据自己的特定需求定制扩展行为,最大限度地利用已部署的资源,防止过度分配。

免责声明

找到今天要查找的内容了吗?

请提供您的意见,以便我们改进网页内容的质量