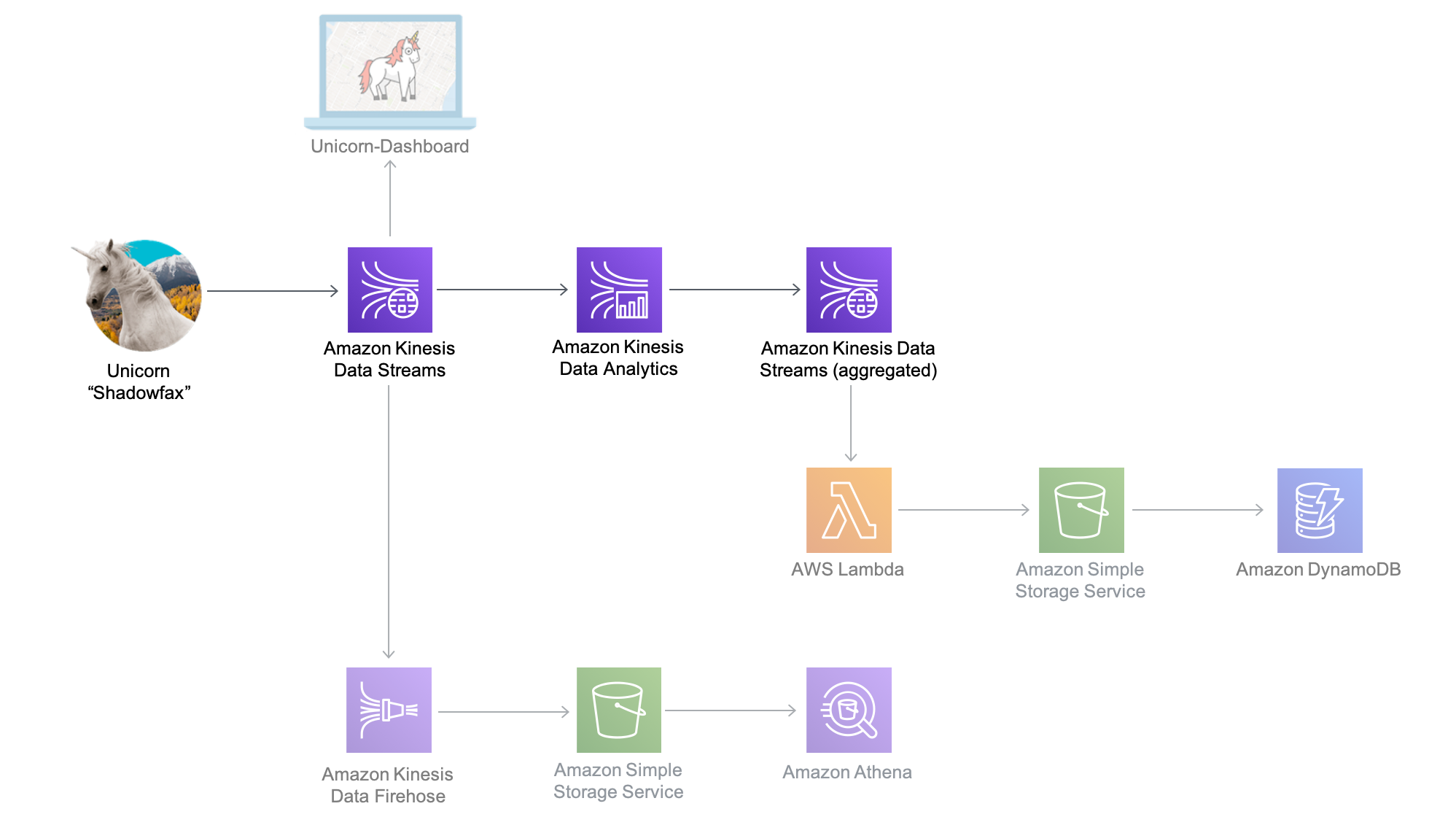

Dans ce module, vous allez créer une application Amazon Kinesis Data Analytics permettant de rassembler en temps réel les données des capteurs provenant du troupeau de licornes. L'application lira les données du flux Amazon Kinesis, calculera la distance totale parcourue ainsi que les valeurs minimales et maximales des points de vie et de magie pour chaque licorne actuellement active en Wild Ryde. En outre, elle produira ces statistiques cumulées dans un flux Amazon Kinesis toutes les minutes.

L'architecture de ce module est constituée d'une application Amazon Kinesis Data Analytics, de flux Amazon Kinesis source et destination, et de

L'application Amazon Kinesis Data Analytics traite les données du flux source Amazon Kinesis que nous avons créé dans le module précédent et les cumule toutes les minutes. Chaque minute, l'application enverra des données, notamment la distance totale parcourue au cours de la dernière minute ainsi que les valeurs minimales et maximales des points de vie et de magie pour chaque licorne de notre troupeau. Ces points de données seront envoyés à un flux de destination Amazon Kinesis dans le but d'être traités par d'autres composants de notre système.

Durée du module : 20 minutes

Services utilisés :

• Amazon Kinesis Data Streams

• Amazon Kinesis Data Analytics

Dans le module suivant, vous utiliserez AWS Lambda pour traiter des données depuis le flux