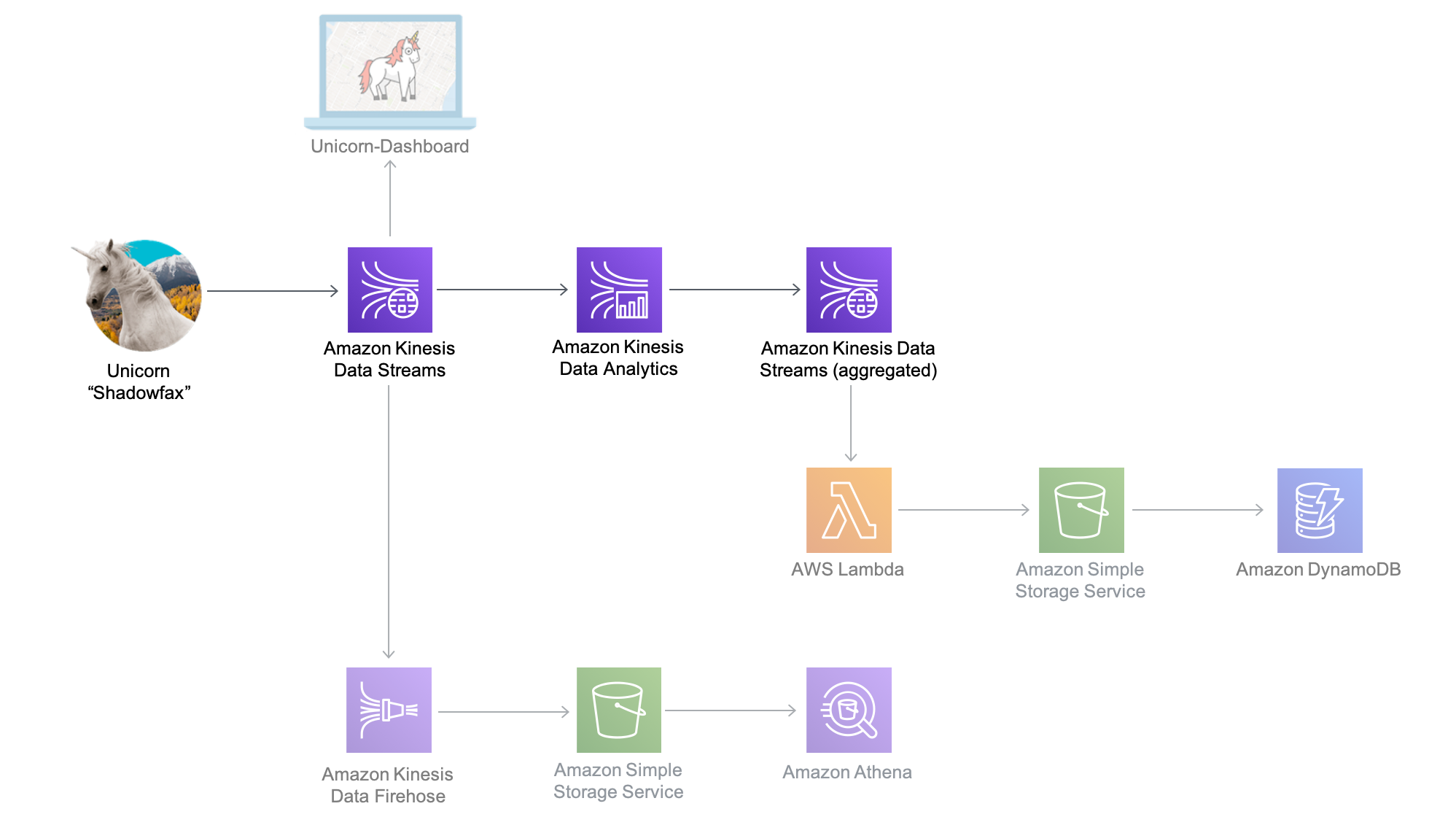

In questo modulo creerai un'applicazione Amazon Kinesis Data Analytics per aggregare in tempo reale dati di sensori provenienti dalla flotta di unicorni. L'applicazione leggerà dal flusso Amazon Kinesis, calcolerà la distanza totale percorsa e i punti minimi e massimi di integrità e magia per ciascun unicorno attualmente su un Wild Ryde e trasmetterà queste statistiche aggregate su un flusso Amazon Kinesis ogni minuto.

L'architettura di questo modulo prevede un'applicazione Amazon Kinesis Data Analytics, flussi Amazon Kinesis di origine e destinazione e

L'applicazione Amazon Kinesis Data Analytics elabora i dati dal flusso Amazon Kinesis di origine che abbiamo creato nel modulo precedente e li aggrega ogni minuto. Ogni minuto, l'applicazione emetterà dati che includono la distanza totale percorsa nell'ultimo minuto, nonché le letture minime e massime dai punti integrità e magia per ciascun unicorno della flotta. Questi punti dati verranno inviati a un flusso Amazon Kinesis di destinazione per l'elaborazione da parte di altri componenti del sistema.

Tempo necessario per completare il modulo: 20 minuti

Servizi utilizzati:

• Amazon Kinesis Data Streams

• Amazon Kinesis Data Analytics

Nel modulo successivo, utilizzerai AWS Lambda per elaborare i dati dal flusso Amazon Kinesis