/portcast%20logo%402x.15ef66a2fd613131199d6eececc53631c6564600.png)

Portcast met à l'échelle des modèles de machine learning relatifs au fret maritime grâce à Amazon SageMaker

2021

Amélioration de l'efficacité de la chaîne d'approvisionnement grâce au machine learning (ML)

Le transport maritime de marchandises est le principal mode de transport pour le commerce mondial, représentant 90 % du volume des échanges. La capacité à prévoir et à planifier l'arrivée des marchandises dans les ports détermine en grande partie l'efficacité de la chaîne d'approvisionnement, en dépit des perturbations météorologiques, des délais douaniers et d'autres facteurs.

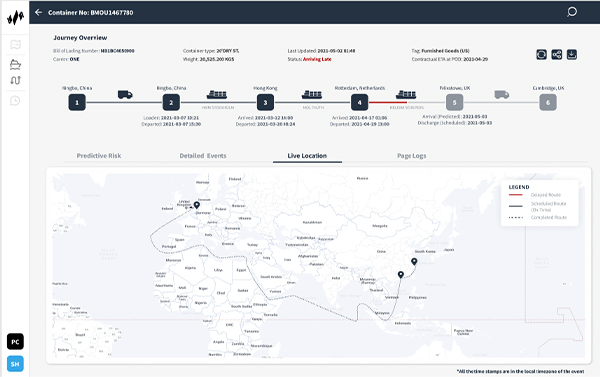

La startup Portcast, basée à Singapour, propose un logiciel en tant que service (SaaS) de prédiction de la chaîne d'approvisionnement via sa plateforme basée sur le machine learning (ML), qui aide les compagnies maritimes et les fabricants à prévoir l'heure d'arrivée des marchandises dans les ports. Portcast souhaite réduire les efforts manuels et les coûts de suivi des conteneurs de ses clients de 80 % et 20 % respectivement. Les modèles ML exclusifs de la société utilisent des modèles historiques d'expédition et de mouvements de conteneurs et des données en temps réel telles que les conditions météorologiques, le trafic portuaire et l'emplacement des navires pour améliorer l'efficacité de la chaîne d'approvisionnement.

Avec Amazon SageMaker, nous pouvons créer une plateforme évolutive à l'échelle mondiale pour la logistique prédictive avec un stockage dans le cloud et un calcul des données efficaces. »

Lingxiao Xia

Cofondateur et directeur technique, Portcast

Isolement des prédictions ML pour une mise à l'échelle indépendante

Portcast utilise une gamme de services Amazon Web Services (AWS) pour soutenir son infrastructure sous-jacente et sa capacité à exécuter des modèles ML à grande échelle. Pour stocker les données recueillies pour le traitement ML, elle utilise Amazon Relational Database Service (Amazon RDS) et Amazon Simple Storage Service (Amazon S3). Elle utilise également Amazon Elasticsearch Service pour l'analyse des journaux de recherche. « L'interaction entre les services sur AWS est transparente, ce qui nous permet d'expérimenter constamment des idées différentes », explique Lingxiao Xia, cofondateur et directeur technique de Portcast.

Jusqu'en 2019, Portcast entraînait et déployait ses modèles ML à l'aide d'instances matériel nu Amazon Elastic Compute Cloud (Amazon EC2) et de clusters auto-hébergés. Cette approche a bien fonctionné au début, lorsque l'entreprise ne suivait que quelques centaines de conteneurs à la fois. Cependant, au fur et à mesure que l'entreprise s'est développée, la mise à l'échelle de ses prévisions ML est devenue complexe et coûteuse, étant donné que chaque navire transportait souvent jusqu'à 20 000 conteneurs. La complexité était encore accrue par la nécessité de fournir des prévisions d'arrivée actualisées deux fois par jour et par conteneur.

Avec une configuration matériel nu, Portcast a dû faire évoluer l'ensemble de son infrastructure ML (y compris le traitement, les prédictions et les points de terminaison) de manière collective, ce qui a généré des besoins en mémoire très élevés. Portcast avait besoin d'isoler l'aspect prédictif de ses modèles ML afin de les faire évoluer de manière indépendante. Elle a relevé le défi en utilisant Amazon SageMaker.

Exécution de processus en parallèle avec une mémoire illimitée

Avant d'opter pour Amazon SageMaker, Portcast a demandé une session de formation pratique avec les architectes de solutions AWS. L'équipe de données de Portcast a utilisé Amazon SageMaker pour optimiser les charges de travail ML en séparant l'entraînement du modèle des prédictions et du traitement, en commençant par quelques instances effectuant l'entraînement du modèle ML. Désormais, Portcast utilise Amazon SageMaker pour accélérer l'automatisation de son cycle ML de bout en bout, de l'entraînement aux prédictions en passant par le traitement.

« En retirant les prédictions du modèle ML en tant que service distinct, nous sommes en mesure de faire évoluer les modèles de manière indépendante et de réduire les besoins en mémoire », explique Xia.

Auparavant, Portcast était limité par le nombre de processus qu'il pouvait exécuter en parallèle, car chaque modèle devait être chargé en mémoire. « Avec tous nos modèles hébergés sur Amazon SageMaker, nous pouvons exécuter des centaines de processus en parallèle sans aucune limite de mémoire. Nous avons le potentiel de générer des millions de prédictions par jour », ajoute Xia. Portcast exploite également la fonction de points de terminaison multi-modèles d'Amazon SageMaker pour réduire les coûts en hébergeant plusieurs modèles sur chaque instance, ce qui permet d'économiser au moins 60 % sur le déploiement ML.

Accélération du déploiement et automatisation de la surveillance

Actuellement, Portcast surveille des dizaines de milliers de conteneurs par jour, une échelle techniquement impossible à atteindre avec son ancienne infrastructure. « Avec Amazon SageMaker, nous pouvons créer une plateforme évolutive à l'échelle mondiale pour la logistique prédictive avec un stockage dans le cloud et un calcul des données efficaces », déclare Xia.

En tant que service entièrement géré, Amazon SageMaker gère l'infrastructure sous-jacente qui entraîne et exécute les modèles ML, de sorte que Portcast n'a qu'à déterminer la configuration initiale. Les modèles ML évoluent automatiquement, et Amazon CloudWatch envoie des alertes lorsque des anomalies sont détectées. L'équipe de Portcast chargée des données dispose d'une interface utilisateur qui permet une grande visibilité des tâches de traitement et de leur statut sans intervention manuelle. Cela permet à l'équipe d'économiser au moins deux à trois heures par semaine, auparavant consacrées à la surveillance de l'infrastructure.

Au-delà des gains de temps, Xia souligne l'intérêt de réduire les changements de contexte. « Si nos scientifiques des données doivent passer de l'analyse de modèles à des tâches de surveillance, le coût de changement de contexte est supérieur au temps consacré à cette tâche », explique-t-il.

Amélioration des flux de travail en matière de science et de développement des données

L'introduction d'Amazon SageMaker a également réduit la dépendance entre les équipes de science des données et de développement de Portcast. Les développeurs n'ont plus besoin de mettre en place une infrastructure avant que l'équipe chargée des données puisse mettre à jour les modèles ML ou ajouter de nouvelles fonctionnalités. Les scientifiques des données peuvent définir de manière indépendante l'infrastructure nécessaire à leurs tâches dans Amazon SageMaker.

Certains scientifiques des données maîtrisant Amazon SageMaker sont devenus des champions en interne. Ils suggèrent ou lancent régulièrement des projets pour aider à relever des défis communs tels que les goulets d'étranglement dans le traitement. L'équipe chargée des données enrichit aussi activement ses connaissances d'Amazon SageMaker par le biais de sessions ciblées et de discussions avec les architectes de solutions AWS sur les stratégies d'optimisation de la mise à l'échelle tout en contrôlant les coûts.

Mise à l'échelle pour soutenir l'expansion

Nidhi Gupta, cofondatrice et directrice générale de Portcast, estime que le meilleur reste à venir pour l'innovation logistique. « Les deux prochaines années constituent le point d'inflexion pour notre secteur, et nous prévoyons une croissance 10 à 20 fois supérieure dans les mois à venir », dit-elle. « Avec Amazon SageMaker, nous pouvons gérer davantage de conteneurs sur la même plateforme à mesure que nous nous développons. Cela nous permet d'explorer davantage d'opportunités commerciales tout en optimisant nos ressources, ce qui, au final, améliore nos résultats. »

En savoir plus

Pour en apprendre davantage, visitez la page Le Machine Learning sur AWS.

À propos de Portcast

Portcast offre une technologie de visibilité prédictive et de prévision de la demande pour les entreprises de logistique et les fabricants. Ses clients peuvent réduire la planification manuelle jusqu'à 80 % et déterminer avec plus de précision la demande de fret et les heures d'arrivée afin de contrôler les coûts.

Avantages d'AWS

- Exécution de centaines de processus ML en parallèle sans limite de mémoire

- Gain d'au moins deux à trois heures par semaine sur la surveillance de l'infrastructure

- Passage du suivi de centaines à des milliers de conteneurs en deux ans

- Réduction d'au moins 60 % des coûts de déploiement ML

- Réduction de la dépendance entre les équipes de développeurs et de scientifiques des données

- Encourage une culture de libre-service pour résoudre les goulots d'étranglement internes

Services AWS utilisés

Amazon SageMaker

Amazon SageMaker aide les scientifiques des données et les développeurs à préparer, créer, entraîner et déployer rapidement des modèles d'apprentissage automatique (ML) de haute qualité en rassemblant un large éventail de fonctionnalités conçues spécialement pour l'apprentissage automatique.

Amazon CloudWatch

Amazon CloudWatch est un service de surveillance et d'observabilité conçu pour les ingénieurs DevOps, les développeurs, les ingénieurs en fiabilité de sites (SRE) et les responsables informatiques.

Amazon Relational Database Service (RDS)

Amazon Relational Database Service (Amazon RDS) vous permet d'installer, de gérer et de mettre à l'échelle facilement une base de données relationnelle dans le cloud.

Amazon Elasticsearch Service

Amazon Elasticsearch Service est un service entièrement géré qui facilite le déploiement, la sécurisation et l'exécution d'Elasticsearch à grande échelle et de façon rentable.

Démarrer

Les entreprises de toute taille et de tous les secteurs d'activités transforment chaque jour leurs activités à l'aide d'AWS. Contactez nos spécialistes et commencez dès aujourd'hui votre transition vers le Cloud AWS.