PyTorch na AWS

Uma experiência PyTorch de alta performance, escalável e pronta para empresas na AWS

Acelere o tempo de treinamento com instâncias do Amazon EC2, Amazon SageMaker e bibliotecas PyTorch.

Acelere a prototipagem de pesquisa para implantações em escala de produção usando bibliotecas PyTorch.

Crie seu modelo de ML usando serviços de machine learning (ML) da AWS totalmente gerenciados ou autogerenciados.

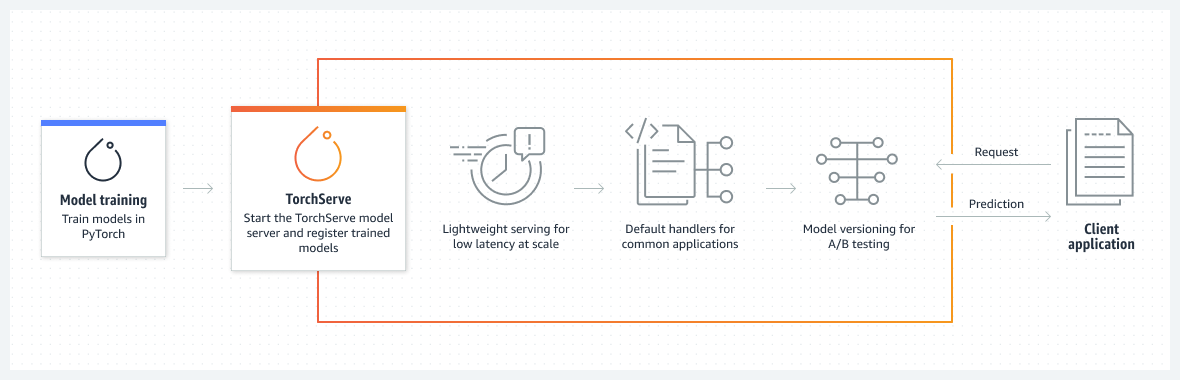

Como funciona

Casos de uso

Treinamento distribuído para grandes modelos de linguagem

Use os sistemas PyTorch Distributed Data Parallel (DDP) para treinar grandes modelos de linguagem com bilhões de parâmetros.

Saiba mais »

Inferência em escala

Escale a inferência usando instâncias do SageMaker e Amazon EC2 Inf1 para atender aos seus requisitos de latência, throughput e custo.

Saiba mais »

Modelos multimodais de ML

Use as bibliotecas multimodais do PyTorch para criar modelos personalizados para casos de uso, como reconhecimento de manuscrito em tempo real.

Saiba mais »

Como começar a usar

Aprenda ML com o Amazon SageMaker Studio Lab

Aprenda e experimente ML usando um ambiente de desenvolvimento gratuito e sem configuração

Comece a usar o PyTorch na AWS

Encontre tudo o que você precisa para começar a usar o PyTorch na AWS.

Veja mais sobre o PyTorch on AWS

Confira os principais recursos e capacidades para começar a trabalhar com o PyTorch.

Crie com o Amazon SageMaker JumpStart

Descubra soluções de ML pré-criadas que você pode implantar com apenas alguns cliques.