/portcast%20logo%402x.15ef66a2fd613131199d6eececc53631c6564600.png)

Portcast escala os modelos de machine learning no mar usando o Amazon SageMaker

2021

Promoção da eficiência da cadeia de suprimentos com machine learning (ML)

O transporte marítimo de mercadorias é o principal meio de transporte para o comércio global, respondendo por 90% do volume comercial. A capacidade de prever e planejar a chegada de mercadorias aos portos determina em grande medida a eficiência da cadeia de suprimentos, apesar das interrupções climáticas, dos atrasos alfandegários e de outros fatores.

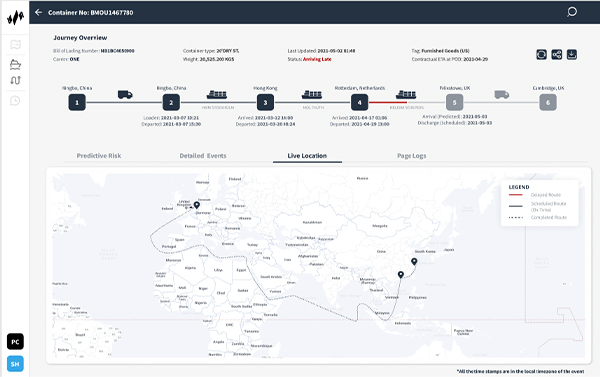

A startup Portcast, com sede em Singapura, oferece um software como serviço (SaaS) de cadeia de suprimentos preditivo por meio de sua plataforma de machine learning (ML), ajudando empresas de transporte e fabricantes a prever o horário de chegada da carga nos portos. A Portcast quer reduzir o esforço manual de seus clientes e o custo de rastreamento de contêineres em 80% e 20%, respectivamente. Os modelos de ML proprietários da empresa usam padrões históricos de movimentação de remessas e contêineres e dados em tempo real, como condições climáticas, tráfego portuário e localização de navios para aumentar a eficiência da cadeia de suprimentos.

Com o Amazon SageMaker, podemos construir uma plataforma globalmente escalável para logística preditiva com armazenamento eficiente em nuvem e computação de dados.”

Lingxiao Xia

Cofundador e CTO, Portcast

Isolar previsões de ML para escalar de forma independente

A Portcast usa uma variedade de serviços da Amazon Web Services (AWS) para oferecer suporte à infraestrutura subjacente e à capacidade de executar modelos de ML em escala. Para armazenar os dados coletados para processamento de ML, ela usa o Amazon Relational Database Service (Amazon RDS) e o Amazon Simple Storage Service (Amazon S3). Ela também usa o Amazon Elasticsearch Service para logs de pesquisa que orientam a análise. “A interação entre os serviços na AWS é perfeita, o que nos permite experimentar constantemente ideias diferentes”, diz Lingxiao Xia, cofundador e diretor de tecnologia da Portcast.

Até 2019, a Portcast estava treinando e implantando seus modelos de ML usando instâncias bare metal do Amazon Elastic Compute Cloud (Amazon EC2) e clusters auto-hospedados. Essa abordagem funcionou bem no início, quando a empresa rastreava algumas centenas de contêineres por vez. No entanto, à medida que a empresa crescia, dimensionar suas previsões de ML tornou-se complexo e caro, pois cada embarcação geralmente transportava até 20.000 contêineres. Para agravar a complexidade, havia a necessidade de fornecer previsões de chegada atualizadas duas vezes por dia por contêiner.

Com uma configuração bare-metal, a Portcast teve que dimensionar toda a sua infraestrutura de ML, incluindo processamento, previsões e endpoints, de maneira coletiva, o que gerou requisitos de memória muito elevados. A Portcast precisava isolar o aspecto de previsão de seus modelos de ML para escalar de forma independente. Então ela resolveu o problema usando o Amazon SageMaker.

Executar processos em paralelo com memória ilimitada

Antes de decidir sobre o Amazon SageMaker, a Portcast solicitou uma sessão de treinamento prático com arquitetos de soluções da AWS. A equipe de dados da Portcast usou o Amazon SageMaker para otimizar workloads de ML, separando o treinamento de modelos de previsões e processamento, começando com algumas instâncias que executam o treinamento de modelos de ML. Agora a Portcast usa o Amazon SageMaker para acelerar a automação em seu ciclo de ML de ponta a ponta, do treinamento ao processamento e às previsões.

“Ao tirar as previsões do modelo de ML como um serviço separado, podemos dimensionar os modelos de forma independente e reduzir os requisitos de memória”, diz Xia.

Anteriormente, a Portcast era limitada pelo número de processos que podia executar em paralelo, pois cada modelo precisava ser carregado na memória. “Com todos os nossos modelos hospedados no Amazon SageMaker, podemos executar centenas de processos em paralelo sem limite de memória. Temos o potencial de gerar milhões de previsões por dia”, acrescenta Xia. A Portcast também aproveita o recurso de endpoints multimodelo no Amazon SageMaker para reduzir custos hospedando vários modelos em cada instância, economizando pelo menos 60% na implantação de ML.

Acelerar a implantação e automatizar o monitoramento

Atualmente, a Portcast monitora dezenas de milhares de contêineres por dia, uma escala tecnicamente impossível em sua infraestrutura anterior. “Com o Amazon SageMaker, podemos construir uma plataforma globalmente escalável para logística preditiva com armazenamento em nuvem eficiente e computação de dados”, diz Xia.

Como um serviço totalmente gerenciado, o Amazon SageMaker lida com a infraestrutura subjacente que treina e executa modelos de ML, portanto, a Portcast precisa apenas determinar a configuração inicial. Os modelos de ML são dimensionados automaticamente e o Amazon CloudWatch envia alertas quando são detectadas anormalidades. A equipe de dados da Portcast tem uma interface de usuário que permite alta visibilidade dos trabalhos de processamento e respectivos status sem intervenção manual. Isso economiza à equipe pelo menos 2 a 3 horas por semana anteriormente gastas no monitoramento de infraestrutura.

Além da economia de tempo, Xia enfatiza o valor de reduzir a troca de contexto. “Se nossos cientistas de dados precisarem mudar da análise de modelos para tarefas de monitoramento, o custo de mudança de contexto é maior do que o tempo gasto nessa tarefa”, explica ele.

Melhorar os fluxos de trabalho de ciência de dados/desenvolvimento

A introdução do Amazon SageMaker também reduziu a dependência entre as equipes de ciência de dados e desenvolvimento da Portcast. Os desenvolvedores não precisam mais configurar a infraestrutura antes que a equipe de dados possa atualizar os modelos de ML ou adicionar novos recursos. Os cientistas de dados podem estabelecer de forma independente a infraestrutura necessária para seus trabalhos no Amazon SageMaker.

Alguns cientistas de dados proficientes no Amazon SageMaker se tornaram campeões internos. Eles regularmente sugerem ou iniciam projetos para ajudar a enfrentar desafios comuns, como gargalos de processamento. A equipe de dados também enriquece ativamente seu conhecimento do Amazon SageMaker por meio de sessões direcionadas e conversas com arquitetos de soluções da AWS sobre estratégias de otimização para escalabilidade e controle de custos.

Escalar para dar suporte à expansão

Nidhi Gupta, cofundadora e CEO da Portcast, sente que o melhor ainda está por vir em relação à inovação da logística. “Os próximos dois anos são apenas o ponto de inflexão para nossa indústria, e prevemos um crescimento de 10 a 20 vezes nos próximos meses”, diz ela. “Com o Amazon SageMaker, podemos lidar com mais contêineres na mesma plataforma à medida que crescemos. Isso nos permite explorar mais oportunidades de negócios enquanto otimizamos nossos recursos, o que, em última análise, melhora nossos resultados.”

Saiba mais

Para saber mais, acesse Machine learning na AWS.

Sobre a Portcast

A Portcast oferece visibilidade preditiva e tecnologia de previsão de demanda para empresas e fabricantes de logística. Os clientes da empresa podem reduzir o planejamento manual em até 80% e determinar com mais precisão a demanda de carga e os tempos de chegada para controlar os custos.

Benefícios da AWS

- Executa centenas de processos de ML em paralelo sem limite de memória

- Economiza pelo menos duas a três horas por semana em monitoramento de infraestrutura

- Escala do rastreamento de centenas a milhares de contêineres em dois anos

- Reduz os custos de implantação de ML em pelo menos 60%

- Reduz a dependência entre as equipes de desenvolvedores e de ciência de dados

- Promove uma cultura de autoatendimento para solucionar gargalos internos

Serviços da AWS usados

Amazon SageMaker

O Amazon SageMaker ajuda cientistas e desenvolvedores de dados a preparar, criar, treinar e implantar modelos de machine learning (ML) de alta qualidade rapidamente reunindo um amplo conjunto de funcionalidades criadas especificamente para ML.

Amazon CloudWatch

O Amazon CloudWatch é um serviço de monitoramento e observação criado para engenheiros de DevOps, desenvolvedores, Site Reliability Engineers (SREs – Engenheiros de confiabilidade de sites) e gerentes de TI.

Amazon Relational Database Service (RDS)

O Amazon Relational Database Service (Amazon RDS) facilita a configuração, a operação e a escalabilidade de bancos de dados relacionais na nuvem.

Amazon Elasticsearch Service

O Amazon Elasticsearch Service é um serviço totalmente gerenciado que facilita a implantação, a segurança e a execução do Elasticsearch de forma eficaz e em grande escala.

Comece a usar

Empresas de todos os portes em todos os setores estão transformando seus negócios diariamente usando a AWS. Entre em contato com nossos especialistas e comece sua própria jornada para a Nuvem AWS hoje mesmo.