/portcast%20logo%402x.15ef66a2fd613131199d6eececc53631c6564600.png)

Portcast escala los modelos de machine learning en el mar con Amazon SageMaker

2021

Fomento de la eficiencia de la cadena de suministro con machine learning (ML)

Los fletes marítimos constituyen la principal forma de transporte del comercio mundial y representan el 90 % del volumen comercial. La capacidad de predecir, y planificar en consecuencia, la llegada de mercancías a los puertos determina en gran medida la eficiencia de la cadena de suministro, a pesar de las interrupciones por inclemencias climáticas, retrasos en la aduana y otros factores.

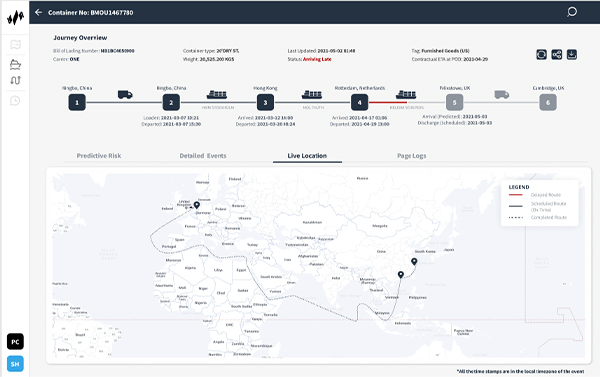

La empresa emergente Portcast, con sede en Singapur, ofrece un software como servicio (SaaS) de predicción de la cadena de suministro gracias a su plataforma con tecnología de machine learning. Este software ayuda a las compañías de envíos y a los fabricantes a predecir cuándo llegarán las cargas a los puertos. Portcast quiere reducir el esfuerzo manual que tienen que hacer los clientes y el coste del seguimiento de los contenedores un 80 % y un 20 %, respectivamente. Los modelos de ML propios de la compañía usan patrones históricos de envío y movimientos de los contenedores, así como datos en tiempo real, como las condiciones climáticas, el tráfico portuario y la ubicación de las embarcaciones para mejorar la eficiencia de la cadena de suministro.

«Con Amazon SageMaker, podemos crear una plataforma escalable a nivel mundial de logística predictiva con un almacenamiento en la nube y una computación de datos eficientes».

Lingxiao Xia

Cofundador y director de tecnología de Portcast

Aislamiento de las predicciones de ML para escalar de forma independiente

Portcast usa una variedad de servicios de Amazon Web Services (AWS) para respaldar su infraestructura subyacente y su capacidad de ejecutar modelos de ML a escala. Para almacenar los datos recopilados para el procesamiento de ML, utiliza Amazon Relational Database Service (Amazon RDS) y Amazon Simple Storage Service (Amazon S3). También usa Amazon Elasticsearch Service para los registros de búsqueda en los que se basan los análisis. «La interacción entre los servicios de AWS es fluida, lo que nos permite experimentar constantemente con distintas ideas», dice Lingxiao Xia, cofundador y director de tecnología de Portcast.

Hasta 2019, Portcast entrenaba y desplegaba sus modelos de ML con instancias bare metal de Amazon Elastic Compute Cloud (Amazon EC2) y clústeres autoalojados. Esta estrategia funcionaba al principio, cuando la compañía solo hacía el seguimiento de unos pocos cientos de contenedores al mismo tiempo. Pero cuando la compañía creció, escalar sus predicciones de ML se convirtió en una tarea compleja y cara teniendo en cuenta que cada embarcación solía llevar hasta 20 000 contenedores. A esto había que añadir la necesidad de ofrecer predicciones de llegada actualizadas dos veces al día por contenedor.

Con una configuración bare metal, Portcast tenía que escalar de forma conjunta toda su infraestructura de ML (que incluía el procesamiento, las predicciones y los puntos de conexión), lo que requería enormes capacidades de memoria. Portcast tenía que aislar el aspecto predictivo de sus modelos de ML para escalar independientemente. Resolvió este desafío con Amazon SageMaker.

Ejecución de procesos en paralelo con memoria sin límites

Antes de decidirse por Amazon SageMaker, Portcast solicitó una sesión de entrenamiento práctica con arquitectos de soluciones de AWS. El equipo de datos de Portcast usó Amazon SageMaker para optimizar las cargas de trabajo de ML. Para ello, separaron el entrenamiento de modelos de las predicciones y el procesamiento, y empezaron con solo unas pocas instancias llevando a cabo el entrenamiento de modelos de ML. Ahora, Portcast usa Amazon SageMaker para acelerar la automatización de su ciclo de ML integral, desde el entrenamiento hasta el procesamiento de predicciones.

«Al sacar predicciones del modelo de ML como un servicio aparte, podemos escalar modelos de forma independiente y reducir requisitos de memoria», dice Xia.

Anteriormente, Portcast estaba limitado por el número de procesos que podía ejecutar en paralelo, pues cada modelo tenía que cargarse en la memoria. «Con todos nuestros modelos alojados en Amazon SageMaker, podemos ejecutar cientos de procesos en paralelo sin límite de memoria. Tenemos el potencial de generar millones de predicciones al día», añade Xia. Portcast también aprovecha la característica de puntos de conexión multimodelo en Amazon SageMaker para reducir los costes alojando varios modelos en cada instancia, lo que ahorra al menos un 60 % en el despliegue de ML.

Aceleración del despliegue y automatización de la monitorización

Actualmente, Portcast monitoriza decenas de miles de contenedores al día, una escala que no podían abarcar técnicamente con su infraestructura anterior. «Con Amazon SageMaker, podemos crear una plataforma escalable a nivel mundial de logística predictiva con un almacenamiento en la nube y una computación de datos eficientes», dice Xia.

Como servicio completamente administrado, Amazon SageMaker gestiona la infraestructura subyacente que entrena y ejecuta modelos de ML, por lo que Portcast solo tiene que determinar la configuración inicial. Los modelos de ML ajustan automáticamente su capacidad y Amazon CloudWatch envía alertas cuando se detectan anomalías. El equipo de datos de Portcast tiene una interfaz de usuario con una buena visibilidad de los trabajos de procesamiento y su estado sin intervenir manualmente. Esto ahorra al equipo al menos 2 o 3 horas a la semana, tiempo que anteriormente dedicaban a la monitorización de la infraestructura.

Pero más allá del ahorro de tiempo, Xia también hace hincapié en el valor de reducir los cambios de contexto. «Si nuestros científicos de datos tuviesen que pasar de analizar modelos a monitorizar tareas, el coste de este cambio de contexto superaría al del tiempo dedicado a la tarea», explica.

Mejora de los flujos de trabajo de desarrollo y ciencia de datos

La adopción de Amazon SageMaker también ha reducido la dependencia entre los equipos de desarrollo y de ciencia de datos de Portcast. Los desarrolladores ya no tienen que configurar la infraestructura antes de que el equipo de datos pueda actualizar los modelos de ML o añadir nuevas características. Los científicos de datos pueden establecer ellos mismos en Amazon SageMaker la infraestructura que necesitan para trabajar.

Algunos científicos de datos con bastante experiencia en Amazon SageMaker se han convertido en adalides internos. Suelen sugerir o iniciar proyectos para abordar desafíos comunes, como los cuellos de botella en el procesamiento. El equipo de datos también enriquece activamente sus conocimientos sobre Amazon SageMaker mediante sesiones y debates especializados con arquitectos de soluciones de AWS. En ellos estudian estrategias de optimización para escalar y, a su vez, controlar los costes.

Escalado para respaldar la expansión

Nidhi Gupta, cofundadora y directora ejecutiva de Portcast, cree que lo mejor está por llegar para la innovación en logística. «Los próximos años serán solo el punto de inflexión de nuestro sector. Anticipamos un crecimiento entre 10 y 20 veces mayor en los próximos meses», dice. «Con Amazon SageMaker, podemos gestionar más contenedores en la misma plataforma a medida que crecemos. Así podremos descubrir más oportunidades empresariales y optimizar nuestros recursos, que es lo que al final mejora nuestros resultados».

Más información

Para más información, consulte Machine learning en AWS.

Acerca de Portcast

Portcast ofrece tecnología de visibilidad predictiva y de previsión de la demanda para compañías de logística y fabricantes. Sus clientes pueden reducir la planificación manual en hasta un 80 % y determinar de forma más precisa la demanda de carga y los tiempos de llegada para controlar los costes.

Ventajas de AWS

- Ejecuta cientos de procesos de ML en paralelo sin límite de memoria.

- Ahorra hasta 2 o 3 horas a la semana en la monitorización de la infraestructura.

- Se adapta para pasar de hacer un seguimiento de cientos de contenedores a miles en 2 años.

- Ahorra los costes de despliegue de ML en al menos un 60 %.

- Reduce la dependencia entre los equipos de desarrolladores y de ciencia de datos.

- Fomenta una cultura de autoservicio para resolver los cuellos de botella internos.

Servicios de AWS utilizados

Amazon SageMaker

Amazon SageMaker ayuda a los científicos de datos y a los desarrolladores a preparar, crear, entrenar e implementar con rapidez modelos de machine learning (ML) de alta calidad al poner a disposición un amplio conjunto de capacidades especialmente creadas para ML.

Amazon CloudWatch

Amazon CloudWatch es un servicio de monitoreo y observación creado para ingenieros de DevOps, desarrolladores, ingenieros de fiabilidad de sitio (SRE) y administradores de TI.

Amazon Relational Database Service (RDS)

Con Amazon Relational Database Service (Amazon RDS), es sencillo configurar, utilizar y escalar una base de datos relacional en la nube.

Amazon Elasticsearch Service

Amazon Elasticsearch Service es un servicio completamente administrado que facilita el despliegue, la protección y la ejecución de Elasticsearch a escala de manera rentable.

Introducción

Cada día crece el número de empresas de todos los tamaños y sectores que consiguen transformar sus negocios gracias a AWS. Contacte con nuestros expertos e inicie hoy mismo su proceso de traspaso a la nube de AWS.