¿Qué es el RLHF?

El aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF) es una técnica de machine learning (ML) que utiliza la retroalimentación humana para optimizar los modelos de ML y que puedan aprender automáticamente de manera más eficiente. Las técnicas de aprendizaje por refuerzo (RL) entrenan al software para tomar decisiones que maximicen las recompensas y hagan que sus resultados sean más precisos. El RLHF incorpora la retroalimentación humana en la función de recompensas, por lo que el modelo de ML puede realizar tareas más alineadas con los objetivos, deseos y necesidades de las personas. El RLHF se utiliza en todas las aplicaciones de inteligencia artificial generativa (IA generativa), incluidos los modelos de lenguaje de gran tamaño (LLM).

Obtenga más información sobre el machine learning

Obtenga más información sobre el aprendizaje por refuerzo

Obtenga más información sobre la IA generativa

Obtenga más información sobre los modelos de lenguaje de gran tamaño

¿Por qué es importante el RLHF?

Las aplicaciones de la inteligencia artificial (IA) son amplias, desde vehículos autónomos hasta el procesamiento de lenguaje natural (NLP), los predictores del mercado de valores y los servicios de personalización minorista. Independientemente de la aplicación dada, el objetivo de la IA es, en última instancia, imitar las respuestas, los comportamientos y la toma de decisiones de los humanos. El modelo ML debe codificar los datos de los humanos como datos de entrenamiento para que la IA imite a los humanos más de cerca al completar tareas complejas.

RLHF es una técnica específica que se utiliza para entrenar los sistemas de IA para que parezcan más humanos, junto con otras técnicas como el aprendizaje supervisado y no supervisado. En primer lugar, las respuestas del modelo se comparan con las respuestas de un ser humano. Luego, un humano evalúa la calidad de las diferentes respuestas de la máquina y califica qué respuestas suenan más como humanas. La puntuación se puede basar en cualidades humanas innatas, como la amabilidad, el grado adecuado de contextualización y el estado de ánimo.

El RLHF ocupa un lugar destacado en la comprensión del lenguaje natural, pero también se utiliza en otras aplicaciones de IA generativa.

Obtenga más información sobre la inteligencia artificial

Obtenga más información sobre el procesamiento de lenguaje natural

Más información sobre la diferencia entre el aprendizaje supervisado y el no supervisado

Mejora el rendimiento de la IA

El RLHF hace que el modelo de ML sea más preciso. Puede entrenar un modelo, se puede entrenar con datos humanos previamente generados, pero tener bucles de retroalimentación humana adicionales mejora significativamente el rendimiento del modelo en comparación con su estado inicial.

Por ejemplo, cuando el texto se traduce de un idioma a otro, un modelo puede producir un texto técnicamente correcto pero que no le parezca natural al lector. En primer lugar, un traductor profesional puede realizar la traducción, y la traducción generada por la máquina se califica en función de ella, y después se puede calificar la calidad de una serie de traducciones generadas por la máquina. La adición de entrenamiento adicional al modelo mejora la producción de traducciones más naturales.

Introduce parámetros de entrenamiento complejos

En algunos casos, en la IA generativa, puede resultar difícil entrenar con precisión el modelo para ciertos parámetros. Por ejemplo, ¿cómo se define el estado de ánimo de una pieza musical? Puede haber parámetros técnicos, como la tonalidad y el tempo, que indiquen un cierto estado de ánimo, pero el espíritu de una pieza musical es más subjetivo y está menos definido que una serie de tecnicismos. En cambio, puede proporcionar orientación humana para que los compositores creen piezas de emotivas y, a continuación, puede etiquetar las piezas generadas por máquinas de acuerdo con su nivel de emotividad. Esto permite que una máquina aprenda estos parámetros con mucha más rapidez.

Mejora la satisfacción del usuario

Si bien un modelo de ML puede ser preciso, puede que no parezca humano. Se necesita RL para guiar el modelo hacia la mejor y más atractiva respuesta para los usuarios humanos.

Por ejemplo, si le pregunta a un chatbot cómo está el tiempo afuera, podría responder: “Hace 30 grados centígrados con nubes y mucha humedad” o podría responder: “La temperatura es de alrededor de 30 grados en este momento. Está nublado y húmedo, ¡así que el aire puede parecer más denso!”. Aunque ambas respuestas dicen lo mismo, la segunda respuesta suena más natural y proporciona más contexto.

A medida que los usuarios humanos califican las respuestas de los modelos que prefieren, puede utilizar el RLHF para recopilar comentarios humanos y mejorar su modelo para que sirva mejor a personas reales.

¿Cómo funciona el RLHF?

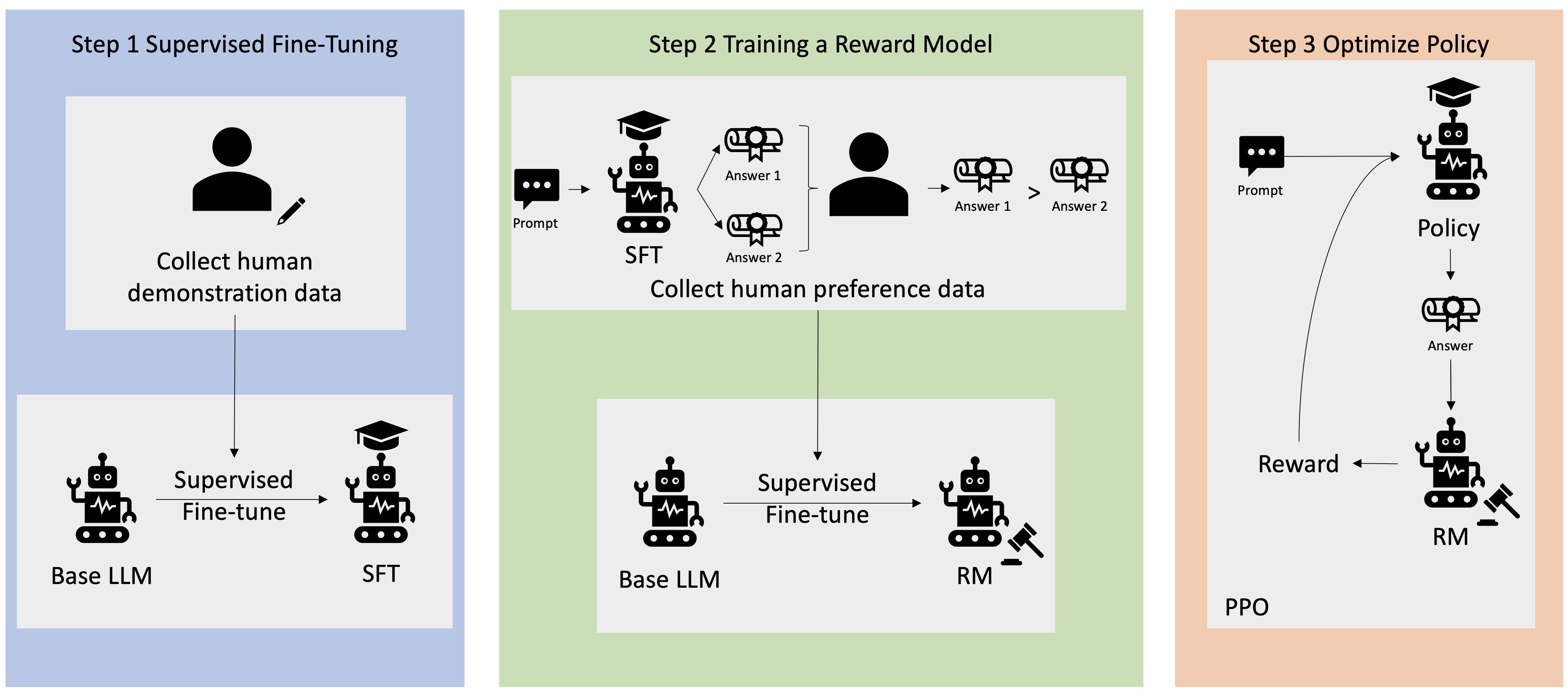

El RLHF se realiza en cuatro etapas antes de que el modelo se considere listo. En este caso, utilizamos el ejemplo de un modelo de lenguaje (un chatbot interno de la base de conocimientos de la empresa) que utiliza RLHF para perfeccionarlo.

Solo damos una visión general del proceso de aprendizaje. Existe una complejidad matemática significativa en el entrenamiento del modelo y su refinamiento de políticas para el RLHF. Sin embargo, los procesos complejos están bien definidos en RLHF y, a menudo, tienen algoritmos previamente diseñados que simplemente necesitan sus entradas únicas.

Recopilación de datos

Antes de realizar tareas de ML con el modelo de lenguaje, se crea un conjunto de indicaciones y respuestas generadas por humanos para los datos de entrenamiento. Este conjunto se usa más adelante en el proceso de entrenamiento del modelo.

Por ejemplo, las indicaciones podrían ser los siguientes:

- “¿Dónde está el departamento de recursos humanos en Boston?”

- “¿Cuál es el proceso de aprobación de las publicaciones en redes sociales?”

- “¿Qué indica el informe del primer trimestre sobre las ventas en comparación con los informes trimestrales anteriores?”

Luego, un trabajador del conocimiento de la empresa responde a estas preguntas con respuestas precisas y naturales.

Afinación supervisada de un modelo de lenguaje

Puede utilizar un modelo comercial previamente entrenado como modelo base para el RLHF. Puede afinar el modelo a la base de conocimientos interna de la empresa mediante técnicas como la generación aumentada de recuperación (RAG). Cuando se ajusta con precisión el modelo, se compara su respuesta a las indicaciones predeterminadas con las respuestas humanas recopiladas en el paso anterior. Las técnicas matemáticas pueden calcular el grado de similitud entre ambos.

Por ejemplo, a las respuestas generadas por máquina se les puede asignar una puntuación entre 0 y 1, y se considera 1 la más precisa y 0 la menos precisa. Con estos puntajes, el modelo ahora tiene una política diseñada para generar respuestas que tengan una puntuación más cercana a las respuestas humanas. Esta política constituye la base de todas las decisiones futuras para el modelo.

Creación de un modelo de recompensas independiente

El núcleo del RLHF es entrenar un modelo de recompensa de IA independiente basado en los comentarios de las personas y, a continuación, utilizar este modelo como una función de recompensa para optimizar las políticas a través de RL. Los seres humanos pueden indicar sus preferencias con respecto a la calidad de cada respuesta, dado un conjunto de respuestas múltiples del modelo que responden a la misma pregunta. Estas preferencias de valoración de las respuestas se utilizan para crear el modelo de recompensas que estime automáticamente la puntuación que una persona obtendría en una respuesta rápida determinada.

Optimización del modelo de lenguaje con el modelo basado en recompensas

A continuación, el modelo de lenguaje utiliza el modelo de recompensas para refinar automáticamente su política antes de responder a las solicitudes. Con el modelo de recompensa, el modelo de lenguaje evalúa internamente una serie de respuestas y, a continuación, elige la respuesta que tiene más probabilidades de resultar en la mayor recompensa. Esto significa que cumple con las preferencias humanas de una manera más optimizada.

La siguiente imagen muestra una descripción general del proceso de aprendizaje del RLHF.

¿Cómo se usa el RLHF en el campo de la IA generativa?

El RLHF es reconocido como la técnica estándar de la industria para garantizar que los LLM produzcan contenido que sea verdadero, inofensivo y útil. Sin embargo, la comunicación humana es un proceso subjetivo y creativo, y la utilidad de los resultados del LLM está profundamente influenciada por los valores y las preferencias humanas. Cada modelo se entrena de forma ligeramente diferente y utiliza diferentes respondedores humanos, por lo que los resultados difieren incluso entre los LLM de la competencia. El grado en que cada modelo involucra los valores humanos depende totalmente del creador.

Las aplicaciones del RLHF van más allá de los límites de los LLM y se extienden a otros tipos de IA generativa. A continuación, se indican varios ejemplos:

- El RLHF se puede utilizar en la generación de imágenes mediante IA: por ejemplo, para medir el grado de realismo, el tecnicismo o el estado de ánimo de una obra de arte.

- En la generación de música, el RLHF puede ayudar a crear música que combine ciertos estados de ánimo y bandas sonoras con las actividades.

- El RLHF se puede usar como asistente de voz, guiando la voz para que suene más amigable, curiosa y confiable.

¿Cómo puede ayudarlo AWS con sus requisitos de RLHF?

Amazon SageMaker Ground Truth ofrece el conjunto más completo de funciones integradas para incorporar los comentarios humanos a lo largo del ciclo de vida del ML para mejorar la precisión y la relevancia del modelo. Puede llevar a cabo diversas tareas de forma continua, desde la generación de datos y la anotación, hasta la generación de modelos de recompensas, la revisión y la personalización de modelos mediante una oferta de autoservicio o administrada por AWS.

SageMaker Ground Truth incluye un anotador de datos para las capacidades de RLHF. Puede brindar comentarios y orientación directos sobre los resultados que ha generado un modelo ordenando, clasificando o haciendo ambas cosas para sus respuestas a los resultados de la RL. Los datos, denominados datos de comparación y clasificación, son efectivamente un modelo de recompensa o una función de recompensa, que luego se utiliza para entrenar el modelo. Puede usar los datos de comparación y clasificación para personalizar un modelo existente para su caso de uso o para ajustar un modelo que cree desde cero.

Para comenzar a utilizar las técnicas RLHF en AWS, cree una cuenta hoy mismo.

Pasos siguientes en AWS

Obtenga acceso instantáneo al nivel Gratuito de AWS.

Comience a crear en la consola de administración de AWS.