/portcast%20logo%402x.15ef66a2fd613131199d6eececc53631c6564600.png)

Portcast Menskalakan Model Machine Learning di Laut Menggunakan Amazon SageMaker

2021

Meningkatkan Efisiensi Rantai Pasokan dengan Machine Learning (ML)

Pengiriman barang melalui laut adalah moda transportasi utama untuk perdagangan global, yaitu sebesar 90 persen dari volume perdagangan. Kemampuan untuk memprediksi dan merencanakan kedatangan barang di pelabuhan sangat menentukan efisiensi rantai pasokan, terlepas dari gangguan cuaca, penundaan bea cukai, dan faktor-faktor lainnya.

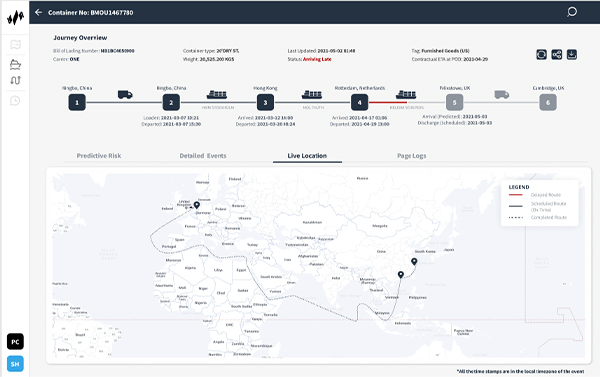

Portcast, sebuah startup yang berbasis di Singapura, menawarkan perangkat lunak sebagai layanan (SaaS) rantai pasokan prediktif melalui platform yang didukung machine learning (ML) mereka untuk membantu perusahaan pengiriman dan juga produsen dalam memprediksi waktu kedatangan kargo di pelabuhan. Portcast ingin mengurangi usaha manual dan biaya pelacakan kontainer dari pelanggannya, masing-masing sebesar 80 persen dan 20 persen. Model machine learning (ML) milik perusahaan menggunakan pola historis dari pengiriman dan pergerakan kontainer, serta data waktu nyata seperti kondisi cuaca, lalu lintas pelabuhan, dan lokasi kapal untuk meningkatkan efisiensi rantai pasokan.

Dengan Amazon SageMaker, kami dapat membangun platform yang dapat diskalakan secara global untuk logistik prediktif menggunakan penyimpanan cloud dan komputasi data yang efisien.”

Lingxiao Xia

Cofounder dan CTO, Portcast

Mengisolasi Prediksi Machine Learning (ML) untuk Penskalaan secara Independen

Portcast menggunakan berbagai produk Amazon Web Services (AWS) guna mendukung infrastruktur dan kemampuan dasarnya untuk menjalankan model machine learning (ML) dalam skala besar. Agar dapat menyimpan data yang dikumpulkan untuk pemrosesan machine learning (ML), Portcast menggunakan Amazon Relational Database Service (Amazon RDS), dan Amazon Simple Storage Service (Amazon S3). Portcast juga menggunakan Amazon Elasticsearch Service untuk analitik berbasis log pencarian. “Interaksi antarlayanan di AWS berjalan lancar sehingga memungkinkan kami untuk terus bereksperimen dengan berbagai ide,” kata Lingxiao Xia, cofounder dan kepala staf teknologi (chief technology officer) di Portcast.

Hingga 2019, Portcast telah melatih dan melakukan deployment untuk model machine learning (ML) mereka menggunakan instans bare metal Amazon Elastic Compute Cloud (Amazon EC2) dan klaster dengan hosting mandiri. Pada awalnya, pendekatan ini bekerja dengan baik ketika perusahaan melacak beberapa ratus kontainer sekaligus. Namun, seiring berkembangnya perusahaan, penskalaan prediksi machine learning (ML) mereka menjadi rumit dan mahal mengingat bahwa setiap kapal sering membawa hingga 20.000 kontainer. Hal lain yang makin menambah kerumitan tersebut ialah kebutuhan untuk memberikan prediksi kedatangan terkini sebanyak dua kali sehari per kontainer.

Dengan penyiapan bare-metal, Portcast harus menskalakan seluruh infrastruktur machine learning (ML) mereka—seperti pemrosesan, prediksi, dan titik akhir—secara kolektif, dan proses ini menyebabkan kebutuhan memori yang sangat tinggi. Portcast perlu mengisolasi aspek prediksi model machine learning (ML) mereka untuk penskalaan secara independen; tantangan ini terpecahkan menggunakan Amazon SageMaker.

Menjalankan Proses secara Paralel dengan Memori Tanpa Batas

Sebelum memutuskan untuk menggunakan Amazon SageMaker, Portcast meminta sesi pelatihan langsung dengan para arsitek solusi AWS. Tim data Portcast menggunakan Amazon SageMaker untuk mengoptimalkan beban kerja machine learning (ML) dengan memisahkan pelatihan model dari prediksi dan pemrosesan, dimulai dengan beberapa instans yang menjalankan pelatihan model machine learning (ML). Kini, Portcast menggunakan Amazon SageMaker untuk mempercepat otomatisasi dalam siklus machine learning (ML) menyeluruh mereka, mulai dari pelatihan ke pemrosesan hingga prediksi.

“Dengan mengeluarkan prediksi dari model machine learning (ML) sebagai suatu layanan terpisah, kami dapat menskalakan model secara independen dan mengurangi kebutuhan memori,” ujar Xia.

Sebelumnya, Portcast dibatasi oleh jumlah proses yang dapat dijalankan secara paralel karena setiap model harus dimuat ke dalam memori. “Dengan melakukan hosting bagi semua model kami di Amazon SageMaker, kami dapat menjalankan ratusan proses secara paralel tanpa batas memori. Kami memiliki potensi untuk menghasilkan jutaan prediksi setiap hari,” imbuh Xia. Portcast juga memanfaatkan fitur titik akhir multi-model di Amazon SageMaker untuk mengurangi biaya dengan melakukan hosting bagi beberapa model di setiap instans, dan langkah ini dapat menghemat setidaknya 60 persen pada deployment machine learning (ML).

Mempercepat Deployment dan Mengotomatiskan Pemantauan

Saat ini, Portcast memantau puluhan ribu kontainer per hari—sebuah skala yang secara teknis tidak mungkin dilakukan pada infrastruktur mereka sebelumnya. Dengan Amazon SageMaker, kami dapat membangun platform yang dapat diskalakan secara global untuk logistik prediktif dengan penyimpanan cloud dan komputasi data yang efisien,” kata Xia.

Sebagai layanan yang terkelola sepenuhnya, Amazon SageMaker menangani infrastruktur dasar yang melatih dan menjalankan model machine learning (ML) sehingga Portcast hanya perlu menentukan penyiapan awal. Model machine learning (ML) melakukan penskalaan secara otomatis, dan Amazon CloudWatch akan mengirimkan peringatan saat abnormalitas terdeteksi. Tim data Portcast memiliki antarmuka pengguna yang memungkinkan visibilitas tinggi ke dalam pekerjaan pemrosesan dan statusnya tanpa intervensi manual. Hal ini dapat menghemat waktu tim setidaknya 2-3 jam per minggu yang sebelumnya dihabiskan untuk pemantauan infrastruktur.

Di luar penghematan waktu, Xia menekankan nilai dari pengurangan pengalihan konteks. “Jika ilmuwan data kami harus beralih dari menganalisis model ke tugas pemantauan, biaya pengalihan konteks akan lebih banyak dari waktu yang dihabiskan pada tugas tersebut,” jelasnya.

Meningkatkan Alur Kerja Ilmu Data/Pengembangan

Hadirnya Amazon SageMaker juga telah mengurangi ketergantungan antara ilmu data dan tim pengembangan Portcast. Developer tidak perlu lagi menyiapkan infrastruktur sebelum tim data dapat memperbarui model machine learning (ML) atau menambahkan fitur baru. Ilmuwan data dapat secara mandiri membangun infrastruktur yang diperlukan untuk pekerjaan mereka di dalam Amazon SageMaker.

Beberapa ilmuwan data yang ahli di Amazon SageMaker telah menjadi pakar internal. Mereka secara teratur menyarankan atau memulai proyek guna membantu mengatasi tantangan umum seperti hambatan pemrosesan. Tim data juga secara aktif memperkaya pengetahuan mereka tentang Amazon SageMaker melalui sesi dan diskusi tertarget dengan para arsitek solusi AWS mengenai strategi pengoptimalan untuk penskalaan sekaligus mengendalikan biaya.

Penskalaan untuk Mendukung Ekspansi

Nidhi Gupta, cofounder dan kepala staf teknologi (chief technology officer) Portcast, merasa bahwa solusi terbaik di bidang inovasi logistik masih belum muncul. “Beberapa tahun ke depan hanyalah titik infleksi bagi industri kami, dan kami mengantisipasi pertumbuhan 10-20 kali lipat dalam beberapa bulan mendatang,” katanya. “Dengan Amazon SageMaker, kami dapat menangani lebih banyak kontainer di platform yang sama seiring dengan pertumbuhan kami. Hal ini memungkinkan kami untuk mengeksplorasi lebih banyak peluang bisnis sembari mengoptimalkan sumber daya kami, yang pada akhirnya akan meningkatkan laba bersih kami.”

Pelajari Lebih Lanjut

Untuk mempelajari selengkapnya, baca Machine Learning di AWS.

Tentang Portcast

Portcast menawarkan visibilitas prediktif serta teknologi prakiraan permintaan untuk perusahaan logistik dan produsen. Pelanggan mereka berhasil mengurangi perencanaan manual hingga 80 persen dan dapat lebih akurat dalam menentukan permintaan kargo serta waktu kedatangan guna mengendalikan biaya.

Manfaat AWS

- Menjalankan ratusan proses machine learning (ML) secara paralel tanpa batas memori

- Menghemat setidaknya 2-3 jam per minggu untuk pemantauan infrastruktur

- Melakukan penskalaan dari pelacakan ratusan kontainer hingga menjadi ribuan dalam 2 tahun

- Memotong biaya deployment machine learning (ML) setidaknya 60%

- Mengurangi ketergantungan antara developer dan tim ilmu data

- Menggalakkan budaya layanan mandiri untuk memecahkan hambatan internal

Produk AWS yang Digunakan

Amazon SageMaker

Amazon SageMaker membantu ilmuwan data dan developer menyiapkan, membangun, melatih, dan men-deploy model machine learning (ML) berkualitas tinggi dengan cepat dengan menggabungkan set kemampuan yang luas yang dibangun dengan tujuan khusus untuk ML.

Amazon CloudWatch

Amazon CloudWatch adalah layanan pemantauan dan pengamatan yang dibangun untuk teknisi DevOps, developer, teknisi keandalan situs (SRE), dan manajer IT.

Amazon Relational Database Service (RDS)

Amazon Relational Database Service (Amazon RDS) memudahkan penyiapan, pengoperasian, dan penskalaan basis data relasional di cloud.

Amazon Elasticsearch Service

Amazon Elasticsearch Service adalah layanan terkelola sepenuhnya yang mempermudah deployment, pengamanan, dan pengoperasian Elasticsearch dalam skala besar, tetapi tetap hemat biaya.

Mulai

Perusahaan segala ukuran dan lintas industri mentransformasikan bisnisnya setiap hari menggunakan AWS. Hubungi ahli kami dan mulai perjalanan AWS Cloud Anda sendiri sekarang juga.