Apa itu RLHF?

Pembelajaran penguatan dari umpan balik manusia (RLHF) adalah teknik machine learning (ML) yang menggunakan umpan balik manusia untuk mengoptimalkan model ML agar dapat belajar sendiri secara lebih efisien. Teknik pembelajaran penguatan (RL) melatih perangkat lunak untuk membuat keputusan yang memaksimalkan pengembalian sehingga membuat hasilnya lebih akurat. RLHF menggabungkan umpan balik manusia dalam fungsi pengembalian sehingga model ML dapat melakukan tugas-tugas yang lebih selaras dengan tujuan, keinginan, dan kebutuhan manusia. RLHF digunakan di seluruh aplikasi kecerdasan buatan generatif (AI generatif), termasuk dalam model bahasa besar (LLM).

Mengapa RLHF penting?

Aplikasi kecerdasan buatan (AI) sangat luas, mulai dari mobil otonom hingga pemrosesan bahasa alami (NLP), prediktor pasar saham, dan layanan personalisasi ritel. Apa pun aplikasi yang diberikan, tujuan AI pada akhirnya adalah untuk meniru respons manusia, perilaku, dan pengambilan keputusan. Model ML harus mengenkodekan input manusia sebagai data pelatihan sehingga AI dapat meniru manusia lebih seksama saat menyelesaikan tugas yang kompleks.

RLHF adalah teknik khusus yang digunakan dalam melatih sistem AI agar tampak lebih manusiawi, di samping teknik lain, seperti pembelajaran yang diawasi dan tanpa pengawasan. Pertama, respons model dibandingkan dengan respons manusia. Kemudian, manusia menilai kualitas respons yang berbeda dari mesin, lalu menilai respons yang terdengar lebih manusiawi. Skor dapat didasarkan pada kualitas bawaan manusia, seperti keramahan, tingkat kontekstualisasi yang tepat, dan suasana hati.

RLHF menonjol dalam pemahaman bahasa alami, tetapi juga digunakan di seluruh aplikasi AI generatif lainnya.

Baca tentang kecerdasan buatan

Baca tentang pemrosesan bahasa alami

Baca tentang perbedaan antara pembelajaran yang diawasi dan tanpa pengawasan

Meningkatkan performa AI

RLHF membuat model ML lebih akurat. Anda dapat melatih model yang dapat dilatih pada data manusia yang dibuat sebelumnya, tetapi dengan loop umpan balik manusia tambahan secara signifikan akan meningkatkan performa model dibandingkan dengan keadaan awalnya.

Misalnya, saat teks diterjemahkan dari satu bahasa ke bahasa lain, model mungkin menghasilkan teks yang secara teknis benar, tetapi terdengar tidak alami bagi pembaca. Seorang penerjemah profesional pertama-tama dapat melakukan penerjemahan, dengan terjemahan yang dihasilkan mesin dinilai terhadap terjemahan profesional tersebut, lalu serangkaian terjemahan yang dihasilkan mesin dapat dinilai kualitasnya. Penambahan pelatihan lebih lanjut pada model menjadikannya lebih baik dalam menghasilkan terjemahan yang terdengar alami.

Memperkenalkan parameter pelatihan yang kompleks

Dalam beberapa instans di AI generatif, melatih model secara akurat untuk parameter tertentu mungkin sulit dilakukan. Misalnya, bagaimana Anda mendefinisikan nuansa sebuah karya musik? Mungkin ada parameter teknis, seperti kunci dan tempo yang menunjukkan nuansa tertentu, tetapi jiwa sebuah karya musik lebih subjektif dan kurang terdefinisi dengan baik daripada sekadar serangkaian teknis. Sebagai gantinya, Anda dapat memberikan panduan manusia kepada komposer untuk membuat karya yang dapat membangun suasana hati, lalu Anda dapat memberi label pada karya yang dihasilkan mesin sesuai dengan tingkat nuansanya. Hal ini memungkinkan mesin untuk mempelajari parameter ini dengan lebih cepat.

Meningkatkan kepuasan pengguna

Meskipun model ML dapat akurat, namun mungkin tidak tampak seperti manusia. RL diperlukan untuk memandu model menuju respons terbaik dan paling menarik bagi pengguna manusia.

Misalnya, jika Anda bertanya kepada chatbot seperti apa cuaca di luar, chatbot tersebut mungkin merespons, “Cuaca di luar 30 derajat Celsius dengan awan dan kelembapan tinggi,” atau mungkin merespons, “Suhu sekitar 30 derajat saat ini. Cuacanya berawan dan lembap sehingga udaranya mungkin tampak lebih berkabutl! ”Meskipun kedua respons mengatakan hal yang sama, respons kedua terdengar lebih alami dan memberikan lebih banyak konteks.

Saat pengguna manusia menilai respons model yang mereka sukai, Anda dapat menggunakan RLHF untuk mengumpulkan umpan balik manusia dan meningkatkan model Anda agar dapat memberikan pelayanan terbaik kepada orang-orang di dunia nyata.

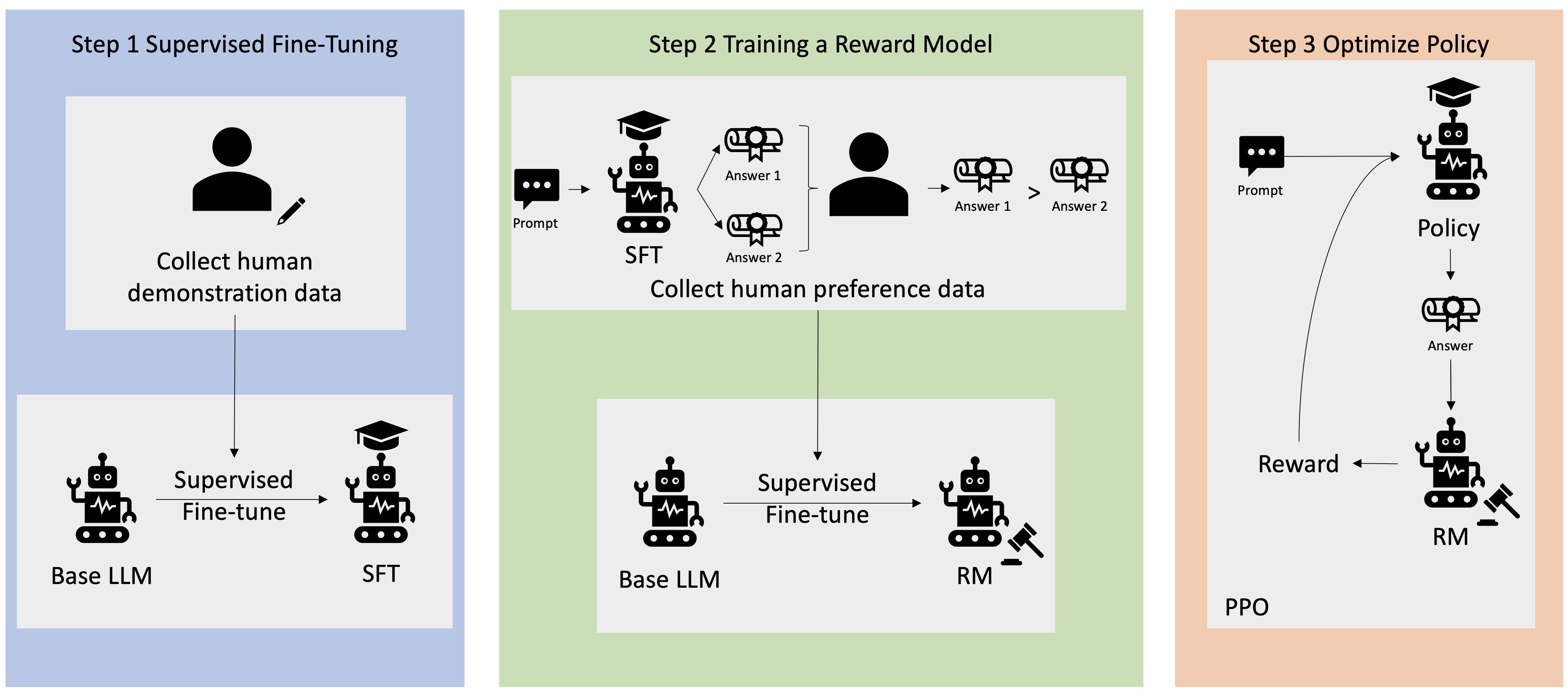

Bagaimana cara kerja RLHF?

RLHF dilakukan dalam empat tahap sebelum model dianggap siap. Di sini, kami menggunakan contoh model bahasa—chatbot basis pengetahuan internal perusahaan—yang menggunakan RLHF untuk penyempurnaan.

Kami hanya memberikan gambaran umum mengenai proses pembelajaran. Kompleksitas matematika yang signifikan ada dalam pelatihan model dan penyempurnaan kebijakannya untuk RLHF. Namun, proses yang kompleks didefinisikan dengan baik di RLHF dan sering memiliki algoritma bawaan yang hanya membutuhkan input unik Anda.

Pengumpulan data

Sebelum melakukan tugas ML dengan model bahasa, set perintah dan respons yang dihasilkan manusia dibuat untuk data pelatihan. Set ini digunakan nanti dalam proses pelatihan model.

Misalnya, perintahnya mungkin:

- “Di mana lokasi departemen SDM di Boston?”

- “Apa saja proses persetujuan untuk posting media sosial?”

- “Apa yang ditunjukkan laporan Q1 tentang penjualan dibandingkan dengan laporan per kuartal sebelumnya?”

Pekerja intelektual di perusahaan lalu menjawab pertanyaan-pertanyaan ini dengan respons yang akurat dan alami.

Penyempurnaan model bahasa yang diawasi

Anda dapat menggunakan model yang dilatih sebelumnya secara komersial sebagai model dasar untuk RLHF. Anda dapat menyempurnakan model ke dasar pengetahuan internal perusahaan dengan menggunakan teknik seperti retrieval-augmented generation (RAG). Saat model disempurnakan dengan baik, Anda membandingkan responsnya dengan perintah yang telah ditentukan sebelumnya dengan respons manusia yang dikumpulkan pada langkah sebelumnya. Teknik matematika dapat menghitung tingkat kesamaan di antara keduanya.

Misalnya, respons yang dihasilkan mesin dapat diberi skor antara 0 dan 1, dengan 1 menjadi yang paling akurat dan 0 menjadi yang paling tidak akurat. Dengan skor tersebut, model kini memiliki kebijakan yang dirancang untuk membentuk respons yang memiliki skor yang mendekati respons manusia. Kebijakan ini membentuk dasar dari semua pengambilan keputusan pada masa mendatang untuk model tersebut.

Membangun model pengembalian terpisah

Inti dari RLHF adalah melatih model imbalan AI terpisah berdasarkan umpan balik manusia, lalu menggunakan model ini sebagai fungsi pengembalian untuk mengoptimalkan kebijakan melalui RL. Dengan adanya serangkaian respons dari model yang menjawab perintah yang sama, manusia dapat menunjukkan preferensi mereka mengenai kualitas setiap respons. Anda menggunakan preferensi tingkat respons ini untuk membangun model pengembalian yang secara otomatis memperkirakan seberapa tinggi skor manusia akan mendapat respons perintah yang diberikan.

Optimalkan model bahasa dengan model berbasis pengembalian

Model bahasa kemudian menggunakan model pengembalian untuk memperbaiki kebijakannya secara otomatis sebelum merespons perintah. Dengan menggunakan model pengembalian, model bahasa secara internal mengevaluasi serangkaian respons lalu memilih respons yang paling mungkin menghasilkan pengembalian terbesar. Hal ini berarti memenuhi preferensi manusia dengan cara yang lebih optimal.

Gambar berikut menunjukkan gambaran umum proses pembelajaran RLHF.

Bagaimana RLHF digunakan dalam bidang AI generatif?

RLHF diakui sebagai teknik standar industri untuk memastikan bahwa LLM menghasilkan konten yang jujur, tidak berbahaya, dan bermanfaat. Namun, komunikasi manusia adalah proses subjektif dan kreatif—dan manfaat output LLM sangat dipengaruhi oleh nilai-nilai dan preferensi manusia. Setiap model dilatih sedikit berbeda dan menggunakan responden manusia yang berbeda sehingga output tersebut berbeda bahkan di antara LLM yang kompetitif. Sejauh mana setiap model melibatkan nilai-nilai kemanusiaan sepenuhnya tergantung pada pembuat.

Aplikasi RLHF melampaui batas LLM ke tipe AI generatif lainnya. Berikut beberapa contohnya:

- RLHF dapat digunakan dalam pembuatan gambar AI: misalnya, mengukur tingkat realisme, teknis, atau nuansa karya seni

- Dalam pembuatan musik, RLHF dapat membantu dalam menciptakan musik yang cocok dengan suasana hati dan soundtrack tertentu untuk aktivitas

- RLHF dapat digunakan dalam asisten suara, memandu suara agar lebih enak didengar, membuat penasaran, dan dapat dipercaya

Bagaimana AWS dapat membantu kebutuhan RLHF Anda?

Amazon SageMaker Ground Truth menawarkan serangkaian kemampuan manusia dalam loop yang paling komprehensif untuk menggabungkan umpan balik manusia di seluruh siklus hidup ML dalam meningkatkan keakuratan dan relevansi model. Anda dapat menyelesaikan berbagai tugas manusia dalam loop, mulai dari pembuatan data dan anotasi hingga pembuatan model pengembalian, peninjauan model, dan penyesuaian melalui layanan mandiri atau penawaran terkelola AWS.

SageMaker Ground Truth mencakup anotator data untuk kemampuan RLHF. Anda dapat memberikan umpan balik dan panduan secara langsung mengenai output yang dihasilkan model dengan memberi peringkat, mengklasifikasikan, atau melakukan keduanya untuk responsnya terhadap hasil RL. Data, yang disebut sebagai data perbandingan dan peringkat, secara efektif merupakan model pengembalian atau fungsi pengembalian, yang kemudian digunakan untuk melatih model. Anda dapat menggunakan data perbandingan dan peringkat untuk menyesuaikan model yang ada untuk kasus penggunaan Anda atau untuk menyempurnakan model yang Anda buat dari awal.

Mulai teknik RLHF di AWS dengan membuat akun sekarang juga.

Langkah Berikutnya di AWS