エンタープライズ AI とは?

エンタープライズ AI とは?

エンタープライズ人工知能 (AI) は、大規模な組織内で高度な AI テクノロジーを採用することです。AI システムをプロトタイプから本番環境に移行すると、規模、パフォーマンス、データガバナンス、倫理、規制遵守に関するいくつかの課題が生じます。エンタープライズ AI には、大規模な組織内で広く AI を使用するためのポリシー、戦略、インフラストラクチャ、およびテクノロジーが含まれます。多額の投資と労力を必要としますが、AI システムが主流になるにつれて、大規模組織にとってエンタープライズ AI の重要性が高まっています。

エンタープライズ AI プラットフォームとは?

エンタープライズAIプラットフォームは、組織がAIアプリケーションを大規模に実験、開発、展開、運用できるようにするテクノロジーの統合グループです。ディープラーニングモデルは、あらゆる AI アプリケーションの中核です。エンタープライズ AI では、より高度な AI モデルにより、新しい問題が発生したり、データセットが提供されたりするたびにモデルをゼロからトレーニングするのではなく、タスク間で再利用するよう求めます。エンタープライズ AI プラットフォームは、深層学習モデルを組織全体で大規模に再利用、製品化、実行するために必要なインフラストラクチャを提供します。これは、継続的な改善や環境の変化に柔軟に対応しながら、持続可能な価値を提供しながら、エンドツーエンドで安定した、回復力があり、反復可能な完全なシステムです。

エンタープライズ AI にはどのようなメリットがありますか?

エンタープライズ AI を実装すると、以前は解決できなかった課題を解決できます。大規模な組織の新たな収益源と効率化を促進するのに役立ちます。

イノベーションの推進

大企業には通常、数百のビジネスチームがありますが、すべてのチームにデータサイエンスのスキルに必要な予算とリソースがあるわけではありません。エンタープライズ規模のAIにより、経営陣は人工知能と機械学習 (AI/ML)テクノロジーを民主化し、企業全体で利用しやすくすることができます。組織内の誰もが AI ツールを提案し、実験し、ビジネスプロセスに組み込むことができます。ビジネス知識を持つドメインエキスパートは、AI プロジェクトに貢献し、デジタルトランスフォーメーションを主導できます。

ガバナンスの強化

AI 開発へのサイロ化されたアプローチでは、可視性とガバナンスが限られています。サイロ化されたアプローチでは、特に重要な意思決定の予測において、利害関係者の信頼を低下させ、AI の採用が限定されてしまいます。

エンタープライズ AI は、プロセスに透明性と制御をもたらします。組織は、イノベーションを促進しながら、規制要件に従って機密データへのアクセスを制御できます。データサイエンスチームは、説明可能な AI アプローチを使用して AI の意思決定に透明性をもたらし、エンドユーザーの信頼を高めることができます。

コスト削減

AI プロジェクトのコスト管理では、特にトレーニング中に、開発労力、時間、コンピューティングリソースを慎重に管理する必要があります。エンタープライズ AI 戦略は、組織内の反復的なエンジニアリング作業を自動化し、標準化することができます。AI プロジェクトでは、重複や無駄を発生させずに、コンピューティングリソースに一元的かつスケーラブルにアクセスできます。時間の経過とともに、リソース割り当てを最適化し、エラーを減らし、プロセス効率を向上させることができます。

生産性を強化

日常的なタスクを自動化することで、AI は時間の浪費を減らし、人的資源をより創造的で生産的な仕事に充てることができます。エンタープライズソフトウェアにインテリジェンスを追加することで、事業運営のスピードが向上し、企業活動のさまざまな段階間で必要な時間を短縮することもできます。設計から商品化、または生産から納品までの期間を短縮することで、投資をすぐに回収できます。

エンタープライズ AI のユースケースにはどのようなものがありますか?

エンタープライズ AI アプリケーションは、サプライチェーン管理から不正検出、顧客関係管理まで、すべてを最適化できます。次に、いくつかの例を導入事例とともに示します。

研究開発

組織は膨大なデータセットを分析し、傾向を予測し、結果をシミュレートすることで、製品開発に必要な時間とリソースを大幅に削減できます。AI モデルは、過去の製品の成功と失敗からパターンとインサイトを特定し、将来の製品やサービスの開発の指針となります。また、コラボレーティブイノベーションの一助にもなり、さまざまな地域のチームが複雑なプロジェクトでより効果的に取り組むことができます。

たとえば、世界的な製薬ブランドであるアストラゼネカは、品質を高め、潜在的な医薬品候補の発見にかかる時間を短縮するために、AI主導の創薬プラットフォームを構築しました。

アセット管理

AI テクノロジーは、組織内の物理資産とデジタルアセットの取得、使用、廃棄を最適化します。例えば、予知保全アルゴリズムは、機器や機械が故障する可能性が高い時期やメンテナンスが必要になる時期を予測できます。効率の向上、エネルギー消費量の削減、またはアセットの耐用年数の延長を目的として、機械の運用上の調整を提案できます。AI を活用した追跡システムを通じて、組織はアセットの場所と状態をリアルタイムで可視化できます。

たとえば、医療技術の世界的リーダーであるバクスター・インターナショナル社は、AIを活用して予期しない機器のダウンタイムを削減し、1つの施設で500マシン時間を超える予期しないダウンタイムを防止しています。

カスタマーサービス

AI は、パーソナライズされた、効率的でスケーラブルな顧客との対話を可能にします。AIを搭載したチャットボットとバーチャルアシスタントは、人間の介入なしに多くの顧客からの問い合わせを処理します。また、AI は膨大な顧客データをリアルタイムで分析できるため、企業はパーソナライズされたレコメンデーションやサポートを提供できます。

たとえば、グローバルな通信企業であるT-Mobileは、AIを使用して顧客とのやり取りのスピードと質を高めています。人間のエージェントは、より良く、より迅速に顧客に対応することで、カスタマーエクスペリエンスを充実させ、人と人との強固なつながりを築くことができます。

エンタープライズ AI における主な技術上の考慮事項は何ですか?

エンタープライズ AI の導入を成功させるには、組織が以下を実装する必要があります。

データ管理

AI プロジェクトには、企業データ資産への簡単で安全なアクセスが必要です。ストリーミングデータ処理、バッチデータ処理、データメッシュ、データウェアハウスを問わず、組織はデータエンジニアリングパイプラインを構築する必要があります。データサイエンティストが必要なデータセットをすばやく見つけて使用できるように、データカタログなどのシステムが整っていることを確認する必要があります。一元化されたデータガバナンスメカニズムは、データ検索に不必要な障害を引き起こすことなく、データアクセスを規制し、リスク管理をサポートします。

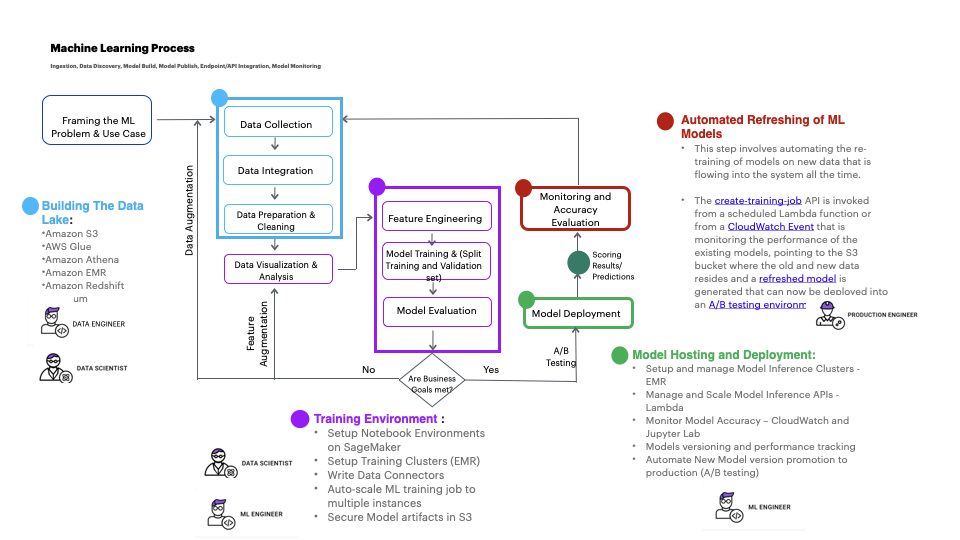

モデルトレーニングインフラストラクチャ

組織は、新規および既存の機械学習モデルを構築およびトレーニングするための一元化されたインフラストラクチャを確立する必要があります。たとえば、特徴エンジニアリングでは、トレーニング用に生データから変数や特徴(価格表や製品説明など)を抽出して変換します。一元化された特徴量ストアにより、さまざまなチームが共同作業を行い、再利用を促進し、重複した作業によるサイロ化を回避できます。

同様に、データサイエンスチームが既存のAIモデルを社内のデータに適応させるには、検索拡張生成 (RAG)をサポートするシステムが必要です。大規模言語モデル (LLM)は膨大なデータ量でトレーニングされ、数十億のパラメーターを使用して元の出力を生成します。LLM は、質問への回答、言語の翻訳、自然言語処理などのタスクに使用できます。RAG は、LLM の既に強力な機能を、モデルを再トレーニングすることなく、特定の分野や組織の内部ナレッジベースに拡張します。

中央モデルレジストリ

中央モデルレジストリは、さまざまなビジネスユニットで構築およびトレーニングされた LLM および機械学習モデルのエンタープライズカタログです。これにより、モデルのバージョニングが可能になり、チームは次のような多くのタスクを実行できます。

-

モデルイテレーションの経時的な追跡

-

さまざまなバージョン間のパフォーマンス比較

-

デプロイで最も効果的で最新のバージョンの確実な使用

また、チームは、トレーニングデータ、パラメータ、パフォーマンスメトリクス、使用権限など、モデルメタデータの詳細な記録を管理できます。これにより、チーム間のコラボレーションが強化され、AI モデルのガバナンス、コンプライアンス、監査が容易になります。

モデルのデプロイ

MLOps や LLMOP のようなプラクティスは、企業の AI 開発に運用効率をもたらします。彼らはDevOpsの原則をAIと機械学習のユニークな課題に適用しています。

例えば、データ準備、モデルトレーニング、テスト、デプロイなど、ML と LLM のさまざまなライフサイクルステージを自動化して、手作業によるミスを減らすことができます。ML と LLM の運用パイプラインを構築することで、AI モデルの継続的インテグレーションと継続的デリバリー (CI/CD) が促進されます。チームは、リアルタイムのフィードバックと変化する要件に基づいて、モデルを迅速に反復および更新できます。

モデルのモニタリング

AI モデルを管理し、AI が生成したコンテンツの信頼性、正確性、関連性を長期にわたって確保するには、監視が不可欠です。AI モデルはハルシネーションを起こしたり、不正確な情報を生成したりする場合もあります。データやコンテキストが進化することで、モデルの出力が重要ではなくなることもあります。

LLM の出力を効果的に管理するには、組織はヒューマンインザループメカニズムを導入する必要があります。ドメインエキスパートが定期的に AI 出力を評価し、その正確性と適切性を確認します。エンドユーザーからのリアルタイムのフィードバックを利用することで、組織はAIモデルの完全性を維持し、利害関係者の進化するニーズに確実に応えることができます。

AWS はエンタープライズ AI 戦略をどのようにサポートできますか?

Amazon Web Services (AWS) では、モデルの選択と柔軟性に基づいて、AI アプリケーションを構築およびスケールする最も簡単な方法が用意されています。当社は、エンドツーエンドのセキュリティ、プライバシー保護、AI ガバナンスにより、企業があらゆる事業分野で AI システムを採用できるよう支援してきました。

ビジネスニーズに合った、最も幅広く奥深いサービスの中からお選びください。エンドツーエンドのソリューションと事前トレーニング済みの AI サービスを見つけることも、フルマネージドインフラストラクチャ上で独自のエンタープライズ AI プラットフォームとモデルを構築することもできます。

AWS の事前トレーニング済みの AI サービス

AWS の事前トレーニング済みの AI サービスは、お客様のアプリケーションとワークフローに既成のインテリジェンスを提供します。たとえば、画像や動画の分析には Amazon Rekognition 、会話型インターフェイスには Amazon Lex 、エンタープライズ検索には Amazon Kendra を使用できます。モデルをトレーニングしたりデプロイしたりしなくても、継続的に学習する API から品質と精度を実現することができます。

Amazon Bedrock

Amazon Bedrock は完全マネージド型サービスで、主要な AI 企業が提供する高性能な基盤モデル (FM) を 1 つの API で選択できます。Bedrock には、セキュリティ、プライバシー保護、責任ある AI を備えた生成 AI アプリケーションを構築するための幅広い機能も用意されています。

Amazon Bedrock を利用すると、ユースケースに最適な FM を簡単に実験および評価できます。その後、ファインチューニングや検索拡張生成 (RAG) などの手法を用いて、データに合わせて個別にカスタマイズできます。また、企業のシステムとデータソースを使用してタスクを実行するエージェントを作成できます。

Amazon SageMaker

Amazon SageMaker はフルマネージド型サービスで、幅広いツールセットを組み合わせて、あらゆるユースケースで高性能で低コストのディープラーニングを実現します。SageMaker を使用すると、深層学習モデルを大規模に構築、トレーニング、およびデプロイできます。ノートブック、デバッガー、プロファイラー、パイプラインなどのツールをすべて 1 つの統合開発環境 (IDE) で使用します。

AWS 深層学習 AMI

AWS ディープラーニング AMI (DLAMI) は、企業の AI 研究者に、厳選された安全なフレームワーク、依存関係、およびツールのセットを提供します。これにより、Amazon Elastic Compute Cloud (Amazon EC2) での深層学習をより迅速に行えます。

Amazon マシンイメージ (AMI) は AWS が提供するイメージで、インスタンスの起動に必要な情報を提供します。Amazon Linux と Ubuntu 向けに構築された AMI には、以下があらかじめ設定されています。

-

TensorFlow

-

PyTorch

-

NVIDIA CUDA ドライバーとライブラリ

-

Intel MKL

-

Elastic Fabric Adapter (EFA)

-

aws-ofi-nccl プラグイン

これらは、AI フレームワークとツールを大規模に迅速にデプロイして実行するのに役立ちます。

今すぐアカウントを作成して、AWS でエンタープライズ AI を使い始めましょう。