/portcast%20logo%402x.15ef66a2fd613131199d6eececc53631c6564600.png)

Portcast skaliert Machine-Learning-Modelle auf See mit Amazon SageMaker

2021

Förderung der Effizienz der Lieferkette mit Machine Learning (ML)

Die Seefracht ist mit 90 Prozent des Handelsvolumens der wichtigste Verkehrsträger im globalen Handel. Die Fähigkeit, die Ankunft von Gütern in den Häfen vorherzusagen und zu planen, bestimmt in hohem Maße die Effizienz der Lieferketten, ungeachtet von Wetterunterbrechungen, Zollverzögerungen und anderen Faktoren.

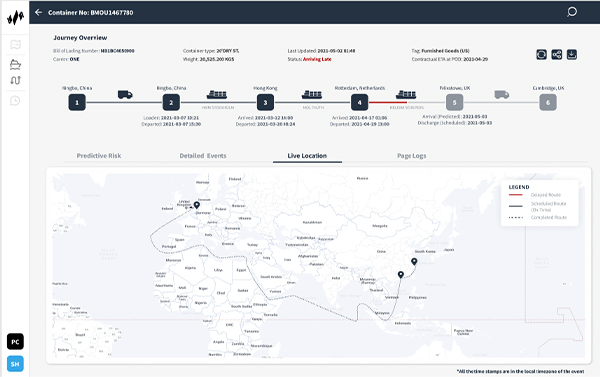

Das in Singapur ansässige Startup-Unternehmen Portcast bietet über seine Plattform für Machine Learning (ML) einen Software-as-a-Service (SaaS) zur Vorhersage von Lieferketten an, der Reedereien und Herstellern hilft, die Ankunftszeit von Fracht in Häfen vorherzusagen. Portcast möchte den manuellen Aufwand und die Kosten für die Containerverfolgung bei seinen Kunden um 80 Prozent bzw. 20 Prozent reduzieren. Die firmeneigenen ML-Modelle nutzen historische Muster von Schifffahrts- und Containerbewegungen sowie Echtzeitdaten wie Wetterbedingungen, Hafenverkehr und Schiffsstandorte, um die Effizienz der Lieferkette zu verbessern.

„Mit Amazon SageMaker können wir eine global skalierbare Plattform für prädiktive Logistik mit effizienter Cloud-Speicherung und Datenberechnung entwickeln.“

Lingxiao Xia

Mitgründer und CTO, Portcast

Isolierte ML-Vorhersagen zur unabhängigen Skalierung

Portcast nutzt eine Reihe von AWS-Services (Amazon Web Services), um die zugrundeliegende Infrastruktur und die Fähigkeit zur Ausführung von ML-Modellen in großem Umfang zu unterstützen. Um die für die ML-Verarbeitung gesammelten Daten zu speichern, verwendet das Unternehmen Amazon Relational Database Service (Amazon RDS) und Amazon Simple Storage Service (Amazon S3). Es verwendet auch den Amazon Elasticsearch Service für Suchprotokolle, die die Analytics steuern. „Die Interaktion zwischen den Diensten auf AWS ist nahtlos, was uns erlaubt, ständig mit verschiedenen Ideen zu experimentieren“, sagt Lingxiao Xia, Mitbegründer und Chief Technology Officer bei Portcast.

Bis 2019 trainierte und implementierte Portcast seine ML-Modelle mit Bare-Metal-Instances von Amazon Elastic Compute Cloud (Amazon EC2) und selbst gehosteten Clustern. Dieser Ansatz funktionierte anfangs gut, als das Unternehmen nur ein paar hundert Container gleichzeitig verfolgte. Als das Unternehmen jedoch wuchs, wurde die Skalierung seiner ML-Vorhersagen komplex und kostspielig, da jedes Schiff oft bis zu 20 000 Container transportierte. Die Komplexität wurde noch dadurch erhöht, dass zweimal täglich aktuelle Ankunftsprognosen pro Container erstellt werden mussten.

Mit einer Bare-Metal-Installation musste Portcast seine gesamte ML-Infrastruktur, einschließlich Verarbeitung, Vorhersagen und Endpunkte, gemeinsam skalieren, was zu einem sehr hohen Speicherbedarf führte. Portcast musste den Vorhersageaspekt seiner ML-Modelle isolieren, um unabhängig skalieren zu können. Die Herausforderung wurde durch den Einsatz von Amazon SageMaker gelöst.

Parallele Ausführung von Prozessen mit unbegrenztem Speicher

Bevor sich Portcast für Amazon SageMaker entschied, bat das Unternehmen um eine praktische Schulung mit den AWS-Lösungsarchitekten. Das Datenteam von Portcast nutzte Amazon SageMaker, um die ML-Workloads zu optimieren, indem es die Modellschulung von den Vorhersagen und der Verarbeitung trennte und mit einigen wenigen Instances begann, die die ML-Modellschulung durchführten. Jetzt verwendet Portcast Amazon SageMaker, um die Automatisierung des gesamten ML-Zyklus zu beschleunigen, vom Training über die Verarbeitung bis hin zu Vorhersagen.

„Indem wir die Vorhersagen als separaten Service aus dem ML-Modell herausnehmen, können wir die Modelle unabhängig skalieren und den Speicherbedarf reduzieren“, sagt Xia.

Zuvor war Portcast durch die Anzahl der parallel laufenden Prozesse begrenzt, da jedes Modell in den Speicher geladen werden musste. „Da alle unsere Modelle auf Amazon SageMaker gehostet werden, können wir Hunderte von Prozessen ohne Speicherplatzbegrenzung parallel laufen lassen. Wir haben das Potenzial, Millionen von Vorhersagen pro Tag zu erstellen“, fügt Xia hinzu. Portcast nutzt auch die Funktion der Multi-Modell-Endpunkte in Amazon SageMaker, um die Kosten zu senken, indem mehrere Modelle auf jeder Instance gehostet werden, was mindestens 60 Prozent bei der ML-Bereitstellung einspart.

Beschleunigen der Bereitstellung und Automatisieren der Überwachung

Derzeit überwacht Portcast zehntausende von Containern pro Tag – eine Größenordnung, die mit der bisherigen Infrastruktur technisch nicht möglich war. „Mit Amazon SageMaker können wir eine global skalierbare Plattform für prädiktive Logistik mit effizienter Cloud-Speicherung und Datenberechnung entwickeln“, so Xia.

Als vollständig verwalteter Service kümmert sich Amazon SageMaker um die zugrunde liegende Infrastruktur, die ML-Modelle trainiert und ausführt, sodass Portcast nur die Ersteinrichtung bestimmen muss. ML-Modelle skalieren automatisch, und Amazon CloudWatch sendet Warnmeldungen, wenn Anomalien entdeckt werden. Das Datenteam von Portcast verfügt über eine Benutzeroberfläche, die eine hohe Transparenz der Verarbeitungsaufträge und ihres Status ohne manuelle Eingriffe ermöglicht. Dadurch spart das Team mindestens 2–3 Stunden pro Woche, die früher für die Überwachung der Infrastruktur aufgewendet wurden.

Abgesehen von der Zeitersparnis betont Xia, wie wichtig es ist, den Kontextwechsel zu reduzieren. „Wenn unsere Datenwissenschaftler von der Analyse von Modellen zu Überwachungsaufgaben wechseln müssen, sind die Kosten für den Kontextwechsel höher als die Zeit, die sie für diese Aufgabe aufwenden“, erklärt er.

Verbesserung der Arbeitsabläufe in der Datenwissenschaft/Entwicklung

Die Einführung von Amazon SageMaker hat auch die Abhängigkeit zwischen den Datenwissenschafts- und Entwicklungsteams von Portcast verringert. Die Entwickler müssen keine Infrastruktur mehr einrichten, bevor das Datenteam ML-Modelle aktualisieren oder neue Funktionen hinzufügen kann. Datenwissenschaftler können die für ihre Arbeit erforderliche Infrastruktur innerhalb von Amazon SageMaker selbständig einrichten.

Einige Datenwissenschaftler, die Amazon SageMaker beherrschen, sind zu internen Champions geworden. Sie schlagen regelmäßig Projekte vor oder initiieren sie, um gemeinsame Herausforderungen wie Engpässe bei der Bearbeitung zu bewältigen. Das Datenteam erweitert außerdem aktiv sein Wissen über Amazon SageMaker durch gezielte Sitzungen und Diskussionen mit AWS-Lösungsarchitekten über Optimierungsstrategien zur Skalierung bei gleichzeitiger Kostenkontrolle.

Skalieren zur Unterstützung der Expansion

Nidhi Gupta, Mitbegründerin und Geschäftsführerin von Portcast, ist der Meinung, dass das Beste für die Logistikinnovation noch vor uns liegt. „Die nächsten paar Jahre sind der Wendepunkt für unsere Branche, und wir erwarten in den kommenden Monaten ein 10- bis 20-faches Wachstum“, sagt sie. „Mit Amazon SageMaker können wir mehr Container auf der gleichen Plattform verarbeiten, wenn wir wachsen. Dies ermöglicht es uns, mehr Geschäftsmöglichkeiten zu erkunden und gleichzeitig unsere Ressourcen zu optimieren, was letztendlich unser Ergebnis verbessert.“

Weitere Informationen

Weitere Informationen finden Sie unter Machine Learning in AWS.

Über Portcast

Portcast bietet Technologie für prädiktive Sichtbarkeit und Nachfrageprognose für Logistikunternehmen und Hersteller. Seine Kunden können die manuelle Planung um bis zu 80 Prozent reduzieren und den Frachtbedarf und die Ankunftszeiten genauer bestimmen, um die Kosten zu kontrollieren.

Vorteile von AWS

- Führt Hunderte von ML-Prozessen parallel und ohne Speicherbegrenzung aus

- Spart mindestens 2–3 Stunden pro Woche für die Überwachung der Infrastruktur

- Skaliert von der Verfolgung hunderter auf tausende von Containern in 2 Jahren

- Senkt die Kosten für die ML-Bereitstellung um mindestens 60 %

- Reduziert die Abhängigkeit zwischen Entwickler- und Datenwissenschaftsteams

- Fördert eine Selfservice-Kultur zur Lösung interner Engpässe

Genutzte AWS-Services

Amazon SageMaker

Amazon SageMaker unterstützt Datenwissenschaftler und Entwickler bei der Vorbereitung, der Erstellung, dem Training und der Bereitstellung hochwertiger Machine Learning (ML)-Modelle durch eine breite Palette von speziell für ML entwickelten Funktionen.

Amazon CloudWatch

Amazon CloudWatch ist ein Dienst zur transparenten Überwachung und Beobachtung für DevOps-Techniker, Entwickler, Site Reliability Engineers (SRE) und IT-Manager.

Amazon Relational Database Service (RDS)

Amazon Relational Database Service (Amazon RDS) erleichtert Ihnen die Einrichtung, Verwaltung und Skalierung einer relationalen Datenbank in der Cloud.

Amazon Elasticsearch Service

Amazon Elasticsearch Service ist ein vollständig verwalteter Service, mit dem Sie Elasticsearch ohne Ausfallzeiten bereitstellen, sichern und ausführen können.

Erste Schritte

Unternehmen jeder Größe und aus jeder Branche transformieren ihr Geschäft mit AWS. Kontaktieren Sie unsere Experten und beginnen Sie noch heute damit, AWS Cloud kennen zu lernen.