Quelle est la différence entre le débit et la latence ?

La latence et le débit sont deux métriques qui mesurent les performances d'un réseau informatique. La latence est le délai de communication réseau. Elle indique le temps nécessaire au transfert des données sur le réseau. Les réseaux qui ont un délai plus long ont une latence élevée, tandis que ceux qui ont des temps de réponse rapides ont une latence plus faible. En revanche, le débit fait référence au volume moyen de données qui peut réellement transiter par le réseau pendant une période donnée. Il indique le nombre de paquets de données qui arrivent à destination avec succès et la perte de paquets de données.

Pourquoi le débit et la latence sont-ils importants ?

Vous pouvez déterminer la vitesse du réseau en examinant la rapidité avec laquelle un réseau peut transférer des paquets de données vers leurs destinations. Cette vitesse est le résultat de facteurs de performance du réseau, tels que la latence et le débit.

La latence détermine le délai qu'un utilisateur rencontre lorsqu'il envoie ou reçoit des données depuis le réseau. Le débit détermine le nombre d'utilisateurs pouvant accéder simultanément au réseau.

Un réseau à faible débit et à latence élevée a du mal à envoyer et à traiter un volume de données élevé, ce qui entraîne un encombrement et de mauvaises performances des applications. En revanche, un réseau à haut débit et à faible latence est réactif et efficace. Les utilisateurs bénéficient de performances améliorées et d'une satisfaction accrue.

Les réseaux performants ont un impact direct sur la génération de revenus et l'efficacité opérationnelle. En outre, certains cas d'utilisation, tels que le streaming en temps réel, l'analytique des données de l'Internet des objets (IoT) et l'informatique à hautes performances, nécessitent certains seuils de performance du réseau pour fonctionner de manière optimale.

Principales différences : latence du réseau vs débit

Bien que la latence et le débit contribuent tous deux à la fiabilité et à la rapidité du réseau, ils ne sont pas identiques. Ces métriques de réseau se concentrent sur des statistiques distinctes et sont différentes.

Comment mesurer

Vous pouvez mesurer la latence du réseau en mesurant le temps de réponse. Ce processus consiste à transmettre un petit paquet de données et à recevoir la confirmation de son arrivée.

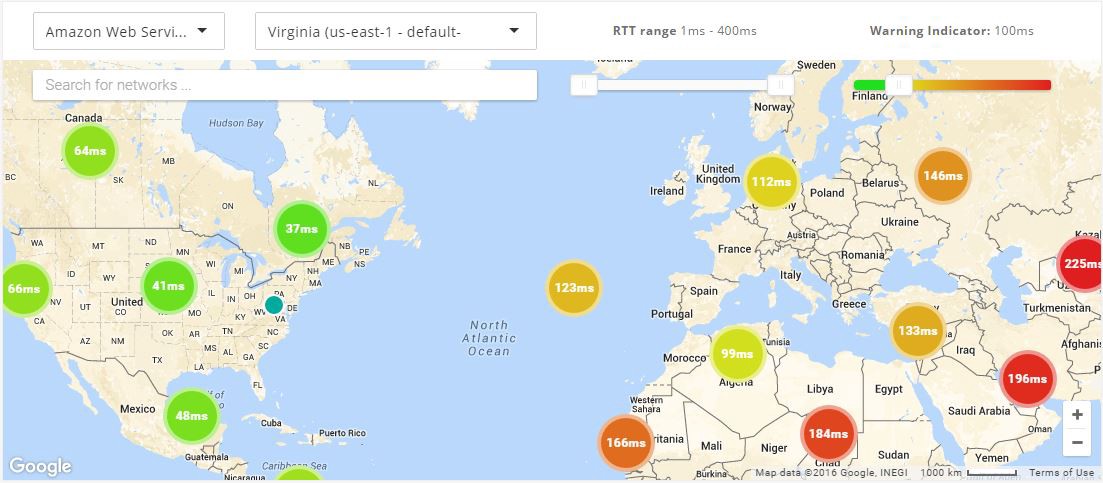

La plupart des systèmes d'exploitation prennent en charge une commande ping qui permet d'effectuer cette opération depuis votre appareil. Le temps aller-retour (RTT, Round-Trip-Time) s'affiche en millisecondes et vous donne une idée du temps nécessaire à votre réseau pour transférer des données.

Vous pouvez mesurer le débit à l'aide d'outils de test réseau ou manuellement. Si vous souhaitez tester le débit manuellement, vous devez envoyer un fichier et diviser la taille du fichier par le temps qu'il met à arriver. Toutefois, la latence et la bande passante ont un impact sur le débit. C'est pourquoi de nombreuses personnes utilisent des outils de test réseau, car ceux-ci indiquent le débit ainsi que d'autres facteurs tels que la bande passante et la latence.

En savoir plus sur le RTT dans le domaine de la mise en réseau »

Unité de mesure

Vous mesurez la latence en millisecondes. Si le nombre de millisecondes est faible, votre réseau ne connaît qu'un léger retard. Plus le nombre en millisecondes est élevé, plus les performances du réseau sont lentes.

À l'origine, le débit du réseau se mesurait en bits par seconde (bit/s). Mais, à mesure que les technologies de transmission de données se sont améliorées, vous pouvez désormais atteindre des valeurs bien plus élevées. De ce fait, vous pouvez mesurer le débit en kilo-octets par seconde (Kbit/s), en mégaoctets par seconde (Mbit/s) et même en gigaoctets par seconde (Gbit/s). Un octet est égal à huit bits.

Facteurs d'impact : latence vs débit

Différents facteurs peuvent avoir une incidence sur vos métriques de latence et de débit.

Latence

Plusieurs facteurs contribuent à augmenter ou diminuer la latence.

Emplacement

L'un des facteurs les plus importants est l'emplacement d'origine des données et leur destination prévue. Si vos serveurs se trouvent dans une zone géographique différente de celle de votre appareil, les données doivent voyager plus loin, ce qui augmente la latence. Ce facteur est appelé propagation.

Encombrement du réseau

Le réseau est encombré lorsqu'un volume élevé de données est transmis sur un réseau. L'augmentation du trafic sur le réseau fait que les paquets empruntent des itinéraires plus longs pour atteindre leur destination.

Efficacité du protocole

Certains réseaux nécessitent des protocoles supplémentaires pour des raisons de sécurité. Les étapes supplémentaires de l'établissement de liaison entraînent un délai.

Infrastructure réseau

Les périphériques réseau peuvent être surchargés, ce qui entraîne la perte de paquets. Lorsque des paquets sont retardés ou perdus, les périphériques les retransmettent. Cela ajoute une latence supplémentaire.

Débit

Les vitesses de débit sont directement affectées par d'autres facteurs.

Bande passante

Si la capacité de votre réseau a atteint la bande passante maximale de votre support de transmission, son débit ne pourra jamais dépasser cette limite.

Puissance de traitement

Certains périphériques réseau disposent d'optimisations matérielles ou logicielles spécialisées qui améliorent leurs performances de traitement. Par exemple, des circuits intégrés dédiés à des applications spécifiques ou des moteurs de traitement de paquets basés sur des logiciels.

Ces optimisations permettent au périphérique de gérer des volumes de trafic plus importants et des tâches de traitement de paquets plus complexes, ce qui se traduit par un débit plus élevé.

Perte de paquets

La perte de paquets peut survenir pour diverses raisons : l'encombrement du réseau, un matériel défectueux ou des périphériques réseau mal configurés. Lorsque des paquets sont perdus, ils doivent être retransmis. Cela entraîne des retards et réduit le débit global du réseau.

Topologie du réseau

La topologie du réseau fait référence au nombre de périphériques réseau, à la bande passante des liens réseau et à la distance entre les périphériques sur un chemin réseau.

Une topologie de réseau bien conçue fournit plusieurs chemins pour la transmission des données, réduit les goulots d'étranglement du trafic et augmente le débit. Les réseaux comportant un plus grand nombre de périphériques ou des distances plus longues nécessitent des topologies réseau complexes pour atteindre un débit élevé.

Relation entre bande passante, latence et débit

La latence et le débit fonctionnent ensemble pour fournir une connectivité et des performances réseau élevées. Comme ces deux éléments ont un impact sur la transmission des paquets de données, ils s'influencent également mutuellement.

Si une connexion réseau présente une latence élevée, son débit peut être plus faible, car les données mettent plus de temps à être transmises et à arriver. Un faible débit donne également l'impression qu'un réseau présente une latence élevée, car les grandes quantités de données mettent plus de temps à arriver.

Comme ils sont étroitement liés, vous devez surveiller à la fois la latence et le débit pour obtenir des performances réseau élevées.

Bande passante et débit réseau

La bande passante représente le volume total de données que vous pouvez transférer sur un réseau. Votre bande passante totale fait référence à la quantité maximale théorique de données que vous pouvez transférer sur un réseau. Vous la mesurez en mégaoctets par seconde (Mbit/s). Vous pouvez considérer la bande passante comme le débit maximal théorique de votre réseau.

La bande passante correspond à la quantité de données que vous pouvez transférer, tandis que le débit correspond à la quantité réelle de données que vous transmettez à un moment donné en fonction des limites réelles du réseau. Une bande passante élevée ne garantit pas la vitesse ou de bonnes performances du réseau, mais une bande passante plus élevée entraîne un débit plus élevé.

Comment améliorer la latence et le débit ?

Pour améliorer la latence, vous pouvez raccourcir la propagation entre la source et la destination. Vous pouvez améliorer le débit en augmentant la bande passante globale du réseau.

Nous allons maintenant vous donner quelques suggestions pour améliorer simultanément la latence et le débit.

Mise en cache

Dans le domaine de la mise en réseau, la mise en cache fait référence au fait de stocker des données fréquemment consultées géographiquement plus près de l'utilisateur. Par exemple, vous pouvez stocker des données sur des serveurs proxy ou des réseaux de diffusion de contenu (CDN).

Votre réseau peut fournir des données depuis l'emplacement mis en cache bien plus rapidement que si elles devaient être récupérées à partir de la source d'origine. De plus, l'utilisateur reçoit les données beaucoup plus rapidement, ce qui améliore la latence. Par ailleurs, étant donné que les données sont extraites d'un cache, cela réduit la charge sur la source d'origine. Cela lui permet de traiter un plus grand nombre de demandes à la fois, améliorant ainsi le débit.

Protocole de transport

En optimisant le protocole de transport que vous utilisez pour des applications spécifiques, vous pouvez améliorer les performances du réseau.

Par exemple, TCP et UDP sont deux protocoles réseau courants. Le protocole TCP établit une connexion et vérifie que vous recevez des données sans erreur. En raison de son objectif de réduction des pertes de paquets, le protocole TCP présente une latence et un débit plus élevés. Le protocole UDP ne vérifie pas la perte de paquets ou les erreurs ; il transmet à la place plusieurs paquets dupliqués. Cela donne donc une latence minimale, mais un débit plus élevé.

Entre TCP et UDP, le choix idéal dépend de l'application que vous utilisez. Par exemple, le protocole TCP est utile pour le transfert de données, tandis que le protocole UDP est utile pour le streaming vidéo et les jeux.

Qualité du service

Vous pouvez utiliser une stratégie de qualité de service (QoS, Quality of Service) pour gérer et optimiser les performances du réseau. La QoS vous permet de diviser le trafic réseau en catégories spécifiques. Vous pouvez attribuer un niveau de priorité à chaque catégorie.

Vos configurations QoS donnent la priorité aux applications sensibles à la latence. Certaines applications et certains utilisateurs bénéficient d'une latence plus faible que d'autres. Vos configurations QoS peuvent également hiérarchiser les données par type, réduisant ainsi les pertes de paquets et augmentant le débit pour certains utilisateurs.

Résumé des différences : débit vs latence

| Débit |

Latence |

|

| De quelle mesure s'agit-il ? |

Le débit mesure le volume de données qui transite par un réseau au cours d'une période donnée. Le débit a une incidence sur la quantité de données que vous pouvez transmettre au cours d'une période donnée. |

La latence mesure le délai d'envoi des données. Une latence plus élevée entraîne un retard sur le réseau. |

| Comment mesurer ? |

Calculez manuellement le débit en envoyant un fichier ou en utilisant des outils de test réseau. |

Calculez la latence en utilisant les temps de réponse. |

| Unité de mesure |

Mégaoctets par seconde (Mbit/s). |

Millisecondes (ms). |

| Facteurs d'impact |

Bande passante, puissance de traitement du réseau, perte de paquets et topologie du réseau. |

Distances géographiques, congestion du réseau, protocole de transport et infrastructure réseau. |

Comment AWS peut-il répondre aux exigences de performance de votre réseau ?

Amazon Web Services (AWS) propose un certain nombre de solutions visant à réduire la latence du réseau et à améliorer le débit du réseau. Vous pouvez mettre en œuvre l'un des services suivants, en fonction de vos besoins :

- Amazon CloudFront est un réseau de diffusion de contenu conçu pour des performances élevées, pour la sécurité et pour la simplicité de développement. Vous pouvez l'utiliser pour diffuser du contenu en toute sécurité avec une faible latence et des vitesses de transfert élevées.

- AWS Direct Connect est un service cloud qui associe votre réseau directement à AWS afin de fournir une latence réseau plus constante et plus faible. Lors de la création d'une connexion, vous pouvez choisir une connexion hébergée fournie par un partenaire de livraison AWS Direct Connect, ou une connexion dédiée depuis AWS pour un déploiement sur plus de 100 points d'accès AWS Direct Connect à travers le monde.

- AWS Global Accelerator est un service de mise en réseau qui vous permet d'obtenir jusqu'à 60 % de performances du trafic des utilisateurs en plus à travers l'infrastructure réseau mondiale d'AWS. Lorsque Internet est encombré, AWS Global Accelerator optimise le chemin vers votre application pour maintenir vos pertes de paquets, votre instabilité et votre latence à un niveau constamment bas.

- Les AWS Local Zones correspondent à un type de déploiement d'infrastructure qui rapproche les capacités de calcul, de stockage, de bases de données et certains autres services AWS des régions de forte concentration démographique et des grands centres industriels. Vous pouvez fournir des applications innovantes qui exigent une faible latence, plus près des utilisateurs finaux et sur des installations sur site.

Commencez à optimiser votre débit et votre latence sur AWS en créant un compte dès aujourd'hui.